El Consejo Asesor Económico del Primer Ministro de la India (EACPM) redactó un documento advirtiendo que las actuales regulaciones globales sobre IA probablemente sean ineficaces y recomendó regular la tecnología con tácticas alternativas, como las utilizadas en los mercados financieros.

El Consejo está muy preocupado por la IA. Su documento advierte: “A través de una combinación de vigilancia, mensajes persuasivos y generación de medios sintéticos, la IA malévola podría controlar cada vez más los ecosistemas de información e incluso fabricar realidades engañosas personalizadas para coaccionar el comportamiento humano, induciendo esquizofrenia masiva”.

La organización critica el enfoque de los EE. UU. hacia la IA por ser demasiado indiferente, el del Reino Unido por presentar riesgos al estar a favor de la innovación y el laissez-faire, y las normas de la UE sobre la IA por ser defectuosas debido a que los países miembros del bloque se dividen y adoptan diferentes énfasis y aplicaciones de medidas de ejecución.

El documento también sostiene que la tendencia de China a regular con “un sistema burocrático centralizado todopoderoso” es defectuosa, como lo demuestra “el probable origen de la COVID-19 en una fuga de laboratorio”.

Estamos a través del espejo aquí, gente.

(Para que conste, la Oficina del Director de Inteligencia Nacional de EE.UU. ha no encontré ninguna indicación que el virus se filtró de un laboratorio chino).

Pero nos estamos desviando.

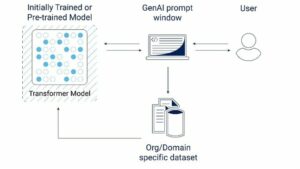

El Consejo sugiere que la IA se considere un “sistema descentralizado y autoorganizado [que evoluciona] a través de ciclos de retroalimentación, transiciones de fase y sensibilidad a las condiciones iniciales” y propone otros ejemplos de tales sistemas, como entidades no lineales vistas en los mercados financieros, el comportamiento de las colonias de hormigas. o patrones de tráfico.

“Los métodos tradicionales se quedan cortos debido a la naturaleza impredecible y no lineal de la IA. Los sistemas de IA son similares a los Sistemas Adaptativos Complejos (CAS), donde los componentes interactúan y evolucionan de manera impredecible”. explicado [PDF] el consejo.

El Consejo no está dispuesto a depender de medidas "ex ante", ya que es imposible saber de antemano el riesgo que presentará un sistema de IA: su comportamiento es el resultado de demasiados factores.

Por tanto, el documento propone que India adopte cinco medidas regulatorias:

- Colocación de barandillas y tabiques., que debería garantizar que las tecnologías de IA no excedan su función prevista ni invadan territorios peligrosos, como la toma de decisiones sobre armamento nuclear. Si de alguna manera rompen esa barandilla en un sistema, las particiones están ahí para garantizar que no se propague.

- Garantizar anulaciones manuales y puntos de bloqueo de autorización que mantienen a los humanos en control y los mantienen seguros con autenticación multifactor y un proceso de revisión de múltiples niveles para los tomadores de decisiones humanos.

- Transparencia y explicabilidad con medidas como licencias abiertas para algoritmos centrales para fomentar un entorno favorable a las auditorías, auditorías y evaluaciones periódicas y documentación de desarrollo estandarizada.

- Responsabilidad distinta a través de protocolos de responsabilidad predefinidos, informes de incidentes estandarizados obligatorios y mecanismos de investigación.

- Promulgar un organismo regulador especializadoque recibe un mandato amplio, adopta un enfoque basado en la retroalimentación, monitorea y rastrea el comportamiento del sistema de IA, integra sistemas de alerta automatizados y establece un registro nacional.

El Consejo recomendó buscar ideas en otros sistemas CAS sobre cómo implementar sus ideas, principalmente en los mercados financieros.

"Los conocimientos obtenidos de la gestión de sistemas caóticos como los mercados financieros demuestran enfoques de regulación viables para tecnologías complejas", observa el documento, sugiriendo que los reguladores dedicados a la IA podrían seguir el modelo de reguladores financieros como el SEBI de la India o la SEC de los EE.UU.

Así como esos organismos imponen suspensiones de operaciones cuando los mercados están en peligro, los reguladores podrían adoptar “puntos de estrangulamiento” similares en los que la IA sería controlada. La presentación de informes financieros obligatorios es un buen modelo para el tipo de divulgación que se podría exigir a los operadores de IA.

Las preocupaciones de los autores se ven alimentadas por la creencia de que la creciente ubicuidad de la IA (combinada con la opacidad de su funcionamiento) significa que la infraestructura crítica, las operaciones de defensa y muchos otros campos están en riesgo.

Entre los peligros que describen se encuentran la “IA desbocada”, donde los sistemas podrían automejorarse recursivamente más allá del control humano y “desalinearse con el bienestar humano”, y el efecto mariposa, un escenario “donde cambios menores pueden conducir a consecuencias significativas e imprevistas”.

“Por lo tanto, un sistema de control estatal opaco sobre algoritmos, conjuntos de entrenamiento y modelos con el objetivo de maximizar los intereses puede conducir a resultados catastróficos”, advirtió el Consejo.

El documento señala que las regulaciones propuestas pueden significar que es necesario descartar algunos escenarios.

“Es posible que nunca permitamos una Internet súper conectada para todo”, admite el Consejo. Pero concluye que la humanidad puede tener más que ganar con regulaciones estrictas.

“Aquellos que crean herramientas de IA no se dejarán llevar fácilmente por supuestas consecuencias no deseadas, insertando así una 'piel en el juego' ex ante. Los humanos conservarán poderes de anulación y autorización. Las auditorías periódicas obligatorias tendrán que hacer cumplir la explicabilidad”. ®

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://go.theregister.com/feed/www.theregister.com/2024/02/01/indian_pms_ai_advice/

- :posee

- :es

- :no

- :dónde

- a

- Nuestra Empresa

- adaptado

- adoptar

- Adopción

- avanzar

- asesores

- asesor

- AI

- Sistemas de IA

- parecido

- Alertar

- algoritmos

- permitir

- también

- alternativa

- an

- y

- hormiga

- aplicaciones

- enfoque

- enfoques

- somos

- Arguye

- AS

- evaluaciones

- At

- auditorías

- Autenticación

- autorización

- Autorzy

- Confirmación de Viaje

- BE

- comportamiento

- "Ser"

- creencia

- Más allá de

- bloque

- cuerpos

- incumplimiento

- Traído

- burocrático

- pero

- by

- PUEDEN

- catastrófico

- Causar

- centralizado

- Cambios

- China

- chino

- CO

- combinación

- combinado

- integraciones

- componentes

- Inquietudes

- concluye

- condiciones

- conectado

- Consecuencias

- considerado

- control

- Core

- podría

- Consejo

- COVID-19

- Creamos

- crítico

- Infraestructura crítica

- Critica

- Current

- se adaptan

- PELIGRO

- peligros

- Descentralizado

- Toma de Decisiones

- tomadores de decisiones

- a dedicados

- Defensa

- entregamos

- demostrar

- demostrado

- Desarrollo

- una experiencia diferente

- Director

- revelación

- documento

- documentación

- doesn

- dos

- pasan fácilmente

- Economic

- ecosistemas

- efecto

- hacer cumplir

- cumplimiento

- garantizar

- entidades

- Entorno

- Éter (ETH)

- EU

- Incluso

- todo

- evoluciona

- evoluciona

- ejemplos

- exceden

- Explicabilidad

- factores importantes

- Otoño

- factible

- realimentación

- Terrenos

- Archive

- financiero

- Reguladores Financieros

- Digital XNUMXk

- defectuoso

- Cuidados de acogida

- Desde

- alimentado

- función

- Obtén

- juego

- generación de AHSS

- dado

- vaso

- Buscar

- objetivo

- candidato

- gobernante

- Tienen

- esta página

- Cómo

- Como Hacer

- HTTPS

- humana

- con Humildad

- Humanos

- ideas

- if

- impuesta

- imposible

- in

- incidente

- creciente

- cada vez más

- India

- Indian

- información

- EN LA MINA

- inicial

- Insights

- Integra

- Intelligence

- Destinado a

- interactuar

- intereses

- Internet

- investigación

- ISN

- IT

- SUS

- jpg

- Keen

- Guardar

- acuerdo

- Tipo

- Saber

- el lab

- Lead

- dejar

- fiscal

- Licencias

- como

- que otros

- mirando

- para lograr

- mandato

- manual

- muchos

- Industrias

- Misa

- Maximizar

- Puede..

- personalizado

- significa

- medidas

- los mecanismos de

- Medios

- miembro

- mensajería

- métodos

- podría

- ministro

- menor de edad

- modelo

- modelos

- monitores

- más,

- autenticación de múltiples factores

- Nacional

- Naciones

- Naturaleza

- ¿ Necesita ayuda

- Neither

- nunca

- no

- no lineal

- ni

- Notas

- nuclear

- Observa

- of

- off

- Oficina

- Oficina del Director de Inteligencia Nacional

- on

- ONE

- opaco

- habiertos

- Operaciones

- operadores

- or

- Natural

- Otro

- salir

- resultados

- contorno

- Más de

- anular

- .

- (PDF)

- Personas

- fase

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- pm

- poderes

- predefinido

- presente

- las cuales

- Prime

- primer ministro

- propuesto

- propone

- protocolos

- RE

- realidades

- recomendado

- grabar

- registro

- regular

- Regula tu

- reguladora

- Regulación

- reglamentos

- Reguladores

- regulador

- confiando

- Informes

- Requisitos

- resultado

- conservar

- una estrategia SEO para aparecer en las búsquedas de Google.

- Riesgo

- dictaminó

- reglas

- s

- ambiente seguro

- dices

- guión

- escenarios

- SEG

- visto

- Sensibilidad

- Sets

- En Corto

- tienes

- importante

- similares

- Piel

- algo

- de algun modo

- especializado

- propagación

- estandarizado

- Estado

- control del Estado

- fuerte

- tal

- Sugiere

- súper

- Supuesto

- seguro

- vigilancia

- sintético

- te

- Todas las funciones a su disposición

- T

- táctica

- toma

- Tecnologías

- Tecnología

- territorios

- esa

- El

- el Reino Unido

- su

- Les

- Ahí.

- de este modo

- por lo tanto

- ellos

- aquellos

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- a

- demasiado

- pistas

- Plataforma de

- tradicional

- tráfico

- Formación

- transiciones

- Uk

- imprevisto

- imprevisible

- us

- usado

- muy

- virus

- prevenido

- advertencia

- Advierte

- formas

- we

- Bienestar

- cuando

- que

- seguirá

- labores

- preocupado

- se

- zephyrnet