Investigadores en Australia están desarrollando gafas inteligentes para personas ciegas, utilizando una tecnología llamada "toque acústico" para convertir imágenes en sonidos. Los experimentos iniciales sugieren que esta tecnología de audio espacial portátil podría ayudar a las personas ciegas o con problemas de visión importantes a localizar objetos cercanos.

Las recientes mejoras en la realidad aumentada, la práctica tecnología de cámaras portátiles y la visión por computadora basada en el aprendizaje profundo están acelerando el desarrollo de gafas inteligentes como una tecnología de asistencia viable y multifuncional para quienes son ciegos o tienen baja visión. Estas gafas inteligentes incorporan cámaras, sistemas GPS, un micrófono y unidades de medición inercial y de detección de profundidad para ofrecer funciones como navegación, control de reconocimiento de voz o representación de objetos, texto o entorno como voz sintetizada por computadora.

Howe Yuan Zhu y colegas de la Universidad Tecnológica de Sydney (UTS) y el Universidad de Sydney investigó la adición de toque acústico a las gafas inteligentes, un enfoque que utiliza el escaneo de la cabeza y la activación de íconos auditivos cuando los objetos aparecen dentro de un campo de visión (FOV) definido.

Escribiendo en PLoS ONE, los investigadores explican que el tacto acústico ofrece varias ventajas sobre los enfoques existentes, incluida la facilidad de integración con la tecnología de gafas inteligentes y un uso más intuitivo que el habla sintetizada por computadora. Estos sistemas también pueden requerir menos capacitación para que los usuarios adquieran competencia.

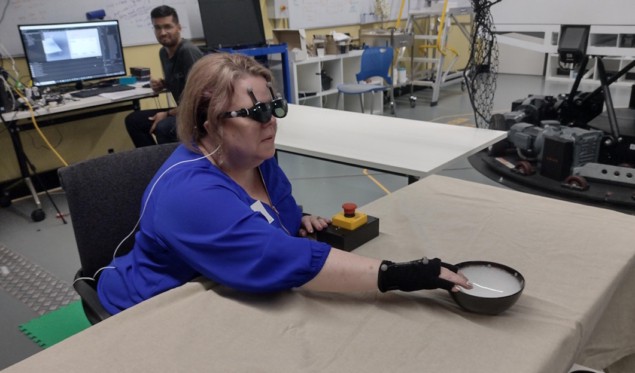

Trabajando con ARIA Research de Sydney (que recientemente ganó Compañía de tecnología australiana del año por sus innovaciones pioneras en tecnología de la visión), el equipo creó un dispositivo de audio foveado (DAP) para probar estas suposiciones en siete voluntarios con visión nula o baja, además de siete participantes videntes con los ojos vendados. El FAD consta de un teléfono inteligente y gafas de realidad aumentada NREAL, a las que el equipo adjuntó marcadores reflectantes de captura de movimiento para permitir el seguimiento de los movimientos de la cabeza.

El FAD realiza el reconocimiento de objetos y determina la distancia del objeto utilizando las cámaras estéreo de las gafas. Luego asigna a los objetos iconos auditivos apropiados, como por ejemplo el sonido de pasar página en un libro. Cuando un usuario gira la cabeza, la tasa de repetición de los íconos auditivos cambia según la posición del elemento dentro del campo de visión auditivo.

Los voluntarios realizaron ejercicios tanto sentados como de pie. La tarea sentada requería que utilizaran varios métodos para buscar y manipular artículos cotidianos, incluidos un libro, una botella, un cuenco o una taza, colocados en una o varias mesas. Esta tarea midió su capacidad para detectar un elemento, reconocer un sonido y memorizar la posición del elemento.

Los investigadores diseñaron esta tarea para comparar el desempeño del FAD con dos señales del habla convencionales: instrucciones verbales en el formato del reloj; y la reproducción secuencial de íconos auditivos de parlantes ubicados junto a cada elemento. Descubrieron que para los participantes ciegos o con baja visión, el rendimiento utilizando el FAD era comparable al de las dos condiciones idealizadas. El grupo con los ojos vendados, sin embargo, obtuvo peores resultados cuando utilizó el DAP.

Un implante cerebral permite a una mujer ciega ver formas simples

La tarea de alcanzar de pie requirió que los participantes usaran el FAD para buscar y alcanzar un elemento objetivo situado entre múltiples elementos distractores. Se pidió a los participantes que encontraran objetos colocados en tres mesas rodeadas por cuatro botellas de diferentes formas. Esta tarea evaluó principalmente el rendimiento funcional del sistema y el comportamiento humano al utilizar el movimiento de todo el cuerpo durante la búsqueda.

"Este año, hemos estado explorando intensamente el uso del paisaje sonoro auditivo para respaldar diversas tareas complejas", dice Zhu. Mundo de la Física. “En particular, hemos explorado el uso de diferentes tipos de sonidos espacializados para guiar a las personas durante la navegación y apoyar actividades deportivas, específicamente tenis de mesa. El año que viene, esperamos seguir ampliando estas áreas y realizar estudios en entornos del mundo real”.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://physicsworld.com/a/acoustic-touch-technology-helps-blind-people-see-using-sound/

- :es

- 90

- a

- capacidad

- acelerador

- Conforme

- acústico

- Activación

- actividades

- adición

- ventajas

- también

- entre

- an

- y

- Aparecer

- enfoque

- enfoques

- adecuado

- somos

- áreas

- aire

- AS

- evaluado

- supuestos

- At

- audio

- tecnología de audio

- aumentado

- Realidad Aumentada

- Australia

- a las que has recomendado

- esto

- comportamiento

- ciego

- primer libro

- ambas

- by

- , que son

- cámara

- cámaras

- Cambios

- personal

- COM

- compañía

- comparable

- comparar

- integraciones

- incluido

- computadora

- Visión por computador

- condiciones

- Conducir

- continue

- control

- convencional

- podría

- creado

- Vaso

- profundo

- se define

- entregamos

- profundidad

- diseñado

- detectar

- determina

- el desarrollo

- Desarrollo

- dispositivo

- una experiencia diferente

- direcciones

- distancia

- durante

- cada una

- facilidad

- habilitar

- permite

- diario

- ejemplo

- existente

- en expansión

- experimentos

- Explicar

- explorado

- Explorar

- Encuentre

- encontrado

- Digital XNUMXk

- Desde

- funcional

- funciones

- gafas

- gps

- Grupo procesos

- guía

- encargarse de

- Tienen

- cabeza

- fuertemente

- ayuda

- ayuda

- esperanza

- Sin embargo

- HTTPS

- humana

- iconos

- imagen

- imágenes

- mejoras

- in

- Incluye

- incorporar

- información

- inicial

- innovaciones

- integración

- dentro

- intuitivo

- IT

- artículos

- SUS

- jpg

- el lab

- menos

- Baja

- max-ancho

- Puede..

- mesurado

- multiplataforma

- miembro

- métodos

- micrófono

- mezclado

- realidad mixta

- más,

- movimiento

- movimiento

- movimientos

- múltiples

- Navegación

- Nuevo

- Next

- no

- irreal

- objeto

- objetos

- of

- Ofertas

- on

- ONE

- or

- Más de

- parte

- Participantes

- particular

- Personas

- actuación

- realizado

- realiza

- Física

- Mundo de la física

- Pioneros

- metido

- plataforma

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- jugando

- más

- posición

- posicionado

- Metodología

- las cuales

- Rate

- en comunicarse

- alcanzando

- mundo real

- Realidad

- recientemente

- reconocimiento

- reconocer

- representación

- exigir

- Requisitos

- la investigación

- investigadores

- exploración

- Buscar

- búsqueda

- ver

- ajustes

- siete

- Varios

- formas

- significativamente

- sencillos

- situado

- inteligente

- Gafas inteligentes

- teléfono inteligente

- Aislamiento de Sonido

- Espacial

- altavoces

- específicamente

- habla

- en pie

- estudios

- tal

- sugieren

- SOPORTE

- Apoyar

- rodeado

- Sydney

- te

- Todas las funciones a su disposición

- mesa

- Target

- Tarea

- tareas

- equipo

- Tecnología

- decirles

- tenis

- test

- texto

- que

- esa

- El

- su

- Les

- luego

- Estas

- ellos

- así

- aquellos

- Tres

- uña del pulgar

- a

- se

- contacto

- Seguimiento

- Formación

- verdadero

- GIRO

- dos

- tipos

- unidades que

- universidad

- utilizan el

- usuarios

- usos

- usando

- diversos

- y

- visión

- Voz

- de reconocimiento de voz

- voluntarios

- fue

- we

- usable

- tuvieron

- cuando

- que

- QUIENES

- dentro de

- mujer

- Won

- mundo

- peor

- año

- Yuan

- zephyrnet