Inside the Tech es una serie de blogs que acompaña nuestra Podcast de charlas tecnológicas. En el episodio 20 del podcast, La evolución de los avatares de Roblox, el director ejecutivo de Roblox, David Baszucki, habló con el director sénior de ingeniería, Kiran Bhat, el director sénior de producto, Mahesh Ramasubramanian, y la directora principal de producto, Effie Goenawan, sobre la El futuro de la comunicación inmersiva. a través de avatares y los desafíos técnicos que estamos resolviendo para potenciarlo. En esta edición de Inside the Tech, hablamos con el Gerente Senior de Ingeniería Andrew Portner para aprender más sobre uno de esos desafíos técnicos, la seguridad en la comunicación de voz inmersiva, y cómo el trabajo del equipo está ayudando a fomentar un entorno digital civil y seguro para todos en nuestra plataforma.

¿Cuáles son los mayores desafíos técnicos que está asumiendo su equipo?

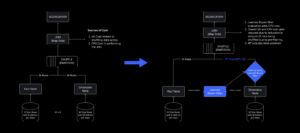

Priorizamos mantener una experiencia segura y positiva para nuestros usuarios. Seguridad y civismo Siempre son una prioridad para nosotros, pero manejarlos en tiempo real puede ser un gran desafío técnico. Siempre que hay un problema, queremos poder revisarlo y tomar medidas en tiempo real, pero esto es un desafío dada nuestra escala. Para manejar esta escala de manera efectiva, necesitamos aprovechar los sistemas de seguridad automatizados.

Otro desafío técnico en el que nos centramos es la precisión de nuestras medidas de seguridad para la moderación. Existen dos enfoques de moderación para abordar las infracciones de políticas y proporcionar comentarios precisos en tiempo real: moderación reactiva y proactiva. Para la moderación reactiva, estamos desarrollando modelos de aprendizaje automático (ML) para identificar con precisión diferentes tipos de violaciones de políticas, que funcionan respondiendo a informes de personas en la plataforma. De forma proactiva, estamos trabajando en la detección en tiempo real de posibles Contenido que viola nuestras políticas., educando a los usuarios sobre su comportamiento. Comprender la palabra hablada y mejorar la calidad del audio es un proceso complejo. Ya estamos viendo avances, pero nuestro objetivo final es tener un modelo altamente preciso que pueda detectar comportamientos que violen las políticas en tiempo real.

¿Cuáles son algunos de los enfoques y soluciones innovadores que estamos utilizando para abordar estos desafíos técnicos?

Hemos desarrollado un modelo de aprendizaje automático de extremo a extremo que puede analizar datos de audio y proporciona un nivel de confianza basado en el tipo de violaciones de políticas (por ejemplo, qué tan probable es que se produzca intimidación, malas palabras, etc.). Este modelo ha mejorado significativamente nuestra capacidad para cerrar automáticamente ciertos informes. Actuamos cuando nuestro modelo tiene confianza y podemos estar seguros de que supera a los humanos. Tan solo unos meses después del lanzamiento, pudimos moderar casi todos los informes de abuso de voz en inglés con este modelo. Hemos desarrollado estos modelos internamente y es un testimonio de la colaboración entre muchas tecnologías de código abierto y nuestro propio trabajo para crear la tecnología detrás de ellas.

Determinar qué es apropiado en tiempo real parece bastante complejo. ¿Cómo funciona?

Se piensa mucho en hacer que el sistema sea consciente del contexto. También analizamos patrones a lo largo del tiempo antes de tomar medidas para estar seguros de que nuestras acciones están justificadas. Nuestras políticas varían según la edad de la persona, si está en un espacio público o en un chat privado y muchos otros factores. Estamos explorando nuevas formas de promover el civismo en tiempo real y el aprendizaje automático está en el centro de ello. Recientemente lanzamos notificaciones automáticas (o "empujones") para recordar a los usuarios nuestras políticas. También estamos analizando otros factores como el tono de voz para comprender mejor las intenciones de una persona y distinguir cosas como el sarcasmo o las bromas. Por último, también estamos construyendo un modelo multilingüe, ya que algunas personas hablan varios idiomas o incluso cambian de idioma a mitad de una frase. Para que todo esto sea posible, debemos tener un modelo preciso.

Actualmente, nos centramos en abordar las formas más destacadas de abuso, como el acoso, la discriminación y las malas palabras. Estos constituyen la mayoría de los informes de abuso. Nuestro objetivo es tener un impacto significativo en estas áreas y establecer las normas de la industria sobre cómo es promover y mantener una conversación civil en línea. Estamos entusiasmados con el potencial del uso del aprendizaje automático en tiempo real, ya que nos permite fomentar de manera efectiva una experiencia civil y segura para todos.

¿En qué son únicos los desafíos que estamos resolviendo en Roblox? ¿Qué estamos en condiciones de resolver primero?

Nuestra Chatea con voz espacial La tecnología crea una experiencia más inmersiva, imitando la comunicación del mundo real. Por ejemplo, si estoy parado a la izquierda de alguien, me escuchará en su oído izquierdo. Estamos creando una analogía de cómo funciona la comunicación en el mundo real y este es un desafío que estamos en condiciones de resolver primero.

Como jugador, he sido testigo de mucho acoso e intimidación en los juegos en línea. Es un problema que a menudo no se controla debido al anonimato del usuario y a la falta de consecuencias. Sin embargo, los desafíos técnicos que estamos abordando en torno a esto son exclusivos de los que enfrentan otras plataformas en un par de áreas. En algunas plataformas de juego, las interacciones se limitan a los compañeros de equipo. Roblox ofrece una variedad de formas de pasar el rato en un entorno social que imita más fielmente la vida real. Con avances en ML y procesamiento de señales en tiempo real, podemos detectar y abordar eficazmente el comportamiento abusivo, lo que significa que no solo somos un entorno más realista, sino también uno en el que todos se sienten seguros para interactuar y conectarse con los demás. La combinación de nuestra tecnología, nuestra plataforma inmersiva y nuestro compromiso de educar a los usuarios sobre nuestras políticas nos coloca en condiciones de abordar estos desafíos de frente.

¿Cuáles son algunas de las cosas clave que ha aprendido al realizar este trabajo técnico?

Siento que he aprendido mucho. No soy un ingeniero de ML. He trabajado principalmente en la parte frontal de los juegos, por lo que poder profundizar más que antes sobre cómo funcionan estos modelos ha sido enorme. Mi esperanza es que las acciones que estamos tomando para promover el civismo se traduzcan en un nivel de empatía en la comunidad en línea que ha estado faltando.

Un último aprendizaje es que todo depende de los datos de entrenamiento que se ingresan. Y para que los datos sean precisos, los humanos deben ponerse de acuerdo sobre las etiquetas que se utilizan para categorizar ciertos comportamientos que violan las políticas. Es realmente importante capacitarse con datos de calidad en los que todos puedan estar de acuerdo. Es un problema realmente difícil de resolver. Empiezas a ver áreas en las que el aprendizaje automático está muy por delante de todo lo demás, y luego otras áreas en las que todavía se encuentra en las primeras etapas. Todavía hay muchas áreas donde el ML sigue creciendo, por lo que es clave ser consciente de sus límites actuales.

¿Con qué valor de Roblox se alinea más tu equipo?

El respeto a la comunidad es nuestro valor rector durante todo este proceso. Primero, debemos centrarnos en mejorar el civismo y reducir las violaciones de políticas en nuestra plataforma. Esto tiene un impacto significativo en la experiencia general del usuario. En segundo lugar, debemos considerar cuidadosamente cómo implementamos estas nuevas funciones. Debemos tener en cuenta los falsos positivos (por ejemplo, marcar incorrectamente algo como abuso) en el modelo y evitar penalizar incorrectamente a los usuarios. Monitorear el desempeño de nuestros modelos y su impacto en la participación de los usuarios es crucial.

¿Qué es lo que más te emociona acerca de hacia dónde se dirigen Roblox y tu equipo?

Hemos logrado avances significativos en la mejora de la comunicación de voz pública, pero aún queda mucho por hacer. La comunicación privada es un área interesante para explorar. Creo que existe una gran oportunidad para mejorar la comunicación privada, permitir a los usuarios expresarse con amigos cercanos, realizar una llamada de voz entre experiencias o durante una experiencia mientras interactúan con sus amigos. Creo que también existe la oportunidad de fomentar estas comunidades con mejores herramientas que permitan a los usuarios autoorganizarse, unirse a comunidades, compartir contenido e ideas.

A medida que continuamos creciendo, ¿cómo escalamos nuestra tecnología de chat para respaldar a estas comunidades en expansión? Estamos apenas arañando la superficie de mucho de lo que podemos hacer, y creo que existe la posibilidad de mejorar el civismo de la comunicación y la colaboración en línea en toda la industria de una manera que no se ha hecho antes. Con la tecnología y las capacidades de aprendizaje automático adecuadas, estamos en una posición única para dar forma al futuro de la comunicación civil en línea.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://blog.roblox.com/2024/01/inside-the-tech-solving-for-safety-in-immersive-voice-communication/

- :posee

- :es

- :no

- :dónde

- $ UP

- 20

- a

- capacidad

- Poder

- Nuestra Empresa

- abuso

- la exactitud

- preciso

- precisamente

- a través de

- la columna Acción

- acciones

- dirección

- direccionamiento

- avances

- Después

- edad

- adelante

- objetivo

- alinear

- Todos

- permitir

- casi

- ya haya utilizado

- también

- hacerlo

- an

- analizar

- y

- Andrés

- anonimato

- cualquier

- enfoques

- adecuado

- somos

- Reservada

- áreas

- en torno a

- AS

- At

- audio

- Confirmación de Viaje

- automáticamente

- avatares

- evitar

- conscientes

- basado

- BE

- esto

- antes

- comenzar

- comportamiento

- detrás de

- "Ser"

- mejores

- entre

- Big

- Mayor

- Blog

- Construir la

- intimidación

- pero

- by

- llamar al

- PUEDEN

- capacidades

- estudiar cuidadosamente

- ceo

- a ciertos

- Reto

- retos

- desafiante

- oportunidad

- chat

- civil

- Cerrar

- de cerca

- competente

- colaboración

- combinación

- compromiso

- Comunicación

- Comunidades

- vibrante e inclusiva

- integraciones

- confianza

- seguros

- Contacto

- Consecuencias

- Considerar

- considerable

- contenido

- continue

- Conversación

- Parejas

- Para crear

- crea

- Creamos

- crucial

- Current

- datos

- David

- acuerdo

- más profundo

- Dependiente

- depende

- detectar

- Detección

- desarrollado

- el desarrollo

- una experiencia diferente

- digital

- Director

- Discriminación

- distinguir

- do

- sí

- "Hacer"

- hecho

- dos

- durante

- e

- Temprano en la

- edición

- educar

- de manera eficaz

- más

- Empatía

- habilitar

- permite

- final

- de extremo a extremo

- de su negocio.

- ingeniero

- Ingeniería

- Inglés

- Entorno

- episodio

- etc.

- Incluso

- todos

- todo

- evolución

- excitado

- excita

- emocionante

- en expansión

- experience

- Experiencias

- explorar

- Explorar

- expreso

- tener problemas con

- factores importantes

- false

- Caracteristicas

- realimentación

- sentir

- se siente

- Nombre

- Focus

- centrado

- Formularios

- Cuidados de acogida

- amigos

- Desde

- frontal o trasero

- Interfaz

- futuras

- juego de azar

- dado

- Go

- objetivo

- Va

- va

- Crecer

- Creciendo

- guía

- puñado

- encargarse de

- Manejo

- acoso

- Difícil

- Tienen

- cabeza

- encabezada

- oír

- Corazón

- ayudando

- altamente

- esperanza

- Cómo

- Sin embargo

- HTTPS

- enorme

- Humanos

- i

- ideas

- Identifique

- if

- inmersiva

- Impacto

- importante

- mejorar

- mejorado

- la mejora de

- in

- incorrectamente

- energético

- originales

- dentro

- ejemplo

- intenciones

- interactuar

- interacciones

- dentro

- IT

- SUS

- únete

- solo

- justificado

- Clave

- Etiquetas

- Falta

- carente

- Idiomas

- Apellido

- Finalmente

- lanzado

- lanzamiento

- APRENDE:

- aprendido

- aprendizaje

- izquierda

- Nivel

- Apalancamiento

- Vida

- como

- que otros

- Limitada

- límites

- Mira

- mirando

- MIRADAS

- Lote

- máquina

- máquina de aprendizaje

- hecho

- el mantenimiento de

- Mayoría

- para lograr

- Realizar

- gerente

- muchos

- marcado

- me

- significa

- medidas

- mente

- ML

- modelo

- modelos

- moderada

- moderación

- monitoreo

- meses

- más,

- MEJOR DE TU

- cuales son las que reflejan

- mucho más

- múltiples

- debe

- my

- yo mismo

- ¿ Necesita ayuda

- Nuevo

- Nuevas características

- normas

- notificaciones

- of

- Ofertas

- a menudo

- on

- ONE

- en línea

- Juego en linea

- , solamente

- habiertos

- de código abierto

- Oportunidad

- or

- solicite

- Otro

- Otros

- nuestros

- salir

- Supera

- Más de

- total

- EL DESARROLLADOR

- .

- Personas

- actuación

- plataforma

- Plataformas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- Podcast

- políticas

- política

- posición

- positivo

- posible

- posible

- industria

- necesidad

- bastante

- Director de la escuela

- priorizar

- privada

- Proactiva

- Problema

- tratamiento

- Producto

- gerente de producto

- BLASFEMIA

- Progreso

- destacado

- promover

- Promoción

- proporcionar

- proporciona un

- público

- Push

- poner

- Pone

- calidad

- datos de calidad

- real

- vida real

- mundo real

- en tiempo real

- realista

- realmente

- recientemente

- la reducción de

- Informes

- responder

- una estrategia SEO para aparecer en las búsquedas de Google.

- Derecho

- Roblox

- Rodar

- ambiente seguro

- Safety

- Sarcasmo

- Escala

- Segundo

- ver

- ver

- parece

- mayor

- Serie

- set

- Forma

- Compartir

- Signal

- importante

- significativamente

- desde

- So

- Social

- Soluciones

- RESOLVER

- Resolver

- algo

- Alguien

- algo

- Fuente

- Espacio

- Espacial

- De una Charla a tu equipo

- habla

- etapas

- en pie

- Sin embargo

- tal

- SOPORTE

- seguro

- Superficie

- Switch

- te

- Todas las funciones a su disposición

- entrada

- abordando

- ¡Prepárate!

- toma

- Discursos

- equipo

- tecnología

- Técnico

- Tecnologías

- Tecnología

- testamento

- que

- esa

- La

- El futuro de las

- su

- sí mismos

- luego

- Ahí.

- Estas

- ellos

- cosas

- pensar

- así

- aquellos

- pensamiento

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- a lo largo de

- equipo

- a

- TONO

- El tono de voz

- parte superior

- Entrenar

- Formación

- la traducción

- dos

- tipo

- tipos

- superior

- entender

- comprensión

- único

- us

- usado

- Usuario

- experiencia como usuario

- usuarios

- usando

- propuesta de

- variedad

- Violaciónes

- Voz

- quieres

- Camino..

- formas

- we

- tuvieron

- ¿

- Que es

- cuando

- sean

- que

- mientras

- dentro de

- fue testigo de

- Palabra

- Actividades:

- trabajado

- trabajando

- funciona

- mundo

- Usted

- tú

- zephyrnet