Σήμερα, είμαστε στην ευχάριστη θέση να ανακοινώσουμε τη διαθεσιμότητα της υποστήριξης συμπερασμάτων και τελειοποίησης του Llama 2 στο Aws trainium και Αίσθηση AWS περιπτώσεις σε Amazon SageMaker JumpStart. Η χρήση παρουσιών που βασίζονται στο AWS Trainium και το Inferentia, μέσω του SageMaker, μπορεί να βοηθήσει τους χρήστες να μειώσουν το κόστος μικροσυντονισμού έως και 50% και να μειώσουν το κόστος ανάπτυξης κατά 4.7 φορές, ενώ μειώνουν την καθυστέρηση ανά διακριτικό. Το Llama 2 είναι ένα μοντέλο γλώσσας κειμένου με δυνατότητα δημιουργίας αυτόματης παλινδρόμησης που χρησιμοποιεί μια βελτιστοποιημένη αρχιτεκτονική μετασχηματιστή. Ως μοντέλο διαθέσιμο στο κοινό, το Llama 2 έχει σχεδιαστεί για πολλές εργασίες NLP, όπως ταξινόμηση κειμένου, ανάλυση συναισθημάτων, μετάφραση γλώσσας, μοντελοποίηση γλώσσας, δημιουργία κειμένου και συστήματα διαλόγου. Η τελειοποίηση και η ανάπτυξη LLM, όπως το Llama 2, μπορεί να γίνει δαπανηρή ή δύσκολη η επίτευξη απόδοσης σε πραγματικό χρόνο για την παροχή καλής εμπειρίας στον πελάτη. Trainium και AWS Inferentia, ενεργοποιημένα από το AWS Neuron κιτ ανάπτυξης λογισμικού (SDK), προσφέρει μια υψηλής απόδοσης και οικονομικά αποδοτική επιλογή για εκπαίδευση και συμπέρασμα μοντέλων Llama 2.

Σε αυτήν την ανάρτηση, δείχνουμε πώς να αναπτύξετε και να ρυθμίσετε με ακρίβεια το Llama 2 σε περιπτώσεις Trainium και AWS Inferentia στο SageMaker JumpStart.

Επισκόπηση λύσεων

Σε αυτό το ιστολόγιο, θα δούμε τα ακόλουθα σενάρια:

- Αναπτύξτε το Llama 2 σε περιπτώσεις Inferentia AWS και στα δύο Στούντιο Amazon SageMaker UI, με εμπειρία ανάπτυξης με ένα κλικ και το SageMaker Python SDK.

- Βελτιστοποιήστε το Llama 2 σε περιπτώσεις Trainium τόσο στο SageMaker Studio UI όσο και στο SageMaker Python SDK.

- Συγκρίνετε την απόδοση του βελτιστοποιημένου μοντέλου Llama 2 με εκείνη του προεκπαιδευμένου μοντέλου για να δείξετε την αποτελεσματικότητα της μικρορύθμισης.

Για να το αποκτήσετε, δείτε το Παράδειγμα σημειωματάριου GitHub.

Αναπτύξτε το Llama 2 σε περιπτώσεις AWS Inferentia χρησιμοποιώντας το SageMaker Studio UI και το Python SDK

Σε αυτήν την ενότητα, παρουσιάζουμε πώς να αναπτύξετε το Llama 2 σε παρουσίες AWS Inferentia χρησιμοποιώντας τη διεπαφή χρήστη SageMaker Studio για ανάπτυξη με ένα κλικ και το Python SDK.

Ανακαλύψτε το μοντέλο Llama 2 στο SageMaker Studio UI

Το SageMaker JumpStart παρέχει πρόσβαση τόσο σε δημόσια διαθέσιμα όσο και σε ιδιόκτητα μοντέλα θεμελίωσης. Τα μοντέλα θεμελίωσης ενσωματώνονται και συντηρούνται από τρίτους και ιδιόκτητους παρόχους. Ως εκ τούτου, κυκλοφορούν με διαφορετικές άδειες χρήσης, όπως ορίζονται από την πηγή του μοντέλου. Φροντίστε να ελέγξετε την άδεια χρήσης για οποιοδήποτε μοντέλο βάσης που χρησιμοποιείτε. Είστε υπεύθυνοι για τον έλεγχο και τη συμμόρφωση με τυχόν ισχύοντες όρους άδειας χρήσης και για να βεβαιωθείτε ότι είναι αποδεκτοί για την περίπτωση χρήσης σας πριν από τη λήψη ή τη χρήση του περιεχομένου.

Μπορείτε να αποκτήσετε πρόσβαση στα μοντέλα βάσης Llama 2 μέσω του SageMaker JumpStart στο SageMaker Studio UI και στο SageMaker Python SDK. Σε αυτήν την ενότητα, θα δούμε πώς να ανακαλύψετε τα μοντέλα στο SageMaker Studio.

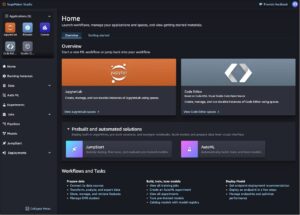

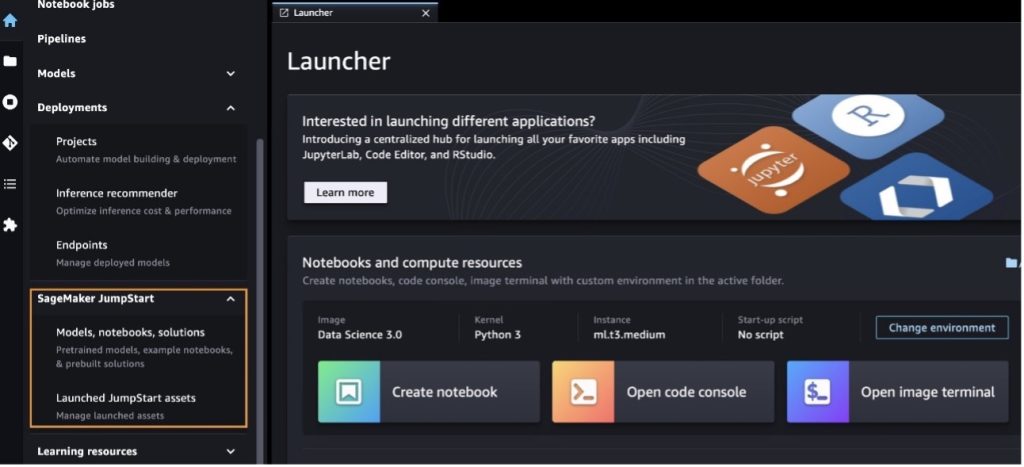

Το SageMaker Studio είναι ένα ολοκληρωμένο περιβάλλον ανάπτυξης (IDE) που παρέχει μια ενιαία οπτική διεπαφή βασισμένη στον ιστό, όπου μπορείτε να έχετε πρόσβαση σε ειδικά κατασκευασμένα εργαλεία για να εκτελέσετε όλα τα βήματα ανάπτυξης μηχανικής μάθησης (ML), από την προετοιμασία δεδομένων έως τη δημιουργία, την εκπαίδευση και την ανάπτυξη της ML σας μοντέλα. Για περισσότερες λεπτομέρειες σχετικά με το πώς να ξεκινήσετε και να ρυθμίσετε το SageMaker Studio, ανατρέξτε στο Amazon SageMaker Studio.

Αφού είστε στο SageMaker Studio, μπορείτε να αποκτήσετε πρόσβαση στο SageMaker JumpStart, το οποίο περιέχει προεκπαιδευμένα μοντέλα, σημειωματάρια και προκατασκευασμένες λύσεις, κάτω από Προκατασκευασμένες και αυτοματοποιημένες λύσεις. Για πιο λεπτομερείς πληροφορίες σχετικά με τον τρόπο πρόσβασης σε ιδιόκτητα μοντέλα, ανατρέξτε στο Χρησιμοποιήστε ιδιόκτητα μοντέλα θεμελίωσης από το Amazon SageMaker JumpStart στο Amazon SageMaker Studio.

Από τη σελίδα προορισμού του SageMaker JumpStart, μπορείτε να αναζητήσετε λύσεις, μοντέλα, σημειωματάρια και άλλους πόρους.

Εάν δεν βλέπετε τα μοντέλα Llama 2, ενημερώστε την έκδοση του SageMaker Studio τερματίζοντας και επανεκκινώντας. Για περισσότερες πληροφορίες σχετικά με τις ενημερώσεις έκδοσης, ανατρέξτε στο Τερματίστε και ενημερώστε τις Κλασικές εφαρμογές του Studio.

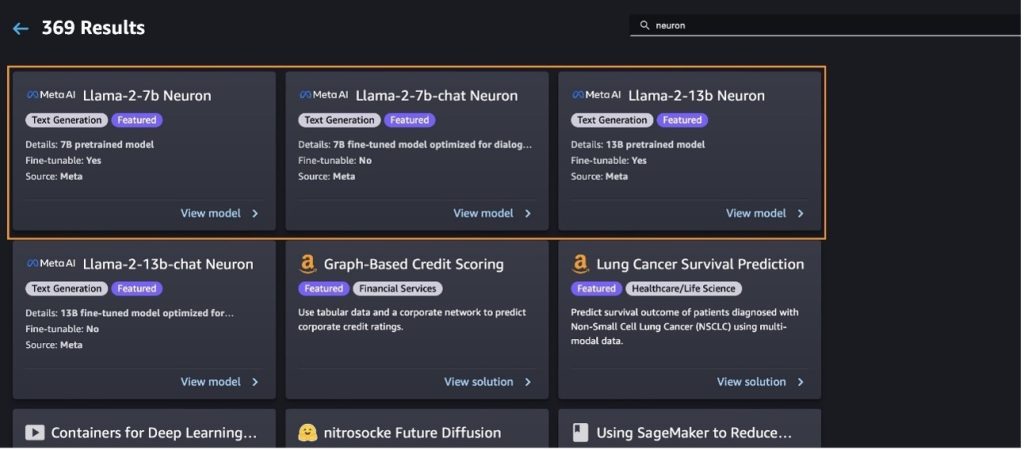

Μπορείτε επίσης να βρείτε άλλες παραλλαγές μοντέλων επιλέγοντας Εξερευνήστε όλα τα μοντέλα δημιουργίας κειμένου ή αναζητώντας llama or neuron στο πλαίσιο αναζήτησης. Θα μπορείτε να δείτε τα μοντέλα Llama 2 Neuron σε αυτή τη σελίδα.

Αναπτύξτε το μοντέλο Llama-2-13b με το SageMaker Jumpstart

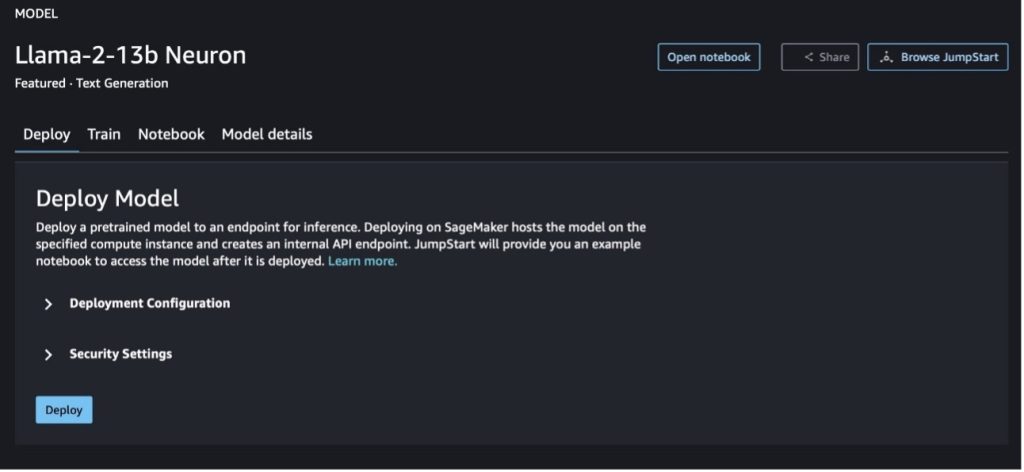

Μπορείτε να επιλέξετε την κάρτα μοντέλου για να δείτε λεπτομέρειες σχετικά με το μοντέλο, όπως άδεια χρήσης, δεδομένα που χρησιμοποιούνται για την εκπαίδευση και πώς να το χρησιμοποιήσετε. Μπορείτε επίσης να βρείτε δύο κουμπιά, Ανάπτυξη και Ανοίξτε το σημειωματάριο, που σας βοηθούν να χρησιμοποιήσετε το μοντέλο χρησιμοποιώντας αυτό το παράδειγμα χωρίς κώδικα.

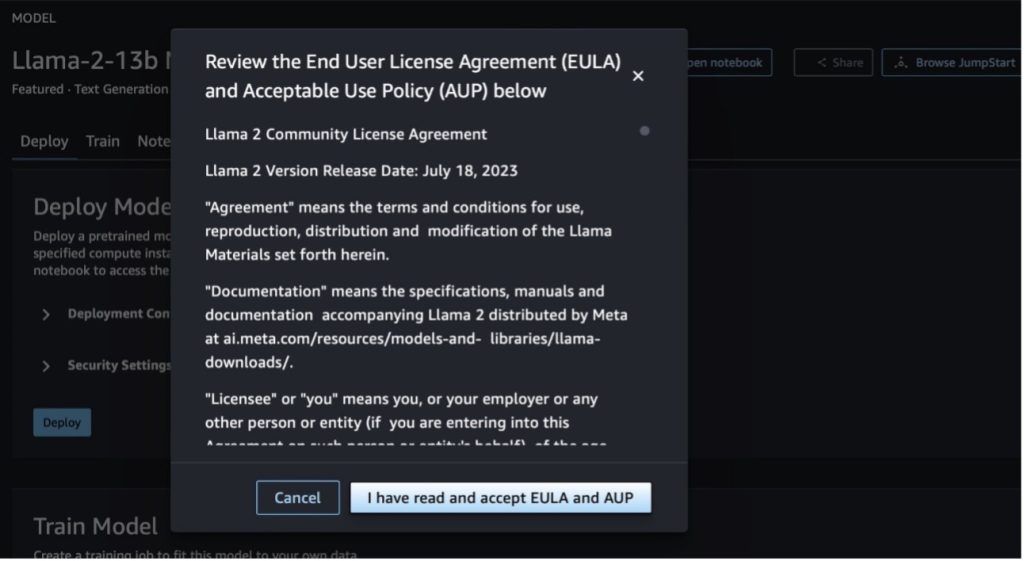

Όταν επιλέγετε οποιοδήποτε κουμπί, ένα αναδυόμενο παράθυρο θα εμφανίσει τη Συμφωνία Άδειας Χρήσης Τελικού Χρήστη και την Πολιτική Αποδεκτής Χρήσης (AUP) για να το αναγνωρίσετε.

Αφού αναγνωρίσετε τις πολιτικές, μπορείτε να αναπτύξετε το τελικό σημείο του μοντέλου και να το χρησιμοποιήσετε μέσω των βημάτων στην επόμενη ενότητα.

Αναπτύξτε το μοντέλο Llama 2 Neuron μέσω του Python SDK

Όταν επιλέγετε Ανάπτυξη και να αναγνωρίσετε τους όρους, θα ξεκινήσει η ανάπτυξη του μοντέλου. Εναλλακτικά, μπορείτε να αναπτύξετε μέσω του παραδείγματος σημειωματάριο επιλέγοντας Ανοίξτε το σημειωματάριο. Το παράδειγμα σημειωματάριο παρέχει καθοδήγηση από άκρο σε άκρο σχετικά με τον τρόπο ανάπτυξης του μοντέλου για εξαγωγή συμπερασμάτων και εκκαθάριση πόρων.

Για να αναπτύξετε ή να τελειοποιήσετε ένα μοντέλο σε περιπτώσεις Trainium ή AWS Inferentia, πρέπει πρώτα να καλέσετε το PyTorch Neuron (πυρσός-νεύρος) για τη μεταγλώττιση του μοντέλου σε ένα γράφημα ειδικό για τον Νευρώνα, το οποίο θα το βελτιστοποιήσει για τους NeuronCores της Inferentia. Οι χρήστες μπορούν να δώσουν εντολή στον μεταγλωττιστή να βελτιστοποιήσει για τη χαμηλότερη καθυστέρηση ή την υψηλότερη απόδοση, ανάλογα με τους στόχους της εφαρμογής. Στο JumpStart, προ-μεταγλωττίσαμε τα γραφήματα Neuron για μια ποικιλία διαμορφώσεων, για να επιτρέψουμε στους χρήστες να περάσουν τα βήματα της μεταγλώττισης, επιτρέποντας ταχύτερο συντονισμό και ανάπτυξη μοντέλων.

Σημειώστε ότι το προμεταγλωττισμένο γράφημα Neuron δημιουργείται με βάση μια συγκεκριμένη έκδοση της έκδοσης Neuron Compiler.

Υπάρχουν δύο τρόποι ανάπτυξης του LIama 2 σε περιπτώσεις που βασίζονται σε AWS Inferentia. Η πρώτη μέθοδος χρησιμοποιεί την προ-ενσωματωμένη διαμόρφωση και σας επιτρέπει να αναπτύξετε το μοντέλο σε δύο μόνο γραμμές κώδικα. Στο δεύτερο, έχετε μεγαλύτερο έλεγχο στη διαμόρφωση. Ας ξεκινήσουμε με την πρώτη μέθοδο, με την προκατασκευασμένη διαμόρφωση και χρησιμοποιούμε το προεκπαιδευμένο μοντέλο Llama 2 13B Neuron, ως παράδειγμα. Ο παρακάτω κώδικας δείχνει πώς να αναπτύξετε το Llama 13B με δύο μόνο γραμμές:

Για να εκτελέσετε συμπέρασμα σε αυτά τα μοντέλα, πρέπει να καθορίσετε το όρισμα accept_eula να είναι True ως μέρος του model.deploy() κλήση. Ορίζοντας αυτό το επιχείρημα ως αληθές, αναγνωρίζετε ότι έχετε διαβάσει και αποδεχτεί την EULA του μοντέλου. Η EULA μπορεί να βρεθεί στην περιγραφή της κάρτας μοντέλου ή από το Ιστοσελίδα Meta.

Ο προεπιλεγμένος τύπος παρουσίας για το Llama 2 13B είναι ml.inf2.8xlarge. Μπορείτε επίσης να δοκιμάσετε άλλα αναγνωριστικά υποστηριζόμενων μοντέλων:

meta-textgenerationneuron-llama-2-7bmeta-textgenerationneuron-llama-2-7b-f(μοντέλο συνομιλίας)meta-textgenerationneuron-llama-2-13b-f(μοντέλο συνομιλίας)

Εναλλακτικά, εάν θέλετε να έχετε περισσότερο έλεγχο των διαμορφώσεων ανάπτυξης, όπως το μήκος περιβάλλοντος, ο παράλληλος βαθμός τανυστή και το μέγιστο μέγεθος κυλιόμενης παρτίδας, μπορείτε να τις τροποποιήσετε μέσω περιβαλλοντικών μεταβλητών, όπως φαίνεται σε αυτήν την ενότητα. Το υποκείμενο Deep Learning Container (DLC) της ανάπτυξης είναι το DLC NeuronX με μεγάλο μοντέλο συμπερασμάτων (LMI).. Οι περιβαλλοντικές μεταβλητές είναι οι εξής:

- OPTION_N_POSITIONS – Ο μέγιστος αριθμός διακριτικών εισόδου και εξόδου. Για παράδειγμα, εάν μεταγλωττίσετε το μοντέλο με

OPTION_N_POSITIONSως 512, τότε μπορείτε να χρησιμοποιήσετε ένα διακριτικό εισόδου 128 (μέγεθος προτροπής εισόδου) με μέγιστο διακριτικό εξόδου 384 (το σύνολο των διακριτικών εισόδου και εξόδου πρέπει να είναι 512). Για το μέγιστο διακριτικό εξόδου, οποιαδήποτε τιμή κάτω από το 384 είναι καλή, αλλά δεν μπορείτε να προχωρήσετε πέρα από αυτό (για παράδειγμα, είσοδος 256 και έξοδος 512). - OPTION_TENSOR_PARALLEL_DEGREE – Ο αριθμός των NeuronCores για φόρτωση του μοντέλου σε περιπτώσεις AWS Inferentia.

- OPTION_MAX_ROLLING_BATCH_SIZE – Το μέγιστο μέγεθος παρτίδας για ταυτόχρονες αιτήσεις.

- OPTION_DTYPE – Ο τύπος ημερομηνίας για τη φόρτωση του μοντέλου.

Η σύνταξη του γραφήματος νευρώνων εξαρτάται από το μήκος περιβάλλοντος (OPTION_N_POSITIONS), παράλληλος βαθμός τανυστή (OPTION_TENSOR_PARALLEL_DEGREE), μέγιστο μέγεθος παρτίδας (OPTION_MAX_ROLLING_BATCH_SIZE), και τύπο δεδομένων (OPTION_DTYPE) για να φορτώσετε το μοντέλο. Το SageMaker JumpStart έχει προ-μεταγλωττίσει γραφήματα Neuron για μια ποικιλία διαμορφώσεων για τις προηγούμενες παραμέτρους για να αποφευχθεί η μεταγλώττιση χρόνου εκτέλεσης. Οι διαμορφώσεις των προμεταγλωττισμένων γραφημάτων παρατίθενται στον παρακάτω πίνακα. Εφόσον οι περιβαλλοντικές μεταβλητές εμπίπτουν σε μία από τις ακόλουθες κατηγορίες, η συλλογή γραφημάτων Neuron θα παραλειφθεί.

| Συνομιλία LIama-2 7B και LIama-2 7B | ||||

| Τύπος παρουσίας | OPTION_N_POSITIONS | OPTION_MAX_ROLLING_BATCH_SIZE | OPTION_TENSOR_PARALLEL_DEGREE | OPTION_DTYPE |

| ml.inf2.xlarge | 1024 | 1 | 2 | Fp16 |

| ml.inf2.8xlarge | 2048 | 1 | 2 | Fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 4 | Fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 8 | Fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 12 | Fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 4 | Fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 8 | Fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 12 | Fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 24 | Fp16 |

| Συνομιλία LIama-2 13B και LIama-2 13B | ||||

| ml.inf2.8xlarge | 1024 | 1 | 2 | Fp16 |

| ml.inf2.24xlarge | 2048 | 4 | 4 | Fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 8 | Fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 12 | Fp16 |

| ml.inf2.48xlarge | 2048 | 4 | 4 | Fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 8 | Fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 12 | Fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 24 | Fp16 |

Το παρακάτω είναι ένα παράδειγμα ανάπτυξης του Llama 2 13B και ρύθμισης όλων των διαθέσιμων διαμορφώσεων.

Τώρα που έχουμε αναπτύξει το μοντέλο Llama-2-13b, μπορούμε να εκτελέσουμε συμπέρασμα με αυτό καλώντας το τελικό σημείο. Το ακόλουθο απόσπασμα κώδικα δείχνει τη χρήση των υποστηριζόμενων παραμέτρων συμπερασμάτων για τον έλεγχο της δημιουργίας κειμένου:

- μέγιστο μήκος – Το μοντέλο δημιουργεί κείμενο μέχρι να φτάσει το μήκος εξόδου (το οποίο περιλαμβάνει το μήκος του περιβάλλοντος εισαγωγής).

max_length. Εάν ορίζεται, πρέπει να είναι θετικός ακέραιος. - max_new_tokens – Το μοντέλο δημιουργεί κείμενο μέχρι να φτάσει το μήκος εξόδου (εξαιρουμένου του μήκους περιβάλλοντος εισαγωγής).

max_new_tokens. Εάν ορίζεται, πρέπει να είναι θετικός ακέραιος. - num_beams – Αυτό υποδεικνύει τον αριθμό των ακτίνων που χρησιμοποιούνται στην άπληστη αναζήτηση. Εάν ορίζεται, πρέπει να είναι ακέραιος αριθμός μεγαλύτερος ή ίσος με

num_return_sequences. - no_repeat_ngram_size – Το μοντέλο διασφαλίζει ότι μια ακολουθία λέξεων του

no_repeat_ngram_sizeδεν επαναλαμβάνεται στην ακολουθία εξόδου. Εάν ορίζεται, πρέπει να είναι θετικός ακέραιος μεγαλύτερος από 1. - θερμοκρασία – Αυτό ελέγχει την τυχαιότητα στην έξοδο. Μια υψηλότερη θερμοκρασία οδηγεί σε μια ακολουθία εξόδου με λέξεις χαμηλής πιθανότητας. μια χαμηλότερη θερμοκρασία οδηγεί σε μια ακολουθία εξόδου με λέξεις υψηλής πιθανότητας. Αν

temperatureισούται με 0, καταλήγει σε άπληστη αποκωδικοποίηση. Εάν καθορίζεται, πρέπει να είναι θετικός float. - νωρίς_διακοπή - Αν

True, η δημιουργία κειμένου ολοκληρώνεται όταν όλες οι υποθέσεις δέσμης φτάσουν στο τέλος της πρότασης. Εάν ορίζεται, πρέπει να είναι Boolean. - do_sample - Αν

True, το μοντέλο λαμβάνει δείγματα της επόμενης λέξης σύμφωνα με την πιθανότητα. Εάν ορίζεται, πρέπει να είναι Boolean. - top_k – Σε κάθε βήμα δημιουργίας κειμένου, το μοντέλο λαμβάνει δείγματα μόνο από το

top_kπιθανότατα λόγια. Εάν ορίζεται, πρέπει να είναι θετικός ακέραιος. - top_p – Σε κάθε βήμα δημιουργίας κειμένου, το μοντέλο λαμβάνει δείγματα από το μικρότερο δυνατό σύνολο λέξεων με αθροιστική πιθανότητα

top_p. Εάν καθορίζεται, πρέπει να είναι float μεταξύ 0–1. - στάση – Εάν ορίζεται, πρέπει να είναι μια λίστα συμβολοσειρών. Η δημιουργία κειμένου σταματά αν δημιουργηθεί οποιαδήποτε από τις καθορισμένες συμβολοσειρές.

Ο παρακάτω κώδικας δείχνει ένα παράδειγμα:

Παραγωγή:

Για περισσότερες πληροφορίες σχετικά με τις παραμέτρους στο ωφέλιμο φορτίο, ανατρέξτε στο Λεπτομερείς παράμετροι.

Μπορείτε επίσης να εξερευνήσετε την υλοποίηση των παραμέτρων στο σημειωματάριο για να προσθέσετε περισσότερες πληροφορίες σχετικά με το σύνδεσμο του σημειωματάριου.

Βελτιώστε τα μοντέλα Llama 2 σε περιπτώσεις Trainium χρησιμοποιώντας το SageMaker Studio UI και το SageMaker Python SDK

Τα βασικά μοντέλα τεχνητής νοημοσύνης που δημιουργούνται έχουν γίνει πρωταρχική εστίαση στο ML και το AI, ωστόσο, η ευρεία γενίκευσή τους μπορεί να υπολείπεται σε συγκεκριμένους τομείς όπως η υγειονομική περίθαλψη ή οι χρηματοοικονομικές υπηρεσίες, όπου εμπλέκονται μοναδικά σύνολα δεδομένων. Αυτός ο περιορισμός υπογραμμίζει την ανάγκη προσαρμογής αυτών των μοντέλων δημιουργίας τεχνητής νοημοσύνης με δεδομένα για συγκεκριμένους τομείς για τη βελτίωση της απόδοσής τους σε αυτούς τους εξειδικευμένους τομείς.

Τώρα που αναπτύξαμε την προεκπαιδευμένη έκδοση του μοντέλου Llama 2, ας δούμε πώς μπορούμε να το προσαρμόσουμε με ακρίβεια σε δεδομένα για συγκεκριμένο τομέα για να αυξήσουμε την ακρίβεια, να βελτιώσουμε το μοντέλο όσον αφορά τις γρήγορες ολοκληρώσεις και να προσαρμόσουμε το μοντέλο σε συγκεκριμένη περίπτωση και δεδομένα επιχειρηματικής χρήσης. Μπορείτε να ρυθμίσετε τα μοντέλα χρησιμοποιώντας είτε το SageMaker Studio UI είτε το SageMaker Python SDK. Συζητάμε και τις δύο μεθόδους σε αυτή την ενότητα.

Βελτιώστε το μοντέλο Llama-2-13b Neuron με το SageMaker Studio

Στο SageMaker Studio, μεταβείτε στο μοντέλο Llama-2-13b Neuron. Στο Ανάπτυξη καρτέλα, μπορείτε να υποδείξετε το Απλή υπηρεσία αποθήκευσης Amazon (Amazon S3) κάδος που περιέχει τα σύνολα δεδομένων εκπαίδευσης και επικύρωσης για τελειοποίηση. Επιπλέον, μπορείτε να διαμορφώσετε τις ρυθμίσεις παραμέτρων ανάπτυξης, τις υπερπαραμέτρους και τις ρυθμίσεις ασφαλείας για μικροσυντονισμό. Στη συνέχεια επιλέξτε Τρένο για να ξεκινήσετε την εργασία εκπαίδευσης σε μια παρουσία του SageMaker ML.

Για να χρησιμοποιήσετε μοντέλα Llama 2, πρέπει να αποδεχτείτε το EULA και το AUP. Θα εμφανιστεί όταν το επιλέξετε Τρένο. Επιλέξτε Έχω διαβάσει και αποδέχομαι EULA και AUP για να ξεκινήσετε τη δουλειά μικρορύθμισης.

Μπορείτε να δείτε την κατάσταση της εργασίας εκπαίδευσης για το βελτιωμένο μοντέλο στην κονσόλα SageMaker επιλέγοντας Εργασίες κατάρτισης στο παράθυρο πλοήγησης.

Μπορείτε είτε να προσαρμόσετε το μοντέλο Llama 2 Neuron χρησιμοποιώντας αυτό το παράδειγμα χωρίς κώδικα είτε να ρυθμίσετε με ακρίβεια το Python SDK, όπως φαίνεται στην επόμενη ενότητα.

Βελτιστοποιήστε το μοντέλο Llama-2-13b Neuron μέσω του SageMaker Python SDK

Μπορείτε να ρυθμίσετε με ακρίβεια το σύνολο δεδομένων με τη μορφή προσαρμογής τομέα ή το λεπτομέρεια βασισμένη σε οδηγίες μορφή. Ακολουθούν οι οδηγίες για τον τρόπο με τον οποίο πρέπει να μορφοποιηθούν τα δεδομένα εκπαίδευσης πριν αποσταλούν σε λεπτομέρεια:

- Εισαγωγή - Μια

trainκατάλογο που περιέχει είτε ένα αρχείο με μορφοποίηση JSON lines (.jsonl) είτε κείμενο (.txt).- Για το αρχείο γραμμών JSON (.jsonl), κάθε γραμμή είναι ένα ξεχωριστό αντικείμενο JSON. Κάθε αντικείμενο JSON θα πρέπει να είναι δομημένο ως ζεύγος κλειδιού-τιμής, όπου πρέπει να βρίσκεται το κλειδί

text, και η αξία είναι το περιεχόμενο ενός παραδείγματος εκπαίδευσης. - Ο αριθμός των αρχείων στον κατάλογο τρένου πρέπει να είναι ίσος με 1.

- Για το αρχείο γραμμών JSON (.jsonl), κάθε γραμμή είναι ένα ξεχωριστό αντικείμενο JSON. Κάθε αντικείμενο JSON θα πρέπει να είναι δομημένο ως ζεύγος κλειδιού-τιμής, όπου πρέπει να βρίσκεται το κλειδί

- Παραγωγή – Ένα εκπαιδευμένο μοντέλο που μπορεί να αναπτυχθεί για συμπεράσματα.

Σε αυτό το παράδειγμα, χρησιμοποιούμε ένα υποσύνολο του Δεδομένα Dolly σε μορφή συντονισμού εντολών. Το σύνολο δεδομένων Dolly περιέχει περίπου 15,000 εγγραφές που ακολουθούν οδηγίες για διάφορες κατηγορίες, όπως απαντήσεις σε ερωτήσεις, σύνοψη και εξαγωγή πληροφοριών. Είναι διαθέσιμο με την άδεια Apache 2.0. Χρησιμοποιούμε το information_extraction παραδείγματα για μικρορύθμιση.

- Φορτώστε το σύνολο δεδομένων Dolly και χωρίστε το σε

train(για μικρορύθμιση) καιtest(για αξιολόγηση):

- Χρησιμοποιήστε ένα πρότυπο προτροπής για την προεπεξεργασία των δεδομένων σε μια μορφή οδηγιών για την εργασία εκπαίδευσης:

- Εξετάστε τις υπερπαραμέτρους και αντικαταστήστε τις για δική σας περίπτωση χρήσης:

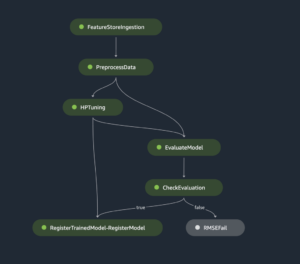

- Βελτιστοποιήστε το μοντέλο και ξεκινήστε μια εργασία εκπαίδευσης στο SageMaker. Τα σενάρια λεπτομέρειας βασίζονται στο νευρώνας-νεμο-μεγατρόν αποθετήριο, τα οποία είναι τροποποιημένες εκδόσεις των πακέτων nemo και Κορυφή που έχουν προσαρμοστεί για χρήση με περιπτώσεις Neuron και EC2 Trn1. ο νευρώνας-νεμο-μεγατρόν Το αποθετήριο έχει παραλληλισμό 3D (δεδομένα, τανυστής και διοχέτευση) για να σας επιτρέψει να ρυθμίσετε με ακρίβεια τα LLM σε κλίμακα. Οι υποστηριζόμενες περιπτώσεις Trainium είναι ml.trn1.32xlarge και ml.trn1n.32xlarge.

- Τέλος, αναπτύξτε το τελειοποιημένο μοντέλο σε ένα τελικό σημείο του SageMaker:

Συγκρίνετε τις αποκρίσεις μεταξύ των προεκπαιδευμένων και βελτιωμένων μοντέλων Llama 2 Neuron

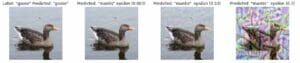

Τώρα που έχουμε αναπτύξει την προεκπαιδευμένη έκδοση του μοντέλου Llama-2-13b και τη βελτιστοποιήσαμε, μπορούμε να δούμε μερικές από τις συγκρίσεις απόδοσης των άμεσων ολοκληρώσεων και από τα δύο μοντέλα, όπως φαίνεται στον παρακάτω πίνακα. Προσφέρουμε επίσης ένα παράδειγμα για να τελειοποιήσετε το Llama 2 σε ένα σύνολο δεδομένων αρχειοθέτησης SEC σε μορφή .txt. Για λεπτομέρειες, δείτε το Παράδειγμα σημειωματάριου GitHub.

| Είδος | Είσοδοι | Επίγεια αλήθεια | Απάντηση από μη λεπτομερές μοντέλο | Απάντηση από τελειοποιημένο μοντέλο |

| 1 | Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που να ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγίες:nΕξαγωγή πανεπιστημίων στα οποία σπούδασε ο Moret και το έτος αποφοίτησής του για καθένα και βάλτε τα σε μια λίστα με κουκκίδες.nn### Εισαγωγή:nΟ Μορέτ γεννήθηκε το 1953 στο Vevey της Ελβετίας , και έκανε τις προπτυχιακές του σπουδές στην École Polytechnique Fédérale de Lausanne (EPFL), αποφοιτώντας το 1975. Συνέχισε τις μεταπτυχιακές του σπουδές στο Πανεπιστήμιο του Tennessee, αποκτώντας Ph.D. το 1980. Στη συνέχεια εντάχθηκε στη σχολή του Πανεπιστημίου του Νέου Μεξικού, όπου παρέμεινε μέχρι το 2006, όταν μετακόμισε στο EPFL. Αποσύρθηκε από το EPFL τον Δεκέμβριο του 2016.nnΤο 1996, ο Moret ίδρυσε το ACM Journal of Experimental Algorithmics και παρέμεινε αρχισυντάκτης του περιοδικού μέχρι το 2003. Το 2001, ο Moret ίδρυσε το Workshop in Algorithms for Bioinformatics and still on theBI) Διευθύνουσα Επιτροπή για το συνέδριο.nnΤο 2018, ο Moret εξελέγη Μέλος της Διεθνούς Εταιρείας Υπολογιστικής Βιολογίας, για την εξαιρετική συνεισφορά του στους τομείς της υπολογιστικής βιολογίας και της βιοπληροφορικής.nn### Απάντηση:n | * École Polytechnique Fédérale de Lausanne (EPFL) (αποφοίτησε το 1975) n* University of Tennessee (αποφοίτησε το 1980) | Ο Moret σπούδασε στην École Polytechnique Fédérale de Lausanne (EPFL) και στο Πανεπιστήμιο του Tennessee, αποφοιτώντας το 1975 και το 1980, αντίστοιχα. Χρησιμοποιήστε τη συνάρτηση «split» για να χωρίσετε κάθε πρόταση σε μια λίστα λέξεων.n- Χρησιμοποιήστε τη συνάρτηση «split» για να χωρίσετε | – École Polytechnique Fédérale de Lausanne (EPFL), 1975n- University of Tennessee, 1980n- University of New Mexico- École Polytechnique Fédérale de Lausanne (EPFL), 2006nn Ακολουθεί μια οδηγία που περιγράφει παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.ν |

| 2 | Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΑπό το απόσπασμα εντοπίστε τα χαρακτηριστικά του Διόνυσου. Εμφανίστε τα αποτελέσματα σε μορφή διαχωρισμένα με κόμματα.nn### Εισαγωγή:nΔιόνυσος (Διόνυσος, Διόνυσος)/Βάκχος (Βάκχος, Μπάκχος)nnΘεός του κρασιού, της καρποφορίας, των πάρτι, των γιορτών, της τρέλας, του χάους, της μέθης, της βλάστησης, της έκστασης και του θέατρο. Είναι ο δύο φορές γεννημένος γιος του Δία και της Σεμέλης, καθώς ο Δίας τον άρπαξε από την κοιλιά της μητέρας του και έσυρε τον Διόνυσο στο μηρό του και τον μετέφερε μέχρι να γεννηθεί. Στην τέχνη απεικονίζεται είτε ως μεγαλύτερος γενειοφόρος θεός (ιδιαίτερα πριν από το 430 π.Χ.) είτε ως θηλυκός, μακρυμάλλης νέος (ιδιαίτερα μετά το 430 π.Χ.). Τα χαρακτηριστικά του περιλαμβάνουν τον θύρσο, ένα ποτήρι, το αμπέλι και ένα στεφάνι από κισσό. Είναι συχνά παρέα με τους θιάσους του, μια ομάδα συνοδών που περιλαμβάνει σάτυρους, μαινάδες και τον παλιό του δάσκαλο Σιληνό. Η σύζυγος του Διονύσου ήταν η Αριάδνη. Κάποτε θεωρήθηκε ότι ο Διονύσιος ήταν μεταγενέστερη προσθήκη στο ελληνικό πάνθεον, αλλά η ανακάλυψη πινακίδων Γραμμικής Β επιβεβαιώνει την ιδιότητά του ως θεότητας από μια πρώιμη περίοδο. Βάκχος ήταν ένα άλλο όνομα γι 'αυτόν στα ελληνικά, και ήρθε σε κοινή χρήση μεταξύ των Ρωμαίων. Τα ιερά του ζώα περιλαμβάνουν δελφίνια, φίδια, τίγρεις και γαϊδούρια.nn### Απάντηση:n | ο θύρσος, ένα ποτήρι, το αμπέλι, ένα στεφάνι από κισσό | Διόνυσος (Διόνυσος, Διόνυσος)nnΘεός του κρασιού, της καρποφορίας, των πάρτι, των γιορτών, της τρέλας, του χάους, της μέθης, της βλάστησης, της έκστασης και του θεάτρου. Είναι ο δύο φορές γεννημένος γιος του Δία και της Σεμέλης, καθώς ο Δίας τον άρπαξε από την κοιλιά της μητέρας του και έραψε τον Διόνυσο στο μηρό του. | Θύρσος, ένα ποτήρι, το αμπέλι, ένα στέμμα από ivynn Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια εισαγωγή που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΠοια είναι η διαφορά μεταξύ της Αυτοκρατορίας των Πάρθων και της Αρσακιδικής Αυτοκρατορίας;nn### Εισαγωγή:nΗ Αυτοκρατορία των Πάρθων, γνωστή και ως Αυτοκρατορία των Αρσακιδών ήταν |

| 3 | Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΓιατί η πρωτεύουσα του Ουζμπεκιστάν περιέχει τη μεγαλύτερη ελληνική κοινότητα;nn### Εισαγωγή:nΟι Έλληνες στο Ουζμπεκιστάν ανέρχονται περίπου στους 9,000. Η κοινότητα αποτελείται από Έλληνες της Ρωσίας που απελάθηκαν με τη βία από τη χώρα αυτή στο Ουζμπεκιστάν τη δεκαετία του 1940, και πολιτικούς πρόσφυγες από την Ελλάδα. Περίπου 30,000 Έλληνες ζούσαν στη χώρα πριν από τον Β' Παγκόσμιο Πόλεμο και άλλοι 11,000 έφτασαν μετά τον Ελληνικό Εμφύλιο Πόλεμο και την ήττα του Δημοκρατικού Στρατού Ελλάδας. Ο αριθμός τους έχει μειωθεί από το υψηλό των 40,000 περίπου τη δεκαετία του 1960. Ο κύριος λόγος είναι η μετανάστευση στην Ελλάδα μετά το τέλος του Ψυχρού Πολέμου, όταν οι νόμοι επέτρεψαν την επιστροφή όλων των εθνικών Ελλήνων που είχαν εξοριστεί για πολιτικούς λόγους μετά τον ελληνικό εμφύλιο πόλεμο. Η μεγαλύτερη ελληνική κοινότητα της χώρας βρίσκεται στην πρωτεύουσα της Τασκένδης, όπου οι περισσότεροι Έλληνες πολιτικοί πρόσφυγες μετεγκαταστάθηκαν από τις σοβιετικές αρχές. Στην αρχαιότητα το νότιο τμήμα της χώρας ήταν μέρος του ελληνιστικού βασιλείου των Σελευκιδών αλλά οι λίγες ελληνικές κοινότητες εκεί αφομοιώθηκαν από τότε. Ο σημαντικότερος οργανισμός που εκπροσωπεί τους Έλληνες είναι ο Ελληνικός Πολιτιστικός Σύλλογος της Τασκένδης. Οι δραστηριότητες αυτού του οργανισμού περιλαμβάνουν διδασκαλία της ελληνικής γλώσσας (19 τμήματα με συνολικά 571 μαθητές, τμήματα για ενήλικες) και διδασκαλία ελληνικών χορών και μουσικής.nn### Απάντηση:n | Οι περισσότεροι Έλληνες πολιτικοί πρόσφυγες στο Ουζμπεκιστάν μεταφέρθηκαν από τις σοβιετικές αρχές στην πρωτεύουσα Τασκένδη. | n“`nΗ πρωτεύουσα του Ουζμπεκιστάν περιέχει τη μεγαλύτερη ελληνική κοινότητα γιατί οι Έλληνες στο Ουζμπεκιστάν ανέρχονται περίπου στις 9,000. Η κοινότητα αποτελείται από Έλληνες από τη Ρωσία που απελάθηκαν με τη βία από τη χώρα αυτή στο Ουζμπεκιστάν τη δεκαετία του 1940, και πολιτικούς πρόσφυγες από την Ελλάδα. Περίπου 30,000 Έλληνες ζούσαν στη χώρα πριν από τον Β' Παγκόσμιο Πόλεμο και άλλοι 11,00 | Η πρωτεύουσα του Ουζμπεκιστάν περιέχει τη μεγαλύτερη ελληνική κοινότητα, επειδή εκεί μεταφέρθηκαν οι περισσότεροι Έλληνες πολιτικοί πρόσφυγες από τις σοβιετικές αρχές μετά την απέλασή τους από την Ελλάδα. περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΠοια είναι η διαφορά μεταξύ της Αυτοκρατορίας Πάρθων και Αρσακιδών;nn### Εισαγωγή:n |

Μπορούμε να δούμε ότι οι απαντήσεις από το τελειοποιημένο μοντέλο επιδεικνύουν σημαντική βελτίωση στην ακρίβεια, τη συνάφεια και τη σαφήνεια σε σύγκριση με εκείνες από το προεκπαιδευμένο μοντέλο. Σε ορισμένες περιπτώσεις, η χρήση του προεκπαιδευμένου μοντέλου για την περίπτωση χρήσης σας μπορεί να μην είναι αρκετή, επομένως η λεπτομέρειά του χρησιμοποιώντας αυτήν την τεχνική θα κάνει τη λύση πιο εξατομικευμένη στο σύνολο δεδομένων σας.

εκκαθάριση

Αφού ολοκληρώσετε την εργασία εκπαίδευσης και δεν θέλετε να χρησιμοποιήσετε πλέον τους υπάρχοντες πόρους, διαγράψτε τους πόρους χρησιμοποιώντας τον ακόλουθο κώδικα:

Συμπέρασμα

Η ανάπτυξη και η τελειοποίηση των μοντέλων Llama 2 Neuron στο SageMaker καταδεικνύουν σημαντική πρόοδο στη διαχείριση και τη βελτιστοποίηση μοντέλων παραγωγής τεχνητής νοημοσύνης μεγάλης κλίμακας. Αυτά τα μοντέλα, συμπεριλαμβανομένων παραλλαγών όπως το Llama-2-7b και το Llama-2-13b, χρησιμοποιούν το Neuron για αποτελεσματική εκπαίδευση και εξαγωγή συμπερασμάτων σε στιγμιότυπα που βασίζονται στο AWS Inferentia και στο Trainium, βελτιώνοντας την απόδοση και την επεκτασιμότητα τους.

Η δυνατότητα ανάπτυξης αυτών των μοντέλων μέσω του SageMaker JumpStart UI και του Python SDK προσφέρει ευελιξία και ευκολία στη χρήση. Το Neuron SDK, με την υποστήριξή του για δημοφιλή πλαίσια ML και δυνατότητες υψηλής απόδοσης, επιτρέπει τον αποτελεσματικό χειρισμό αυτών των μεγάλων μοντέλων.

Η λεπτομερής ρύθμιση αυτών των μοντέλων σε δεδομένα συγκεκριμένου τομέα είναι ζωτικής σημασίας για τη βελτίωση της συνάφειας και της ακρίβειάς τους σε εξειδικευμένους τομείς. Η διαδικασία, την οποία μπορείτε να πραγματοποιήσετε μέσω του SageMaker Studio UI ή του Python SDK, επιτρέπει την προσαρμογή σε συγκεκριμένες ανάγκες, οδηγώντας σε βελτιωμένη απόδοση του μοντέλου όσον αφορά τις έγκαιρες ολοκληρώσεις και την ποιότητα απόκρισης.

Συγκριτικά, οι προεκπαιδευμένες εκδόσεις αυτών των μοντέλων, αν και ισχυρές, ενδέχεται να παρέχουν πιο γενικές ή επαναλαμβανόμενες απαντήσεις. Η τελειοποίηση προσαρμόζει το μοντέλο σε συγκεκριμένα περιβάλλοντα, με αποτέλεσμα πιο ακριβείς, σχετικές και ποικίλες απαντήσεις. Αυτή η προσαρμογή είναι ιδιαίτερα εμφανής όταν συγκρίνονται αποκρίσεις από προεκπαιδευμένα και βελτιωμένα μοντέλα, όπου το τελευταίο δείχνει αξιοσημείωτη βελτίωση στην ποιότητα και την ιδιαιτερότητα της παραγωγής. Συμπερασματικά, η ανάπτυξη και η τελειοποίηση των μοντέλων Neuron Llama 2 στο SageMaker αντιπροσωπεύουν ένα ισχυρό πλαίσιο για τη διαχείριση προηγμένων μοντέλων τεχνητής νοημοσύνης, προσφέροντας σημαντικές βελτιώσεις στην απόδοση και την εφαρμογή, ειδικά όταν προσαρμόζονται σε συγκεκριμένους τομείς ή εργασίες.

Ξεκινήστε σήμερα αναφέροντας το δείγμα του SageMaker σημειωματάριο.

Για περισσότερες πληροφορίες σχετικά με την ανάπτυξη και τη λεπτομερή ρύθμιση προεκπαιδευμένων μοντέλων Llama 2 σε παρουσίες που βασίζονται σε GPU, ανατρέξτε στο Βελτιστοποιήστε το Llama 2 για δημιουργία κειμένου στο Amazon SageMaker JumpStart και Τα μοντέλα βάσης Llama 2 από τη Meta είναι πλέον διαθέσιμα στο Amazon SageMaker JumpStart.

Οι συγγραφείς θα ήθελαν να αναγνωρίσουν τις τεχνικές συνεισφορές των Evan Kravitz, Christopher Whitten, Adam Kozdrowicz, Manan Shah, Jonathan Guinegagne και Mike James.

Σχετικά με τους Συγγραφείς

Σιν Χουάνγκ είναι Senior Applied Scientist για τους ενσωματωμένους αλγόριθμους Amazon SageMaker JumpStart και Amazon SageMaker. Επικεντρώνεται στην ανάπτυξη κλιμακωτών αλγορίθμων μηχανικής μάθησης. Τα ερευνητικά του ενδιαφέροντα είναι στον τομέα της επεξεργασίας φυσικής γλώσσας, της εξηγήσιμης βαθιάς μάθησης σε δεδομένα πινάκων και της ισχυρής ανάλυσης της μη παραμετρικής ομαδοποίησης του χωροχρόνου. Έχει δημοσιεύσει πολλές εργασίες σε συνέδρια ACL, ICDM, KDD και Royal Statistical Society: Series A.

Σιν Χουάνγκ είναι Senior Applied Scientist για τους ενσωματωμένους αλγόριθμους Amazon SageMaker JumpStart και Amazon SageMaker. Επικεντρώνεται στην ανάπτυξη κλιμακωτών αλγορίθμων μηχανικής μάθησης. Τα ερευνητικά του ενδιαφέροντα είναι στον τομέα της επεξεργασίας φυσικής γλώσσας, της εξηγήσιμης βαθιάς μάθησης σε δεδομένα πινάκων και της ισχυρής ανάλυσης της μη παραμετρικής ομαδοποίησης του χωροχρόνου. Έχει δημοσιεύσει πολλές εργασίες σε συνέδρια ACL, ICDM, KDD και Royal Statistical Society: Series A.

Νιτίν Ευσέβιος είναι Sr. Enterprise Solutions Architect στην AWS, με εμπειρία στη Μηχανική Λογισμικού, την Enterprise Architecture και την AI/ML. Είναι βαθιά παθιασμένος με την εξερεύνηση των δυνατοτήτων της γενετικής τεχνητής νοημοσύνης. Συνεργάζεται με πελάτες για να τους βοηθήσει να δημιουργήσουν καλά αρχιτεκτονημένες εφαρμογές στην πλατφόρμα AWS και είναι αφοσιωμένος στην επίλυση τεχνολογικών προκλήσεων και στην παροχή βοήθειας στο ταξίδι τους στο cloud.

Νιτίν Ευσέβιος είναι Sr. Enterprise Solutions Architect στην AWS, με εμπειρία στη Μηχανική Λογισμικού, την Enterprise Architecture και την AI/ML. Είναι βαθιά παθιασμένος με την εξερεύνηση των δυνατοτήτων της γενετικής τεχνητής νοημοσύνης. Συνεργάζεται με πελάτες για να τους βοηθήσει να δημιουργήσουν καλά αρχιτεκτονημένες εφαρμογές στην πλατφόρμα AWS και είναι αφοσιωμένος στην επίλυση τεχνολογικών προκλήσεων και στην παροχή βοήθειας στο ταξίδι τους στο cloud.

Madhur Prashant εργάζεται στον χώρο παραγωγής AI στο AWS. Είναι παθιασμένος με τη διασταύρωση της ανθρώπινης σκέψης και της γενετικής τεχνητής νοημοσύνης. Τα ενδιαφέροντά του έγκεινται στη δημιουργία τεχνητής νοημοσύνης, συγκεκριμένα στην κατασκευή λύσεων που είναι χρήσιμες και αβλαβείς, και κυρίως βέλτιστες για τους πελάτες. Εκτός δουλειάς, του αρέσει να κάνει γιόγκα, να κάνει πεζοπορία, να περνά χρόνο με το δίδυμό του και να παίζει κιθάρα.

Madhur Prashant εργάζεται στον χώρο παραγωγής AI στο AWS. Είναι παθιασμένος με τη διασταύρωση της ανθρώπινης σκέψης και της γενετικής τεχνητής νοημοσύνης. Τα ενδιαφέροντά του έγκεινται στη δημιουργία τεχνητής νοημοσύνης, συγκεκριμένα στην κατασκευή λύσεων που είναι χρήσιμες και αβλαβείς, και κυρίως βέλτιστες για τους πελάτες. Εκτός δουλειάς, του αρέσει να κάνει γιόγκα, να κάνει πεζοπορία, να περνά χρόνο με το δίδυμό του και να παίζει κιθάρα.

Dewan Choudhury είναι Μηχανικός Ανάπτυξης Λογισμικού με τις Υπηρεσίες Ιστού της Amazon. Εργάζεται στους αλγόριθμους και τις προσφορές του JumpStart του Amazon SageMaker. Εκτός από την κατασκευή υποδομών AI/ML, είναι επίσης παθιασμένος με την κατασκευή κλιμακούμενων κατανεμημένων συστημάτων.

Dewan Choudhury είναι Μηχανικός Ανάπτυξης Λογισμικού με τις Υπηρεσίες Ιστού της Amazon. Εργάζεται στους αλγόριθμους και τις προσφορές του JumpStart του Amazon SageMaker. Εκτός από την κατασκευή υποδομών AI/ML, είναι επίσης παθιασμένος με την κατασκευή κλιμακούμενων κατανεμημένων συστημάτων.

Χάο Ζου είναι ερευνητής με το Amazon SageMaker. Πριν από αυτό, εργάστηκε στην ανάπτυξη μεθόδων μηχανικής εκμάθησης για τον εντοπισμό απάτης για το Amazon Fraud Detector. Είναι παθιασμένος με την εφαρμογή μηχανικής μάθησης, βελτιστοποίησης και τεχνικών τεχνητής νοημοσύνης σε διάφορα προβλήματα του πραγματικού κόσμου. Είναι διδάκτωρ Ηλεκτρολόγου Μηχανικού από το Πανεπιστήμιο Northwestern.

Χάο Ζου είναι ερευνητής με το Amazon SageMaker. Πριν από αυτό, εργάστηκε στην ανάπτυξη μεθόδων μηχανικής εκμάθησης για τον εντοπισμό απάτης για το Amazon Fraud Detector. Είναι παθιασμένος με την εφαρμογή μηχανικής μάθησης, βελτιστοποίησης και τεχνικών τεχνητής νοημοσύνης σε διάφορα προβλήματα του πραγματικού κόσμου. Είναι διδάκτωρ Ηλεκτρολόγου Μηχανικού από το Πανεπιστήμιο Northwestern.

Τσινγκ Λαν είναι Μηχανικός Ανάπτυξης Λογισμικού στην AWS. Έχει εργαστεί σε πολλά προκλητικά προϊόντα στο Amazon, συμπεριλαμβανομένων λύσεων συμπερασμάτων ML υψηλής απόδοσης και συστήματος καταγραφής υψηλής απόδοσης. Η ομάδα του Qing κυκλοφόρησε με επιτυχία το πρώτο μοντέλο δισεκατομμυρίων παραμέτρων στο Amazon Advertising με πολύ χαμηλό λανθάνοντα χρόνο που απαιτείται. Ο Qing έχει εις βάθος γνώση σχετικά με τη βελτιστοποίηση της υποδομής και την επιτάχυνση Deep Learning.

Τσινγκ Λαν είναι Μηχανικός Ανάπτυξης Λογισμικού στην AWS. Έχει εργαστεί σε πολλά προκλητικά προϊόντα στο Amazon, συμπεριλαμβανομένων λύσεων συμπερασμάτων ML υψηλής απόδοσης και συστήματος καταγραφής υψηλής απόδοσης. Η ομάδα του Qing κυκλοφόρησε με επιτυχία το πρώτο μοντέλο δισεκατομμυρίων παραμέτρων στο Amazon Advertising με πολύ χαμηλό λανθάνοντα χρόνο που απαιτείται. Ο Qing έχει εις βάθος γνώση σχετικά με τη βελτιστοποίηση της υποδομής και την επιτάχυνση Deep Learning.

Δρ Ashish Khetan είναι Ανώτερος Εφαρμοσμένος Επιστήμονας με ενσωματωμένους αλγόριθμους του Amazon SageMaker και βοηθά στην ανάπτυξη αλγορίθμων μηχανικής μάθησης. Πήρε το διδακτορικό του από το Πανεπιστήμιο του Illinois Urbana-Champaign. Είναι ενεργός ερευνητής στη μηχανική μάθηση και στα στατιστικά συμπεράσματα και έχει δημοσιεύσει πολλές εργασίες σε συνέδρια NeurIPS, ICML, ICLR, JMLR, ACL και EMNLP.

Δρ Ashish Khetan είναι Ανώτερος Εφαρμοσμένος Επιστήμονας με ενσωματωμένους αλγόριθμους του Amazon SageMaker και βοηθά στην ανάπτυξη αλγορίθμων μηχανικής μάθησης. Πήρε το διδακτορικό του από το Πανεπιστήμιο του Illinois Urbana-Champaign. Είναι ενεργός ερευνητής στη μηχανική μάθηση και στα στατιστικά συμπεράσματα και έχει δημοσιεύσει πολλές εργασίες σε συνέδρια NeurIPS, ICML, ICLR, JMLR, ACL και EMNLP.

Δρ Li Zhang είναι ένας κύριος διαχειριστής προϊόντων-τεχνικός για τους ενσωματωμένους αλγόριθμους Amazon SageMaker JumpStart και Amazon SageMaker, μια υπηρεσία που βοηθά τους επιστήμονες δεδομένων και τους επαγγελματίες της μηχανικής μάθησης να ξεκινήσουν με την εκπαίδευση και την ανάπτυξη των μοντέλων τους και χρησιμοποιεί ενισχυτική μάθηση με το Amazon SageMaker. Η προηγούμενη δουλειά του ως κύριο μέλος του ερευνητικού προσωπικού και κύριος εφευρέτης στην IBM Research κέρδισε το βραβείο τεστ του χρόνου στο IEEE INFOCOM.

Δρ Li Zhang είναι ένας κύριος διαχειριστής προϊόντων-τεχνικός για τους ενσωματωμένους αλγόριθμους Amazon SageMaker JumpStart και Amazon SageMaker, μια υπηρεσία που βοηθά τους επιστήμονες δεδομένων και τους επαγγελματίες της μηχανικής μάθησης να ξεκινήσουν με την εκπαίδευση και την ανάπτυξη των μοντέλων τους και χρησιμοποιεί ενισχυτική μάθηση με το Amazon SageMaker. Η προηγούμενη δουλειά του ως κύριο μέλος του ερευνητικού προσωπικού και κύριος εφευρέτης στην IBM Research κέρδισε το βραβείο τεστ του χρόνου στο IEEE INFOCOM.

Kamran Khan, Sr Διευθυντής Τεχνικής Επιχειρηματικής Ανάπτυξης για το AWS Inferentina/Trianium στην AWS. Έχει πάνω από μια δεκαετία εμπειρίας βοηθώντας τους πελάτες να αναπτύξουν και να βελτιστοποιήσουν την εκπαίδευση σε βάθος και τον φόρτο εργασίας εξαγωγής συμπερασμάτων χρησιμοποιώντας το AWS Inferentia και το AWS Trainium.

Kamran Khan, Sr Διευθυντής Τεχνικής Επιχειρηματικής Ανάπτυξης για το AWS Inferentina/Trianium στην AWS. Έχει πάνω από μια δεκαετία εμπειρίας βοηθώντας τους πελάτες να αναπτύξουν και να βελτιστοποιήσουν την εκπαίδευση σε βάθος και τον φόρτο εργασίας εξαγωγής συμπερασμάτων χρησιμοποιώντας το AWS Inferentia και το AWS Trainium.

Τζο Σενέρτσια είναι Ανώτερος Διευθυντής Προϊόντων στην AWS. Ορίζει και κατασκευάζει περιπτώσεις Amazon EC2 για βαθιά μάθηση, τεχνητή νοημοσύνη και φόρτους εργασίας υπολογιστών υψηλής απόδοσης.

Τζο Σενέρτσια είναι Ανώτερος Διευθυντής Προϊόντων στην AWS. Ορίζει και κατασκευάζει περιπτώσεις Amazon EC2 για βαθιά μάθηση, τεχνητή νοημοσύνη και φόρτους εργασίας υπολογιστών υψηλής απόδοσης.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://aws.amazon.com/blogs/machine-learning/fine-tune-and-deploy-llama-2-models-cost-effectively-in-amazon-sagemaker-jumpstart-with-aws-inferentia-and-aws-trainium/

- :έχει

- :είναι

- :δεν

- :που

- $UP

- 000

- 1

- 10

- 100

- 11

- 12

- 121

- 13

- 15%

- 16

- 19

- 1996

- 2001

- 2006

- 2016

- 2018

- 25

- 30

- 36

- 3d

- 40

- 60

- 610

- 65

- 7

- 8

- 9

- a

- ικανότητα

- Ικανός

- Σχετικα

- επιτάχυνση

- Αποδέχομαι

- αποδεκτό

- αποδεκτές

- πρόσβαση

- ακρίβεια

- ακριβής

- αναγνωρίζω

- ACM

- ενεργός

- δραστηριοτήτων

- Αδάμ

- προσαρμόσει

- προσαρμογή

- προσαρμοστεί

- προσθέτω

- Επιπλέον

- ενήλικες

- προηγμένες

- προαγωγή

- Διαφήμιση

- Μετά το

- Συμφωνία

- AI

- Μοντέλα AI

- AI / ML

- αλγόριθμοι

- Όλα

- επιτρέπουν

- επιτρέπεται

- επιτρέπει

- Επίσης

- Amazon

- Amazon EC2

- Ανιχνευτής απάτης Amazon

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon υπηρεσίες Web

- μεταξύ των

- an

- ανάλυση

- Αρχαίος

- και

- αγελάδων

- Ανακοινώστε

- Άλλος

- κάθε

- πια

- Apache

- χώρια

- εφαρμόσιμος

- Εφαρμογή

- εφαρμογές

- εφαρμοσμένος

- εφαρμόζοντας

- κατάλληλα

- περίπου

- αρχιτεκτονική

- ΕΙΝΑΙ

- ΠΕΡΙΟΧΗ

- περιοχές

- επιχείρημα

- Στρατός

- έφτασε

- Τέχνη

- τεχνητός

- τεχνητή νοημοσύνη

- AS

- βοηθώντας

- Σχέση

- At

- Συμμετέχοντες

- γνωρίσματα

- Αρχές

- συγγραφείς

- Αυτοματοποιημένη

- διαθεσιμότητα

- διαθέσιμος

- αποφύγετε

- AWS

- Αίσθηση AWS

- b

- βασίζονται

- BE

- Πλάτος

- επειδή

- γίνονται

- ήταν

- πριν

- είναι

- Πιστεύω

- παρακάτω

- μεταξύ

- Πέρα

- Μεγαλύτερη

- βιολογία

- Μπλοκ

- γεννημένος

- και οι δύο

- Κουτί

- ευρύς

- χτίζω

- Κτίριο

- Χτίζει

- ενσωματωμένο

- επιχείρηση

- ανάπτυξη επιχείρησης

- αλλά

- κουμπί

- κουμπιά

- by

- κλήση

- ήρθε

- CAN

- δυνατότητες

- κεφάλαιο

- κάρτα

- που

- περίπτωση

- περιπτώσεις

- κατηγορίες

- κατηγορία

- προκλήσεις

- πρόκληση

- αλλαγή

- Χάος

- chat

- αρχηγός

- επιλογή

- Επιλέξτε

- επιλέγοντας

- Χριστόφορος

- Πόλη

- πολιτικής

- σαφήνεια

- τάξεις

- κλασικό

- ταξινόμηση

- καθαρός

- Backup

- ομαδοποίηση

- κωδικός

- κρύο

- επιτροπή

- Κοινός

- Κοινοτήτων

- κοινότητα

- εταίρα

- σύγκριση

- συγκρίνοντας

- συγκρίσεις

- Ολοκληρώθηκε το

- Ολοκληρώνει

- υπολογιστική

- χρήση υπολογιστή

- συμπέρασμα

- ανταγωνιστής

- Διεξαγωγή

- Διάσκεψη

- συνέδρια

- διαμόρφωση

- Επιβεβαιώνω

- πρόξενος

- περιέχουν

- Δοχείο

- Περιέχει

- περιεχόμενο

- συμφραζόμενα

- πλαίσια

- συνεισφορές

- έλεγχος

- ελέγχους

- Κόστος

- δαπανηρός

- Δικαστικά έξοδα

- χώρα

- δημιουργήθηκε

- Στέμμα

- κρίσιμος

- πολιτιστικός

- Φλιτζάνι

- πελάτης

- εμπειρία του πελάτη

- Πελάτες

- παραμετροποίηση

- ημερομηνία

- σύνολα δεδομένων

- Ημερομηνία

- de

- δεκαετία

- Δεκέμβριος

- Αποκρυπτογράφηση

- αφιερωμένο

- βαθύς

- βαθιά μάθηση

- βαθιά

- Προεπιλογή

- Ορίζει

- Πτυχίο

- παραδώσει

- δημοκρατικός

- αποδεικνύουν

- κατέδειξε

- καταδεικνύει

- Σε συνάρτηση

- εξαρτάται

- παρατάσσω

- αναπτυχθεί

- ανάπτυξη

- ανάπτυξη

- περιγράφει

- περιγραφή

- καθορισμένο

- σχεδιασμένα

- λεπτομερής

- καθέκαστα

- Ανίχνευση

- ανάπτυξη

- ανάπτυξη

- Ανάπτυξη

- Διάλογος

- DID

- διαφορά

- διαφορετικές

- ανακαλύπτουν

- ανακάλυψη

- συζητήσουν

- Display

- διανέμονται

- κατανεμημένα συστήματα

- διάφορα

- κάνει

- πράξη

- Κουκλίτσα

- τομέα

- domains

- Μην

- κάτω

- κάθε

- Νωρίς

- Κερδίστε

- ευκολία

- ευκολία στη χρήση

- συντάκτης

- Αποτελεσματικός

- αποτελεσματικότητα

- αποτελεσματικός

- είτε

- εκλεγμένα

- Ηλεκτρολόγων Μηχανικών

- Αυτοκρατορία

- ενεργοποιημένη

- δίνει τη δυνατότητα

- ενεργοποίηση

- τέλος

- από άκρη σε άκρη

- Τελικό σημείο

- μηχανικός

- Μηχανική

- ενίσχυση

- ενίσχυση

- αρκετά

- εξασφαλίζει

- Εταιρεία

- Επιχειρηματικές Λύσεις

- Περιβάλλον

- περιβάλλοντος

- ίσος

- ισούται

- ειδικά

- Αιθέρας (ΕΤΗ)

- αξιολογήσει

- εκτίμηση

- εμφανές

- παράδειγμα

- παραδείγματα

- ενθουσιασμένοι

- Με εξαίρεση

- υφιστάμενα

- εμπειρία

- έμπειρος

- πειραματικός

- διερευνήσει

- Εξερευνώντας

- εξαγωγή

- Πτώση

- ψευδής

- γρηγορότερα

- σύντροφος

- φεστιβάλ

- λίγοι

- Πεδία

- Αρχεία

- Αρχεία

- Κατάθεση

- οικονομικός

- των χρηματοπιστωτικών υπηρεσιών

- Εύρεση

- τέλος

- Όνομα

- Ευελιξία

- φλοτέρ

- Συγκέντρωση

- εστιάζει

- Εξής

- εξής

- Για

- Δύναμη

- μορφή

- Βρέθηκαν

- Θεμέλιο

- Ίδρυση

- Πλαίσιο

- πλαισίων

- απάτη

- ανίχνευση απάτης

- από

- λειτουργία

- περαιτέρω

- παράγεται

- δημιουργεί

- γενεά

- γενετική

- Παραγωγική τεχνητή νοημοσύνη

- παίρνω

- Go

- Θεός

- καλός

- πήρε

- αποφοιτήσουν

- γραφική παράσταση

- γραφικές παραστάσεις

- μεγαλύτερη

- Ελλάδα

- Άπληστος

- ελληνικο

- Group

- καθοδήγηση

- κιθάρα

- είχε

- Χειρισμός

- τα χέρια

- ευτυχισμένος

- Έχω

- he

- υγειονομική περίθαλψη

- Ήρωας

- βοήθεια

- χρήσιμο

- βοήθεια

- βοηθά

- Ψηλά

- υψηλή απόδοση

- υψηλότερο

- υψηλότερο

- ανταύγειες

- πεζοπορία

- αυτόν

- του

- κατέχει

- Πως

- Πώς να

- Ωστόσο

- HTML

- http

- HTTPS

- ανθρώπινος

- i

- IBM

- ICLR

- προσδιορίσει

- ids

- IEEE

- if

- ii

- Ιλλινόις

- εκτέλεση

- εισαγωγή

- σημαντικό

- βελτίωση

- βελτιωθεί

- βελτίωση

- βελτιώσεις

- in

- σε βάθος

- περιλαμβάνουν

- περιλαμβάνει

- Συμπεριλαμβανομένου

- Αυξάνουν

- υποδηλώνει

- πληροφορίες

- εξαγωγή πληροφοριών

- Υποδομή

- υποδομή

- εισαγωγή

- είσοδοι

- παράδειγμα

- περιπτώσεις

- οδηγίες

- ενσωματωθεί

- Νοημοσύνη

- συμφέροντα

- περιβάλλον λειτουργίας

- International

- διασταύρωση

- σε

- συμμετέχουν

- IT

- ΤΟΥ

- james

- Δουλειά

- Θέσεις εργασίας

- εντάχθηκαν

- Jonathan

- ημερολόγιο

- ταξίδι

- jpg

- json

- μόλις

- Κλειδί

- Βασίλειο

- κιτ

- Κιτ (SDK)

- γνώση

- γνωστός

- προσγείωση

- σελίδα προορισμού

- Γλώσσα

- large

- μεγάλης κλίμακας

- Αφάνεια

- αργότερα

- ξεκίνησε

- Του νόμου

- που οδηγεί

- μάθηση

- Μήκος

- li

- Άδεια

- άδειες

- ψέμα

- ζωή

- Μου αρέσει

- πιθανότητα

- Πιθανός

- περιορισμός

- γραμμή

- γραμμές

- LINK

- Λιστα

- Εισηγμένες

- Είδος μικρής καμήλας

- φορτίο

- τοπικός

- ξύλευση

- Μακριά

- ματιά

- αγαπά

- Χαμηλός

- χαμηλότερα

- μείωση

- χαμηλότερο

- μηχανή

- μάθηση μηχανής

- που

- Κυρίως

- κάνω

- Κατασκευή

- διευθυντής

- διαχείριση

- Μανάν Σαχ

- πολοί

- κύριος

- ανώτατο όριο

- Ενδέχεται..

- νόημα

- Γνωρίστε

- μέλος

- Meta

- μέθοδος

- μέθοδοι

- Μεξικό

- ενδέχεται να

- μικρόφωνο

- νου

- ML

- μοντέλο

- μοντελοποίηση

- μοντέλα

- τροποποιημένο

- τροποποιήσει

- περισσότερο

- πλέον

- μετακινηθεί

- Μουσική

- πρέπει

- όνομα

- Φυσικό

- Φυσική γλώσσα

- Επεξεργασία φυσικής γλώσσας

- Πλοηγηθείτε

- Πλοήγηση

- Ανάγκη

- ανάγκες

- NeurIPS

- Νέα

- επόμενη

- nlp

- Northwestern University

- σημειωματάριο

- φορητούς υπολογιστές

- τώρα

- αριθμός

- αριθμοί

- αντικείμενο

- στόχοι

- of

- προσφορά

- προσφορά

- Offerings

- προσφορές

- συχνά

- Παλιά

- ηλικιωμένων

- on

- μια φορά

- ONE

- αποκλειστικά

- βέλτιστη

- βελτιστοποίηση

- Βελτιστοποίηση

- βελτιστοποιημένη

- βελτιστοποίηση

- Επιλογή

- or

- επιχειρήσεις

- ΑΛΛΑ

- παραγωγή

- εκτός

- εκκρεμή

- επί

- δική

- Packages

- σελίδα

- ζεύγος

- ζεύγη

- παράθυρο

- Χαρτί

- χαρτιά

- Παράλληλο

- παράμετροι

- μέρος

- ιδιαίτερα

- μέρη

- πέρασμα

- παθιασμένος

- Το παρελθόν

- για

- εκτελέσει

- επίδοση

- περίοδος

- Εξατομικευμένη

- phd

- αγωγού

- πλατφόρμες

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- παιχνίδι

- σας παρακαλούμε

- Σημείο

- Πολιτικές

- πολιτική

- πολιτικός

- pop-up

- Δημοφιλής

- θετικός

- δυνατότητες

- δυνατός

- Θέση

- ισχυρός

- προηγείται

- Ακρίβεια

- προετοιμασία

- πρωταρχικός

- Κύριος

- πιθανότητα

- προβλήματα

- διαδικασια μας

- μεταποίηση

- Προϊόν

- υπεύθυνος προϊόντων

- Προϊόντα

- ιδιόκτητο

- παρέχουν

- Παρόχους υπηρεσιών

- παρέχει

- δημοσίως

- δημοσιεύθηκε

- βάζω

- Python

- pytorch

- ποιότητα

- ερώτηση

- τυχαία

- φθάσουν

- Φτάνει

- Διάβασε

- έτοιμος

- πραγματικός

- πραγματικό κόσμο

- σε πραγματικό χρόνο

- λόγος

- λόγους

- αρχεία

- παραπέμπω

- αναφοράς

- προσφύγων

- κυκλοφόρησε

- συνάφεια

- Μεταφέρθηκε

- παρέμεινε

- λείψανα

- επανειλημμένες

- επαναλαμβανόμενη

- αντικαθιστώ

- Αποθήκη

- εκπροσωπώ

- εκπροσωπούν

- ζητήσει

- αιτήματα

- απαιτείται

- έρευνα

- ερευνητής

- Υποστηρικτικό υλικό

- αντίστοιχα

- απάντησης

- απαντήσεις

- υπεύθυνος

- με αποτέλεσμα

- Αποτελέσματα

- απόδοση

- ανασκόπηση

- επανεξέταση

- εύρωστος

- Κυλιομένος

- βασιλικός

- τρέξιμο

- Russia

- σοφός

- Απεριόριστες δυνατότητες

- επεκτάσιμη

- Κλίμακα

- σενάρια

- Επιστήμονας

- επιστήμονες

- Εφαρμογές

- SDK

- Αναζήτηση

- αναζήτηση

- SEC

- SEC αρχειοθέτηση

- Δεύτερος

- Τμήμα

- ασφάλεια

- δείτε

- αρχαιότερος

- αποστέλλονται

- ποινή

- συναίσθημα

- ξεχωριστό

- Ακολουθία

- Σειρές

- Σειρά Α

- υπηρεσία

- Υπηρεσίες

- σειρά

- τον καθορισμό

- ρυθμίσεις

- διάφοροι

- Κοντά

- θα πρέπει να

- δείχνουν

- παρουσιάζεται

- Δείχνει

- σημαντικός

- Απλούς

- αφού

- ενιαίας

- Μέγεθος

- Απόσπασμα

- So

- Κοινωνία

- λογισμικό

- ανάπτυξη λογισμικού

- κιτ ανάπτυξης λογισμικού

- τεχνολογία λογισμικού

- λύση

- Λύσεις

- Επίλυση

- μερικοί

- του

- Πηγή

- Νότος

- σοβιέτ

- Χώρος

- ειδικευμένος

- συγκεκριμένες

- ειδικά

- εξειδίκευση

- καθορίζεται

- Δαπάνες

- διαίρεση

- Προσωπικό

- Εκκίνηση

- ξεκίνησε

- Κατάσταση

- στατιστικός

- Κατάσταση

- πηδαλιούχηση

- Βήμα

- Βήματα

- Διακόπτει

- χώρος στο δίσκο

- δομημένος

- Φοιτητές

- μελετημένος

- μελέτες

- στούντιο

- Επιτυχώς

- τέτοιος

- υποστήριξη

- υποστηριζόνται!

- βέβαιος

- Ελβετία

- σύστημα

- συστήματα

- τραπέζι

- επειξειργασμένος από ραπτήν

- Έργο

- εργασίες

- Διδασκαλία

- Τεχνικός

- τεχνική

- τεχνικές

- Τεχνολογία

- πρότυπο

- Τενεσί

- όροι

- δοκιμή

- κείμενο

- Ταξινόμηση κειμένου

- δημιουργία κειμένου

- από

- ότι

- Η

- Η περιοχή

- Η πρωτεύουσα

- Θέατρο

- τους

- Τους

- τότε

- Εκεί.

- Αυτοί

- αυτοί

- Σκέψη

- τρίτους

- αυτό

- εκείνοι

- Μέσω

- διακίνηση

- τίγρεις

- ώρα

- φορές

- προς την

- σήμερα

- ένδειξη

- κουπόνια

- εργαλεία

- Σύνολο

- Τρένο

- εκπαιδευμένο

- Εκπαίδευση

- μετασχηματιστής

- Μετάφραση

- αληθής

- προσπαθώ

- δίδυμο

- δύο

- τύπος

- ui

- υπό

- υποκείμενες

- μοναδικός

- Πανεπιστήμια

- πανεπιστήμιο

- μέχρι

- Ενημέρωση

- ενημερώσεις

- Χρήση

- χρήση

- περίπτωση χρήσης

- μεταχειρισμένος

- Χρήστες

- Χρήστες

- χρησιμοποιεί

- χρησιμοποιώντας

- χρησιμοποιεί

- το ουζμπεκιστάν

- επικύρωση

- αξία

- ποικιλία

- διάφορα

- εκδοχή

- πολύ

- μέσω

- Δες

- αμπέλου

- οπτικές

- walk

- θέλω

- πόλεμος

- ήταν

- τρόπους

- we

- ιστός

- διαδικτυακές υπηρεσίες

- Web-based

- πήγε

- ήταν

- πότε

- Ποιό

- ενώ

- Ο ΟΠΟΊΟΣ

- θα

- ΚΡΑΣΙ

- με

- Κέρδισε

- λέξη

- λόγια

- Εργασία

- εργάστηκαν

- εργαζόμενος

- λειτουργεί

- συνεργείο

- κόσμος

- θα

- γράφω

- έτος

- Yoga

- εσείς

- Σας

- νεολαία

- zephyrnet

- Δίας