Εισαγωγή

Φανταστείτε να στέκεστε σε μια βιβλιοθήκη με χαμηλό φωτισμό, να παλεύετε να αποκρυπτογραφήσετε ένα περίπλοκο έγγραφο ενώ ταχυδακτυλουργείτε με δεκάδες άλλα κείμενα. Αυτός ήταν ο κόσμος των Transformers πριν η εφημερίδα «Attention is All You Need» αποκαλύψει το επαναστατικό της προσκήνιο – το μηχανισμός προσοχής.

Πίνακας περιεχομένων

Περιορισμοί των RNN

Παραδοσιακά διαδοχικά μοντέλα, όπως Επαναλαμβανόμενα νευρωνικά δίκτυα (RNN), επεξεργάστηκε τη γλώσσα λέξη προς λέξη, οδηγώντας σε αρκετούς περιορισμούς:

- Εξάρτηση μικρής εμβέλειας: Οι RNN προσπάθησαν να κατανοήσουν τις συνδέσεις μεταξύ μακρινών λέξεων, συχνά παρερμηνεύοντας το νόημα προτάσεων όπως «ο άνθρωπος που επισκέφτηκε τον ζωολογικό κήπο χθες», όπου το θέμα και το ρήμα απέχουν πολύ.

- Περιορισμένος παραλληλισμός: Η διαδοχική επεξεργασία πληροφοριών είναι εγγενώς αργή, αποτρέποντας την αποτελεσματική εκπαίδευση και χρήση υπολογιστικών πόρων, ειδικά για μεγάλες ακολουθίες.

- Εστίαση στο τοπικό πλαίσιο: Τα RNN εξετάζουν κυρίως τους άμεσους γείτονες, χάνοντας πιθανώς κρίσιμες πληροφορίες από άλλα μέρη της πρότασης.

Αυτοί οι περιορισμοί εμπόδισαν την ικανότητα των Transformers να εκτελούν σύνθετες εργασίες όπως η αυτόματη μετάφραση και η κατανόηση φυσικής γλώσσας. Μετά ήρθε το μηχανισμός προσοχής, ένας επαναστατικός προβολέας που φωτίζει τις κρυφές συνδέσεις μεταξύ των λέξεων, μεταμορφώνοντας την κατανόησή μας για τη γλωσσική επεξεργασία. Τι ακριβώς έλυσε όμως η προσοχή και πώς άλλαξε το παιχνίδι για τους Transformers;

Ας επικεντρωθούμε σε τρεις βασικούς τομείς:

Εξάρτηση μεγάλης εμβέλειας

- Πρόβλημα: Τα παραδοσιακά μοντέλα σκόνταψαν συχνά σε προτάσεις όπως «η γυναίκα που ζούσε στο λόφο είδε ένα πεφταστέρι χθες το βράδυ». Αγωνίστηκαν να συνδέσουν «γυναίκα» και «πεφταστέρι» λόγω της απόστασης τους, οδηγώντας σε παρερμηνείες.

- Μηχανισμός Προσοχής: Φανταστείτε το μοντέλο να λάμπει μια φωτεινή δέσμη σε όλη την πρόταση, συνδέοντας τη "γυναίκα" απευθείας με το "πεφταστέρι" και κατανοώντας την πρόταση στο σύνολό της. Αυτή η ικανότητα καταγραφής σχέσεων ανεξάρτητα από την απόσταση είναι ζωτικής σημασίας για εργασίες όπως η αυτόματη μετάφραση και η περίληψη.

Διαβάστε επίσης: Επισκόπηση της Μακροπρόθεσμης Μνήμης (LSTM)

Ισχύς παράλληλης επεξεργασίας

- Πρόβλημα: Τα παραδοσιακά μοντέλα επεξεργάζονταν πληροφορίες διαδοχικά, όπως η ανάγνωση ενός βιβλίου σελίδα προς σελίδα. Αυτό ήταν αργό και αναποτελεσματικό, ειδικά για μεγάλα κείμενα.

- Μηχανισμός Προσοχής: Φανταστείτε πολλαπλούς προβολείς να σαρώνουν τη βιβλιοθήκη ταυτόχρονα, αναλύοντας διαφορετικά μέρη του κειμένου παράλληλα. Αυτό επιταχύνει δραματικά τη δουλειά του μοντέλου, επιτρέποντάς του να χειρίζεται τεράστιες ποσότητες δεδομένων αποτελεσματικά. Αυτή η παράλληλη ισχύς επεξεργασίας είναι απαραίτητη για την εκπαίδευση πολύπλοκων μοντέλων και την πραγματοποίηση προβλέψεων σε πραγματικό χρόνο.

Συνείδηση του παγκόσμιου πλαισίου

- Πρόβλημα: Τα παραδοσιακά μοντέλα επικεντρώνονταν συχνά σε μεμονωμένες λέξεις, χάνοντας το ευρύτερο πλαίσιο της πρότασης. Αυτό οδήγησε σε παρεξηγήσεις σε περιπτώσεις όπως ο σαρκασμός ή οι διπλές έννοιες.

- Μηχανισμός Προσοχής: Φανταστείτε τα φώτα της δημοσιότητας να σαρώνουν ολόκληρη τη βιβλιοθήκη, να παίρνουν κάθε βιβλίο και να κατανοούν πώς σχετίζονται μεταξύ τους. Αυτή η συνολική επίγνωση του πλαισίου επιτρέπει στο μοντέλο να λάβει υπόψη το σύνολο του κειμένου κατά την ερμηνεία κάθε λέξης, οδηγώντας σε μια πιο πλούσια και πιο λεπτή κατανόηση.

Αποσαφηνιστικές πολύσημες λέξεις

- Πρόβλημα: Λέξεις όπως «τράπεζα» ή «μήλο» μπορεί να είναι ουσιαστικά, ρήματα ή ακόμα και εταιρείες, δημιουργώντας ασάφεια που τα παραδοσιακά μοντέλα προσπάθησαν να επιλύσουν.

- Μηχανισμός Προσοχής: Φανταστείτε το μοντέλο να φωτίζει τα φώτα της δημοσιότητας σε όλες τις εμφανίσεις της λέξης «τράπεζα» σε μια πρόταση, και στη συνέχεια να αναλύει το περιβάλλον και τις σχέσεις με άλλες λέξεις. Λαμβάνοντας υπόψη τη γραμματική δομή, τα κοντινά ουσιαστικά, ακόμη και τις προηγούμενες προτάσεις, ο μηχανισμός προσοχής μπορεί να συναγάγει το επιδιωκόμενο νόημα. Αυτή η ικανότητα αποσαφήνισης πολυσηματικών λέξεων είναι ζωτικής σημασίας για εργασίες όπως η αυτόματη μετάφραση, η σύνοψη κειμένου και τα συστήματα διαλόγου.

Αυτές οι τέσσερις πτυχές – εξάρτηση μακράς εμβέλειας, παράλληλη ισχύς επεξεργασίας, συνείδηση του παγκόσμιου πλαισίου και αποσαφήνιση – επιδεικνύουν τη μετασχηματιστική δύναμη των μηχανισμών προσοχής. Έχουν ωθήσει τους Transformers στην πρώτη γραμμή της επεξεργασίας φυσικής γλώσσας, δίνοντάς τους τη δυνατότητα να αντιμετωπίζουν σύνθετες εργασίες με αξιοσημείωτη ακρίβεια και αποτελεσματικότητα.

Καθώς το NLP και συγκεκριμένα τα LLM συνεχίζουν να εξελίσσονται, οι μηχανισμοί προσοχής θα διαδραματίσουν αναμφίβολα έναν ακόμη πιο κρίσιμο ρόλο. Αποτελούν τη γέφυρα μεταξύ της γραμμικής αλληλουχίας των λέξεων και της πλούσιας ταπετσαρίας της ανθρώπινης γλώσσας και, εν τέλει, το κλειδί για να ξεκλειδώσετε τις πραγματικές δυνατότητες αυτών των γλωσσικών θαυμάτων. Αυτό το άρθρο εμβαθύνει στους διάφορους τύπους μηχανισμών προσοχής και τις λειτουργίες τους.

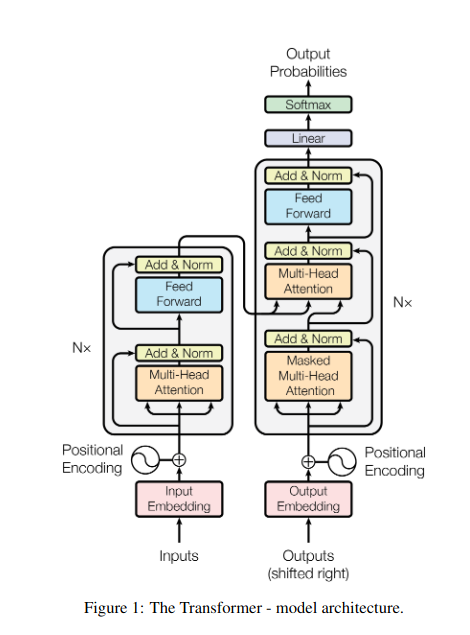

1. Αυτοπροσοχή: Το αστέρι του μετασχηματιστή

Φανταστείτε να κάνετε ταχυδακτυλουργικά πολλά βιβλία και να χρειάζεται να αναφέρετε συγκεκριμένα αποσπάσματα σε κάθε ένα ενώ γράφετε μια περίληψη. Η προσοχή του εαυτού ή του Scaled Dot-Product λειτουργεί σαν έξυπνος βοηθός, βοηθώντας τα μοντέλα να κάνουν το ίδιο με διαδοχικά δεδομένα όπως προτάσεις ή χρονικές σειρές. Επιτρέπει σε κάθε στοιχείο της ακολουθίας να παρακολουθεί κάθε άλλο στοιχείο, αποτυπώνοντας αποτελεσματικά εξαρτήσεις μεγάλης εμβέλειας και πολύπλοκες σχέσεις.

Ακολουθεί μια πιο προσεκτική ματιά στις βασικές τεχνικές πτυχές του:

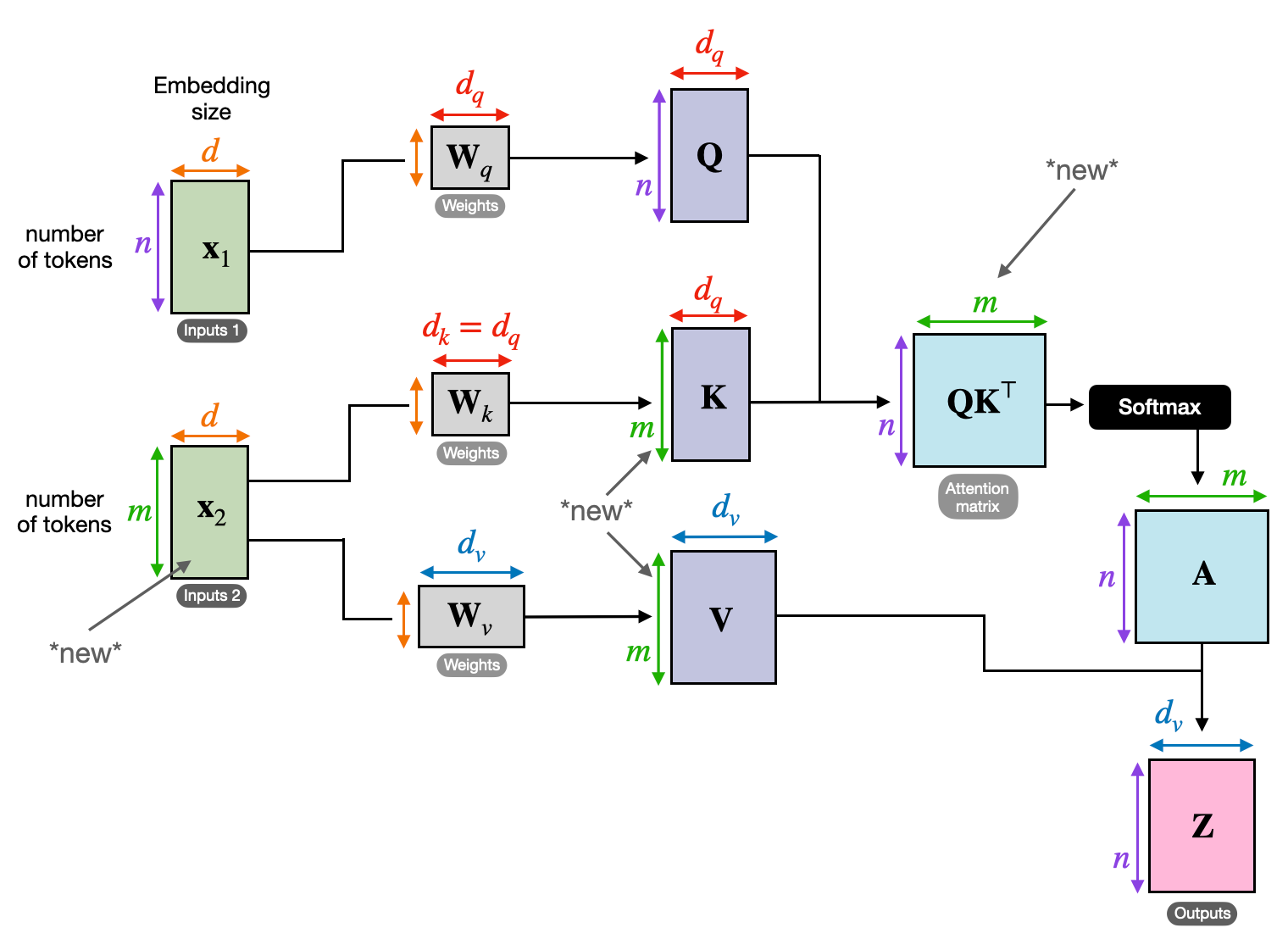

Διανυσματική αναπαράσταση

Κάθε στοιχείο (λέξη, σημείο δεδομένων) μετατρέπεται σε ένα διάνυσμα υψηλών διαστάσεων, που κωδικοποιεί το πληροφοριακό του περιεχόμενο. Αυτός ο διανυσματικός χώρος χρησιμεύει ως το θεμέλιο για την αλληλεπίδραση μεταξύ των στοιχείων.

Μετασχηματισμός QKV

Ορίζονται τρεις βασικοί πίνακες:

- Ερώτημα (Q): Αντιπροσωπεύει την «ερώτηση» που θέτει κάθε στοιχείο στα άλλα. Το Q καταγράφει τις ανάγκες πληροφοριών του τρέχοντος στοιχείου και καθοδηγεί την αναζήτησή του για σχετικές πληροφορίες εντός της ακολουθίας.

- Κλειδί (K): Κρατάει το «κλειδί» για τις πληροφορίες κάθε στοιχείου. Το K κωδικοποιεί την ουσία του περιεχομένου κάθε στοιχείου, επιτρέποντας σε άλλα στοιχεία να προσδιορίσουν πιθανή συνάφεια με βάση τις δικές τους ανάγκες.

- Τιμή (V): Αποθηκεύει το πραγματικό περιεχόμενο που θέλει να μοιραστεί κάθε στοιχείο. Το V περιέχει τις λεπτομερείς πληροφορίες στις οποίες άλλα στοιχεία μπορούν να έχουν πρόσβαση και να αξιοποιήσουν με βάση τους βαθμούς προσοχής τους.

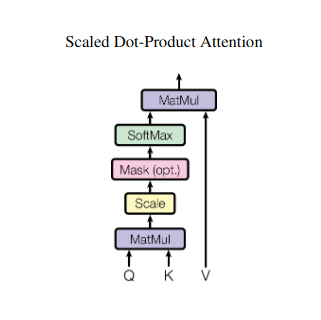

Υπολογισμός βαθμολογίας προσοχής

Η συμβατότητα μεταξύ κάθε ζεύγους στοιχείων μετράται μέσω ενός γινόμενου κουκκίδων μεταξύ των αντίστοιχων διανυσμάτων Q και K. Οι υψηλότερες βαθμολογίες δείχνουν μια ισχυρότερη πιθανή συνάφεια μεταξύ των στοιχείων.

Κλιμακωμένα Βάρη Προσοχής

Για να διασφαλιστεί η σχετική σημασία, αυτές οι βαθμολογίες συμβατότητας κανονικοποιούνται χρησιμοποιώντας μια συνάρτηση softmax. Αυτό οδηγεί σε βάρη προσοχής, που κυμαίνονται από 0 έως 1, που αντιπροσωπεύουν τη σταθμισμένη σημασία κάθε στοιχείου για το πλαίσιο του τρέχοντος στοιχείου.

Συνάθροιση σταθμισμένου περιβάλλοντος

Τα βάρη προσοχής εφαρμόζονται στον πίνακα V, υπογραμμίζοντας ουσιαστικά τις σημαντικές πληροφορίες από κάθε στοιχείο με βάση τη συνάφειά του με το τρέχον στοιχείο. Αυτό το σταθμισμένο άθροισμα δημιουργεί μια αναπαράσταση με βάση τα συμφραζόμενα για το τρέχον στοιχείο, ενσωματώνοντας πληροφορίες που συγκεντρώθηκαν από όλα τα άλλα στοιχεία της ακολουθίας.

Βελτιωμένη αναπαράσταση στοιχείων

Με την εμπλουτισμένη αναπαράστασή του, το στοιχείο κατέχει πλέον μια βαθύτερη κατανόηση του δικού του περιεχομένου καθώς και των σχέσεών του με άλλα στοιχεία της σειράς. Αυτή η μετασχηματισμένη αναπαράσταση αποτελεί τη βάση για την επακόλουθη επεξεργασία εντός του μοντέλου.

Αυτή η διαδικασία πολλαπλών βημάτων επιτρέπει την αυτοπροσοχή σε:

- Καταγράψτε εξαρτήσεις μεγάλης εμβέλειας: Οι σχέσεις μεταξύ απομακρυσμένων στοιχείων γίνονται εύκολα εμφανείς, ακόμα κι αν χωρίζονται από πολλαπλά παρεμβαλλόμενα στοιχεία.

- Μοντέλο πολύπλοκων αλληλεπιδράσεων: Οι λεπτές εξαρτήσεις και οι συσχετισμοί μέσα στην ακολουθία έρχονται στο φως, οδηγώντας σε μια πλουσιότερη κατανόηση της δομής και της δυναμικής των δεδομένων.

- Προσδιορίστε τα συμφραζόμενα κάθε στοιχείου: Το μοντέλο αναλύει κάθε στοιχείο όχι μεμονωμένα αλλά εντός του ευρύτερου πλαισίου της ακολουθίας, οδηγώντας σε πιο ακριβείς και διαφοροποιημένες προβλέψεις ή αναπαραστάσεις.

Η αυτοπροσοχή έχει φέρει επανάσταση στον τρόπο με τον οποίο τα μοντέλα επεξεργάζονται διαδοχικά δεδομένα, ξεκλειδώνοντας νέες δυνατότητες σε διάφορα πεδία όπως η αυτόματη μετάφραση, η παραγωγή φυσικής γλώσσας, η πρόβλεψη χρονοσειρών και άλλα. Η ικανότητά του να αποκαλύπτει τις κρυφές σχέσεις μέσα σε ακολουθίες παρέχει ένα ισχυρό εργαλείο για την αποκάλυψη πληροφοριών και την επίτευξη ανώτερης απόδοσης σε ένα ευρύ φάσμα εργασιών.

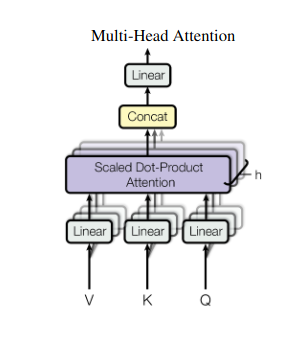

2. Προσοχή πολλαπλών κεφαλών: Βλέποντας μέσα από διαφορετικούς φακούς

Η αυτοπροσοχή παρέχει μια ολιστική άποψη, αλλά μερικές φορές η εστίαση σε συγκεκριμένες πτυχές των δεδομένων είναι ζωτικής σημασίας. Εκεί έρχεται η προσοχή πολλών κεφαλών. Φανταστείτε να έχετε πολλούς βοηθούς, ο καθένας εξοπλισμένος με διαφορετικό φακό:

- Πολλαπλά «κεφάλια» δημιουργούνται, το καθένα παρακολουθεί την ακολουθία εισόδου μέσω των δικών του πινάκων Q, K και V.

- Κάθε κεφάλι μαθαίνει να εστιάζει σε διαφορετικές πτυχές των δεδομένων, όπως εξαρτήσεις μεγάλης εμβέλειας, συντακτικές σχέσεις ή τοπικές αλληλεπιδράσεις λέξεων.

- Οι έξοδοι από κάθε κεφαλή στη συνέχεια ενώνονται και προβάλλονται σε μια τελική αναπαράσταση, αποτυπώνοντας την πολύπλευρη φύση της εισόδου.

Αυτό επιτρέπει στο μοντέλο να εξετάζει ταυτόχρονα διάφορες προοπτικές, οδηγώντας σε μια πιο πλούσια και πιο λεπτή κατανόηση των δεδομένων.

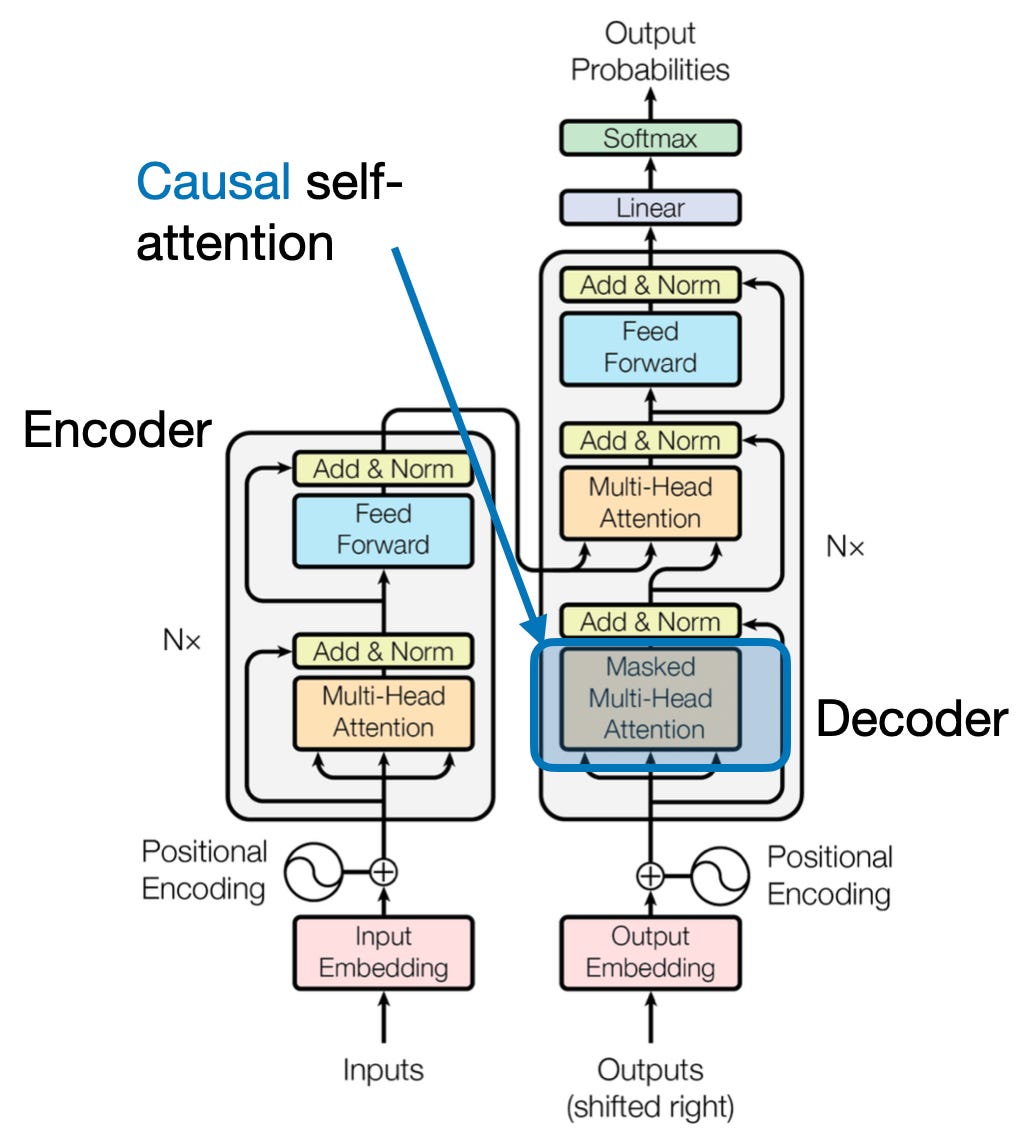

3. Διασταυρούμενη Προσοχή: Χτίζοντας Γέφυρες Ανάμεσα σε Ακολουθίες

Η ικανότητα κατανόησης των συνδέσεων μεταξύ διαφορετικών τμημάτων πληροφοριών είναι ζωτικής σημασίας για πολλές εργασίες NLP. Φανταστείτε να γράφετε μια κριτική βιβλίου – δεν θα συνοψίζετε απλώς το κείμενο λέξη προς λέξη, αλλά μάλλον θα αντλείτε ιδέες και συνδέσεις μεταξύ των κεφαλαίων. Εισαγω διασταυρούμενη προσοχή, ένας ισχυρός μηχανισμός που δημιουργεί γέφυρες μεταξύ ακολουθιών, ενδυναμώνοντας τα μοντέλα να αξιοποιούν πληροφορίες από δύο διαφορετικές πηγές.

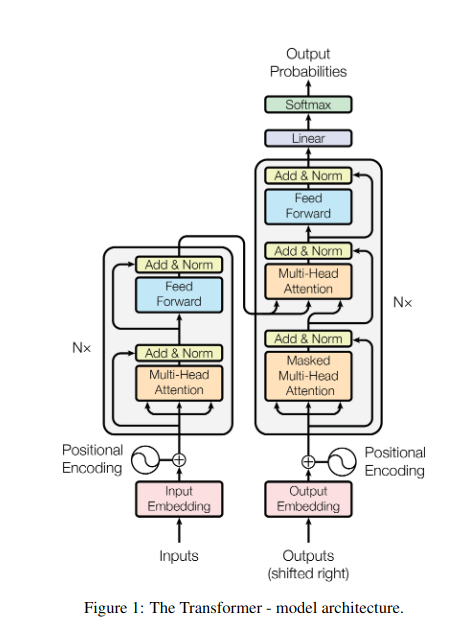

- Σε αρχιτεκτονικές κωδικοποιητή-αποκωδικοποιητή όπως οι Transformers, το κωδικοποιητή επεξεργάζεται την ακολουθία εισόδου (το βιβλίο) και δημιουργεί μια κρυφή αναπαράσταση.

- Η αποκωδικοποιητή χρησιμοποιεί διασταυρούμενη προσοχή για να παρακολουθεί την κρυφή αναπαράσταση του κωδικοποιητή σε κάθε βήμα, ενώ δημιουργεί την ακολουθία εξόδου (την ανασκόπηση).

- Ο πίνακας Q του αποκωδικοποιητή αλληλεπιδρά με τους πίνακες K και V του κωδικοποιητή, επιτρέποντάς του να εστιάζει σε σχετικά μέρη του βιβλίου ενώ γράφει κάθε πρόταση της κριτικής.

Αυτός ο μηχανισμός είναι ανεκτίμητος για εργασίες όπως η αυτόματη μετάφραση, η περίληψη και η απάντηση ερωτήσεων, όπου η κατανόηση των σχέσεων μεταξύ των ακολουθιών εισόδου και εξόδου είναι απαραίτητη.

4. Αιτιατική Προσοχή: Διατήρηση της ροής του χρόνου

Φανταστείτε να προβλέψετε την επόμενη λέξη σε μια πρόταση χωρίς να κοιτάξετε μπροστά. Οι παραδοσιακοί μηχανισμοί προσοχής παλεύουν με εργασίες που απαιτούν τη διατήρηση της χρονικής σειράς των πληροφοριών, όπως η δημιουργία κειμένου και η πρόβλεψη χρονοσειρών. Εύκολα «κοιτάζουν μπροστά» στη σειρά, οδηγώντας σε ανακριβείς προβλέψεις. Η αιτιολογική προσοχή αντιμετωπίζει αυτόν τον περιορισμό διασφαλίζοντας ότι οι προβλέψεις εξαρτώνται αποκλειστικά από πληροφορίες που έχουν υποστεί προηγούμενη επεξεργασία.

Ετσι δουλευει

- Μηχανισμός κάλυψης: Μια συγκεκριμένη μάσκα εφαρμόζεται στα βάρη προσοχής, εμποδίζοντας αποτελεσματικά την πρόσβαση του μοντέλου σε μελλοντικά στοιχεία της σειράς. Για παράδειγμα, όταν προβλέπει τη δεύτερη λέξη στο «η γυναίκα που…», το μοντέλο μπορεί να λάβει υπόψη μόνο «το» και όχι «ποιος» ή επόμενες λέξεις.

- Αυτοπαλινδρομική Επεξεργασία: Οι πληροφορίες ρέουν γραμμικά, με την αναπαράσταση κάθε στοιχείου να βασίζεται αποκλειστικά σε στοιχεία που εμφανίζονται μπροστά του. Το μοντέλο επεξεργάζεται την ακολουθία λέξη προς λέξη, δημιουργώντας προβλέψεις με βάση το πλαίσιο που δημιουργήθηκε μέχρι εκείνο το σημείο.

Η αιτιολογική προσοχή είναι ζωτικής σημασίας για εργασίες όπως η δημιουργία κειμένου και η πρόβλεψη χρονοσειρών, όπου η διατήρηση της χρονικής σειράς των δεδομένων είναι ζωτικής σημασίας για ακριβείς προβλέψεις.

5. Παγκόσμια vs. Τοπική Προσοχή: Εξασφάλιση της ισορροπίας

Οι μηχανισμοί προσοχής αντιμετωπίζουν έναν βασικό συμβιβασμό: την καταγραφή εξαρτήσεων μεγάλης εμβέλειας έναντι της διατήρησης αποτελεσματικού υπολογισμού. Αυτό εκδηλώνεται με δύο κύριες προσεγγίσεις: παγκόσμια προσοχή και τοπική προσοχή. Φανταστείτε να διαβάζετε ένα ολόκληρο βιβλίο αντί να εστιάσετε σε ένα συγκεκριμένο κεφάλαιο. Η συνολική προσοχή επεξεργάζεται ολόκληρη τη σειρά ταυτόχρονα, ενώ η τοπική προσοχή εστιάζει σε ένα μικρότερο παράθυρο:

- Παγκόσμια προσοχή καταγράφει εξαρτήσεις μεγάλης εμβέλειας και το συνολικό πλαίσιο, αλλά μπορεί να είναι υπολογιστικά ακριβό για μεγάλες ακολουθίες.

- Τοπική προσοχή είναι πιο αποτελεσματικό, αλλά μπορεί να χάσει τις μακρινές σχέσεις.

Η επιλογή μεταξύ παγκόσμιας και τοπικής προσοχής εξαρτάται από διάφορους παράγοντες:

- Απαιτήσεις εργασιών: Εργασίες όπως η μηχανική μετάφραση απαιτούν την καταγραφή μακρινών σχέσεων, ευνοώντας την παγκόσμια προσοχή, ενώ η ανάλυση συναισθήματος μπορεί να ευνοήσει την εστίαση της τοπικής προσοχής.

- Μήκος ακολουθίας: Οι μεγαλύτερες ακολουθίες καθιστούν την παγκόσμια προσοχή υπολογιστικά ακριβή, απαιτώντας τοπικές ή υβριδικές προσεγγίσεις.

- Χωρητικότητα μοντέλου: Οι περιορισμοί πόρων ενδέχεται να απαιτούν τοπική προσοχή ακόμη και για εργασίες που απαιτούν παγκόσμιο πλαίσιο.

Για να επιτευχθεί η βέλτιστη ισορροπία, τα μοντέλα μπορούν να χρησιμοποιήσουν:

- Δυναμική εναλλαγή: χρησιμοποιήστε την παγκόσμια προσοχή για βασικά στοιχεία και την τοπική προσοχή για άλλους, προσαρμόζοντας τη σημασία και την απόσταση.

- Υβριδικές προσεγγίσεις: συνδυάστε και τους δύο μηχανισμούς μέσα στο ίδιο στρώμα, αξιοποιώντας τις αντίστοιχες δυνάμεις τους.

Διαβάστε επίσης: Ανάλυση τύπων νευρωνικών δικτύων στη βαθιά μάθηση

Συμπέρασμα

Τελικά, η ιδανική προσέγγιση βρίσκεται σε ένα φάσμα μεταξύ παγκόσμιας και τοπικής προσοχής. Η κατανόηση αυτών των αντισταθμίσεων και η υιοθέτηση κατάλληλων στρατηγικών επιτρέπει στα μοντέλα να εκμεταλλεύονται αποτελεσματικά τις σχετικές πληροφορίες σε διαφορετικές κλίμακες, οδηγώντας σε μια πλουσιότερη και ακριβέστερη κατανόηση της ακολουθίας.

αναφορές

- Raschka, S. (2023). «Κατανόηση και κωδικοποίηση της προσοχής του εαυτού, της πολλαπλής προσοχής, της διασταυρούμενης προσοχής και της αιτιολογικής προσοχής στα LLMs».

- Vaswani, Α., et al. (2017). «Η προσοχή είναι το μόνο που χρειάζεστε».

- Radford, Α., et al. (2019). "Τα γλωσσικά μοντέλα είναι μαθητές πολλαπλών εργασιών χωρίς επίβλεψη."

Σχετικά:

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://www.analyticsvidhya.com/blog/2024/01/different-types-of-attention-mechanisms/

- :έχει

- :είναι

- :δεν

- :που

- $UP

- 1

- 2017

- 2019

- 2023

- 302

- 320

- 321

- 7

- a

- ικανότητα

- πρόσβαση

- ακρίβεια

- ακριβής

- Κατορθώνω

- την επίτευξη

- απέναντι

- πράξεις

- πραγματικός

- διευθύνσεις

- υιοθετώντας

- εμπρός

- AL

- Όλα

- Επιτρέποντας

- επιτρέπει

- am

- Ασάφεια

- Ποσά

- an

- ανάλυση

- αναλύσεις

- αναλύοντας

- και

- απάντηση

- χώρια

- εμφανής

- εφαρμοσμένος

- πλησιάζω

- προσεγγίσεις

- ΕΙΝΑΙ

- περιοχές

- άρθρο

- AS

- πτυχές

- Βοηθός

- βοηθούς

- At

- παραβρίσκομαι

- παρακολούθηση

- προσοχή

- επίγνωση

- Υπόλοιπο

- βασίζονται

- βάση

- BE

- Πλάτος

- γίνονται

- πριν

- μεταξύ

- Πέρα

- κλείδωμα

- βιβλίο

- Βιβλία

- και οι δύο

- ΓΕΦΥΡΑ

- γέφυρες

- Φωτεινό

- ευρύτερη

- Έφερε

- Κτίριο

- Χτίζει

- χτισμένο

- αλλά

- by

- ήρθε

- CAN

- πιάνω

- συλλαμβάνει

- Καταγραφή

- περιπτώσεις

- αλλαγή

- Κεφάλαιο

- Κεφάλαια

- επιλογή

- πιο κοντά

- Κωδικοποίηση

- συνδυασμός

- έρχεται

- Εταιρείες

- συμβατότητα

- συγκρότημα

- υπολογισμός

- υπολογιστική

- Connect

- Συνδετικός

- Διασυνδέσεις

- Εξετάστε

- θεωρώντας

- περιορισμούς

- Περιέχει

- περιεχόμενο

- συμφραζόμενα

- ΣΥΝΕΧΕΙΑ

- πυρήνας

- συσχετισμοί

- δημιουργήθηκε

- δημιουργεί

- δημιουργία

- κρίσιμης

- κρίσιμος

- Ρεύμα

- ημερομηνία

- επιστημονικά δεδομένα

- Αποκρυπτογραφώ

- βαθύς

- βαθύτερη

- ορίζεται

- ντελ

- εξαρτηθεί

- εξάρτηση

- εξαρτήσεις

- Εξάρτηση

- εξαρτάται

- λεπτομερής

- Διάλογος

- DID

- διαφορετικές

- κατευθείαν

- απόσταση

- μακρινός

- διακριτή

- διάφορα

- do

- έγγραφο

- DOT

- διπλασιαστεί

- δεκάδες

- δραματικά

- σχεδιάζω

- δυο

- δυναμική

- Ε & Τ

- κάθε

- αποτελεσματικά

- αποδοτικότητα

- αποτελεσματικός

- αποτελεσματικά

- στοιχείο

- στοιχεία

- ενδυνάμωση

- δίνει τη δυνατότητα

- ενεργοποίηση

- κωδικοποίησης

- εμπλουτισμένος

- εξασφαλίζω

- εξασφαλίζοντας

- εισάγετε

- Ολόκληρος

- ολότητα

- εξοπλισμένο

- ειδικά

- ουσία

- ουσιώδης

- κατ 'ουσίαν,

- εγκατεστημένος

- Even

- Κάθε

- εξελίσσονται

- ακριβώς

- ακριβά

- Εκμεταλλεύομαι

- εκχύλισμα

- Πρόσωπο

- παράγοντες

- μακριά

- ευνοούν

- πεδίο

- Πεδία

- τελικός

- ροή

- Ροές

- Συγκέντρωση

- επικεντρώθηκε

- εστιάζει

- εστιάζοντας

- Για

- Πρώτη γραμμή

- μορφές

- Θεμέλιο

- τέσσερα

- Πλαίσιο

- από

- λειτουργία

- λειτουργίες

- μελλοντικός

- παιχνίδι

- δημιουργεί

- παραγωγής

- γενεά

- Παγκόσμιο

- παγκόσμιο πλαίσιο

- πιάσιμο

- Grow

- Οδηγοί

- καθοδήγηση

- λαβή

- Έχω

- που έχει

- κεφάλι

- βοήθεια

- κρυμμένο

- Ψηλά

- υψηλότερο

- επισήμανση

- κατέχει

- ολιστική

- Πως

- HTTPS

- ανθρώπινος

- Υβριδικό

- i

- ιδανικό

- προσδιορίσει

- if

- φαντάζομαι

- άμεσος

- σπουδαιότητα

- σημαντικό

- in

- ανακριβής

- ενσωματώνοντας

- υποδεικνύω

- ατομικές

- ανεπαρκής

- πληροφορίες

- εκ φύσεως

- εισαγωγή

- ιδέες

- παράδειγμα

- Έξυπνος

- προορίζονται

- αλληλεπίδραση

- αλληλεπιδράσεις

- διαδραστικός

- παρέμβασης

- σε

- ανεκτίμητος

- απομόνωση

- IT

- ΤΟΥ

- jpg

- μόλις

- Κλειδί

- Περιοχές κλειδιά

- Γλώσσα

- Επίθετο

- στρώμα

- που οδηγεί

- ΜΑΘΑΊΝΩ

- Μάθετε και μεγαλώστε

- μαθητές

- μάθηση

- Led

- Φακός

- φακούς

- Μόχλευση

- μόχλευσης

- Βιβλιοθήκη

- βρίσκεται

- φως

- Μου αρέσει

- περιορισμός

- περιορισμούς

- τοπικός

- Μακριά

- πλέον

- ματιά

- αγάπη

- μηχανή

- μάθηση μηχανής

- μηχανική μετάφραση

- Η διατήρηση

- κάνω

- Κατασκευή

- άνδρας

- πολοί

- μάσκα

- Μήτρα

- max-width

- νόημα

- σημασίες

- μετράται

- μηχανισμός

- μηχανισμούς

- Μνήμη

- ενδέχεται να

- χάσετε

- Λείπει

- μοντέλο

- μοντέλα

- περισσότερο

- πιο αποτελεσματικό

- πολύπλευρη

- πολλαπλούς

- Φυσικό

- Φυσική γλώσσα

- Φυσική Γλώσσα

- Επεξεργασία φυσικής γλώσσας

- Φυσική κατανόηση της γλώσσας

- Φύση

- Ανάγκη

- χρειάζονται

- ανάγκες

- γείτονες

- δίκτυα

- Νευρικός

- νευρωνικά δίκτυα

- Νέα

- επόμενη

- βράδυ

- nlp

- ουσιαστικά

- τώρα

- αποχρώσεις

- of

- συχνά

- on

- μια φορά

- αποκλειστικά

- βέλτιστη

- or

- τάξη

- ΑΛΛΑ

- Άλλα

- δικός μας

- έξω

- παραγωγή

- εξόδους

- φόρμες

- επισκόπηση

- δική

- σελίδα

- ζεύγος

- Χαρτί

- Παράλληλο

- εξαρτήματα

- χωρία

- Το παρελθόν

- πρότυπα

- εκτελέσει

- επίδοση

- προοπτικές

- κομμάτια

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- Δοκιμάστε να παίξετε

- Σημείο

- θέτει

- διαθέτει

- δυνατότητες

- ισχυρός

- δυναμικού

- ενδεχομένως

- δύναμη

- ισχυρός

- προβλέποντας

- Προβλέψεις

- διατηρώντας

- πρόληψη

- προηγουμένως

- πρωτίστως

- πρωταρχικός

- διαδικασια μας

- επεξεργασία

- Διεργασίες

- μεταποίηση

- Επεξεργαστικη ΙΣΧΥΣ

- Προϊόν

- προβλέπεται

- ωθείται

- παρέχει

- ερώτηση

- σειρά

- κυμαίνεται

- μάλλον

- Διάβασε

- πρόθυμα

- Ανάγνωση

- σε πραγματικό χρόνο

- αναφορά

- Ανεξάρτητα

- Σχέσεις

- σχετικής

- συνάφεια

- αξιοσημείωτος

- αντιπροσώπευση

- εκπροσωπούν

- αντιπροσωπεύει

- απαιτούν

- επίλυση

- πόρος

- Υποστηρικτικό υλικό

- εκείνοι

- Αποτελέσματα

- ανασκόπηση

- επαναστατικός

- επανάσταση

- Πλούσιος

- Ρόλος

- s

- ίδιο

- Σαρκασμός

- πριόνι

- Ζυγός

- σάρωσης

- Επιστήμη

- σκορ

- αποτελέσματα

- Αναζήτηση

- Δεύτερος

- βλέποντας

- ποινή

- συναίσθημα

- Ακολουθία

- Σειρές

- εξυπηρετεί

- διάφοροι

- Κοινοποίηση

- λάμψη

- γυρίσματα

- Κοντά

- βιτρίνα

- ταυτοχρόνως

- επιβραδύνουν

- μικρότερος

- μόνο

- SOLVE

- μερικές φορές

- Πηγές

- Χώρος

- συγκεκριμένες

- ειδικά

- Φάσμα

- ταχύτητες

- Προβολέας θέατρου

- ορθοστασία

- Αστέρι

- Βήμα

- καταστήματα

- στρατηγικές

- δυνατά

- ισχυρότερη

- δομή

- Πάλη

- Παλεύοντας

- θέμα

- μεταγενέστερος

- τέτοιος

- κατάλληλος

- άθροισμα

- συνοψίζω

- ΠΕΡΙΛΗΨΗ

- ανώτερος

- περιβάλλων

- συστήματα

- ανυψωτήρ

- λήψη

- ταπισερί

- εργασίες

- Τεχνικός

- όρος

- κείμενο

- δημιουργία κειμένου

- ότι

- Η

- ο κόσμος

- τους

- Τους

- τότε

- Αυτοί

- αυτοί

- αυτό

- τρία

- Μέσω

- ώρα

- Χρονική σειρά

- προς την

- εργαλείο

- παραδοσιακός

- Εκπαίδευση

- μεταμορφωτικός

- μετασχηματίζεται

- μετασχηματιστής

- μετασχηματιστές

- μετασχηματίζοντας

- Μετάφραση

- αληθής

- δύο

- τύποι

- τελικά

- καταλαβαίνω

- κατανόηση

- αναμφίβολα

- ξεκλειδώματος

- αποκαλύπτω

- αποκαλυπτήρια

- χρήση

- χρησιμοποιεί

- χρησιμοποιώντας

- διάφορα

- Σταθερή

- Εναντίον

- Δες

- επισκέφθηκε

- ζωτικής σημασίας

- vs

- θέλω

- θέλει

- ήταν

- ΛΟΙΠΌΝ

- Τι

- πότε

- ενώ

- Ο ΟΠΟΊΟΣ

- ολόκληρο

- ευρύς

- Ευρύ φάσμα

- θα

- παράθυρο

- με

- εντός

- χωρίς

- γυναίκα

- λέξη

- λόγια

- Εργασία

- κόσμος

- γραφή

- χτες

- εσείς

- zephyrnet

- ΖΩΟΛΟΓΙΚΟΣ ΚΗΠΟΣ