Οι πρόσφατες πρόοδοι στην ανάπτυξη των LLM έχουν διαδώσει τη χρήση τους για διάφορες εργασίες NLP που προηγουμένως αντιμετωπίζονταν χρησιμοποιώντας παλαιότερες μεθόδους μηχανικής μάθησης. Τα μεγάλα γλωσσικά μοντέλα είναι ικανά να λύσουν μια ποικιλία γλωσσικών προβλημάτων, όπως ταξινόμηση, σύνοψη, ανάκτηση πληροφοριών, δημιουργία περιεχομένου, απάντηση ερωτήσεων και διατήρηση μιας συνομιλίας — όλα χρησιμοποιώντας ένα μόνο μοντέλο. Αλλά πώς ξέρουμε ότι κάνουν καλή δουλειά σε όλες αυτές τις διαφορετικές εργασίες;

Η άνοδος των LLMs έφερε στο φως ένα άλυτο πρόβλημα: δεν έχουμε αξιόπιστο πρότυπο για την αξιολόγησή τους. Αυτό που κάνει την αξιολόγηση πιο δύσκολη είναι ότι χρησιμοποιούνται για εξαιρετικά διαφορετικές εργασίες και δεν έχουμε σαφή ορισμό για το ποια είναι η καλή απάντηση για κάθε περίπτωση χρήσης.

Αυτό το άρθρο εξετάζει τις τρέχουσες προσεγγίσεις για την αξιολόγηση των LLM και εισάγει έναν νέο πίνακα κατάταξης LLM που αξιοποιεί την ανθρώπινη αξιολόγηση που βελτιώνει τις υπάρχουσες τεχνικές αξιολόγησης.

Η πρώτη και συνήθης αρχική μορφή αξιολόγησης είναι η εκτέλεση του μοντέλου σε πολλά επιμελημένα σύνολα δεδομένων και η εξέταση της απόδοσής του. Το HuggingFace δημιούργησε ένα Ανοίξτε το Leaderboard LLM όπου τα μεγάλα μοντέλα ανοιχτής πρόσβασης αξιολογούνται χρησιμοποιώντας τέσσερα γνωστά σύνολα δεδομένων (AI2 Reasoning Challenge , HellaSwag , MMLU , TruthfulQA). Αυτό αντιστοιχεί στην αυτόματη αξιολόγηση και ελέγχει την ικανότητα του μοντέλου να λαμβάνει τα δεδομένα για ορισμένες συγκεκριμένες ερωτήσεις.

Αυτό είναι ένα παράδειγμα ερώτησης από το MMLU σύνολο δεδομένων

Θέμα: κολέγιο_ιατρική

Ερώτηση: Μια αναμενόμενη παρενέργεια της λήψης συμπληρωμάτων κρεατίνης είναι.

- Α) μυϊκή αδυναμία

- Β) αύξηση μάζας σώματος

- Γ) μυϊκές κράμπες

- Δ) απώλεια ηλεκτρολυτών

Απάντηση: (Β)

Η βαθμολόγηση του μοντέλου για την απάντηση αυτού του τύπου ερωτήσεων είναι μια σημαντική μέτρηση και χρησιμεύει καλά για τον έλεγχο των γεγονότων, αλλά δεν δοκιμάζει τη παραγωγική ικανότητα του μοντέλου. Αυτό είναι ίσως το μεγαλύτερο μειονέκτημα αυτής της μεθόδου αξιολόγησης, επειδή η δημιουργία ελεύθερου κειμένου είναι ένα από τα πιο σημαντικά χαρακτηριστικά των LLM.

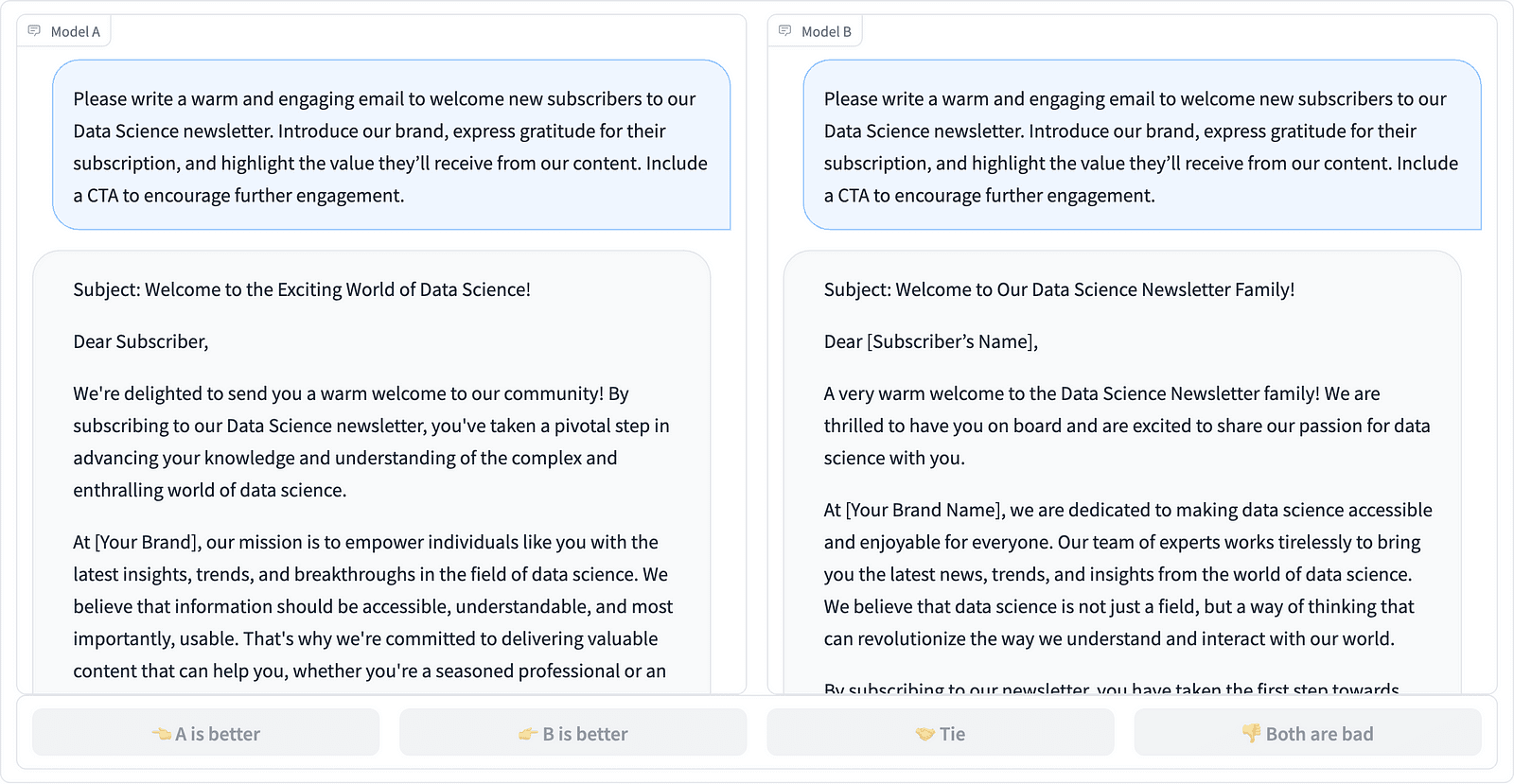

Φαίνεται ότι υπάρχει συναίνεση μέσα στην κοινότητα ότι για να αξιολογήσουμε σωστά το μοντέλο χρειαζόμαστε ανθρώπινη αξιολόγηση. Αυτό γίνεται συνήθως συγκρίνοντας τις απαντήσεις από διαφορετικά μοντέλα.

Συγκρίνοντας δύο άμεσες ολοκληρώσεις στο έργο LMSYS – στιγμιότυπο οθόνης από τον συγγραφέα

Οι σχολιαστές αποφασίζουν ποια απόκριση είναι καλύτερη, όπως φαίνεται στο παραπάνω παράδειγμα, και μερικές φορές ποσοτικοποιούν τη διαφορά στην ποιότητα των ολοκληρώσεων προτροπής. Το LMSYS Org έχει δημιουργήσει ένα leaderboard που χρησιμοποιεί αυτό το είδος ανθρώπινης αξιολόγησης και συγκρίνει 17 διαφορετικά μοντέλα, αναφέροντας το Βαθμολογία Elo για κάθε μοντέλο.

Επειδή η ανθρώπινη αξιολόγηση μπορεί να είναι δύσκολο να κλιμακωθεί, έχουν γίνει προσπάθειες να κλιμακωθεί και να επιταχυνθεί η διαδικασία αξιολόγησης και αυτό κατέληξε σε ένα ενδιαφέρον έργο που ονομάζεται AlpacaEval. Εδώ κάθε μοντέλο συγκρίνεται με μια βασική γραμμή (κείμενο-davinci-003 που παρέχεται από το GPT-4) και η ανθρώπινη αξιολόγηση αντικαθίσταται με την κρίση GPT-4. Αυτό είναι πράγματι γρήγορο και επεκτάσιμο, αλλά μπορούμε να εμπιστευτούμε το μοντέλο εδώ για να εκτελέσει τη βαθμολογία; Πρέπει να γνωρίζουμε τις προκαταλήψεις του μοντέλου. Το έργο έδειξε στην πραγματικότητα ότι το GPT-4 μπορεί να ευνοήσει μεγαλύτερες απαντήσεις.

Οι μέθοδοι αξιολόγησης LLM συνεχίζουν να εξελίσσονται καθώς η κοινότητα AI αναζητά εύκολες, δίκαιες και επεκτάσιμες προσεγγίσεις. Η τελευταία εξέλιξη έρχεται από την ομάδα στο Τολόκα με ένα νέο leaderboard για περαιτέρω προώθηση των υφιστάμενων προτύπων αξιολόγησης.

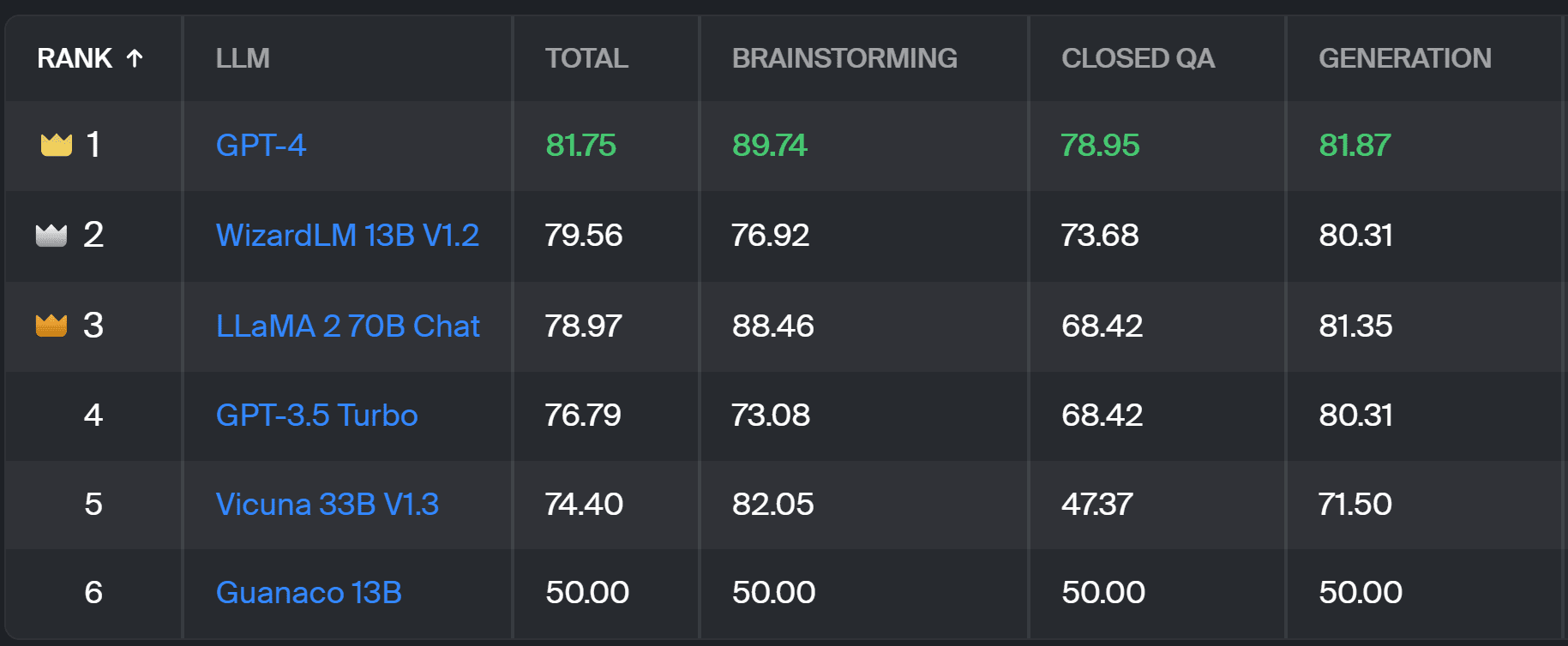

Το νέο leaderboard συγκρίνει τις αποκρίσεις του μοντέλου με τις προτροπές χρηστών του πραγματικού κόσμου που κατηγοριοποιούνται από χρήσιμες εργασίες NLP, όπως περιγράφεται στο αυτό το έγγραφο InstructGPT. Δείχνει επίσης το συνολικό ποσοστό νίκης κάθε μοντέλου σε όλες τις κατηγορίες.

Toloka leaderboard – στιγμιότυπο οθόνης από τον συγγραφέα

Η αξιολόγηση που χρησιμοποιήθηκε για αυτό το έργο είναι παρόμοια με αυτή που πραγματοποιήθηκε στο AlpacaEval. Οι βαθμολογίες στον πίνακα κατάταξης αντιπροσωπεύουν το ποσοστό νίκης του αντίστοιχου μοντέλου σε σύγκριση με το Γκουανάκο 13Β μοντέλο, το οποίο χρησιμεύει εδώ ως σύγκριση βάσης. Η επιλογή του Guanaco 13B είναι μια βελτίωση της μεθόδου AlpacaEval, η οποία χρησιμοποιεί ως βάση το σύντομα ξεπερασμένο μοντέλο text-davinci-003.

Η πραγματική αξιολόγηση πραγματοποιείται από ανθρώπους ειδικούς σχολιαστές σε ένα σύνολο εντολών του πραγματικού κόσμου. Για κάθε προτροπή, δίνονται στους σχολιαστές δύο συμπληρώσεις και ερωτώνται ποια προτιμούν. Μπορείτε να βρείτε λεπτομέρειες σχετικά με τη μεθοδολογία εδώ.

Αυτός ο τύπος ανθρώπινης αξιολόγησης είναι πιο χρήσιμος από οποιαδήποτε άλλη μέθοδο αυτόματης αξιολόγησης και θα πρέπει να βελτιώσει την ανθρώπινη αξιολόγηση που χρησιμοποιείται για το LMSYS leaderboard. Το μειονέκτημα της μεθόδου LMSYS είναι ότι οποιοσδήποτε με το σύνδεσμος μπορεί να λάβει μέρος στην αξιολόγηση, εγείροντας σοβαρά ερωτήματα σχετικά με την ποιότητα των δεδομένων που συλλέγονται με αυτόν τον τρόπο. Ένα κλειστό πλήθος ειδικών σχολιαστών έχει καλύτερες δυνατότητες για αξιόπιστα αποτελέσματα και η Toloka εφαρμόζει πρόσθετες τεχνικές ποιοτικού ελέγχου για να διασφαλίσει την ποιότητα των δεδομένων.

Σε αυτό το άρθρο, παρουσιάσαμε μια πολλά υποσχόμενη νέα λύση για την αξιολόγηση των LLMs — το Toloka Leaderboard. Η προσέγγιση είναι καινοτόμος, συνδυάζει τα πλεονεκτήματα των υπαρχουσών μεθόδων, προσθέτει ευαισθησία για συγκεκριμένες εργασίες και χρησιμοποιεί αξιόπιστες τεχνικές ανθρώπινου σχολιασμού για τη σύγκριση των μοντέλων.

Εξερευνήστε τον πίνακα και μοιραστείτε τις απόψεις και τις προτάσεις σας για βελτιώσεις μαζί μας.

Magdalena Konkiewicz είναι Ευαγγελιστής δεδομένων στην Toloka, μια παγκόσμια εταιρεία που υποστηρίζει γρήγορη και επεκτάσιμη ανάπτυξη τεχνητής νοημοσύνης. Είναι κάτοχος μεταπτυχιακού τίτλου στην Τεχνητή Νοημοσύνη από το Πανεπιστήμιο του Εδιμβούργου και έχει εργαστεί ως Μηχανικός NLP, Developer και Data Scientist για επιχειρήσεις στην Ευρώπη και την Αμερική. Έχει επίσης ασχοληθεί με τη διδασκαλία και την καθοδήγηση Επιστημόνων Δεδομένων και συμβάλλει τακτικά σε εκδόσεις Επιστήμης Δεδομένων και Μηχανικής Μάθησης.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :έχει

- :είναι

- :δεν

- :που

- $UP

- 17

- a

- ικανότητα

- Σχετικα

- πάνω από

- απέναντι

- πραγματικός

- πραγματικά

- Πρόσθετος

- Προσθέτει

- εκ των προτέρων

- προκαταβολές

- AI

- Όλα

- Επίσης

- Αμερική

- an

- και

- απάντηση

- απαντήσεις

- κάθε

- ισχύει

- πλησιάζω

- προσεγγίσεις

- ΕΙΝΑΙ

- Αρένα

- άρθρο

- τεχνητός

- τεχνητή νοημοσύνη

- AS

- At

- Αυτόματο

- επίγνωση

- b

- Baseline

- BE

- επειδή

- ήταν

- Καλύτερα

- μεροληψίες

- Μεγαλύτερη

- επιτροπή

- σώμα

- Έφερε

- επιχειρήσεις

- αλλά

- by

- CAN

- ικανός

- περίπτωση

- κατηγορίες

- πρόκληση

- έλεγχοι

- επιλογή

- ταξινόμηση

- καθαρός

- κλειστό

- συνδυάζει

- έρχεται

- κοινότητα

- εταίρα

- συγκρίνουν

- σύγκριση

- συγκρίνοντας

- σύγκριση

- Ομοφωνία

- περιεχόμενο

- δημιουργία περιεχομένου

- συνεχίζοντας

- συμβάλλει

- έλεγχος

- Συνομιλία

- αντιστοιχεί

- δημιουργήθηκε

- δημιουργία

- πλήθος

- επιμέλεια

- Ρεύμα

- ημερομηνία

- την ποιότητα των δεδομένων

- επιστημονικά δεδομένα

- επιστήμονας δεδομένων

- σύνολα δεδομένων

- αποφασίζει

- ορισμός

- Πτυχίο

- καθέκαστα

- Εργολάβος

- Ανάπτυξη

- διαφορά

- διαφορετικές

- Μειονέκτημα

- διάφορα

- do

- κάνει

- πράξη

- γίνεται

- Μην

- μειονέκτημα

- κάθε

- εύκολος

- Εδιμβούργο

- αποτέλεσμα

- προσπάθειες

- ηλεκτρολύτες

- μηχανικός

- εξασφαλίζω

- Ευρώπη

- αξιολογήσει

- αξιολόγηση

- αξιολογώντας

- εκτίμηση

- Ευαγγελιστής

- εξελίσσονται

- εξετάζω

- παράδειγμα

- υφιστάμενα

- αναμένεται

- εμπειρογνώμονας

- γεγονότα

- έκθεση

- FAST

- ευνοούν

- Χαρακτηριστικά

- Εύρεση

- Όνομα

- Για

- μορφή

- τέσσερα

- Δωρεάν

- από

- περαιτέρω

- Κέρδος

- συγκεντρώθηκαν

- παραγωγής

- γενετική

- παίρνω

- GitHub

- δεδομένου

- Παγκόσμιο

- καλός

- καλή δουλειά

- Σκληρά

- σκληρότερα

- Έχω

- εδώ

- υψηλά

- κατέχει

- Πως

- HTTPS

- Πρόσωπο αγκαλιάς

- ανθρώπινος

- σημαντικό

- βελτίωση

- βελτίωση

- βελτιώσεις

- βελτιώνει

- in

- πληροφορίες

- αρχικός

- καινοτόμες

- Νοημοσύνη

- ενδιαφέρον

- εισήγαγε

- Εισάγει

- συμμετέχουν

- IT

- ΤΟΥ

- Δουλειά

- μόλις

- μόνο ένα

- KDnuggets

- Ξέρω

- Έλλειψη

- Γλώσσα

- large

- αργότερο

- μάθηση

- μόχλευσης

- φως

- πλέον

- off

- μηχανή

- μάθηση μηχανής

- Η διατήρηση

- ΚΑΝΕΙ

- τρόπος

- Μάζα

- κύριος

- Ενδέχεται..

- mentoring

- μέθοδος

- Μεθοδολογία

- μέθοδοι

- μετρικός

- μοντέλο

- μοντέλα

- περισσότερο

- πλέον

- μυς

- Ανάγκη

- Νέα

- νέα λύση

- nlp

- of

- ηλικιωμένων

- on

- ONE

- ανοίξτε

- Απόψεις

- ΑΛΛΑ

- σκιαγραφείται

- φόρμες

- μέρος

- εκτελέσει

- επίδοση

- εκτελούνται

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- δυναμικού

- προτιμώ

- προηγουμένως

- πιθανώς

- Πρόβλημα

- προβλήματα

- διαδικασια μας

- σχέδιο

- υποσχόμενος

- προτρέπει

- δεόντως

- παρέχεται

- δημοσιεύσεις

- ποιότητα

- ερώτηση

- Ερωτήσεις

- αύξηση

- Τιμή

- πραγματικό κόσμο

- τακτικά

- αξιόπιστος

- αντικατασταθούν

- Αναφορά

- εκπροσωπώ

- εκείνοι

- απάντησης

- απαντήσεις

- είχε ως αποτέλεσμα

- Αποτελέσματα

- Αύξηση

- τρέξιμο

- s

- επεκτάσιμη

- Κλίμακα

- Επιστήμη

- Επιστήμονας

- επιστήμονες

- αποτελέσματα

- βαθμολόγησης

- αναζητήσεις

- φαίνεται

- δει

- σοβαρός

- εξυπηρετεί

- σειρά

- διάφοροι

- Κοινοποίηση

- αυτή

- θα πρέπει να

- παρουσιάζεται

- Δείχνει

- πλευρά

- παρόμοιες

- ενιαίας

- λύση

- Επίλυση

- μερικοί

- μερικές φορές

- συγκεκριμένες

- ταχύτητα

- πρότυπο

- πρότυπα

- δυνατά

- τέτοιος

- Στήριξη

- Πάρτε

- εργασίες

- Διδασκαλία

- τεχνικές

- δοκιμή

- κείμενο

- από

- ότι

- Η

- τους

- Τους

- Εκεί.

- Αυτοί

- αυτοί

- αυτό

- προς την

- Εμπιστευθείτε

- δύο

- τύπος

- συνήθως

- πανεπιστήμιο

- επάνω σε

- us

- Χρήση

- χρήση

- περίπτωση χρήσης

- μεταχειρισμένος

- Χρήστες

- χρησιμοποιεί

- χρησιμοποιώντας

- συνήθης

- ποικιλία

- Τρόπος..

- we

- αδυναμία

- ΛΟΙΠΌΝ

- πολύ γνωστό

- ήταν

- Τι

- Τι είναι

- Ποιό

- νίκη

- με

- εντός

- εργάστηκαν

- εσείς

- Σας

- zephyrnet

![Τρόπος επιτάχυνσης ερωτημάτων SQL με χρήση ευρετηρίων [Python Edition] - KDnuggets](https://platoaistream.com/wp-content/uploads/2023/08/how-to-speed-up-sql-queries-using-indexes-python-edition-kdnuggets-300x169.png)