Key Take Away

- Thought Propagation (TP) ist eine neuartige Methode, die die komplexen Denkfähigkeiten von Large Language Models (LLMs) verbessert.

- TP nutzt analoge Probleme und ihre Lösungen, um das Denken zu verbessern, anstatt LLMs das Denken von Grund auf neu zu gestalten.

- Experimente zu verschiedenen Aufgaben zeigen, dass TP die Basismethoden deutlich übertrifft, wobei die Verbesserungen zwischen 12 % und 15 % liegen.

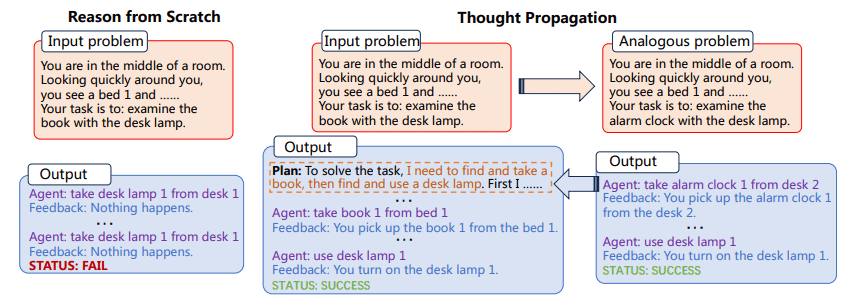

TP fordert LLMs zunächst dazu auf, eine Reihe analoger Probleme vorzuschlagen und zu lösen, die mit dem Eingabeproblem in Zusammenhang stehen. Dann verwendet TP die Ergebnisse analoger Probleme wieder, um direkt eine neue Lösung zu liefern oder einen wissensintensiven Plan für die Ausführung abzuleiten, um die ursprüngliche Lösung von Grund auf zu ändern.

Die Vielseitigkeit und Rechenleistung von Large Language Models (LLMs) ist unbestreitbar, aber nicht grenzenlos. Eine der bedeutendsten und beständigsten Herausforderungen für LLMs ist ihr allgemeiner Ansatz zur Problemlösung, der darin besteht, bei jeder neuen Aufgabe auf der Grundlage erster Prinzipien zu argumentieren. Dies ist problematisch, da es ein hohes Maß an Anpassungsfähigkeit ermöglicht, aber auch die Fehlerwahrscheinlichkeit erhöht, insbesondere bei Aufgaben, die mehrstufiges Denken erfordern.

Die Herausforderung, „von Grund auf neu zu argumentieren“, ist besonders ausgeprägt bei komplexen Aufgaben, die mehrere Schritte der Logik und Schlussfolgerung erfordern. Wenn ein LLM beispielsweise aufgefordert wird, den kürzesten Weg in einem Netzwerk miteinander verbundener Punkte zu finden, würde er normalerweise weder Vorkenntnisse noch analoge Probleme nutzen, um eine Lösung zu finden. Stattdessen würde versucht, das Problem isoliert zu lösen, was zu suboptimalen Ergebnissen oder sogar völligen Fehlern führen kann. Eingeben Gedankenverbreitung (TP), eine Methode zur Verbesserung der Argumentationsfähigkeiten von LLMs. TP zielt darauf ab, die inhärenten Einschränkungen von LLMs zu überwinden, indem es ihnen ermöglicht, aus einem Reservoir analoger Probleme und der entsprechenden Lösungen zu schöpfen. Dieser innovative Ansatz verbessert nicht nur die Genauigkeit von LLM-generierten Lösungen, sondern verbessert auch erheblich deren Fähigkeit, mehrstufige, komplexe Argumentationsaufgaben zu bewältigen. Durch die Nutzung der Kraft der Analogie bietet TP einen Rahmen, der die inhärenten Denkfähigkeiten von LLMs verstärkt und uns der Verwirklichung wirklich intelligenter künstlicher Systeme einen Schritt näher bringt.

Die Gedankenverbreitung umfasst zwei Hauptschritte:

- Zunächst wird der LLM aufgefordert, eine Reihe analoger Probleme im Zusammenhang mit dem Eingabeproblem vorzuschlagen und zu lösen

- Als nächstes werden die Lösungen dieser analogen Probleme verwendet, um entweder direkt eine neue Lösung zu ergeben oder die ursprüngliche Lösung zu ändern

Der Prozess der Identifizierung analoger Probleme ermöglicht es dem LLM, Problemlösungsstrategien und -lösungen wiederzuverwenden und dadurch seine Denkfähigkeiten zu verbessern. TP ist mit vorhandenen Eingabeaufforderungsmethoden kompatibel und bietet eine verallgemeinerbare Lösung, die ohne nennenswerte aufgabenspezifische Technik in verschiedene Aufgaben integriert werden kann.

Figure 1: Der Gedankenausbreitungsprozess (Bild aus Papier)

Darüber hinaus ist die Anpassungsfähigkeit von TP nicht zu unterschätzen. Seine Kompatibilität mit vorhandenen Eingabeaufforderungsmethoden macht es zu einem äußerst vielseitigen Werkzeug. Dies bedeutet, dass TP nicht auf eine bestimmte Art von Problemlösungsbereich beschränkt ist. Dies eröffnet spannende Möglichkeiten für aufgabenspezifische Feinabstimmung und Optimierung und steigert so den Nutzen und die Wirksamkeit von LLMs in einem breiten Anwendungsspektrum.

Die Implementierung von Thought Propagation kann in den Workflow bestehender LLMs integriert werden. Beispielsweise könnte TP in einer Aufgabe zum Denken auf dem kürzesten Weg zunächst eine Reihe einfacherer, analoger Probleme lösen, um verschiedene mögliche Pfade zu verstehen. Diese Erkenntnisse würden dann zur Lösung des komplexen Problems genutzt und dadurch die Wahrscheinlichkeit erhöht, die optimale Lösung zu finden.

Beispiel 1

- Aufgabe: Argumentation auf dem kürzesten Weg

- Analoge Probleme: Kürzester Weg zwischen Punkt A und B, Kürzester Weg zwischen Punkt B und C

- Endgültige Lösung: Optimaler Weg von Punkt A nach C unter Berücksichtigung der Lösungen analoger Probleme

Beispiel 2

- Aufgabe: Kreatives Schreiben

- Analoge Probleme: Schreiben Sie eine Kurzgeschichte über Freundschaft. Schreiben Sie eine Kurzgeschichte über Vertrauen

- Endgültige Lösung: Schreiben Sie eine komplexe Kurzgeschichte, die Themen wie Freundschaft und Vertrauen integriert

Der Prozess besteht darin, zunächst diese analogen Probleme zu lösen und dann die gewonnenen Erkenntnisse für die Bewältigung der komplexen Aufgabe zu nutzen. Diese Methode hat ihre Wirksamkeit bei mehreren Aufgaben unter Beweis gestellt und deutliche Verbesserungen bei den Leistungsmetriken gezeigt.

Die Auswirkungen von Thought Propagation gehen über die bloße Verbesserung bestehender Kennzahlen hinaus. Diese Aufforderungstechnik hat das Potenzial, die Art und Weise zu verändern, wie wir LLMs verstehen und einsetzen. Die Methodik unterstreicht einen Wandel von der isolierten, atomaren Problemlösung hin zu einem ganzheitlicheren, vernetzten Ansatz. Es regt uns dazu an, darüber nachzudenken, wie LLMs nicht nur aus Daten, sondern auch aus dem Prozess der Problemlösung selbst lernen können. Durch die kontinuierliche Aktualisierung ihres Verständnisses durch Lösungen für analoge Probleme sind mit TP ausgestattete LLMs besser auf die Bewältigung unvorhergesehener Herausforderungen vorbereitet und werden dadurch widerstandsfähiger und anpassungsfähiger in sich schnell entwickelnden Umgebungen.

Thought Propagation ist eine vielversprechende Ergänzung des Instrumentariums an Aufforderungsmethoden, die darauf abzielen, die Fähigkeiten von LLMs zu verbessern. Indem es LLMs ermöglicht, analoge Probleme und deren Lösungen zu nutzen, bietet TP eine differenziertere und effektivere Argumentationsmethode. Experimente bestätigen seine Wirksamkeit und machen es zu einer möglichen Strategie zur Verbesserung der Leistung von LLMs bei einer Vielzahl von Aufgaben. TP könnte letztendlich einen bedeutenden Fortschritt bei der Suche nach leistungsfähigeren KI-Systemen darstellen.

Matthäus Mayo (@mattmayo13) hat einen Master-Abschluss in Informatik und ein Diplom in Data Mining. Als Chefredakteur von KDnuggets möchte Matthew komplexe datenwissenschaftliche Konzepte zugänglich machen. Zu seinen beruflichen Interessen zählen die Verarbeitung natürlicher Sprache, Algorithmen für maschinelles Lernen und die Erforschung neuer KI. Seine Mission ist es, das Wissen in der Datenwissenschaftsgemeinschaft zu demokratisieren. Matthew programmiert seit seinem sechsten Lebensjahr.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.kdnuggets.com/thought-propagation-an-analogical-approach-to-complex-reasoning-with-large-language-models?utm_source=rss&utm_medium=rss&utm_campaign=thought-propagation-an-analogical-approach-to-complex-reasoning-with-large-language-models

- :hast

- :Ist

- :nicht

- $UP

- 15%

- 8

- a

- Fähigkeiten

- Fähigkeit

- Über Uns

- zugänglich

- Genauigkeit

- über

- Zusatz

- AI

- KI-Systeme

- gezielt

- Ziel

- Algorithmen

- Zulassen

- erlaubt

- ebenfalls

- verstärkt

- an

- und

- jedem

- Anwendungen

- Ansatz

- SIND

- künstlich

- AS

- At

- Versuch

- vermehren

- Alleen

- b

- Baseline

- BE

- war

- Besser

- zwischen

- Beyond

- Bringing

- breit

- aber

- by

- CAN

- Kandidat

- Fähigkeiten

- fähig

- challenges

- Herausforderungen

- näher

- Programmierung

- community

- Kompatibilität

- kompatibel

- Komplex

- rechnerisch

- Rechenleistung

- Computer

- Computerwissenschaften

- Konzepte

- Schichtannahme

- Geht davon

- Berücksichtigung

- konsistent

- Bestehend

- ständig

- Dazugehörigen

- könnte

- Kreativ (Creative)

- technische Daten

- Data Mining

- Datenwissenschaft

- Grad

- Demand

- demokratisieren

- Synergie

- einsetzen

- entworfen

- Direkt

- Domain

- zeichnen

- angetrieben

- Chefredakteur

- Effektiv

- Wirksamkeit

- Wirksamkeit

- entweder

- erhebend

- aufstrebenden

- Entwicklung

- Verbessert

- Eine Verbesserung der

- Enter

- Umgebungen

- ausgestattet

- Fehler

- insbesondere

- Sogar

- Jedes

- sich entwickelnden

- Beispiel

- unterhaltsame Programmpunkte

- Ausführung

- vorhandenen

- Experimente

- Möglichkeiten sondieren

- Finden Sie

- Suche nach

- Vorname

- Aussichten für

- vorwärts

- Unser Ansatz

- Freundschaft

- für

- gewonnen

- Allgemeines

- Go

- Abschluss

- Pflege

- he

- GUTE

- hoch

- seine

- hält

- ganzheitliche

- Ultraschall

- HTTPS

- Identifizierung

- if

- Image

- Implementierung

- Auswirkungen

- zu unterstützen,

- Verbesserungen

- verbessert

- Verbesserung

- in

- das

- Incorporated

- Steigert

- zunehmend

- inhärent

- Anfangs-

- angeboren

- innovativ

- Varianten des Eingangssignals:

- Einblicke

- beantragen müssen

- integriert

- Integriert

- Intelligent

- verbunden

- Interessen

- in

- beinhaltet

- isoliert

- Isolierung

- IT

- SEINE

- selbst

- jpg

- nur

- KDnuggets

- Art

- Wissen

- Sprache

- grosse

- führen

- LERNEN

- lernen

- Hebelwirkung

- Hebelwirkungen

- Nutzung

- Wahrscheinlichkeit

- LIMIT

- Einschränkungen

- Limitiert

- Logik

- Maschine

- Maschinelles Lernen

- Main

- um

- MACHT

- Making

- Master

- Matthew

- Kann..

- Mittel

- nur

- Methode

- Methodik

- Methoden

- Metrik

- Bergbau

- Ziel

- für

- mehr

- vor allem warme

- mehrere

- Natürliche

- Natürliche Sprache

- Verarbeitung natürlicher Sprache

- Netzwerk

- Neu

- neue Lösung

- Roman

- erhalten

- of

- Alt

- on

- EINEM

- einzige

- öffnet

- optimal

- Optimierung

- or

- Übertrifft

- geradezu

- Überwinden

- Papier

- besonders

- Weg

- Leistung

- Plan

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Punkte

- möglich

- Potenzial

- Werkzeuge

- bereit

- Grundsätze

- Vor

- Aufgabenstellung:

- Problemlösung

- Probleme

- Prozessdefinierung

- Verarbeitung

- Professionell

- aussichtsreich

- ausgesprochen

- Fortpflanzung

- bietet

- bietet

- Bereitstellung

- Bereich

- schnell

- lieber

- Realisierung

- Grund

- bezogene

- Rendering

- vertreten

- erfordern

- federnde

- Die Ergebnisse

- Wiederverwendung

- s

- Wissenschaft

- kratzen

- Suche

- kompensieren

- verschieben

- Short

- sollte

- erklären

- präsentiert

- signifikant

- bedeutend

- da

- Lösung

- Lösungen

- LÖSEN

- Auflösung

- spezifisch

- Spektrum

- Schritt

- Shritte

- Geschichte

- Strategien

- Strategie

- wesentlich

- im Wesentlichen

- Systeme und Techniken

- angehen

- Aufgabe

- und Aufgaben

- Technik

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Themen

- dann

- damit

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- dachte

- Durch

- zu

- Werkzeug

- Tools

- gegenüber

- tp

- wirklich

- Vertrauen

- XNUMX

- typisch

- Letztlich

- unbestreitbar

- Unterstrichen

- verstehen

- Verständnis

- unvorhergesehen

- Aktualisierung

- us

- -

- benutzt

- Verwendung von

- Nutzen

- Vielfalt

- verschiedene

- vielseitig

- Vielseitigkeit

- wurde

- we

- welche

- mit

- ohne

- Arbeitsablauf.

- würde

- schreiben

- Schreiben

- Jahr

- noch

- Ausbeute

- Zephyrnet