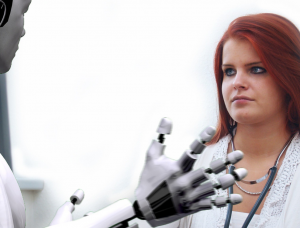

Künstliche Intelligenz (KI) hat verschiedene Branchen revolutioniert und bietet zahlreiche Vorteile und Möglichkeiten. Es bestehen jedoch Bedenken hinsichtlich des Potenzials von KI, Diskriminierung und Vorurteile aufrechtzuerhalten. Dieser Artikel befasst sich mit dem Thema KI-Diskriminierung und beleuchtet die Herausforderungen bei der Identifizierung und Bewältigung von in KI-Systemen verankerten Vorurteilen. Brancheninsider äußern Zweifel an den moralischen und ethischen Implikationen von KI und verweisen auf Bedenken hinsichtlich Fehlinformationen, Vorurteilen in Algorithmen und der Generierung irreführender Inhalte. Da die Debatten über KI immer intensiver werden, wird der Ruf nach einer sinnvollen Regulierung immer lauter, um Transparenz, Rechenschaftspflicht und den Schutz der Grundrechte zu gewährleisten.

Herausforderungen für die Finanzbranche mit KI

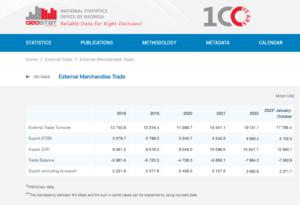

Laut Nabil Manji, dem Leiter für Krypto und Web3 bei Worldpay by FIS, hängt die Wirksamkeit von KI-Produkten stark von der Qualität des für die Schulung verwendeten Quellmaterials ab. In einem Interview mit CNBC erklärte Manji, dass zwei Hauptfaktoren zur Leistung der KI beitragen: die Daten, auf die sie Zugriff hat, und die Fähigkeiten des großen Sprachmodells.

Um die Bedeutung von Daten zu veranschaulichen, erwähnte Manji, dass Unternehmen wie Reddit öffentlich Beschränkungen für das Daten-Scraping erklärt haben und eine Zahlung für den Zugriff verlangen. Im Finanzdienstleistungssektor hob er die Herausforderung fragmentierter Datensysteme in verschiedenen Sprachen und Formaten hervor. Dieser Mangel an Konsolidierung und Harmonisierung schränkt die Wirksamkeit KI-gesteuerter Produkte ein, insbesondere im Vergleich zu Branchen mit standardisierter und modernisierter Dateninfrastruktur.

Laut Manji könnte der Einsatz der Blockchain- oder Distributed-Ledger-Technologie eine potenzielle Lösung zur Bewältigung dieses Problems bieten. Dieser innovative Ansatz kann eine verbesserte Transparenz der fragmentierten Daten ermöglichen, die in den komplexen Systemen herkömmlicher Banken gespeichert sind. Er räumte jedoch ein, dass die stark regulierte und langsame Natur der Banken ihre Fähigkeit zur schnellen Einführung neuer KI-Tools beeinträchtigen könnte, im Gegensatz zu agileren Technologieunternehmen wie Microsoft und Google, die in den letzten paar Jahren an der Spitze der Innovationsförderung standen Jahrzehnte.

Unter Berücksichtigung dieser Faktoren wird deutlich, dass die Finanzbranche aufgrund der Komplexität der Datenintegration und der inhärenten Natur des Bankensektors vor besonderen Herausforderungen bei der Nutzung von KI steht.

Laut Rumman Chowdhury, einem ehemaligen Leiter der Abteilung Ethik, Transparenz und Rechenschaftspflicht für maschinelles Lernen bei Twitter, ist die Kreditvergabe ein bemerkenswertes Beispiel dafür, wie sich Voreingenommenheit in KI-Systemen nachteilig auf marginalisierte Gemeinschaften auswirken kann. Bei einer Podiumsdiskussion in Amsterdam hob Chowdhury die historische Praxis des „Redlining“ in Chicago in den 1930er Jahren hervor. Redlining beinhaltete die Verweigerung von Krediten an überwiegend afroamerikanische Viertel aufgrund der rassischen Demografie.

Chowdhury erklärte, dass, obwohl moderne Algorithmen Rasse möglicherweise nicht explizit als Datenpunkt einbeziehen, Vorurteile dennoch implizit kodiert werden können. Bei der Entwicklung von Algorithmen zur Bewertung der Risikobereitschaft von Bezirken und Einzelpersonen für Kreditvergabezwecke können historische Daten, die Verzerrungen enthalten, unbeabsichtigt zu einer Aufrechterhaltung der Diskriminierung führen.

Angle Bush, der Visionär hinter Black Women in Artificial Intelligence, betonte, wie wichtig es sei, die Gefahren anzuerkennen, die mit der Reproduktion von in historischen Daten eingebetteten Vorurteilen verbunden seien, wenn KI-Systeme zur Entscheidung über die Kreditgenehmigung eingesetzt würden. Eine solche Praxis kann dazu führen, dass Kreditanträge von marginalisierten Gemeinschaften automatisch abgelehnt werden, wodurch Rassen- oder Geschlechterungleichheiten aufrechterhalten werden.

Frost Li, ein erfahrener KI-Entwickler, wies auf die Herausforderungen der Personalisierung hin KI-Integration. Die Auswahl von „Kernfunktionen“ für das Training von KI-Modellen kann manchmal unabhängige Faktoren beinhalten, die zu verzerrten Ergebnissen führen können. Li lieferte ein Beispiel dafür, wie Fintech-Startups, die auf Ausländer abzielen, im Vergleich zu lokalen Banken, die mit den örtlichen Schulen und Gemeinden besser vertraut sind, möglicherweise anderen Bonitätsbewertungskriterien unterliegen könnten.

Niklas Guske, COO von Taktile, einem Startup, das sich auf die Automatisierung der Entscheidungsfindung für Fintechs spezialisiert hat, stellte klar, dass generative KI normalerweise nicht zur Erstellung von Kredit- oder Risikobewertungen von Verbrauchern verwendet wird. Im Gegenteil, seine Stärke liegt in der Vorverarbeitung unstrukturierter Daten wie Textdateien, um die Datenqualität für herkömmliche Underwriting-Modelle zu verbessern.

Zusammenfassend lässt sich sagen, dass der Einsatz von KI in der Kreditvergabe und bei Finanzdienstleistungen Bedenken hinsichtlich Voreingenommenheit und Diskriminierung aufwirft. Die in den Daten verankerten historischen Verzerrungen und die Auswahl irrelevanter Merkmale während des KI-Trainings können zu unfairen Ergebnissen führen. Für Banken und Finanzinstitute ist es von entscheidender Bedeutung, diese Probleme zu erkennen und anzugehen, um die unbeabsichtigte Aufrechterhaltung von Diskriminierung bei der Implementierung von KI-Lösungen zu verhindern.

Beweis der KI-Diskriminierung

Der Nachweis KI-basierter Diskriminierung kann eine Herausforderung sein, wie Beispiele wie der Fall um Apple und Goldman Sachs zeigen. Das New York State Department of Financial Services wies die Vorwürfe zurück, Frauen würden niedrigere Limits für die Apple Card auferlegt, mit der Begründung, es fehle an stichhaltigen Beweisen.

Kim Smouter, Direktorin des Europäischen Netzwerks gegen Rassismus, weist darauf hin, dass der massenhafte Einsatz von KI zu Undurchsichtigkeit in Entscheidungsprozessen führt und es für Einzelpersonen schwierig macht, Diskriminierung zu erkennen und dagegen vorzugehen.

Smouter erklärt, dass Einzelpersonen oft nur über begrenzte Kenntnisse über die Funktionsweise von KI-Systemen verfügen, was es schwierig macht, Fälle von Diskriminierung oder systemischen Vorurteilen zu erkennen. Noch komplexer wird es, wenn die Diskriminierung Teil eines umfassenderen Problems ist, das mehrere Personen betrifft. Smouter verweist auf den niederländischen Kindeswohlskandal, bei dem eine große Zahl von Leistungsanträgen aufgrund institutioneller Voreingenommenheit fälschlicherweise als betrügerisch eingestuft wurde. Die Entdeckung solcher Funktionsstörungen ist eine Herausforderung, und die Erlangung von Wiedergutmachung kann schwierig und zeitaufwändig sein und zu erheblichen und manchmal irreversiblen Schäden führen.

Diese Beispiele veranschaulichen die inhärenten Schwierigkeiten, eine KI-basierte Diskriminierung zu begründen und Rechtsmittel zu erhalten, wenn eine solche Diskriminierung auftritt. Die Komplexität von KI-Systemen und die mangelnde Transparenz bei Entscheidungsprozessen können es für Einzelpersonen schwierig machen, Fälle von Diskriminierung zu erkennen und wirksam dagegen vorzugehen.

Laut Chowdhury besteht ein dringender Bedarf an einer globalen Regulierungsbehörde ähnlich den Vereinten Nationen, um die mit KI verbundenen Risiken anzugehen. Während KI bemerkenswerte Innovationen gezeigt hat, haben Technologen und Ethiker Bedenken hinsichtlich ihrer moralischen und ethischen Auswirkungen geäußert. Diese Bedenken umfassen Probleme wie Fehlinformationen, eingebettete rassische und geschlechtsspezifische Vorurteile in KI-Algorithmen und die Generierung irreführender Inhalte durch Tools wie ChatGPT.

Chowdhury äußert seine Besorgnis über den Eintritt in eine postfaktische Welt, in der Online-Informationen, einschließlich Text, Video und Audio, aufgrund generativer KI nicht mehr vertrauenswürdig sind. Dies wirft die Frage auf, wie wir die Integrität von Informationen sicherstellen können und wie wir uns darauf verlassen können, fundierte Entscheidungen zu treffen. Am Beispiel des KI-Gesetzes der Europäischen Union ist eine sinnvolle Regulierung der KI derzeit von entscheidender Bedeutung. Es bestehen jedoch Bedenken hinsichtlich der langen Zeitspanne, die bis zur Wirksamkeit von Regulierungsvorschlägen vergeht, wodurch möglicherweise notwendige Maßnahmen verzögert werden.

Smouter betont die Notwendigkeit einer größeren Transparenz und Rechenschaftspflicht bei KI-Algorithmen. Dazu gehört, Algorithmen für Laien verständlicher zu machen, Tests durchzuführen und Ergebnisse zu veröffentlichen, unabhängige Beschwerdeprozesse einzurichten, regelmäßige Audits und Berichte durchzuführen sowie rassistisch motivierte Gemeinschaften in die Entwicklung und den Einsatz von Technologie einzubeziehen. Die Durchsetzung des KI-Gesetzes, das eine Grundrechtsperspektive einnimmt und Konzepte wie Wiedergutmachung einführt, wird voraussichtlich in etwa zwei Jahren beginnen. Eine Verkürzung dieses Zeitrahmens wäre von Vorteil, um Transparenz und Rechenschaftspflicht als integrale Aspekte der Innovation aufrechtzuerhalten.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://www.forexnewsnow.com/fintech/the-urgency-of-addressing-ai-discrimination-transparency-accountability-and-regulatory-timelines/

- :hast

- :Ist

- :nicht

- :Wo

- a

- Fähigkeit

- Über Uns

- Zugang

- Rechenschaftspflicht

- anerkannt

- Handlung

- Aktionen

- Adresse

- Adressierung

- adoptieren

- vorteilhaft

- nachteilig

- beeinflussen

- afrikanisch

- gegen

- agil

- AI

- KI-Gesetz

- KI-Systeme

- KI-Training

- Algorithmen

- Behauptungen

- Obwohl

- amerikanisch

- amsterdam

- an

- und

- Vorweggenommen

- Apple

- Apple-Karte

- Anwendungen

- Ansatz

- Genehmigung

- ca.

- SIND

- Artikel

- künstlich

- künstliche Intelligenz

- AS

- Aspekte

- beurteilen

- Bewertung

- damit verbundenen

- At

- Audio-

- Audits

- automatische

- automatisieren

- Bankinggg

- Bankensektor

- Banken

- basierend

- BE

- werden

- wird

- war

- hinter

- Nutzen

- Vorteile

- vorspannen

- voreingenommen

- Vorurteile

- Schwarz

- Blockchain

- Körper

- Brings

- breiteres

- by

- rufen Sie uns an!

- CAN

- Fähigkeiten

- Karte

- Häuser

- challenges

- Herausforderungen

- herausfordernd

- ChatGPT

- Chicago

- der

- aus aller Welt

- geklärt

- CNBC

- Communities

- Unternehmen

- verglichen

- Beschwerde

- Komplex

- Komplexität

- Komplexität

- Konzepte

- Bedenken

- Leitung

- Festigung

- KUNDEN

- enthält

- Inhalt

- Gegenteil

- beitragen

- konventionellen

- gurren

- Erstellen

- Kredit

- Kriterien

- wichtig

- Krypto

- Gefahren

- technische Daten

- Dateninfrastruktur

- Datenintegration

- Datenqualität

- Debatten

- Jahrzehnte

- Decision Making

- Entscheidungen

- Demographie

- Abteilung

- hängt

- Einsatz

- Design

- Entwickler:in / Unternehmen

- Entwicklung

- anders

- schwer

- Schwierigkeiten

- Direktor

- Entdeckung

- Diskriminierung

- Diskussion

- verteilt

- Verteiltes Hauptbuch

- verteilte Ledger-Technologie

- Fahren

- zwei

- im

- Niederländisch

- Effektiv

- effektiv

- Wirksamkeit

- eingebettet

- entstanden

- betont

- umfassen

- Durchsetzung

- zu steigern,

- verbesserte

- gewährleisten

- Eingabe

- insbesondere

- Festlegung

- ethisch

- Ethik

- Europäische

- Sogar

- Beweis

- offensichtlich

- Beispiel

- Beispiele

- erfahrensten

- erklärt

- Erklärt

- erforscht

- express

- Gesicht

- Gesichter

- Faktoren

- vertraut

- Eigenschaften

- wenige

- Mappen

- Revolution

- Finanzbranchen

- Finanzinstitutionen

- Finanzdienstleistungen

- FinTech

- Fintech-Startups

- FinTechs

- FIS

- Aussichten für

- Vordergrund

- Früher

- fragmentierten

- betrügerisch

- für

- fundamental

- Geschlecht

- Generation

- generativ

- Generative KI

- Global

- goldman

- Goldman Sachs

- mehr

- persönlichem Wachstum

- schaden

- Haben

- he

- ganzer

- schwer

- Besondere

- hoch

- historisch

- Ultraschall

- aber

- HTTPS

- identifizieren

- Identifizierung

- Umsetzung

- Auswirkungen

- Bedeutung

- imposant

- in

- das

- Dazu gehören

- Einschließlich

- unabhängig

- Einzelpersonen

- Branchen

- Energiegewinnung

- Ungleichheiten

- Information

- informiert

- Infrastruktur

- inhärent

- Innovation

- innovativ

- Institutionell

- Institutionen

- Integral

- Integration

- Integrität

- Intelligenz

- Interview

- in

- Stellt vor

- beteiligen

- beteiligt

- Beteiligung

- Problem

- Probleme

- IT

- SEINE

- Wissen

- Mangel

- Sprache

- Sprachen

- grosse

- führen

- führenden

- lernen

- Ledger

- Darlehen

- Nutzung

- li

- liegt

- !

- Gefällt mir

- Limitiert

- Grenzen

- Darlehen

- Kredite

- aus einer regionalen

- LOKALE BANKEN

- senken

- Maschine

- Maschinelles Lernen

- Main

- um

- Making

- Masse

- Ihres Materials

- Kann..

- sinnvoll

- erwähnt

- Microsoft

- könnte

- Fehlinformationen

- irreführend

- Modell

- für

- modern

- Moment

- Moral

- mehr

- mehrere

- Nationen

- Natur

- notwendig,

- Need

- Netzwerk

- Neu

- New York

- Der Staat New York

- New York State Department für Finanzdienstleistungen

- Nicht-Experten

- bemerkenswert

- Anzahl

- und viele

- zahlreiche vorteile

- beschaffen

- of

- bieten

- bieten

- vorgenommen,

- on

- Online

- betreiben

- Entwicklungsmöglichkeiten

- or

- Ergebnisse

- Tafel

- Podiumsdiskussion

- Teil

- passt

- Zahlung

- Leistung

- periodisch

- Personalisierung

- Perspektive

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Punkte

- Potenzial

- möglicherweise

- Praxis

- überwiegend

- Drücken

- verhindern

- Aufgabenstellung:

- anpassen

- Produkte

- Vorschläge

- Sicherheit

- die

- vorausgesetzt

- öffentlich

- Publishing

- Zwecke

- Qualität

- Fragen

- Rennen

- Rassismus

- geschafft

- wirft

- erkennen

- Reduzierung

- Referenzen

- in Bezug auf

- geregelt

- Rechtliches

- Regulierungsbehörden

- verlassen

- bemerkenswert

- Reporting

- Einschränkungen

- Die Ergebnisse

- revolutioniert

- Rechte

- Risiko

- Risiken

- Sachs

- Skandal

- Schulen

- Partituren

- Wertung

- kratzen

- Bibliotheken

- Auswahl

- Auswahl

- Lösungen

- gezeigt

- Bedeutung

- signifikant

- ähnlich

- Lösung

- Lösungen

- Quelle

- Sprechen

- spezialisieren

- Anfang

- Startups

- Bundesstaat

- State Department

- Immer noch

- gelagert

- Stärke

- so

- ZUSAMMENFASSUNG

- Umgebung

- schnell

- systemisch

- Systeme und Techniken

- angehen

- nimmt

- Targeting

- Tech

- Tech-Unternehmen

- Technologen

- Technologie

- Tests

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Quelle

- ihr

- Dort.

- damit

- Diese

- fehlen uns die Worte.

- Zeitaufwendig

- Timeline

- Zeitleisten

- zu

- Werkzeuge

- Thema

- Ausbildung

- Transparenz

- XNUMX

- typisch

- verständlich

- Underwriting-

- unfair

- einzigartiges

- Vereinigt

- vereinigte nationen

- nicht wie

- Aufrechterhalten

- Dringlichkeit

- -

- benutzt

- verschiedene

- Video

- Visionär

- we

- Web3

- Wohl

- waren

- wann

- welche

- während

- mit

- .

- Damen

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- WorldPay

- Sorgen

- würde

- Jahr

- York

- Zephyrnet