Bild erstellt mit DALL-E3

Künstliche Intelligenz war eine völlige Revolution in der Technologiewelt.

Seine Fähigkeit, menschliche Intelligenz nachzuahmen und Aufgaben auszuführen, die einst als ausschließlich menschliche Domäne galten, überrascht die meisten von uns immer noch.

Doch egal wie gut diese späten KI-Sprünge waren, es gibt immer Raum für Verbesserungen.

Und genau hier kommt Prompt Engineering ins Spiel!

Betreten Sie dieses Feld, das die Produktivität von KI-Modellen erheblich steigern kann.

Lassen Sie uns gemeinsam alles entdecken!

Prompt Engineering ist ein schnell wachsender Bereich innerhalb der KI, der sich auf die Verbesserung der Effizienz und Effektivität von Sprachmodellen konzentriert. Es geht darum, perfekte Eingabeaufforderungen zu erstellen, um KI-Modelle anzuleiten, die gewünschten Ergebnisse zu erzielen.

Stellen Sie sich das so vor, als würden Sie lernen, jemandem bessere Anweisungen zu geben, um sicherzustellen, dass er eine Aufgabe richtig versteht und ausführt.

Warum schnelles Engineering wichtig ist

- Erhöhte Produktivität: Durch die Verwendung hochwertiger Eingabeaufforderungen können KI-Modelle genauere und relevantere Antworten generieren. Das bedeutet weniger Zeitaufwand für Korrekturen und mehr Zeit für die Nutzung der KI-Fähigkeiten.

- Kosteneffizienz: Das Training von KI-Modellen ist ressourcenintensiv. Prompt Engineering kann die Notwendigkeit einer erneuten Schulung reduzieren, indem die Modellleistung durch bessere Eingabeaufforderungen optimiert wird.

- Vielseitigkeit: Eine gut ausgearbeitete Eingabeaufforderung kann KI-Modelle vielseitiger machen und es ihnen ermöglichen, ein breiteres Spektrum an Aufgaben und Herausforderungen zu bewältigen.

Bevor wir uns mit den fortschrittlichsten Techniken befassen, erinnern wir uns an zwei der nützlichsten (und grundlegendsten) Techniken des Prompt Engineering.

Sequentielles Denken mit „Denken wir Schritt für Schritt“

Heute ist bekannt, dass die Genauigkeit von LLM-Modellen deutlich verbessert wird, wenn die Wortfolge „Lass uns Schritt für Schritt denken“ hinzugefügt wird.

Warum ... fragen Sie sich vielleicht?

Das liegt daran, dass wir das Modell zwingen, jede Aufgabe in mehrere Schritte zu unterteilen, um sicherzustellen, dass das Modell genügend Zeit hat, jeden einzelnen Schritt zu verarbeiten.

Zum Beispiel könnte ich GPT3.5 mit der folgenden Eingabeaufforderung herausfordern:

Wenn John 5 Birnen hat, dann 2 isst, 5 weitere kauft und dann 3 seinem Freund gibt, wie viele Birnen hat er dann?

Das Model wird mir sofort eine Antwort geben. Wenn ich jedoch das abschließende „Lass uns Schritt für Schritt denken“ hinzufüge, zwinge ich das Modell, einen Denkprozess mit mehreren Schritten zu generieren.

Wenige-Schuss-Eingabeaufforderung

Während sich die Zero-Shot-Eingabeaufforderung darauf bezieht, dass das Modell aufgefordert wird, eine Aufgabe auszuführen, ohne jeglichen Kontext oder Vorkenntnisse bereitzustellen, impliziert die Wenig-Schuss-Eingabeaufforderungstechnik, dass wir dem LLM einige Beispiele unserer gewünschten Ausgabe zusammen mit einer spezifischen Frage präsentieren.

Wenn wir beispielsweise ein Modell entwickeln möchten, das einen Begriff mit einem poetischen Ton definiert, kann es schwierig sein, dies zu erklären. Rechts?

Wir könnten jedoch die folgenden Eingabeaufforderungen mit wenigen Schüssen verwenden, um das Modell in die gewünschte Richtung zu lenken.

Ihre Aufgabe besteht darin, in einem einheitlichen Stil zu antworten, der dem folgenden Stil entspricht.

: Bring mir etwas über Resilienz bei.

: Resilienz ist wie ein Baum, der sich im Wind beugt, aber niemals bricht.

Es ist die Fähigkeit, sich von Widrigkeiten zu erholen und weiter voranzukommen.

: Ihr Beitrag hier.

Wenn Sie es noch nicht ausprobiert haben, können Sie GPT herausfordern.

Da ich jedoch ziemlich sicher bin, dass die meisten von Ihnen diese Grundtechniken bereits kennen, werde ich versuchen, Sie mit einigen fortgeschrittenen Techniken herauszufordern.

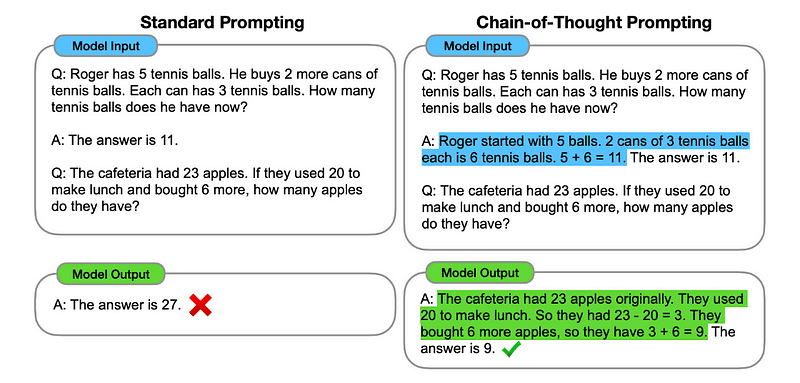

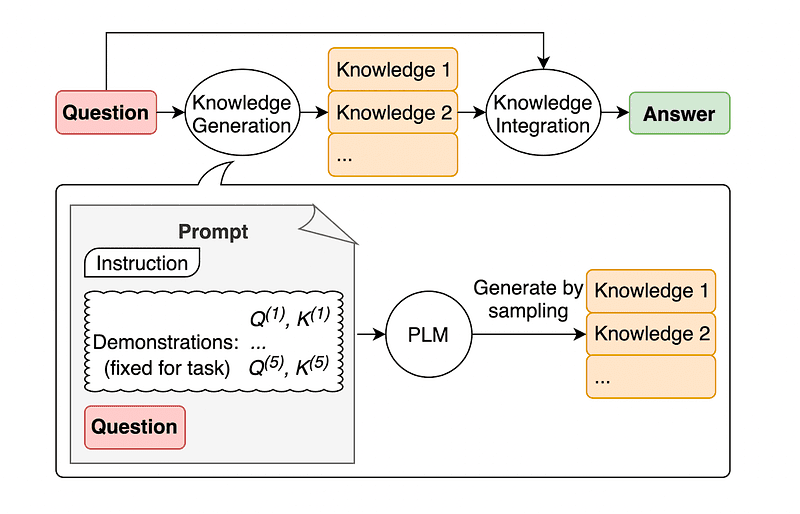

1. Chain of Thought (CoT)-Aufforderung

Eingeführt durch Google im Jahr 2022Bei dieser Methode wird das Modell angewiesen, mehrere Argumentationsphasen zu durchlaufen, bevor es die endgültige Antwort liefert.

Kommt Ihnen bekannt vor, oder? Wenn ja, dann haben Sie vollkommen recht.

Es ist, als würde man sequentielles Denken und Few-Shot-Prompting verschmelzen.

Wie?

Im Wesentlichen weist die CoT-Eingabeaufforderung den LLM an, Informationen nacheinander zu verarbeiten. Das bedeutet, dass wir veranschaulichen, wie ein erstes Problem mit mehrstufigem Denken gelöst werden kann, und dann unsere eigentliche Aufgabe an das Modell senden, in der Erwartung, dass es eine vergleichbare Gedankenkette nachahmt, wenn es auf die eigentliche Frage antwortet, die es lösen soll.

Bild aus dem Krepppapier.

Dem allerersten Beispiel folgend, könnten wir also eine Eingabeaufforderung mit dem ersten Problem und einer fortlaufenden Erklärung zur Lösung bereitstellen. Dann können wir unseren Beitrag senden und sehen, wie Magie entsteht!

Wenn John 5 Birnen hat, dann 2 isst, 5 weitere kauft und dann 3 seinem Freund gibt, wie viele Birnen hat er dann? Denken wir Schritt für Schritt.

Gehen wir Schritt für Schritt vor. John beginnt mit 5 Birnen. Er isst 2 Birnen, also hat er noch 5–2 = 3 Birnen übrig. Dann kauft er noch 5 Birnen. Er hat jetzt also 3 + 5 = 8 Birnen. Schließlich gibt er seinem Freund 3 Birnen. Daher hat er noch 8–3 = 5 Birnen übrig. Nach all diesen Schritten hat John also 5 Birnen.

Ihr Beitrag hier.

Die meisten von Ihnen denken jedoch bestimmt: Muss ich jedes Mal, wenn ich auf ChatGPT etwas fragen möchte, über einen sequenziellen Weg zur Lösung eines Problems nachdenken?

Na ja... du bist nicht der Erste! Und das führt uns zu ...

2. Automatische Gedankenkette (Auto-CoT)

In 2022, Zhang und Kollegen führten eine Methode ein, um diesen manuellen Prozess zu vermeiden. Es gibt zwei Hauptgründe, manuelle Aufgaben zu vermeiden:

- Es kann langweilig sein.

- Es kann zu schlechten Ergebnissen führen – zum Beispiel, wenn unser geistiger Prozess falsch ist.

Sie schlugen vor, LLMs in Kombination mit der Aufforderung „Lass uns Schritt für Schritt denken“ zu verwenden, um nacheinander Argumentationsketten für jede Demonstration zu erstellen.

Das bedeutet, dass man ChatGPT nacheinander fragt, wie es ein Problem lösen kann, und es dann anhand desselben Beispiels trainiert, wie man jedes andere Problem löst.

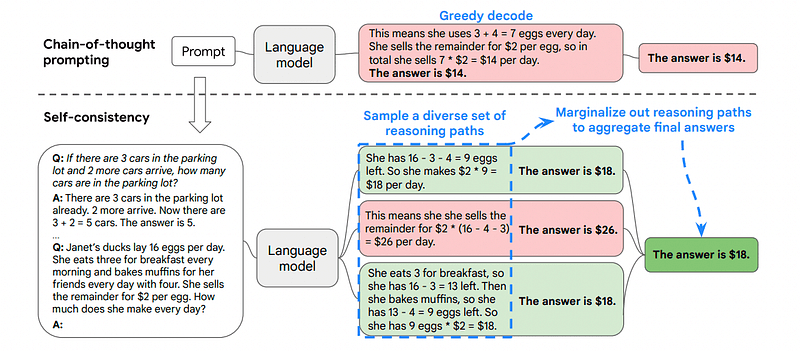

3. Selbstkonsistenz

Selbstkonsistenz ist eine weitere interessante Aufforderungstechnik, die darauf abzielt, die Gedankenkette bei komplexeren Denkproblemen zu verbessern.

Also... was ist der Hauptunterschied?

Die Hauptidee der Selbstkonsistenz besteht darin, sich bewusst zu sein, dass wir das Modell mit einem falschen Beispiel trainieren können. Stellen Sie sich vor, ich löse das vorherige Problem mit einem falschen mentalen Prozess:

Wenn John 5 Birnen hat, dann 2 isst, 5 weitere kauft und dann 3 seinem Freund gibt, wie viele Birnen hat er dann? Denken wir Schritt für Schritt.

Beginnen Sie mit 5 Birnen. John isst 2 Birnen. Dann gibt er seinem Freund 3 Birnen. Diese Aktionen können kombiniert werden: 2 (gegessen) + 3 (gegeben) = insgesamt 5 Birnen betroffen. Subtrahieren Sie nun die Gesamtzahl der betroffenen Birnen von den ursprünglichen 5 Birnen: 5 (anfänglich) – 5 (betroffen) = 0 Birnen übrig.

Dann ist jede andere Aufgabe, die ich an das Modell sende, falsch.

Aus diesem Grund umfasst die Selbstkonsistenz die Auswahl verschiedener Argumentationspfade, von denen jeder eine Gedankenkette enthält, und die anschließende Auswahl des besten und konsistentesten Pfads zur Lösung des Problems durch den LLM.

Bild aus dem Krepppapier

In diesem Fall und noch einmal dem allerersten Beispiel folgend, können wir dem Modell verschiedene Möglichkeiten zur Lösung des Problems aufzeigen.

Wenn John 5 Birnen hat, dann 2 isst, 5 weitere kauft und dann 3 seinem Freund gibt, wie viele Birnen hat er dann?

Beginnen Sie mit 5 Birnen. John isst 2 Birnen und hat 5–2 = 3 Birnen übrig. Er kauft 5 weitere Birnen, sodass sich die Gesamtsumme auf 3 + 5 = 8 Birnen ergibt. Zum Schluss gibt er seinem Freund 3 Birnen, sodass er noch 8–3 = 5 Birnen übrig hat.

Wenn John 5 Birnen hat, dann 2 isst, 5 weitere kauft und dann 3 seinem Freund gibt, wie viele Birnen hat er dann?

Beginnen Sie mit 5 Birnen. Dann kauft er noch 5 Birnen. John isst jetzt 2 Birnen. Diese Aktionen können kombiniert werden: 2 (gegessen) + 5 (gekauft) = insgesamt 7 Birnen. Subtrahieren Sie die Birne, die Jon gegessen hat, von der Gesamtmenge an Birnen 7 (Gesamtmenge) – 2 (gegessen) = 5 Birnen übrig.

Ihr Beitrag hier.

Und hier kommt die letzte Technik.

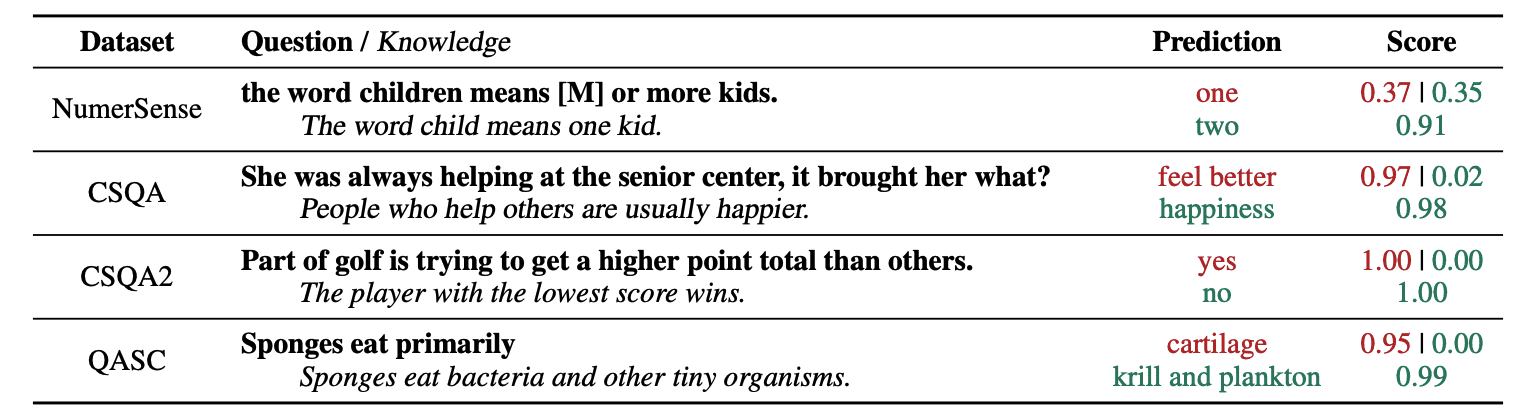

4. Allgemeine Wissensaufforderung

Eine gängige Praxis des Prompt Engineering besteht darin, eine Abfrage mit zusätzlichem Wissen zu ergänzen, bevor der endgültige API-Aufruf an GPT-3 oder GPT-4 gesendet wird.

Laut Jiacheng Liu und CoWir können jeder Anfrage jederzeit etwas Wissen hinzufügen, damit der LLM besser über die Frage Bescheid weiß.

Bild aus dem Krepppapier.

Wenn wir beispielsweise ChatGPT fragen, ob ein Teil des Golfsports darauf abzielt, eine höhere Gesamtpunktzahl als andere zu erzielen, wird uns das bestätigt. Das Hauptziel des Golfsports ist jedoch genau das Gegenteil. Aus diesem Grund können wir einige Vorkenntnisse hinzufügen, die sagen: „Der Spieler mit der niedrigeren Punktzahl gewinnt.“

Was ist also das Lustige daran, wenn wir dem Modell genau die Antwort sagen?

In diesem Fall wird diese Technik verwendet, um die Art und Weise zu verbessern, wie LLM mit uns interagiert.

Anstatt also ergänzenden Kontext aus einer externen Datenbank zu ziehen, empfehlen die Autoren des Papiers, dass der LLM sein eigenes Wissen erarbeitet. Dieses selbst generierte Wissen wird dann in die Eingabeaufforderung integriert, um das vernünftige Denken zu stärken und bessere Ergebnisse zu liefern.

Auf diese Weise können LLMs verbessert werden, ohne den Trainingsdatensatz zu vergrößern!

Prompt Engineering hat sich als entscheidende Technik zur Verbesserung der Fähigkeiten von LLM herausgestellt. Durch die Iteration und Verbesserung von Eingabeaufforderungen können wir direkter mit KI-Modellen kommunizieren und so genauere und kontextrelevantere Ergebnisse erhalten, was sowohl Zeit als auch Ressourcen spart.

Für Technikbegeisterte, Datenwissenschaftler und Content-Ersteller kann das Verständnis und die Beherrschung von Prompt Engineering von großem Nutzen sein, um das volle Potenzial der KI auszuschöpfen.

Durch die Kombination sorgfältig gestalteter Eingabeaufforderungen mit diesen fortschrittlicheren Techniken werden Ihnen die Fähigkeiten der Eingabeaufforderungstechnik in den kommenden Jahren zweifellos einen Vorteil verschaffen.

Josef Ferrer ist Analytikingenieur aus Barcelona. Er hat einen Abschluss in Physikingenieurwesen und arbeitet derzeit im Bereich Data Science für die menschliche Mobilität. Er ist ein Teilzeit-Content-Creator, der sich auf Data Science und Technologie konzentriert. Sie können ihn unter kontaktieren LinkedIn, Twitter or Medium.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.kdnuggets.com/some-kick-ass-prompt-engineering-techniques-to-boost-our-llm-models?utm_source=rss&utm_medium=rss&utm_campaign=some-kick-ass-prompt-engineering-techniques-to-boost-our-llm-models

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 10

- 11

- 2022

- 29

- 7

- 8

- a

- Fähigkeit

- LiveBuzz

- Genauigkeit

- genau

- Aktionen

- präsentieren

- hinzufügen

- Hinzufügen

- Zusätzliche

- advanced

- Nach der

- aufs Neue

- AI

- KI-Modelle

- Ziel

- ausgerichtet

- gleich

- Alle

- Zulassen

- entlang

- bereits

- immer

- am

- Betrag

- an

- Analytik

- und

- Ein anderer

- beantworten

- jedem

- Bienen

- angewandt

- SIND

- AS

- fragen

- fragen

- Vermögenswert

- Autoren

- automatische

- vermeiden

- bewusst

- ein Weg

- Zurück

- Badewanne

- Barcelona

- basic

- BE

- weil

- war

- Bevor

- Sein

- BESTE

- Besser

- Nackenrolle

- Auftrieb

- Bohren

- beide

- gekauft

- Prallen

- Break

- geht kaputt

- Brings

- breiteres

- aber

- Kauft

- by

- rufen Sie uns an!

- CAN

- Fähigkeiten

- vorsichtig

- Häuser

- Kette

- Ketten

- challenges

- Herausforderungen

- ChatGPT

- Auswählen

- Kopien

- kombiniert

- Vereinigung

- wie die

- kommt

- Kommen

- gemeinsam

- mit uns kommunizieren,

- vergleichbar

- abschließen

- Komplex

- betrachtet

- konsistent

- Kontakt

- Inhalt

- Inhaltsentwickler

- Kontext

- Korrekturen

- korrekt

- könnte

- erstellt

- Schöpfer

- Schöpfer

- Zur Zeit

- technische Daten

- Datenwissenschaft

- Datenbase

- Definiert

- liefern

- entworfen

- erwünscht

- Unterschied

- anders

- Direkt

- Richtung

- entdeckt,

- Tauchen

- do

- die

- Domain

- Domains

- nach unten

- jeder

- Edge

- Wirksamkeit

- Effizienz

- entstanden

- Ingenieur

- Entwicklung

- zu steigern,

- Eine Verbesserung der

- genug

- gewährleisten

- Enthusiasten

- genau

- Beispiel

- Beispiele

- ausführen

- erwartet

- Erklären

- Erklärung

- vertraut

- wenige

- Feld

- Finale

- Endlich

- Vorname

- konzentriert

- konzentriert

- Folgende

- Aussichten für

- Zwingen

- vorwärts

- Freund

- für

- voller

- komisch

- Allgemeines

- erzeugen

- bekommen

- ABSICHT

- gegeben

- gibt

- Go

- Kundenziele

- Golf

- gut

- Guide

- hart

- Nutzen

- Haben

- mit

- he

- hier

- hochwertige

- höher

- ihm

- seine

- Ultraschall

- Hilfe

- aber

- HTTPS

- human

- menschliche Intelligenz

- i

- Idee

- if

- Bild

- zu unterstützen,

- verbessert

- Verbesserung

- Verbesserung

- in

- zunehmend

- Information

- Anfangs-

- Varianten des Eingangssignals:

- Instanz

- Anleitung

- integriert

- Intelligenz

- interagiert

- interessant

- in

- eingeführt

- beinhaltet

- IT

- SEINE

- Peter

- jon

- nur

- KDnuggets

- Behalten

- Kick

- Kicks

- Wissen

- Wissen

- kennt

- Sprache

- Nachname

- Spät

- umwandeln

- Springen

- lernen

- Verlassen

- links

- weniger

- lassen

- Vermietung

- Nutzung

- Gefällt mir

- senken

- Magie

- Main

- um

- Making

- Weise

- manuell

- viele

- Mastering

- Materie

- me

- Mittel

- geistig

- Verschmelzung

- Methode

- könnte

- Mobilität

- Modell

- für

- mehr

- vor allem warme

- ziehen um

- mehrere

- sollen

- Need

- hört niemals

- nicht

- jetzt an

- erhalten

- of

- on

- einmal

- gegenüber

- Optimierung

- or

- Andere

- Anders

- UNSERE

- Möglichkeiten für das Ausgangssignal:

- Ausgänge

- aussen

- besitzen

- Papier

- Teil

- Weg

- perfekt

- ausführen

- Leistung

- Physik

- zentrale

- Plato

- Datenintelligenz von Plato

- PlatoData

- Spieler

- Points

- Potenzial

- Praxis

- genau

- Gegenwart

- ziemlich

- früher

- Aufgabenstellung:

- Probleme

- Prozessdefinierung

- produziert

- PRODUKTIVITÄT

- die

- Bereitstellung

- Ziehen

- Frage

- ganz

- Angebot

- lieber

- echt

- Gründe

- empfehlen

- Veteran

- bezieht sich

- relevant

- Anforderung

- Elastizität

- ressourcenintensiv

- Downloads

- reagiert

- Antwort

- Antworten

- Die Ergebnisse

- Umschulung

- Revolution

- Recht

- Zimmer

- s

- gleich

- Einsparung

- Wissenschaft

- Wissenschaft und Technologie

- Wissenschaftler

- Ergebnis

- sehen

- senden

- Sendung

- Reihenfolge

- kompensieren

- mehrere

- erklären

- bedeutend

- Geschicklichkeit

- So

- allein

- LÖSEN

- Auflösung

- einige

- Jemand,

- etwas

- spezifisch

- verbrachte

- Stufen

- Anfang

- beginnt

- steuern

- Schritt

- Shritte

- Immer noch

- Stil

- sicher

- angehen

- gemacht

- Aufgabe

- und Aufgaben

- Tech

- Technik

- Techniken

- Technologie

- erzählen

- Begriff

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Sie

- dann

- Dort.

- deswegen

- Diese

- vom Nutzer definierten

- think

- Denken

- fehlen uns die Worte.

- dachte

- Durch

- So

- Zeit

- zu

- TONE

- Gesamt

- TOTAL

- Training

- Ausbildung

- Baum

- versucht

- versuchen

- Versuch

- XNUMX

- letzte

- für

- unterziehen

- verstehen

- Verständnis

- zweifellos

- us

- -

- benutzt

- Verwendung von

- BESTÄTIGEN

- wertvoll

- verschiedene

- vielseitig

- sehr

- wollen

- Weg..

- Wege

- we

- bekannt

- waren

- wann

- welche

- warum

- werden wir

- Wind

- mit

- .

- ohne

- Word

- arbeiten,

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- Falsch

- Jahr

- noch

- Ausbeute

- U

- Ihr

- Zephyrnet