Anfang dieses Jahres haben wir unsere geteilt Seh- für generative künstliche Intelligenz (KI) auf Roblox und die intuitiven neuen Tools, die es jedem Benutzer ermöglichen, zum Schöpfer zu werden. Da sich diese Tools in der Branche rasant weiterentwickeln, möchte ich ein paar Updates zu den Fortschritten geben, die wir gemacht haben, zum Weg, der noch vor uns liegt, um die generative KI-Erstellung zu demokratisieren, und warum wir denken, dass generative KI ein entscheidendes Element für die Zukunft von Roblox ist.

Fortschritte in der generativen KI und bei großen Sprachmodellen (LLMs) stellen eine unglaubliche Chance dar, die Zukunft immersiver Erlebnisse zu erschließen, indem sie eine einfachere und schnellere Erstellung bei gleichzeitiger Wahrung der Sicherheit ermöglichen und ohne große Rechenressourcen erfordern. Darüber hinaus öffnen Fortschritte bei KI-Modellen, die multimodal sind, das heißt, sie werden mit mehreren Arten von Inhalten trainiert – wie Bildern, Code, Text, 3D-Modellen und Audio – die Tür für neue Fortschritte bei Erstellungstools. Dieselben Modelle beginnen auch, multimodale Ausgaben zu erzeugen, beispielsweise ein Modell, das eine Textausgabe erstellen kann, sowie einige visuelle Elemente, die den Text ergänzen. Wir sehen diese KI-Durchbrüche als enorme Chance, gleichzeitig die Effizienz für erfahrenere Entwickler zu steigern und es noch mehr Menschen zu ermöglichen, großartige Ideen auf Roblox zum Leben zu erwecken. Dieses Jahr Roblox-Entwicklerkonferenz (RDC), haben wir mehrere neue Tools angekündigt, die generative KI in Roblox Studio und darüber hinaus integrieren werden, um jedem Roblox-Benutzer dabei zu helfen, schneller zu skalieren, schneller zu iterieren und seine Fähigkeiten zu erweitern, um noch bessere Inhalte zu erstellen.

Roblox-Assistent

Roblox hat Entwicklern immer die Werkzeuge zur Verfügung gestellt, DIENSTLEISTUNGEN und Support Sie müssen immersive 3D-Erlebnisse schaffen. Gleichzeitig haben wir gesehen, dass unsere Entwickler damit begonnen haben, generative und konversationsbasierte KI von Drittanbietern zu nutzen, um sie bei der Erstellung zu unterstützen. Diese Standardversionen sind zwar nützlich, um die Arbeitsbelastung des Erstellers zu verringern, wurden jedoch nicht für durchgängige Roblox-Workflows entwickelt und sind nicht auf Roblox-Code, -Slang und -Jargon geschult. Das bedeutet, dass den Erstellern erheblicher zusätzlicher Aufwand bevorsteht, wenn sie diese Versionen zum Erstellen von Inhalten für Roblox verwenden. Wir haben daran gearbeitet, den Wert dieser Tools in Roblox Studio zu integrieren, und bei RDC haben wir ein frühes Beispiel von Assistant geteilt.

Assistant ist unsere Konversations-KI, die es Entwicklern aller Erfahrungsstufen ermöglicht, deutlich weniger Zeit mit alltäglichen, sich wiederholenden Aufgaben beim Erstellen zu verbringen und mehr Zeit für hochwertige Aktivitäten wie Erzählung, Gameplay und Erlebnisdesign zu haben. Roblox ist einzigartig positioniert, um dieses dialogorientierte KI-Modell für immersive 3D-Welten zu entwickeln, dank unseres Zugriffs auf eine große Menge öffentlicher 3D-Modelle zum Trainieren, unserer Fähigkeit, ein Modell in unsere Plattform-APIs zu integrieren, und unserer wachsenden Suite innovativer KI-Lösungen . Ersteller werden in der Lage sein, Textansagen in natürlicher Sprache zu verwenden, um Szenen zu erstellen, 3D-Modelle zu bearbeiten und interaktives Verhalten auf Objekte anzuwenden. Der Assistent unterstützt die drei Phasen der Erstellung: Lernen, Codieren und Erstellen:

- Lernen: Unabhängig davon, ob ein Entwickler ganz neu in der Entwicklung auf Roblox ist oder ein erfahrener Veteran ist, hilft Roblox Assistant bei der Beantwortung von Fragen auf einer Vielzahl von Oberflächen in natürlicher Sprache.

- Codierung: Der Assistent wird unsere neuesten Informationen erweitern Code-Assistent Werkzeug. Beispielsweise könnten Entwickler den Assistenten bitten, ihren Code zu verbessern, einen Codeabschnitt zu erklären oder beim Debuggen zu helfen und Korrekturen für Code vorzuschlagen, der nicht richtig funktioniert.

- Gebäude: Der Assistent hilft Entwicklern dabei, schnell neue Ideen umzusetzen. Beispielsweise könnte ein neuer Ersteller ganze Szenen erstellen und verschiedene Versionen ausprobieren, indem er einfach eine Eingabeaufforderung wie „Fügen Sie einige Straßenlaternen entlang dieser Straße hinzu“ oder „Erstellen Sie einen Wald mit verschiedenen Baumarten“ eingibt. Fügen Sie nun einige Büsche und Blumen hinzu.“

Die Zusammenarbeit mit Assistant wird kollaborativ, interaktiv und iterativ sein, sodass Entwickler Feedback geben und Assistant die richtige Lösung bereitstellen können. Es wird so sein, als hätte man einen erfahrenen Schöpfer als Partner, mit dem man Ideen austauschen und Ideen ausprobieren kann, bis man sie richtig hinbekommt.

Um Assistant zum bestmöglichen Partner zu machen, haben wir beim RDC eine weitere Ankündigung gemacht: Wir haben Entwickler dazu eingeladen entscheiden in ihre anonymisierten Luau-Skriptdaten beizusteuern. Diese Skriptdaten werden dazu beitragen, dass unsere KI-Tools wie Code Assist und Assistant wesentlich besser darin sind, effizienteren Code vorzuschlagen und zu erstellen, was den Roblox-Entwicklern, die sie verwenden, etwas zurückgibt. Wenn sich Entwickler außerdem dafür entscheiden, über Roblox hinaus zu teilen, werden ihre Skriptdaten zu einem Datensatz hinzugefügt, der Dritten zur Verfügung gestellt wird, um ihre KI-Chat-Tools so zu trainieren, dass sie Luau-Code besser vorschlagen können, was den Luau-Entwicklern überall etwas zurückgibt.

Um es klar auszudrücken: Durch umfassende Benutzerforschung und transparente Gespräche mit Top-Entwicklern haben wir dies als Opt-in-Möglichkeit konzipiert und werden dazu beitragen, dass alle Teilnehmer verstehen, was das Programm beinhaltet, und damit einverstanden sind. Als Dankeschön an diejenigen, die sich dafür entscheiden, am Austausch von Skriptdaten mit Roblox teilzunehmen, gewähren wir Zugriff auf die leistungsstärkeren Versionen von Assistant und Code Assist, die auf diesem von der Community geschulten Modell basieren. Diejenigen, die sich nicht angemeldet haben, haben weiterhin Zugriff auf unsere bestehende Version von Assistant und Code Assist.

Einfachere Avatar-Erstellung

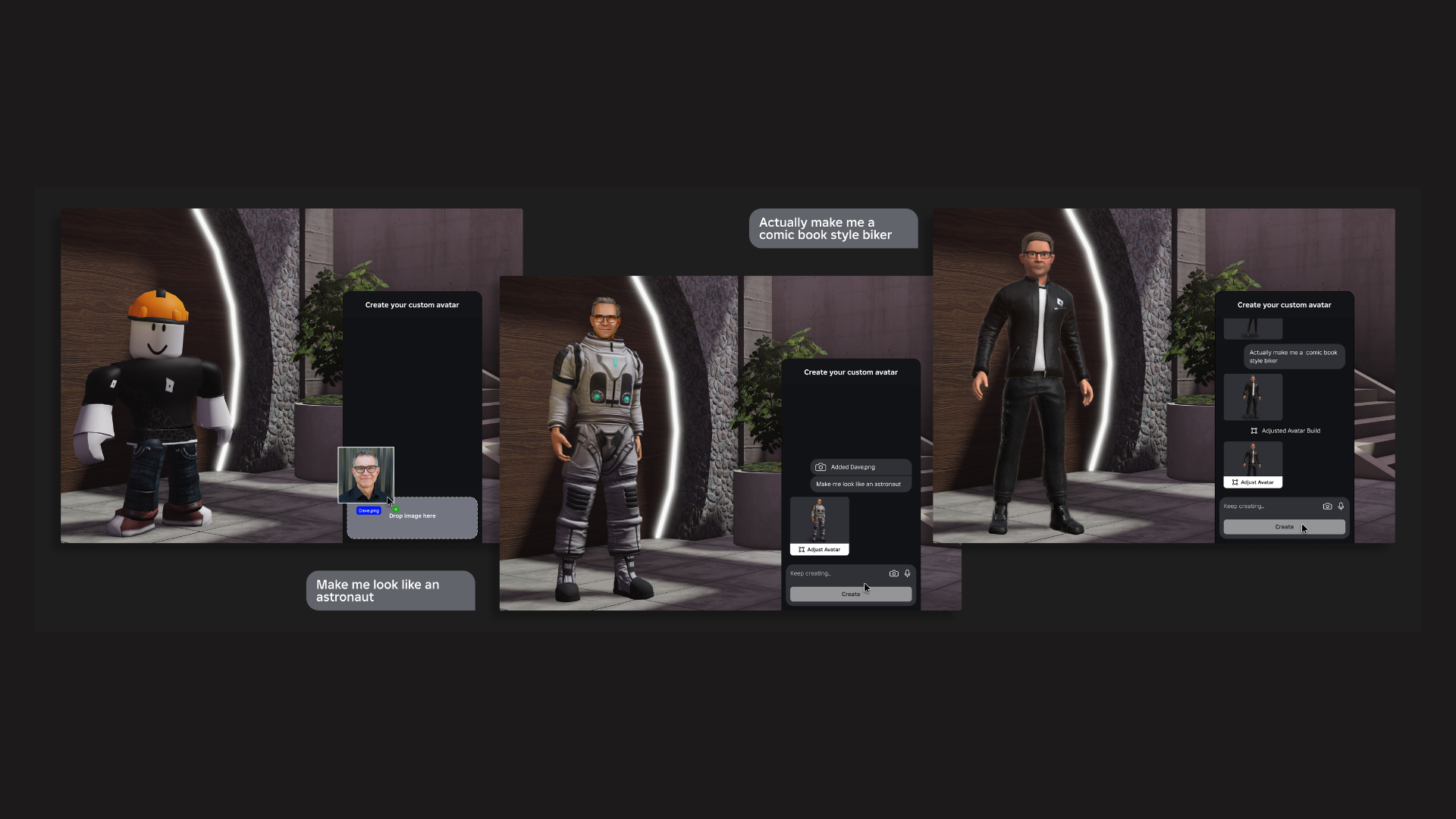

Letztendlich möchten wir, dass jeder unserer 65.5 Millionen täglichen Nutzer einen Avatar hat, der ihn wirklich repräsentiert und zum Ausdruck bringt, wer er ist. Wir haben kürzlich die Möglichkeit für unsere Mitglieder des UGC-Programms freigegeben, dies zu tun Erstellen und verkaufen Sie sowohl Avatar-Körper als auch eigenständige Köpfe. Heutzutage erfordert dieser Prozess Zugriff auf Studio oder unser UGC-Programm, ein ziemlich hohes Maß an Fähigkeiten und mehrere Arbeitstage, um Gesichtsausdruck, Körperbewegung, 3D-Rigging usw. zu ermöglichen. Dies macht die Erstellung von Avataren zeitaufwändig und muss dies auch tun Datum, begrenzte die Anzahl der verfügbaren Optionen. Wir wollen noch weiter gehen.

Damit jeder auf Roblox einen personalisierten, ausdrucksstarken Avatar haben kann, müssen wir die Erstellung und Anpassung von Avataren sehr einfach gestalten. Bei RDC haben wir ein neues Tool angekündigt, das wir 2024 veröffentlichen werden und das die einfache Erstellung eines benutzerdefinierten Avatars aus einem Bild oder mehreren Bildern ermöglichen wird. Mit diesem Tool kann jeder Ersteller mit Zugriff auf Studio oder unser UGC-Programm ein Bild hochladen, einen Avatar für sich erstellen lassen und ihn dann nach Belieben ändern. Längerfristig beabsichtigen wir, dies auch direkt in Erlebnissen auf Roblox verfügbar zu machen.

Um dies zu ermöglichen, trainieren wir KI-Modelle auf dem Avatar-Schema von Roblox und einer Reihe von Roblox-eigenen 3D-Avatar-Modellen. Ein Ansatz nutzt Forschungsprojekte zum Generieren stilisierter 3D-Avatare aus 2D-Bildern. Wir erwägen auch die Verwendung vorab trainierter Text-zu-Bild-Diffusionsmodelle, um begrenzte 3D-Trainingsdaten mit generativen 2D-Techniken zu erweitern, und die Verwendung eines GAN-basierten 3D-Generierungsnetzwerks (Generative Adversarial Network) für das Training. Schließlich arbeiten wir an der Verwendung ControlNet um vordefinierte Posen zu überlagern, um die resultierenden Mehransichtsbilder der Avatare zu steuern.

Dieser Prozess erzeugt ein 3D-Netz für den Avatar. Als nächstes nutzen wir 3D Semantische Segmentierungsforschung, trainiert in 3D-Avatar-Posen, um dieses 3D-Netz zu nehmen und es anzupassen, um entsprechende Gesichtszüge, Käfige, Rigging und Texturen hinzuzufügen, im Wesentlichen, um das statische 3D-Netz in einen Roblox-Avatar zu verwandeln. Schließlich ermöglicht ein Netzbearbeitungstool Benutzern, das Modell zu verändern und anzupassen, damit es eher der Version ähnelt, die sie sich vorstellen. Und das alles geschieht schnell – innerhalb von Minuten – und erzeugt einen neuen Avatar, der in Roblox importiert und in einem Erlebnis verwendet werden kann.

Moderation von Sprachkommunikation

Für uns geht es bei KI nicht nur um Schöpfung, sondern auch um ein viel effizienteres System zur Gewährleistung einer vielfältigen, sicheren und zivilen Gemeinschaft in großem Maßstab. Während wir mit der Einführung neuer Sprachfunktionen beginnen, darunter Voice-Chat und Roblox Connect, der neuen Funktion „Anrufen als Avatar“ und der auf der RDC angekündigten APIs, stehen wir vor einer neuen Herausforderung: der Moderation gesprochener Sprache in Echtzeit. Der aktuelle Industriestandard hierfür ist ein Prozess namens „Automatische Spracherkennung“ (Automatic Speech Recognition, ASR), der im Wesentlichen eine Audiodatei nimmt, sie transkribiert, um sie in Text umzuwandeln, und dann den Text analysiert, um nach unangemessener Sprache, Schlüsselwörtern usw. zu suchen.

Dies funktioniert gut für Unternehmen, die es in kleinerem Maßstab nutzen, aber als wir uns mit der Nutzung desselben ASR-Prozesses zur Moderation der Sprachkommunikation beschäftigten, wurde uns schnell klar, dass es in unserem Maßstab schwierig und ineffizient ist. Bei diesem Ansatz gehen auch unglaublich wertvolle Informationen verloren, die in der Lautstärke und im Tonfall eines Sprechers sowie im breiteren Kontext des Gesprächs kodiert sind. Von den Millionen Gesprächsminuten, die wir jeden Tag in verschiedenen Sprachen transkribieren müssten, würde nur ein sehr kleiner Prozentsatz überhaupt wie etwas Unangemessenes klingen. Und während wir weiter skalieren, würde dieses System immer mehr Rechenleistung benötigen, um mithalten zu können. Deshalb haben wir uns genauer angesehen, wie wir dies effizienter machen können, indem wir eine Pipeline aufgebaut haben, die direkt vom Live-Audio bis zur Kennzeichnung von Inhalten reicht, um anzuzeigen, ob sie gegen unsere Richtlinien verstoßen oder nicht.

Letztendlich konnten wir ein internes, individuelles Spracherkennungssystem aufbauen, indem wir ASR zur Klassifizierung unserer internen Sprachdatensätze verwendeten und diese klassifizierten Sprachdaten dann zum Trainieren des Systems verwendeten. Genauer gesagt, um dieses neue System zu trainieren, beginnen wir mit Audio und erstellen ein Transkript. Anschließend lassen wir das Transkript durch unser Roblox-Textfiltersystem laufen, um das Audio zu klassifizieren. Dieses Textfiltersystem eignet sich hervorragend zur Erkennung von richtlinienverletzender Sprache auf Roblox, da wir dasselbe Filtersystem seit Jahren für Roblox-spezifische Umgangssprache, Abkürzungen und Umgangssprache optimieren. Am Ende dieser Schulungsebenen verfügen wir über ein Modell, das in der Lage ist, Richtlinienverstöße direkt anhand von Audiodaten in Echtzeit zu erkennen.

Obwohl dieses System in der Lage ist, bestimmte Schlüsselwörter wie Obszönitäten zu erkennen, handelt es sich bei Richtlinienverstößen selten nur um ein einzelnes Wort. Ein Wort kann in einem Kontext oft problematisch erscheinen und in einem anderen Kontext völlig in Ordnung sein. Bei dieser Art von Verstößen geht es im Wesentlichen darum, was Sie sagen, wie Sie es sagen und in welchem Kontext die Aussagen gemacht werden.

Um den Kontext besser zu verstehen, nutzen wir die native Leistungsfähigkeit einer transformatorbasierten Architektur, die sich sehr gut für die Zusammenfassung von Sequenzen eignet. Es kann eine Datenfolge wie einen Audiostream aufnehmen und für Sie zusammenfassen. Diese Architektur ermöglicht es uns, eine längere Audiosequenz beizubehalten, sodass wir nicht nur Wörter, sondern auch Kontext und Betonung erkennen können. Sobald alle diese Elemente zusammenkommen, haben wir ein endgültiges System, bei dem die Eingabe Audio und die Ausgabe eine Klassifizierung ist – ob gegen Richtlinien verstoßen wird oder nicht. Dieses System kann Schlüsselwörter und richtlinienverletzende Formulierungen erkennen, aber auch Tonfall, Stimmung und andere Kontexte, die für die Bestimmung der Absicht wichtig sind. Dieses neue System, das richtlinienverletzende Sprache direkt im Audio erkennt, ist deutlich recheneffizienter als ein herkömmliches ASR-System, was die Skalierung erheblich erleichtert, da wir die Art und Weise, wie Menschen zusammenkommen, immer wieder neu überdenken.

Wir brauchten auch eine neue Möglichkeit, die Nutzer unserer Sprachkommunikationstools vor den möglichen Folgen dieser Art von Sprache zu warnen. Mit diesem innovativen Erkennungssystem experimentieren wir nun mit Möglichkeiten, das Online-Verhalten zu beeinflussen, um eine sichere Umgebung zu gewährleisten. Wir wissen, dass Menschen manchmal unbeabsichtigt gegen unsere Richtlinien verstoßen, und wir möchten verstehen, ob eine gelegentliche Erinnerung dazu beitragen kann, weitere Verstöße zu verhindern. Um dabei zu helfen, experimentieren wir mit Echtzeit-Benutzerfeedback durch Benachrichtigungen. Wenn das System feststellt, dass Sie mehrmals etwas gesagt haben, das gegen unsere Richtlinien verstößt, zeigen wir eine Popup-Benachrichtigung auf Ihrem Bildschirm an, die Sie darüber informiert, dass Ihre Sprache gegen unsere Richtlinien verstößt, und verweist Sie auf unsere Richtlinien, um weitere Informationen zu erhalten.

Sprachstream-Benachrichtigungen sind jedoch nur ein Element des Moderationssystems. Wir betrachten auch Verhaltensmuster auf der Plattform sowie Beschwerden von anderen auf Roblox, um unsere allgemeinen Moderationsentscheidungen zu treffen. Die Gesamtheit dieser Signale könnte zu schwerwiegenderen Konsequenzen führen, einschließlich der Sperrung des Zugriffs auf Audiofunktionen oder bei schwerwiegenderen Verstößen zu einem vollständigen Verbot der Plattform. Es ist von entscheidender Bedeutung, die Sicherheit und Zivilität unserer Community zu gewährleisten, da diese Fortschritte bei multimodalen KI-Modellen, generativer KI und LLMs zusammenkommen, um den Entwicklern unglaubliche neue Tools und Fähigkeiten zu ermöglichen.

Wir glauben, dass die Bereitstellung dieser Tools für YouTuber sowohl die Eintrittsbarriere für weniger erfahrene YouTuber senkt als auch erfahrenere YouTuber von den mühsameren Aufgaben dieses Prozesses befreit. Dadurch haben sie mehr Zeit für die erfinderischen Aspekte der Feinabstimmung und Ideenfindung. Unser Ziel bei all dem ist es, jedem überall auf der Welt die Möglichkeit zu geben, seine Ideen zum Leben zu erwecken und die Vielfalt der auf Roblox verfügbaren Avatare, Gegenstände und Erlebnisse erheblich zu erhöhen. Wir sind auch Austausch von Informationen und Tools zum Schutz neuer Kreationen.

Wir stellen uns bereits erstaunliche Möglichkeiten vor: Angenommen, jemand könnte direkt aus einem Foto einen Avatar-Doppelgänger erstellen, dann könnte er seinen Avatar anpassen, um ihn größer zu machen oder ihn im Anime-Stil darzustellen. Oder sie könnten ein Erlebnis schaffen, indem sie den Assistenten bitten, Autos, Gebäude und Landschaften hinzuzufügen, Licht- oder Windbedingungen festzulegen oder das Gelände zu ändern. Von dort aus könnten sie iterieren, um Dinge zu verfeinern, indem sie einfach mit Assistant hin und her tippen. Wir wissen, dass die Realität dessen, was Menschen mit diesen Tools schaffen, sobald sie verfügbar sind, weit über das hinausgehen wird, was wir uns überhaupt vorstellen können.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- ChartPrime. Verbessern Sie Ihr Handelsspiel mit ChartPrime. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://blog.roblox.com/2023/09/revolutionizing-creation-roblox/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 1

- 2024

- 2D

- 3d

- 65

- 8

- a

- Fähigkeit

- Fähig

- LiveBuzz

- Zugang

- ACM

- über

- Aktivitäten

- hinzufügen

- hinzugefügt

- Zusätzliche

- einstellen

- Vorschüsse

- widersprüchlich

- beeinflussen

- Aggregat

- voraus

- AI

- KI-Modelle

- Alle

- erlauben

- erlaubt

- entlang

- bereits

- ebenfalls

- immer

- erstaunlich

- an

- Analysen

- und

- anime

- angekündigt

- Ankündigung

- Ein anderer

- beantworten

- jedem

- jemand

- APIs

- Bewerben

- Ansatz

- angemessen

- Architektur

- SIND

- künstlich

- künstliche Intelligenz

- Künstliche Intelligenz (AI)

- AS

- fragen

- fragen

- Aspekte

- helfen

- Assistentin

- At

- Audio-

- automatische

- verfügbar

- direkt verfügbar

- Benutzerbild

- Avatare

- Zurück

- verboten

- Barriere

- BE

- werden

- war

- beginnen

- Anfang

- Sein

- Glauben

- BESTE

- Besser

- Beyond

- Blog

- Körper

- Körper

- beide

- Prallen

- Durchbrüche

- bringen

- breiteres

- bauen

- Building

- aber

- by

- Aufruf

- CAN

- Fähigkeiten

- fähig

- Autos

- Übernehmen

- Auswählen

- zivil

- eingestuft

- klassifizieren

- klar

- näher

- Code

- Programmierung

- kollaborative

- wie die

- Kommunikation

- community

- Unternehmen

- Beschwerden

- Ergänzung

- umfassend

- Berechnen

- Bedingungen

- Konferenz

- Vernetz Dich

- Zustimmung

- Folgen

- Inhalt

- Kontext

- fortsetzen

- beitragen

- Gespräch

- Konversations

- Konversations-KI

- Gespräche

- verkaufen

- könnte

- erstellen

- erstellt

- Erstellen

- Schaffung

- Schöpfer

- Schöpfer

- kritischem

- Strom

- Original

- anpassen

- Unterricht

- technische Daten

- Datensatz

- Datensätze

- Datum

- Tag

- Tage

- Entscheidungen

- demokratisieren

- Design

- entworfen

- Entdeckung

- Bestimmen

- Entwickler

- Entwicklung

- anders

- schwer

- Rundfunk

- Direkt

- Display

- verschieden

- Diversität

- do

- die

- Tut nicht

- Von

- Antrieb

- jeder

- Früh

- einfacher

- Einfache

- Effizienz

- effizient

- effizient

- Element

- Elemente

- ermöglichen

- ermöglicht

- ermöglichen

- Ende

- End-to-End

- enorm

- gewährleisten

- Gewährleistung

- Ganz

- vollständig

- Eintrag

- Arbeitsumfeld

- Essenz

- im Wesentlichen

- etc

- Sogar

- Jedes

- jeden Tag

- jedermann

- überall

- entwickelt sich

- Beispiel

- vorhandenen

- Erweitern Sie die Funktionalität der

- ERFAHRUNGEN

- erfahrensten

- Erfahrungen

- Experte

- Erklären

- Erkundet

- Ausdruck

- expressiv

- Gesicht

- Gesichts-

- ziemlich

- beschleunigt

- Merkmal

- Eigenschaften

- Feedback

- Reichen Sie das

- Filter

- Finale

- Endlich

- Ende

- Aussichten für

- Wald

- weiter

- Frei

- für

- weiter

- Zukunft

- erzeugen

- Erzeugung

- Generation

- generativ

- Generative KI

- bekommen

- Unterstützung

- Go

- Kundenziele

- Goes

- gehen

- gut

- gewähren

- groß

- persönlichem Wachstum

- Guide

- das passiert

- Haben

- mit

- Hilfe

- GUTE

- Ultraschall

- aber

- HTTPS

- i

- Ideen

- if

- Image

- Bilder

- Bild

- immersive

- wichtig

- zu unterstützen,

- in

- Einschließlich

- Erhöhung

- unglaublich

- unglaublich

- zeigen

- Energiegewinnung

- ineffizient

- Information

- innovativ

- Varianten des Eingangssignals:

- integrieren

- Intelligenz

- wollen

- Absicht

- interaktive

- in

- intuitiv

- eingeladen

- beteiligen

- beteiligt

- IT

- Artikel

- nur

- nur einer

- Behalten

- Aufbewahrung

- Schlüsselwörter

- Wissen

- bekannt

- Beschriftung

- Sprache

- Sprachen

- grosse

- Schicht

- Lagen

- lernen

- weniger

- Niveau

- Cholesterinspiegel

- Hebelwirkung

- Hebelwirkungen

- Lebensdauer

- Lighting

- Gefällt mir

- Limitiert

- leben

- länger

- aussehen

- suchen

- Verliert

- senken

- gemacht

- halten

- Aufrechterhaltung

- um

- MACHT

- Making

- massiv

- Bedeutung

- Mittel

- Mitglieder

- ineinander greifen

- könnte

- Million

- Millionen

- Minuten

- Modell

- für

- moderieren

- Mäßigung

- ändern

- mehr

- effizienter

- Bewegung

- viel

- mehrere

- NARRATIVE

- nativen

- Natürliche

- Natürliche Sprache

- Need

- erforderlich

- Netzwerk

- Neu

- weiter

- Benachrichtigung

- Benachrichtigungen

- jetzt an

- Anzahl

- Objekte

- gelegentlich

- of

- WOW!

- vorgenommen,

- on

- einmal

- EINEM

- Online

- einzige

- Gelegenheit

- Optimierung

- Optionen

- or

- Andere

- Anders

- UNSERE

- Möglichkeiten für das Ausgangssignal:

- Gesamt-

- Teilnehmer

- teilnehmen

- Parteien

- Partner

- Muster

- Personen

- Prozentsatz

- Personalisiert

- für Ihre privaten Foto

- Sätze

- Pipeline

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- Politik durchzulesen

- Datenschutzrichtlinien

- Pop-up

- Posen

- positioniert

- Möglichkeiten

- möglich

- gegebenenfalls

- Potenzial

- Werkzeuge

- angetriebene

- größte treibende

- Gegenwart

- verhindern

- Prozessdefinierung

- produziert

- produziert

- PROFANITÄT

- Programm

- Fortschritt

- richtig

- Risiken zu minimieren

- Prototyp

- die

- vorausgesetzt

- Bereitstellung

- Öffentlichkeit

- Fragen

- schnell

- Angebot

- schnell

- selten

- echt

- Echtzeit

- Realität

- realisiert

- kürzlich

- kürzlich

- Anerkennung

- Veteran

- verfeinern

- freigegeben

- Loslassen

- repetitiv

- representiert

- erfordern

- erfordert

- Forschungsprojekte

- Downloads

- Folge

- was zu

- Revolutionierung

- Recht

- Straße

- Roblox

- Rollen

- Führen Sie

- Safe

- Sicherheit

- Said

- gleich

- sagen

- Skalieren

- Szenen

- Bildschirm

- Skript

- gewürzt

- Abschnitt

- sehen

- scheinen

- gesehen

- Segmentierung

- verkaufen

- Gefühl

- Reihenfolge

- ernst

- kompensieren

- Sets

- mehrere

- Teilen

- von Locals geführtes

- ,,teilen"

- Signale

- signifikant

- bedeutend

- einfach

- gleichzeitig

- da

- Geschicklichkeit

- Fähigkeiten

- klein

- kleinere

- So

- Lösung

- Lösungen

- einige

- Jemand,

- etwas

- manchmal

- Klingen

- spezifisch

- speziell

- Rede

- Spracherkennung

- verbringen

- gesprochen

- standalone

- Standard

- Aussagen

- Immer noch

- Strom

- stärker

- Studio Adressen

- Stil

- so

- vorschlagen

- Suite

- zusammenfassen

- Support

- System

- Nehmen

- nimmt

- und Aufgaben

- Techniken

- Begriff

- Text

- als

- dank

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Zukunft

- ihr

- Sie

- dann

- Dort.

- Diese

- vom Nutzer definierten

- think

- Dritte

- dritte seite

- basierte Online-to-Offline-Werbezuordnungen von anderen gab.

- fehlen uns die Worte.

- dieses Jahr

- diejenigen

- nach drei

- Durch

- Zeit

- Zeitaufwendig

- mal

- zu

- heute

- gemeinsam

- TONE

- Tonfall

- nahm

- Werkzeug

- Werkzeuge

- Top

- traditionell

- Training

- trainiert

- Ausbildung

- Abschrift

- transparent

- Bäume

- wirklich

- versuchen

- tippe

- Typen

- verstehen

- Verständnis

- einzigartig

- öffnen

- bis

- Updates

- us

- -

- benutzt

- Mitglied

- Nutzer

- Verwendung von

- wertvoll

- Wertvolle Information

- Wert

- Version

- sehr

- Veteran

- Verstöße

- Visuals

- Stimme

- Volumen

- wollen

- wollte

- Weg..

- Wege

- we

- GUT

- waren

- Was

- ob

- welche

- während

- WHO

- warum

- breit

- Große Auswahl

- werden wir

- Wind

- mit

- .

- ohne

- Word

- Worte

- Arbeiten

- Workflows

- arbeiten,

- Werk

- weltweit

- würde

- Jahr

- Jahr

- U

- Ihr

- Youtube

- Zephyrnet