Meta hat ein weiteres offenes Modell für maschinelles Lernen veröffentlicht, dieses Mal auf die Generierung von Software-Quellcode abgestimmt.

Code Lama ist eine Familie großer Sprachmodelle – daher die gelegentliche Großschreibung „LLaMA“ – basierend auf dem Llama 2-Modell freigegeben im Juli. Es wurde fein abgestimmt und trainiert, um Quellcode als Reaktion auf Textaufforderungen auszugeben und zu diskutieren, statt wie sein Vorläufer in Prosa.

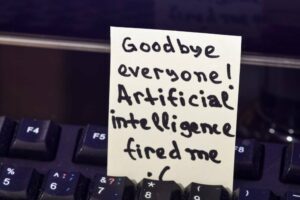

Wie jede Spitzentechnologie birgt Code Llama Risiken

„Code Llama hat das Potenzial, als Produktivitäts- und Bildungstool eingesetzt zu werden, um Programmierern dabei zu helfen, robustere, gut dokumentierte Software zu schreiben“, behauptete Meta in eine Ankündigung Donnerstag.

Wenn man Code Llama bittet, eine Funktion zu schreiben, die die Fibonacci-Folge erzeugt, generiert das Modell sowohl Code als auch natürliche Sprache, die die Quelle erklärt, sagt Meta. Und das KI-Modell kann dies in Python, C++, Java, PHP, Typescript (Javascript), C#, Bash und anderen Sprachen tun.

Benutzer werden jedoch angewiesen, Code Llama auf Englisch anzusprechen, da das Modell keinen Sicherheitstests in anderen Sprachen unterzogen wurde und möglicherweise etwas Schreckliches sagt, wenn es in einem abgefragt wird außer Reichweite Sprache.

„Wie jede hochmoderne Technologie birgt Code Llama Risiken“, erklärt Meta und weist darauf hin, dass Code Llama bei seinen eigenen Red-Team-Tests, um die Erstellung von Schadcode zu fördern, mit sichereren Antworten reagierte als ChatGPT (GPT3.5 Turbo).

Laut Meta übertrifft Code Llama Open-Source-Code-spezifische LLMs und sein eigenes übergeordnetes Llama 2 in zwei Benchmarks: HumanEval und größtenteils grundlegende Python-Programmierung (MBPP) – und entspricht der Leistung von OpenAIs ChatGPT.

Code Llama gibt es in drei Größen – 7B-, 13B- und 34B-Parameter – und jede Variante wurde mit 500B Code-Tokens und codebezogenen Daten trainiert. Ein Token besteht im Englischen aus etwa vier Zeichen. Die größte Version des OpenAI-Codex hatte zum Zeitpunkt seiner Veröffentlichung 12B Parameter.

Laut Meta wurden die beiden kleinsten Code-Llama-Modelle darauf trainiert, fehlende Quellen zu ergänzen, sodass sie ohne weitere Feinabstimmung zur Code-Vervollständigung verwendet werden können. Die 34B-Version soll die besten Ergebnisse liefern, die beiden kleineren reagieren jedoch schneller und eignen sich daher besser für Aufgaben wie die Code-Vervollständigung, bei denen die Latenz spürbar ist.

Es gibt auch zwei Varianten: Code Llama – Python und Code Llama – Instruct. Ersteres entsteht durch die Feinabstimmung von Code Llama mit zusätzlichen 100 Milliarden Tokens Python-Code. Letzteres wurde so optimiert, dass es Eingabe- und Ausgabemustern entspricht, wodurch es sich besser für die Codegenerierung eignet.

Zuverlässigkeit, irgendjemand?

LLMs bieten oft unrichtig Antworten zu Programmieraufforderungen, obwohl sie dennoch von vielen Entwicklern verwendet werden, um Routinemuster und API-Parameter abzurufen oder Suchanfragen und Dokumentationsprüfungen zu vermeiden.

Eines der Verkaufsargumente von Code Llama ist, dass es die Ein- und Ausgabe von Codesequenzen verarbeiten kann, die aus bis zu 100,000 Token bestehen. Das heißt, Sie können das Modell mit vielen Codezeilen aufrufen und erhalten möglicherweise eine ausführliche Antwort.

„Längere Eingabesequenzen sind nicht nur eine Voraussetzung für die Generierung längerer Programme, sondern erschließen auch aufregende neue Anwendungsfälle für ein Code-LLM“, erklärte Meta. „Benutzer können dem Modell beispielsweise mehr Kontext aus ihrer Codebasis zur Verfügung stellen, um die Generationen relevanter zu machen.“ Es hilft auch beim Debuggen von Szenarios in größeren Codebasen, bei denen es für Entwickler schwierig sein kann, den Überblick über den gesamten Code im Zusammenhang mit einem konkreten Problem zu behalten.“

Benutzer können dem Modell mehr Kontext aus ihrer Codebasis zur Verfügung stellen, um die Generationen relevanter zu machen

Code Llama schließt sich einem wachsenden Feld von Code-versierten Modellen an, die ursprünglich durch den Codex von OpenAI und die damit verbundenen GitHub-Modelle entstanden sind prozessbelastet Copilot (2021) Programmvorschlagsdienst. Zu den folgenden programmierungspositiven Modellen gehört DeepMind AlphaCode (2022), OpenAIs GPT-4 (2023), Amazon Codeflüsterer (2023) und Googles Bard (2023), eingestellt im April generieren Quellcode.

Darüber hinaus gab es verschiedene Open-Source-LLMs (oder eine Art offene LLMs). StarCoder und XGen, um zwei zu nennen.

Unter demselben Motto hat Meta auch Code Llama veröffentlicht Community-Lizenz als Llama 2 und zitierte den Glauben des Megakonzerns an einen „offenen Ansatz für KI“ als den besten Weg, innovative, sichere und verantwortungsvolle Werkzeuge zu entwickeln.

Aber wie bereits bei Llama 2 festgestellt wurde, gilt die Community-Lizenz keine Open-Source-Lizenz. Metas „offener Ansatz“ für KI ist dem Wettbewerb verschlossen – die Lizenz verbietet ausdrücklich die Verwendung der Software „zur Verbesserung eines anderen großen Sprachmodells“.

Und während die Community-Lizenz von Meta die kommerzielle Nutzung seiner verschiedenen Lamas erlaubt, zieht sie die Grenze bei Diensten mit „mehr als 700 Millionen monatlich aktiven Nutzern“.

Das eher wähle die Gruppe von Megadiensten – YouTube, WeChat, TikTok, LinkedIn, Telegram, Snapchat und Douyin, darunter Social-Media-Plattformen, die noch nicht von Meta betrieben werden, und vermutlich Unternehmen, die betriebssystembasierte Plattformen wie Apple, Google und Microsoft betreiben – „müssen eine Anfrage stellen.“ eine Lizenz von Meta, die Meta Ihnen nach eigenem Ermessen gewähren kann…“ ®

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- ChartPrime. Verbessern Sie Ihr Handelsspiel mit ChartPrime. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://go.theregister.com/feed/www.theregister.com/2023/08/25/meta_lets_code_llama_run/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 000

- 100

- 2021

- 2022

- 2023

- 700

- a

- aktiv

- Zusatz

- Adresse

- haften

- AI

- Alle

- erlaubt

- bereits

- ebenfalls

- Amazon

- unter

- an

- und

- Ein anderer

- Antworten

- jedem

- jemand

- Bienen

- Apple

- Ansatz

- April

- SIND

- AS

- damit verbundenen

- At

- Vermeidung von

- basierend

- bash

- basic

- BE

- war

- Sein

- Glauben

- Benchmarks

- BESTE

- Besser

- beide

- aber

- by

- C + +

- CAN

- Kapitalisierung

- Fälle

- herausfordernd

- Zeichen

- ChatGPT

- Schecks

- behauptet

- geschlossen

- CO

- Code

- Codebasis

- kommt

- kommerziell

- community

- Unternehmen

- Wettbewerb

- Abschluss

- Kontext

- Schaffung

- Schneiden

- technische Daten

- DeepMind

- entwickeln

- Entwickler

- DID

- diskutieren

- do

- Dokumentation

- douyin

- zieht

- im

- jeder

- Edge

- Bildungs-

- Englisch

- Äther (ETH)

- Beispiel

- unterhaltsame Programmpunkte

- erklärt

- Erläuterung

- Erklärt

- extra

- Familie

- beschleunigt

- FB

- Fibonacci

- Feld

- füllen

- Ende

- gefolgt

- Aussichten für

- Früher

- vier

- für

- Funktion

- weiter

- erzeugen

- Erzeugung

- Generation

- Generationen

- bekommen

- GitHub

- gewähren

- mehr

- persönlichem Wachstum

- hätten

- Griff

- Haben

- mit

- Hilfe

- hilft

- daher

- aber

- HTTPS

- if

- zu unterstützen,

- in

- In anderen

- das

- anfänglich

- innovativ

- Varianten des Eingangssignals:

- beantragen müssen

- Problem

- IT

- SEINE

- Javac

- JavaScript

- Joins

- jpg

- Juli

- nur

- Sprache

- Sprachen

- grosse

- größer

- höchste

- Latency

- lernen

- Lasst uns

- Lizenz

- Gefällt mir

- Line

- Linien

- Lama

- länger

- Maschine

- Maschinelles Lernen

- um

- Making

- viele

- Kann..

- Medien

- Meta

- Microsoft

- könnte

- Million

- Kommt demnächst...

- Modell

- für

- monatlich

- mehr

- meist

- sollen

- Name

- Natürliche

- Natürliche Sprache

- Neu

- bekannt

- Bemerkens

- gelegentlich

- of

- vorgenommen,

- on

- EINEM

- XNUMXh geöffnet

- Open-Source-

- OpenAI

- die

- or

- Andere

- Übertrifft

- Möglichkeiten für das Ausgangssignal:

- besitzen

- Parameter

- Muster

- Leistung

- PHP

- Plattformen

- Plato

- Datenintelligenz von Plato

- PlatoData

- Punkte

- Potenzial

- produziert

- PRODUKTIVITÄT

- Vorläufer

- Programmierer

- Programmierung

- Programme

- die

- setzen

- Python

- Abfragen

- lieber

- RE

- Rot

- bezogene

- freigegeben

- relevant

- Anforderung

- Reagieren

- Antwort

- für ihren Verlust verantwortlich.

- Die Ergebnisse

- Aufruhr

- Risiken

- robust

- rund

- Führen Sie

- Laufen

- s

- Safe

- Sicherheit

- Sicherheit

- Said

- gleich

- sagt

- Szenarien

- Suche

- in XNUMX Minuten

- Reihenfolge

- Lösungen

- Größen

- kleinere

- snapchat

- So

- Social Media

- Social Media

- Social-Media-Plattformen

- Software

- etwas

- Quelle

- Quellcode

- T

- und Aufgaben

- Team

- Technologie

- Telegram

- AGB

- Testen

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Quelle

- ihr

- Sie

- Dort.

- vom Nutzer definierten

- fehlen uns die Worte.

- obwohl?

- nach drei

- Durch

- Donnerstag

- TikTok

- Zeit

- zu

- Zeichen

- Tokens

- Werkzeug

- Werkzeuge

- Top

- trainiert

- XNUMX

- Typoskript

- für

- entsperrt

- -

- benutzt

- Nutzer

- Verwendung von

- Variante

- verschiedene

- Version

- wurde

- Weg..

- wann

- welche

- während

- weit

- Wikipedia

- werden wir

- mit

- ohne

- schreiben

- noch

- U

- Youtube

- Zephyrnet