Bild von Adobe Firefly

„Wir waren zu viele. Wir hatten Zugang zu zu viel Geld, zu viel Ausrüstung und nach und nach wurden wir verrückt.“

Francis Ford Coppola wollte keine Metapher für KI-Unternehmen entwerfen, die zu viel ausgeben und dabei den Überblick verlieren, aber er hätte es sein können. Apokalypse jetzt war episch, aber auch ein langes, schwieriges und teures Projekt, ähnlich wie GPT-4. Ich würde vermuten, dass die Entwicklung von LLMs auf zu viel Geld und zu viel Ausrüstung zurückzuführen ist. Und der Hype „Wir haben gerade die allgemeine Intelligenz erfunden“ ist teilweise etwas verrückt. Aber jetzt sind die Open-Source-Communities an der Reihe, das zu tun, was sie am besten können: kostenlose, konkurrierende Software mit weitaus weniger Geld und Ausrüstung bereitzustellen.

OpenAI hat über 11 Milliarden US-Dollar an Finanzmitteln erhalten und es wird geschätzt, dass GPT-3.5 5 bis 6 Millionen US-Dollar pro Trainingslauf kostet. Wir wissen sehr wenig über GPT-4, da OpenAI keine Aussagekraft hat, aber ich denke, man kann davon ausgehen, dass es nicht kleiner als GPT-3.5 ist. Derzeit herrscht weltweit ein GPU-Mangel, und das liegt ausnahmsweise nicht am neuesten Kryptocoin. Generative KI-Start-ups erzielen Serie-A-Runden im Wert von über 100 Millionen US-Dollar zu enormen Bewertungen, wenn sie kein geistiges Eigentum für das LLM besitzen, das sie für den Betrieb ihres Produkts verwenden. Der LLM-Zug läuft auf Hochtouren und das Geld fließt.

Es hatte so ausgesehen, als wären die Würfel gefallen: Nur finanzstarke Unternehmen wie Microsoft/OpenAI, Amazon und Google konnten es sich leisten, Modelle mit hundert Milliarden Parametern zu trainieren. Man ging davon aus, dass größere Modelle die besseren Modelle seien. GPT-3 hat etwas falsch gemacht? Warten Sie einfach, bis es eine größere Version gibt, und alles wird gut! Kleinere Unternehmen, die im Wettbewerb bestehen wollten, mussten weitaus mehr Kapital beschaffen oder blieben beim Aufbau von Warenintegrationen auf dem ChatGPT-Marktplatz zurück. Die Wissenschaft wurde mit ihren noch begrenzteren Forschungsbudgets ins Abseits gedrängt.

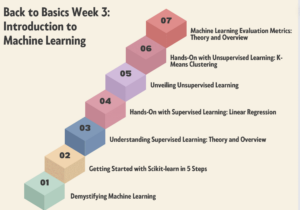

Glücklicherweise betrachteten viele kluge Köpfe und Open-Source-Projekte dies eher als Herausforderung denn als Einschränkung. Forscher in Stanford haben Alpaca veröffentlicht, ein 7-Milliarden-Parametermodell, dessen Leistung dem 3.5-Milliarden-Parametermodell von GPT-175 nahe kommt. Da ihnen die Ressourcen fehlten, um einen Trainingssatz in der von OpenAI verwendeten Größe zu erstellen, entschieden sie sich geschickt dafür, ein trainiertes Open-Source-LLM, LLaMA, zu nehmen und es stattdessen anhand einer Reihe von GPT-3.5-Eingabeaufforderungen und -Ausgaben zu verfeinern. Im Wesentlichen hat das Modell gelernt, was GPT-3.5 tut, was sich als sehr effektive Strategie zur Replikation seines Verhaltens herausstellt.

Alpaca ist nur für die nichtkommerzielle Nutzung von Code und Daten lizenziert, da es das nichtkommerzielle Open-Source-LLaMA-Modell verwendet und OpenAI ausdrücklich jede Verwendung seiner APIs zur Erstellung konkurrierender Produkte untersagt. Dadurch entsteht die verlockende Aussicht, ein anderes Open-Source-LLM auf die Eingabeaufforderungen und Ausgaben von Alpaca abzustimmen und ein drittes GPT-3.5-ähnliches Modell mit anderen Lizenzierungsmöglichkeiten zu schaffen.

Hier liegt noch eine weitere Ebene der Ironie darin, dass alle großen LLMs auf urheberrechtlich geschützte Texte und Bilder im Internet geschult wurden und den Rechteinhabern keinen Cent zahlten. Die Unternehmen beanspruchen die „Fair Use“-Ausnahme nach dem US-amerikanischen Urheberrecht mit dem Argument, dass die Nutzung „transformativ“ sei. Wenn es jedoch um die Ausgabe der Modelle geht, die sie mit kostenlosen Daten erstellen, möchten sie wirklich nicht, dass ihnen jemand das Gleiche antut. Ich gehe davon aus, dass sich dies ändern wird, wenn die Rechteinhaber umsichtiger werden, und möglicherweise irgendwann vor Gericht landet.

Dies ist ein anderer und deutlicher Punkt als der, den Autoren von Open Source mit restriktiven Lizenzen vorbringen, die bei generativen KI-for-Code-Produkten wie CoPilot Einwände dagegen erheben, dass ihr Code für Schulungen verwendet wird, mit der Begründung, dass die Lizenz nicht eingehalten wird. Das Problem für einzelne Open-Source-Autoren besteht darin, dass sie nachweisen müssen, dass sie substanziell kopiert haben, und dass ihnen ein Schaden entstanden ist. Und da die Modelle es schwierig machen, den Ausgabecode mit der Eingabe zu verknüpfen (die Zeilen des Quellcodes des Autors) und es keinen wirtschaftlichen Verlust gibt (es soll kostenlos sein), ist es weitaus schwieriger, eine Begründung zu liefern. Dies ist anders als bei gewinnorientierten Urhebern (z. B. Fotografen), deren gesamtes Geschäftsmodell in der Lizenzierung/Verkauf ihrer Werke besteht und die durch Aggregatoren wie Getty Images vertreten werden, die substanzielle Kopien nachweisen können.

Eine weitere interessante Sache an LLaMA ist, dass es aus Meta hervorgegangen ist. Es wurde ursprünglich nur für Forscher freigegeben und dann über BitTorrent an die Welt weitergegeben. Meta ist in einem grundlegend anderen Geschäft tätig als OpenAI, Microsoft, Google und Amazon, da es nicht versucht, Ihnen Cloud-Dienste oder Software zu verkaufen, und daher ganz andere Anreize hat. Das Unternehmen hat seine Computerdesigns in der Vergangenheit als Open-Source-Lösung bereitgestellt (OpenCompute) und hat gesehen, wie die Community sie verbessert hat – es versteht den Wert von Open Source.

Meta könnte sich als einer der wichtigsten Open-Source-KI-Mitwirkenden erweisen. Es verfügt nicht nur über enorme Ressourcen, es profitiert auch von der Verbreitung großartiger generativer KI-Technologie: Es wird mehr Inhalte geben, die in den sozialen Medien monetarisiert werden können. Meta hat drei weitere Open-Source-KI-Modelle veröffentlicht: ImageBind (mehrdimensionale Datenindizierung), DINOv2 (Computer Vision) und Segment Anything. Letzteres identifiziert einzigartige Objekte in Bildern und wird unter der äußerst freizügigen Apache-Lizenz veröffentlicht.

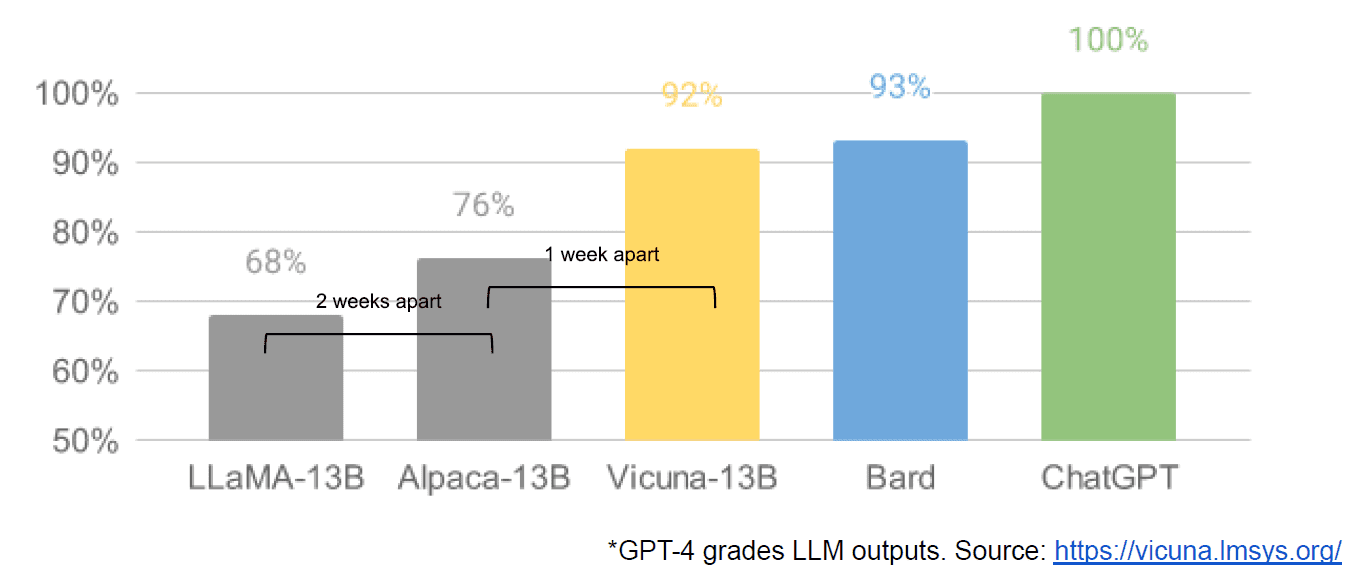

Schließlich wurde auch ein internes Google-Dokument mit dem Titel „We Have No Moat, and We Have No Moat, and Neither Does OpenAI“ angeblich durchgesickert, in dem geschlossene Modelle im Vergleich zur Innovation von Communities, die weitaus kleinere, billigere Modelle mit einer ähnlichen oder sogar besseren Leistung produzieren, düster beurteilt werden ihre Closed-Source-Gegenstücke. Ich sage angeblich, weil es keine Möglichkeit gibt, die Quelle des Artikels als Google-intern zu überprüfen. Es enthält jedoch dieses überzeugende Diagramm:

Die vertikale Achse ist zur Verdeutlichung die Einstufung der LLM-Ergebnisse nach GPT-4.

Stable Diffusion, das Bilder aus Text synthetisiert, ist ein weiteres Beispiel dafür, dass generative Open-Source-KI schneller Fortschritte machen konnte als proprietäre Modelle. Eine aktuelle Version dieses Projekts (ControlNet) hat es so verbessert, dass es die Fähigkeiten von Dall-E2 übertrifft. Dies ist das Ergebnis zahlreicher Tüfteleien auf der ganzen Welt, was zu einem Fortschrittstempo führte, das von keiner einzelnen Institution erreicht werden kann. Einige dieser Tüftler haben herausgefunden, wie man Stable Diffusion schneller trainieren und auf billigerer Hardware ausführen kann, was kürzere Iterationszyklen für mehr Leute ermöglicht.

Damit schließt sich der Kreis. Nicht zu viel Geld und nicht zu viel Ausrüstung zu haben, hat eine ganze Gemeinschaft gewöhnlicher Menschen zu einem raffinierten Maß an Innovation inspiriert. Was für eine Zeit, ein KI-Entwickler zu sein.

Mathew Lodge ist CEO von Diffblue, einem AI For Code-Startup. Er verfügt über mehr als 25 Jahre vielfältige Erfahrung in der Produktleitung bei Unternehmen wie Anaconda und VMware. Lodge ist derzeit Vorstandsmitglied des Good Law Project und stellvertretender Vorsitzender des Kuratoriums der Royal Photographic Society.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Die Zukunft prägen mit Adryenn Ashley. Hier zugreifen.

- Kaufen und verkaufen Sie Anteile an PRE-IPO-Unternehmen mit PREIPO®. Hier zugreifen.

- Quelle: https://www.kdnuggets.com/2023/05/llm-apocalypse-revenge-open-source-clones.html?utm_source=rss&utm_medium=rss&utm_campaign=llm-apocalypse-now-revenge-of-the-open-source-clones

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 9

- a

- Fähig

- Über uns

- Akademie

- Zugang

- Adobe

- vorantreiben

- Aggregatoren

- AI

- Alle

- angeblich

- angeblich

- ebenfalls

- Amazon

- an

- und

- Ein anderer

- jedem

- jemand

- etwas

- Apache

- APIs

- SIND

- Argument

- Artikel

- AS

- angenommen

- At

- Autor

- Autoren

- verfügbar

- Achse

- BE

- weil

- war

- Sein

- Vorteile

- BESTE

- Besser

- größer

- BitTorrent

- Tafel

- beide

- Budgets

- bauen

- Building

- Haufen

- Geschäft

- Geschäftsmodell

- aber

- by

- kam

- CAN

- Fähigkeiten

- Hauptstadt

- Häuser

- CEO

- Vorsitzende

- challenges

- Übernehmen

- ChatGPT

- billiger

- wählten

- Kreis

- Anspruch

- klar

- Menu

- geschlossen

- Cloud

- Cloud-Services

- Code

- wie die

- kommt

- Ware

- Communities

- community

- Unternehmen

- zwingend

- konkurrieren

- konkurrierenden

- Berechnen

- Computer

- Computer Vision

- Inhalt

- mitwirkende

- Kopieren

- Urheberrecht

- Kosten

- könnte

- Platz

- erstellen

- Erstellen

- Schöpfer

- Kryptocoin

- Zur Zeit

- Zyklen

- technische Daten

- liefern

- Stellvertreter

- Designs

- Entwickler:in / Unternehmen

- Entwicklung

- Sterben

- anders

- schwer

- Rundfunk

- deutlich

- verschieden

- do

- Dokument

- die

- Nicht

- e

- Wirtschaftlich

- Effektiv

- ermöglichen

- Ende

- Ganz

- EPIC

- Ausrüstung

- im Wesentlichen

- geschätzt

- Sogar

- Beispiel

- erwarten

- teuer

- ERFAHRUNGEN

- weit

- beschleunigt

- gemustert

- Fließen

- gefolgt

- Aussichten für

- Ford

- Frei

- für

- voller

- grundlegend

- Finanzierung

- Ausrüstung

- Allgemeines

- generativ

- Generative KI

- gut

- GPU

- Graph

- groß

- hätten

- hart

- Hardware

- Haben

- mit

- he

- hier

- High

- hoch

- Inhaber

- Ultraschall

- Hilfe

- aber

- HTTPS

- riesig

- Hype

- i

- identifiziert

- if

- Bilder

- wichtig

- zu unterstützen,

- verbessert

- in

- Incentives

- Krankengymnastik

- Innovation

- Eingangsmöglichkeiten:

- Wahnsinn

- inspirierte

- beantragen müssen

- Institution

- Integrationen

- interessant

- intern

- Internet

- Erfunden

- IP

- Ironie

- IT

- Iteration

- SEINE

- nur

- KDnuggets

- Wissen

- Landung

- neueste

- Recht

- Schicht

- Leadership

- gelernt

- links

- weniger

- Niveau

- Lizenz

- Zugelassen

- Lizenzierung

- Gefällt mir

- Linien

- LINK

- wenig

- Lama

- Lang

- sah

- suchen

- verlieren

- Verlust

- Los

- Dur

- um

- Making

- viele

- Marktplatz

- massiv

- Spiel

- Kann..

- Medien

- Meta

- Microsoft

- Modell

- für

- monetarisieren

- Geld

- mehr

- vor allem warme

- viel

- Need

- Weder

- nicht

- nichtkommerziell

- jetzt an

- Objekt

- Objekte

- of

- on

- EINEM

- einzige

- XNUMXh geöffnet

- Open-Source-

- Open Source-Projekte

- OpenAI

- or

- gewöhnlich

- ursprünglich

- Andere

- Signalausgangsmöglichkeiten:

- übrig

- besitzen

- Frieden

- Parameter

- passt

- AUFMERKSAMKEIT

- Personen

- ausführen

- Leistung

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Möglichkeiten

- Werkzeuge

- Aufgabenstellung:

- Produkt

- Produkte

- Projekt

- Projekte

- Eigentums-

- Aussicht

- erhöhen

- geschafft

- lieber

- wirklich

- kürzlich

- freigegeben

- vertreten

- Forschungsprojekte

- Forscher

- Downloads

- Einschränkung

- was zu

- Rechte

- Runde

- königlich

- Führen Sie

- s

- safe

- gleich

- sagen

- gesehen

- Segment

- verkaufen

- getrennte

- Modellreihe

- Serie A

- dient

- Leistungen

- kompensieren

- Mangel

- erklären

- da

- Single

- Größe

- kleinere

- smart

- So

- Social Media

- Social Media

- Gesellschaft

- Software

- einige

- etwas

- Quelle

- Quellcode

- verbringen

- stabil

- Stanford

- Start-ups

- Anfang

- Strategie

- so

- vorschlagen

- vermutet

- übertroffen

- Nehmen

- gemacht

- nimmt

- Technologie

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Quelle

- die Welt

- ihr

- Sie

- dann

- Dort.

- vom Nutzer definierten

- Ding

- think

- Dritte

- fehlen uns die Worte.

- diejenigen

- nach drei

- Zeit

- zu

- auch

- nahm

- Training

- trainiert

- Ausbildung

- WENDE

- Drehungen

- für

- versteht

- einzigartiges

- nicht wie

- bis

- us

- -

- benutzt

- verwendet

- Verwendung von

- Bewertungen

- Wert

- überprüfen

- Version

- vertikal

- sehr

- Anzeigen

- Seh-

- VMware

- vs

- warten

- wollen

- wurde

- Weg..

- we

- ging

- waren

- Was

- wann

- welche

- WHO

- ganze

- deren

- werden wir

- WISE

- mit

- Arbeiten

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- Falsch

- U

- Zephyrnet