1Abteilung für Mathematik und Informatik, Argonne National Laboratory, 9700 S. Cass Ave., Lemont, IL 60439

2Edward P. Fitts Institut für Industrie- und Systemtechnik, North Carolina State University, 915 Partners Way, Raleigh, NC 27601

3HRL Laboratories, LLC, 3011 Malibu Canyon Road, Malibu, CA 90265

Findest du dieses Paper interessant oder möchtest du darüber diskutieren? Scite oder hinterlasse einen Kommentar zu SciRate.

Abstrakt

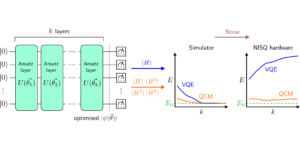

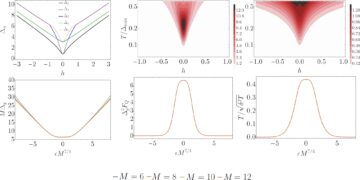

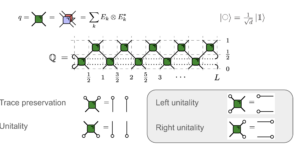

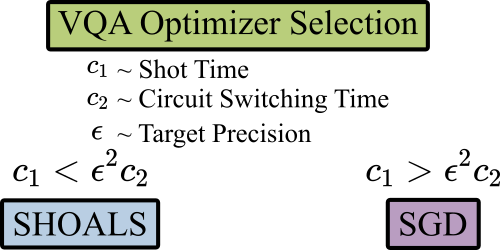

Variationelle Quantenalgorithmen, die in der verrauschten Quantenumgebung im mittleren Maßstab an Bedeutung gewonnen haben, erfordern die Implementierung eines stochastischen Optimierers auf klassischer Hardware. Bis heute hat die meiste Forschung Algorithmen verwendet, die auf der stochastischen Gradienteniteration als dem stochastischen klassischen Optimierer basieren. In dieser Arbeit schlagen wir stattdessen vor, stochastische Optimierungsalgorithmen zu verwenden, die stochastische Prozesse liefern, die die Dynamik klassischer deterministischer Algorithmen emulieren. Dieser Ansatz führt zu Verfahren mit theoretisch überlegener Worst-Case-Iterationskomplexität auf Kosten größerer Stichproben(Schuss)-Komplexitäten pro Iteration. Wir untersuchen diesen Kompromiss sowohl theoretisch als auch empirisch und kommen zu dem Schluss, dass die Präferenzen für die Wahl des stochastischen Optimierers explizit von einer Funktion sowohl der Latenz als auch der Schussausführungszeiten abhängen sollten.

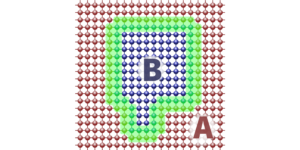

Ausgewähltes Bild: Latenzen und Zielgenauigkeit beeinflussen die Wahl stochastischer Optimierer für Variationsquantenalgorithmen.

Populäre Zusammenfassung

► BibTeX-Daten

► Referenzen

[1] Benjamin P. Lanyon, James D. Whitfield, Geoff G. Gillett, Michael E. Goggin, Marcelo P. Almeida, Ivan Kassal, Jacob D. Biamonte, Masoud Mohseni, Ben J. Powell, Marco Barbieri, et al. „Auf dem Weg zur Quantenchemie auf einem Quantencomputer“. Naturchemie 2, 106–111 (2010).

https: / / doi.org/ 10.1038 / nchem.483

[2] Ian C. Cloët, Matthew R. Dietrich, John Arrington, Alexei Bazavov, Michael Bishof, Adam Freese, Alexey V. Gorshkov, Anna Grassellino, Kawtar Hafidi, Zubin Jacob, et al. „Möglichkeiten für Kernphysik & Quanteninformatik“ (2019). arXiv:1903.05453.

arXiv: 1903.05453

[3] Adam Smith, MS Kim, Frank Pollmann und Johannes Knolle. „Simulation der Quanten-Vielteilchendynamik auf einem aktuellen digitalen Quantencomputer“. npj Quantum Information 5, 1–13 (2019).

https://doi.org/10.1038/s41534-019-0217-0

[4] Benjamin Nachman, Davide Provasoli, Wibe A. de Jong und Christian W. Bauer. „Quantenalgorithmus für Simulationen der Hochenergiephysik“. Physical Review Letters 126, 062001 (2021).

https://doi.org/ 10.1103/PhysRevLett.126.062001

[5] Jacob Biamonte, Peter Wittek, Nicola Pancotti, Patrick Rebentrost, Nathan Wiebe und Seth Lloyd. „Quantenmaschinelles Lernen“. Natur 549, 195–202 (2017).

https: / / doi.org/ 10.1038 / nature23474

[6] Roman Orus, Samuel Mugel und Enrique Lizaso. „Quantencomputing für Finanzen: Überblick und Perspektiven“. Rezensionen in Physik 4, 100028 (2019).

https: // doi.org/ 10.1016 / j.revip.2019.100028

[7] John Preskill. „Quantencomputing in der NISQ-Ära und darüber hinaus“. Quantum 2, 79 (2018).

https://doi.org/10.22331/q-2018-08-06-79

[8] U. Dorner, R. Demkowicz-Dobrzanski, BJ Smith, JS Lundeen, W. Wasilewski, K. Banaszek und IA Walmsley. "Optimale Quantenphasenschätzung". Physical Review Letters 102, 040403 (2009).

https://doi.org/ 10.1103/PhysRevLett.102.040403

[9] John Preskill. „Fehlertolerante Quantencomputing“. In Einführung in die Quantenberechnung und -information. Seiten 213–269. Weltwissenschaftlich (1998).

[10] Marco Cerezo, Andrew Arrasmith, Ryan Babbush, Simon C. Benjamin, Suguru Endo, Keisuke Fujii, Jarrod R. McClean, Kosuke Mitarai, Xiao Yuan, Lukasz Cincio, et al. „Variative Quantenalgorithmen“. Nature Reviews PhysicsSeiten 1–20 (2021).

https://doi.org/10.1038/s42254-021-00348-9

[11] Peter JJ O’Malley, Ryan Babbush, Ian D. Kivlichan, Jonathan Romero, Jarrod R. McClean, Rami Barends, Julian Kelly, Pedram Roushan, Andrew Tranter, Nan Ding, et al. „Skalierbare Quantensimulation molekularer Energien“. Physical Review X 6, 031007 (2016).

https://doi.org/ 10.1103/PhysRevX.6.031007

[12] Xiao Yuan, Suguru Endo, Qi Zhao, Ying Li und Simon C. Benjamin. „Theorie der Variationsquantensimulation“. Quantum 3, 191 (2019).

https://doi.org/10.22331/q-2019-10-07-191

[13] Matthew Otten, Cristian L. Cortes und Stephen K. Gray. „Rauschresistente Quantendynamik mit symmetrieerhaltenden Ansätzen“ (2019). arXiv:1910.06284.

arXiv: 1910.06284

[14] Abhinav Kandala, Antonio Mezzacapo, Kristan Temme, Maika Takita, Markus Brink, Jerry M Chow und Jay M Gambetta. „Hardwareeffizienter Variations-Quanten-Eigenlöser für kleine Moleküle und Quantenmagnete“. Natur 549, 242–246 (2017).

https: / / doi.org/ 10.1038 / nature23879

[15] Kosuke Mitarai, Makoto Negoro, Masahiro Kitagawa und Keisuke Fujii. „Quantenschaltungslernen“. Physical Review A 98, 032309 (2018).

https: / / doi.org/ 10.1103 / PhysRevA.98.032309

[16] Matthew Otten, Imène R. Goumiri, Benjamin W. Priest, George F. Chapline und Michael D. Schneider. „Quantenmaschinelles Lernen unter Verwendung von Gaußschen Prozessen mit performanten Quantenkernen“ (2020). arXiv:2004.11280.

arXiv: 2004.11280

[17] Robert M. Parrish, Edward G. Hohenstein, Peter L. McMahon und Todd J. Martínez. „Quantenberechnung elektronischer Übergänge mit einem Variations-Quanten-Eigenlöser“. Physical Review Letters 122, 230401 (2019).

https://doi.org/ 10.1103/PhysRevLett.122.230401

[18] Kevin J. Sung, Jiahao Yao, Matthew P. Harrigan, Nicholas C. Rubin, Zhang Jiang, Lin Lin, Ryan Babbush und Jarrod R. McClean. „Verwendung von Modellen zur Verbesserung von Optimierern für Variationsquantenalgorithmen“. Quantenwissenschaft und -technologie 5, 044008 (2020).

https://doi.org/10.1088/2058-9565/abb6d9

[19] Jay Gambetta, WA Braff, A. Wallraff, SM Girvin und RJ Schoelkopf. „Protokolle zum optimalen Auslesen von Qubits mittels einer kontinuierlichen Quantenzerstörungsmessung“. Physical Review A 76, 012325 (2007).

https: / / doi.org/ 10.1103 / PhysRevA.76.012325

[20] Susan M. Clark, Daniel Lobser, Melissa C. Revelle, Christopher G. Yale, David Bossert, Ashlyn D. Burch, Matthew N. Chow, Craig W. Hogle, Megan Ivory, Jessica Pehr, et al. „Engineering des Open-User-Testbeds für quantenwissenschaftliches Rechnen“. IEEE Transactions on Quantum Engineering 2, 1–32 (2021).

https: / / doi.org/ 10.1109 / TQE.2021.3096480

[21] Colin D. Bruzewicz, John Chiaverini, Robert McConnell und Jeremy M. Sage. „Quantencomputing mit gefangenen Ionen: Fortschritt und Herausforderungen“. Applied Physics Reviews 6, 021314 (2019).

https: / / doi.org/ 10.1063 / 1.5088164

[22] Jonas M. Kübler, Andrew Arrasmith, Lukasz Cincio und Patrick J. Coles. "Ein adaptiver Optimierer für messungssparsame Variationsalgorithmen". Quantum 4, 263 (2020).

https://doi.org/10.22331/q-2020-05-11-263

[23] Diederik P. Kingma und Jimmy Ba. „Adam: Eine Methode zur stochastischen Optimierung“ (2014). arXiv:1412.6980.

arXiv: 1412.6980

[24] Trygve Helgaker, Poul Jorgensen und Jeppe Olsen. „Molekulare elektronische Strukturtheorie“. John Wiley & Söhne. (2014).

https: / / doi.org/ 10.1002 / 9781119019572

[25] Tom Schaul, Ioannis Antonoglou und David Silver. „Einheitentests zur stochastischen Optimierung“. In Yoshua Bengio und Yann LeCun, Herausgeber, 2nd International Conference on Learning Representations, ICLR 2014, Banff, AB, Kanada, 14.-16. April 2014, Conference Track Proceedings. (2014). URL: http:///arxiv.org/abs/1312.6055.

arXiv: 1312.6055

[26] Hilal Asi und John C. Duchi. „Die Bedeutung besserer Modelle in der stochastischen Optimierung“. Proceedings of the National Academy of Sciences 116, 22924–22930 (2019).

https: / / doi.org/ 10.1073 / pnas.1908018116

[27] Billy Jin, Katya Scheinberg und Miaolan Xie. „Komplexitätsgrenzen mit hoher Wahrscheinlichkeit für die Liniensuche basierend auf stochastischen Orakeln“ (2021). arXiv:2106.06454.

arXiv: 2106.06454

[28] Jose Blanchet, Coralia Cartis, Matt Menickelly und Katya Scheinberg. "Konvergenzratenanalyse einer stochastischen Trust-Region-Methode über Supermartingale". INFORMS Journal on Optimization 1, 92–119 (2019).

https:///doi.org/10.1287/ijoo.2019.0016

[29] Courtney Paquette und Katya Scheinberg. "Ein stochastisches Liniensuchverfahren mit erwarteter Komplexitätsanalyse". SIAM Journal on Optimization 30, 349–376 (2020).

https: / / doi.org/ 10.1137 / 18M1216250

[30] Albert S. Berahas, Liyuan Cao und Katya Scheinberg. "Globale Konvergenzratenanalyse eines generischen Liniensuchalgorithmus mit Rauschen". SIAM Journal on Optimization 31, 1489–1518 (2021).

https: / / doi.org/ 10.1137 / 19M1291832

[31] Coralia Cartis, Nicholas IM Gould und Ph. L. Toint. "Über die Komplexität des steilsten Abstiegs, Newtons und regularisierte Newtons Methoden für nichtkonvexe, uneingeschränkte Optimierungsprobleme". Siam Journal on Optimization 20, 2833–2852 (2010).

https: / / doi.org/ 10.1137 / 090774100

[32] Coralia Cartis, Nicholas IM Gould und Philippe L. Toint. "Über die Orakelkomplexität von Algorithmen erster Ordnung und ableitungsfreier Algorithmen zur glatten nichtkonvexen Minimierung". SIAM Journal on Optimization 22, 66–86 (2012).

https: / / doi.org/ 10.1137 / 100812276

[33] Yair Carmon, John C. Duchi, Oliver Hinder und Aaron Sidford. „Untere Schranken zum Finden stationärer Punkte I“. Mathematische Programmierung 184, 71–120 (2020).

https: / / doi.org/ 10.1007 / s10107-019-01406-y

[34] Yair Carmon, John C. Duchi, Oliver Hinder und Aaron Sidford. „„konvex bis zum Beweis der Schuld“: Dimensionsfreie Beschleunigung des Gradientenabstiegs bei nicht-konvexen Funktionen“. In der Internationalen Konferenz für maschinelles Lernen. Seiten 654–663. PMLR (2017).

https: / / doi.org/ 10.5555 / 3305381.3305449

[35] Chi Jin, Praneeth Netrapalli und Michael I. Jordan. „Beschleunigter Gradientenabstieg entkommt Sattelpunkten schneller als Gradientenabstieg“. In Konferenz über Lerntheorie. Seiten 1042–1085. PMLR (2018). URL: https:///proceedings.mlr.press/v75/jin18a.html.

https:///proceedings.mlr.press/v75/jin18a.html

[36] Saeed Ghadimi und Guanghui Lan. "Stochastische Methoden erster und nullter Ordnung für nichtkonvexe stochastische Programmierung". SIAM Journal on Optimization 23, 2341–2368 (2013).

https: / / doi.org/ 10.1137 / 120880811

[37] Yossi Arjevani, Yair Carmon, John C. Duchi, Dylan J. Foster, Nathan Srebro und Blake Woodworth. „Untere Schranken für nicht-konvexe stochastische Optimierung“ (2019). arXiv:1912.02365.

arXiv: 1912.02365

[38] Cong Fang, Chris Junchi Li, Zhouchen Lin und Tong Zhang. "Spider: Nahezu optimale nicht-konvexe Optimierung über stochastischen pfadintegrierten Differentialschätzer". In S. Bengio, H. Wallach, H. Larochelle, K. Grauman, N. Cesa-Bianchi und R. Garnett, Herausgeber, Advances in Neural Information Processing Systems. Band 31. Curran Associates, Inc. (2018). URL: https:///proceedings.neurips.cc/paper/2018/file/1543843a4723ed2ab08e18053ae6dc5b-Paper.pdf.

https://proceedings.neurips.cc/paper/2018/file/1543843a4723ed2ab08e18053ae6dc5b-Paper.pdf

[39] Shiro Tamiya und Hayata Yamasaki. „Stochastic Gradient Line Bayesian Optimization: Reduzieren von Messschüssen bei der Optimierung parametrisierter Quantenschaltkreise“ (2021). arXiv:2111.07952.

https://doi.org/10.1038/s41534-022-00592-6

arXiv: 2111.07952

[40] Pascual Jordan und Eugene Paul Wigner. „über das paulische Äquivalenzverbot“. In den Gesammelten Werken von Eugene Paul Wigner. Seiten 109–129. Springer (1993).

[41] Maria Schuld, Ville Bergholm, Christian Gogolin, Josh Izaac und Nathan Killoran. „Auswertung analytischer Gradienten auf Quantenhardware“. Physical Review A 99, 032331 (2019).

https: / / doi.org/ 10.1103 / PhysRevA.99.032331

[42] Joonho Lee, William J. Huggins, Martin Head-Gordon und K. Birgitta Whaley. "Verallgemeinerte unitär gekoppelte Clusterwellenfunktionen für die Quantenberechnung". Journal of Chemical Theory and Computation 15, 311–324 (2018).

https: / / doi.org/ 10.1021 / acs.jctc.8b01004

[43] Alberto Peruzzo, Jarrod McClean, Peter Shadbolt, Man-Hong Yung, Xiao-Qi Zhou, Peter J Love, Alán Aspuru-Guzik und Jeremy L O’brien. "Ein Variationseigenwertlöser auf einem photonischen Quantenprozessor". Nature Communications 5, 1–7 (2014). URL: https:///doi.org/10.1038/ncomms5213.

https: / / doi.org/ 10.1038 / ncomms5213

[44] Ilya G. Ryabinkin, Tzu-Ching Yen, Scott N. Genin und Artur F. Izmaylov. „Qubit-gekoppelte Cluster-Methode: ein systematischer Ansatz zur Quantenchemie auf einem Quantencomputer“. Zeitschrift für chemische Theorie und Berechnung 14, 6317–6326 (2018).

https: / / doi.org/ 10.1021 / acs.jctc.8b00932

[45] Ho Lun Tang, VO Shkolnikov, George S. Barron, Harper R. Grimsley, Nicholas J. Mayhall, Edwin Barnes und Sophia E. Economou. „qubit-ADAPT-VQE: Ein adaptiver Algorithmus zur Konstruktion hardwareeffizienter Ansätze auf einem Quantenprozessor“. PRX Quantum 2, 020310 (2021).

https: / / doi.org/ 10.1103 / PRXQuantum.2.020310

[46] Dmitry A. Fedorov, Yuri Alexeev, Stephen K. Gray und Matthew Otten. „Unitary Selective Coupled-Cluster-Methode“. Quantum 6, 703 (2022).

https://doi.org/10.22331/q-2022-05-02-703

[47] Pranav Gokhale, Olivia Angiuli, Yongshan Ding, Kaiwen Gui, Teague Tomesh, Martin Suchara, Margaret Martonosi und Frederic T Chong. „$ o (n^3) $ Messkosten für Variations-Quanten-Eigenlöser auf molekularen Hamiltonianern“. IEEE Transactions on Quantum Engineering 1, 1–24 (2020).

https: / / doi.org/ 10.1109 / TQE.2020.3035814

[48] Ruobing Chen, Matt Menickelly und Katya Scheinberg. "Stochastische Optimierung mit einer Trust-Region-Methode und Zufallsmodellen". Mathematische Programmierung 169, 447–487 (2018).

https://doi.org/10.1007/s10107-017-1141-8

[49] Léon Bottou, Frank E. Curtis und Jorge Nocedal. „Optimierungsmethoden für maschinelles Lernen im großen Maßstab“. Siam Review 60, 223–311 (2018).

https: / / doi.org/ 10.1137 / 16M1080173

[50] Yoel Drori und Ohad Shamir. "Die Komplexität des Auffindens stationärer Punkte mit stochastischem Gradientenabstieg". In der Internationalen Konferenz für maschinelles Lernen. Seiten 2658–2667. PMLR (2020). URL: https:///proceedings.mlr.press/v119/drori20a.html.

https:///proceedings.mlr.press/v119/drori20a.html

[51] Cong Fang, Zhouchen Lin und Tong Zhang. "Scharfe Analyse für nichtkonvexe SGD, die aus Sattelpunkten entweicht". In Konferenz über Lerntheorie. Seiten 1192–1234. PMLR (2019). URL: https://proceedings.mlr.press/v99/fang19a.html.

https:///proceedings.mlr.press/v99/fang19a.html

[52] S Reddi, Manzil Zaheer, Devendra Sachan, Satyen Kale und Sanjiv Kumar. "Adaptive Methoden zur nichtkonvexen Optimierung". In Proceedings of 32nd Conference on Neural Information Processing Systems (NIPS 2018). (2018). URL: https:///proceedings.neurips.cc/paper/2018/file/90365351ccc7437a1309dc64e4db32a3-Paper.pdf.

https://proceedings.neurips.cc/paper/2018/file/90365351ccc7437a1309dc64e4db32a3-Paper.pdf

[53] Léon Bottou und Olivier Bousquet. "Die Kompromisse des Lernens im großen Maßstab". In J. Platt, D. Koller, Y. Singer und S. Roweis, Herausgeber, Advances in Neural Information Processing Systems. Band 20. Curran Associates, Inc. (2007). URL: https:///proceedings.neurips.cc/paper/2007/file/0d3180d672e08b4c5312dcdafdf6ef36-Paper.pdf.

https://proceedings.neurips.cc/paper/2007/file/0d3180d672e08b4c5312dcdafdf6ef36-Paper.pdf

[54] Peter J. Karalekas, Nikolas A. Tezak, Eric C. Peterson, Colm A. Ryan, Marcus P. da Silva und Robert S. Smith. „Eine quantenklassische Cloud-Plattform, optimiert für Variations-Hybrid-Algorithmen“. Quantenwissenschaft und -technologie 5, 024003 (2020).

https: / / doi.org/ 10.1088 / 2058-9565 / ab7559

[55] HJ Briegel, Tommaso Calarco, Dieter Jaksch, Juan Ignacio Cirac und Peter Zoller. „Quantencomputing mit neutralen Atomen“. Zeitschrift für moderne Optik 47, 415–451 (2000).

https: / / doi.org/ 10.1080 / 09500340008244052

[56] Sergey Bravyi, Jay M. Gambetta, Antonio Mezzacapo und Kristan Temme. „Tapering off qubits to simulieren fermionische Hamiltonianer“ (2017). arXiv:1701.08213.

arXiv: 1701.08213

[57] MD SAJID ANIS, Héctor Abraham, AduOffei, Rochisha Agarwal, Gabriele Agliardi, Merav Aharoni, Ismail Yunus Akhalwaya, Gadi Aleksandrowicz, Thomas Alexander, Matthew Amy, Sashwat Anagolum, Eli Arbel, Abraham Asfaw, Anish Athalye, Artur Avkhadiev, et al. „Qiskit: Ein Open-Source-Framework für Quantencomputer“ (2021).

[58] Ciyou Zhu, Richard H. Byrd, Peihuang Lu und Jorge Nocedal. "Algorithmus 778: L-BFGS-B: Fortran-Unterroutinen für groß angelegte Optimierung mit Begrenzungsbeschränkungen". ACM Transactions on Mathematical Software (TOMS) 23, 550–560 (1997).

https: / / doi.org/ 10.1145 / 279232.279236

[59] Raghu Bollapragada, Richard Byrd und Jorge Nocedal. „Adaptive Abtaststrategien für die stochastische Optimierung“. SIAM Journal on Optimization 28, 3312–3343 (2018).

https: / / doi.org/ 10.1137 / 17M1154679

[60] Raghu Bollapragada, Jorge Nocedal, Dheevatsa Mudigere, Hao-Jun Shi und Ping Tak Peter Tang. "Eine progressive Batching-L-BFGS-Methode für maschinelles Lernen". In der Internationalen Konferenz für maschinelles Lernen. Seiten 620–629. PMLR (2018). URL: https:///proceedings.mlr.press/v80/bollapragada18a.html.

https:///proceedings.mlr.press/v80/bollapragada18a.html

[61] Raghu Pasupathy, Peter Glynn, Soumyadip Ghosh und Fatemeh S Hashemi. „Über Abtastraten in simulationsbasierten Rekursionen“. SIAM Journal on Optimization 28, 45–73 (2018).

https: / / doi.org/ 10.1137 / 140951679

[62] Andrew Arrasmith, Lukasz Cincio, Rolando D. Somma und Patrick J. Coles. „Operator-Sampling für Shot-Frugal-Optimierung in Variationsalgorithmen“ (2020). arXiv:2004.06252.

arXiv: 2004.06252

[63] Yangyang Xu und Wotao Yin. „Blockstochastische Gradienteniteration für konvexe und nichtkonvexe Optimierung“. SIAM Journal on Optimization 25, 1686–1716 (2015).

https: / / doi.org/ 10.1137 / 140983938

Zitiert von

[1] Matt Menickelly, Stefan M. Wild und Miaolan Xie, „Eine stochastische Quasi-Newton-Methode in Abwesenheit gemeinsamer Zufallszahlen“, arXiv: 2302.09128, (2023).

[2] Kosuke Ito, „Latenzbewusste adaptive Schusszuordnung für laufzeiteffiziente Variationsquantenalgorithmen“, arXiv: 2302.04422, (2023).

Die obigen Zitate stammen von SAO / NASA ADS (Zuletzt erfolgreich aktualisiert am 2023, 03:16:18 Uhr). Die Liste ist möglicherweise unvollständig, da nicht alle Verlage geeignete und vollständige Zitationsdaten bereitstellen.

Konnte nicht abrufen Crossref zitiert von Daten während des letzten Versuchs 2023-03-16 18:30:43: Von Crossref konnten keine zitierten Daten für 10.22331 / q-2023-03-16-949 abgerufen werden. Dies ist normal, wenn der DOI kürzlich registriert wurde.

Dieses Papier ist in Quantum unter dem veröffentlicht Creative Commons Namensnennung 4.0 International (CC BY 4.0) Lizenz. Das Copyright verbleibt bei den ursprünglichen Copyright-Inhabern wie den Autoren oder deren Institutionen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- Platoblockkette. Web3-Metaverse-Intelligenz. Wissen verstärkt. Hier zugreifen.

- Quelle: https://quantum-journal.org/papers/q-2023-03-16-949/

- :Ist

- ][P

- 1

- 10

- 102

- 11

- 116

- 1998

- 2012

- 2014

- 2016

- 2017

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 28

- 39

- 7

- 8

- 9

- 98

- a

- Heinz

- oben

- ABSTRACT

- Academy

- Beschleunigung

- Zugang

- ACM

- Marcus

- Adam Smith

- Anpassungen

- Vorschüsse

- beeinflussen

- Zugehörigkeiten

- AL

- Udo

- Algorithmus

- Algorithmen

- Alle

- Zuteilung

- Analyse

- Analytisch

- machen

- Martin

- anna

- angewandt

- Ansatz

- April

- SIND

- Argonne National Laboratory

- AS

- Annahme

- At

- Autor

- Autoren

- basierend

- Bayesianisch

- BE

- Christoph

- Besser

- zwischen

- Beyond

- Break

- Rand

- by

- CA

- namens

- CAN

- Kanada

- Kandidaten

- Cass

- Herausforderungen

- chemisch

- Chemie

- chen

- Wahl

- Chris

- Friedrich

- Cloud

- Cloud-Plattform

- Cluster

- Kommentar

- gemeinsam

- Unterhaus

- Kommunikation

- vergleichbar

- abschließen

- Komplexität

- Komplexität

- Berechnung

- Computer

- Computerwissenschaften

- Computer

- Computing

- Schluss

- Konferenz

- Überlegungen

- Berücksichtigung

- Bau

- kontinuierlich

- Gegenteil

- Konvergenz

- konvex

- Urheberrecht

- Kosten

- könnte

- gekoppelt

- Craig

- Strom

- DA

- Matthias

- technische Daten

- Datum

- Christian

- David Silber

- zeigen

- Es

- Abteilung

- entworfen

- digital

- diskutieren

- Division

- im

- Dynamik

- e

- Ludwig

- Edwin

- Effizienz

- effizient

- elektronisch

- Energie

- Entwicklung

- Era

- Äther (ETH)

- Ausführung

- erwartet

- teuer

- beschleunigt

- Finanzen

- Suche nach

- Aussichten für

- Fördern

- gefunden

- Unser Ansatz

- für

- Funktion

- Funktionen

- Michael

- Steigungen

- grau

- mehr

- Hardware

- Harvard

- Haben

- hier

- High

- behindern

- Inhaber

- aber

- HTML

- http

- HTTPS

- Hybrid

- i

- ia

- ICLR

- IEEE

- Image

- Implementierung

- Bedeutung

- zu unterstützen,

- in

- Inc.

- industriell

- Information

- beantragen müssen

- Institutionen

- interessant

- International

- Einleitung

- untersuchen

- Iteration

- JavaScript

- Peter

- Jordanien

- Zeitschrift

- Kim

- Labor

- grosse

- großflächig

- Nachname

- Latency

- lernen

- Verlassen

- Lee

- Lizenz

- Line

- Liste

- LLC

- ich liebe

- Maschine

- Maschinelles Lernen

- Magnete

- Marco

- Rainer

- Martin

- mathematisch

- max-width

- Messungen

- Megan

- Methode

- Methoden

- Michael

- Minimierung

- für

- modern

- Molekular-

- Monat

- mehr

- effizienter

- vor allem warme

- MS

- National

- Natur

- Bedürfnisse

- Neural

- NeuroIPS

- Neutral

- Neu

- Newton

- Lärm

- normal

- Norden

- Nord-Carolina

- Kernenergie

- Kernphysik

- Zahlen

- of

- Olive

- on

- XNUMXh geöffnet

- Open-Source-

- Optik

- optimal

- Optimierung

- optimiert

- Optimierung

- Orakel

- Orakel

- Original

- Andere

- Übertrifft

- Überblick

- Papier

- Parameter

- Alexander

- ausführen

- Durchführung

- Jürgen

- Peterson

- Phase

- Philippe

- physikalisch

- Physik

- Klingeln

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- Punkte

- Powell

- Praktisch

- Präzision

- Vorlieben

- Wahrscheinlichkeit

- Probleme

- Verfahren

- Prozessdefinierung

- anpassen

- Verarbeitung

- Prozessor

- Programmierung

- Fortschritt

- fortschrittlich

- Bedeutung

- aussichtsreich

- bietet

- Chancen

- zuverlässig

- die

- veröffentlicht

- Herausgeber

- Verlag

- Qi

- Qiskit

- Quant

- Quantenalgorithmen

- Quantencomputer

- Quantencomputer

- Quantencomputing

- Quanteninformation

- Qubits

- Raleigh

- ROMME

- zufällig

- Bewerten

- Honorar

- kürzlich

- Reduziert

- Reduzierung

- Referenzen

- eingetragen

- bleibt bestehen

- wiederholt

- erfordern

- Forschungsprojekte

- Die Ergebnisse

- Überprüfen

- Bewertungen

- Daniel

- Auferstanden

- Straße

- ROBERT

- Führen Sie

- Lutz

- s

- Skalieren

- Wissenschaft

- Wissenschaft und Technologie

- WISSENSCHAFTEN

- Suche

- selektiv

- Einstellung

- SGD

- sollte

- erklären

- siam

- bedeutend

- Silbermedaille

- Bernd

- Simulation

- Sänger

- klein

- Software

- Auflösung

- verbrachte

- Bundesstaat

- Johannes

- Sturm

- Strategien

- Erfolgreich

- so

- geeignet

- Oberteil

- Susan

- Systeme und Techniken

- Target

- Technologie

- Tests

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Diese

- Zeit

- mal

- Titel

- zu

- Gesamt

- verfolgen sind

- Transaktionen

- Übergänge

- für

- Universität

- aktualisiert

- URL

- Mitglied

- Volumen

- W

- Wave

- Weg..

- welche

- Wild

- mit

- Arbeiten

- Werk

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- X

- Jahr

- Yen

- Ausbeute

- JING

- Yuan

- Zephyrnet

- Zhao