1Fachbereich Physik, University of Waterloo, Waterloo, ON, N2L 3G1, Kanada

2Institut für Quantencomputing, Waterloo, ON, N2L 3G1, Kanada

3Perimeter-Institut für Theoretische Physik, Waterloo, Ontario, N2L 2Y5, Kanada

4Xanadu, Toronto, ON, M5G 2C8, Kanada

Findest du dieses Paper interessant oder möchtest du darüber diskutieren? Scite oder hinterlasse einen Kommentar zu SciRate.

Abstrakt

Der weit verbreitete Erfolg tiefer neuronaler Netze hat eine Überraschung im klassischen maschinellen Lernen offenbart: Sehr komplexe Modelle lassen sich oft gut verallgemeinern, während gleichzeitig Trainingsdaten überpasst werden. Dieses Phänomen der harmlosen Überanpassung wurde für verschiedene klassische Modelle untersucht, mit dem Ziel, die Mechanismen hinter Deep Learning besser zu verstehen. Die Charakterisierung des Phänomens im Kontext des quantenmaschinellen Lernens könnte in ähnlicher Weise unser Verständnis der Beziehung zwischen Überanpassung, Überparametrisierung und Generalisierung verbessern. In dieser Arbeit liefern wir eine Charakterisierung der gutartigen Überanpassung in Quantenmodellen. Dazu leiten wir das Verhalten eines klassischen interpolierenden Fourier-Merkmalsmodells für die Regression bei verrauschten Signalen ab und zeigen, wie eine Klasse von Quantenmodellen analoge Merkmale aufweist und dadurch die Struktur von Quantenschaltkreisen (wie Datenkodierung und Zustandsvorbereitungsoperationen) verknüpft ) zu Überparametrisierung und Überanpassung in Quantenmodellen. Wir erklären diese Merkmale intuitiv anhand der Fähigkeit des Quantenmodells, verrauschte Daten mit lokal „spitzenartigem“ Verhalten zu interpolieren, und liefern ein konkretes Demonstrationsbeispiel für eine harmlose Überanpassung.

► BibTeX-Daten

► Referenzen

[1] Michael A. Nielsen. „Neuronale Netze und Deep Learning“. Bestimmungspresse. (2015). URL: http://neuralnetworksanddeeplearning.com/.

http:///neuralnetworksanddeeplearning.com/

[2] Stuart Geman, Elie Bienenstock und René Doursat. „Neuronale Netze und das Bias/Varianz-Dilemma“. Neuronale Berechnung. 4, 1–58 (1992).

https: / / doi.org/ 10.1162 / neco.1992.4.1.1

[3] Trevor Hastie, Robert Tibshirani, Jerome H. Friedman und Jerome H. Friedman. „Die Elemente des statistischen Lernens: Data Mining, Inferenz und Vorhersage“. Band 2. Springer. (2009).

https://doi.org/10.1007/978-0-387-84858-7

[4] Peter L. Bartlett, Andrea Montanari und Alexander Rakhlin. „Deep Learning: eine statistische Sichtweise“. Acta Numerica 30, 87–201 (2021).

https: / / doi.org/ 10.1017 / S0962492921000027

[5] Michail Belkin. „Fit ohne Angst: bemerkenswerte mathematische Phänomene des Deep Learning durch das Prisma der Interpolation“. Acta Numerica 30, 203–248 (2021).

[6] Peter L. Bartlett, Philip M. Long, Gábor Lugosi und Alexander Tsigler. „Gutartige Überanpassung in der linearen Regression“. Proz. Natl. Acad. Wissenschaft. 117, 30063–30070 (2020).

https: / / doi.org/ 10.1073 / pnas.1907378117

[7] Mikhail Belkin, Daniel Hsu, Siyuan Ma und Soumik Mandal. „Versöhnung moderner maschineller Lernpraxis und des klassischen Bias-Varianz-Kompromisses“. Proz. Natl. Acad. Wissenschaft. 116, 15849–15854 (2019).

https: / / doi.org/ 10.1073 / pnas.1903070116

[8] Mikhail Belkin, Alexander Rakhlin und Alexandre B. Tsybakov. „Steht die Dateninterpolation im Widerspruch zur statistischen Optimalität?“ In Proceedings of Machine Learning Research. Band 89, Seiten 1611–1619. PMLR (2019). URL: https:///proceedings.mlr.press/v89/belkin19a.html.

https:///proceedings.mlr.press/v89/belkin19a.html

[9] Vidya Muthukumar, Kailas Vodrahalli, Vignesh Subramanian und Anant Sahai. „Harmlose Interpolation verrauschter Daten in der Regression“. IEEE Journal on Selected Areas in Information Theory 1, 67–83 (2020).

https: / / doi.org/ 10.1109 / ISIT.2019.8849614

[10] Vidya Muthukumar, Adhyyan Narang, Vignesh Subramanian, Mikhail Belkin, Daniel Hsu und Anant Sahai. „Klassifizierung vs. Regression in überparametrisierten Regimen: Spielt die Verlustfunktion eine Rolle?“ J. Mach. Lernen. Res. 22, 1–69 (2021). URL: http:///jmlr.org/papers/v22/20-603.html.

http: // jmlr.org/ papers / v22 / 20-603.html

[11] Yehuda Dar, Vidya Muthukumar und Richard G. Baraniuk. „Ein Abschied vom Bias-Varianz-Kompromiss? ein Überblick über die Theorie des überparametrisierten maschinellen Lernens“ (2021). arXiv:2109.02355.

arXiv: 2109.02355

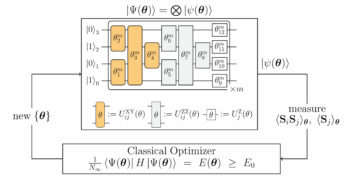

[12] Marcello Benedetti, Erika Lloyd, Stefan Sack und Mattia Fiorentini. „Parametrisierte Quantenschaltungen als Modelle für maschinelles Lernen“. Quantenwissenschaft. Technol. 4, 043001 (2019).

https://doi.org/10.1088/2058-9565/ab4eb5

[13] K. Mitarai, M. Negoro, M. Kitagawa und K. Fujii. „Quantenschaltungslernen“. Phys. Rev. A 98, 032309 (2018).

https: / / doi.org/ 10.1103 / physreva.98.032309

[14] Maria Schuld, Ville Bergholm, Christian Gogolin, Josh Izaac und Nathan Killoran. „Auswertung analytischer Gradienten auf Quantenhardware“. Phys. Rev. A 99, 032331 (2019).

https: / / doi.org/ 10.1103 / physreva.99.032331

[15] Maria Schuld und Nathan Killoran. „Quantenmaschinelles Lernen in Feature-Hilbert-Räumen“. Phys. Rev. Lett. 122, 040504 (2019).

https://doi.org/ 10.1103/physrevlett.122.040504

[16] Vojtěch Havlíček, Antonio D. Córcoles, Kristan Temme, Aram W. Harrow, Abhinav Kandala, Jerry M. Chow und Jay M. Gambetta. „Überwachtes Lernen mit quantenverstärkten Merkmalsräumen“. Natur 567, 209–212 (2019).

https://doi.org/10.1038/s41586-019-0980-2

[17] Seth Lloyd und Christian Weedbrook. „Quantengeneratives kontradiktorisches Lernen“. Physik. Rev. Lett. 121, 040502 (2018).

https://doi.org/ 10.1103/physrevlett.121.040502

[18] Pierre-Luc Dallaire-Demers und Nathan Killoran. „Quantengenerative gegnerische Netzwerke“. Physik. Rev. A 98, 012324 (2018).

https: / / doi.org/ 10.1103 / physreva.98.012324

[19] Amira Abbas, David Sutter, Christa Zoufal, Aurelien Lucchi, Alessio Figalli und Stefan Woerner. „Die Kraft quantenneuronaler Netze“. Nat. Berechnen. Wissenschaft. 1, 403–409 (2021).

https://doi.org/10.1038/s43588-021-00084-1

[20] Logan G. Wright und Peter L. McMahon. „Die Kapazität quantenneuronaler Netze“. Im Jahr 2020 Konferenz über Laser und Elektrooptik (CLEO). Seiten 1–2. (2020). URL: https:///ieeexplore.ieee.org/document/9193529.

https: / / ieeexplore.ieee.org/ document / 9193529

[21] Sukin Sim, Peter D. Johnson und Alán Aspuru-Guzik. „Expressibilität und Verschränkungsfähigkeit parametrisierter Quantenschaltungen für hybride quantenklassische Algorithmen“. Adv. Quantentechnologie. 2, 1900070 (2019).

https: / / doi.org/ 10.1002 / qute.201900070

[22] Thomas Hubregtsen, Josef Pichlmeier, Patrick Stecher und Koen Bertels. „Bewertung parametrisierter Quantenschaltkreise: zum Zusammenhang zwischen Klassifizierungsgenauigkeit, Ausdrückbarkeit und Verschränkungsfähigkeit“. Quantenmach. Intel. 3, 1 (2021).

https: / / doi.org/ 10.1007 / s42484-021-00038-w

[23] Jarrod R. McClean, Sergio Boixo, Vadim N. Smelyanskiy, Ryan Babbush und Hartmut Neven. „Unfruchtbare Hochebenen in Trainingslandschaften für Quanten-Neuronale Netze“. Nat. Komm. 9, 4812 (2018).

https://doi.org/10.1038/s41467-018-07090-4

[24] Marco Cerezo, Akira Sone, Tyler Volkoff, Lukasz Cincio und Patrick J Coles. „Kostenfunktionsabhängige unfruchtbare Plateaus in flachen parametrisierten Quantenschaltkreisen“. Nat. Komm. 12, 1791 (2021).

https: / / doi.org/ 10.1038 / s41467-021-21728-w

[25] Matthias C. Caro, Elies Gil-Fuster, Johannes Jakob Meyer, Jens Eisert und Ryan Sweke. „Kodierungsabhängige Generalisierungsgrenzen für parametrisierte Quantenschaltungen“. Quantum 5, 582 (2021).

https://doi.org/10.22331/q-2021-11-17-582

[26] Hsin-Yuan Huang, Michael Broughton, Masoud Mohseni, Ryan Babbush, Sergio Boixo, Hartmut Neven und Jarrod R McClean. „Macht der Daten beim Quantenmaschinellen Lernen“. Nat. Komm. 12, 2631 (2021).

https://doi.org/10.1038/s41467-021-22539-9

[27] Matthias C. Caro, Hsin-Yuan Huang, M. Cerezo, Kunal Sharma, Andrew Sornborger, Lukasz Cincio und Patrick J. Coles. „Verallgemeinerung beim quantenmaschinellen Lernen aus wenigen Trainingsdaten“. Nat. Komm. 13, 4919 (2022).

https://doi.org/10.1038/s41467-022-32550-3

[28] Leonardo Banchi, Jason Pereira und Stefano Pirandola. „Verallgemeinerung im quantenmaschinellen Lernen: Ein Standpunkt der Quanteninformation“. PRX Quantum 2, 040321 (2021).

https: / / doi.org/ 10.1103 / PRXQuantum.2.040321

[29] Francisco Javier Gil Vidal und Dirk Oliver Theis. „Eingaberedundanz für parametrisierte Quantenschaltungen“. Vorderseite. Physik. 8, 297 (2020).

https: / / doi.org/ 10.3389 / fphy.2020.00297

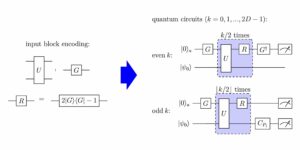

[30] Maria Schuld, Ryan Sweke und Johannes Jakob Meyer. „Auswirkung der Datenkodierung auf die Ausdruckskraft von Variationsmodellen des quantenmaschinellen Lernens“. Physik. Rev. A 103, 032430 (2021).

https: / / doi.org/ 10.1103 / physreva.103.032430

[31] David Wierichs, Josh Izaac, Cody Wang und Cedric Yen-Yu Lin. „Allgemeine Parameterverschiebungsregeln für Quantengradienten“. Quantum 6, 677 (2022).

https://doi.org/10.22331/q-2022-03-30-677

[32] Kendall E. Atkinson. „Eine Einführung in die numerische Analysis“. John Wiley & Söhne. (2008).

[33] Ali Rahimi und Benjamin Recht. „Zufällige Funktionen für große Kernelmaschinen“. In Fortschritte in neuronalen Informationsverarbeitungssystemen. Band 20. (2007). URL: https:///papers.nips.cc/paper_files/paper/2007/hash/013a006f03dbc5392effeb8f18fda755-Abstract.html.

https://papers.nips.cc/paper_files/paper/2007/hash/013a006f03dbc5392effeb8f18fda755-Abstract.html

[34] Walter Rudin. „Die Grundsätze der Fourier-Analyse“. John Wiley & Sons, Ltd. (1990).

https: / / doi.org/ 10.1002 / 9781118165621.ch1

[35] Song Mei und Andrea Montanari. „Der Generalisierungsfehler der Regression zufälliger Merkmale: Präzise Asymptotik und die doppelte Abstiegskurve“. Komm. Reine Appl. Mathematik. 75, 667–766 (2022).

https: / / doi.org/ 10.1002 / cpa.22008

[36] Trevor Hastie, Andrea Montanari, Saharon Rosset und Ryan J. Tibshirani. „Überraschungen bei der hochdimensionalen gratlosen Kleinste-Quadrate-Interpolation“. Ann. Stat. 50, 949 – 986 (2022).

https: / / doi.org/ 10.1214 / 21-AOS2133

[37] Tengyuan Liang, Alexander Rakhlin und Xiyu Zhai. „Über den mehrfachen Abstieg von Interpolanten mit minimaler Norm und eingeschränkter unterer Isometrie von Kerneln“. In Proceedings of Machine Learning Research. Band 125, Seiten 1–29. PMLR (2020). URL: http:///proceedings.mlr.press/v125/liang20a.html.

http:///proceedings.mlr.press/v125/liang20a.html

[38] Edward Farhi und Hartmut Neven. „Klassifizierung mit quantenneuronalen Netzen auf Nahzeitprozessoren“ (2018). arXiv:1802.06002.

arXiv: 1802.06002

[39] Maria Schuld, Alex Bocharov, Krysta M. Svore und Nathan Wiebe. „Schaltkreiszentrierte Quantenklassifikatoren“. Physik. Rev. A 101, 032308 (2020).

https: / / doi.org/ 10.1103 / physreva.101.032308

[40] Adrián Pérez-Salinas, Alba Cervera-Lierta, Elies Gil-Fuster und José I. Latorre. „Erneutes Hochladen von Daten für einen universellen Quantenklassifikator“. Quantum 4, 226 (2020).

https://doi.org/10.22331/q-2020-02-06-226

[41] Sofiene Jerbi, Lukas J Fiderer, Hendrik Poulsen Nautrup, Jonas M Kübler, Hans J Briegel und Vedran Dunjko. „Quantenmaschinelles Lernen jenseits von Kernel-Methoden“. Nat. Komm. 14, 517 (2023).

https: / / doi.org/ 10.1038 / s41467-023-36159-y

[42] Casper Gyurik, Dyon Vreumingen, van und Vedran Dunjko. „Strukturelle Risikominimierung für quantenlineare Klassifikatoren“. Quantum 7, 893 (2023).

https://doi.org/10.22331/q-2023-01-13-893

[43] Maria Schuld. „Überwachte quantenmechanische Lernmodelle sind Kernel-Methoden“ (2021). arXiv:2101.11020.

arXiv: 2101.11020

[44] S. Shin, Y. S. Teo und H. Jeong. „Exponentielle Datenkodierung für quantenüberwachtes Lernen“. Physik. Rev. A 107, 012422 (2023).

https: / / doi.org/ 10.1103 / PhysRevA.107.012422

[45] Sophie Piccard. „Sur les ensembles de distances des ensembles de pointes d’un espace euklidien.“ Memoires de l’Universite de Neuchatel. Sekretariat der Universität. (1939).

[46] Dave Wecker, Matthew B. Hastings, Nathan Wiebe, Bryan K. Clark, Chetan Nayak und Matthias Troyer. „Lösung stark korrelierter Elektronenmodelle auf einem Quantencomputer“. Physik. Rev. A 92, 062318 (2015).

https: / / doi.org/ 10.1103 / PhysRevA.92.062318

[47] Ian D. Kivlichan, Jarrod McClean, Nathan Wiebe, Craig Gidney, Alán Aspuru-Guzik, Garnet Kin-Lic Chan und Ryan Babbush. „Quantensimulation der elektronischen Struktur mit linearer Tiefe und Konnektivität“. Phys. Rev. Lett. 120, 110501 (2018).

https://doi.org/ 10.1103/PhysRevLett.120.110501

[48] Martín Larocca, Frédéric Sauvage, Faris M. Sbahi, Guillaume Verdon, Patrick J. Coles und M. Cerezo. „Gruppeninvariantes Quantenmaschinelles Lernen“. PRX Quantum 3, 030341 (2022).

https: / / doi.org/ 10.1103 / PRXQuantum.3.030341

[49] Johannes Jakob Meyer, Marian Mularski, Elies Gil-Fuster, Antonio Anna Mele, Francesco Arzani, Alissa Wilms und Jens Eisert. „Ausnutzung der Symmetrie beim quantenmechanischen Variationslernen“. PRX Quantum 4, 010328 (2023).

https: / / doi.org/ 10.1103 / PRXQuantum.4.010328

[50] Martin Larocca, Nathan Ju, Diego García-Martín, Patrick J. Coles und Marco Cerezo. „Theorie der Überparametrisierung in quantenneuronalen Netzen“. Nat. Berechnen. Wissenschaft. 3, 542–551 (2023).

https://doi.org/10.1038/s43588-023-00467-6

[51] Yuxuan Du, Min-Hsiu Hsieh, Tongliang Liu und Dacheng Tao. „Ausdruckskraft parametrisierter Quantenschaltungen“. Physik. Rev. Res. 2, 033125 (2020).

https: / / doi.org/ 10.1103 / physrevresearch.2.033125

[52] Zoë Holmes, Kunal Sharma, M. Cerezo und Patrick J. Coles. "Ansatz-Ausdrückbarkeit mit Gradientengrößen und kargen Plateaus verbinden". PRX Quantum 3, 010313 (2022).

https: / / doi.org/ 10.1103 / PRXQuantum.3.010313

[53] Samson Wang, Enrico Fontana, Marco Cerezo, Kunal Sharma, Akira Sone, Lukasz Cincio und Patrick J Coles. „Rauscheninduzierte unfruchtbare Plateaus in Variationsquantenalgorithmen“. Nat. Komm. 12, 6961 (2021).

https://doi.org/10.1038/s41467-021-27045-6

[54] Abdulkadir Canatar, Evan Peters, Cengiz Pehlevan, Stefan M. Wild und Ruslan Shaydulin. „Bandbreite ermöglicht Verallgemeinerung in Quantenkernmodellen“. Transaktionen zur maschinellen Lernforschung (2023). URL: https:///openreview.net/forum?id=A1N2qp4yAq.

https:///openreview.net/forum?id=A1N2qp4yAq

[55] Hsin-Yuan Huang, Michael Broughton, Jordan Cotler, Sitan Chen, Jerry Li, Masoud Mohseni, Hartmut Neven, Ryan Babbush, Richard Kueng, John Preskill und Jarrod R. McClean. „Quantenvorteil beim Lernen aus Experimenten“. Wissenschaft 376, 1182–1186 (2022).

https:///doi.org/10.1126/science.abn7293

[56] Sitan Chen, Jordan Cotler, Hsin-Yuan Huang und Jerry Li. „Exponentielle Trennung zwischen Lernen mit und ohne Quantengedächtnis“. Im Jahr 2021 findet das 62. IEEE-Jahressymposium zu Grundlagen der Informatik (FOCS) statt. Seiten 574–585. (2022).

https:///doi.org/10.1109/FOCS52979.2021.00063

[57] Hsin-Yuan Huang, Richard Kueng und John Preskill. „Informationstheoretische Grenzen des Quantenvorteils beim maschinellen Lernen“. Physik. Rev. Lett. 126, 190505 (2021).

https://doi.org/ 10.1103/PhysRevLett.126.190505

[58] Ville Bergholm, Josh Izaac, Maria Schuld, Christian Gogolin, M. Sohaib Alam, Shahnawaz Ahmed, Juan Miguel Arrazola, Carsten Blank, Alain Delgado, Soran Jahangiri, Keri McKiernan, Johannes Jakob Meyer, Zeyue Niu, Antal Száva und Nathan Killoran. „Pennylane: Automatische Differenzierung hybrider quantenklassischer Berechnungen“ (2018). arXiv:1811.04968.

arXiv: 1811.04968

[59] Peter L. Bartlett, Philip M. Long, Gábor Lugosi und Alexander Tsigler. „Gutartige Überanpassung in der linearen Regression“. Proz. Natl. Acad. Wissenschaft. 117, 30063–30070 (2020).

https: / / doi.org/ 10.1073 / pnas.1907378117

[60] Vladimir Koltchinskii und Karim Lounici. „Konzentrationsungleichungen und Momentgrenzen für Stichprobenkovarianzoperatoren“. Bernoulli 23, 110 – 133 (2017).

https:///doi.org/10.3150/15-BEJ730

[61] Zbigniew Puchała und Jarosław Adam Miszczak. „Symbolische Integration in Bezug auf das Haarmaß auf der Einheitsgruppe“. Stier. Pol. Acad. Wissenschaft. 65, 21–27 (2017).

https://doi.org/ 10.1515/bpasts-2017-0003

[62] Daniel A. Roberts und Beni Yoshida. „Chaos und Komplexität durch Design“. J. Hochenergiephysik. 2017, 121 (2017).

https:///doi.org/10.1007/jhep04(2017)121

[63] Wallace C. Babcock. „Intermodulationsstörungen in Funksystemen, Häufigkeit des Auftretens und Kontrolle durch Kanalauswahl“. Klingelsystem. Technik. J. 32, 63–73 (1953).

https: / / doi.org/ 10.1002 / j.1538-7305.1953.tb01422.x

[64] M. Atkinson, N. Santoro und J. Urrutia. „Ganzzahlsätze mit unterschiedlichen Summen und Differenzen und Trägerfrequenzzuweisungen für nichtlineare Repeater“. IEEE Trans. Komm. 34, 614–617 (1986).

https:///doi.org/10.1109/TCOM.1986.1096587

[65] J. Robinson und A. Bernstein. „Eine Klasse binärer wiederkehrender Codes mit begrenzter Fehlerausbreitung“. IEEE Trans. Inf. 13, 106–113 (1967).

https: / / doi.org/ 10.1109 / TIT.1967.1053951

[66] R. J. F. Fang und W. A. Sandrin. „Trägerfrequenzzuweisung für nichtlineare Repeater“. COMSAT Technical Review 7, 227–245 (1977).

Zitiert von

[1] Alexey Melnikov, Mohammad Kordzanganeh, Alexander Alodjants und Ray-Kuang Lee, „Quantum Machine Learning: from Physics to Software Engineering“, Fortschritte in der Physik X 8 1, 2165452 (2023).

[2] Mo Kordzanganeh, Pavel Sekatski, Leonid Fedichkin und Alexey Melnikov, „Eine exponentiell wachsende Familie universeller Quantenschaltungen“, Maschinelles Lernen: Wissenschaft und Technologie 4 3, 035036 (2023).

[3] Stefano Mangini, „Variative Quantenalgorithmen für maschinelles Lernen: Theorie und Anwendungen“, arXiv: 2306.09984, (2023).

[4] Ben Jaderberg, Antonio A. Gentile, Youssef Achari Berrada, Elvira Shishenina und Vincent E. Elfving, „Lassen Sie Quantum Neural Networks ihre eigenen Frequenzen wählen“, arXiv: 2309.03279, (2023).

[5] Yuxuan Du, Yibo Yang, Dacheng Tao und Min-Hsiu Hsieh, „Problem-Dependent Power of Quantum Neural Networks on Multiclass Classification“, Physische Überprüfungsschreiben 131 14, 140601 (2023).

[6] S. Shin, Y. S. Teo und H. Jeong, „Exponentielle Datenkodierung für quantenüberwachtes Lernen“, Physische Überprüfung A 107 1, 012422 (2023).

[7] Elies Gil-Fuster, Jens Eisert und Carlos Bravo-Prieto: „Um quantenmaschinelles Lernen zu verstehen, muss auch die Verallgemeinerung neu überdacht werden.“ arXiv: 2306.13461, (2023).

[8] Jason Iaconis und Sonika Johri, „Tensor Network Based Efficient Quantum Data Loading of Images“, arXiv: 2310.05897, (2023).

[9] Alice Barthe und Adrián Pérez-Salinas, „Gradienten und Frequenzprofile von Quanten-Re-Uploading-Modellen“, arXiv: 2311.10822, (2023).

[10] Tobias Haug und MS Kim, „Generalisierung mit Quantengeometrie zum Lernen von Unitären“, arXiv: 2303.13462, (2023).

[11] Jonas Landman, Slimane Thabet, Constantin Dalyac, Hela Mhiri und Elham Kashefi, „Classically Approximating Variational Quantum Machine Learning with Random Fourier Features“, arXiv: 2210.13200, (2022).

[12] Berta Casas und Alba Cervera-Lierta, „Mehrdimensionale Fourier-Reihen mit Quantenschaltungen“, Physische Überprüfung A 107 6, 062612 (2023).

[13] Elies Gil-Fuster, Jens Eisert und Vedran Dunjko, „Über die Expressivität der Einbettung von Quantenkernen“, arXiv: 2309.14419, (2023).

[14] Lucas Slattery, Ruslan Shaydulin, Shouvanik Chakrabarti, Marco Pistoia, Sami Khairy und Stefan M. Wild, „Numerischer Beweis gegen Vorteil mit Quantentreuekernen auf klassischen Daten“, Physische Überprüfung A 107 6, 062417 (2023).

[15] Mo Kordzanganeh, Daria Kosichkina und Alexey Melnikov, „Parallel Hybrid Networks: ein Zusammenspiel zwischen Quanten- und klassischen neuronalen Netzwerken“, arXiv: 2303.03227, (2023).

[16] Aikaterini, Gratsea und Patrick Huembeli, „Die Wirkung der Verarbeitungs- und Messoperatoren auf die Ausdruckskraft von Quantenmodellen“, arXiv: 2211.03101, (2022).

[17] Shun Okumura und Masayuki Ohzeki, „Fourierkoeffizient parametrisierter Quantenschaltungen und Barren-Plateau-Problem“, arXiv: 2309.06740, (2023).

[18] Massimiliano Incudini, Michele Grossi, Antonio Mandarino, Sofia Vallecorsa, Alessandra Di Pierro und David Windridge, „The Quantum Path Kernel: a Generalized Quantum Neural Tangent Kernel for Deep Quantum Machine Learning“, arXiv: 2212.11826, (2022).

[19] Jorja J. Kirk, Matthew D. Jackson, Daniel J. M. King, Philip Intallura und Mekena Metcalf, „Emergent Order in Classical Data Representations on Ising Spin Models“, arXiv: 2303.01461, (2023).

[20] Francesco Scala, Andrea Ceschini, Massimo Panella und Dario Gerace, „A General Approach to Dropout in Quantum Neural Networks“, arXiv: 2310.04120, (2023).

[21] Julian Berberich, Daniel Fink, Daniel Pranjić, Christian Tutschku und Christian Holm, „Training robuster und generalisierbarer Quantenmodelle“, arXiv: 2311.11871, (2023).

Die obigen Zitate stammen von SAO / NASA ADS (Zuletzt erfolgreich aktualisiert am 2023, 12:21:00 Uhr). Die Liste ist möglicherweise unvollständig, da nicht alle Verlage geeignete und vollständige Zitationsdaten bereitstellen.

On Der von Crossref zitierte Dienst Es wurden keine Daten zum Zitieren von Werken gefunden (letzter Versuch 2023-12-21 00:40:53).

Dieses Papier ist in Quantum unter dem veröffentlicht Creative Commons Namensnennung 4.0 International (CC BY 4.0) Lizenz. Das Copyright verbleibt bei den ursprünglichen Copyright-Inhabern wie den Autoren oder deren Institutionen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://quantum-journal.org/papers/q-2023-12-20-1210/

- :hast

- :Ist

- :nicht

- 1

- 10

- 107

- 11

- 110

- 116

- 12

- 120

- 121

- 125

- 13

- 14

- 15%

- 16

- 17

- 1791

- 19

- 20

- 2008

- 2015

- 2017

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 35%

- 36

- 39

- 40

- 41

- 43

- 46

- 49

- 50

- 51

- 52

- 53

- 54

- 58

- 60

- 65

- 66

- 7

- 75

- 8

- 9

- 98

- a

- Abbas

- Fähigkeit

- oben

- ABSTRACT

- Zugang

- Nach

- Genauigkeit

- Marcus

- Vorschüsse

- Vorteil

- widersprüchlich

- Zugehörigkeiten

- gegen

- ahmed

- alex

- Udo

- Algorithmen

- Alice

- Alle

- ebenfalls

- an

- Analyse

- Analytisch

- und

- Martin

- anna

- jährlich

- Anwendungen

- Ansatz

- SIND

- Bereiche

- AS

- Versuch

- Autor

- Autoren

- automatische

- b

- unfruchtbar

- basierend

- basic

- BE

- war

- Verhalten

- hinter

- Bell

- ben

- Christoph

- Besser

- zwischen

- Beyond

- leer

- Beschränkt

- Break

- Bryan

- Stier

- by

- capability

- Kapazität

- carlos

- casper

- chan

- Kanal

- chen

- Auswählen

- Chow

- Christian

- Anführung

- Klasse

- Einstufung

- Codes

- Kommentar

- Unterhaus

- abschließen

- Komplex

- Komplexität

- Berechnungen

- Computer

- Computerwissenschaften

- Computing

- Beton

- Konferenz

- Konnektivität

- Kontext

- Smartgeräte App

- Urheberrecht

- korreliert

- Craig

- Kurve

- Matthias

- technische Daten

- Data Mining

- Dave

- Christian

- Dez

- tief

- tiefe Lernen

- tiefe neuronale Netze

- Es

- abhängig

- Tiefe

- ableiten

- Design

- Trotz

- Bestimmung

- Diego

- Unterschiede

- diskutieren

- deutlich

- do

- die

- doppelt

- e

- Ludwig

- bewirken

- effizient

- elektronisch

- Elemente

- Einbettung

- ermöglicht

- Codierung

- Energie

- Entwicklung

- Erika

- Fehler

- Äther (ETH)

- Beweis

- Beispiel

- Exponate

- Experimente

- Erklären

- exponentiell

- expressiv

- Familie

- Abschied

- Angst

- Merkmal

- Eigenschaften

- wenige

- Treue

- Aussichten für

- gefunden

- Foundations

- Francisco cisco~~POS=HEADCOMP

- Frequenz

- für

- Materials des

- Funktion

- Allgemeines

- generativ

- generative kontradiktorische Netzwerke

- Geometrie

- Kundenziele

- Steigungen

- Gruppe an

- Hardware

- Harvard

- GUTE

- Inhaber

- Ultraschall

- HTML

- http

- HTTPS

- Huang

- Hybrid

- hybrider Quantenklassiker

- i

- IEEE

- Bilder

- zu unterstützen,

- in

- Ungleichheiten

- Information

- Institut

- Institutionen

- Integration

- interessant

- Einmischung

- International

- Einleitung

- Jackson

- JavaScript

- jerome

- Peter

- Johnson

- Jordanien

- Zeitschrift

- John

- karim

- Kendall

- Kim

- King

- Kirche

- großflächig

- -Laser

- Nachname

- LERNEN

- lernen

- am wenigsten

- Verlassen

- Lee

- lassen

- li

- Lizenz

- Limitiert

- lin

- Linking

- Liste

- Laden

- örtlich

- Logan

- Lang

- Verlust

- senken

- Ltd

- Maschine

- Maschinelles Lernen

- Maschinen

- Marco

- maria

- Martin

- Mathe

- mathematisch

- Materie

- Matthew

- matthias

- Kann..

- McClean

- messen

- Messung

- Mechanismen

- Memory

- Metcalf

- Methoden

- Meyer

- Michael

- könnte

- mikhail

- Minimierung

- Bergbau

- Modell

- für

- modern

- Moment

- Monat

- mehrere

- Natur

- In der Nähe von

- Netzwerk

- Netzwerke

- Neural

- neuronale Netzwerk

- Neuronale Netze

- nicht

- Auftreten

- of

- vorgenommen,

- oliver

- on

- Ontario

- XNUMXh geöffnet

- Einkauf & Prozesse

- Betreiber

- or

- Auftrag

- Original

- UNSERE

- Überblick

- besitzen

- Seiten

- Papier

- Parallel

- Weg

- Patrick

- Jürgen

- Phänomen

- Physik

- Plato

- Datenintelligenz von Plato

- PlatoData

- Punkte

- Werkzeuge

- Praxis

- präzise

- Prognose

- Vorbereitung

- Presse

- Aufgabenstellung:

- PROC

- Verfahren

- Verarbeitung

- Prozessoren

- Profil

- Fortpflanzung

- die

- veröffentlicht

- Herausgeber

- Verlag

- Quant

- Quantenvorteil

- Quantenalgorithmen

- Quantencomputer

- Quantencomputing

- Quanteninformation

- Quantenmaschinelles Lernen

- R

- Radio

- zufällig

- wiederkehrend

- Referenzen

- Regime

- Regression

- Beziehung

- Beziehung

- bleibt bestehen

- bemerkenswert

- erfordert

- Forschungsprojekte

- Umwelt und Kunden

- eingeschränkt

- Revealed

- Überprüfen

- Daniel

- Risiko

- ROBERT

- robust

- Ohne eine erfahrene Medienplanung zur Festlegung von Regeln und Strategien beschleunigt der programmatische Medieneinkauf einfach die Rate der verschwenderischen Ausgaben.

- Lutz

- s

- Scala

- SCI

- Wissenschaft

- Wissenschaft und Technologie

- ausgewählt

- Auswahl

- Modellreihe

- Sets

- seicht

- Sharma

- erklären

- Signale

- JA

- Ähnlich

- Simulation

- gleichzeitig

- Software

- Softwareentwicklung

- Lied

- Räume

- Wirbelsäule ... zu unterstützen.

- Quadrate

- Standpunkt

- Bundesstaat

- statistisch

- stefan

- starker

- Struktur

- sucht

- Erfolg

- Erfolgreich

- so

- geeignet

- Summen

- überwachtes Lernen

- Überraschung

- Symposium

- Systeme und Techniken

- Tech

- Technische

- Technologie

- Begriff

- Das

- ihr

- theoretisch

- Theorie

- damit

- Diese

- fehlen uns die Worte.

- Durch

- Titel

- zu

- toronto

- Ausbildung

- trans

- Transaktionen

- Trevor

- tyler

- UN

- für

- Verständnis

- Universal-

- Universität

- aktualisiert

- URL

- Vielfalt

- sehr

- vincent

- Volumen

- vs

- W

- wang

- wollen

- wurde

- we

- GUT

- während

- weit verbreitet

- Wild

- mit

- ohne

- Arbeiten

- Werk

- Wright

- X

- Jahr

- Zephyrnet