Jay Dawani ist Mitbegründer und CEO von Lemurische Labore, ein Startup, das eine beschleunigte Computerplattform entwickelt, die speziell auf KI-Anwendungen zugeschnitten ist. Die Plattform durchbricht die Hardware-Barrieren, um die KI-Entwicklung schneller, kostengünstiger, nachhaltiger und für mehr als nur wenige Unternehmen zugänglich zu machen.

Bevor er Lemurian gründete, gründete Jay zwei weitere Unternehmen im KI-Bereich. Er ist außerdem Autor des am besten bewerteten Buches „Mathematik für Deep Learning"

Als Experte für künstliche Intelligenz, Robotik und Mathematik war Jay als CTO von BlocPlay tätig, einem börsennotierten Unternehmen, das eine Blockchain-basierte Spieleplattform aufbaut, und als Director of AI bei GEC, wo er die Entwicklung mehrerer Kundenprojekte in verschiedenen Bereichen leitete aus dem Einzelhandel, dem algorithmischen Handel, der Proteinfaltung, Robotern für die Weltraumforschung, Empfehlungssystemen und mehr. In seiner Freizeit war er außerdem Berater beim NASA Frontier Development Lab, bei Spacebit und SiaClassic.

Als wir Lemurian Labs das letzte Mal vorgestellt haben, haben Sie sich auf Robotik und Edge-KI konzentriert. Jetzt konzentrieren Sie sich auf die Rechenzentrums- und Cloud-Infrastruktur. Was ist passiert, das Sie dazu veranlasst hat, umzuschwenken?

Tatsächlich sind wir vom Fokus auf den Aufbau eines hochleistungsfähigen System-on-Chips mit geringer Latenz für autonome Robotikanwendungen, das die gesamte Sense-Plan-Act-Schleife beschleunigen könnte, zum Aufbau eines domänenspezifischen Beschleunigers für KI übergegangen, der sich auf Anwendungen im Rechenzentrumsmaßstab konzentriert . Aber es war nicht nur ein gewöhnlicher Drehpunkt; Es war ein Fanfarenruf, von dem wir glaubten, dass wir die Verantwortung hätten, darauf zu antworten.

Im Jahr 2018 arbeiteten wir daran, ein 2.1 Milliarden US-Dollar teures Parametermodell zu trainieren, aber wir gaben den Aufwand auf, weil die Kosten so außerordentlich hoch waren, dass wir sie nicht rechtfertigen konnten. Stellen Sie sich also meine Überraschung vor, dass GPT3, das OpenAI im November 2022 als ChatGPT veröffentlichte, ein 175-Milliarden-Dollar-Parametermodell war. Dieses Modell ist mehr als 80-mal größer als das, an dem wir nur vier Jahre zuvor gearbeitet haben, was sowohl aufregend als auch beängstigend ist.

Die Kosten für die Schulung eines solchen Modells sind, gelinde gesagt, atemberaubend. Basierend auf den aktuellen Skalierungstrends können wir davon ausgehen, dass die Kosten für das Training eines Grenz-KI-Modells in nicht allzu ferner Zukunft eine Milliarde Dollar überschreiten werden. Während die Fähigkeiten dieser Modelle erstaunlich sein werden, sind die Kosten lächerlich hoch. Basierend auf dieser Entwicklung werden es sich nur eine Handvoll sehr gut ausgestatteter Unternehmen mit eigenen Rechenzentren leisten können, diese Modelle zu trainieren, bereitzustellen und zu optimieren. Das liegt nicht nur daran, dass Rechenleistung teuer und energiehungrig ist, sondern auch daran, dass die Software-Stacks, auf die wir uns verlassen, nicht für diese Welt entwickelt wurden.

Aufgrund geografischer und energetischer Einschränkungen gibt es nur eine begrenzte Anzahl an Standorten für den Bau von Rechenzentren. Um den Rechenanforderungen der KI gerecht zu werden, müssen wir in der Lage sein, Maschinen im Zetta-Maßstab zu bauen, ohne dass dafür 20 Kernreaktoren erforderlich sind. Wir brauchen eine praktischere, skalierbarere und wirtschaftlichere Lösung. Wir schauten uns um und sahen niemanden, der das Problem lösen könnte. Und so machten wir uns ans Zeichenbrett, um das Problem ganzheitlich als System von Systemen zu betrachten und auf der Grundlage erster Prinzipien über eine Lösung nachzudenken. Wir haben uns gefragt, wie wir den gesamten Stack von der Software bis zur Hardware entwerfen würden, wenn wir wirtschaftlich 10 Milliarden LLM-Anfragen pro Tag bedienen müssten. Unser Ziel ist es, bis 200 eine Maschine im Zetta-Maßstab mit weniger als 2028 MW zu bauen.

Der Trick besteht darin, es unter dem Gesichtspunkt der inproportionalen Skalierung zu betrachten – verschiedene Teile eines Systems folgen unterschiedlichen Skalierungsregeln, sodass die Dinge irgendwann einfach nicht mehr funktionieren, kaputt gehen oder der Kosten-Nutzen-Kompromiss keinen Sinn mehr ergibt. In diesem Fall besteht die einzige Möglichkeit darin, das System neu zu gestalten. Unsere Bewertung und Lösung umfasst Workload, Zahlensystem, Programmiermodell, Compiler, Laufzeit und Hardware ganzheitlich.

Glücklicherweise erkennen unsere bestehenden Investoren und der Rest des Marktes die Vision, und wir haben eine Startkapitalfinanzierung in Höhe von 9 Millionen US-Dollar eingeworben, um unser Zahlenformat – PAL – zu entwickeln, um den Designraum zu erkunden und uns auf eine Architektur für unseren domänenspezifischen Beschleuniger und unsere Architektur zu einigen Compiler und Laufzeit. In Simulationen konnten wir einen 20-fachen Durchsatzgewinn bei geringerem Energiebedarf im Vergleich zu modernen GPUs erzielen und gehen davon aus, dass wir mit derselben Transistortechnologie einen 8-fachen Vorteil bei der Systemleistung bei den Gesamtbetriebskosten erzielen können.

Unnötig zu erwähnen, dass wir noch viel Arbeit vor uns haben, aber wir freuen uns sehr über die Aussicht, die Wirtschaftlichkeit von Rechenzentren neu definieren zu können, um eine Zukunft zu gewährleisten, in der KI für jeden in Hülle und Fülle verfügbar ist.

Das klingt auf jeden Fall spannend und diese Zahlen klingen beeindruckend. Aber Sie haben Zahlensysteme, Hardware, Compiler und Laufzeiten als all die Dinge erwähnt, auf die Sie sich konzentrieren – das klingt nach einer Menge, die jedes Unternehmen auf einmal übernehmen muss. Es scheint ein sehr riskantes Unterfangen zu sein. Müssen Startups nicht fokussierter sein?

Es hört sich nach vielen unterschiedlichen Anstrengungen an, ist aber tatsächlich eine einzige Anstrengung mit vielen miteinander verbundenen Teilen. Die isolierte Lösung nur einer dieser Komponenten wird das Innovationspotenzial nur behindern, da dadurch die systemischen Ineffizienzen und Engpässe übersehen werden. Jensen Huang hat es am treffendsten ausgedrückt: „Um ein Accelerated-Computing-Unternehmen zu sein, muss man ein Full-Stack-Unternehmen sein“, und ich stimme voll und ganz zu. Sie sind nicht ohne Grund der aktuelle Marktführer. Aber ich würde die Vorstellung in Frage stellen, dass wir nicht konzentriert sind. Unser Fokus liegt darauf, wie wir das Problem ganzheitlich betrachten und wie wir es für unsere Kunden am besten lösen können.

Um dies zu erreichen, ist ein multidisziplinärer Ansatz wie unserer erforderlich. Jeder Teil unserer Arbeit informiert und unterstützt die anderen, sodass wir eine Lösung schaffen können, die weit mehr ist als die Summe ihrer Teile. Stellen Sie sich vor, Sie müssten einen Rennwagen bauen. Sie würden nicht willkürlich ein Chassis auswählen, Rennreifen hinzufügen und den stärksten Motor einbauen, den Sie finden können, und damit Rennen fahren, oder? Sie würden über die Aerodynamik der Karosserie nachdenken, um den Luftwiderstand zu reduzieren und den Abtrieb zu erhöhen, die Gewichtsverteilung für ein gutes Handling optimieren, den Motor individuell für maximale Leistung konstruieren, ein Kühlsystem einbauen, um Überhitzung zu verhindern, und einen Überrollkäfig ausstatten, um die Sicherheit des Fahrers zu gewährleisten usw. Jedes dieser Elemente baut auf dem anderen auf und informiert es.

Allerdings ist es riskant, für jedes Unternehmen in jeder Branche alles auf einmal zu versuchen. Um die Risiken zu bewältigen, verfolgen wir einen stufenweisen Ansatz, der es uns ermöglicht, unsere Technologie bei Kunden zu validieren und unsere Strategie bei Bedarf anzupassen. Wir haben bewiesen, dass unser Zahlenformat funktioniert und dass es ein besseres Leistungs-Leistungs-Verhältnis als entsprechende Gleitkommatypen aufweist und gleichzeitig über bessere numerische Eigenschaften verfügt, die es einfacher machen, neuronale Netze auf kleinere Bitbreiten zu quantisieren. Wir haben eine Architektur entworfen, von der wir überzeugt sind und die sowohl für das Training als auch für die Inferenz geeignet ist. Aber noch wichtiger als all das ist die richtige Software, und darauf konzentrieren wir uns unmittelbar. Wir müssen sicherstellen, dass wir in unserem Software-Stack die richtigen Entscheidungen treffen, wenn es darum geht, wie sich die Welt in ein, zwei oder mehr Jahren entwickeln wird.

Der Aufbau eines Hardware-Unternehmens ist schwierig, teuer und dauert lange. Der Fokus auf Software klingt zunächst nach einem sehr rentablen Geschäft für sich und ist im aktuellen Umfeld möglicherweise attraktiver für Investoren. Warum stellen Sie auch Hardware her, wenn doch so viele gut finanzierte Unternehmen in diesem Bereich ihre Türen schließen, Schwierigkeiten haben, sich bei den Kunden durchzusetzen, und größere Player ihre eigene Hardware bauen?

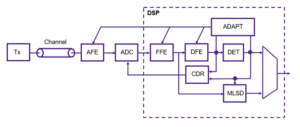

Sie haben absolut Recht, dass Softwareunternehmen im Allgemeinen viel einfacher Kapital beschaffen konnten als Hardwareunternehmen, und dass Hardware sehr schwierig ist. Unser aktueller Fokus liegt stark auf Software, weil wir dort das größere Problem sehen. Lassen Sie mich klarstellen, dass das Problem nicht darin besteht, ob ich Kernel auf einer CPU oder GPU mit hoher Leistung zum Laufen bringen kann; das ist ein längst gelöstes Problem. Das heutige Problem besteht darin, wie wir es Entwicklern einfacher machen können, aus mehreren tausend Knotenclustern, die aus heterogener Rechenleistung bestehen, produktiv mehr Leistung herauszuholen, ohne dass sie ihren Workflow überarbeiten müssen.

Das ist das Problem, auf dessen Lösung wir uns derzeit konzentrieren, mit einem Software-Stack, der Entwicklern Superkräfte verleiht und die volle Leistungsfähigkeit von Computern im Lagermaßstab freisetzt, sodass wir KI-Modelle wirtschaftlicher trainieren und einsetzen können.

Nun, was Investitionen betrifft, sind VCs zwar wählerischer bei der Art der Unternehmen, die sie unterstützen, aber das bedeutet auch, dass VCs nach Unternehmen suchen, die das Potenzial haben, wirklich bahnbrechende Produkte anzubieten, die einen klaren Weg zur Kommerzialisierung haben und gleichzeitig erhebliche Auswirkungen haben. Wir haben aus den Herausforderungen und Fehlern anderer gelernt und unser Geschäftsmodell und unsere Roadmap aktiv so gestaltet, dass sie den Risiken begegnen. Es ist auch wichtig zu beachten, dass der Erfolg von Startups selten darin liegt, wie einfach sie VC-Finanzierung beschaffen können, sondern eher in ihrem Einfallsreichtum, ihrer Sturheit und Kundenorientierung liegt.

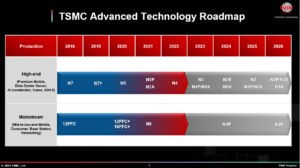

Und bevor Sie fragen: Wir arbeiten immer noch an der Hardware, aber derzeit hauptsächlich an der Simulation. Wir haben nicht vor, für eine Weile mit dem Tape-Out zu beginnen. Aber wir können uns dieses Gespräch für ein anderes Mal aufsparen.

Das ist auf jeden Fall überzeugend und Ihr schrittweiser Ansatz unterscheidet sich deutlich von dem, was wir bei anderen Hardware-Unternehmen gesehen haben. Ich verstehe das Problem, von dem Sie sagen, dass Ihr Software-Stack es lösen wird, aber wie unterscheidet sich Ihre Software von den verschiedenen Angeboten auf dem Markt?

Die meisten Unternehmen, auf die Sie sich beziehen, konzentrieren sich darauf, die Programmierung von GPUs zu vereinfachen, indem sie kachelbasierte oder Task-Mapping-Programmiermodelle einführen, um mehr Leistung aus GPUs herauszuholen, oder indem sie neue Programmiersprachen entwickeln, um leistungsstarke Kernel auf verschiedenen Geräten zu planen Plattformen mit Unterstützung für die Inline-Montage. Das sind wichtige Probleme, die sie ansprechen, aber wir betrachten das Problem, das wir lösen, als nahezu orthogonal.

Lassen Sie uns einen Moment über den Rhythmus von Hardware- und Softwareübergängen nachdenken. Single-Core-Architekturen gewannen an Leistung durch Taktrate und Transistordichte, doch irgendwann erreichten die Taktraten ein Plateau. Die Parallelität mit vielen Kernen umging dies und sorgte für beträchtliche Beschleunigungen. Es dauerte etwa ein Jahrzehnt, bis die Software aufholte, da Programmiermodelle, Compiler und Laufzeiten neu überdacht werden mussten, um Entwicklern dabei zu helfen, den Wert dieses Paradigmas zu nutzen. Dann begannen GPUs, Allzweckbeschleuniger zu werden, wiederum mit einem anderen Programmiermodell. Auch hier dauerte es fast ein Jahrzehnt, bis die Entwickler hier einen Mehrwert schafften.

Wieder einmal erreicht die Hardware ein Plateau – das Mooresche Gesetz, Energie- und Wärmebeschränkungen, Speicherengpässe und die Vielfalt der Arbeitslasten sowie der Bedarf an exponentiell mehr Rechenleistung treiben uns dazu, immer heterogenere Computerarchitekturen für bessere Leistung, Effizienz und Gesamtkosten zu entwickeln. Dieser Wandel in der Hardware wird natürlich auch Herausforderungen für die Software mit sich bringen, da wir nicht über die richtigen Compiler und Laufzeiten verfügen, um die nächste Evolutionsstufe der Datenverarbeitung zu unterstützen. Dieses Mal sollten wir jedoch nicht weitere 10 Jahre warten müssen, bis die Software den Wert heterogener Architekturen oder großer Cluster ausschöpft, insbesondere wenn diese zu mehr als 80 % ungenutzt bleiben.

Unser Fokus liegt auf dem Aufbau eines heterogenitätsbewussten Programmiermodells mit aufgabenbasierter Parallelität, das die tragbare Leistung mit prozessorübergreifenden Optimierungen, kontextbezogener Kompilierung und dynamischer Ressourcenzuweisung berücksichtigt. Und für uns spielt es keine Rolle, ob es sich um eine CPU, GPU, TPU, SPU (Lemurians Architektur) oder ein Netz aus allen handelt. Ich weiß, das hört sich nach vielen ausgefallenen Worten an, aber was es eigentlich aussagt, ist, dass wir es möglich gemacht haben, jede Art von Prozessor mit einem einzigen Ansatz zu programmieren, und wir können Code mit minimalem Aufwand von einer Art von Prozessor auf eine andere portieren Erledigen Sie Ihren Arbeitsaufwand, ohne dass Sie Einbußen bei der Leistung hinnehmen müssen, und planen Sie die Arbeit adaptiv und dynamisch über alle Knoten hinweg.

Wenn das, was Sie sagen, wahr ist, können Sie die Informatik völlig neu definieren. Lassen Sie uns über die Finanzierung sprechen. Sie haben letztes Jahr 9 Millionen US-Dollar an Startkapital aufgebracht, was die starke Unterstützung der Investoren und den Glauben an Ihre Vision unterstreicht. Was hast du seitdem gemacht?

Im vergangenen Jahr haben wir dank der Startkapitalfinanzierung erhebliche Fortschritte gemacht. Mit unserem mittlerweile 20-köpfigen Team haben wir Herausforderungen akribisch angegangen, mit Kunden zusammengearbeitet und unseren Ansatz verfeinert.

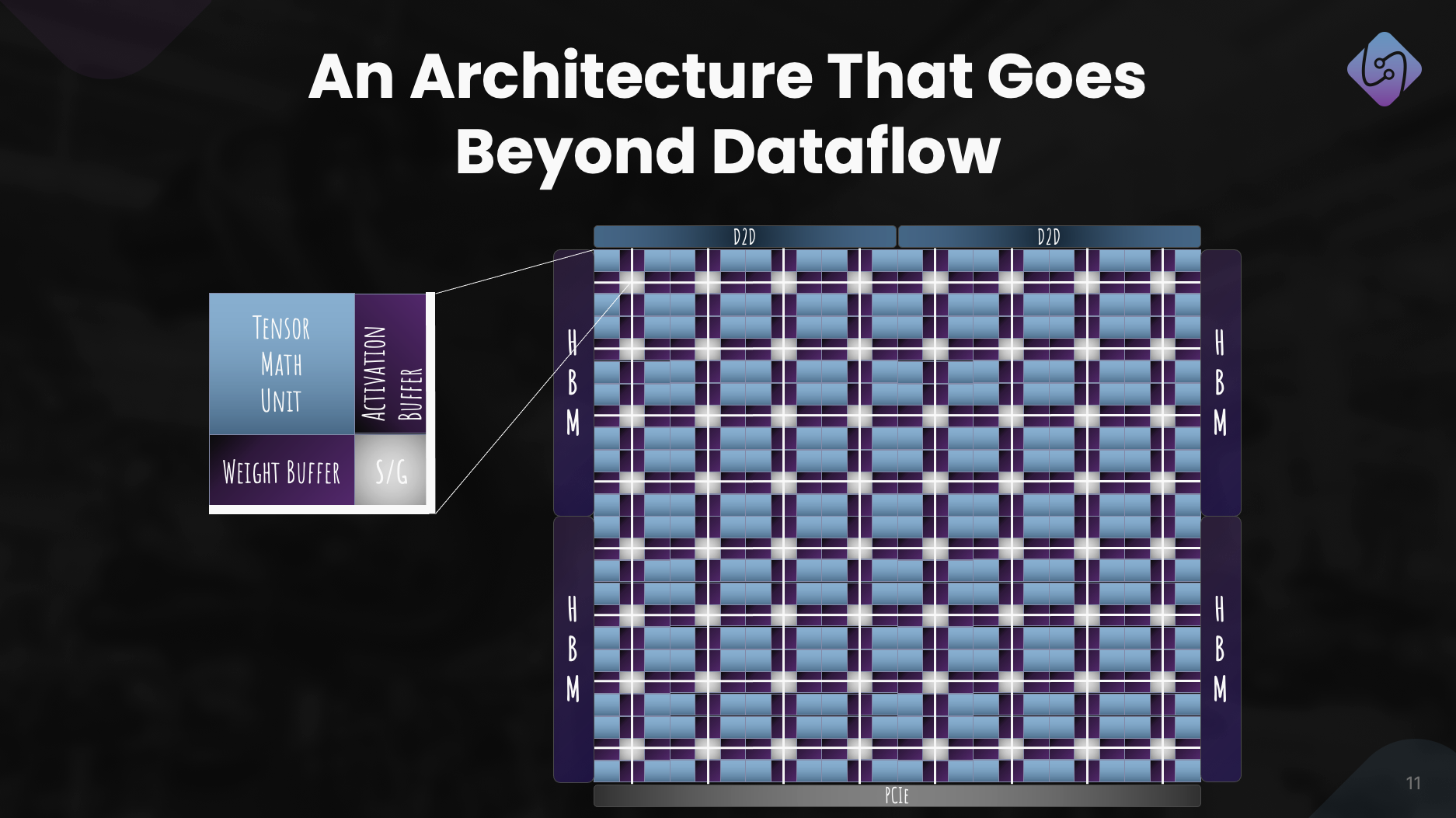

Wir haben uns auf die Verbesserung von PAL für Training und Inferenz konzentriert, die Computerarchitektur für unseren Beschleuniger erforscht und einen Simulator für Leistungsmetriken entwickelt. Gleichzeitig haben wir unseren Software-Stack für Rechenzentrumsanwendungen neu konzipiert und dabei den Schwerpunkt auf heterogenes Computing gelegt.

Diese Bemühungen führten zu einer klar definierten Architektur, die die Wirksamkeit von PAL für KI im großen Maßstab demonstrierte. Über den technischen Fortschritt hinaus verfolgten wir Kooperationen und Öffentlichkeitsarbeit, um den Zugang zu demokratisieren. Diese Bemühungen versetzen Lemurian Labs in die Lage, unmittelbare Kundenherausforderungen anzugehen und sich auf die Freigabe unseres Produktionssiliziums vorzubereiten.

Was sind die mittelfristigen Pläne von Lemurian Labs in Bezug auf die Entwicklung von Software-Stacks, Kooperationen und die Verbesserung der Architektur des Beschleunigers?

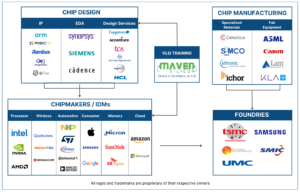

Unser unmittelbares Ziel ist es, einen Software-Stack zu erstellen, der auf CPUs, GPUs und unsere KI-Beschleuniger mit tragbarer Leistung abzielt und der Ende des Jahres frühen Partnern zur Verfügung gestellt wird. Wir führen derzeit Gespräche mit den meisten führenden Halbleiterunternehmen, Cloud-Dienstanbietern, Hyperscalern und KI-Unternehmen, um ihnen Zugriff auf unseren Compiler und unsere Laufzeit zu gewähren. Parallel dazu arbeiten wir weiter an der Architektur unseres Beschleunigers und verbessern diese für ein wirklich gemeinsam entworfenes System aus Hardware und Software. Und natürlich haben wir gerade mit der Aufstockung unserer Serie A begonnen und stoßen dabei auf großes Interesse seitens der Investorengemeinschaft. Dies wird es uns ermöglichen, unser Team zu vergrößern und unser Ziel für die Lieferung von Softwareprodukten am Ende des Jahres zu erreichen.

Abschließend: Wie wird Lemurian Labs Ihrer Meinung nach dazu beitragen, die Landschaft der KI-Entwicklung, Zugänglichkeit und Gerechtigkeit in den kommenden Jahren zu verändern?

Unser Ziel war es nicht, die Computertechnik nur aus kommerziellen Gründen oder aus Spaß an der Freude neu zu definieren. Als Lemurianer ist es unsere treibende Kraft, dass wir an das transformative Potenzial der KI glauben und dass mehr als nur ein paar Unternehmen über die Ressourcen verfügen sollten, die Zukunft dieser Technologie und deren Nutzung zu definieren. Wir finden es auch nicht akzeptabel, dass die Rechenzentrumsinfrastruktur für KI bis 20 bis zu 2030 % der weltweiten Energie verbrauchen wird. Wir sind alle zusammengekommen, weil wir glauben, dass es einen besseren Weg nach vorne für die Gesellschaft gibt, wenn wir es schaffen Machen Sie KI zugänglicher, indem Sie die damit verbundenen Kosten drastisch senken, beschleunigen Sie das Innovationstempo in der KI und erweitern Sie ihre Wirkung. Durch die Bewältigung der Herausforderungen der aktuellen Hardware-Infrastruktur möchten wir den Weg ebnen, einer Milliarde Menschen die Fähigkeiten der KI zu ermöglichen und eine gerechte Verteilung dieser fortschrittlichen Technologie sicherzustellen. Wir hoffen, dass unser Engagement für produktorientierte Lösungen, Zusammenarbeit und kontinuierliche Innovation uns als treibende Kraft bei der positiven Gestaltung der Zukunft der KI-Entwicklung positioniert.

Lesen Sie auch:

Teile diesen Beitrag über:

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://semiwiki.com/ceo-interviews/341485-ceo-interview-jay-dawani-of-lemurian-labs-2/

- :hast

- :Ist

- :nicht

- :Wo

- 9 Mio. US$

- $UP

- 1

- 10

- 20

- 2018

- 2022

- 2028

- 2030

- 20x

- 300

- 4

- a

- Fähig

- Über uns

- absolut

- beschleunigen

- beschleunigt

- Beschleuniger

- Beschleuniger

- akzeptabel

- Zugang

- Zugänglichkeit

- zugänglich

- Erreichen

- über

- aktiv

- hinzufügen

- Adresse

- angesprochen

- Adressierung

- einstellen

- Adoption

- advanced

- Fortschrittliche Technologie

- Fortschritte

- Berater

- aufs Neue

- voraus

- AI

- KI-Modelle

- algorithmisch

- algorithmischer Handel

- Alle

- Zuteilung

- Zulassen

- fast

- ebenfalls

- Amazon

- an

- machen

- Ein anderer

- beantworten

- jedem

- jemand

- ansprechend

- Anwendungen

- Ansatz

- willkürlich

- Architektur

- Architekturen

- SIND

- Bereiche

- um

- künstlich

- künstliche Intelligenz

- AS

- fragen

- fragen

- Versammlung

- Bewertung

- damit verbundenen

- erstaunlich

- At

- Autor

- Autonom

- verfügbar

- Zurück

- Barrieren

- basierend

- BE

- weil

- Werden

- war

- Bevor

- Sein

- Glauben

- Glauben

- Nutzen

- BESTE

- Besser

- Beyond

- größer

- Milliarde

- Blockchain-basiert

- Tafel

- Körper

- beide

- Engpässe

- Bruch

- geht kaputt

- erweitern

- bauen

- Building

- baut

- erbaut

- Masse

- Geschäft

- Geschäftsmodell

- Unternehmen

- aber

- by

- Kadenz

- rufen Sie uns an!

- kam

- CAN

- Kann bekommen

- Fähigkeiten

- capability

- Hauptstadt

- Ringen

- Center

- CEO

- CEO-Vorstellungsgespräch

- sicherlich

- challenges

- Herausforderungen

- Ändern

- Chassis

- ChatGPT

- billiger

- klar

- Auftraggeber

- Klimaschutz

- Uhr

- Schließen

- Cloud

- Cloud-Infrastruktur

- Co-Gründer

- Code

- Zusammenarbeit

- Kooperationen

- Kommen

- kommerziell

- Vermarktung

- Engagement

- community

- Unternehmen

- Unternehmen

- verglichen

- zwingend

- Compiler

- uneingeschränkt

- Komponenten

- Berechnen

- Computer

- Computer

- Computing

- zuversichtlich

- Einschränkungen

- verbrauchen

- fortsetzen

- kontinuierlich

- Beitrag

- konvergieren

- Gespräch

- Gespräche

- Kühlsystem

- und beseitigen Muskelschwäche

- Kosten

- könnte

- Kurs

- Abdeckung

- CPU

- erstellen

- Cross

- CTO

- Strom

- Zur Zeit

- Original

- individuelles Design

- Kunde

- Kunden

- technische Daten

- Data Center

- Datacenter

- Tag

- Jahrzehnte

- Entscheidungen

- tief

- definieren

- Übergeben

- Lieferanten

- Anforderungen

- demokratisieren

- Dichte

- einsetzen

- Design

- entworfen

- entwickeln

- entwickelt

- Entwickler

- Entwicklung

- Entwicklung

- DID

- anders

- unterscheiden

- Direktor

- Entfernt

- Verteilung

- Diversität

- do

- die

- Tut nicht

- Dabei

- Dollar

- Domain

- erledigt

- Nicht

- Türen

- Dramatisch

- Zeichnung

- Fahrer

- Fahren

- Drop

- dynamisch

- dynamisch

- jeder

- Früher

- Früh

- einfacher

- leicht

- wirtschaftlich

- Wirtschaftskunde

- Edge

- Wirksamkeit

- Effizienz

- Anstrengung

- Bemühungen

- Elemente

- Betonung

- Empowerment

- ermöglichen

- ermöglichen

- umfasst

- Ende

- Energie

- beschäftigt

- Motor

- zu steigern,

- Eine Verbesserung der

- gewährleisten

- Gewährleistung

- Ganz

- gerecht

- Gerechtigkeit

- Äquivalent

- insbesondere

- etc

- schließlich

- jedermann

- Evolution

- überschreiten

- aufgeregt

- unterhaltsame Programmpunkte

- vorhandenen

- erwarten

- teuer

- Experte

- Exploration

- ERKUNDEN

- Erkundet

- exponentiell

- Extrakt

- außerordentlich

- Tatsache

- Phantasie

- weit

- beschleunigt

- funktions

- fühlen

- Fehler

- wenige

- Finden Sie

- Vorname

- schweben

- Setzen Sie mit Achtsamkeit

- konzentriert

- Fokussierung

- folgen

- Fußabdruck

- Aussichten für

- Zwingen

- Format

- vorwärts

- Gründung

- Gründung

- für

- Grenze

- getankt

- voller

- Voller Stapel

- voll

- Spaß

- Finanzierung

- Zukunft

- Zukunft der KI

- Gewinnen

- gewonnen

- Gaming

- Spielplattform

- Getriebe

- Allgemeines

- allgemein

- geographisch

- bekommen

- bekommen

- ABSICHT

- gegeben

- gibt

- Kundenziele

- gehen

- gut

- habe

- GPU

- GPUs

- bahnbrechend

- Wachsen Sie über sich hinaus

- hätten

- Hand voll

- Handling

- passiert

- das passiert

- Hardware

- Haben

- mit

- he

- Hilfe

- hier

- GUTE

- behindern

- seine

- Hit

- schlagen

- ein Geschenk

- Ultraschall

- Hilfe

- HTTPS

- Huang

- Hungrig

- i

- if

- Bild

- unmittelbar

- Impact der HXNUMXO Observatorien

- wichtig

- beeindruckend

- zu unterstützen,

- Verbesserung

- in

- zunehmend

- Energiegewinnung

- Ineffizienzen

- Informiert

- Infrastruktur

- Innovation

- Intelligenz

- wollen

- verbunden

- Interesse

- Interview

- Einführung

- Investition

- Investor

- Investoren

- Isolierung

- IT

- SEINE

- Jensen Huang

- jpg

- nur

- Behalten

- Art

- Wissen

- Labor

- Labs

- Landschaft

- Sprachen

- grosse

- größer

- Nachname

- Letztes Jahr

- Latency

- Recht

- Führer

- führenden

- gelernt

- am wenigsten

- geführt

- lassen

- Gefällt mir

- ll

- llm

- Lang

- lange Zeit

- länger

- aussehen

- sah

- suchen

- Los

- Sneaker

- Senkung

- Maschine

- Maschinen

- gemacht

- um

- MACHT

- Making

- verwalten

- viele

- Markt

- Marktführer

- Mathematik

- Materie

- max-width

- maximal

- Kann..

- me

- Mittel

- Triff

- Mitglieder

- Memory

- erwähnt

- nur

- ineinander greifen

- sorgfältig

- Metrik

- Million

- minimal

- Fehler

- Modell

- für

- modern

- Moment

- mehr

- vor allem warme

- viel

- multidisziplinär

- my

- NASA

- Need

- erforderlich

- benötigen

- Netzwerke

- Neural

- Neuronale Netze

- Neu

- weiter

- nicht

- Knoten

- Fiber Node

- beachten

- Notion

- November

- jetzt an

- Kernenergie

- Anzahl

- Zahlen

- of

- bieten

- on

- einmal

- EINEM

- einzige

- OpenAI

- Optimierungen

- Optimieren

- Option

- or

- Auftrag

- gewöhnlich

- Andere

- Anders

- UNSERE

- uns

- Reichweite

- übrig

- Überholung

- besitzen

- Eigentum

- Frieden

- Paradigma

- Parallel

- Parameter

- Teil

- Teile

- passt

- Weg

- pflastern

- Personen

- Leistung

- Phasenweise

- wählen

- Drehpunkt

- Länder/Regionen

- Pläne

- Plattform

- Plattformen

- Plato

- Datenintelligenz von Plato

- PlatoData

- erfahren

- Points

- Perspektive

- tragbar

- Position

- für einige Positionen

- positiv

- möglich

- Post

- Potenzial

- möglicherweise

- Werkzeuge

- größte treibende

- Praktisch

- ziemlich

- verhindern

- in erster Linie

- Grundsätze

- Aufgabenstellung:

- Probleme

- Verarbeitung

- Prozessor

- Produkt

- Produktion

- Produkte

- Programm

- Programmierung

- Programmiersprachen

- Projekte

- immobilien

- Vorschlag

- Aussicht

- Proteine

- zuverlässig

- vorausgesetzt

- Anbieter

- Öffentlichkeit

- rein

- Zweck

- Schieben

- Abfragen

- Rennen

- Renn-

- erhöhen

- geschafft

- Erhöhung

- selten

- Lesen Sie mehr

- wirklich

- Grund

- Software Empfehlungen

- neu definieren

- Redesign

- Veteran

- Bezugnahme

- raffiniert

- in Bezug auf

- neu gedacht

- Release

- freigegeben

- verlassen

- erfordert

- Ressourcen

- Downloads

- Verantwortung

- REST

- Folge

- Die Ergebnisse

- Einzelhandel

- Recht

- Risiken

- Riskant

- Fahrplan

- Robotik

- Roboter

- Rollen

- rund

- rund

- Ohne eine erfahrene Medienplanung zur Festlegung von Regeln und Strategien beschleunigt der programmatische Medieneinkauf einfach die Rate der verschwenderischen Ausgaben.

- Laufen

- opfern

- Safe

- Said

- gleich

- Speichern

- sagen

- skalierbaren

- Skalieren

- Skalierung

- Zeitplan

- vorgesehen

- sehen

- Samen

- Saatgutfinanzierung

- Samenrunde

- Suchen

- scheint

- gesehen

- selektiv

- Halbleiter

- Sinn

- Modellreihe

- Serie A

- brauchen

- serviert

- Dienstleister

- kompensieren

- mehrere

- Gestaltung

- verschieben

- sollte

- präsentiert

- Sehenswertes

- signifikant

- bedeutet

- Silizium

- Simulation

- Simulationen

- Simulator

- gleichzeitig

- da

- Single

- beträchtlich

- Schlitten

- kleinere

- So

- Gesellschaft

- Software

- Lösung

- Lösungen

- LÖSEN

- gelöst

- Auflösung

- einige

- Klingen

- Geräusche

- Raumfahrt

- Weltraumforschung

- räumlich

- spezifisch

- speziell

- Geschwindigkeit

- Geschwindigkeiten

- Stapel

- Stacks

- Staffelung

- Anfang

- begonnen

- Anfang

- Startups

- Immer noch

- Stoppen

- Strategie

- Schritte

- stark

- Struggling

- erfolgreich

- so

- geeignet

- Summe

- Support

- Unterstützt

- vermutet

- Überraschung

- nachhaltiger

- System

- systemisch

- Systeme und Techniken

- zugeschnitten

- Nehmen

- nimmt

- Einnahme

- Reden

- Band

- Target

- Ziele

- Team

- Tech

- Technologie

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Zukunft

- Die Landschaft

- die Welt

- ihr

- Sie

- dann

- Dort.

- Thermal-

- Diese

- vom Nutzer definierten

- think

- fehlen uns die Worte.

- diejenigen

- obwohl?

- tausend

- Durch

- Durchsatz

- Zeit

- Reifen

- zu

- heute

- gemeinsam

- auch

- nahm

- Gesamt

- zäh

- gegenüber

- verfolgen sind

- Trading

- Training

- Ausbildung

- Flugbahn

- Transformativ

- Übergang

- Übergänge

- Trends

- Trick

- was immer dies auch sein sollte.

- wirklich

- versuchen

- XNUMX

- Typen

- für

- verstehen

- Einheit

- entsperrt

- auf

- us

- -

- Verwendung von

- BESTÄTIGEN

- Wert

- verschiedene

- VC

- VC-Finanzierung

- VCs

- sehr

- lebensfähig

- Anzeigen

- Seh-

- warten

- wollen

- Warehouse

- wurde

- we

- Gewicht

- GUT

- gut definiert

- ging

- waren

- Was

- wann

- ob

- welche

- während

- warum

- werden wir

- mit

- ohne

- Worte

- Arbeiten

- Arbeitsablauf.

- arbeiten,

- Werk

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- weltweit

- würde

- Jahr

- Jahr

- ja

- U

- Ihr

- Zephyrnet