Einleitung

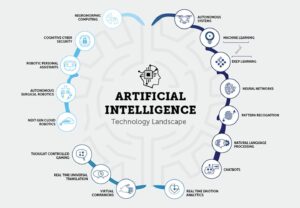

Da der Bereich der künstlichen Intelligenz (KI) weiter wächst und sich weiterentwickelt, wird es für angehende KI-Entwickler immer wichtiger, über die neuesten Forschungsergebnisse und Fortschritte auf dem Laufenden zu bleiben. Eine der besten Möglichkeiten, dies zu tun, ist die Lektüre von AI Papers für GenAI-Entwickler, die wertvolle Einblicke in modernste Techniken und Algorithmen bieten. In diesem Artikel werden 15 wichtige KI-Papiere für GenAI-Entwickler untersucht. Diese Papiere behandeln verschiedene Themen, von der Verarbeitung natürlicher Sprache bis hin zu Computer Vision. Sie werden Ihr Verständnis von KI erweitern und Ihre Chancen auf Ihren ersten Job in diesem spannenden Bereich erhöhen.

Bedeutung von AI-Papieren für GenAI-Entwickler

AI Papers für GenAI-Entwickler ermöglichen es Forschern und Experten, ihre Erkenntnisse, Methoden und Durchbrüche mit der breiteren Community zu teilen. Durch die Lektüre dieser Artikel erhalten Sie Zugang zu den neuesten Fortschritten in der KI, sodass Sie immer einen Schritt voraus sind und bei Ihrer Arbeit fundierte Entscheidungen treffen können. Darüber hinaus bieten AI Papers für GenAI-Entwickler häufig detaillierte Erläuterungen zu Algorithmen und Techniken, die Ihnen ein tieferes Verständnis dafür vermitteln, wie sie funktionieren und wie sie auf reale Probleme angewendet werden können.

Das Lesen von AI Papers für GenAI-Entwickler bietet angehenden KI-Entwicklern mehrere Vorteile. Erstens hilft es Ihnen, über die neuesten Forschungsergebnisse und Trends auf diesem Gebiet auf dem Laufenden zu bleiben. Dieses Wissen ist bei Bewerbungen für KI-bezogene Stellen von entscheidender Bedeutung, da Arbeitgeber häufig nach Kandidaten suchen, die mit den neuesten Entwicklungen vertraut sind. Darüber hinaus können Sie durch das Lesen von KI-Artikeln Ihr Wissen erweitern und ein tieferes Verständnis der KI-Konzepte und -Methoden erlangen. Dieses Wissen kann auf Ihre Projekte und Forschung angewendet werden und macht Sie zu einem kompetenteren und erfahreneren KI-Entwickler.

Inhaltsverzeichnis

Ein Überblick: Grundlegende KI-Papiere für GenAI-Entwickler mit Links

Papier 1: Transformatoren: Aufmerksamkeit ist alles, was Sie brauchen

Link: Lesen Sie hier

Papierzusammenfassung

Der Artikel stellt den Transformer vor, eine neuartige neuronale Netzwerkarchitektur für Sequenztransduktionsaufgaben wie maschinelle Übersetzung. Im Gegensatz zu herkömmlichen Modellen, die auf wiederkehrenden oder Faltungs-Neuronalen Netzen basieren, verlässt sich der Transformer ausschließlich auf Aufmerksamkeitsmechanismen, wodurch Wiederholungen und Faltungen nicht erforderlich sind. Die Autoren argumentieren, dass diese Architektur eine überlegene Leistung in Bezug auf Übersetzungsqualität, erhöhte Parallelisierbarkeit und kürzere Trainingszeit bietet.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- Aufmerksamkeitsmechanismus

Der Transformer basiert vollständig auf Aufmerksamkeitsmechanismen und ermöglicht es ihm, globale Abhängigkeiten zwischen Eingabe- und Ausgabesequenzen zu erfassen. Dieser Ansatz ermöglicht es dem Modell, Beziehungen zu berücksichtigen, ohne durch den Abstand zwischen Elementen in den Sequenzen eingeschränkt zu sein.

- Parallelisierung

Ein großer Vorteil der Transformer-Architektur ist ihre erhöhte Parallelisierbarkeit. Herkömmliche wiederkehrende Modelle leiden unter der sequentiellen Berechnung, was die Parallelisierung zu einer Herausforderung macht. Das Design des Transformers ermöglicht eine effizientere Parallelverarbeitung während des Trainings und verkürzt so die Trainingszeiten.

- Überlegene Qualität und Effizienz

Der Artikel präsentiert experimentelle Ergebnisse zu maschinellen Übersetzungsaufgaben und zeigt, dass der Transformer im Vergleich zu bestehenden Modellen eine überlegene Übersetzungsqualität erreicht. Es übertrifft bisherige State-of-the-Art-Ergebnisse, einschließlich Ensemble-Modellen, deutlich. Darüber hinaus erreicht der Transformer diese Ergebnisse mit deutlich kürzerer Trainingszeit.

- Übersetzungsleistung

Bei der Englisch-Deutsch-Übersetzungsaufgabe des WMT 2014 erreicht das vorgeschlagene Modell einen BLEU-Wert von 28.4 und übertrifft damit die bisherigen besten Ergebnisse um mehr als 2 BLEU. Bei der Englisch-Französisch-Aufgabe ermittelt das Modell nach nur 41.8 Tagen Training auf acht GPUs einen neuen, hochmodernen BLEU-Wert für ein einzelnes Modell von 3.5.

- Verallgemeinerung auf andere AufgabenDie Autoren zeigen, dass sich die Transformer-Architektur gut auf Aufgaben über die maschinelle Übersetzung hinaus verallgemeinern lässt. Sie wenden das Modell erfolgreich auf das Parsen englischer Wahlkreise an und zeigen seine Anpassungsfähigkeit an verschiedene Sequenztransduktionsprobleme.

Papier 2: BERT: Vorschulung tiefer bidirektionaler Transformatoren für das Sprachverständnis

Link: Lesen Sie hier

Papierzusammenfassung

Das Vortraining des Sprachmodells hat sich zur Verbesserung verschiedener Aufgaben der Verarbeitung natürlicher Sprache als wirksam erwiesen. Der Artikel unterscheidet zwischen merkmalsbasierten und Feinabstimmungsansätzen für die Anwendung vorab trainierter Sprachdarstellungen. BERT wird eingeführt, um Einschränkungen bei Feinabstimmungsansätzen zu beseitigen, insbesondere die Unidirektionalitätsbeschränkung von Standardsprachmodellen. Das Papier schlägt ein „Masked Language Model“ (MLM)-Vortrainingsziel vor, das von der Lückentext-Aufgabe inspiriert ist, um bidirektionale Darstellungen zu ermöglichen. Eine Aufgabe zur „Vorhersage des nächsten Satzes“ wird auch verwendet, um Textpaardarstellungen gemeinsam vorab zu trainieren.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- Bidirektionale Bedeutung vor dem Training

Der Artikel betont die Bedeutung des bidirektionalen Vortrainings für Sprachdarstellungen. Im Gegensatz zu früheren Modellen verwendet BERT maskierte Sprachmodelle, um tiefe bidirektionale Darstellungen zu ermöglichen, und übertrifft damit die in früheren Arbeiten verwendeten unidirektionalen Sprachmodelle.

- Reduzierung aufgabenspezifischer Architekturen

BERT zeigt, dass vorab trainierte Darstellungen den Bedarf an hochentwickelten aufgabenspezifischen Architekturen verringern. Es ist das erste auf Feinabstimmung basierende Darstellungsmodell, das bei einer Vielzahl von Aufgaben auf Satz- und Token-Ebene eine hochmoderne Leistung erzielt und aufgabenspezifische Architekturen übertrifft.

- Modernste Fortschritte

BERT erzielt bei elf Aufgaben der Verarbeitung natürlicher Sprache neue, hochmoderne Ergebnisse und stellt damit seine Vielseitigkeit unter Beweis. Zu den bemerkenswerten Verbesserungen gehören eine erhebliche Steigerung des GLUE-Scores, der MultiNLI-Genauigkeit und Verbesserungen bei den Frage-Antwort-Aufgaben in SQuAD v1.1 und v2.0.

Sie können auch lesen: Feinabstimmung von BERT mit maskierter Sprachmodellierung

Papier 3: GPT: Sprachmodelle sind Few-Shot-Lernende

Link: Lesen Sie hier

Papierzusammenfassung

Das Papier erörtert die Verbesserungen, die bei Aufgaben der Verarbeitung natürlicher Sprache (NLP) durch die Skalierung von Sprachmodellen erzielt werden, wobei der Schwerpunkt auf folgendem liegt: GPT-3 (Generative Pre-trained Transformer 3), ein autoregressives Sprachmodell mit 175 Milliarden Parametern. Die Autoren betonen dies, obwohl es noch nicht neu ist NLP-Modelle Obwohl sie durch Vorschulung und Feinabstimmung erhebliche Fortschritte erzielen, benötigen sie für die Feinabstimmung häufig aufgabenspezifische Datensätze mit Tausenden von Beispielen. Im Gegensatz dazu können Menschen neue Sprachaufgaben mit wenigen Beispielen oder einfachen Anweisungen ausführen.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- Durch die Skalierung wird die Few-Shot-Leistung verbessert

Die Autoren zeigen, dass die Skalierung von Sprachmodellen die aufgabenunabhängige Leistung mit wenigen Schüssen erheblich verbessert. GPT-3 erreicht aufgrund seiner großen Parametergröße manchmal Wettbewerbsfähigkeit mit hochmodernen Feinabstimmungsansätzen ohne aufgabenspezifische Feinabstimmung oder Gradientenaktualisierungen.

- Breite Anwendbarkeit

GPT-3 zeigt eine starke Leistung bei verschiedenen NLP-Aufgaben, einschließlich Übersetzung, Beantwortung von Fragen, Lückentextaufgaben und Aufgaben, die schnelles Denken oder Domänenanpassung erfordern. - Herausforderungen und Einschränkungen

Während GPT-3 bemerkenswerte Lernfähigkeiten mit wenigen Schüssen aufweist, identifizieren die Autoren Datensätze, bei denen es Schwierigkeiten bereitet, und heben methodische Probleme im Zusammenhang mit dem Training großer Webkorpora hervor. - Menschenähnliche Artikelgenerierung

GPT-3 kann Nachrichtenartikel generieren, die menschliche Bewerter nur schwer von Artikeln unterscheiden können, die von Menschen geschrieben wurden. - Gesellschaftliche Auswirkungen und umfassendere Überlegungen

Das Papier erörtert die umfassenderen gesellschaftlichen Auswirkungen der Fähigkeiten von GPT-3, insbesondere bei der Generierung menschenähnlicher Texte. Die Auswirkungen seiner Leistung bei verschiedenen Aufgaben werden im Hinblick auf praktische Anwendungen und potenzielle Herausforderungen betrachtet. - Einschränkungen aktueller NLP-Ansätze

Die Autoren heben die Einschränkungen aktueller NLP-Ansätze hervor, insbesondere ihre Abhängigkeit von aufgabenspezifischen Feinabstimmungsdatensätzen, die Herausforderungen mit sich bringen, wie etwa die Notwendigkeit großer gekennzeichneter Datensätze und das Risiko einer Überanpassung an enge Aufgabenverteilungen. Darüber hinaus bestehen Bedenken hinsichtlich der Generalisierungsfähigkeit dieser Modelle außerhalb der Grenzen ihrer Trainingsverteilung.

Artikel 4: CNNs: ImageNet-Klassifizierung mit Deep Convolutional Neural Networks

Link: Lesen Sie hier

Papierzusammenfassung

Der Artikel beschreibt die Entwicklung und das Training eines großen, tiefen Convolutional Neural Network (CNN) für die Bildklassifizierung anhand der ImageNet Large Scale Visual Recognition Challenge (ILSVRC)-Datensätze. Das Modell erzielt deutliche Verbesserungen der Klassifizierungsgenauigkeit im Vergleich zu bisherigen Methoden auf dem neuesten Stand der Technik.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- Modellarchitektur

Das in der Studie verwendete neuronale Netzwerk ist ein tiefes CNN mit 60 Millionen Parametern und 650,000 Neuronen. Es besteht aus fünf Faltungsschichten, auf einige gefolgt von Max-Pooling-Schichten, und drei vollständig verbundenen Schichten mit einem abschließenden 1000-Wege-Softmax zur Klassifizierung.

- Trainingsdaten

Das Modell wird anhand eines umfangreichen Datensatzes von 1.2 Millionen hochauflösenden Bildern aus dem ImageNet ILSVRC-2010-Wettbewerb trainiert. Der Trainingsprozess umfasst die Klassifizierung von Bildern in 1000 verschiedene Klassen.

- Leistung

Das Modell erreicht Top-1- und Top-5-Fehlerraten von 37.5 % bzw. 17.0 % der Testdaten. Diese Fehlerquoten sind erheblich besser als beim bisherigen Stand der Technik, was die Wirksamkeit des vorgeschlagenen Ansatzes unterstreicht.

- Verbesserungen bei der Überanpassung

Das Papier stellt mehrere Techniken zur Behebung von Überanpassungsproblemen vor, darunter nicht sättigende Neuronen, eine effiziente GPU-Implementierung für schnelleres Training und eine Regularisierungsmethode namens „Dropout“ in vollständig verbundenen Schichten. - Recheneffizienz

Trotz der Rechenanforderungen, die das Training großer CNNs mit sich bringt, stellt das Papier fest, dass aktuelle GPUs und optimierte Implementierungen es möglich machen, solche Modelle auf hochauflösenden Bildern zu trainieren.

- Beiträge

Das Papier hebt die Beiträge der Studie hervor, darunter das Training eines der größten Faltungs-Neuronalen Netze auf ImageNet-Datensätzen und das Erreichen hochmoderner Ergebnisse bei ILSVRC-Wettbewerben.

Sie können auch lesen: Ein umfassendes Tutorial zum Erlernen von Faltungs-Neuronalen Netzen

Papier 5: GATs: Graph Attention Networks

Link: Lesen Sie hier

Papierzusammenfassung

Das Papier stellt eine aufmerksamkeitsbasierte Architektur für die Knotenklassifizierung in graphstrukturierten Daten vor und demonstriert deren Effizienz, Vielseitigkeit und Wettbewerbsleistung in verschiedenen Benchmarks. Die Einbeziehung von Aufmerksamkeitsmechanismen erweist sich als leistungsstarkes Werkzeug für den Umgang mit beliebig strukturierten Diagrammen.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- Graph Attention Networks (GATs)GATs nutzen maskierte Selbstaufmerksamkeitsschichten, um Einschränkungen früherer Methoden zu beheben, die auf Graphfaltungen basieren. Die Architektur ermöglicht es Knoten, die Merkmale ihrer Nachbarschaften zu überwachen und dabei implizit unterschiedliche Gewichtungen für verschiedene Knoten festzulegen, ohne sich auf kostspielige Matrixoperationen oder vorherige Kenntnisse der Graphenstruktur verlassen zu müssen.

- Bewältigung spektralbasierter Herausforderungen

GATs adressieren gleichzeitig mehrere Herausforderungen in spektralbasierten graphischen neuronalen Netzen. Zu den Herausforderungen des Graph Attention Network (GAT) gehören räumlich lokalisierte Filter, intensive Berechnungen und nicht räumlich lokalisierte Filter. Darüber hinaus hängen GATs von der Laplace-Eigenbasis ab, was zu ihrer Anwendbarkeit auf induktive und transduktive Probleme beiträgt.

- Leistung über Benchmarks hinweg

GAT-Modelle erzielen oder erreichen Ergebnisse auf dem neuesten Stand der Technik in vier etablierten Diagramm-Benchmarks: Cora-, Citeseer- und Pubmed-Zitiernetzwerk-Datensätzen sowie einem Protein-Protein-Interaktionsdatensatz. Diese Benchmarks decken sowohl transduktive als auch induktive Lernszenarien ab und verdeutlichen die Vielseitigkeit von GATs.

- Vergleich mit früheren Ansätzen

Das Papier bietet einen umfassenden Überblick über frühere Ansätze, einschließlich rekursiver neuronaler Netze, Graph Neuronale Netze (GNNs), spektrale und nicht-spektrale Methoden und Aufmerksamkeitsmechanismen. GATs beinhalten Aufmerksamkeitsmechanismen, die eine effiziente Parallelisierung über Knoten-Nachbar-Paare hinweg und die Anwendung auf Knoten mit unterschiedlichem Grad ermöglichen.

- Effizienz und AnwendbarkeitGATs bieten eine parallelisierbare, effiziente Operation, die auf Graphknoten mit unterschiedlichem Grad angewendet werden kann, indem den Nachbarn beliebige Gewichtungen zugewiesen werden. Das Modell lässt sich direkt auf induktive Lernprobleme anwenden und eignet sich daher für Aufgaben, bei denen eine Verallgemeinerung auf völlig unsichtbare Diagramme erforderlich ist.

- Bezug zu Vorgängermodellen

Die Autoren stellen fest, dass GATs als eine bestimmte Instanz von MoNet umformuliert werden können, Ähnlichkeiten mit relationalen Netzwerken aufweisen und eine Verbindung zu Werken herstellen, die Nachbarschaftsaufmerksamkeitsoperationen nutzen. Das vorgeschlagene Aufmerksamkeitsmodell wird mit verwandten Ansätzen wie Duan et al. verglichen. (2017) und Denil et al. (2017).

Aufsatz 6: ViT: Ein Bild ist 16×16 Wörter wert: Transformatoren für die Bilderkennung im Maßstab

Link: Lesen Sie hier

Papierzusammenfassung

Das Papier erkennt die Dominanz von Faltungsarchitekturen in der Computer Vision trotz des Erfolgs von Transformer-Architekturen in der Verarbeitung natürlicher Sprache an. Inspiriert durch die Effizienz und Skalierbarkeit von Transformatoren im NLP wandten die Autoren einen Standardtransformator mit minimalen Änderungen direkt auf Bilder an.

Sie stellen die vor Vision-Transformer (ViT), wobei Bilder in Patches aufgeteilt werden und die Reihenfolge der linearen Einbettungen dieser Patches als Eingabe für den Transformer dient. Das Modell wird überwacht auf Bildklassifizierungsaufgaben trainiert. Beim Training mit mittelgroßen Datensätzen wie ImageNet ohne starke Regularisierung erreicht ViT zunächst Genauigkeiten, die leicht unter vergleichbaren ResNets liegen.

Die Autoren zeigen jedoch, dass eine groß angelegte Schulung für den Erfolg von ViT von entscheidender Bedeutung ist und über die Einschränkungen hinausgeht, die durch das Fehlen bestimmter induktiver Vorurteile entstehen. Wenn ViT auf riesigen Datensätzen vorab trainiert wird, übertrifft es modernste Faltungsnetzwerke bei mehreren Benchmarks, darunter ImageNet, CIFAR-100 und VTAB. Das Papier unterstreicht den Einfluss der Skalierung auf die Erzielung bemerkenswerter Ergebnisse mit Transformer-Architekturen in der Computer Vision.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- Transformator in Computer Vision

Das Papier stellt die vorherrschende Abhängigkeit von Faltungs-Neuronalen Netzen (CNNs) für Computer-Vision-Aufgaben in Frage. Es zeigt, dass ein reiner Transformer bei direkter Anwendung auf Sequenzen von Bildfeldern eine hervorragende Leistung bei Bildklassifizierungsaufgaben erzielen kann.

- Vision-Transformer (ViT)

Die Autoren stellen den Vision Transformer (ViT) vor, ein Modell, das Selbstaufmerksamkeitsmechanismen ähnlich den Transformers im NLP nutzt. ViT kann bei verschiedenen Bilderkennungs-Benchmarks, darunter ImageNet, CIFAR-100 und VTAB, wettbewerbsfähige Ergebnisse erzielen.

- Vorschulung und Transferlernen

Der Artikel betont, wie wichtig es ist, große Datenmengen vorab zu trainieren, ähnlich wie beim NLP-Ansatz, und die erlernten Darstellungen dann auf spezifische Bilderkennungsaufgaben zu übertragen. Wenn ViT vorab auf riesigen Datensätzen wie ImageNet-21k oder JFT-300M trainiert wird, übertrifft es modernste Faltungsnetzwerke bei verschiedenen Benchmarks.

- RecheneffizienzViT erzielt bemerkenswerte Ergebnisse mit wesentlich weniger Rechenressourcen während des Trainings als hochmoderne Faltungsnetzwerke. Diese Effizienz ist besonders bemerkenswert, wenn das Modell in großem Maßstab vorab trainiert wird.

- Skalierende Wirkung

Das Papier hebt die Bedeutung der Skalierung hervor, um mit Transformer-Architekturen in der Computer Vision eine überlegene Leistung zu erzielen. Umfangreiches Training an Datensätzen mit Millionen bis Hunderten von Millionen Bildern hilft ViT dabei, das Fehlen einiger induktiver Verzerrungen in CNNs zu überwinden.

Artikel 7: AlphaFold2: Hochpräzise Proteinstruktur mit AlphaFold

Link: Lesen Sie hier

Papierzusammenfassung

Der Artikel „AlphaFold2: Hochpräzise Proteinstruktur mit AlphaFold“ stellt AlphaFold2 vor, ein Deep-Learning-Modell, das Proteinstrukturen genau vorhersagt. AlphaFold2 nutzt eine neuartige aufmerksamkeitsbasierte Architektur und erzielt einen Durchbruch bei der Proteinfaltung.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- AlphaFold2 nutzt ein tiefes neuronales Netzwerk mit Aufmerksamkeitsmechanismen, um die 3D-Struktur von Proteinen anhand ihrer Aminosäuresequenzen vorherzusagen.

- Das Modell wurde anhand eines großen Datensatzes bekannter Proteinstrukturen trainiert und erreichte im Proteinfaltungswettbewerb 14th Critical Assessment of Protein Structure Prediction (CASP14) eine beispiellose Genauigkeit.

- Die genauen Vorhersagen von AlphaFold2 können möglicherweise die Arzneimittelforschung, das Protein-Engineering und andere Bereiche der Biochemie revolutionieren.

Artikel 8: GANs: Generative Adversarial Nets

Link: Lesen Sie hier

Papierzusammenfassung

Der Artikel befasst sich mit den Herausforderungen beim Training tiefer generativer Modelle und stellt einen innovativen Ansatz namens „Adversarial Nets“ vor. In diesem Rahmen spielen generative und diskriminative Modelle ein Spiel, bei dem das generative Modell darauf abzielt, Proben zu erzeugen, die nicht von realen Daten zu unterscheiden sind. Im Gegensatz dazu unterscheidet das diskriminative Modell zwischen realen und generierten Stichproben. Der kontradiktorische Trainingsprozess führt zu einer einzigartigen Lösung, bei der das generative Modell die Datenverteilung wiederherstellt.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- Kontradiktorischer Rahmen

Die Autoren stellen ein kontradiktorisches Framework vor, bei dem zwei Modelle gleichzeitig trainiert werden – ein generatives Modell (G), das die Datenverteilung erfasst, und ein diskriminatives Modell (D), das die Wahrscheinlichkeit schätzt, dass eine Stichprobe aus den Trainingsdaten und nicht aus dem generativen Modell stammt.

- Minimax-SpielDas Trainingsverfahren beinhaltet die Maximierung der Wahrscheinlichkeit, dass das Unterscheidungsmodell einen Fehler macht. Dieses Framework ist als Minimax-Spiel für zwei Spieler formuliert, bei dem das generative Modell darauf abzielt, Stichproben zu generieren, die nicht von realen Daten zu unterscheiden sind, und das diskriminative Modell darauf abzielt, zu klassifizieren, ob eine Stichprobe real ist oder korrekt generiert wurde.

- Einzigartige Lösung

Eine eindeutige Lösung existiert in beliebigen Funktionen für G und D, wobei G die Trainingsdatenverteilung wiederherstellt und D überall gleich 1/2 ist. Dieses Gleichgewicht wird durch den kontradiktorischen Trainingsprozess erreicht.

- Mehrschichtige Perzeptrons (MLPs)Die Autoren zeigen, dass das gesamte System mithilfe von Backpropagation trainiert werden kann, wenn mehrschichtige Perzeptrone G und D darstellen. Dadurch entfällt die Notwendigkeit von Markov-Ketten oder entrollten ungefähren Inferenznetzwerken während des Trainings und der Probengenerierung.

- Keine ungefähre Schlussfolgerung

Der vorgeschlagene Rahmen vermeidet die Schwierigkeiten bei der Approximation hartnäckiger probabilistischer Berechnungen bei der Maximum-Likelihood-Schätzung. Es überwindet auch Herausforderungen bei der Nutzung der Vorteile stückweise linearer Einheiten im generativen Kontext.

Artikel 9: RoBERTa: Ein robust optimierter BERT-Pretraining-Ansatz

Link: Lesen Sie hier

Papierzusammenfassung

Das Papier befasst sich mit dem Problem der unzureichenden Ausbildung von BERT und stellt RoBERTa vor, eine optimierte Version, die die Leistung von BERT übertrifft. Die Änderungen im Trainingsverfahren von RoBERTa und die Verwendung eines neuartigen Datensatzes (CC-NEWS) tragen zu hochmodernen Ergebnissen bei mehreren Aufgaben der Verarbeitung natürlicher Sprache bei. Die Ergebnisse unterstreichen die Bedeutung von Designentscheidungen und Trainingsstrategien für die Wirksamkeit des Vortrainings von Sprachmodellen. Die veröffentlichten Ressourcen, einschließlich des RoBERTa-Modells und -Codes, leisten einen Beitrag zur Forschungsgemeinschaft.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- BERT-Unterschulung

Das finden die Autoren BERT, ein weit verbreitetes Sprachmodell, war deutlich untertrainiert. Durch sorgfältige Bewertung der Auswirkungen der Hyperparameter-Abstimmung und der Trainingssatzgröße zeigen sie, dass BERT verbessert werden kann, um die Leistung aller danach veröffentlichten Modelle zu erreichen oder zu übertreffen.

- Verbessertes Trainingsrezept (RoBERTa)

Die Autoren führen Modifikationen am BERT-Trainingsverfahren ein, wodurch RoBERTa entsteht. Diese Änderungen umfassen längere Trainingsperioden mit größeren Stapeln, die Eliminierung des nächsten Satzvorhersageziels, das Training auf längeren Sequenzen und dynamische Maskierungsmusteranpassungen für Trainingsdaten.

- Beitrag zum DatensatzDas Papier stellt einen neuen Datensatz namens CC-NEWS vor, dessen Größe mit anderen privat genutzten Datensätzen vergleichbar ist. Die Einbeziehung dieses Datensatzes trägt dazu bei, die Auswirkungen der Trainingssatzgröße besser zu kontrollieren und trägt zu einer verbesserten Leistung bei nachgelagerten Aufgaben bei.

- Leistungserfolge

RoBERTa erzielt mit den vorgeschlagenen Modifikationen Ergebnisse auf dem neuesten Stand der Technik bei verschiedenen Benchmark-Aufgaben, darunter GLUE, RACE und SQuAD. Es erreicht oder übertrifft die Leistung aller Post-BERT-Methoden bei Aufgaben wie MNLI, QNLI, RTE, STS-B, SQuAD und RACE.

- Wettbewerbsfähigkeit des Vortrainings für maskierte Sprachmodelle

Das Papier bekräftigt, dass das Vortrainingsziel des maskierten Sprachmodells mit den richtigen Designentscheidungen mit anderen kürzlich vorgeschlagenen Trainingszielen konkurrenzfähig ist.

- Freigegebene Ressourcen

Die Autoren veröffentlichen ihr RoBERTa-Modell zusammen mit dem in PyTorch implementierten Vortrainings- und Feinabstimmungscode und tragen so zur Reproduzierbarkeit und weiteren Erforschung ihrer Ergebnisse bei.

Lesen Sie auch: Eine sanfte Einführung in RoBERTa

Artikel 10: NeRF: Darstellung von Szenen als neuronale Strahlungsfelder für die Ansichtssynthese

Link: Lesen Sie hier

Papierzusammenfassung

Bei der Optimierung geht es darum, den Fehler zwischen beobachteten Bildern mit bekannten Kamerapositionen und den aus der kontinuierlichen Szenendarstellung gerenderten Ansichten zu minimieren. Das Papier geht auf Herausforderungen im Zusammenhang mit Konvergenz und Effizienz ein, indem es eine Positionscodierung zur Verarbeitung höherfrequenter Funktionen einführt und ein hierarchisches Abtastverfahren vorschlägt, um die Anzahl der für eine angemessene Abtastung erforderlichen Abfragen zu reduzieren.

Wichtige Erkenntnisse aus KI-Papieren für GenAI-Entwickler

- Kontinuierliche Szenendarstellung

Der Artikel stellt eine Methode zur Darstellung komplexer Szenen als neuronale 5D-Strahlungsfelder unter Verwendung grundlegender Multilayer-Perceptron-Netzwerke (MLP) vor.

- Differenzierbares Rendering

Das vorgeschlagene Rendering-Verfahren basiert auf klassischen Volumen-Rendering-Techniken und ermöglicht eine verlaufsbasierte Optimierung unter Verwendung von Standard-RGB-Bildern.

- Hierarchische Stichprobenstrategie

Es wird eine hierarchische Sampling-Strategie eingeführt, um die MLP-Kapazität für Bereiche mit sichtbarem Szeneninhalt zu optimieren und Konvergenzprobleme anzugehen.

- PositionskodierungDie Verwendung der Positionskodierung zur Abbildung eingegebener 5D-Koordinaten in einen höherdimensionalen Raum ermöglicht die erfolgreiche Optimierung neuronaler Strahlungsfelder für hochfrequente Szeneninhalte.

Die vorgeschlagene Methode übertrifft modernste Ansichtssyntheseansätze, einschließlich der Anpassung neuronaler 3D-Darstellungen und des Trainings tiefer Faltungsnetzwerke. In diesem Artikel wird eine kontinuierliche neuronale Szenendarstellung zum Rendern hochauflösender, fotorealistischer neuartiger Ansichten aus RGB-Bildern in natürlichen Umgebungen vorgestellt. Zusätzliche Vergleiche werden im Zusatzvideo gezeigt, um ihre Wirksamkeit bei der Handhabung komplexer Szenengeometrie und -erscheinung hervorzuheben.

Artikel 11: FunSearch: Mathematische Entdeckungen aus der Programmsuche mit großen Sprachmodellen

Link: Lesen Sie hier

Papierzusammenfassung

Der Artikel stellt FunSearch vor, einen neuartigen Ansatz zur Nutzung großer Sprachmodelle (LLMs) zur Lösung komplexer Probleme, insbesondere in der wissenschaftlichen Entdeckung. Die größte Herausforderung ist das Auftreten von Konfabulationen (Halluzinationen) bei LLMs, die zu plausiblen, aber falschen Aussagen führen. FunSearch kombiniert ein vorab trainiertes LLM mit einem systematischen Evaluator in einem evolutionären Verfahren, um diese Einschränkung zu überwinden.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- Problemlösung mit LLMs

Das Papier befasst sich mit dem Problem, dass LLMs konfabulieren oder nicht in der Lage sind, neue Ideen und korrekte Lösungen für komplexe Probleme zu generieren. Es betont, wie wichtig es ist, neue, nachweislich richtige Ideen zu finden, insbesondere für mathematisch-naturwissenschaftliche Herausforderungen.

- Evolutionäres Verfahren – FunSearch

FunSearch kombiniert einen vorab trainierten LLM mit einem Evaluator in einem evolutionären Prozess. Es entwickelt iterativ Programme mit niedriger Punktzahl zu Programmen mit hoher Punktzahl weiter und stellt so die Entdeckung neuen Wissens sicher. Der Prozess umfasst Best-Shot-Eingabeaufforderungen, die Weiterentwicklung von Programmgerüsten, die Aufrechterhaltung der Programmvielfalt und die asynchrone Skalierung.

- Anwendung auf extreme Kombinatorik

Der Artikel demonstriert die Wirksamkeit von FunSearch beim Cap-Set-Problem in der extremen Kombinatorik. FunSearch entdeckt neue Konstruktionen von Large-Cap-Mengen, übertrifft die bekanntesten Ergebnisse und bietet die größte Verbesserung der asymptotischen Untergrenze seit 20 Jahren.

- Algorithmisches Problem – Online-Bin-Packing

FunSearch wird auf das Online-Bin-Packing-Problem angewendet und führt zur Entdeckung neuer Algorithmen, die bei gut untersuchten interessierenden Verteilungen herkömmliche Algorithmen übertreffen. Zu den potenziellen Anwendungen gehört die Verbesserung von Job-Scheduling-Algorithmen.

- Programme vs. LösungenFunSearch konzentriert sich auf die Generierung von Programmen, die beschreiben, wie ein Problem gelöst werden kann, und nicht auf die direkte Ausgabe von Lösungen. Diese Programme sind tendenziell besser interpretierbar, erleichtern die Interaktion mit Fachexperten und sind einfacher bereitzustellen als andere Arten von Beschreibungen, wie etwa neuronale Netze.

- Interdisziplinäre Wirkung

Die Methodik von FunSearch ermöglicht die Untersuchung eines breiten Spektrums von Problemen und macht es zu einem vielseitigen Ansatz mit interdisziplinären Anwendungen. Das Papier hebt sein Potenzial hervor, mithilfe von LLMs überprüfbare wissenschaftliche Entdeckungen zu machen.

Artikel 12: VAEs: Auto-Encoding Variational Bayes

Link: Lesen Sie hier

Papierzusammenfassung

Der Artikel „Auto-Encoding Variational Bayes“ befasst sich mit der Herausforderung einer effizienten Inferenz und eines effizienten Lernens in gerichteten Wahrscheinlichkeitsmodellen mit kontinuierlichen latenten Variablen, insbesondere wenn die Posterior-Verteilungen unlösbar sind und es mit großen Datensätzen zu tun hat. Die Autoren schlagen einen stochastischen Variationsinferenz- und Lernalgorithmus vor, der sich gut für große Datensätze skalieren lässt und auch bei hartnäckigen Posteriorverteilungen anwendbar bleibt.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- Neuparametrisierung der Variationsuntergrenze

Der Artikel demonstriert eine Neuparametrisierung der Variationsuntergrenze, was zu einem Untergrenzenschätzer führt. Dieser Schätzer kann mithilfe standardmäßiger stochastischer Gradientenmethoden optimiert werden, was ihn rechnerisch effizient macht.

- Effiziente Posterior-Inferenz für kontinuierliche latente VariablenDie Autoren schlagen den Auto-Encoding VB (AEVB)-Algorithmus für Datensätze mit kontinuierlichen latenten Variablen pro Datenpunkt vor. Dieser Algorithmus nutzt den Stochastic Gradient Variational Bayes (SGVB)-Schätzer, um ein Erkennungsmodell zu optimieren und so eine effiziente approximative posteriore Inferenz durch Ahnenstichprobe zu ermöglichen. Dieser Ansatz vermeidet teure iterative Inferenzschemata wie Markov Chain Monte Carlo (MCMC) für jeden Datenpunkt.

- Theoretische Vorteile und experimentelle Ergebnisse

Die theoretischen Vorteile der vorgeschlagenen Methode spiegeln sich in den experimentellen Ergebnissen wider. Das Papier legt nahe, dass das Reparametrisierungs- und Erkennungsmodell zu Recheneffizienz und Skalierbarkeit führt und den Ansatz auf große Datensätze und in Situationen anwendbar macht, in denen das Posterior unlösbar ist.

Lies auch: Enthüllung der Essenz der Stochastik im maschinellen Lernen

Papier 13: LANGES KURZZEITGEDÄCHTNIS

Link: Lesen Sie hier

Papierzusammenfassung

Der Artikel befasst sich mit der Herausforderung, zu lernen, Informationen über längere Zeitintervalle in rekurrenten neuronalen Netzen zu speichern. Es stellt eine neuartige, effiziente, auf Gradienten basierende Methode namens „Long Short-Term Memory“ (LSTM) vor, die Probleme mit unzureichendem und abnehmendem Fehlerrückfluss überwindet. LSTM erzwingt einen konstanten Fehlerfluss durch „konstante Fehlerkarussells“ und verwendet multiplikative Gate-Einheiten zur Zugriffskontrolle. Bei der lokalen Raum-Zeit-Komplexität (O(1) pro Zeitschritt und Gewicht) zeigen experimentelle Ergebnisse, dass LSTM bestehende Algorithmen hinsichtlich Lerngeschwindigkeit und Erfolgsraten übertrifft, insbesondere bei Aufgaben mit längeren Zeitverzögerungen.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- Problemanalyse

Das Papier bietet eine detaillierte Analyse der Herausforderungen, die mit dem Fehlerrückfluss in wiederkehrenden neuronalen Netzen verbunden sind, und hebt die Probleme hervor, die dazu führen können, dass Fehlersignale im Laufe der Zeit entweder explodieren oder verschwinden.

- Einführung von LSTM

Die Autoren stellen LSTM als eine neuartige Architektur vor, die darauf ausgelegt ist, die Probleme verschwindender und explodierender Fehlersignale zu lösen. LSTM beinhaltet einen konstanten Fehlerfluss durch spezialisierte Einheiten und verwendet multiplikative Gate-Einheiten, um den Zugriff auf diesen Fehlerfluss zu regulieren.

- Experimentelle Ergebnisse

Durch Experimente mit künstlichen Daten zeigt das Papier, dass LSTM andere wiederkehrende Netzwerkalgorithmen übertrifft, darunter BPTT, RTRL, wiederkehrende Kaskadenkorrelation, Elman-Netze und Neural Sequence Chunking. LSTM zeigt schnelleres Lernen und höhere Erfolgsquoten, insbesondere bei der Lösung komplexer Aufgaben mit großen Zeitverzögerungen.

- Lokal in Raum und Zeit

LSTM wird als lokale Architektur in Raum und Zeit beschrieben, wobei die Rechenkomplexität pro Zeitschritt und Gewicht O(1) beträgt.

- Anwendbarkeit

Die vorgeschlagene LSTM-Architektur löst effektiv komplexe, künstliche Langzeitverzögerungsaufgaben, die von früheren wiederkehrenden Netzwerkalgorithmen nicht erfolgreich gelöst werden konnten.

- Einschränkungen und Vorteile

Das Papier erörtert die Einschränkungen und Vorteile von LSTM und bietet Einblicke in die praktische Anwendbarkeit der vorgeschlagenen Architektur.

Lies auch: Was ist LSTM? Einführung in das lange Kurzzeitgedächtnis

Artikel 14: Erlernen übertragbarer visueller Modelle aus der Überwachung natürlicher Sprache

Link: Lesen Sie hier

Papierzusammenfassung

Der Artikel untersucht das Training hochmoderner Computer-Vision-Systeme durch direktes Lernen aus Rohtext über Bilder, anstatt sich auf feste Sätze vorgegebener Objektkategorien zu verlassen. Die Autoren schlagen eine Vortrainingsaufgabe vor, um vorherzusagen, welche Bildunterschrift einem bestimmten Bild entspricht, und zwar unter Verwendung eines Datensatzes von 400 Millionen (Bild-, Text-)Paaren, die aus dem Internet gesammelt wurden. Das resultierende Modell, CLIP (Contrastive Language-Image Pre-Training), demonstriert effizientes und skalierbares Lernen von Bilddarstellungen. Nach dem Vortraining referenziert die natürliche Sprache visuelle Konzepte und ermöglicht so eine Zero-Shot-Übertragung auf verschiedene nachgelagerte Aufgaben. CLIP wird anhand von über 30 Computer-Vision-Datensätzen bewertet und zeigt die Wettbewerbsleistung ohne aufgabenspezifisches Training.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

- Schulung zu natürlicher Sprache für Computer Vision

Der Artikel untersucht die Verwendung natürlicher Sprachüberwachung zum Trainieren von Computer-Vision-Modellen anstelle des traditionellen Trainingsansatzes für Crowd-Label-Datensätze wie ImageNet.

- Aufgabe vor dem TrainingDie Autoren schlagen eine einfache Vortrainingsaufgabe vor: Vorhersagen, welche Bildunterschrift einem bestimmten Bild entspricht. Diese Aufgabe wird verwendet, um hochmoderne Bilddarstellungen anhand eines riesigen Datensatzes von 400 Millionen online gesammelten (Bild-, Text-)Paaren von Grund auf zu erlernen.

- Zero-Shot-Übertragung

Nach dem Vortraining nutzt das Modell natürliche Sprache, um erlernte visuelle Konzepte zu referenzieren oder neue zu beschreiben. Dies ermöglicht eine Zero-Shot-Übertragung des Modells auf nachgelagerte Aufgaben, ohne dass ein spezielles Datensatztraining erforderlich ist.

- Benchmarking für verschiedene Aufgaben

Das Papier bewertet die Leistung des vorgeschlagenen Ansatzes anhand von über 30 verschiedenen Computer-Vision-Datensätzen und deckt Aufgaben wie OCR, Aktionserkennung in Videos, Geolokalisierung und feinkörnige Objektklassifizierung ab.

- Wettbewerbsleistung

Das Modell zeigt eine Wettbewerbsleistung mit vollständig überwachten Basislinien für verschiedene Aufgaben und erreicht oder übertrifft häufig die Genauigkeit von Modellen, die auf aufgabenspezifischen Datensätzen ohne zusätzliches datensatzspezifisches Training trainiert wurden.

- Skalierbarkeitsstudie

Die Autoren untersuchen die Skalierbarkeit ihres Ansatzes, indem sie eine Reihe von acht Modellen mit unterschiedlichen Rechenressourcen trainieren. Es stellt sich heraus, dass die Übertragungsleistung eine reibungslos vorhersagbare Funktion des Rechnens ist.

- Modellrobustheit

Das Papier hebt hervor, dass Zero-Shot-CLIP-Modelle robuster sind als überwachte ImageNet-Modelle mit gleicher Genauigkeit, was darauf hindeutet, dass die Zero-Shot-Bewertung von aufgabenunabhängigen Modellen ein repräsentativeres Maß für die Leistungsfähigkeit eines Modells darstellt.

Papier 15: LORA: NIEDRIGE ANPASSUNG GROSSER SPRACHENMODELLE

Link: Lesen Sie hier

Papierzusammenfassung

Das Papier schlägt LoRA als effiziente Methode zur Anpassung großer vorab trainierter Sprachmodelle an bestimmte Aufgaben vor und bewältigt so die mit ihrer zunehmenden Größe verbundenen Bereitstellungsherausforderungen. Die Methode reduziert die trainierbaren Parameter und den GPU-Speicherbedarf erheblich und sorgt gleichzeitig für die Beibehaltung oder Verbesserung der Modellqualität über verschiedene Benchmarks hinweg. Die Open-Source-Implementierung erleichtert die Einführung von LoRA in praktische Anwendungen zusätzlich.

Wichtige Erkenntnisse aus AI-Papieren für GenAI-Entwickler

1. Problem Statement

- Ein umfangreiches Vortraining mit anschließender Feinabstimmung ist ein gängiger Ansatz bei der Verarbeitung natürlicher Sprache.

- Eine Feinabstimmung wird mit zunehmender Modellgröße immer schwieriger, insbesondere bei der Bereitstellung von Modellen mit umfangreichen Parametern wie GPT-3 (175 Milliarden Parameter).

2. Vorgeschlagene Lösung: Low-Rank Adaptation (LoRA)

- Der Artikel stellt LoRA vor, eine Methode, die vorab trainierte Modellgewichte einfriert und trainierbare Rangzerlegungsmatrizen in jede Schicht der Transformer-Architektur einführt.

- LoRA reduziert die Anzahl der trainierbaren Parameter für nachgelagerte Aufgaben im Vergleich zur vollständigen Feinabstimmung erheblich.

3. Vorteile von LoRA

- Parameterreduzierung: Im Vergleich zur Feinabstimmung kann LoRA die Anzahl der trainierbaren Parameter um das bis zu 10,000-fache reduzieren, was die Recheneffizienz erhöht.

- Speichereffizienz: LoRA senkt den GPU-Speicherbedarf im Vergleich zur Feinabstimmung um das Dreifache.

- Modellqualität: Obwohl LoRA über weniger trainierbare Parameter verfügt, ist die Leistung hinsichtlich der Modellqualität bei verschiedenen Modellen, einschließlich RoBERTa, DeBERTa, GPT-2 und GPT-3, gleichwertig oder besser als die Feinabstimmung.

4. Herausforderungen bei der Bereitstellung meistern

- Das Papier befasst sich mit der Herausforderung, Modelle mit vielen Parametern bereitzustellen, indem LoRA eingeführt wird, was einen effizienten Aufgabenwechsel ermöglicht, ohne das gesamte Modell neu zu trainieren.

5. Effizienz und geringe Inferenzlatenz

- LoRA erleichtert die gemeinsame Nutzung eines vorab trainierten Modells zum Erstellen mehrerer LoRA-Module für verschiedene Aufgaben und reduziert so den Speicherbedarf und den Aufwand für den Aufgabenwechsel.

- Das Training wird effizienter gestaltet und die Hardware-Eintrittsbarriere wird durch den Einsatz adaptiver Optimierer um das Dreifache gesenkt.

6. Kompatibilität und Integration

- LoRA ist mit verschiedenen bisherigen Methoden kompatibel und kann mit diesen kombiniert werden, beispielsweise mit dem Präfix-Tuning.

- Das vorgeschlagene lineare Design ermöglicht das Zusammenführen trainierbarer Matrizen mit eingefrorenen Gewichten während der Bereitstellung, wodurch im Vergleich zu vollständig fein abgestimmten Modellen keine zusätzliche Inferenzlatenz entsteht.

7. Empirische Untersuchung

- Das Papier enthält eine empirische Untersuchung des Rangdefizits bei der Anpassung von Sprachmodellen und liefert Einblicke in die Wirksamkeit des LoRA-Ansatzes.

8. Open-Source-Implementierung

- Die Autoren stellen ein Paket bereit, das die Integration von LoRA mit PyTorch-Modellen erleichtert und Implementierungen und Modellprüfpunkte für RoBERTa, DeBERTa und GPT-2 veröffentlicht.

Sie können auch lesen: Parametereffiziente Feinabstimmung großer Sprachmodelle mit LoRA und QLoRA

Zusammenfassung

Zusammenfassend lässt sich sagen, dass die Auseinandersetzung mit den 15 wesentlichen KI-Papieren für GenAI-Entwickler, die in diesem Artikel hervorgehoben werden, nicht nur eine Empfehlung, sondern eine strategische Notwendigkeit für jeden angehenden Entwickler ist. Diese KI-Artikel bieten eine umfassende Reise durch die vielfältige Landschaft der künstlichen Intelligenz und umfassen kritische Bereiche wie die Verarbeitung natürlicher Sprache, Computer Vision und darüber hinaus. Durch das Eintauchen in die Erkenntnisse und Innovationen, die in diesen Artikeln präsentiert werden, erlangen Entwickler ein tiefgreifendes Verständnis der modernsten Techniken und Algorithmen auf diesem Gebiet.

Verbunden

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.analyticsvidhya.com/blog/2024/01/essential-ai-papers-every-gen-ai-developer-must-read/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 000

- 1

- 10

- 11

- 12

- 13

- 14

- 15%

- 17

- 20

- 20 Jahre

- 2014

- 2017

- 28

- 30

- 3d

- 400

- 41

- 60

- 7

- 8

- 9

- 913

- a

- Fähigkeit

- LiveBuzz

- AC

- Zugang

- Genauigkeit

- genau

- genau

- Erreichen

- erreicht

- Erreicht

- Erreichen

- über

- Action

- Anpassung

- adaptiv

- Zusätzliche

- zusätzlich

- Adresse

- angesprochen

- Adressen

- Adressierung

- Anpassungen

- Adoption

- Fortschritte

- Vorteil

- Vorteilen

- widersprüchlich

- Nach der

- voraus

- AI

- Ziel

- AL

- Algorithmus

- Algorithmen

- Alle

- erlauben

- Zulassen

- erlaubt

- entlang

- ebenfalls

- Beträge

- an

- Analyse

- und

- jedem

- anwendbar

- Anwendung

- Anwendungen

- angewandt

- gilt

- Bewerben

- Anwendung

- Ansatz

- Ansätze

- ungefähr

- Architektur

- SIND

- Bereiche

- argumentieren

- entstehen

- Artikel

- Artikel

- künstlich

- künstliche Intelligenz

- Künstliche Intelligenz (AI)

- AS

- strebend

- Bewertung

- damit verbundenen

- At

- besuchen

- Aufmerksamkeit

- Autoren

- Barriere

- basierend

- basic

- BE

- wird

- Sein

- unten

- Benchmark

- Benchmarking

- Benchmarks

- Vorteile

- BESTE

- Besser

- zwischen

- Beyond

- Vorurteile

- Milliarde

- BIN

- Auftrieb

- beide

- gebunden

- Durchbruch

- Durchbrüche

- breiteres

- Building

- erbaut

- aber

- by

- namens

- kam

- Kamera

- CAN

- Kandidaten

- Kappe

- Fähigkeiten

- capability

- Kapazität

- Erfassung

- Captures

- vorsichtig

- Kaskade

- Kategorien

- sicher

- Kette

- Ketten

- challenges

- Herausforderungen

- herausfordernd

- Chancen

- Änderungen

- Entscheidungen

- Unterricht

- Einstufung

- klassifizieren

- CNN

- Code

- kombiniert

- vereint

- gemeinsam

- community

- vergleichbar

- verglichen

- Vergleiche

- kompatibel

- kompetent

- Wettbewerb

- Ligen

- wettbewerbsfähig

- Wettbewerbsfähigkeit

- uneingeschränkt

- Komplex

- Komplexität

- umfassend

- Berechnung

- rechnerisch

- Berechnungen

- Computer

- Computer Vision

- Computing

- Konzepte

- Bedenken

- Abschluss

- Vernetz Dich

- Sie

- Geht davon

- betrachtet

- besteht

- konstante

- Inhalt

- Wettbewerb

- Kontext

- weiter

- kontinuierlich

- Kontrast

- beitragen

- trägt dazu bei

- Beitrag

- Beiträge

- Smartgeräte App

- Konvergenz

- Faltungs neuronales Netzwerk

- und beseitigen Muskelschwäche

- korrekt

- Korrelation

- entspricht

- teuer werden

- Abdeckung

- Abdeckung

- kritischem

- wichtig

- Strom

- Kurve

- innovativ, auf dem neuesten Stand

- technische Daten

- Datensätze

- Tage

- Behandlung

- Entscheidungen

- sinkt

- tief

- tiefe Lernen

- tiefes neuronales Netzwerk

- tiefer

- Anforderungen

- zeigen

- zeigt

- demonstrieren

- abhängen

- Abhängigkeiten

- einsetzen

- Bereitstellen

- Einsatz

- beschreiben

- beschrieben

- beschreibt

- Design

- entworfen

- Trotz

- detailliert

- Entwickler:in / Unternehmen

- Entwickler

- Entwicklung

- anders

- schwer

- Schwierigkeiten

- gerichtet

- Direkt

- Entdeckt

- Entdeckung

- Abstand

- unterscheiden

- unterscheidet

- Verteilung

- Ausschüttungen

- verschieden

- Diversität

- do

- Domain

- Domains

- Herrschaft

- Medikament

- Wirkstoffforschung

- im

- dynamisch

- E & T

- jeder

- einfacher

- Effektiv

- effektiv

- Wirksamkeit

- Effekten

- Wirksamkeit

- Effizienz

- effizient

- acht

- entweder

- Elemente

- elf

- eliminiert

- eliminieren

- betonen

- betont

- Arbeitgeber

- beschäftigt

- ermöglichen

- ermöglicht

- ermöglichen

- Codierung

- engagieren

- Entwicklung

- Englisch

- zu steigern,

- Verbesserungen

- Verbessert

- Gewährleistung

- Ganz

- vollständig

- Eintrag

- gleich

- Gleichgewicht

- Äquivalent

- Fehler

- insbesondere

- Essenz

- essential

- etablierten

- etabliert

- Schätzungen

- Äther (ETH)

- Auswerten

- Auswertung

- Sogar

- überall

- entwickelt sich

- entwickelt sich

- sich entwickelnden

- Beispiele

- überschreiten

- übersteigt

- Ausgezeichnet

- unterhaltsame Programmpunkte

- Exponate

- vorhandenen

- existiert

- Erweitern Sie die Funktionalität der

- teuer

- experimentell

- Experimente

- Experten

- Exploration

- ERKUNDEN

- erforscht

- Möglichkeiten sondieren

- verlängert

- erleichtert

- erleichtern

- andernfalls

- vertraut

- beschleunigt

- möglich

- Eigenschaften

- wenige

- Weniger

- Feld

- Felder

- Filter

- Finale

- Finden Sie

- Suche nach

- Befund

- Vorname

- passend zu

- fünf

- fixiert

- Fluss

- konzentriert

- Fokussierung

- gefolgt

- Aussichten für

- gefunden

- vier

- Unser Ansatz

- Frequenz

- für

- eingefroren

- voller

- voll

- Funktion

- Funktionen

- weiter

- Gewinnen

- Gewinne

- Spiel

- GANs

- Tor

- Genai

- erzeugen

- erzeugt

- Erzeugung

- generativ

- generatives Modell

- sanft

- Geometrie

- gegeben

- Unterstützung

- Global

- GPU

- GPUs

- Graph

- Graph neuronale Netze

- Graphen

- Wachsen Sie über sich hinaus

- Griff

- Handling

- Hardware

- mit

- hilft

- hierarchische

- GUTE

- Hochfrequenz

- hochauflösenden

- höher

- Hervorheben

- Besondere

- Hervorheben

- Highlights

- hoch

- Ultraschall

- Hilfe

- HTTPS

- human

- Humans

- hunderte

- hunderte Millionen

- Hyperparameter-Tuning

- Ideen

- identifizieren

- Image

- Bildklassifizierung

- Bilderkennung

- IMAGEnet

- Bilder

- Impact der HXNUMXO Observatorien

- Einfluss hat

- Imperativ

- Implementierung

- Realisierungen

- umgesetzt

- Auswirkungen

- Bedeutung

- wichtig

- auferlegten

- verbessert

- Verbesserung

- Verbesserungen

- verbessert

- Verbesserung

- in

- das

- Dazu gehören

- Einschließlich

- integrieren

- beinhaltet

- Erhöhung

- hat

- zunehmend

- zunehmend

- Anzeige

- Information

- informiert

- anfänglich

- Innovationen

- innovativ

- Varianten des Eingangssignals:

- Einblicke

- inspirierte

- Instanz

- beantragen müssen

- Anleitung

- Integration

- Intelligenz

- intensiv

- Interaktion

- Interaktionen

- Interesse

- Internet

- in

- einführen

- eingeführt

- Stellt vor

- Einführung

- Einleitung

- Untersuchung

- beteiligen

- beinhaltet

- Problem

- Probleme

- IT

- SEINE

- Job

- Jobs

- Reise

- jpg

- Wissen

- bekannt

- Mangel

- Landung

- Landschaft

- Sprache

- grosse

- großflächig

- größer

- höchste

- Latency

- neueste

- Schicht

- Lagen

- führenden

- umwandeln

- LERNEN

- gelernt

- lernen

- weniger

- Cholesterinspiegel

- Hebelwirkung

- Hebelwirkungen

- Nutzung

- Gefällt mir

- Wahrscheinlichkeit

- Einschränkung

- Einschränkungen

- Limitiert

- aus einer regionalen

- Lang

- lange Zeit

- aussehen

- Sneaker

- senken

- Senkung

- Maschine

- Maschinenübersetzung

- gemacht

- Aufrechterhaltung

- Dur

- um

- Making

- Weise

- viele

- Karte

- Marge

- massiv

- Spiel

- Streichhölzer

- Abstimmung

- mathematisch

- Matrix

- max-width

- Maximierung

- maximal

- messen

- Mechanismen

- Memory

- nur

- Verschmelzung

- Methode

- Methodologien

- Methodik

- Methoden

- Million

- Millionen

- minimal

- minimieren

- Fehler

- Modell

- für

- Änderungen

- Module

- mehr

- effizienter

- Zudem zeigt

- vor allem warme

- mehrere

- sollen

- Must Read

- Natürliche

- Natürliche Sprache

- Verarbeitung natürlicher Sprache

- Natur

- Need

- erforderlich

- Bedürfnisse

- Nerf

- Netze

- Netzwerk

- Netzwerke

- Neural

- neuronale Netzwerk

- Neuronale Netze

- NeuroIPS

- Neuronen

- Neu

- News

- weiter

- Nlp

- nicht

- Knoten

- Fiber Node

- bemerkenswert

- beachten

- Notizen

- Roman

- Anzahl

- Objekt

- Ziel

- beobachtet

- Auftreten

- OCR

- of

- bieten

- Angebote

- vorgenommen,

- on

- EINEM

- Einsen

- Online

- einzige

- Open-Source-

- Betrieb

- Einkauf & Prozesse

- Optimierung

- Optimieren

- optimiert

- or

- Andere

- Übertreffen

- outperforming

- Übertrifft

- Möglichkeiten für das Ausgangssignal:

- aussen

- übrig

- Überwinden

- Überwindung

- Überblick

- Paket

- Paare

- pankaj

- Papier

- Papiere

- Parallel

- Parameter

- Parameter

- besondere

- besonders

- Patches

- Schnittmuster

- für

- ausführen

- Leistung

- führt

- Zeiträume

- Fotorealistisch

- Plato

- Datenintelligenz von Plato

- PlatoData

- plausibel

- Points

- Posen

- Potenzial

- möglicherweise

- größte treibende

- Praktisch

- Praktische Anwendungen

- vorhersagen

- Vorhersagbar

- Vorhersage

- Prognose

- Prognosen

- sagt voraus,

- Gegenwart

- vorgeführt

- Geschenke

- früher

- primär

- Vor

- Wahrscheinlichkeit

- Aufgabenstellung:

- Probleme

- Verfahren

- Prozessdefinierung

- Verarbeitung

- produziert

- tiefgreifende

- Programm

- Programme

- Projekte

- bietet

- vorgeschlage

- schlägt vor

- schlägt

- Proteine

- Proteine

- zuverlässig

- Beweist

- die

- bietet

- Bereitstellung

- veröffentlicht

- Pytorch

- Qualität

- Abfragen

- Rennen

- Angebot

- Rang

- Honorar

- lieber

- Roh

- erreicht

- Lesen Sie mehr

- Lesebrillen

- bekräftigt

- echt

- realen Welt

- kürzlich

- kürzlich

- Rezept

- Anerkennung

- Software Empfehlungen

- erholt

- Wiederholung

- wiederkehrend

- Rekursive

- Veteran

- Reduziert

- reduziert

- Reduzierung

- Reduktion

- Referenz

- Referenzen

- reflektiert

- in Bezug auf

- Regulieren

- bezogene

- Beziehungen

- Release

- freigegeben

- Vertrauen

- sich auf

- bleibt bestehen

- bemerkenswert

- gemacht

- Rendering

- vertreten

- Darstellung

- Vertreter

- Darstellen

- erfordern

- Anforderung

- Voraussetzungen:

- Forschungsprojekte

- Forschungsgemeinschaft

- Forscher

- Downloads

- beziehungsweise

- was zu

- Die Ergebnisse

- Umschulung

- zeigen

- revolutionieren

- RGB

- Recht

- Risiko

- robust

- Skalierbarkeit

- skalierbaren

- Skalieren

- Waage

- Skalierung

- Szenarien

- Szene

- Szenen

- Planung

- Regelungen

- wissenschaftlich

- Ergebnis

- kratzen

- Suche

- Satz

- Reihenfolge

- Modellreihe

- dient

- kompensieren

- Sets

- Einstellungen

- mehrere

- Teilen

- ,,teilen"

- kurzfristig

- erklären

- präsentiert

- präsentiert

- zeigt

- Konzerte

- Signale

- Bedeutung

- signifikant

- bedeutend

- ähnlich

- Ähnlichkeiten

- Einfacher

- gleichzeitig

- Umstände

- Größe

- erfahren

- glatt

- gesellschaftlich

- allein

- Lösung

- Lösungen

- LÖSEN

- Löst

- Auflösung

- einige

- manchmal

- Raumfahrt

- Raum und Zeit

- überspannend

- spezialisiert

- spezifisch

- Spectral

- Geschwindigkeit

- gespalten

- Standard

- State-of-the-art

- Aussagen

- bleiben

- Schritt

- Lagerung

- speichern

- Strategisch

- Strategien

- Strategie

- stark

- Struktur

- strukturierte

- Strukturen

- Kämpft

- Studie

- wesentlich

- im Wesentlichen

- Erfolg

- erfolgreich

- Erfolgreich

- so

- Schlägt vor

- geeignet

- Oberteil

- Aufsicht

- übertrifft

- übertreffen

- SVG

- Synthese

- System

- Systeme und Techniken

- Aufgabe

- und Aufgaben

- Techniken

- Neigen

- AGB

- Test

- Text

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Der Graph

- ihr

- Sie

- dann

- theoretisch

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- Tausende

- nach drei

- Durch

- Zeit

- mal

- zu

- Werkzeug

- Themen

- gegenüber

- traditionell

- Training

- trainiert

- Ausbildung

- privaten Transfer

- Übertragen

- Transformator

- Transformer

- Übersetzungen

- Übersetzungsqualität

- Trends

- Lernprogramm

- XNUMX

- Typen

- Unterstrichen

- Verständnis

- einzigartiges

- Bereiche

- nicht wie

- beispiellos

- aktualisiert

- Updates

- -

- benutzt

- verwendet

- Verwendung von

- die

- v1

- wertvoll

- verschiedene

- überprüfbare

- vielseitig

- Vielseitigkeit

- Version

- Video

- Videos

- Anzeigen

- Ansichten

- sichtbar

- Seh-

- Vision-Systeme

- visuell

- Visuelle Erkennung

- Volumen

- vs

- wurde

- Wege

- Netz

- Gewicht

- GUT

- wann

- ob

- welche

- während

- breit

- Große Auswahl

- weit

- breiter

- Größere Gemeinschaft

- Wikipedia

- werden wir

- mit

- .

- ohne

- Worte

- Arbeiten

- Werk

- wert

- geschrieben

- Jahr

- nachgiebig

- U

- Ihr

- Zephyrnet