Du har udført dit A / B test, omhyggeligt analyseret dataene og lavet strategiske beslutninger baseret på resultaterne. Der opstår imidlertid en forvirrende situation, når resultaterne observeres i de sofistikerede A / B-testværktøjer undlader at tilpasse sig observationer fra den virkelige verden.

Hvad giver? Velkommen til verden af uoverensstemmelse mellem A/B-testværktøjer , observationer fra det virkelige liv. Det er en vild tur, hvor faktorer som f.eks statistisk varians, prøveudtagningsbias, kontekstuelle forskelle, tekniske fejl, tidsramme forskydning, Og endda regression til middelværdien kan kaste dine nøje beregnede resultater af sig.

Spænd op, mens vi dykker ned i de småting om, hvorfor disse der sker uoverensstemmelser og hvad du kan gøre ved dem.

Tekniske problemer

A/B-testværktøjer er afhængige af JavaScript-kode eller andre tekniske implementeringer for at tildele brugere til forskellige variationer. Men på trods af hvor robuste de er, er disse værktøjer ikke immun over for tekniske problemer som kan påvirke nøjagtigheden af deres resultater. For eksempel, scriptfejl inden for implementeringen kan forekomme, forebyggende ordentlig sporing af brugerinteraktioner eller fører til fejlagtig tildeling af brugere til variationer. Disse fejl kan forstyrre dataene indsamlingsproces og indføre uoverensstemmelser i de opnåede resultater. Derudover kompatibilitetsproblemer med forskellige webbrowsere or variationer i caching-mekanismer kan potentielt påvirke værktøjets funktionalitet fører til uoverensstemmelser mellem de observerede resultater og faktisk brugeroplevelse.

Desuden er virkningen af tekniske problemer kan variere afhængigt af kompleksiteten af hjemmesiden or applikation, der testes. Websteder med komplekse brugerveje or dynamisk indhold er særligt tilbøjelige til tekniske udfordringer, der kan forstyrre A/B-testen behandle. Tilstedeværelsen af tredjeparts scripts or integrationer kan yderligere komplicere sagerne, som Konflikter or fejl i disse komponenter kan forstyrre nøjagtig sporing af brugeradfærd. Disse tekniske kompleksiteter understreger vigtigheden af grundig testning og kvalitetssikring for at sikre, at den fungerer korrekt A / B-testværktøjer , minimere risikoen for uoverensstemmelser mellem værktøjernes resultater og den faktiske ydeevne af variationerne i virkelige scenarier.

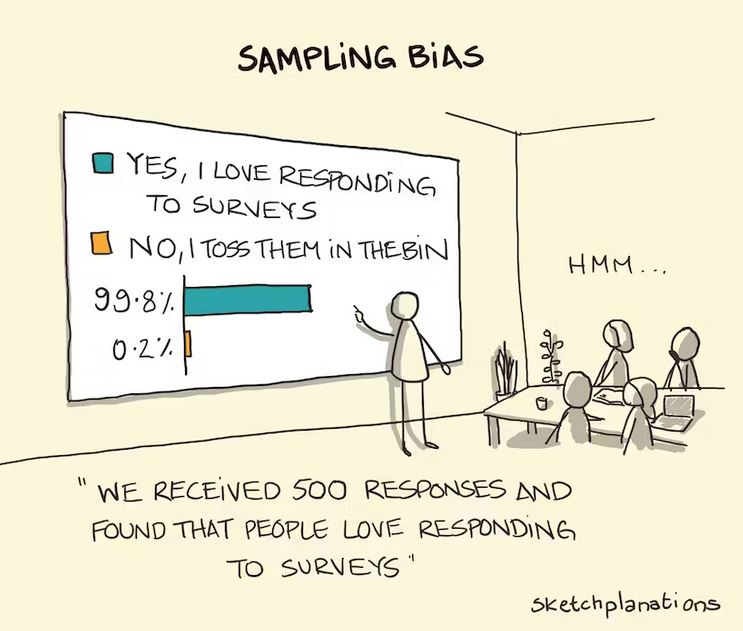

Sampling Bias

A/B-testværktøjer tildeler ofte brugere til forskellige variationer tilfældigt. På grund af opgavens tilfældige karakter kan der dog være tilfælde, hvor visse brugersegmenter er uforholdsmæssigt store repræsenteret i en variation sammenlignet med en anden. Dette kan introducere skævhed og påvirke resultaterne observeret i værktøjet. For eksempel hvis en bestemt variant vises oftere til brugere, der er allerede tilbøjelig til at foretage et køb, kan det pustes kunstigt op konverteringsraten for denne variation.

Tilsvarende, hvis en visse brugersegmenter er underrepræsenteret i en variation, værktøjet muligvis ikke fange deres adfærd tilstrækkeligt, hvilket fører til unøjagtige konklusioner om variationens effektivitet. Det her prøveudtagningsbias kan oprette en uoverensstemmelse mellem opnåede resultater fra AB testværktøjer og faktisk adfærd af den bredere brugerbase.

Tidsramme Fejljustering

A/B-testværktøjer typisk akkumulere data over en bestemt periode for at analysere resultaterne. Imidlertid tidspunkt for dataindsamling i forhold til live performance af variationen kan indføre uoverensstemmelser. Én fælles problem er, når værktøjet indsamler data for en længere varighed end den periode, hvor variationen faktisk var live. I sådanne tilfælde kan værktøjet evt utilsigtet omfatter yderligere tidsperioder hvor variationens ydeevne afveg fra den tiltænkte version, og dermed skævvrider den overordnede analyse. Dette kan føre til vildledende konklusioner , en afbrydelse mellem værktøjets resultater og faktisk virkning af variationen i dens tilsigtede tidsramme.

Omvendt kan der også være tilfælde, hvor dataindsamlingsperioden for A/B-testværktøjet mangler den fulde effekt af variationen. Hvis værktøjets tidsramme is kortere end den periode, det tager for brugerne at engagere sig fuldt ud med og reagere på variationen, kan resultaterne evt ikke nøjagtigt afspejler sandt ydeevne. Dette kan forekomme, når variationen kræver det en længere tilpasningsperiode for brugerne at justere deres adfærd, eller når virkningen af variationen udfolder sig gradvist over tid. I sådanne tilfælde kan værktøjet for tidligt drage konklusioner om effektiviteten af variationen, hvilket fører til en uoverensstemmelse mellem værktøjets resultater og den faktiske langsigtede ydeevne under virkelige forhold.

Til afbøde påvirkningen af tidsrammeforskydning, er det afgørende at planlægge nøje , synkronisere dataindsamlingsperioden for A/B-testværktøjer med live-implementering af variationer. Dette indebærer tilpasning start- og slutdatoerne af testfasen med faktisk tidsramme når variationerne er aktive. Derudover i betragtning af potentiel forsinkelsestid for brugerne at tilpasse sig og reagere på ændringerne kan give en mere omfattende forståelse af variationens sande effekt. Ved at sikre en korrekt tilpasning af tidsrammer kan virksomheder reducere risikoen af uoverensstemmelser og lav flere præcis datadrevet beslutninger baseret på resultaterne opnået fra A/B-test.

Kontekstuel forskel

A/B-testværktøjer fungerer ofte inden for en kontrolleret testmiljø, hvor brugerne er uvidende om testen og kan opføre sig anderledes i forhold til hvornår variationen er sat live i den virkelige verden. En vigtig faktor, der bidrager til uoverensstemmelse mellem testværktøjets resultater og liveoptræden er den nyhedseffekt. Når brugere møde en ny variation i et testmiljø kan de evt udvise øget nysgerrighed or engagement simpelthen fordi det er anderledes end hvad de er vant til. Dette kan kunstigt pustes op de præstationsmålinger, der registreres af testværktøjet, da brugere kan interagere med variationen mere entusiastisk, end de ville i deres almindelige browsing- eller købsvaner.

Derudover bevidstheden om være en del af et eksperiment kan påvirke brugernes adfærd. Når brugere er klar over, at de er en del af en testproces, kan de evt udstille bevidst or underbevidste skævheder som kan påvirke deres svar. Dette fænomen, kendt som Hawthorne-effekt, henviser til ændring af adfærd på grund af bevidstheden om at blive observeret eller testet. Brugere kan blive mere opmærksomme, selvbevidste eller tilbøjelige til at opføre sig på måder, de opfatter som ønskværdige, hvilket potentielt forvrænger resultaterne opnået fra testværktøjet. Denne uoverensstemmelse mellem den kontrollerede test miljø og den virkelige verden kan føre til forskelle i brugerengagement og konverteringsrater, når variationen implementeres uden for testmiljøet. En person med en skarpt øje kan typisk bemærke de subtile signaler afgøre, at de går ind i en A/B-test.

Desuden er det fravær af den virkelige verden kontekst i testmiljøet kan også påvirke brugeradfærd og efterfølgende påvirke resultaterne. I den virkelige verden møder brugerne variationer inden for rammerne af deres daglige liv, som omfatter en lang række eksterne faktorer som f.eks. tidsbegrænsninger, konkurrerende distraktioner eller personlige forhold. Disse kontekstuelle elementer kan i væsentlig grad påvirke brugernes beslutninger-gør , aktioner. Imidlertid A / B-testværktøjer tit isolere brugerne fra disse virkelige påvirkninger, med fokus udelukkende på selve variationen. Som et resultat heraf kan værktøjets resultater muligvis ikke fange brugernes nøjagtighed ville svare til variationen, når de konfronteres med kompleksiteten af deres hverdagserfaringer. Denne uoverensstemmelse i kontekstuelle faktorer kan føre til forskelle i brugeradfærd , udfald mellem testværktøjet og variationens live-performance.

Regression til middelværdien

I A/B-test er det det ikke ualmindeligt at observere ekstreme resultater for en variation i testfasen. Dette kan ske pga tilfældig chance, et specifikt segment af brugere er mere lydhør til variationen eller andre faktorer det holder måske ikke rigtigt når variationen eksponeres for et større, mere mangfoldigt publikum over en længere periode. Dette fænomen er kendt som regression til middelværdien.

Regression til middelværdien opstår når ekstrem or afvigende resultater observeret under testen er ikke bæredygtig i det lange løb. For eksempel, hvis en variation viser en betydelig stigning in omregningskurser under testfasen er det muligt, at denne spids skyldtes en bestemt gruppe af brugere, der var særligt modtagelige over for ændringerne. Men når variationen er sat live , udsat til et større og mere forskelligartet publikum, er det sandsynligt, at den indledende stigning vil aftage, og præstation vil konvergere mod gennemsnits- eller basisniveauet. Dette kan føre til forskellige resultater sammenlignet med, hvad testværktøjet oprindeligt indikerede, da de ekstreme resultater, der blev observeret under testning, muligvis ikke er indikative for variationens langsigtede virkning.

Forståelse af begrebet regression til middelværdien er afgørende ved fortolkning af A/B-testresultater. Det understreger vigtigheden af ikke udelukkende at stole på indledende testfase fund men i betragtning af den samlede ydelse af variationen over en mere forlænget periode. Ved at overveje potentialet for regression til gennemsnittet, virksomheder kan undgå at drage fejlagtige konklusioner or implementere ændringer baseret på midlertidige spidser or fald observeret i testfasen. Det understreger behovet for forsigtig fortolkning af A/B-testresultater og et omfattende overblik over variationens ydeevne i den virkelige verden.

Konklusion

Så der har du det. Virkeligheden af A/B-testværktøjer stemmer ikke altid overens med den virkelige verden resultater du oplever. Det er ikke en fejl i dine analysefærdigheder eller et tegn på, at A/B-test er upålidelige. Det er bare dyrets natur.

Hvornår fortolkning af A/B-testresultater, er det afgørende ikke udelukkende at stole på indledende fund men overvej overordnet ydelse af variationen over en længere periode. Ved at gøre det kan virksomhederne undgå at drage fejlagtige konklusioner or implementere ændringer baseret på midlertidige spidser eller fald observeret under testfasen.

For at navigere i realitetskløften er det vigtigt at nærme sig A / B-test resultater med et kritisk blik. Vær opmærksom på værktøjernes begrænsninger , redegøre for virkelige sammenhænge. Suppler dine resultater med andre forskningsmetoder for at få en omfattende forståelse af variationens ydeevne. Ved at anlægge en holistisk tilgang vil du være godt rustet til at træffe datadrevne beslutninger, der stemmer overens med dine brugeres virkelighed.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Automotive/elbiler, Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- BlockOffsets. Modernisering af miljømæssig offset-ejerskab. Adgang her.

- Kilde: https://blog.2checkout.com/gap-between-ab-testing-tools-and-real-outcomes/

- :er

- :ikke

- :hvor

- ][s

- $OP

- 32

- a

- Om

- AC

- nøjagtighed

- præcist

- aktiv

- faktiske

- faktisk

- tilpasse

- tilpasning

- Derudover

- tilstrækkeligt

- påvirke

- AG

- AI

- tilpasse

- justering

- også

- altid

- an

- analyse

- analysere

- analyseret

- ,

- En anden

- tilgang

- ER

- AS

- sikkerhed

- publikum

- gennemsnit

- AVG

- undgå

- opmærksom på

- bevidsthed

- bund

- baseret

- Baseline

- BE

- fordi

- bliver

- være

- mellem

- bredere

- Browsing

- virksomheder

- men

- by

- beregnet

- CAN

- fange

- Optagelse

- omhyggeligt

- tilfælde

- forsigtig

- udfordringer

- Ændringer

- samling

- indsamler

- sammenlignet

- kompatibilitet

- komplekse

- kompleksiteter

- kompleksitet

- komponenter

- omfattende

- betingelser

- Overvej

- Overvejer

- sammenhæng

- kontekstuelle

- bidrager

- kontrolleret

- Konvertering

- skabe

- kritisk

- afgørende

- dagligt

- data

- datastyret

- afgørelser

- Afhængigt

- implementering

- Trods

- Bestem

- forskelle

- forskellige

- uoverensstemmelse

- Afbryde

- forskelligartede

- Diverse publikum

- do

- gør

- tegne

- grund

- varighed

- i løbet af

- e

- effektivitet

- elementer

- fremgår

- understrege

- møde

- ende

- engagement

- sikre

- sikring

- indtastning

- Miljø

- væsentlig

- Ether (ETH)

- Endog

- hverdagen

- eksempel

- henrettet

- erfaring

- Oplevelser

- udsat

- ekstern

- ekstrem

- øje

- faktor

- faktorer

- FAIL

- defekt

- Med

- fund

- fejl

- fokusering

- Til

- hyppigt

- fra

- fuld

- fuldt ud

- funktionalitet

- fungerer

- yderligere

- Gevinst

- kløft

- gif

- giver

- ske

- Have

- øget

- højdepunkter

- hold

- holistisk

- Hvordan

- Men

- HTTPS

- HubSpot

- i

- if

- immun

- KIMOs Succeshistorier

- implementering

- implementeret

- betydning

- vigtigt

- in

- skrå

- omfatter

- omfatter

- angivet

- vejledende

- indflydelse

- initial

- i første omgang

- instans

- beregnet

- interagere

- interaktioner

- blande

- fortolkning

- ind

- indføre

- Investopedia

- spørgsmål

- IT

- ITS

- jpg

- lige

- kendt

- større

- føre

- førende

- Niveau

- Sandsynlig

- leve

- Lives

- Lang

- langsigtet

- længere

- lavet

- lave

- Making

- Matters

- max-bredde

- Kan..

- betyde

- metoder

- omhyggeligt

- Metrics

- måske

- mere

- Natur

- Naviger

- Behov

- Ny

- Varsel..

- observeret

- opnået

- forekomme

- of

- off

- tit

- on

- ONE

- betjene

- or

- Andet

- udfald

- uden for

- i løbet af

- samlet

- del

- særlig

- især

- ydeevne

- periode

- person,

- fase

- fænomen

- fly

- plato

- Platon Data Intelligence

- PlatoData

- mulig

- potentiale

- potentielt

- tilstedeværelse

- forebyggelse

- behandle

- passende

- give

- køb

- kvalitet

- tilfældig

- rækkevidde

- Sats

- priser

- bedømmelse

- ægte

- virkelige verden

- Reality

- registreres

- refererer

- afspejler

- regression

- fast

- relation

- stole

- stole

- repræsenteret

- Kræver

- forskning

- Svar

- reaktioner

- resultere

- Resultater

- Ride

- robust

- Kør

- s

- scenarier

- score

- segment

- segmenter

- Kort

- vist

- Shows

- underskrive

- betydeligt

- Situationen

- færdigheder

- So

- Alene

- sofistikeret

- specifikke

- specificeret

- spike

- spikes

- starte

- statistiske

- Succesfuld

- sådan

- supplere

- tager

- tager

- Teknisk

- midlertidig

- prøve

- afprøvet

- Test

- end

- at

- verdenen

- deres

- Them

- Der.

- Disse

- de

- denne

- dem

- tid

- tidsramme

- til

- værktøj

- værktøjer

- mod

- Sporing

- sand

- typisk

- Ualmindelig

- understregninger

- forståelse

- Bruger

- Brugererfaring

- brugere

- Specifikation

- stemmer

- W

- var

- måder

- we

- web

- websites

- velkommen

- var

- Hvad

- hvornår

- som

- WHO

- hvorfor

- bred

- Bred rækkevidde

- Wikipedia

- Wild

- vilje

- med

- inden for

- world

- ville

- X

- dig

- Din

- zephyrnet