Finite element-metoder til analyse dukker op på mange områder inden for elektronisk systemdesign: mekanisk spændingsanalyse i multi-die-systemer, termisk analyse som modstykke til både køle- og spændingsanalyse (f.eks. vridning) og elektromagnetisk overensstemmelsesanalyse. (Computational fluid dynamics – CFD – er et anderledes dyr, som jeg måske dækker i en separat blog.) Jeg har dækket emner på dette område med en anden klient og fortsætter med at finde domænet attraktivt, fordi det resonerer med min fysikbaggrund og min indre matematiknørd (løsning af differentialligninger). Her udforsker jeg en nyligt papir fra Siemens AG sammen med de tekniske universiteter i München og Braunschweig.

Problemformuleringen

Finite element metoder er teknikker til numerisk at løse systemer af 2D/3D partielle differentialligninger (PDE'er), der opstår i mange fysiske analyser. Disse kan strække sig fra, hvordan varmen diffunderer i en kompleks SoC, til EM-analyser til bilradar, til hvordan en mekanisk struktur bøjer sig under stress, til hvordan fronten af en bil krøller sammen i et styrt.

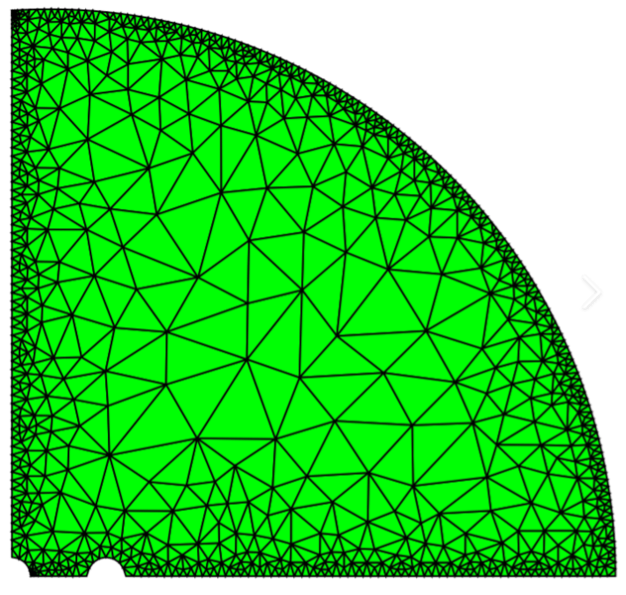

For FEM er et mesh konstrueret på tværs af det fysiske rum som en diskret ramme for analyse, finere kornet omkring grænser og især hurtigt varierende randforhold, og mere grovkornet andre steder. Ved at springe de blodige detaljer over, optimerer metoden lineære superpositioner af simple funktioner på tværs af nettet ved at variere koefficienter i superpositionen. Optimering har til formål at finde den bedste pasform inden for en acceptabel tolerance, der er i overensstemmelse med diskrete proxyer for PDE'erne sammen med startbetingelser og grænsebetingelser gennem lineær algebra og andre metoder.

Meget store masker er almindeligvis nødvendige for at opfylde acceptabel nøjagtighed, hvilket fører til meget lange køretider for FEM-løsninger på realistiske problemer, hvilket bliver endnu mere besværligt, når der køres flere analyser for at udforske optimeringsmuligheder. Hver kørsel starter i det væsentlige fra bunden uden nogen indlæringseffekt mellem kørsler, hvilket antyder en mulighed for at bruge ML-metoder til at accelerere analysen.

Måder at bruge ML med FEM

En meget brugt tilgang til at accelerere FEM-analyser (FEA) er at bygge surrogatmodeller. Disse er som abstrakte modeller i andre domæner – forenklede versioner af den originale models fulde kompleksitet. FEA-eksperter taler om Reduced Order Models (ROM'er), som fortsat udviser en god tilnærmelse af kildemodellens (diskretiserede) fysiske adfærd, men omgår behovet for at køre FEA, i det mindste i designoptimeringsfasen, selvom de kører meget hurtigere end FEA .

En måde at bygge et surrogat på ville være at starte med en masse FEA'er, ved at bruge den information som en træningsdatabase til at bygge surrogaten. Dette kræver dog stadig lange analyser for at generere træningssæt af input og output. Forfatterne påpeger også en anden svaghed ved en sådan tilgang. ML har ingen indfødt forståelse af de fysiske begrænsninger, der er vigtige i alle sådanne applikationer og er derfor tilbøjelige til at hallucinere, hvis de præsenteres for et scenarie uden for sit træningssæt.

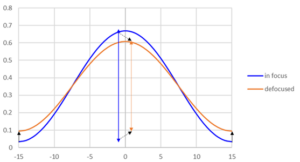

Omvendt erstattes FEM med en fysisk informeret neurale netværk (PINN) inkorporerer fysiske PDE'er i tabsfunktionsberegninger, og introducerer i det væsentlige fysiske begrænsninger i gradientbaserede optimeringer. Dette er en smart idé, selvom efterfølgende forskning har vist, at selvom metoden virker på simple problemer, bryder den sammen ved tilstedeværelse af højfrekvente og multi-skala funktioner. Det er også skuffende, at træningstiden for sådanne metoder kan være længere end FEA-løbetider.

Dette papir foreslår et spændende alternativ, at kombinere FEA- og ML-træning tættere, så ML-tabsfunktioner træner på FEA-fejlberegningerne ved tilpasning af prøveløsninger på tværs af nettet. Der er en vis lighed med PINN-tilgangen, men med en vigtig forskel: dette neurale net løber sammen med FEA for at accelerere konvergensen til en løsning inden for træning. Hvilket tilsyneladende resulterer i hurtigere træning. Som følge heraf kører den neurale net-model uden behov for FEA. Ved konstruktion bør en model, der er trænet på denne måde, være i overensstemmelse med de fysiske begrænsninger af det virkelige problem, da den er blevet trænet meget tæt mod en fysisk bevidst løser.

Jeg tror, at min fortolkning her er ret præcis. Jeg glæder mig over rettelser fra eksperter!

Del dette opslag via:

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://semiwiki.com/artificial-intelligence/341034-blending-finite-element-methods-and-ml/

- :har

- :er

- $OP

- a

- Om

- ABSTRACT

- fremskynde

- acceptabel

- nøjagtighed

- præcis

- tværs

- AG

- mod

- målsætninger

- Alle

- også

- alternativ

- an

- analyser

- analyse

- ,

- En anden

- applikationer

- tilgang

- ER

- OMRÅDE

- opstår

- omkring

- AS

- At

- attraktivt

- forfattere

- automotive

- opmærksom på

- baggrund

- BE

- fordi

- blive

- været

- adfærd

- BEDSTE

- mellem

- blanding

- Blog

- både

- grænser

- pauser

- bygge

- Bunch

- men

- by

- bypass

- CAN

- bil

- CFD

- kunde

- nøje

- kombinerer

- almindeligt

- komplekse

- kompleksitet

- Compliance

- beregningsmæssige

- betingelser

- konsekvent

- begrænsninger

- konstrueret

- opbygge

- fortsæt

- Konvergens

- Rettelser

- Modregning

- dæksel

- dækket

- Crash

- afgrøde

- Database

- Design

- detaljer

- forskel

- forskellige

- skuffende

- domæne

- Domæner

- ned

- dynamik

- hver

- elektronisk

- element

- andetsteds

- ligninger

- fejl

- især

- Essensen

- væsentlige

- Endog

- udstille

- eksperter

- udforske

- udvide

- retfærdigt

- hurtigere

- Funktionalitet

- Finde

- passer

- montering

- væske

- Væskedynamik

- Til

- Framework

- Frekvens

- fra

- forsiden

- fuld

- funktion

- funktioner

- Geek

- generere

- godt

- Have

- link.

- Høj

- Hvordan

- Men

- HTTPS

- i

- idé

- if

- vigtigt

- in

- I andre

- inkorporerer

- oplysninger

- informeret

- initial

- indre

- indgange

- fortolkning

- ind

- spændende

- indføre

- IT

- ITS

- stor

- førende

- læring

- mindst

- Leverage

- ligesom

- Lang

- længere

- off

- mange

- matematik

- max-bredde

- mekanisk

- Mød

- mesh

- metode

- metoder

- måske

- minut

- ML

- model

- modeller

- mere

- meget

- flere

- München

- my

- indfødte

- Behov

- behov

- netto

- Neural

- ingen

- of

- on

- Opportunity

- optimering

- Optimerer

- ordrer

- original

- Andet

- ud

- udgange

- uden for

- Papir

- fase

- fysisk

- Fysisk

- Fysik

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- muligheder

- Indlæg

- tilstedeværelse

- forelagt

- Problem

- problemer

- fuldmagter

- radar

- hurtigt

- ægte

- realistisk

- Reduceret

- Kræver

- forskning

- resonans

- Resultater

- Kør

- kører

- løber

- scenarie

- ridse

- adskille

- sæt

- sæt

- bør

- vist

- Siemens

- Simpelt

- forenklet

- siden

- So

- løsninger

- Løsninger

- SOLVE

- Løsning

- nogle

- Kilde

- Space

- starte

- starter

- Stadig

- stress

- struktur

- efterfølgende

- sådan

- foreslår

- superposition

- systemet

- Systemer

- Tal

- Teknisk

- teknikker

- end

- at

- The Source

- Der.

- derfor

- termisk

- Disse

- tror

- denne

- selvom?

- Gennem

- tid

- gange

- til

- sammen

- tolerance

- Emner

- Tog

- uddannet

- Kurser

- retssag

- under

- forståelse

- Universiteter

- brug

- anvendte

- ved brug af

- Varierende

- versioner

- meget

- via

- Vej..

- Svaghed

- velkommen

- hvornår

- som

- mens

- bredt

- med

- inden for

- uden

- virker

- ville

- zephyrnet