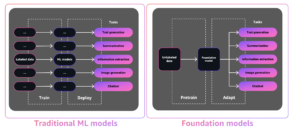

Den hurtige vækst af generativ AI bringer lovende ny innovation og rejser samtidig nye udfordringer. Disse udfordringer inkluderer nogle, der var almindelige før generativ AI, såsom bias og forklarlighed, og nye unikke for foundation-modeller (FM'er), herunder hallucinationer og toksicitet. Hos AWS er vi forpligtet til udvikle generativ AI ansvarligt, tager en menneskecentreret tilgang, der prioriterer uddannelse, videnskab og vores kunder, for at integrere ansvarlig AI på tværs af ende-til-ende AI-livscyklussen.

I løbet af det seneste år har vi introduceret nye muligheder i vores generative AI-applikationer og modeller, såsom indbygget sikkerhedsscanning i Amazon Code Whisperer, træning i at opdage og blokere skadeligt indhold Amazon Titan, og databeskyttelse i Amazonas grundfjeld. Vores investering i sikker, gennemsigtig og ansvarlig generativ kunstig intelligens inkluderer samarbejde med det globale samfund og politiske beslutningstagere, da vi opmuntrede og støttede både Det Hvide Hus Frivillige AI-forpligtelser , AI Safety Summit i Storbritannien. Og vi fortsætter med at arbejde hånd i hånd med kunder for at operationalisere ansvarlig AI med specialbyggede værktøjer som Amazon SageMaker Clarify, ML Governance med Amazon SageMakerOg meget mere.

Introduktion af ny ansvarlig AI-innovation

Efterhånden som generativ kunstig intelligens skaleres til nye industrier, organisationer og anvendelsesmuligheder, skal denne vækst ledsages af en vedvarende investering i ansvarlig FM-udvikling. Kunder ønsker, at deres FM'er skal bygges med sikkerhed, retfærdighed og sikkerhed for øje, så de igen kan implementere AI på en ansvarlig måde. Hos AWS re:Invent i år er vi glade for at kunne annoncere nye muligheder til at fremme ansvarlig generativ AI-innovation på tværs af et bredt sæt af muligheder med nye indbyggede værktøjer, kundebeskyttelse, ressourcer til at øge gennemsigtigheden og værktøjer til at bekæmpe desinformation. Vi sigter mod at give kunderne den information, de har brug for for at evaluere FM'er i forhold til vigtige ansvarlige AI-overvejelser, såsom toksicitet og robusthed, og introducere autoværn til at anvende sikkerhedsforanstaltninger baseret på kundeanvendelsestilfælde og ansvarlige AI-politikker. Samtidig ønsker vores kunder at blive bedre informeret om sikkerheden, retfærdigheden, sikkerheden og andre egenskaber ved AI-tjenester og FM'er, når de bruger dem i deres egen organisation. Vi er glade for at kunne annoncere flere ressourcer til at hjælpe kunder med bedre at forstå vores AWS AI-tjenester og levere den gennemsigtighed, de beder om.

Implementering af sikkerhedsforanstaltninger: Autoværn til Amazon Bedrock

Sikkerhed er en prioritet, når det kommer til at introducere generativ AI i stor skala. Organisationer ønsker at fremme sikre interaktioner mellem deres kunder og generative AI-applikationer, der undgår skadeligt eller stødende sprog og stemmer overens med virksomhedens politikker. Den nemmeste måde at gøre det på er at indføre konsekvente sikkerhedsforanstaltninger på tværs af hele organisationen, så alle kan innovere sikkert. I går annoncerede vi forhåndsvisningen af Autoværn til Amazon Bedrock—en ny funktion, der gør det nemt at implementere applikationsspecifikke sikkerhedsforanstaltninger baseret på kundebrugssager og ansvarlige AI-politikker.

Guardrails sørger for ensartethed i, hvordan FM'er på Amazon Bedrock reagerer på uønsket og skadeligt indhold i applikationer. Kunder kan anvende autoværn til store sprogmodeller på Amazon Bedrock samt på finjusterede modeller og i kombination med Agenter for Amazon Bedrock. Guardrails giver dig mulighed for at angive emner, der skal undgås, og tjenesten registrerer og forhindrer automatisk forespørgsler og svar, der falder ind under begrænsede kategorier. Kunder kan også konfigurere indholdsfiltreringstærskler på tværs af kategorier, herunder hadefulde ytringer, fornærmelser, seksualiseret sprogbrug og vold for at bortfiltrere skadeligt indhold til det ønskede niveau. For eksempel kan en netbankapplikation oprettes for at undgå at yde investeringsrådgivning og begrænse upassende indhold (såsom hadefulde ytringer, fornærmelser og vold). I den nærmeste fremtid vil kunder også være i stand til at redigere personlig identificerbar information (PII) i brugerinput og FM'ers svar, indstille bandeordfiltre og levere en liste over tilpassede ord til at blokere i interaktioner mellem brugere og FM'er, hvilket forbedrer compliance og yderligere beskytte brugerne. Med Guardrails kan du innovere hurtigere med generativ kunstig intelligens, mens du opretholder beskyttelser og sikkerhedsforanstaltninger i overensstemmelse med virksomhedens politikker.

Identifikation af den bedste FM til en specifik use case: Model Evaluation in Amazon Bedrock

I dag har organisationer en bred vifte af FM-muligheder til at drive deres generative AI-applikationer. For at finde den rette balance mellem nøjagtighed og ydeevne for deres anvendelsestilfælde skal organisationer effektivt sammenligne modeller og finde den bedste mulighed baseret på vigtige ansvarlige AI og kvalitetsmålinger, der er vigtige for dem. For at evaluere modeller skal organisationer først bruge dage på at identificere benchmarks, opsætte evalueringsværktøjer og køre vurderinger, hvilket alt sammen kræver dyb ekspertise inden for datavidenskab. Ydermere er disse test ikke nyttige til at evaluere subjektive kriterier (f.eks. brandstemme, relevans og stil), der kræver dømmekraft gennem kedelige, tidskrævende arbejdsgange med menneskelig gennemgang. Den tid, ekspertise og ressourcer, der kræves til disse evalueringer – for hver ny use case – gør det vanskeligt for organisationer at evaluere modeller i forhold til ansvarlige AI-dimensioner og træffe et informeret valg omkring, hvilken model der vil give deres kunder den mest nøjagtige, sikre oplevelse.

Nu tilgængelig i forhåndsvisning, Modelevaluering på Amazon Bedrock hjælper kunder med at evaluere, sammenligne og vælge de bedste FM'er til deres specifikke brugssag baseret på brugerdefinerede metrics, såsom nøjagtighed og sikkerhed, ved hjælp af enten automatiske eller menneskelige evalueringer. I Amazon Bedrock-konsollen vælger kunder de FM'er, de vil sammenligne for en given opgave, såsom besvarelse af spørgsmål eller indholdsresumé. Til automatiske evalueringer vælger kunder foruddefinerede evalueringskriterier (f.eks. nøjagtighed, robusthed og toksicitet) og uploader deres eget testdatasæt eller vælger fra indbyggede, offentligt tilgængelige datasæt. For subjektive kriterier eller nuanceret indhold, der kræver dømmekraft, kan kunder nemt opsætte menneskebaserede evalueringsarbejdsgange med blot et par klik. Disse arbejdsgange udnytter en kundes interne arbejdsteam eller bruger en administreret arbejdsstyrke leveret af AWS til at evaluere modelsvar. Under menneskebaserede evalueringer definerer kunder brugscasespecifikke metrics (f.eks. relevans, stil og brands stemme). Når kunderne er færdige med opsætningsprocessen, kører Amazon Bedrock evalueringer og genererer en rapport, så kunderne nemt kan forstå, hvordan modellen klarede sig på tværs af vigtige sikkerheds- og nøjagtighedskriterier og vælge den bedste model til deres brug.

Denne evne til at evaluere modeller er ikke begrænset til Amazon Bedrock, kunder kan også bruge modelevaluering i Amazon SageMaker Clarify til nemt at evaluere, sammenligne og vælge den bedste FM-mulighed på tværs af nøglekvalitets- og ansvarsmålinger såsom nøjagtighed, robusthed og toksicitet – på tværs alle FM'er.

Bekæmpelse af desinformation: Vandmærke i Amazon Titan

I dag meddelte vi Amazon Titan Image Generator i preview, som giver kunderne mulighed for hurtigt at producere og forbedre billeder af høj kvalitet i stor skala. Vi overvejede ansvarlig AI under hvert trin af modeludviklingsprocessen, herunder træning af datavalg, opbygning af filtreringsmuligheder til at opdage og fjerne upassende brugerinput og modeloutput og forbedring af den demografiske mangfoldighed af vores modeloutput. Alle Amazon Titan-genererede billeder indeholder som standard et usynligt vandmærke, som er designet til at hjælpe med at reducere spredningen af desinformation ved at give en diskret mekanisme til at identificere AI-genererede billeder. AWS er blandt de første modeludbydere, der i vid udstrækning frigiver indbyggede usynlige vandmærker, der er integreret i billedoutput og er designet til at være modstandsdygtige over for ændringer.

Opbygning af tillid: At stå bag vores modeller og applikationer med godtgørelse

Opbygning af kundetillid er kernen i AWS. Vi har været på en rejse med vores kunder siden vores start, og med væksten af generativ AI er vi fortsat forpligtet til at bygge innovativ teknologi sammen. For at give kunderne mulighed for at udnytte kraften i vores generative AI, skal de vide, at de er beskyttet. AWS tilbyder dækning af copyright-skadesløshed for output fra følgende Amazon generative AI-tjenester: Amazon Titan Text Express, Amazon Titan Text Lite, Amazon Titan Embeddings, Amazon Titan Multimodal Embeddings, Amazon CodeWhisperer Professional, AWS HealthScribe, Amazon Lexog Amazon Tilpas. Dette betyder, at kunder, der bruger tjenesterne ansvarligt, er beskyttet mod tredjepartskrav, der påstår krænkelse af ophavsretten som følge af output genereret af disse tjenester (se afsnit 50.10 i Servicevilkår). Derudover beskytter vores standard IP-skadeserstatning for brug af tjenesterne kunder mod krav fra tredjeparter om påstand om IP-krænkelse af tjenesterne og de data, der bruges til at træne dem. For at sige det på en anden måde, hvis du bruger en Amazon generativ AI-tjeneste angivet ovenfor, og nogen sagsøger dig for IP-krænkelse, vil AWS forsvare denne retssag, som omfatter dækning af enhver dom mod dig eller forligsomkostninger.

Vi står bag vores generative AI-tjenester og arbejder på løbende at forbedre dem. Efterhånden som AWS lancerer nye tjenester, og generativ kunstig intelligens fortsætter med at udvikle sig, vil AWS fortsat ubønhørligt fokusere på at tjene og fastholde kundernes tillid.

Forbedring af gennemsigtighed: AWS AI Service Card til Amazon Titan Text

We introducerede AWS AI Service Cards på re:Invent 2022 som en gennemsigtighedsressource for at hjælpe kunder med bedre at forstå vores AWS AI-tjenester. AI-servicekort er en form for ansvarlig AI-dokumentation, der giver kunderne et enkelt sted at finde information om de tilsigtede brugssager og begrænsninger, ansvarlige AI-designvalg og bedste praksis for implementering og ydeevneoptimering for vores AI-tjenester. De er en del af en omfattende udviklingsproces, vi påtager os at bygge vores tjenester på en ansvarlig måde, der adresserer retfærdighed, forklarlighed, sandhed og robusthed, styring, gennemsigtighed, privatliv og sikkerhed, sikkerhed og kontrollerbarhed.

På re:Invent i år annoncerer vi en nyt AI-servicekort til Amazon Titan Text at øge gennemsigtigheden i funderingsmodeller. Vi lancerer også fire nye AI-servicekort, herunder: Amazon Comprehend Detect PII, Amazon Transkribering Toksicitet Detektion, Amazon Rekognition Face Livenessog AWS HealthScribe. Du kan udforske hvert af disse kort på AWS hjemmeside. I takt med at generativ kunstig intelligens fortsætter med at vokse og udvikle sig, vil gennemsigtighed om, hvordan teknologi udvikles, testes og bruges, være en vigtig komponent for at opnå tillid fra både organisationer og deres kunder. Hos AWS er vi forpligtet til at fortsætte med at bringe gennemsigtighedsressourcer som AI-servicekort til det bredere fællesskab – og til at gentage og indsamle feedback om de bedste veje frem.

Investering i ansvarlig AI på tværs af hele den generative AI-livscyklus

Vi er begejstrede for de nye innovationer, der blev annonceret på re:Invent i denne uge, som giver vores kunder flere værktøjer, ressourcer og indbyggede beskyttelser til at bygge og bruge generativ AI sikkert. Fra modelevaluering til autoværn til vandmærkning kan kunder nu bringe generativ kunstig intelligens til deres organisation hurtigere, samtidig med at risikoen mindskes. Nye beskyttelser for kunder som IP-skadeserstatning og nye ressourcer til at øge gennemsigtigheden som yderligere AI-servicekort er også nøgleeksempler på vores forpligtelse til at opbygge tillid på tværs af teknologivirksomheder, politiske beslutningstagere, samfundsgrupper, videnskabsmænd og mere. Vi fortsætter med at foretage meningsfulde investeringer i ansvarlig AI på tværs af livscyklussen af en fundamentmodel – for at hjælpe vores kunder med at skalere AI på en sikker, sikker og ansvarlig måde.

Om forfatterne

Peter Hallinan leder initiativer inden for videnskab og praksis af ansvarlig AI hos AWS AI sammen med et team af ansvarlige AI-eksperter. Han har dyb ekspertise inden for kunstig intelligens (PhD, Harvard) og iværksætteri (Blindsight, solgt til Amazon). Hans frivillige aktiviteter har inkluderet at tjene som rådgivende professor ved Stanford University School of Medicine og som præsident for American Chamber of Commerce på Madagaskar. Når det er muligt, er han afsted i bjergene med sine børn: skiløb, klatring, vandreture og rafting

Peter Hallinan leder initiativer inden for videnskab og praksis af ansvarlig AI hos AWS AI sammen med et team af ansvarlige AI-eksperter. Han har dyb ekspertise inden for kunstig intelligens (PhD, Harvard) og iværksætteri (Blindsight, solgt til Amazon). Hans frivillige aktiviteter har inkluderet at tjene som rådgivende professor ved Stanford University School of Medicine og som præsident for American Chamber of Commerce på Madagaskar. Når det er muligt, er han afsted i bjergene med sine børn: skiløb, klatring, vandreture og rafting

Vasi Philomin er i øjeblikket VP for Generative AI hos AWS. Han leder generative AI-indsatser, herunder Amazon Bedrock, Amazon Titan og Amazon CodeWhisperer.

Vasi Philomin er i øjeblikket VP for Generative AI hos AWS. Han leder generative AI-indsatser, herunder Amazon Bedrock, Amazon Titan og Amazon CodeWhisperer.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-and-capabilities-to-enable-responsible-ai-innovation/

- :har

- :er

- :ikke

- $OP

- 10

- 100

- 125

- 2022

- 50

- a

- evne

- I stand

- Om

- over

- ledsaget

- nøjagtighed

- præcis

- tværs

- aktiviteter

- Desuden

- Yderligere

- adresser

- rådgivning

- mod

- AI

- AI-tjenester

- sigte

- tilpasse

- ens

- Alle

- langs med

- også

- Amazon

- Amazon Code Whisperer

- Amazon SageMaker

- Amazon Web Services

- amerikansk

- blandt

- an

- ,

- Annoncere

- annoncerede

- Annoncerer

- En anden

- enhver

- Anvendelse

- applikationer

- Indløs

- tilgang

- ER

- omkring

- AS

- spørge

- vurderinger

- At

- Automatisk Ur

- automatisk

- til rådighed

- undgå

- undgås

- AWS

- AWS re: Invent

- Balance

- Bank

- baseret

- BE

- været

- før

- bag

- Benchmarks

- BEDSTE

- bedste praksis

- Bedre

- mellem

- skævhed

- Bloker

- både

- brand

- bringe

- Bringer

- bred

- bredere

- bygge

- opbyg tillid

- Bygning

- bygget

- indbygget

- by

- CAN

- kapaciteter

- kapacitet

- kort

- Kort

- tilfælde

- tilfælde

- kategorier

- udfordringer

- Kammer

- Børn

- valg

- valg

- Vælg

- fordringer

- Klatring

- samarbejde

- bekæmpe

- kombination

- kommer

- Handel

- engagement

- engageret

- Fælles

- samfund

- Virksomheder

- selskab

- sammenligne

- Compliance

- komponent

- forstå

- omfattende

- overvejelser

- betragtes

- konsekvent

- Konsol

- rådgivning

- indeholder

- indhold

- løbende

- fortsæt

- fortsætter

- fortsættende

- ophavsret

- krænkelse af ophavsret

- Core

- Omkostninger

- dækning

- dækker

- kriterier

- For øjeblikket

- skik

- kunde

- Kunder

- data

- databeskyttelse

- datalogi

- datasæt

- Dage

- dyb

- dyb ekspertise

- Standard

- definere

- levere

- demografiske

- indsætte

- implementering

- Design

- konstrueret

- ønskes

- opdage

- udviklet

- Udvikling

- svært

- størrelse

- misinformation

- Mangfoldighed

- do

- dokumentation

- køre

- i løbet af

- e

- hver

- tjene

- Optjening

- nemmeste

- nemt

- let

- Uddannelse

- effektivt

- indsats

- enten

- bemyndiger

- muliggøre

- tilskyndes

- ende til ende

- forbedre

- Hele

- iværksætteri

- Ether (ETH)

- evaluere

- evaluere

- evaluering

- evalueringer

- Hver

- alle

- udvikle sig

- eksempel

- eksempler

- ophidset

- erfaring

- ekspertise

- eksperter

- Forklarlighed

- udforske

- Express

- Ansigtet

- fairness

- Fall

- hurtigere

- tilbagemeldinger

- få

- filtrere

- filtrering

- Filtre

- Finde

- slut

- Fornavn

- Fokus

- efter

- Til

- formular

- Videresend

- Foster

- Foundation

- fire

- fra

- yderligere

- Endvidere

- fremtiden

- samle

- genereret

- genererer

- generative

- Generativ AI

- given

- giver

- Global

- regeringsførelse

- Gruppens

- Grow

- Vækst

- skadelig

- seletøj

- Harvard

- hader

- hadefuld tale

- Have

- he

- hjælpe

- hjælper

- høj kvalitet

- hiking

- hans

- hus

- Hvordan

- HTTPS

- menneskelig

- identificere

- identificere

- if

- billede

- billeder

- gennemføre

- vigtigt

- Forbedre

- forbedring

- in

- starten

- omfatter

- medtaget

- omfatter

- Herunder

- Forøg

- industrier

- oplysninger

- informeret

- krænkelse

- initiativer

- innovere

- Innovation

- innovationer

- innovativ

- innovativ teknologi

- indgange

- integrere

- integreret

- beregnet

- interaktioner

- ind

- indføre

- introduceret

- indføre

- investering

- Investeringer

- usynlige

- IP

- IT

- rejse

- jpg

- lige

- Nøgle

- Kend

- Sprog

- stor

- lanceringer

- lancering

- retssag

- Leads

- Lets

- Niveau

- Leverage

- livscyklus

- ligesom

- GRÆNSE

- begrænsninger

- Limited

- Liste

- Børsnoterede

- opretholdelse

- lave

- maerker

- lykkedes

- meningsfuld

- midler

- mekanisme

- medicin

- Metrics

- tankerne

- formildende

- model

- modeller

- mere

- mest

- skal

- I nærheden af

- Behov

- Ny

- nu

- of

- off

- offensiv

- Tilbud

- on

- engang

- dem

- online

- netbank

- optimering

- Option

- Indstillinger

- or

- organisation

- organisationer

- Andet

- vores

- ud

- udgange

- egen

- del

- forbi

- ydeevne

- udføres

- Personligt

- phd

- PIO

- Place

- plato

- Platon Data Intelligence

- PlatoData

- politikker

- politiske beslutningstagere

- mulig

- magt

- praksis

- praksis

- præsident

- forhindrer

- Eksempel

- prioriterer

- prioritet

- Beskyttelse af personlige oplysninger

- Privatliv og sikkerhed

- behandle

- producere

- UPRÆK

- professionel

- Professor

- lovende

- fremme

- egenskaber

- beskyttet

- beskyttelse

- beskytter

- give

- forudsat

- udbydere

- leverer

- offentligt

- sætte

- kvalitet

- forespørgsler

- rejser

- rækkevidde

- hurtige

- hurtigt

- RE

- reducere

- frigive

- relevans

- forblive

- Fjern

- indberette

- påkrævet

- Kræver

- resistent

- ressource

- Ressourcer

- Svar

- reaktioner

- ansvar

- ansvarlige

- ansvarligt

- begrænset

- højre

- Risiko

- robusthed

- kører

- løber

- sikker

- sikkerhedsforanstaltninger

- sikkert

- Sikkerhed

- sagemaker

- samme

- Scale

- skala ai

- skalaer

- scanning

- Skole

- Videnskab

- forskere

- Sektion

- sikker

- sikkerhed

- se

- Vælg

- valg

- tjeneste

- Tjenester

- servering

- sæt

- indstilling

- afregning

- setup

- siden

- enkelt

- So

- solgt

- nogle

- Nogen

- specifikke

- tale

- tilbringe

- spredes

- Stage

- stå

- standard

- stående

- Stanford

- Stanford University

- strejke

- stil

- sådan

- Sues

- Understøttet

- vedvarende

- tager

- Opgaver

- hold

- Teknologier

- teknologiselskaber

- afprøvet

- Test

- tests

- tekst

- at

- oplysninger

- UK

- deres

- Them

- Disse

- de

- tredjepart

- denne

- denne uge

- i år

- dem

- Gennem

- tid

- titan

- til

- sammen

- værktøjer

- Emner

- Tog

- Kurser

- Gennemsigtighed

- gennemsigtig

- Stol

- TUR

- Uk

- forstå

- forpligter

- enestående

- universitet

- brug

- brug tilfælde

- anvendte

- Bruger

- brugere

- ved brug af

- afgørende

- Voice

- frivillig

- frivilligt

- vp

- ønsker

- vandmærke

- vandmærkning

- vand varemærker

- Vej..

- måder

- we

- web

- webservices

- Hjemmeside

- uge

- GODT

- var

- Hvad

- hvornår

- som

- mens

- WHO

- Hele

- bred

- Bred rækkevidde

- bredt

- vilje

- med

- inden for

- ord

- Arbejde

- arbejdsgange

- Workforce

- år

- i går

- dig

- zephyrnet