Vi ønsker alle at se vores ideelle menneskelige værdier afspejlet i vores teknologier. Vi forventer, at teknologier såsom kunstig intelligens (AI) ikke lyver for os, ikke diskriminerer og er sikre for os og vores børn at bruge. Alligevel står mange AI-skabere i øjeblikket over for tilbageslag for de skævheder, unøjagtigheder og problematiske datapraksis, der afsløres i deres modeller. Disse problemer kræver mere end en teknisk, algoritmisk eller AI-baseret løsning. I virkeligheden kræves en holistisk, socioteknisk tilgang.

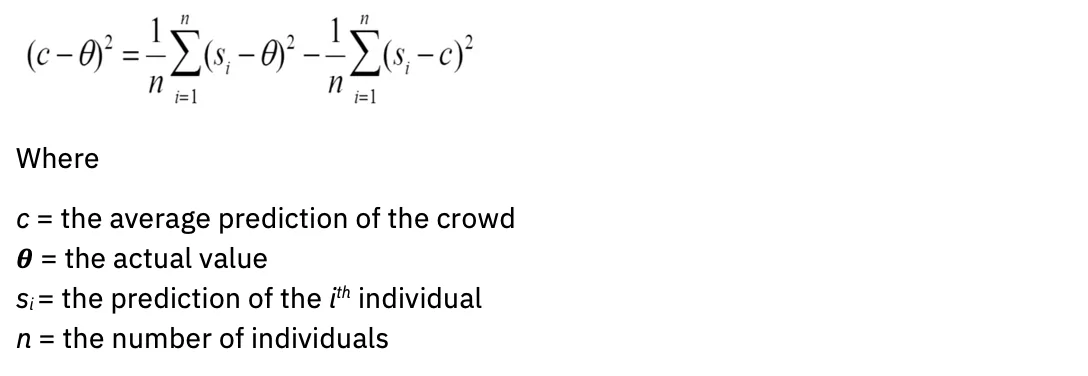

Matematikken demonstrerer en stærk sandhed

Alle prædiktive modeller, inklusive AI, er mere nøjagtige, når de inkorporerer forskellig menneskelig intelligens og erfaring. Dette er ikke en mening; den har empirisk gyldighed. Overvej mangfoldighedsforudsigelse. Kort sagt, når mangfoldigheden i en gruppe er stor, er mængdens fejl lille - hvilket understøtter konceptet "mængdens visdom". I en indflydelsesrig undersøgelse blev det vist, at forskellige grupper af problemløsere med lav evne kan udkonkurrere grupper af højevne problemløsere (Hong & Page, 2004).

I matematisk sprog: jo bredere din varians, jo mere standard er din gennemsnitlige. Ligningen ser sådan ud:

A yderligere studier leverede flere beregninger, der forfiner de statistiske definitioner af en klog skare, herunder uvidenhed om andre medlemmers forudsigelser og inklusion af dem med maksimalt anderledes (negativt korrelerede) forudsigelser eller vurderinger. Så det er ikke kun volumen, men mangfoldigheden, der forbedrer forudsigelserne. Hvordan kan denne indsigt påvirke evalueringen af AI-modeller?

Model (u)nøjagtighed

For at citere en almindelig aforisme er alle modeller forkerte. Dette gælder inden for områderne statistik, videnskab og kunstig intelligens. Modeller skabt med mangel på domæneekspertise kan føre til fejlagtig udgange.

I dag bestemmer en lillebitte homogen gruppe mennesker, hvilke data der skal bruges til at træne generative AI-modeller, som er hentet fra kilder, der i høj grad overrepræsenterer engelsk. "For de fleste af de over 6,000 sprog i verden er de tilgængelige tekstdata ikke nok til at træne en storstilet fundamentmodel" (fra "Om muligheder og risici ved funderingsmodeller", Bommasani et al., 2022).

Derudover er selve modellerne skabt ud fra begrænsede arkitekturer: "Næsten alle state-of-the-art NLP-modeller er nu tilpasset fra en af nogle få fundamentmodeller, såsom BERT, RoBERTa, BART, T5 osv. Mens denne homogenisering producerer ekstrem høj gearing (enhver forbedring i fundamentmodellerne kan føre til umiddelbare fordele på tværs af hele NLP), det er også et ansvar; alle AI-systemer kan arve de samme problematiske skævheder fra nogle få fundamentmodeller (Bommasani et al.) "

For at generativ AI bedre kan afspejle de forskellige samfund, den tjener, skal en langt bredere vifte af menneskelige data repræsenteres i modeller.

Evaluering af modellens nøjagtighed går hånd i hånd med evaluering af bias. Vi må spørge, hvad er hensigten med modellen, og for hvem er den optimeret? Overvej for eksempel, hvem der har mest gavn af indholdsanbefalingsalgoritmer og søgemaskinealgoritmer. Interessenter kan have vidt forskellige interesser og mål. Algoritmer og modeller kræver mål eller proxyer for Bayes-fejl: den minimale fejl, som en model skal forbedre. Denne proxy er ofte en person, såsom en emneekspert med domæneekspertise.

En meget menneskelig udfordring: Risikovurdering før modelanskaffelse eller udvikling

Nye AI-forskrifter og handlingsplaner understreger i stigende grad vigtigheden af algoritmiske konsekvensvurderingsskemaer. Målet med disse formularer er at indfange kritisk information om AI-modeller, så styringsteams kan vurdere og håndtere deres risici, før de implementeres. Typiske spørgsmål omfatter:

- Hvad er din models use case?

- Hvad er risikoen for uensartet påvirkning?

- Hvordan vurderer du retfærdighed?

- Hvordan gør du din model forklarlig?

Selvom det er designet med gode intentioner, er problemet, at de fleste ejere af AI-modeller ikke forstår, hvordan de skal vurdere risiciene for deres brugssag. Et almindeligt refræn kan være: "Hvordan kan min model være uretfærdig, hvis den ikke indsamler personligt identificerbare oplysninger (PII)?" Følgelig udfyldes formularerne sjældent med den omtanke, der er nødvendig for, at styringssystemerne nøjagtigt kan markere risikofaktorer.

Dermed understreges løsningens sociotekniske karakter. En modelejer – en person – kan ikke blot få en liste over afkrydsningsfelter til at vurdere, om deres anvendelsestilfælde vil forårsage skade. Det, der i stedet kræves, er grupper af mennesker med vidt forskellige livserfaringer, der samles i fællesskaber, der tilbyder psykologisk sikkerhed for at føre vanskelige samtaler om forskellig påvirkning.

Imødekommende bredere perspektiver for pålidelig kunstig intelligens

IBM® tror på at tage en "klient-nul"-tilgang og implementere de anbefalinger og systemer, det ville lave for sine egne kunder på tværs af rådgivning og produktledede løsninger. Denne tilgang strækker sig til etisk praksis, hvilket er grunden til, at IBM har oprettet et Trustworthy AI Center of Excellence (COE).

Som forklaret ovenfor er mangfoldigheden af erfaringer og færdigheder afgørende for korrekt at kunne evaluere virkningerne af AI. Men udsigten til at deltage i et Center of Excellence kan være skræmmende i en virksomhed, der er sprængfyldt med AI-innovatorer, eksperter og fremtrædende ingeniører, så det er nødvendigt at dyrke et fællesskab af psykologisk sikkerhed. IBM kommunikerer dette tydeligt ved at sige: "Interesseret i kunstig intelligens? Interesseret i AI-etik? Du har en plads ved dette bord."

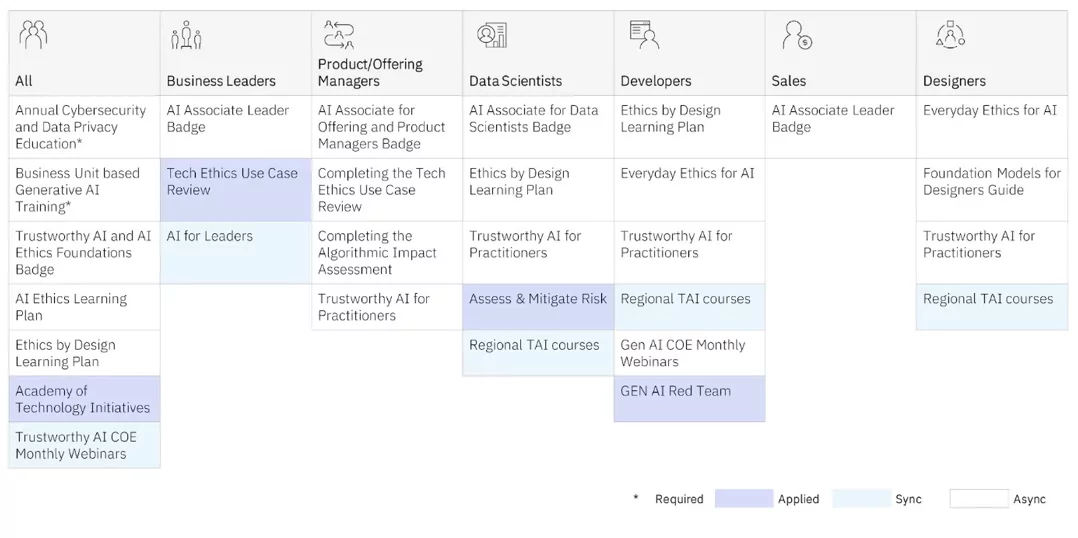

COE tilbyder træning i AI-etik til praktikere på alle niveauer. Der tilbydes både synkron læring (lærer og elever i klassemiljøer) og asynkrone (selv-guidede) programmer.

Men det er COE's anvendt træning, der giver vores praktikere den dybeste indsigt, da de arbejder med globale, forskelligartede, multidisciplinære teams på rigtige projekter for bedre at forstå forskellig påvirkning. De udnytter også designtænkningsrammer, som IBM's Design til AI group bruger internt og med kunder til at vurdere de utilsigtede virkninger af AI-modeller, og holder dem, der ofte er marginaliserede, øverst i sindet. (Se Sylvia Duckworths Hjulet af magt og privilegier for eksempler på, hvordan personlige egenskaber krydser hinanden for at privilegere eller marginalisere mennesker.) IBM donerede også mange af rammerne til open source-fællesskabet Design etisk.

Nedenfor er et par af de rapporter, IBM offentligt har offentliggjort om disse projekter:

Automatiserede AI-modelstyringsværktøjer er nødvendige for at få vigtig indsigt i, hvordan din AI-model klarer sig. Men bemærk, at fange risiko i god tid før din model er blevet udviklet og er i produktion er optimal. Ved at skabe fællesskaber af forskelligartede, tværfaglige praktikere, der tilbyder et sikkert rum for folk til at have hårde samtaler om forskellig påvirkning, kan du begynde din rejse til at operationalisere dine principper og udvikle AI på en ansvarlig måde.

I praksis, når du ansætter AI-udøvere, skal du overveje, at langt over 70 % af indsatsen med at skabe modeller er at kurere de rigtige data. Du ønsker at ansætte folk, der forstår at indsamle data, der er repræsentative, og som også indsamles med samtykke. Du vil også have, at folk, der ved, arbejder tæt sammen med domæneeksperter for at sikre sig, at de har den rigtige tilgang. Det er vigtigt at sikre, at disse udøvere har den følelsesmæssige intelligens til at nærme sig udfordringen med at kurere AI på en ansvarlig måde med ydmyghed og dømmekraft. Vi skal være bevidste om at lære at genkende, hvordan og hvornår AI-systemer kan forværre ulighed lige så meget, som de kan øge menneskelig intelligens.

Genopfind, hvordan din virksomhed arbejder med kunstig intelligens

Var denne artikel til hjælp?

JaIngen

Mere fra kunstig intelligens

IBM nyhedsbreve

Få vores nyhedsbreve og emneopdateringer, der leverer den seneste tankelederskab og indsigt i nye trends.

Tilmeld nu

Flere nyhedsbreve

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://www.ibm.com/blog/why-we-need-diverse-multidisciplinary-coes-for-model-risk/

- :har

- :er

- :ikke

- :hvor

- $OP

- 000

- 1

- 16

- 2022

- 2024

- 23

- 25

- 28

- 29

- 30

- 300

- 32

- 39

- 40

- 400

- 65

- 7

- 9

- a

- evne

- Om

- over

- AC

- fremskynde

- nøjagtighed

- præcis

- præcist

- tværs

- Handling

- tilpasset

- adresse

- indrømme

- vedtage

- Reklame

- rådgivning

- påvirke

- midler

- AI

- AI modeller

- AI-systemer

- sigte

- AL

- algoritmisk

- algoritmer

- Alle

- også

- altid

- amp

- an

- analytics

- ,

- enhver

- Anvendelse

- applikationer

- tilgang

- ER

- områder

- artikel

- kunstig

- kunstig intelligens

- Kunstig intelligens (AI)

- AS

- spørg

- vurdere

- Vurdering

- vurdering

- assistenter

- bistår

- At

- lyd

- forøge

- forfatter

- til rådighed

- undgå

- tilbage

- afbalancering

- BE

- været

- før

- begynde

- være

- mener

- fordele

- Bedre

- Beyond

- skævhed

- fordomme

- Blog

- blogs

- Blå

- boston

- både

- bredere

- Bygning

- virksomhed

- forretningsfunktioner

- virksomheder

- men

- .

- by

- CAN

- fange

- Optagelse

- kulstof

- kort

- Kort

- hvilken

- tilfælde

- KAT

- Boligtype

- Årsag

- center

- Center for ekspertise

- central

- vis

- udfordre

- karakteristika

- chatbots

- kontrollere

- barn

- Børn

- kredse

- CIS

- klasse

- tydeligt

- kunder

- nøje

- Cloud

- farve

- kombination

- kommer

- Fælles

- Fællesskaber

- samfund

- Virksomheder

- selskab

- Afsluttet

- Konceptet

- samtykke

- følgelig

- Overvej

- rådgivning

- Container

- fortsæt

- samtaler

- Core

- korrigere

- korreleret

- Koste

- kunne

- oprettet

- Oprettelse af

- skabere

- kritisk

- crowd

- CSS

- curating

- For øjeblikket

- skik

- kunde

- Kundeoplevelse

- Kunder

- data

- Dato

- afgørelser

- dybeste

- Standard

- definitioner

- levere

- demonstrerer

- implementering

- beskrivelse

- Design

- designtænkning

- konstrueret

- Bestem

- udvikle

- udviklet

- forskellige

- svært

- digital

- Digital Transformation

- dårskab

- Distinguished

- forskelligartede

- Mangfoldighed

- do

- domæne

- doneret

- trukket

- køre

- E&T

- effekter

- indsats

- eliminere

- indlejring

- omfavne

- smergel

- medarbejdere

- muliggøre

- engagerende

- Engine (Motor)

- Ingeniører

- Engelsk

- nok

- sikring

- Indtast

- fejl

- etc.

- Ether (ETH)

- etisk

- etik

- evaluere

- evaluere

- evaluering

- Endog

- Hver

- overalt

- forværre

- eksempel

- eksempler

- Excellence

- Udgang

- forvente

- erfaring

- Oplevelser

- ekspert

- ekspertise

- eksperter

- forklarede

- udsat

- udvider

- ekstremt

- facebook messenger

- lette

- vender

- faktorer

- fairness

- falsk

- langt

- FAST

- få

- Finde

- Fokus

- følger

- efter

- skrifttyper

- Til

- forkant

- formularer

- Foundation

- rammer

- fra

- forsiden

- funktioner

- samle

- indsamlede

- indsamling

- generative

- Generativ AI

- generator

- få

- given

- giver

- Global

- mål

- Mål

- Goes

- godt

- regeringsførelse

- Grammatik

- stærkt

- Grid

- gruppe

- Gruppens

- Vækst

- vejlede

- skade

- Have

- Overskrift

- høre

- højde

- hjælpe

- hjælpsom

- Høj

- ham

- leje

- Ansættelse

- hans

- besidder

- holistisk

- Home

- Hvordan

- How To

- HTTPS

- menneskelig

- menneskelig intelligens

- ydmyghed

- Hybrid

- Hybrid sky

- i

- SYG

- IBM

- ICO

- ICON

- ideal

- identificeret

- if

- Uvidenhed

- billede

- umiddelbar

- KIMOs Succeshistorier

- Påvirkninger

- gennemføre

- gennemføre

- betydning

- vigtigt

- Forbedre

- forbedringer

- forbedrer

- in

- omfatter

- Herunder

- inklusion

- indarbejde

- stigende

- inkremental

- indeks

- industrien

- Indflydelsesrig

- oplysninger

- Innovation

- innovatorer

- indgang

- indsigt

- indsigt

- øjeblikkeligt

- i stedet

- Institut

- forsikring

- forsikringsselskaber

- Intelligens

- Intelligent

- hensigt

- Forsætlig

- intentioner

- interesseret

- interesser

- internt

- Gennemskær

- indgriben

- skræmmende

- iboende

- isn

- spørgsmål

- spørgsmål

- IT

- ITS

- januar

- deltage

- Kontakt os

- rejse

- jpg

- lige

- holde

- Nøgle

- Kend

- kendt

- Mangel

- Sprog

- Sprog

- stor

- storstilet

- seneste

- føre

- leder

- Leadership" (virkelig menneskelig ledelse)

- læring

- lad

- Niveau

- Leverage

- ansvar

- ligge

- ligesom

- Limited

- Liste

- lokale

- Local

- UDSEENDE

- lave

- Making

- ledelse

- manuel

- mange

- matematik

- matematiske

- Matter

- max-bredde

- Kan..

- me

- betyde

- Mød

- budbringer

- måske

- minut

- tankerne

- minimum

- minutter

- Mobil

- model

- modeller

- modernisering

- mere

- mest

- bevæge sig

- meget

- tværfaglig

- skal

- my

- Natur

- Navigation

- nødvendig

- Behov

- behov

- behov

- negativt

- Ny

- nye produkter

- Nyhedsbreve

- NLP

- ingen

- Bemærk

- intet

- nu

- talrige

- of

- off

- tilbyde

- tilbydes

- Tilbud

- tit

- on

- ONE

- open source

- Udtalelse

- Muligheder

- optimal

- optimeret

- or

- organisationer

- Andet

- vores

- udkonkurrerer

- udgange

- i løbet af

- egen

- ejere

- side

- deltager

- passerer

- Mennesker

- udfører

- person,

- personale

- Personligt

- perspektiver

- PHP

- PIO

- planer

- plato

- Platon Data Intelligence

- PlatoData

- plugin

- politik

- position

- Indlæg

- potentiale

- potentielle kunder

- magt

- vigtigste

- praksis

- praksis

- forudsigelse

- Forudsigelser

- forudsigende

- primære

- principper

- Prioriter

- privilegium

- Problem

- indkøb

- producerer

- produktion

- produktivitet

- Produkter

- Programmer

- projekter

- korrekt

- udsigten

- forudsat

- leverer

- fuldmagter

- proxy

- psykologiske

- offentligt

- offentliggjort

- sætte

- Spørgsmål

- hurtigt

- citere

- sjældent

- Readiness

- Læsning

- ægte

- Reality

- genkende

- anbefalinger

- reducere

- raffinere

- afspejler

- afspejles

- regler

- Rapporter

- repræsentativt

- repræsenteret

- anmodninger

- kræver

- påkrævet

- forskning

- reagere

- ansvarlige

- ansvarligt

- lydhør

- indtægter

- Omsætningsvækst

- højre

- Risiko

- risikofaktorer

- risici

- vej

- robotter

- sikker

- Sikkerhed

- Said

- samme

- siger

- Scale

- skalering

- Videnskab

- Skærm

- scripts

- Søg

- søgemaskine

- sikker

- se

- SEO

- tjener

- indstillinger

- bør

- vist

- ganske enkelt

- websted

- slæk

- lille

- Smart

- Smarte højttalere

- SMS

- So

- løsninger

- Løsninger

- nogle

- Kilder

- Space

- højttalere

- Sponsoreret

- firkanter

- interessenter

- standard

- starte

- state-of-the-art

- statistiske

- statistik

- Studerende

- Studere

- emne

- Hold mig opdateret

- sådan

- support

- Støtte

- SVG

- Systemer

- T

- bord

- tager

- mål

- lærer

- hold

- Teknisk

- Teknologier

- tertiære

- tekst

- end

- tak

- at

- verdenen

- deres

- Them

- tema

- selv

- Disse

- de

- tror

- Tænker

- denne

- dem

- tænkte

- tænkt lederskab

- tre

- Gennem

- tid

- Titel

- til

- sammen

- værktøjer

- top

- emne

- hård

- Tog

- Kurser

- Transformation

- Tendenser

- sand

- troværdig

- to

- typen

- typisk

- forstå

- urimelig

- enestående

- oplåsning

- opdateringer

- på

- URL

- us

- brug

- brug tilfælde

- bruger

- Ved hjælp af

- værdi

- Værdier

- række

- Varierende

- meget

- Virtual

- bind

- W

- ønsker

- var

- we

- GODT

- Hvad

- Hvad er

- hvornår

- hvorvidt

- som

- mens

- WHO

- hvem

- hvorfor

- bredt

- bredere

- vilje

- visdom

- KLOG

- med

- ord

- WordPress

- Arbejde

- virker

- world

- ville

- skriftlig

- Forkert

- endnu

- dig

- Din

- zephyrnet