Et teknisk papir med titlen "WWW: What, When, Where to Compute-in-Memory" blev udgivet af forskere ved Purdue University.

Abstract:

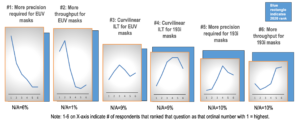

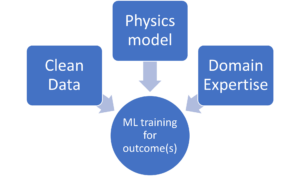

"Compute-in-memory (CiM) er dukket op som en overbevisende løsning til at lette høje omkostninger til dataflytning i von Neumann-maskiner. CiM kan udføre massivt parallelle generel matrix multiplikation (GEMM) operationer i hukommelsen, den dominerende beregning i Machine Learning (ML) inferens. Men genanvendelse af hukommelse til databehandling stiller nøglespørgsmål om 1) Hvilken type CiM der skal bruges: I betragtning af et væld af analoge og digitale CiM'er er det nødvendigt at bestemme deres egnethed fra et systemperspektiv. 2) Hvornår skal CiM bruges: ML-inferens inkluderer arbejdsbelastninger med en række forskellige hukommelses- og computerkrav, hvilket gør det vanskeligt at identificere, hvornår CiM er mere fordelagtigt end standardbehandlingskerner. 3) Hvor skal CiM integreres: Hvert hukommelsesniveau har forskellig båndbredde og kapacitet, hvilket påvirker databevægelsen og lokalitetsfordelene ved CiM-integration.

I dette papir undersøger vi svar på disse spørgsmål vedrørende CiM-integration til ML-inferensacceleration. Vi bruger Timeloop-Accelergy til tidlig system-niveau evaluering af CiM prototyper, herunder både analoge og digitale primitiver. Vi integrerer CiM i forskellige cachehukommelsesniveauer i en Nvidia A100-lignende baseline-arkitektur og skræddersyer dataflowet til forskellige ML-arbejdsbelastninger. Vores eksperimenter viser, at CiM-arkitekturer forbedrer energieffektiviteten og opnår op til 0.12x lavere energi end den etablerede baseline med INT-8-præcision og op til 4x ydeevneforøgelser med vægtindfletning og duplikering. Det foreslåede arbejde giver indsigt i, hvilken type CiM der skal bruges, og hvornår og hvor man optimalt kan integrere det i cachehierarkiet til GEMM-acceleration."

Find teknisk papir her. Udgivet december 2023 (fortryk).

Sharma, Tanvi, Mustafa Ali, Indranil Chakraborty og Kaushik Roy. "WWW: Hvad, hvornår, hvor skal man beregne-i-hukommelse." arXiv preprint arXiv:2312.15896 (2023).

Beslægtet læsning

Øget AI-energieffektivitet med beregning i hukommelsen

Sådan behandler du zettascale-arbejdsbelastninger og holder dig inden for et fast strømbudget.

Modellering af beregning i hukommelse med biologisk effektivitet

Generativ AI tvinger chipproducenter til at bruge computerressourcer mere intelligent.

SRAM In AI: The Future Of Memory

Hvorfor SRAM ses som et kritisk element i nye og traditionelle computerarkitekturer.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://semiengineering.com/cim-integration-for-ml-inference-acceleration/

- :har

- :er

- :hvor

- $OP

- 1

- 2023

- a

- acceleration

- opnå

- AI

- lindre

- an

- ,

- svar

- arkitektur

- AS

- At

- båndbredde

- Baseline

- gavnlig

- fordele

- både

- budget

- by

- cache

- CAN

- Kapacitet

- overbevisende

- beregning

- Compute

- Omkostninger

- kritisk

- data

- december

- bestemmelse

- forskellige

- svært

- digital

- dominerende

- hver

- Tidligt

- effektivitet

- element

- opstået

- energi

- energieffektivitet

- etableret

- evaluering

- eksperimenter

- udforske

- fast

- Til

- Forces

- fra

- fremtiden

- gevinster

- Generelt

- given

- link.

- hierarki

- Høj

- Men

- HTTPS

- identificere

- Forbedre

- in

- omfatter

- Herunder

- indsigt

- integrere

- integration

- ind

- IT

- jpg

- Nøgle

- læring

- Niveau

- niveauer

- lavere

- maskine

- machine learning

- Maskiner

- Making

- massivt

- Matrix

- Hukommelse

- ML

- mere

- bevægelse

- mangfoldighed

- behov

- Ny

- Nvidia

- of

- on

- åbent

- Produktion

- vores

- Papir

- Parallel

- udføre

- ydeevne

- perspektiv

- plato

- Platon Data Intelligence

- PlatoData

- udgør

- magt

- Precision

- behandle

- forarbejdning

- foreslog

- prototyper

- giver

- offentliggjort

- Spørgsmål

- om

- Krav

- forskere

- Ressourcer

- roy

- Vis

- løsninger

- standard

- forblive

- egnethed

- Systemer

- Teknisk

- end

- at

- Fremtiden

- deres

- Disse

- denne

- titlen

- til

- traditionelle

- typen

- universitet

- brug

- række

- forskellige

- set

- af

- var

- we

- vægt

- Hvad

- hvornår

- med

- inden for

- Arbejde

- zephyrnet