Josh Lospinosos første cybersikkerhedsstartup blev erhvervet i 2017 af Raytheon/Forcepoint. Hans anden, Shift5, arbejder med det amerikanske militær, jernbaneoperatører og flyselskaber, herunder JetBlue. En 2009 West Point grad og Rhodes Scholar, den 36-årige tidligere hærkaptajn tilbragte mere end et årti forfatter hacking værktøjer for National Security Agency og US Cyber Command.

Lospinoso fortalte for nylig et Senatets væbnede tjenesters underudvalg, hvordan kunstig intelligens kan hjælpe med at beskytte militære operationer. Den administrerende direktør/programmør diskuterede emnet med Associated Press samt, hvordan softwaresårbarheder i våbensystemer er en stor trussel mod det amerikanske militær. Interviewet er redigeret for klarhed og længde.

Spørgsmål: I dit vidnesbyrd beskrev du to hovedtrusler mod AI-aktiverede teknologier: Den ene er tyveri. Det er selvforklarende. Den anden er dataforgiftning. Kan du forklare det?

A: En måde at tænke på dataforgiftning er som digital desinformation. Hvis modstandere er i stand til at skabe de data, som AI-aktiverede teknologier ser, kan de have stor indflydelse på, hvordan denne teknologi fungerer.

Spørgsmål: Er der dataforgiftning i gang?

A: Vi ser det ikke bredt. Men det er sket. En af de mest kendte sager skete i 2016. Microsoft udgav en Twitter-chatbot ved navn Tay, som lærte af samtaler, den havde online. Ondsindede brugere konspirerede for at tweete krænkende, stødende sprog på det. Tay begyndte at generere inflammatorisk indhold. Microsoft tog det offline.

Q: AI er ikke kun chatbots. Det har længe været en integreret del af cybersikkerhed, ikke?

A: AI bruges i e-mail-filtre til at forsøge at markere og adskille junkmail og phishing-lokker. Et andet eksempel er endepunkter, som antivirusprogrammet på din bærbare computer – eller malware-detektionssoftware, der kører på netværk. Selvfølgelig bruger offensive hackere også AI til at forsøge at besejre disse klassifikationssystemer. Det kaldes adversarial AI.

Q: Lad os tale om militære softwaresystemer. Et alarmerende 2018 Rapport fra regeringens ansvarlighedskontor sagde, at næsten alle nyudviklede våbensystemer havde missionskritiske sårbarheder. Og Pentagon tænker på at sætte kunstig intelligens i sådanne systemer?

A: Der er to problemer her. For det første skal vi sikre de eksisterende våbensystemer tilstrækkeligt. Det er en teknisk gæld, vi har, som vil tage meget lang tid at betale. Så er der en ny grænse for at sikre AI-algoritmer – nye ting, som vi ville installere. GAO-rapporten talte ikke rigtig om AI. Så glem AI et øjeblik. Hvis disse systemer bare forblev, som de er, er de stadig dybt sårbare.

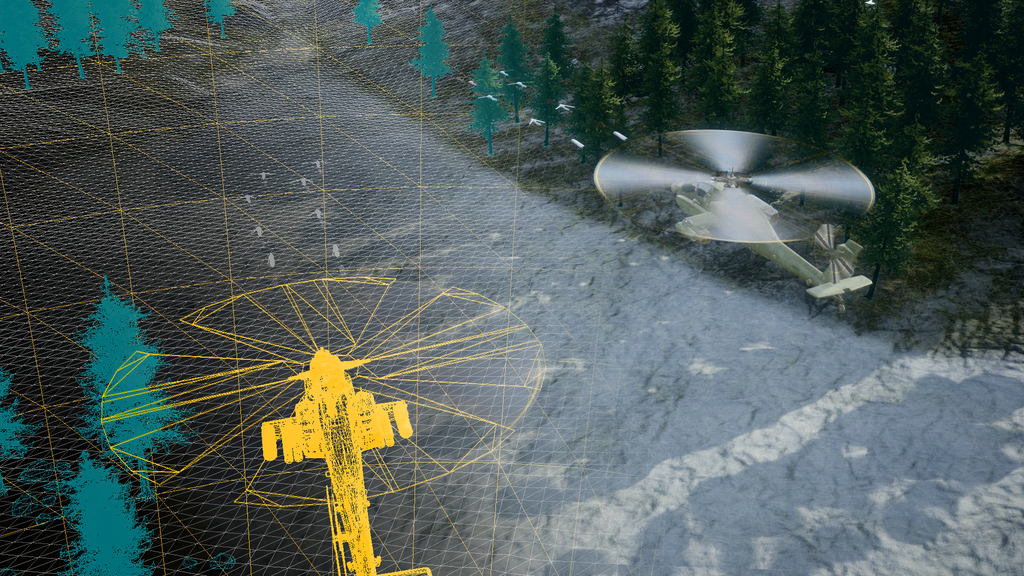

Vi diskuterer at skubbe rammerne og tilføje AI-aktiverede funktioner til ting som forbedret vedligeholdelse og operationel intelligens. Alt sammen fantastisk. Men vi bygger oven på et korthus. Mange systemer er årtier gamle, eftermonteret med digitale teknologier. Fly, landkøretøjer, rumaktiver, ubåde. De er nu forbundet. Vi bytter data ind og ud. Systemerne er porøse, svære at opgradere og kan blive angrebet. Når først en angriber får adgang, er spillet slut.

Nogle gange er det nemmere at bygge en ny platform end at redesigne eksisterende systems digitale komponenter. Men der er en rolle for AI i sikringen af disse systemer. AI kan bruges til at forsvare, hvis nogen forsøger at kompromittere dem.

Spørgsmål: Du vidnede om, at det ville være en dårlig idé at sætte AI-forskning på pause, som nogle har opfordret til, fordi det ville favorisere Kina og andre konkurrenter. Men du er også bekymret over det store hastværk til AI-produkter. Hvorfor?

A: Jeg hader at lyde fatalistisk, men den såkaldte "branding-use"-sag ser ud til at gælde. Et produkt, der skynder sig på markedet, bryder ofte i brand (bliver hacket, fejler, gør utilsigtet skade). Og vi siger: 'Dreng, vi skulle have indbygget sikkerhed.' Jeg forventer, at tempoet i AI-udviklingen vil accelerere, og vi holder måske ikke pause nok til at gøre dette på en sikker og ansvarlig måde. I det mindste Det Hvide Hus og Kongressen diskuterer disse spørgsmål.

Spørgsmål: Det ser ud til, at en flok virksomheder – inklusive i forsvarssektoren – skynder sig at annoncere halvbagte AI-produkter.

A: Alle teknologivirksomheder og mange ikke-teknologiske virksomheder har næsten gjort et rystende omdrejningspunkt i retning af AI. Økonomiske dislokationer er på vej. Forretningsmodeller vil grundlæggende ændre sig. Forskydninger sker allerede eller er i horisonten - og virksomhedsledere forsøger ikke at blive fanget fladfodet.

Q: Hvad med brugen af kunstig intelligens i militær beslutningstagning såsom målretning?

A: Jeg tror ikke, kategorisk ikke, at kunstig intelligens-algoritmer - de data, vi indsamler - er klar til bedste sendetid for et dødeligt våbensystem til at træffe beslutninger. Det er vi bare så langt fra.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoAiStream. Web3 Data Intelligence. Viden forstærket. Adgang her.

- Udmøntning af fremtiden med Adryenn Ashley. Adgang her.

- Køb og sælg aktier i PRE-IPO-virksomheder med PREIPO®. Adgang her.

- Kilde: https://www.defensenews.com/artificial-intelligence/2023/05/29/adversarial-ai-a-threat-to-military-systems-shift5s-lospinoso-says/

- :har

- :er

- :ikke

- 2016

- 2017

- 2018

- 70

- a

- I stand

- Om

- fremskynde

- adgang

- ansvarlighed

- erhvervede

- tilføje

- tilstrækkeligt

- kontradiktorisk

- agentur

- AI

- ai forskning

- fly

- Flyselskaber

- algoritmer

- Alle

- allerede

- også

- an

- ,

- Annoncere

- En anden

- antivirus

- Indløs

- ER

- væbnet

- Army

- kunstig

- kunstig intelligens

- AS

- Aktiver

- forbundet

- At

- Bad

- BE

- fordi

- været

- begyndte

- bredt

- bygge

- Bygning

- bygget

- Bunch

- virksomhed

- men

- by

- kaldet

- CAN

- kapaciteter

- Kort

- tilfælde

- tilfælde

- fanget

- lave om

- chatbot

- chatbots

- Kina

- klarhed

- klassificering

- Indsamling

- kommer

- Virksomheder

- selskab

- konkurrenter

- komponenter

- kompromis

- Bekymringer

- Kongressen

- indhold

- samtaler

- kunne

- kursus

- håndværk

- kritisk

- Cyber

- Cybersecurity

- data

- Gæld

- årti

- årtier

- Beslutningstagning

- afgørelser

- Forsvar

- beskrevet

- Detektion

- udviklet

- Udvikling

- digital

- drøftet

- diskuterer

- misinformation

- do

- gør

- lettere

- Økonomisk

- nok

- Hver

- eksempel

- eksisterende

- forvente

- Forklar

- mislykkes

- langt

- favorisere

- Filtre

- Brand

- Fornavn

- Til

- Tidligere

- fra

- Frontier

- fundamentalt

- gevinster

- spil

- GAO

- generere

- få

- gå

- stor

- Ground

- hacket

- hackere

- hacking

- havde

- skete

- Happening

- Hård Ost

- Have

- hovedet

- hjælpe

- link.

- hans

- horisont

- hus

- Hvordan

- HTTPS

- i

- idé

- if

- billeder

- KIMOs Succeshistorier

- forbedret

- in

- Herunder

- installere

- integral

- Intelligens

- sammenkoblet

- Interview

- ind

- spørgsmål

- IT

- jetBlå

- lige

- Sprog

- laptop

- ledere

- lærte

- mindst

- Længde

- ligesom

- Lang

- lang tid

- lavet

- vedligeholdelse

- større

- Making

- malware

- malware detektion

- mange

- Marked

- microsoft

- måske

- Militær

- Mission

- modeller

- mere

- Som hedder

- national

- national sikkerhed

- National Security Agency

- næsten

- Behov

- net

- Ny

- Ny platform

- roman

- nu

- forekom

- of

- offensiv

- Office

- offline

- tit

- Gammel

- on

- engang

- ONE

- online

- opererer

- operationelle

- Produktion

- Operatører

- or

- Andet

- ud

- i løbet af

- Tempo

- pause

- Betal

- femkant

- Phishing

- Pivot

- perron

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- trykke

- Prime

- Main

- Produkt

- Produkter

- Program

- beskytte

- Pushing

- Sætte

- jernbane

- klar

- virkelig

- for nylig

- redesign

- frigivet

- indberette

- forskning

- ansvarlige

- højre

- roller

- haste

- s

- Said

- siger

- siger

- Anden

- sektor

- sikker

- fastgørelse

- sikkerhed

- se

- se

- synes

- Senatet

- Tjenester

- bør

- So

- indtil nu

- Software

- nogle

- Nogen

- Lyd

- Space

- brugt

- opstart

- opholdt sig

- Stadig

- underudvalg

- emne

- sådan

- bytte

- systemet

- Systemer

- Tag

- Tal

- rettet mod

- tech

- Tech Company

- Teknisk

- Teknologier

- Teknologier

- vidnede

- vidnesbyrd

- end

- at

- tyveri

- Them

- derefter

- Der.

- Disse

- de

- ting

- tror

- Tænker

- denne

- dem

- trussel

- trusler

- tid

- til

- tog

- top

- mod

- prøv

- tweet

- to

- os

- opgradering

- brug

- anvendte

- brugere

- Køretøjer

- meget

- Sårbarheder

- Sårbar

- var

- Vej..

- we

- Våben

- GODT

- Vest

- Hvad

- hvid

- Hvide Hus

- hvorfor

- med

- virker

- ville

- dig

- Din

- zephyrnet