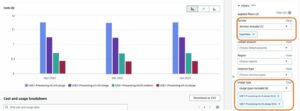

আজ, আমরা Llama 2 অনুমান এবং ফাইন-টিউনিং সমর্থনের উপলব্ধতা ঘোষণা করতে পেরে উত্তেজিত এডব্লিউএস ট্রেনিয়াম এবং এডাব্লুএস ইনফেরেন্টিয়া মধ্যে উদাহরণ আমাজন সেজমেকার জাম্পস্টার্ট. AWS Trainium এবং Inferentia ভিত্তিক দৃষ্টান্ত ব্যবহার করে, SageMaker-এর মাধ্যমে, ব্যবহারকারীদের 50% পর্যন্ত ফাইন-টিউনিং খরচ কমাতে সাহায্য করতে পারে, এবং প্রতি টোকেন লেটেন্সি কমিয়ে 4.7x কম স্থাপনার খরচ। লামা 2 হল একটি অটো-রিগ্রেসিভ জেনারেটিভ টেক্সট ল্যাঙ্গুয়েজ মডেল যা একটি অপ্টিমাইজড ট্রান্সফরমার আর্কিটেকচার ব্যবহার করে। একটি সর্বজনীনভাবে উপলব্ধ মডেল হিসাবে, Llama 2 অনেক NLP কাজের জন্য ডিজাইন করা হয়েছে যেমন পাঠ্য শ্রেণিবিন্যাস, অনুভূতি বিশ্লেষণ, ভাষা অনুবাদ, ভাষা মডেলিং, পাঠ্য প্রজন্ম এবং সংলাপ সিস্টেম। Llama 2-এর মতো এলএলএমগুলিকে ফাইন-টিউনিং এবং স্থাপন করা, ভাল গ্রাহক অভিজ্ঞতা প্রদানের জন্য রিয়েল টাইম পারফরম্যান্স পূরণ করা ব্যয়বহুল বা চ্যালেঞ্জিং হতে পারে। Trainium এবং AWS Inferentia, দ্বারা সক্ষম AWS নিউরন সফ্টওয়্যার ডেভেলপমেন্ট কিট (SDK), Llama 2 মডেলের প্রশিক্ষণ এবং অনুমানের জন্য একটি উচ্চ-কর্মক্ষমতা এবং সাশ্রয়ী বিকল্প অফার করে।

এই পোস্টে, আমরা SageMaker JumpStart-এ Trainium এবং AWS Inferentia দৃষ্টান্তগুলিতে লামা 2 কীভাবে স্থাপন এবং সূক্ষ্ম-টিউন করতে হয় তা প্রদর্শন করি।

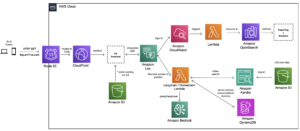

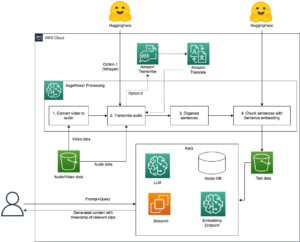

সমাধান ওভারভিউ

এই ব্লগে, আমরা নিম্নলিখিত পরিস্থিতিগুলির মধ্য দিয়ে হাঁটব:

- উভয় ক্ষেত্রে AWS Inferentia দৃষ্টান্তে Llama 2 স্থাপন করুন অ্যামাজন সেজমেকার স্টুডিও UI, একটি এক-ক্লিক স্থাপনার অভিজ্ঞতা এবং SageMaker Python SDK সহ।

- সেজমেকার স্টুডিও ইউআই এবং সেজমেকার পাইথন SDK উভয় ক্ষেত্রেই ট্রেনিয়ামের দৃষ্টান্তে লামা 2 সূক্ষ্ম-টিউন করুন।

- ফাইন-টিউনিং এর কার্যকারিতা দেখানোর জন্য সূক্ষ্ম-টিউনড লামা 2 মডেলের কার্যকারিতা পূর্ব-প্রশিক্ষিত মডেলের সাথে তুলনা করুন।

হাত পেতে, দেখুন GitHub উদাহরণ নোটবুক.

SageMaker Studio UI এবং Python SDK ব্যবহার করে AWS Inferentia দৃষ্টান্তগুলিতে Llama 2 স্থাপন করুন

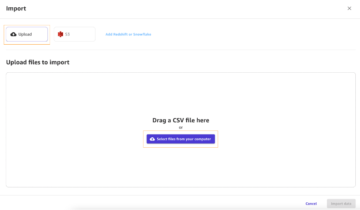

এই বিভাগে, আমরা প্রদর্শন করি যে কীভাবে একটি এক-ক্লিক স্থাপনার জন্য সেজমেকার স্টুডিও ইউআই ব্যবহার করে এবং পাইথন SDK-এর জন্য AWS Inferentia উদাহরণগুলিতে Llama 2 স্থাপন করা যায়।

SageMaker স্টুডিও UI-তে Llama 2 মডেলটি আবিষ্কার করুন

SageMaker JumpStart সর্বজনীনভাবে উপলব্ধ এবং মালিকানাধীন উভয় অ্যাক্সেস প্রদান করে ভিত্তি মডেল. ফাউন্ডেশন মডেলগুলি অনবোর্ড করা হয় এবং তৃতীয় পক্ষ এবং মালিকানাধীন প্রদানকারীদের থেকে রক্ষণাবেক্ষণ করা হয়। যেমন, তারা মডেল উত্স দ্বারা মনোনীত বিভিন্ন লাইসেন্সের অধীনে মুক্তি পায়। আপনি যে কোনো ফাউন্ডেশন মডেল ব্যবহার করেন তার লাইসেন্স পর্যালোচনা করতে ভুলবেন না। আপনি কোন প্রযোজ্য লাইসেন্স শর্তাবলী পর্যালোচনা এবং মেনে চলার জন্য দায়ী এবং সামগ্রী ডাউনলোড বা ব্যবহার করার আগে আপনার ব্যবহারের ক্ষেত্রে সেগুলি গ্রহণযোগ্য কিনা তা নিশ্চিত করার জন্য আপনি দায়ী৷

আপনি সেজমেকার স্টুডিও ইউআই এবং সেজমেকার পাইথন এসডিকে-তে সেজমেকার জাম্পস্টার্টের মাধ্যমে লামা 2 ফাউন্ডেশন মডেলগুলি অ্যাক্সেস করতে পারেন। এই বিভাগে, আমরা সেজমেকার স্টুডিওতে মডেলগুলি কীভাবে আবিষ্কার করব তা নিয়ে যাই।

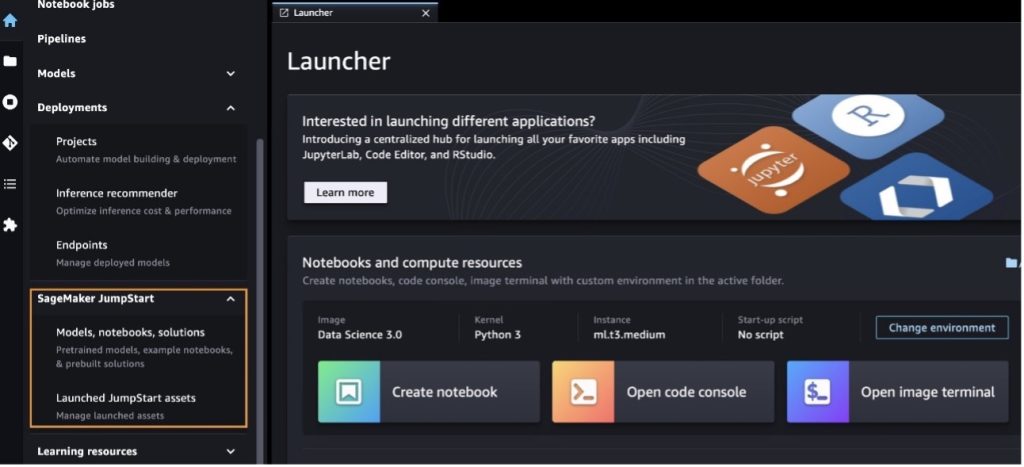

সেজমেকার স্টুডিও হল একটি ইন্টিগ্রেটেড ডেভেলপমেন্ট এনভায়রনমেন্ট (আইডিই) যা একটি একক ওয়েব-ভিত্তিক ভিজ্যুয়াল ইন্টারফেস প্রদান করে যেখানে আপনি ডেটা প্রস্তুত করা থেকে শুরু করে আপনার এমএল তৈরি, প্রশিক্ষণ এবং স্থাপন পর্যন্ত সমস্ত মেশিন লার্নিং (এমএল) ডেভেলপমেন্ট ধাপগুলি সম্পাদন করার জন্য উদ্দেশ্য-নির্মিত সরঞ্জামগুলি অ্যাক্সেস করতে পারেন। মডেল কীভাবে শুরু করবেন এবং সেজমেকার স্টুডিও সেট আপ করবেন সে সম্পর্কে আরও বিশদ বিবরণের জন্য দেখুন আমাজন সেজমেকার স্টুডিও।

আপনি সেজমেকার স্টুডিওতে থাকার পরে, আপনি সেজমেকার জাম্পস্টার্ট অ্যাক্সেস করতে পারবেন, যার মধ্যে রয়েছে পূর্ব-প্রশিক্ষিত মডেল, নোটবুক এবং পূর্বনির্মাণ সমাধানগুলি পূর্বনির্মাণ এবং স্বয়ংক্রিয় সমাধান. কিভাবে মালিকানাধীন মডেলগুলি অ্যাক্সেস করতে হয় সে সম্পর্কে আরও বিস্তারিত তথ্যের জন্য, পড়ুন Amazon SageMaker স্টুডিওতে Amazon SageMaker JumpStart থেকে মালিকানাধীন ভিত্তি মডেল ব্যবহার করুন.

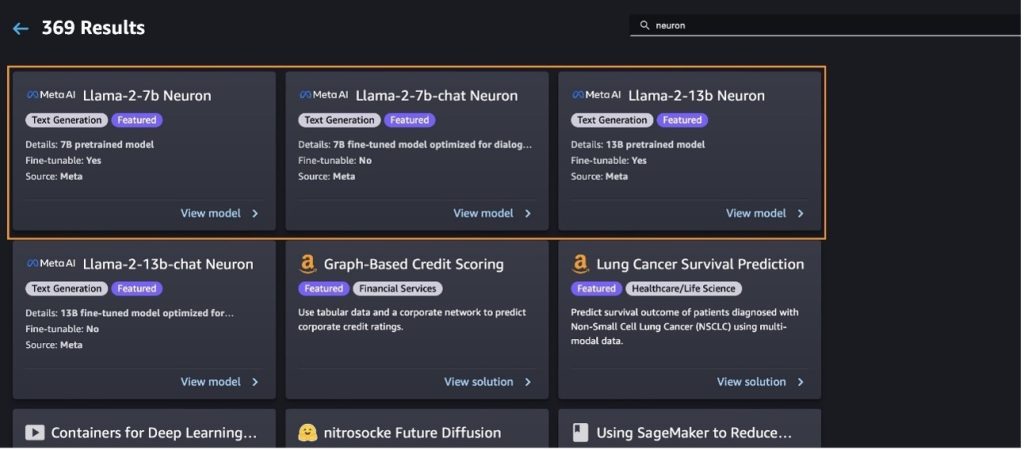

সেজমেকার জাম্পস্টার্ট ল্যান্ডিং পৃষ্ঠা থেকে, আপনি সমাধান, মডেল, নোটবুক এবং অন্যান্য সংস্থানগুলির জন্য ব্রাউজ করতে পারেন।

আপনি যদি Llama 2 মডেলগুলি দেখতে না পান, তাহলে বন্ধ করে এবং পুনরায় চালু করে আপনার SageMaker স্টুডিও সংস্করণ আপডেট করুন। সংস্করণ আপডেট সম্পর্কে আরও তথ্যের জন্য, পড়ুন বন্ধ করুন এবং স্টুডিও ক্লাসিক অ্যাপ আপডেট করুন.

এছাড়াও আপনি চয়ন করে অন্যান্য মডেল বৈকল্পিক খুঁজে পেতে পারেন সমস্ত পাঠ্য প্রজন্মের মডেলগুলি অন্বেষণ করুন৷ বা অনুসন্ধান llama or neuron অনুসন্ধান বাক্সে আপনি এই পৃষ্ঠায় লামা 2 নিউরন মডেল দেখতে সক্ষম হবেন।

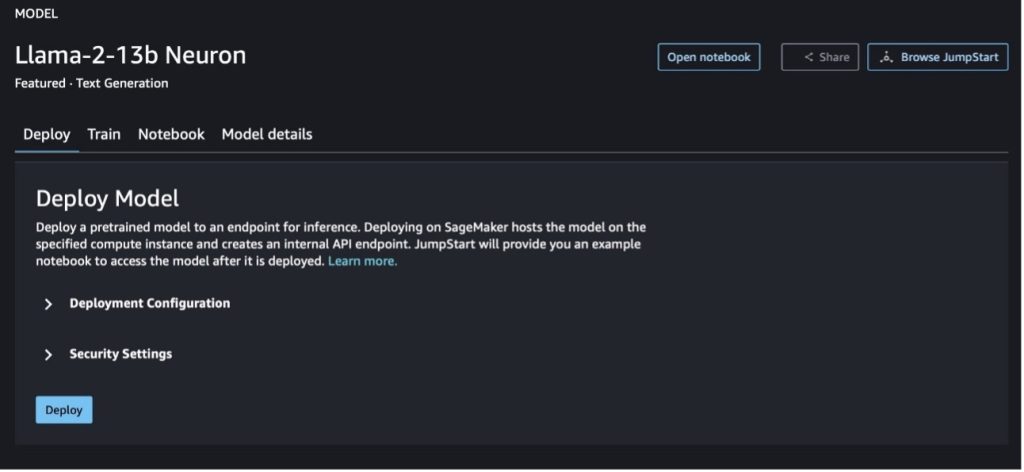

সেজমেকার জাম্পস্টার্টের সাথে Llama-2-13b মডেলটি স্থাপন করুন

আপনি মডেল সম্পর্কে বিশদ বিবরণ দেখতে মডেল কার্ড চয়ন করতে পারেন যেমন লাইসেন্স, প্রশিক্ষণে ব্যবহৃত ডেটা এবং এটি কীভাবে ব্যবহার করতে হয়। আপনি দুটি বোতাম খুঁজে পেতে পারেন, স্থাপন করুন এবং নোটবুক খুলুন, যা আপনাকে এই নো-কোড উদাহরণ ব্যবহার করে মডেল ব্যবহার করতে সাহায্য করে।

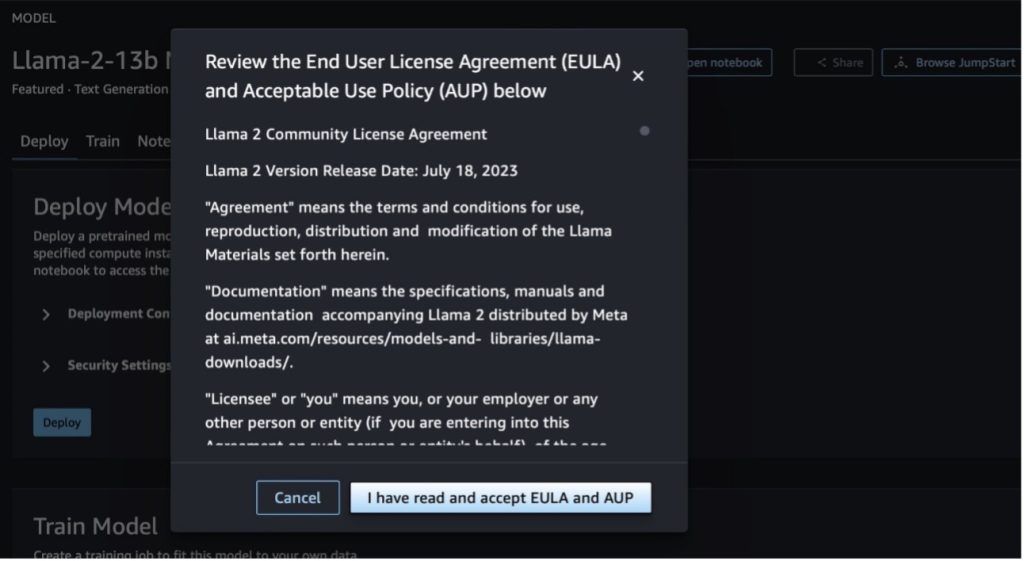

যখন আপনি যেকোনো একটি বোতাম বেছে নেবেন, তখন একটি পপ-আপ আপনাকে স্বীকার করার জন্য শেষ ব্যবহারকারী লাইসেন্স চুক্তি এবং গ্রহণযোগ্য ব্যবহার নীতি (AUP) দেখাবে।

আপনি নীতিগুলি স্বীকার করার পরে, আপনি মডেলের শেষ বিন্দু স্থাপন করতে পারেন এবং পরবর্তী বিভাগে পদক্ষেপগুলির মাধ্যমে এটি ব্যবহার করতে পারেন।

Python SDK এর মাধ্যমে Llama 2 নিউরন মডেল স্থাপন করুন

আপনি যখন চয়ন স্থাপন করুন এবং শর্তাবলী স্বীকার করুন, মডেল স্থাপনা শুরু হবে। বিকল্পভাবে, আপনি বেছে নিয়ে উদাহরণ নোটবুকের মাধ্যমে স্থাপন করতে পারেন নোটবুক খুলুন. উদাহরণ নোটবুকটি অনুমানের জন্য মডেলটি কীভাবে স্থাপন করতে হয় এবং সংস্থানগুলি পরিষ্কার করতে হয় সে সম্পর্কে শেষ থেকে শেষ নির্দেশিকা প্রদান করে।

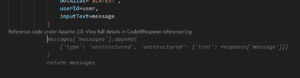

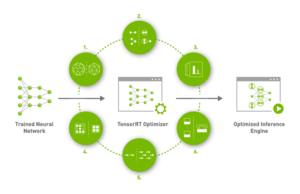

Trainium বা AWS Inferentia উদাহরণে একটি মডেল স্থাপন বা সূক্ষ্ম-টিউন করতে, আপনাকে প্রথমে PyTorch Neuron কল করতে হবে (টর্চ-নিউরনক্স) মডেলটিকে একটি নিউরন-নির্দিষ্ট গ্রাফে কম্পাইল করতে, যা এটিকে ইনফেরেনশিয়ার নিউরনকোরসের জন্য অপ্টিমাইজ করবে। ব্যবহারকারীরা অ্যাপ্লিকেশনের উদ্দেশ্যগুলির উপর নির্ভর করে কম্পাইলারকে সর্বনিম্ন লেটেন্সি বা সর্বোচ্চ থ্রুপুটের জন্য অপ্টিমাইজ করার নির্দেশ দিতে পারেন। জাম্পস্টার্টে, আমরা বিভিন্ন কনফিগারেশনের জন্য নিউরন গ্রাফগুলিকে প্রাক-সংকলন করেছি, যাতে ব্যবহারকারীদের সংকলন পদক্ষেপগুলি চুমুক দিতে পারে, দ্রুত সূক্ষ্ম-টিউনিং এবং মডেল স্থাপন করতে সক্ষম করে।

উল্লেখ্য যে নিউরন প্রাক-সংকলিত গ্রাফটি নিউরন কম্পাইলার সংস্করণের একটি নির্দিষ্ট সংস্করণের উপর ভিত্তি করে তৈরি করা হয়েছে।

AWS Inferentia-ভিত্তিক দৃষ্টান্তগুলিতে LIama 2 স্থাপন করার দুটি উপায় রয়েছে। প্রথম পদ্ধতিটি পূর্ব-নির্মিত কনফিগারেশন ব্যবহার করে, এবং আপনাকে কোডের মাত্র দুটি লাইনে মডেল স্থাপন করতে দেয়। দ্বিতীয়টিতে, কনফিগারেশনের উপর আপনার আরও বেশি নিয়ন্ত্রণ রয়েছে। আগে থেকে তৈরি কনফিগারেশনের সাথে প্রথম পদ্ধতিটি শুরু করা যাক এবং উদাহরণ হিসেবে প্রাক-প্রশিক্ষিত লামা 2 13B নিউরন মডেল ব্যবহার করা যাক। নিচের কোডটি দেখায় কিভাবে Llama 13B স্থাপন করতে হয় মাত্র দুটি লাইন দিয়ে:

এই মডেলগুলিতে অনুমান সঞ্চালন করতে, আপনাকে যুক্তিটি নির্দিষ্ট করতে হবে accept_eula হতে True এর অংশ হিসাবে model.deploy() কল এই যুক্তিটিকে সত্য হিসাবে সেট করা, স্বীকার করে যে আপনি মডেলটির EULA পড়েছেন এবং গ্রহণ করেছেন। EULA মডেল কার্ডের বিবরণে বা থেকে পাওয়া যাবে মেটা ওয়েবসাইট.

Llama 2 13B-এর ডিফল্ট উদাহরণের ধরন হল ml.inf2.8xlarge। এছাড়াও আপনি অন্যান্য সমর্থিত মডেল আইডি চেষ্টা করতে পারেন:

meta-textgenerationneuron-llama-2-7bmeta-textgenerationneuron-llama-2-7b-f(চ্যাট মডেল)meta-textgenerationneuron-llama-2-13b-f(চ্যাট মডেল)

বিকল্পভাবে, আপনি যদি ডিপ্লোয়মেন্ট কনফিগারেশনের উপর আরো নিয়ন্ত্রণ করতে চান, যেমন প্রসঙ্গ দৈর্ঘ্য, টেনসর সমান্তরাল ডিগ্রী, এবং সর্বাধিক রোলিং ব্যাচের আকার, আপনি পরিবেশগত ভেরিয়েবলের মাধ্যমে তাদের পরিবর্তন করতে পারেন, যেমন এই বিভাগে প্রদর্শিত হয়েছে। স্থাপনার অন্তর্নিহিত ডিপ লার্নিং কন্টেইনার (DLC) হল বড় মডেল ইনফারেন্স (LMI) NeuronX DLC. পরিবেশগত ভেরিয়েবলগুলি নিম্নরূপ:

- OPTION_N_POSITIONS - ইনপুট এবং আউটপুট টোকেনের সর্বাধিক সংখ্যা। উদাহরণস্বরূপ, যদি আপনি মডেল কম্পাইল সঙ্গে

OPTION_N_POSITIONS512 হিসাবে, তারপর আপনি 128 এর একটি ইনপুট টোকেন (ইনপুট প্রম্পট আকার) ব্যবহার করতে পারেন যার সর্বোচ্চ আউটপুট টোকেন 384 (মোট ইনপুট এবং আউটপুট টোকেন হতে হবে 512)। সর্বাধিক আউটপুট টোকেনের জন্য, 384-এর নীচের যে কোনও মান ঠিক আছে, তবে আপনি এটির বাইরে যেতে পারবেন না (উদাহরণস্বরূপ, ইনপুট 256 এবং আউটপুট 512)। - OPTION_TENSOR_PARALLEL_DEGREE - AWS Inferentia দৃষ্টান্তে মডেল লোড করার জন্য নিউরনকোরের সংখ্যা।

- OPTION_MAX_ROLLING_BATCH_SIZE - সমসাময়িক অনুরোধের জন্য সর্বোচ্চ ব্যাচের আকার।

- OPTION_DTYPE - মডেল লোড করার তারিখের ধরন।

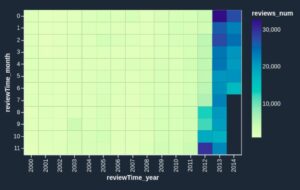

নিউরন গ্রাফের সংকলন প্রসঙ্গ দৈর্ঘ্যের উপর নির্ভর করে (OPTION_N_POSITIONS), টেনসর সমান্তরাল ডিগ্রী (OPTION_TENSOR_PARALLEL_DEGREE), সর্বোচ্চ ব্যাচ আকার (OPTION_MAX_ROLLING_BATCH_SIZE), এবং ডেটা টাইপ (OPTION_DTYPE) মডেল লোড করতে। সেজমেকার জাম্পস্টার্ট রানটাইম সংকলন এড়াতে পূর্ববর্তী পরামিতিগুলির জন্য বিভিন্ন কনফিগারেশনের জন্য নিউরন গ্রাফ পূর্ব-সংকলিত করেছে। পূর্ব-সংকলিত গ্রাফগুলির কনফিগারেশনগুলি নিম্নলিখিত সারণীতে তালিকাভুক্ত করা হয়েছে। যতক্ষণ না পরিবেশগত ভেরিয়েবলগুলি নিম্নলিখিত শ্রেণীগুলির মধ্যে একটিতে পড়ে, ততক্ষণ পর্যন্ত নিউরন গ্রাফগুলির সংকলন বাদ দেওয়া হবে।

| LIama-2 7B এবং LIama-2 7B চ্যাট | ||||

| দৃষ্টান্তের ধরণ | OPTION_N_POSITIONS | OPTION_MAX_ROLLING_BATCH_SIZE | OPTION_TENSOR_PARALLEL_DEGREE | OPTION_DTYPE |

| ml.inf2.xlarge | 1024 | 1 | 2 | fp16 |

| ml.inf2.8xlarge | 2048 | 1 | 2 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 4 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 4 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 24 | fp16 |

| LIama-2 13B এবং LIama-2 13B চ্যাট | ||||

| ml.inf2.8xlarge | 1024 | 1 | 2 | fp16 |

| ml.inf2.24xlarge | 2048 | 4 | 4 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 2048 | 4 | 4 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 24 | fp16 |

নিচে Llama 2 13B স্থাপন এবং সমস্ত উপলব্ধ কনফিগারেশন সেট করার একটি উদাহরণ।

এখন যেহেতু আমরা Llama-2-13b মডেলটি স্থাপন করেছি, আমরা শেষ বিন্দুকে আহ্বান করে এটির সাথে অনুমান চালাতে পারি। নিম্নলিখিত কোড স্নিপেট টেক্সট জেনারেশন নিয়ন্ত্রণ করতে সমর্থিত ইনফারেন্স প্যারামিটার ব্যবহার করে দেখায়:

- সর্বোচ্চ দৈর্ঘ্য - আউটপুট দৈর্ঘ্য (যা ইনপুট প্রসঙ্গ দৈর্ঘ্য অন্তর্ভুক্ত) না পৌঁছানো পর্যন্ত মডেলটি পাঠ্য তৈরি করে

max_length. নির্দিষ্ট করা হলে, এটি একটি ধনাত্মক পূর্ণসংখ্যা হতে হবে। - সর্বোচ্চ_নতুন_টোকেন - আউটপুট দৈর্ঘ্য (ইনপুট প্রসঙ্গের দৈর্ঘ্য ব্যতীত) পৌঁছানো পর্যন্ত মডেলটি পাঠ্য তৈরি করে

max_new_tokens. নির্দিষ্ট করা হলে, এটি একটি ধনাত্মক পূর্ণসংখ্যা হতে হবে। - সংখ্যা_বিম - এটি লোভী অনুসন্ধানে ব্যবহৃত বিমের সংখ্যা নির্দেশ করে। নির্দিষ্ট করা হলে, এটি অবশ্যই এর থেকে বড় বা সমান একটি পূর্ণসংখ্যা হতে হবে

num_return_sequences. - no_repeat_ngram_size – মডেল নিশ্চিত করে যে শব্দের একটি ক্রম

no_repeat_ngram_sizeআউটপুট ক্রম পুনরাবৃত্তি হয় না. নির্দিষ্ট করা হলে, এটি অবশ্যই 1-এর থেকে বড় একটি ধনাত্মক পূর্ণসংখ্যা হতে হবে। - তাপমাত্রা - এটি আউটপুটে এলোমেলোতা নিয়ন্ত্রণ করে। উচ্চ তাপমাত্রার ফলে কম-সম্ভাব্য শব্দের আউটপুট ক্রম হয়; কম তাপমাত্রার ফলে উচ্চ-সম্ভাব্য শব্দের আউটপুট ক্রম হয়। যদি

temperature0 এর সমান, এটি লোভী ডিকোডিং এর ফলাফল। নির্দিষ্ট করা হলে, এটি একটি ইতিবাচক ফ্লোট হতে হবে। - তাড়াতাড়ি_স্টপিং - যদি

True, টেক্সট জেনারেশন শেষ হয় যখন সমস্ত বীম হাইপোথিসিস বাক্যের টোকেনের শেষে পৌঁছায়। নির্দিষ্ট করা হলে, এটি বুলিয়ান হতে হবে। - do_sample - যদি

True, মডেল সম্ভাব্যতা অনুযায়ী পরবর্তী শব্দের নমুনা দেয়। নির্দিষ্ট করা হলে, এটি বুলিয়ান হতে হবে। - শীর্ষ_কে – টেক্সট প্রজন্মের প্রতিটি ধাপে, শুধুমাত্র থেকে মডেল নমুনা

top_kসম্ভবত শব্দ। নির্দিষ্ট করা হলে, এটি একটি ধনাত্মক পূর্ণসংখ্যা হতে হবে। - শীর্ষ_পি - পাঠ্য তৈরির প্রতিটি ধাপে, ক্রমবর্ধমান সম্ভাব্যতা সহ শব্দের ক্ষুদ্রতম সম্ভাব্য সেট থেকে মডেল নমুনা

top_p. নির্দিষ্ট করা থাকলে, এটি অবশ্যই 0-1 এর মধ্যে একটি ফ্লোট হতে হবে। - বন্ধ করা - নির্দিষ্ট করা থাকলে, এটি অবশ্যই স্ট্রিংয়ের একটি তালিকা হতে হবে। টেক্সট জেনারেশন বন্ধ হয়ে যায় যদি নির্দিষ্ট স্ট্রিংগুলির যেকোন একটি জেনারেট করা হয়।

নিম্নলিখিত কোড একটি উদাহরণ দেখায়:

আউটপুট:

পেলোডে প্যারামিটার সম্পর্কে আরও তথ্যের জন্য, পড়ুন বিশদ পরামিতি.

এছাড়াও আপনি প্যারামিটার বাস্তবায়ন অন্বেষণ করতে পারেন নোটবই নোটবুকের লিঙ্ক সম্পর্কে আরও তথ্য যোগ করতে।

সেজমেকার স্টুডিও ইউআই এবং সেজমেকার পাইথন এসডিকে ব্যবহার করে ট্রেনিয়াম দৃষ্টান্তে লামা 2 মডেলগুলিকে সূক্ষ্ম-টিউন করুন

জেনারেটিভ AI ফাউন্ডেশন মডেলগুলি ML এবং AI-তে প্রাথমিক ফোকাস হয়ে উঠেছে, তবে, স্বাস্থ্যসেবা বা আর্থিক পরিষেবাগুলির মতো নির্দিষ্ট ডোমেনে তাদের বিস্তৃত সাধারণীকরণ কম হতে পারে, যেখানে অনন্য ডেটাসেট জড়িত। এই সীমাবদ্ধতা ডোমেন-নির্দিষ্ট ডেটার সাথে এই বিশেষায়িত ক্ষেত্রগুলিতে তাদের কার্যকারিতা বাড়াতে এই জেনারেটিভ এআই মডেলগুলিকে সূক্ষ্ম-সুর করার প্রয়োজনীয়তা তুলে ধরে।

এখন যেহেতু আমরা লামা 2 মডেলের প্রাক-প্রশিক্ষিত সংস্করণ স্থাপন করেছি, আসুন আমরা কীভাবে সঠিকতা বাড়ানোর জন্য, দ্রুত সমাপ্তির পরিপ্রেক্ষিতে মডেলটিকে উন্নত করতে এবং মডেলটিকে মানিয়ে নিতে ডোমেন-নির্দিষ্ট ডেটাতে কীভাবে এটিকে সূক্ষ্ম-টিউন করতে পারি তা দেখি। আপনার নির্দিষ্ট ব্যবসায়িক ব্যবহারের ক্ষেত্রে এবং ডেটা। আপনি SageMaker Studio UI বা SageMaker Python SDK ব্যবহার করে মডেলগুলিকে সূক্ষ্ম-টিউন করতে পারেন। আমরা এই বিভাগে উভয় পদ্ধতি আলোচনা.

সেজমেকার স্টুডিওর সাথে Llama-2-13b নিউরন মডেলটি সূক্ষ্ম সুর করুন

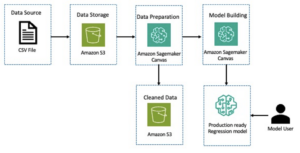

SageMaker স্টুডিওতে, Llama-2-13b নিউরন মডেলে নেভিগেট করুন। উপরে স্থাপন করুন ট্যাব, আপনি নির্দেশ করতে পারেন আমাজন সিম্পল স্টোরেজ সার্ভিস (Amazon S3) ফাইন-টিউনিংয়ের জন্য প্রশিক্ষণ এবং বৈধতা ডেটাসেট ধারণকারী বালতি। উপরন্তু, আপনি ফাইন-টিউনিংয়ের জন্য স্থাপনার কনফিগারেশন, হাইপারপ্যারামিটার এবং নিরাপত্তা সেটিংস কনফিগার করতে পারেন। তাহলে বেছে নাও রেলগাড়ি একটি সেজমেকার এমএল উদাহরণে প্রশিক্ষণের কাজ শুরু করতে।

Llama 2 মডেল ব্যবহার করতে, আপনাকে EULA এবং AUP গ্রহণ করতে হবে। আপনি যখন চয়ন করেন তখন এটি প্রদর্শিত হবে রেলগাড়ি। চয়ন করুন আমি EULA এবং AUP পড়েছি এবং গ্রহণ করেছি ফাইন-টিউনিং কাজ শুরু করতে।

আপনি পছন্দ করে সেজমেকার কনসোলের অধীনে সূক্ষ্ম-টিউনড মডেলের জন্য আপনার প্রশিক্ষণ কাজের অবস্থা দেখতে পারেন প্রশিক্ষণ কাজ নেভিগেশন ফলকে।

আপনি এই নো-কোড উদাহরণ ব্যবহার করে আপনার Llama 2 নিউরন মডেলটিকে সূক্ষ্ম-টিউন করতে পারেন, অথবা Python SDK-এর মাধ্যমে সূক্ষ্ম-টিউন করতে পারেন, যেমনটি পরবর্তী বিভাগে প্রদর্শিত হয়েছে।

SageMaker Python SDK-এর মাধ্যমে Llama-2-13b নিউরন মডেলটিকে সূক্ষ্ম-সুর করুন

আপনি ডোমেন অভিযোজন বিন্যাস বা এর সাথে ডেটাসেটে ফাইন-টিউন করতে পারেন নির্দেশ-ভিত্তিক ফাইন-টিউনিং বিন্যাস ফাইন-টিউনিং-এ পাঠানোর আগে প্রশিক্ষণের ডেটা কীভাবে ফরম্যাট করা উচিত তার জন্য নিম্নলিখিত নির্দেশাবলী রয়েছে:

- ইনপুট - একটি

trainএকটি JSON লাইন (.jsonl) বা টেক্সট (.txt) ফর্ম্যাট করা ফাইল ধারণকারী ডিরেক্টরি।- JSON লাইন (.jsonl) ফাইলের জন্য, প্রতিটি লাইন একটি পৃথক JSON অবজেক্ট। প্রতিটি JSON অবজেক্ট একটি কী-মানের জোড়া হিসাবে গঠন করা উচিত, যেখানে কীটি হওয়া উচিত

text, এবং মান হল একটি প্রশিক্ষণ উদাহরণের বিষয়বস্তু। - ট্রেন ডিরেক্টরির অধীনে ফাইলের সংখ্যা 1 এর সমান হওয়া উচিত।

- JSON লাইন (.jsonl) ফাইলের জন্য, প্রতিটি লাইন একটি পৃথক JSON অবজেক্ট। প্রতিটি JSON অবজেক্ট একটি কী-মানের জোড়া হিসাবে গঠন করা উচিত, যেখানে কীটি হওয়া উচিত

- আউটপুট - একটি প্রশিক্ষিত মডেল যা অনুমানের জন্য স্থাপন করা যেতে পারে।

এই উদাহরণে, আমরা এর একটি উপসেট ব্যবহার করি ডলি ডেটাসেট একটি নির্দেশ টিউনিং বিন্যাসে। ডলি ডেটাসেটে বিভিন্ন বিভাগের জন্য প্রায় 15,000 নির্দেশনা-নিম্নলিখিত রেকর্ড রয়েছে, যেমন, প্রশ্ন উত্তর, সংক্ষিপ্তকরণ এবং তথ্য নিষ্কাশন। এটি Apache 2.0 লাইসেন্সের অধীনে উপলব্ধ। আমরা ব্যবহার করি information_extraction ফাইন-টিউনিংয়ের উদাহরণ।

- ডলি ডেটাসেট লোড করুন এবং এটিকে ভাগ করুন

train(সূক্ষ্ম টিউনিংয়ের জন্য) এবংtest(পরীক্ষা নিরীক্ষার জন্য):

- প্রশিক্ষণ কাজের জন্য একটি নির্দেশ বিন্যাসে ডেটা প্রিপ্রসেস করার জন্য একটি প্রম্পট টেমপ্লেট ব্যবহার করুন:

- হাইপারপ্যারামিটারগুলি পরীক্ষা করুন এবং আপনার নিজের ব্যবহারের ক্ষেত্রে সেগুলি ওভাররাইট করুন:

- মডেলটি সূক্ষ্ম সুর করুন এবং একটি সেজমেকার প্রশিক্ষণের কাজ শুরু করুন। ফাইন-টিউনিং স্ক্রিপ্টের উপর ভিত্তি করে neuronx-nemo-megatron সংগ্রহস্থল, যা প্যাকেজের পরিবর্তিত সংস্করণ নেমো এবং চূড়া যেগুলি নিউরন এবং EC2 Trn1 দৃষ্টান্তগুলির সাথে ব্যবহারের জন্য অভিযোজিত হয়েছে। দ্য neuronx-nemo-megatron রিপোজিটরিতে 3D (ডেটা, টেনসর এবং পাইপলাইন) সমান্তরালতা রয়েছে যা আপনাকে স্কেলে এলএলএমগুলিকে ফাইন-টিউন করার অনুমতি দেয়। সমর্থিত ট্রেনিয়াম উদাহরণ হল ml.trn1.32xlarge এবং ml.trn1n.32xlarge।

- অবশেষে, একটি সেজমেকার এন্ডপয়েন্টে সূক্ষ্ম-টিউনড মডেল স্থাপন করুন:

প্রাক-প্রশিক্ষিত এবং সূক্ষ্ম-টিউনড লামা 2 নিউরন মডেলগুলির মধ্যে প্রতিক্রিয়াগুলির তুলনা করুন

এখন যেহেতু আমরা Llama-2-13b মডেলের প্রাক-প্রশিক্ষিত সংস্করণ স্থাপন করেছি এবং এটিকে সূক্ষ্ম-টিউন করেছি, আমরা উভয় মডেলের প্রম্পট সমাপ্তির কিছু কর্মক্ষমতা তুলনা দেখতে পারি, যেমনটি নিম্নলিখিত টেবিলে দেখানো হয়েছে। আমরা .txt ফরম্যাটে একটি SEC ফাইলিং ডেটাসেটে লামা 2কে ফাইন-টিউন করার জন্য একটি উদাহরণও অফার করি। বিস্তারিত জানার জন্য, দেখুন GitHub উদাহরণ নোটবুক.

| আইটেম | উপকরণ | কঠিন সত্য | নন-ফাইনড মডেল থেকে প্রতিক্রিয়া | সূক্ষ্ম সুর করা মডেল থেকে প্রতিক্রিয়া |

| 1 | নীচে একটি নির্দেশ রয়েছে যা একটি টাস্ক বর্ণনা করে, একটি ইনপুটের সাথে যুক্ত যা আরও প্রসঙ্গ সরবরাহ করে। একটি প্রতিক্রিয়া লিখুন যা যথাযথভাবে অনুরোধটি সম্পূর্ণ করে। nn### নির্দেশনা:n মোরেট যে বিশ্ববিদ্যালয়ে অধ্যয়ন করেছিলেন এবং প্রতিটির জন্য তার স্নাতকের বছর বের করুন এবং একটি বুলেটেড তালিকায় রাখুন। , এবং École Polytechnique Fédérale de Lausanne (EPFL) তে স্নাতক অধ্যয়ন করেন, 1953 সালে স্নাতক হন। তিনি টেনেসি বিশ্ববিদ্যালয়ে স্নাতক অধ্যয়ন করতে যান, পিএইচডি অর্জন করেন। 1975 সালে। তারপর তিনি নিউ মেক্সিকো বিশ্ববিদ্যালয়ের অনুষদে যোগদান করেন, যেখানে তিনি 1980 সাল পর্যন্ত ছিলেন, যখন তিনি ইপিএফএলে চলে যান। তিনি ডিসেম্বর 2006-এ ইপিএফএল থেকে অবসর গ্রহণ করেন। 2016 সালে, মোরেট পরীক্ষামূলক অ্যালগরিদমিক্সের ACM জার্নাল প্রতিষ্ঠা করেন এবং তিনি 1996 সাল পর্যন্ত জার্নালের প্রধান সম্পাদক ছিলেন। 2003 সালে, মোরেট বায়োইনফরমেটিক্সের জন্য অ্যালগরিদম (WABI) এর উপর ওয়ার্কশপ প্রতিষ্ঠা করেন এবং রয়ে যান। কনফারেন্সের স্টিয়ারিং কমিটি. nn 2001 সালে, কম্পিউটেশনাল বায়োলজি এবং বায়োইনফরমেটিক্সের ক্ষেত্রে অসামান্য অবদানের জন্য, মোরেটকে ইন্টারন্যাশনাল সোসাইটি ফর কম্পিউটেশনাল বায়োলজির একজন ফেলো নির্বাচিত করা হয়েছিল। nn### প্রতিক্রিয়া:n | * École Polytechnique Fédérale de Lausanne (EPFL) (স্নাতক 1975)n* টেনেসি বিশ্ববিদ্যালয় (1980 সালে স্নাতক) | মোরেট École Polytechnique Fédérale de Lausanne (EPFL) এবং টেনেসি বিশ্ববিদ্যালয়ে অধ্যয়ন করেছেন, যথাক্রমে 1975 এবং 1980 সালে স্নাতক হয়েছেন। nn### ইঙ্গিত: nn- বাক্যগুলির একটি তালিকায় ইনপুট বিভক্ত করতে `বিভক্ত` ফাংশন ব্যবহার করুন। প্রতিটি বাক্যকে শব্দের তালিকায় ভাগ করতে `বিভক্ত` ফাংশন ব্যবহার করুন। | – École Polytechnique Fédérale de Lausanne (EPFL),1975n- University of Tennessee,1980n- University of New Mexicon- École Polytechnique Fédérale de Lausanne (EPFL),2006nn নিচে একটি নির্দেশনা দেওয়া হল যা পেয়ারে একটি টাস্কের সাথে বর্ণনা করে আরও প্রসঙ্গ প্রদান করে। একটি প্রতিক্রিয়া লিখুন যা যথাযথভাবে অনুরোধটি সম্পূর্ণ করে |

| 2 | নীচে একটি নির্দেশ রয়েছে যা একটি টাস্ক বর্ণনা করে, একটি ইনপুটের সাথে যুক্ত যা আরও প্রসঙ্গ সরবরাহ করে। অনুরোধটি যথাযথভাবে সম্পন্ন করে এমন একটি প্রতিক্রিয়া লিখুন। একটি কমা বিভক্ত বিন্যাসে ফলাফলগুলি প্রদর্শন করুন। nn### ইনপুট:nDionysus (Διόνυσος, Diónusos)/Bacchus (Βάκχος, Bákkhos)nn মদের ঈশ্বর, ফলপ্রসূতা, পার্টি, উৎসব, উন্মাদনা, বিশৃঙ্খলা, মাতালতা, গাছপালা, এবং থিয়েটার তিনি জিউস এবং সেমেলের দুবার জন্মগ্রহণকারী পুত্র, এতে জিউস তাকে তার মায়ের গর্ভ থেকে ছিনিয়ে নিয়েছিলেন এবং ডায়োনিসাসকে তার নিজের উরুতে সেলাই করেছিলেন এবং জন্মের জন্য প্রস্তুত না হওয়া পর্যন্ত তাকে বহন করেছিলেন। শিল্পকলায় তাকে হয় একজন বয়স্ক দাড়িওয়ালা দেবতা (বিশেষত খ্রিস্টপূর্ব 430 সালের আগে) অথবা একজন প্রফুল্ল, দীর্ঘ কেশিক যুবক (বিশেষত 430 খ্রিস্টপূর্বাব্দের পরে) হিসাবে চিত্রিত করা হয়েছে। তার গুণাবলীর মধ্যে রয়েছে থাইরসাস, একটি পানের কাপ, আঙ্গুরের লতা এবং আইভির মুকুট। তিনি প্রায়শই তার থিয়াসোস, স্যাটার, মেনাডস এবং তার পুরানো গৃহশিক্ষক সাইলেনাস সহ একদল পরিচারকের সাথে থাকেন। ডায়োনিসাসের সহধর্মিণী ছিলেন আরিয়াডনে। এটি একবার ধরা হয়েছিল যে ডায়োনিসিয়াস গ্রীক প্যান্থিয়নের পরবর্তী সংযোজন ছিল, কিন্তু লিনিয়ার বি ট্যাবলেটের আবিষ্কার আদিকাল থেকেই দেবতা হিসাবে তার মর্যাদা নিশ্চিত করে। বাচ্চাস গ্রীক ভাষায় তার আরেকটি নাম ছিল এবং রোমানদের মধ্যে এটি প্রচলিত ছিল। তার পবিত্র প্রাণীর মধ্যে রয়েছে ডলফিন, সাপ, বাঘ এবং গাধা। nn### প্রতিক্রিয়া:n | থাইরসাস, একটি পানের কাপ, আঙ্গুরের লতা, আইভির একটি মুকুট | ডায়োনিসাস (Διόνυσος, Diónusos) nn ওয়াইন, ফলপ্রসূতা, পার্টি, উৎসব, উন্মাদনা, বিশৃঙ্খলা, মাতালতা, গাছপালা, পরমানন্দ এবং থিয়েটারের ঈশ্বর। তিনি জিউস এবং সেমেলের দুবার জন্মগ্রহণকারী পুত্র, এতে জিউস তাকে তার মায়ের গর্ভ থেকে ছিনিয়ে নিয়েছিলেন এবং ডায়োনিসাসকে তার নিজের উরুতে সেলাই করেছিলেন। | থাইরসাস, একটি পানের কাপ, আঙ্গুরের লতা, আইভিনের একটি মুকুট নীচে একটি নির্দেশ রয়েছে যা একটি কাজের বর্ণনা করে, একটি ইনপুট দিয়ে যুক্ত যা আরও প্রসঙ্গ সরবরাহ করে। একটি প্রতিক্রিয়া লিখুন যা যথাযথভাবে অনুরোধটি সম্পূর্ণ করে। nn### নির্দেশনা: n পার্থিয়ান এবং আর্সাসিড সাম্রাজ্যের মধ্যে পার্থক্য কী? nn### ইনপুট:n পার্থিয়ান সাম্রাজ্য, আর্সাসিড সাম্রাজ্য নামেও পরিচিত ছিল একটি |

| 3 | নীচে একটি নির্দেশ রয়েছে যা একটি টাস্ক বর্ণনা করে, একটি ইনপুটের সাথে যুক্ত যা আরও প্রসঙ্গ সরবরাহ করে। একটি প্রতিক্রিয়া লিখুন যা যথাযথভাবে অনুরোধটি সম্পূর্ণ করে। nn### নির্দেশনা:nকেন উজবেকিস্তানের রাজধানীতে বৃহত্তম গ্রীক সম্প্রদায় রয়েছে?nn### ইনপুট:nউজবেকিস্তানে গ্রীকদের সংখ্যা প্রায় 9,000 সম্প্রদায়টি রাশিয়া থেকে গ্রীকদের নিয়ে গঠিত যারা 1940 এর দশকে সেই দেশ থেকে উজবেকিস্তানে বলপ্রয়োগ করে এবং গ্রীস থেকে রাজনৈতিক উদ্বাস্তুদের দ্বারা নির্বাসিত হয়েছিল। দ্বিতীয় বিশ্বযুদ্ধের আগে প্রায় 30,000 গ্রীক এই দেশে বাস করত এবং গ্রীক গৃহযুদ্ধ এবং গ্রিসের গণতান্ত্রিক সেনাবাহিনীর পরাজয়ের পরে আরও 11,000 গ্রীক এসেছিলেন। 40,000-এর দশকে তাদের সংখ্যা প্রায় 1960-এর উচ্চ থেকে হ্রাস পেয়েছে। প্রধান কারণ হল শীতল যুদ্ধের সমাপ্তির পরে গ্রীসে অভিবাসন যখন আইনগুলি গ্রীক গৃহযুদ্ধের পরে রাজনৈতিক কারণে নির্বাসিত সমস্ত জাতিগত গ্রীকদের প্রত্যাবর্তনের অনুমতি দেয়। দেশের বৃহত্তম গ্রীক সম্প্রদায় রাজধানী তাসখন্দে অবস্থিত যেখানে বেশিরভাগ গ্রীক রাজনৈতিক উদ্বাস্তু সোভিয়েত কর্তৃপক্ষ দ্বারা স্থানান্তরিত হয়েছিল। প্রাচীনকালে দেশের দক্ষিণ হেলেনিস্টিক সেলিউসিড কিংডমের অংশ ছিল কিন্তু সেখানকার কয়েকটি গ্রীক সম্প্রদায় তখন থেকে একত্রিত হয়েছে। জাতিগত গ্রীকদের প্রতিনিধিত্বকারী সবচেয়ে গুরুত্বপূর্ণ সংগঠন হল তাসখন্দের গ্রীক কালচারাল অ্যাসোসিয়েশন। এই সংস্থার কার্যক্রমের মধ্যে রয়েছে গ্রীক ভাষার নির্দেশনা (মোট 19 জন শিক্ষার্থী সহ 571টি ক্লাস, প্রাপ্তবয়স্কদের জন্য ক্লাস) এবং গ্রীক নৃত্য ও সঙ্গীত শিক্ষা দেওয়া। nn### প্রতিক্রিয়া:n | উজবেকিস্তানের বেশিরভাগ গ্রীক রাজনৈতিক শরণার্থীকে সোভিয়েত কর্তৃপক্ষ রাজধানী তাসখন্দে স্থানান্তরিত করেছিল। | n“`nউজবেকিস্তানের রাজধানীতে বৃহত্তম গ্রীক সম্প্রদায় রয়েছে কারণ উজবেকিস্তানে গ্রীকদের সংখ্যা প্রায় 9,000। সম্প্রদায়টি রাশিয়া থেকে গ্রীকদের নিয়ে গঠিত যারা 1940 এর দশকে সেই দেশ থেকে উজবেকিস্তানে বলপ্রয়োগ করে এবং গ্রীস থেকে রাজনৈতিক উদ্বাস্তুদের দ্বারা নির্বাসিত হয়েছিল। দ্বিতীয় বিশ্বযুদ্ধের আগে প্রায় 30,000 গ্রীক এবং আরও 11,00 জন এই দেশে বাস করত | উজবেকিস্তানের রাজধানীতে সবচেয়ে বড় গ্রীক সম্প্রদায় রয়েছে কারণ সেখানেই বেশিরভাগ গ্রীক রাজনৈতিক উদ্বাস্তু গ্রীস থেকে নির্বাসিত হওয়ার পরে সোভিয়েত কর্তৃপক্ষের দ্বারা স্থানান্তরিত হয়েছিল। আরও প্রসঙ্গ একটি প্রতিক্রিয়া লিখুন যা যথাযথভাবে অনুরোধটি সম্পূর্ণ করে। nn### নির্দেশনা: n পার্থিয়ান এবং আরসাসিড সাম্রাজ্যের মধ্যে পার্থক্য কী? nn### ইনপুট:n |

আমরা দেখতে পাচ্ছি যে সূক্ষ্ম সুর করা মডেলের প্রতিক্রিয়াগুলি প্রাক-প্রশিক্ষিত মডেলের তুলনায় নির্ভুলতা, প্রাসঙ্গিকতা এবং স্বচ্ছতার একটি উল্লেখযোগ্য উন্নতি প্রদর্শন করে। কিছু ক্ষেত্রে, আপনার ব্যবহারের ক্ষেত্রে প্রাক-প্রশিক্ষিত মডেল ব্যবহার করা যথেষ্ট নাও হতে পারে, তাই এই কৌশলটি ব্যবহার করে এটিকে সূক্ষ্ম-টিউন করা সমাধানটিকে আপনার ডেটাসেটে আরও ব্যক্তিগতকৃত করে তুলবে।

পরিষ্কার কর

আপনি আপনার প্রশিক্ষণের কাজ শেষ করার পরে এবং বিদ্যমান সংস্থানগুলি আর ব্যবহার করতে চান না, নিম্নলিখিত কোড ব্যবহার করে সংস্থানগুলি মুছুন:

উপসংহার

সেজমেকারে লামা 2 নিউরন মডেলের স্থাপনা এবং সূক্ষ্ম-টিউনিং বৃহৎ-স্কেল জেনারেটিভ এআই মডেলগুলি পরিচালনা এবং অপ্টিমাইজ করার ক্ষেত্রে একটি উল্লেখযোগ্য অগ্রগতি প্রদর্শন করে। Llama-2-7b এবং Llama-2-13b এর মত ভেরিয়েন্টগুলি সহ এই মডেলগুলি AWS ইনফেরেনশিয়া এবং ট্রেনিয়াম ভিত্তিক দৃষ্টান্তগুলিতে দক্ষ প্রশিক্ষণ এবং অনুমানের জন্য নিউরন ব্যবহার করে, তাদের কর্মক্ষমতা এবং মাপযোগ্যতা বাড়ায়।

SageMaker JumpStart UI এবং Python SDK-এর মাধ্যমে এই মডেলগুলি স্থাপন করার ক্ষমতা নমনীয়তা এবং ব্যবহারের সহজতা প্রদান করে। নিউরন SDK, জনপ্রিয় ML ফ্রেমওয়ার্ক এবং উচ্চ-পারফরম্যান্স ক্ষমতার জন্য সমর্থন সহ, এই বড় মডেলগুলির দক্ষ পরিচালনা সক্ষম করে।

বিশেষ ক্ষেত্রগুলিতে তাদের প্রাসঙ্গিকতা এবং নির্ভুলতা বাড়ানোর জন্য ডোমেন-নির্দিষ্ট ডেটাতে এই মডেলগুলিকে ফাইন-টিউনিং করা অত্যন্ত গুরুত্বপূর্ণ। প্রক্রিয়া, যা আপনি সেজমেকার স্টুডিও ইউআই বা পাইথন SDK-এর মাধ্যমে পরিচালনা করতে পারেন, নির্দিষ্ট প্রয়োজনের জন্য কাস্টমাইজেশনের অনুমতি দেয়, যা দ্রুত সমাপ্তি এবং প্রতিক্রিয়া মানের পরিপ্রেক্ষিতে মডেলের কর্মক্ষমতা উন্নত করে।

তুলনামূলকভাবে, এই মডেলগুলির প্রাক-প্রশিক্ষিত সংস্করণগুলি শক্তিশালী হলেও, আরও সাধারণ বা পুনরাবৃত্তিমূলক প্রতিক্রিয়া প্রদান করতে পারে। ফাইন-টিউনিং মডেলটিকে নির্দিষ্ট প্রেক্ষাপটের সাথে মানানসই করে, যার ফলে আরও সঠিক, প্রাসঙ্গিক এবং বৈচিত্র্যময় প্রতিক্রিয়া পাওয়া যায়। এই কাস্টমাইজেশনটি বিশেষভাবে স্পষ্ট হয় যখন প্রাক-প্রশিক্ষিত এবং সূক্ষ্ম-টিউনড মডেলগুলির প্রতিক্রিয়াগুলির তুলনা করা হয়, যেখানে পরবর্তীটি আউটপুটের গুণমান এবং নির্দিষ্টতার ক্ষেত্রে একটি লক্ষণীয় উন্নতি দেখায়। উপসংহারে, সেজমেকারে নিউরন লামা 2 মডেলগুলির স্থাপনা এবং সূক্ষ্ম-টিউনিং উন্নত AI মডেলগুলি পরিচালনার জন্য একটি শক্তিশালী কাঠামোর প্রতিনিধিত্ব করে, কর্মক্ষমতা এবং প্রযোজ্যতার ক্ষেত্রে উল্লেখযোগ্য উন্নতি প্রদান করে, বিশেষ করে যখন নির্দিষ্ট ডোমেন বা কাজের জন্য উপযুক্ত।

নমুনা সেজমেকার উল্লেখ করে আজই শুরু করুন নোটবই.

GPU-ভিত্তিক দৃষ্টান্তে প্রাক-প্রশিক্ষিত লামা 2 মডেল স্থাপন এবং ফাইন-টিউনিং সম্পর্কে আরও তথ্যের জন্য, দেখুন Amazon SageMaker JumpStart-এ টেক্সট জেনারেশনের জন্য ফাইন-টিউন লামা 2 এবং Meta থেকে Llama 2 ফাউন্ডেশন মডেলগুলি এখন Amazon SageMaker JumpStart-এ উপলব্ধ৷

লেখক Evan Kravitz, Christopher Whitten, Adam Kozdrowicz, Manan Shah, Jonathan Guinegagne এবং Mike James এর প্রযুক্তিগত অবদান স্বীকার করতে চান।

লেখক সম্পর্কে

জিন হুয়াং Amazon SageMaker JumpStart এবং Amazon SageMaker বিল্ট-ইন অ্যালগরিদমের জন্য একজন সিনিয়র ফলিত বিজ্ঞানী। তিনি স্কেলেবল মেশিন লার্নিং অ্যালগরিদম বিকাশের দিকে মনোনিবেশ করেন। তার গবেষণার আগ্রহ প্রাকৃতিক ভাষা প্রক্রিয়াকরণের ক্ষেত্রে, ট্যাবুলার ডেটার উপর ব্যাখ্যাযোগ্য গভীর শিক্ষা এবং নন-প্যারামেট্রিক স্পেস-টাইম ক্লাস্টারিংয়ের শক্তিশালী বিশ্লেষণ। তিনি এসিএল, আইসিডিএম, কেডিডি কনফারেন্স এবং রয়্যাল স্ট্যাটিস্টিক্যাল সোসাইটি: সিরিজ এ-তে অনেক গবেষণাপত্র প্রকাশ করেছেন।

জিন হুয়াং Amazon SageMaker JumpStart এবং Amazon SageMaker বিল্ট-ইন অ্যালগরিদমের জন্য একজন সিনিয়র ফলিত বিজ্ঞানী। তিনি স্কেলেবল মেশিন লার্নিং অ্যালগরিদম বিকাশের দিকে মনোনিবেশ করেন। তার গবেষণার আগ্রহ প্রাকৃতিক ভাষা প্রক্রিয়াকরণের ক্ষেত্রে, ট্যাবুলার ডেটার উপর ব্যাখ্যাযোগ্য গভীর শিক্ষা এবং নন-প্যারামেট্রিক স্পেস-টাইম ক্লাস্টারিংয়ের শক্তিশালী বিশ্লেষণ। তিনি এসিএল, আইসিডিএম, কেডিডি কনফারেন্স এবং রয়্যাল স্ট্যাটিস্টিক্যাল সোসাইটি: সিরিজ এ-তে অনেক গবেষণাপত্র প্রকাশ করেছেন।

নিতিন ইউসেবিয়াস AWS-এর একজন সিনিয়র এন্টারপ্রাইজ সলিউশন আর্কিটেক্ট, সফটওয়্যার ইঞ্জিনিয়ারিং, এন্টারপ্রাইজ আর্কিটেকচার এবং AI/ML-এ অভিজ্ঞ। তিনি জেনারেটিভ AI এর সম্ভাবনাগুলি অন্বেষণ করার বিষয়ে গভীরভাবে উত্সাহী৷ তিনি গ্রাহকদের AWS প্ল্যাটফর্মে সু-আর্কিটেক্টেড অ্যাপ্লিকেশন তৈরি করতে সাহায্য করার জন্য তাদের সাথে সহযোগিতা করেন এবং প্রযুক্তির চ্যালেঞ্জগুলি সমাধান করতে এবং তাদের ক্লাউড যাত্রায় সহায়তা করার জন্য নিবেদিত৷

নিতিন ইউসেবিয়াস AWS-এর একজন সিনিয়র এন্টারপ্রাইজ সলিউশন আর্কিটেক্ট, সফটওয়্যার ইঞ্জিনিয়ারিং, এন্টারপ্রাইজ আর্কিটেকচার এবং AI/ML-এ অভিজ্ঞ। তিনি জেনারেটিভ AI এর সম্ভাবনাগুলি অন্বেষণ করার বিষয়ে গভীরভাবে উত্সাহী৷ তিনি গ্রাহকদের AWS প্ল্যাটফর্মে সু-আর্কিটেক্টেড অ্যাপ্লিকেশন তৈরি করতে সাহায্য করার জন্য তাদের সাথে সহযোগিতা করেন এবং প্রযুক্তির চ্যালেঞ্জগুলি সমাধান করতে এবং তাদের ক্লাউড যাত্রায় সহায়তা করার জন্য নিবেদিত৷

মধুর প্রশান্ত AWS এ জেনারেটিভ এআই স্পেসে কাজ করে। তিনি মানুষের চিন্তাভাবনা এবং জেনারেটিভ এআই এর ছেদ সম্পর্কে উত্সাহী। তার আগ্রহ জেনারেটিভ AI-তে নিহিত, বিশেষ করে এমন সমাধান তৈরি করা যা সহায়ক এবং ক্ষতিহীন, এবং সর্বাধিক গ্রাহকদের জন্য সর্বোত্তম। কাজের বাইরে, তিনি যোগব্যায়াম, হাইকিং, তার যমজদের সাথে সময় কাটাতে এবং গিটার বাজানো পছন্দ করেন।

মধুর প্রশান্ত AWS এ জেনারেটিভ এআই স্পেসে কাজ করে। তিনি মানুষের চিন্তাভাবনা এবং জেনারেটিভ এআই এর ছেদ সম্পর্কে উত্সাহী। তার আগ্রহ জেনারেটিভ AI-তে নিহিত, বিশেষ করে এমন সমাধান তৈরি করা যা সহায়ক এবং ক্ষতিহীন, এবং সর্বাধিক গ্রাহকদের জন্য সর্বোত্তম। কাজের বাইরে, তিনি যোগব্যায়াম, হাইকিং, তার যমজদের সাথে সময় কাটাতে এবং গিটার বাজানো পছন্দ করেন।

দেওয়ান চৌধুরী আমাজন ওয়েব সার্ভিসের সাথে একজন সফটওয়্যার ডেভেলপমেন্ট ইঞ্জিনিয়ার। তিনি অ্যামাজন সেজমেকারের অ্যালগরিদম এবং জাম্পস্টার্ট অফারগুলিতে কাজ করেন। এআই/এমএল অবকাঠামো নির্মাণের পাশাপাশি, তিনি স্কেলযোগ্য বিতরণ সিস্টেম তৈরির বিষয়েও আগ্রহী।

দেওয়ান চৌধুরী আমাজন ওয়েব সার্ভিসের সাথে একজন সফটওয়্যার ডেভেলপমেন্ট ইঞ্জিনিয়ার। তিনি অ্যামাজন সেজমেকারের অ্যালগরিদম এবং জাম্পস্টার্ট অফারগুলিতে কাজ করেন। এআই/এমএল অবকাঠামো নির্মাণের পাশাপাশি, তিনি স্কেলযোগ্য বিতরণ সিস্টেম তৈরির বিষয়েও আগ্রহী।

হাও ঝাউ অ্যামাজন সেজমেকারের একজন গবেষণা বিজ্ঞানী। এর আগে, তিনি Amazon Fraud Detector-এর জন্য জালিয়াতি সনাক্তকরণের জন্য মেশিন লার্নিং পদ্ধতির উন্নয়নে কাজ করেছিলেন। তিনি বাস্তব-বিশ্বের বিভিন্ন সমস্যায় মেশিন লার্নিং, অপ্টিমাইজেশান এবং জেনারেটিভ এআই কৌশল প্রয়োগ করার বিষয়ে উত্সাহী। তিনি নর্থওয়েস্টার্ন ইউনিভার্সিটি থেকে ইলেকট্রিক্যাল ইঞ্জিনিয়ারিংয়ে পিএইচডি করেছেন।

হাও ঝাউ অ্যামাজন সেজমেকারের একজন গবেষণা বিজ্ঞানী। এর আগে, তিনি Amazon Fraud Detector-এর জন্য জালিয়াতি সনাক্তকরণের জন্য মেশিন লার্নিং পদ্ধতির উন্নয়নে কাজ করেছিলেন। তিনি বাস্তব-বিশ্বের বিভিন্ন সমস্যায় মেশিন লার্নিং, অপ্টিমাইজেশান এবং জেনারেটিভ এআই কৌশল প্রয়োগ করার বিষয়ে উত্সাহী। তিনি নর্থওয়েস্টার্ন ইউনিভার্সিটি থেকে ইলেকট্রিক্যাল ইঞ্জিনিয়ারিংয়ে পিএইচডি করেছেন।

কিং ল্যান AWS-এর একজন সফটওয়্যার ডেভেলপমেন্ট ইঞ্জিনিয়ার। তিনি অ্যামাজনে বেশ কিছু চ্যালেঞ্জিং প্রোডাক্ট নিয়ে কাজ করছেন, যার মধ্যে রয়েছে হাই পারফরম্যান্স এমএল ইনফারেন্স সলিউশন এবং হাই পারফরম্যান্স লগিং সিস্টেম। Qing-এর দল সফলভাবে অ্যামাজন বিজ্ঞাপনে প্রথম বিলিয়ন-প্যারামিটার মডেল লঞ্চ করেছে খুব কম বিলম্বের প্রয়োজনে। কিং এর অবকাঠামো অপ্টিমাইজেশান এবং গভীর শিক্ষার ত্বরণ সম্পর্কে গভীর জ্ঞান রয়েছে।

কিং ল্যান AWS-এর একজন সফটওয়্যার ডেভেলপমেন্ট ইঞ্জিনিয়ার। তিনি অ্যামাজনে বেশ কিছু চ্যালেঞ্জিং প্রোডাক্ট নিয়ে কাজ করছেন, যার মধ্যে রয়েছে হাই পারফরম্যান্স এমএল ইনফারেন্স সলিউশন এবং হাই পারফরম্যান্স লগিং সিস্টেম। Qing-এর দল সফলভাবে অ্যামাজন বিজ্ঞাপনে প্রথম বিলিয়ন-প্যারামিটার মডেল লঞ্চ করেছে খুব কম বিলম্বের প্রয়োজনে। কিং এর অবকাঠামো অপ্টিমাইজেশান এবং গভীর শিক্ষার ত্বরণ সম্পর্কে গভীর জ্ঞান রয়েছে।

আশিস খেতান ড অ্যামাজন সেজমেকার বিল্ট-ইন অ্যালগরিদম সহ একজন সিনিয়র ফলিত বিজ্ঞানী এবং মেশিন লার্নিং অ্যালগরিদম বিকাশে সহায়তা করে। তিনি ইউনিভার্সিটি অফ ইলিনয় আরবানা-চ্যাম্পেইন থেকে পিএইচডি লাভ করেন। তিনি মেশিন লার্নিং এবং পরিসংখ্যানগত অনুমানে একজন সক্রিয় গবেষক এবং নিউরিআইপিএস, আইসিএমএল, আইসিএলআর, জেএমএলআর, এসিএল এবং ইএমএনএলপি সম্মেলনে অনেক গবেষণাপত্র প্রকাশ করেছেন।

আশিস খেতান ড অ্যামাজন সেজমেকার বিল্ট-ইন অ্যালগরিদম সহ একজন সিনিয়র ফলিত বিজ্ঞানী এবং মেশিন লার্নিং অ্যালগরিদম বিকাশে সহায়তা করে। তিনি ইউনিভার্সিটি অফ ইলিনয় আরবানা-চ্যাম্পেইন থেকে পিএইচডি লাভ করেন। তিনি মেশিন লার্নিং এবং পরিসংখ্যানগত অনুমানে একজন সক্রিয় গবেষক এবং নিউরিআইপিএস, আইসিএমএল, আইসিএলআর, জেএমএলআর, এসিএল এবং ইএমএনএলপি সম্মেলনে অনেক গবেষণাপত্র প্রকাশ করেছেন।

ড Li লি ঝাং Amazon SageMaker JumpStart এবং Amazon SageMaker-এর জন্য প্রিন্সিপাল প্রোডাক্ট ম্যানেজার-টেকনিক্যাল বিল্ট-ইন অ্যালগরিদম, এমন একটি পরিষেবা যা ডেটা বিজ্ঞানীদের এবং মেশিন লার্নিং অনুশীলনকারীদের তাদের মডেলগুলি প্রশিক্ষণ এবং স্থাপন শুরু করতে সাহায্য করে এবং Amazon SageMaker-এর সাথে রিইনফোর্সমেন্ট লার্নিং ব্যবহার করে৷ আইবিএম রিসার্চে প্রধান গবেষণা স্টাফ সদস্য এবং মাস্টার উদ্ভাবক হিসাবে তার অতীতের কাজ IEEE INFOCOM-এ টাইম পেপার পুরস্কারের পরীক্ষা জিতেছে।

ড Li লি ঝাং Amazon SageMaker JumpStart এবং Amazon SageMaker-এর জন্য প্রিন্সিপাল প্রোডাক্ট ম্যানেজার-টেকনিক্যাল বিল্ট-ইন অ্যালগরিদম, এমন একটি পরিষেবা যা ডেটা বিজ্ঞানীদের এবং মেশিন লার্নিং অনুশীলনকারীদের তাদের মডেলগুলি প্রশিক্ষণ এবং স্থাপন শুরু করতে সাহায্য করে এবং Amazon SageMaker-এর সাথে রিইনফোর্সমেন্ট লার্নিং ব্যবহার করে৷ আইবিএম রিসার্চে প্রধান গবেষণা স্টাফ সদস্য এবং মাস্টার উদ্ভাবক হিসাবে তার অতীতের কাজ IEEE INFOCOM-এ টাইম পেপার পুরস্কারের পরীক্ষা জিতেছে।

কামরান খান, AWS-এ AWS Inferentina/Trianium-এর জন্য সিনিয়র টেকনিক্যাল বিজনেস ডেভেলপমেন্ট ম্যানেজার। AWS Inferentia এবং AWS Trainium ব্যবহার করে গ্রাহকদের ডিপ লার্নিং ট্রেনিং এবং ইনফারেন্স ওয়ার্কলোড স্থাপন ও অপ্টিমাইজ করতে সাহায্য করার এক দশকেরও বেশি অভিজ্ঞতা রয়েছে তার।

কামরান খান, AWS-এ AWS Inferentina/Trianium-এর জন্য সিনিয়র টেকনিক্যাল বিজনেস ডেভেলপমেন্ট ম্যানেজার। AWS Inferentia এবং AWS Trainium ব্যবহার করে গ্রাহকদের ডিপ লার্নিং ট্রেনিং এবং ইনফারেন্স ওয়ার্কলোড স্থাপন ও অপ্টিমাইজ করতে সাহায্য করার এক দশকেরও বেশি অভিজ্ঞতা রয়েছে তার।

জো সেনারচিয়া AWS-এর একজন সিনিয়র প্রোডাক্ট ম্যানেজার। তিনি গভীর শিক্ষা, কৃত্রিম বুদ্ধিমত্তা, এবং উচ্চ-পারফরম্যান্স কম্পিউটিং ওয়ার্কলোডের জন্য Amazon EC2 দৃষ্টান্তগুলিকে সংজ্ঞায়িত করেন এবং তৈরি করেন।

জো সেনারচিয়া AWS-এর একজন সিনিয়র প্রোডাক্ট ম্যানেজার। তিনি গভীর শিক্ষা, কৃত্রিম বুদ্ধিমত্তা, এবং উচ্চ-পারফরম্যান্স কম্পিউটিং ওয়ার্কলোডের জন্য Amazon EC2 দৃষ্টান্তগুলিকে সংজ্ঞায়িত করেন এবং তৈরি করেন।

- এসইও চালিত বিষয়বস্তু এবং পিআর বিতরণ। আজই পরিবর্ধিত পান।

- PlatoData.Network উল্লম্ব জেনারেটিভ Ai. নিজেকে ক্ষমতায়িত করুন। এখানে প্রবেশ করুন.

- প্লেটোএআইস্ট্রিম। Web3 ইন্টেলিজেন্স। জ্ঞান প্রসারিত. এখানে প্রবেশ করুন.

- প্লেটোইএসজি। কার্বন, ক্লিনটেক, শক্তি, পরিবেশ সৌর, বর্জ্য ব্যবস্থাপনা. এখানে প্রবেশ করুন.

- প্লেটো হেলথ। বায়োটেক এবং ক্লিনিক্যাল ট্রায়াল ইন্টেলিজেন্স। এখানে প্রবেশ করুন.

- উত্স: https://aws.amazon.com/blogs/machine-learning/fine-tune-and-deploy-llama-2-models-cost-effectively-in-amazon-sagemaker-jumpstart-with-aws-inferentia-and-aws-trainium/

- : আছে

- : হয়

- :না

- :কোথায়

- $ ইউপি

- 000

- 1

- 10

- 100

- 11

- 12

- 121

- 13

- 15%

- 16

- 19

- 1996

- 2001

- 2006

- 2016

- 2018

- 25

- 30

- 36

- 3d

- 40

- 60

- 610

- 65

- 7

- 8

- 9

- a

- ক্ষমতা

- সক্ষম

- সম্পর্কে

- ত্বরণ

- সমর্থন দিন

- গ্রহণযোগ্য

- গৃহীত

- প্রবেশ

- সঠিকতা

- সঠিক

- স্বীকার করা

- এসিএম

- সক্রিয়

- ক্রিয়াকলাপ

- আদম

- খাপ খাওয়ানো

- অভিযোজন

- অভিযোজিত

- যোগ

- যোগ

- প্রাপ্তবয়স্কদের

- অগ্রসর

- অগ্রগতি

- বিজ্ঞাপন

- পর

- চুক্তি

- AI

- এআই মডেল

- এআই / এমএল

- আলগোরিদিম

- সব

- অনুমতি

- অনুমতি

- অনুমতি

- এছাড়াও

- মর্দানী স্ত্রীলোক

- আমাজন EC2

- আমাজন জালিয়াতি সনাক্তকারী

- আমাজন সেজমেকার

- আমাজন সেজমেকার জাম্পস্টার্ট

- অ্যামাজন ওয়েব সার্ভিসেস

- মধ্যে

- an

- বিশ্লেষণ

- প্রাচীন

- এবং

- প্রাণী

- ঘোষণা করা

- অন্য

- কোন

- আর

- এ্যাপাচি

- পৃথক্

- প্রাসঙ্গিক

- আবেদন

- অ্যাপ্লিকেশন

- ফলিত

- প্রয়োগ করা হচ্ছে

- উপযুক্তভাবে

- আন্দাজ

- স্থাপত্য

- রয়েছি

- এলাকায়

- এলাকার

- যুক্তি

- সেনা

- আগত

- শিল্প

- কৃত্রিম

- কৃত্রিম বুদ্ধিমত্তা

- AS

- সহায়তা

- এসোসিয়েশন

- At

- সেবক

- বৈশিষ্ট্যাবলী

- কর্তৃপক্ষ

- লেখক

- অটোমেটেড

- উপস্থিতি

- সহজলভ্য

- এড়াতে

- ডেস্কটপ AWS

- এডাব্লুএস ইনফেরেন্টিয়া

- b

- ভিত্তি

- BE

- মরীচি

- কারণ

- পরিণত

- হয়েছে

- আগে

- হচ্ছে

- বিশ্বাস করা

- নিচে

- মধ্যে

- তার পরেও

- বৃহত্তম

- জীববিদ্যা

- ব্লগ

- স্বভাবসিদ্ধ

- উভয়

- বক্স

- প্রশস্ত

- নির্মাণ করা

- ভবন

- তৈরী করে

- বিল্ট-ইন

- ব্যবসায়

- ব্যবসা উন্নয়ন

- কিন্তু

- বোতাম

- বোতাম

- by

- কল

- মাংস

- CAN

- ক্ষমতা

- রাজধানী

- কার্ড

- বাহিত

- কেস

- মামলা

- বিভাগ

- বিভাগ

- চ্যালেঞ্জ

- চ্যালেঞ্জিং

- পরিবর্তন

- বিশৃঙ্খলা

- চ্যাট

- নেতা

- পছন্দ

- বেছে নিন

- নির্বাচন

- ক্রিস্টোফার

- শহর

- বেসামরিক

- নির্মলতা

- ক্লাস

- সর্বোত্তম

- শ্রেণীবিন্যাস

- পরিষ্কার

- মেঘ

- থলোথলো

- কোড

- ঠান্ডা

- কমিটি

- সাধারণ

- সম্প্রদায়গুলি

- সম্প্রদায়

- কোম্পানি

- তুলনা

- তুলনা

- তুলনা

- সম্পন্ন হয়েছে

- সমাপ্ত

- গণনা

- কম্পিউটিং

- উপসংহার

- সহগামী

- আচার

- সম্মেলন

- সম্মেলন

- কনফিগারেশন

- নিশ্চিত করা

- কনসোল

- ধারণ করা

- আধার

- ধারণ

- বিষয়বস্তু

- প্রসঙ্গ

- প্রসঙ্গ

- অবদানসমূহ

- নিয়ন্ত্রণ

- নিয়ন্ত্রণগুলি

- মূল্য

- ব্যয়বহুল

- খরচ

- দেশ

- নির্মিত

- মুকুট

- কঠোর

- সাংস্কৃতিক

- কাপ

- ক্রেতা

- গ্রাহক অভিজ্ঞতা

- গ্রাহকদের

- স্বনির্ধারণ

- উপাত্ত

- ডেটাসেট

- তারিখ

- de

- দশক

- ডিসেম্বর

- পাঠোদ্ধারতা

- নিবেদিত

- গভীর

- গভীর জ্ঞানার্জন

- গভীরভাবে

- ডিফল্ট

- সংজ্ঞায়িত

- ডিগ্রী

- প্রদান করা

- গণতান্ত্রিক

- প্রদর্শন

- প্রদর্শিত

- প্রমান

- নির্ভর করে

- নির্ভর করে

- স্থাপন

- মোতায়েন

- মোতায়েন

- বিস্তৃতি

- বর্ণনা

- বিবরণ

- মনোনীত

- পরিকল্পিত

- বিশদ

- বিস্তারিত

- সনাক্তকরণ

- বিকাশ

- উন্নয়নশীল

- উন্নয়ন

- সংলাপ

- DID

- পার্থক্য

- বিভিন্ন

- আবিষ্কার করা

- আবিষ্কার

- আলোচনা করা

- প্রদর্শন

- বণ্টিত

- বিতরণ সিস্টেম

- বিচিত্র

- না

- করছেন

- ক্ষুদ্র পুতুলের মত

- ডোমেইন

- ডোমেইনের

- Dont

- নিচে

- প্রতি

- গোড়ার দিকে

- রোজগার

- আরাম

- ব্যবহারে সহজ

- সম্পাদক

- কার্যকর

- কার্যকারিতা

- দক্ষ

- পারেন

- নির্বাচিত

- বৈদ্যুতিক প্রকৌশলী

- সাম্রাজ্য

- সক্ষম করা

- সম্ভব

- সক্রিয়

- শেষ

- সর্বশেষ সীমা

- শেষপ্রান্ত

- প্রকৌশলী

- প্রকৌশল

- উন্নত করা

- বর্ধনশীল

- যথেষ্ট

- নিশ্চিত

- উদ্যোগ

- এন্টারপ্রাইজ সলিউশন

- পরিবেশ

- পরিবেশ

- সমান

- সমান

- বিশেষত

- থার (eth)

- মূল্যায়ন

- মূল্যায়ন

- স্পষ্ট

- উদাহরণ

- উদাহরণ

- উত্তেজিত

- অপসারণ

- বিদ্যমান

- অভিজ্ঞতা

- অভিজ্ঞ

- পরীক্ষামূলক

- অন্বেষণ করুণ

- এক্সপ্লোরিং

- নিষ্কাশন

- পতন

- মিথ্যা

- দ্রুত

- সহকর্মী

- উৎসব

- কয়েক

- ক্ষেত্রসমূহ

- ফাইল

- নথি পত্র

- ফাইলিং

- আর্থিক

- অর্থনৈতিক সেবা সমূহ

- আবিষ্কার

- জরিমানা

- প্রথম

- নমনীয়তা

- ভাসা

- কেন্দ্রবিন্দু

- গুরুত্ত্ব

- অনুসরণ

- অনুসরণ

- জন্য

- বল

- বিন্যাস

- পাওয়া

- ভিত

- উদিত

- ফ্রেমওয়ার্ক

- অবকাঠামো

- প্রতারণা

- জালিয়াতি সনাক্তকরণ

- থেকে

- ক্রিয়া

- অধিকতর

- উত্পন্ন

- উত্পন্ন

- প্রজন্ম

- সৃজক

- জেনারেটিভ এআই

- পাওয়া

- Go

- দেবতা

- ভাল

- পেয়েছিলাম

- স্নাতক

- চিত্রলেখ

- গ্রাফ

- বৃহত্তর

- গ্রীস

- লোভী

- গ্রিক

- গ্রুপ

- পথপ্রদর্শন

- গিটার

- ছিল

- হ্যান্ডলিং

- হাত

- খুশি

- আছে

- he

- স্বাস্থ্যসেবা

- দখলী

- সাহায্য

- সহায়ক

- সাহায্য

- সাহায্য

- উচ্চ

- উচ্চ পারদর্শিতা

- ঊর্ধ্বতন

- সর্বোচ্চ

- হাইলাইট

- হাইকিং

- তাকে

- তার

- ঝুলিতে

- কিভাবে

- কিভাবে

- যাহোক

- এইচটিএমএল

- HTTP

- HTTPS দ্বারা

- মানবীয়

- i

- আইবিএম

- আইসিএলআর

- সনাক্ত করা

- আইডি

- আইইইই

- if

- ii

- ইলিনয়

- বাস্তবায়ন

- আমদানি

- গুরুত্বপূর্ণ

- উন্নত করা

- উন্নত

- উন্নতি

- উন্নতি

- in

- গভীর

- অন্তর্ভুক্ত করা

- অন্তর্ভুক্ত

- সুদ্ধ

- বৃদ্ধি

- ইঙ্গিত

- তথ্য

- তথ্য নিষ্কাশন

- পরিকাঠামো

- অবকাঠামো

- ইনপুট

- ইনপুট

- উদাহরণ

- দৃষ্টান্ত

- নির্দেশাবলী

- সংহত

- বুদ্ধিমত্তা

- মধ্যে রয়েছে

- ইন্টারফেস

- আন্তর্জাতিক

- ছেদ

- মধ্যে

- জড়িত

- IT

- এর

- জেমস

- কাজ

- জবস

- যোগদান

- জনাথন

- রোজনামচা

- যাত্রা

- JPG

- JSON

- মাত্র

- চাবি

- রাজ্য

- সজ্জা

- কিট (SDK)

- জ্ঞান

- পরিচিত

- অবতরণ

- ল্যান্ডিং পাতা

- ভাষা

- বড়

- বড় আকারের

- অদৃশ্যতা

- পরে

- চালু

- আইন

- নেতৃত্ব

- শিক্ষা

- লম্বা

- li

- লাইসেন্স

- লাইসেন্স

- মিথ্যা

- জীবন

- মত

- সম্ভাবনা

- সম্ভবত

- সীমাবদ্ধতা

- লাইন

- লাইন

- LINK

- তালিকা

- তালিকাভুক্ত

- শিখা

- বোঝা

- স্থানীয়

- লগিং

- দীর্ঘ

- দেখুন

- ভালবাসে

- কম

- নিম্ন

- কমিয়ে

- অধম

- মেশিন

- মেশিন লার্নিং

- প্রণীত

- প্রধান

- করা

- মেকিং

- পরিচালক

- পরিচালক

- মনন শাহ

- অনেক

- মালিক

- সর্বাধিক

- মে..

- অর্থ

- সম্মেলন

- সদস্য

- মেটা

- পদ্ধতি

- পদ্ধতি

- মেক্সিকো

- হতে পারে

- মাইক

- মন

- ML

- মডেল

- মূর্তিনির্মাণ

- মডেল

- পরিবর্তিত

- পরিবর্তন

- অধিক

- সেতু

- সরানো হয়েছে

- সঙ্গীত

- অবশ্যই

- নাম

- প্রাকৃতিক

- স্বভাবিক ভাষা

- স্বাভাবিক ভাষা প্রক্রিয়াকরণ

- নেভিগেট করুন

- ন্যাভিগেশন

- প্রয়োজন

- চাহিদা

- নিউরপ্স

- নতুন

- পরবর্তী

- NLP

- নর্থওয়েস্টার্ন বিশ্ববিদ্যালয়

- নোটবই

- নোটবুক

- এখন

- সংখ্যা

- সংখ্যার

- লক্ষ্য

- উদ্দেশ্য

- of

- অর্পণ

- নৈবেদ্য

- অর্ঘ

- অফার

- প্রায়ই

- পুরাতন

- পুরোনো

- on

- একদা

- ONE

- কেবল

- অনুকূল

- অপ্টিমাইজেশান

- অপ্টিমিজ

- অপ্টিমাইজ

- সর্বোচ্চকরন

- পছন্দ

- or

- সংগঠন

- অন্যান্য

- আউটপুট

- বাহিরে

- অনিষ্পন্ন

- শেষ

- নিজের

- প্যাকেজ

- পৃষ্ঠা

- যুগল

- জোড়া

- শার্সি

- কাগজ

- কাগজপত্র

- সমান্তরাল

- পরামিতি

- অংশ

- বিশেষত

- দলগুলোর

- উত্তরণ

- কামুক

- গত

- প্রতি

- সম্পাদন করা

- কর্মক্ষমতা

- কাল

- ব্যক্তিগতকৃত

- পিএইচডি

- পাইপলাইন

- মাচা

- Plato

- প্লেটো ডেটা ইন্টেলিজেন্স

- প্লেটোডাটা

- কেলি

- দয়া করে

- বিন্দু

- নীতি

- নীতি

- রাজনৈতিক

- পপ-আপ

- জনপ্রিয়

- ধনাত্মক

- সম্ভাবনার

- সম্ভব

- পোস্ট

- ক্ষমতাশালী

- পূর্ববর্তী

- স্পষ্টতা

- প্রস্তুতি

- প্রাথমিক

- অধ্যক্ষ

- সম্ভাবনা

- সমস্যা

- প্রক্রিয়া

- প্রক্রিয়াজাতকরণ

- পণ্য

- পণ্য ব্যবস্থাপক

- পণ্য

- মালিকানা

- প্রদান

- প্রদানকারীর

- উপলব্ধ

- প্রকাশ্যে

- প্রকাশিত

- করা

- পাইথন

- পাইটার্চ

- গুণ

- প্রশ্ন

- যদৃচ্ছতা

- নাগাল

- ছুঁয়েছে

- পড়া

- প্রস্তুত

- বাস্তব

- বাস্তব জগতে

- প্রকৃত সময়

- কারণ

- কারণে

- রেকর্ড

- পড়ুন

- উল্লেখ

- উদ্বাস্তু

- মুক্ত

- প্রাসঙ্গিকতা

- প্রাসঙ্গিক

- স্থানান্তর করা

- রয়ে

- দেহাবশেষ

- পুনরাবৃত্ত

- পুনরাবৃত্তিমূলক

- প্রতিস্থাপন করা

- সংগ্রহস্থলের

- চিত্রিত করা

- প্রতিনিধিত্বমূলক

- অনুরোধ

- অনুরোধ

- প্রয়োজনীয়

- গবেষণা

- গবেষক

- Resources

- যথাক্রমে

- প্রতিক্রিয়া

- প্রতিক্রিয়া

- দায়ী

- ফলে এবং

- ফলাফল

- প্রত্যাবর্তন

- এখানে ক্লিক করুন

- পর্যালোচনা

- শক্তসমর্থ

- ঘূর্ণায়মান

- রাজকীয়

- চালান

- রাশিয়া

- ঋষি নির্মাতা

- স্কেলেবিলিটি

- মাপযোগ্য

- স্কেল

- পরিস্থিতিতে

- বিজ্ঞানী

- বিজ্ঞানীরা

- স্ক্রিপ্ট

- SDK

- সার্চ

- অনুসন্ধানের

- এসইসি

- এসইসি ফাইলিং

- দ্বিতীয়

- অধ্যায়

- নিরাপত্তা

- দেখ

- জ্যেষ্ঠ

- প্রেরিত

- বাক্য

- অনুভূতি

- আলাদা

- ক্রম

- ক্রম

- সিরিজ এ

- সেবা

- সেবা

- সেট

- বিন্যাস

- সেটিংস

- বিভিন্ন

- সংক্ষিপ্ত

- উচিত

- প্রদর্শনী

- প্রদর্শিত

- শো

- গুরুত্বপূর্ণ

- সহজ

- থেকে

- একক

- আয়তন

- টুকিটাকি

- So

- সমাজ

- সফটওয়্যার

- সফটওয়্যার উন্নয়ন

- সফটওয়্যার ডেভেলপমেন্ট কিট

- সফ্টওয়্যার প্রকৌশল

- সমাধান

- সলিউশন

- সমাধানে

- কিছু

- তার

- উৎস

- দক্ষিণ

- সোভিয়েত

- স্থান

- বিশেষজ্ঞ

- নির্দিষ্ট

- বিশেষভাবে

- নির্দিষ্টতা

- নিদিষ্ট

- খরচ

- বিভক্ত করা

- দণ্ড

- শুরু

- শুরু

- রাষ্ট্র

- পরিসংখ্যানসংক্রান্ত

- অবস্থা

- চালনা

- ধাপ

- প্রারম্ভিক ব্যবহারের নির্দেশাবলী

- স্টপ

- স্টোরেজ

- কাঠামোবদ্ধ

- শিক্ষার্থীরা

- চর্চিত

- গবেষণায়

- চিত্রশালা

- সফলভাবে

- এমন

- সমর্থন

- সমর্থিত

- নিশ্চিত

- সুইজারল্যান্ড

- পদ্ধতি

- সিস্টেম

- টেবিল

- উপযোগী

- কার্য

- কাজ

- শিক্ষাদান

- টীম

- কারিগরী

- প্রযুক্তি

- প্রযুক্তি

- প্রযুক্তিঃ

- টেমপ্লেট

- টেনেসি

- শর্তাবলী

- পরীক্ষা

- পাঠ

- পাঠ্য শ্রেণিবিন্যাস

- পাঠ্য প্রজন্ম

- চেয়ে

- যে

- সার্জারির

- ক্ষেত্র

- রাজধানী

- থিয়েটার

- তাদের

- তাহাদিগকে

- তারপর

- সেখানে।

- এইগুলো

- তারা

- চিন্তা

- তৃতীয় পক্ষের

- এই

- সেগুলো

- দ্বারা

- থ্রুপুট

- বাঘ

- সময়

- বার

- থেকে

- আজ

- টোকেন

- টোকেন

- সরঞ্জাম

- মোট

- রেলগাড়ি

- প্রশিক্ষিত

- প্রশিক্ষণ

- ট্রান্সফরমার

- অনুবাদ

- সত্য

- চেষ্টা

- যমজ

- দুই

- আদর্শ

- ui

- অধীনে

- নিম্নাবস্থিত

- অনন্য

- বিশ্ববিদ্যালয়

- বিশ্ববিদ্যালয়

- পর্যন্ত

- আপডেট

- আপডেট

- ব্যবহার

- ব্যবহার

- ব্যবহার ক্ষেত্রে

- ব্যবহৃত

- ব্যবহারকারী

- ব্যবহারকারী

- ব্যবহারসমূহ

- ব্যবহার

- ব্যবহার

- উজ্বেকিস্থান

- বৈধতা

- মূল্য

- বৈচিত্র্য

- বিভিন্ন

- সংস্করণ

- খুব

- মাধ্যমে

- চেক

- দ্রাক্ষালতা

- চাক্ষুষ

- পদব্রজে ভ্রমণ

- প্রয়োজন

- যুদ্ধ

- ছিল

- উপায়

- we

- ওয়েব

- ওয়েব সার্ভিস

- ওয়েব ভিত্তিক

- গিয়েছিলাম

- ছিল

- কখন

- যে

- যখন

- হু

- ইচ্ছা

- মদ

- সঙ্গে

- ওঁন

- শব্দ

- শব্দ

- হয়া যাই ?

- কাজ করছে

- কাজ

- কাজ

- কারখানা

- বিশ্ব

- would

- লেখা

- বছর

- যোগশাস্ত্র

- আপনি

- আপনার

- যৌবন

- zephyrnet

- গ্রীকদের দেবরাজ