في مجال الذكاء الاصطناعي سريع التطور ، أصبحت معالجة اللغة الطبيعية نقطة محورية للباحثين والمطورين على حد سواء. بناء على أسس هندسة المحولات و ترقية BERT ثنائية الاتجاه، ظهرت العديد من النماذج اللغوية الرائدة في السنوات الأخيرة ، مما دفع حدود ما يمكن للآلات أن تفهمه وتولده.

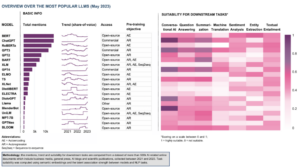

في هذه المقالة ، سوف نتعمق في أحدث التطورات في عالم نماذج اللغات واسعة النطاق ، واستكشاف التحسينات التي أدخلها كل نموذج ، وقدراته ، والتطبيقات المحتملة. سننظر أيضًا في نماذج اللغة المرئية (VLMs) التي تم تدريبها على معالجة ليس فقط البيانات النصية ولكن أيضًا البيانات المرئية.

إذا كنت ترغب في التخطي ، فإليك نماذج اللغات التي قدمناها:

- GPT-3 بواسطة OpenAI

- LaMDA من جوجل

- PaLM من Google

- فلامنغو من ديب مايند

- BLIP-2 بواسطة Salesforce

- LLaMA بواسطة Meta AI

- GPT-4 بواسطة OpenAI

إذا كان هذا المحتوى التعليمي المتعمق مفيدًا لك ، فيمكنك ذلك اشترك في القائمة البريدية لأبحاث الذكاء الاصطناعي ليتم تنبيهنا عندما نصدر مادة جديدة.

أهم نماذج اللغات الكبيرة (LLMs) ونماذج اللغات المرئية (VLMs) في عام 2023

1. GPT-3 بواسطة OpenAI

نبذة عامة

قدم فريق OpenAI GPT-3 كبديل لوجود مجموعة بيانات مصنفة لكل مهمة لغة جديدة. اقترحوا أن توسيع نطاق نماذج اللغة يمكن أن يحسن أداء بعض اللقطات الحيادية. لاختبار هذا الاقتراح ، قاموا بتدريب نموذج لغة ارتداد ذاتي مكون من 175B ، يسمى GPT-3، وقيمت أدائها في أكثر من عشرين مهمة من مهام البرمجة اللغوية العصبية. أظهر التقييم في إطار التعلم قليل اللقطات ، والتعلم من طلقة واحدة ، والتعلم بدون طلقة ، أن GPT-3 حقق نتائج واعدة وحتى تفوقت أحيانًا على أحدث النتائج التي حققتها النماذج الدقيقة.

ما هو الهدف؟

- لاقتراح حل بديل للمشكلة الحالية ، عند الحاجة إلى مجموعة بيانات معنونة لكل مهمة لغوية جديدة.

كيف يتم التعامل مع المشكلة؟

- اقترح الباحثون توسيع نطاق نماذج اللغة لتحسين أداء بعض اللقطات الحيادية.

- • GPT-3 يستخدم النموذج نفس الطراز والبنية مثل GPT-2 ، بما في ذلك التهيئة المعدلة ، والتطبيع المسبق ، والترميز القابل للانعكاس.

- ومع ذلك ، على عكس GPT-2 ، فإنه يستخدم أنماط انتباه متناوبة كثيفة ومتفرقة محليًا في طبقات المحول ، كما في محول متفرق.

ما هي النتائج؟

- يحقق نموذج GPT-3 بدون صقل نتائج واعدة في عدد من مهام البرمجة اللغوية العصبية ، بل ويتفوق أحيانًا على أحدث النماذج التي تم ضبطها لهذه المهمة المحددة:

- على CoQA المعيار ، 81.5 F1 في إعداد اللقطة الصفرية ، و 84.0 F1 في إعداد اللقطة الواحدة ، و 85.0 F1 في إعداد اللقطة القليلة ، مقارنة بدرجة 90.7 F1 التي حققتها SOTA بدقة.

- على تريفيا المعيار ، دقة 64.3٪ في إعداد اللقطة الصفرية ، و 68.0٪ في إعداد اللقطة الواحدة ، و 71.2٪ في إعداد اللقطة القليلة ، متجاوزًا أحدث التقنيات (68٪) بنسبة 3.2٪.

- على مبادا مجموعة البيانات ، دقة 76.2٪ في إعداد اللقطة الصفرية ، 72.5٪ في إعداد اللقطة الواحدة ، و 86.4٪ في إعداد اللقطة القليلة ، متجاوزة أحدث التقنيات (68٪) بنسبة 18٪.

- يصعب التمييز بين المقالات الإخبارية التي تم إنشاؤها بواسطة نموذج GPT-175 ذي المعامل 3B وبين المقالات الحقيقية ، وفقًا للتقييمات البشرية (بدقة أعلى قليلاً من مستوى الفرصة عند 52٪ تقريبًا).

- على الرغم من الأداء الرائع لـ GPT-3 ، فقد حصلت على آراء متباينة من مجتمع الذكاء الاصطناعي:

- "الضجيج GPT-3 كثير جدًا. إنه أمر مثير للإعجاب (شكرًا على الإطراءات اللطيفة!) ولكنه لا يزال يحتوي على نقاط ضعف خطيرة وأحيانًا يرتكب أخطاء سخيفة جدًا. سيغير الذكاء الاصطناعي العالم ، لكن GPT-3 هي مجرد لمحة مبكرة جدًا. لا يزال لدينا الكثير لنكتشفه ". - سام التمان ، الرئيس التنفيذي والمؤسس المشارك لشركة OpenAI.

- "لقد صُدمت من مدى صعوبة إنشاء نصوص عن المسلمين من GPT-3 لا علاقة لها بالعنف ... أو القتل ..." - أبو بكر عابد ، الرئيس التنفيذي ومؤسس جراديو.

- "لا. لا يفهم GPT-3 العالم الذي يتحدث عنه بشكل أساسي. ستسمح زيادة المجموعة بشكل أكبر بتوليد نسخ أكثر مصداقية ولكن ليس إصلاح افتقارها الأساسي إلى فهم العالم. ستظل العروض التوضيحية لـ GPT-4 تتطلب قطف الكرز البشري ". - غاري ماركوس ، الرئيس التنفيذي ومؤسس Robust.ai.

- "إن استقراء الأداء المذهل لـ GPT3 في المستقبل يشير إلى أن الإجابة على الحياة والكون وكل شيء هي فقط 4.398 تريليون معلمة." - جيفري هينتون ، الحائز على جائزة تورينج.

أين تتعلم المزيد عن هذا البحث؟

من أين تحصل على رمز التنفيذ؟

- الكود نفسه غير متاح ، ولكن تم إصدار بعض إحصائيات مجموعة البيانات جنبًا إلى جنب مع عينات الرموز 2048 غير المشروطة وغير المفلترة من GPT-3 في GitHub جيثب:.

2. LaMDA من Google

نبذة عامة

Laنجوى Mأوديلز Dحوار Aمضاعفات (لامدا) من خلال عملية ضبط مجموعة من نماذج اللغة العصبية المستندة إلى المحولات المصممة خصيصًا للحوارات. تحتوي هذه النماذج على حد أقصى من المعلمات يبلغ 137B وتم تدريبها على استخدام مصادر المعرفة الخارجية. كان لدى مطوري LaMDA ثلاثة أهداف رئيسية في الاعتبار - الجودة والسلامة والأرضية. أظهرت النتائج أن الضبط الدقيق يسمح بتضييق فجوة الجودة إلى المستويات البشرية ، لكن أداء النموذج ظل أقل من المستويات البشرية فيما يتعلق بالسلامة والتأريض.

جوجل بارد ، صدر مؤخرًا كبديل لـ ChatGPT ، يتم تشغيله بواسطة LaMDA. على الرغم من وصف Bard في كثير من الأحيان باسم ممل، يمكن اعتبار ذلك دليلاً على التزام Google بإعطاء الأولوية للسلامة ، حتى في خضم التنافس الشديد بين Google و Microsoft لتأسيس الهيمنة في مجال الذكاء الاصطناعي التوليدي.

ما هو الهدف؟

- لبناء نموذج لتطبيقات حوار المجال المفتوح ، حيث يكون وكيل الحوار قادرًا على التحدث عن أي موضوع مع استجابات معقولة ومحددة للسياق ومرتكزة على مصادر موثوقة وأخلاقية.

كيف يتم التعامل مع المشكلة؟

- تم بناء LaMDA على محول، وهي بنية شبكة عصبية اخترعها Google Research وفتح مصدرها في عام 2017.

- مثل نماذج اللغات الكبيرة الأخرى ، بما في ذلك BERT و GPT-3 ، يتم تدريب LaMDA على تيرابايت من البيانات النصية لمعرفة كيفية ارتباط الكلمات ببعضها البعض ثم التنبؤ بالكلمات التي من المحتمل أن تأتي بعد ذلك.

- ومع ذلك ، على عكس معظم النماذج اللغوية ، تم تدريب LaMDA على الحوار لالتقاط الفروق الدقيقة التي تميز المحادثة المفتوحة عن أشكال اللغة الأخرى.

- تم أيضًا ضبط النموذج لتحسين حساسية وسلامة وخصوصية استجاباته. في حين أن عبارات مثل "هذا لطيف" و "لا أعرف" يمكن أن تكون ذات مغزى في العديد من سيناريوهات الحوار ، فمن غير المحتمل أن تؤدي إلى محادثات شيقة وجذابة.

- يُولِّد مُنشئ LaMDA أولاً العديد من استجابات المرشحين ، والتي يتم تسجيلها جميعًا بناءً على مدى أمانها وحساسيتها ومحددة ومثيرة للاهتمام. يتم تصفية الاستجابات ذات درجات الأمان المنخفضة ، ثم يتم تحديد النتيجة الأعلى مرتبة كاستجابة.

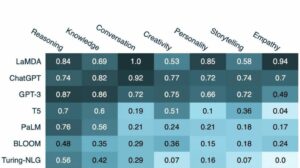

ما هي النتائج؟

- تظهر العديد من التجارب أن LaMDA يمكنه المشاركة في محادثات مفتوحة حول مجموعة متنوعة من الموضوعات.

- أكدت سلسلة من التقييمات النوعية أن استجابات النموذج تميل إلى أن تكون معقولة ومحددة ومثيرة للاهتمام ومرتكزة على مصادر خارجية موثوقة ولكن لا يزال هناك مجال للتحسين.

- على الرغم من كل التقدم الذي تم إحرازه حتى الآن ، يدرك المؤلفون أن النموذج لا يزال به العديد من القيود التي قد تؤدي إلى توليد استجابات غير مناسبة أو حتى ضارة.

أين تتعلم المزيد عن هذا البحث؟

من أين تحصل على رمز التنفيذ؟

- يتوفر تطبيق PyTorch مفتوح المصدر لهيكل ما قبل التدريب لـ LaMDA GitHub جيثب:.

3. PaLM من Google

نبذة عامة

Paالممرات Language Mأوديل (كف، نخلة) هو نموذج لغة قائم على المحولات تبلغ قيمته 540 مليار معلمة. تم تدريب PaLM على رقائق 6144 TPU v4 باستخدام Pathways ، وهو نظام ML جديد للتدريب الفعال عبر العديد من أجهزة TPU. يوضح النموذج فوائد التوسع في التعلم قليل اللقطات ، وتحقيق أحدث النتائج على مئات من فهم اللغة ومعايير التوليد. يتفوق PaLM في الأداء على أحدث النماذج الدقيقة في مهام التفكير متعددة الخطوات ويتجاوز متوسط الأداء البشري في معيار BIG-المعياري.

ما هو الهدف؟

- لتحسين فهم كيفية تأثير تحجيم نماذج اللغة الكبيرة على التعلم القليل اللقطات.

كيف يتم التعامل مع المشكلة؟

- الفكرة الأساسية هي توسيع نطاق تدريب نموذج لغة مكون من 540 مليار معلمة باستخدام نظام Pathways:

- كان الفريق يستخدم توازي البيانات على مستوى Pod عبر اثنين من Cloud TPU v4 Pods أثناء استخدام البيانات القياسية وتوازي النماذج داخل كل Pod.

- لقد تمكنوا من توسيع نطاق التدريب إلى شرائح 6144 TPU v4 ، وهو أكبر تكوين للنظام يعتمد على TPU يستخدم للتدريب حتى الآن.

- حقق النموذج كفاءة تدريب بنسبة 57.8 ٪ من استخدام FLOPs للأجهزة ، والتي ، كما يدعي المؤلفون ، هي أعلى كفاءة تدريب تم تحقيقها لنماذج اللغات الكبيرة في هذا المقياس.

- تضمنت بيانات التدريب الخاصة بنموذج PaLM مجموعة من مجموعات البيانات الإنجليزية ومتعددة اللغات التي تحتوي على مستندات ويب عالية الجودة وكتب وويكيبيديا ومحادثات وكود GitHub.

ما هي النتائج؟

- تُظهر تجارب عديدة أن أداء النموذج قد ازداد بشكل حاد مع توسع الفريق إلى نموذجهم الأكبر.

- حقق PaLM 540B أداءً مذهلاً في العديد من المهام الصعبة للغاية:

- فهم اللغة وتوليدها. تجاوز النموذج المقدم أداء عدد قليل من اللقطات للنماذج الكبيرة السابقة في 28 من أصل 29 مهمة تتضمن مهام الإجابة على الأسئلة ، ومهام الإغلاق وإكمال الجملة ، ومهام فهم القراءة في السياق ، ومهام التفكير المنطقي ، ومهام SuperGLUE ، و أكثر. أظهر أداء PaLM في مهام BIG-bench أنه يمكنه التمييز بين السبب والنتيجة ، وكذلك فهم التوليفات المفاهيمية في السياقات المناسبة.

- منطق. من خلال دفع 8 طلقات ، يحل PaLM 58٪ من المشكلات في GSM8K ، وهو معيار لآلاف أسئلة الرياضيات الصعبة على مستوى المدرسة الابتدائية ، متفوقًا على الدرجة الأولى السابقة البالغة 55٪ التي تم تحقيقها من خلال ضبط نموذج GPT-3 175B. يوضح PaLM أيضًا القدرة على إنشاء تفسيرات صريحة في المواقف التي تتطلب مزيجًا معقدًا من الاستدلال المنطقي متعدد الخطوات ، والمعرفة العالمية ، والفهم العميق للغة.

- رمز الجيل. يعمل PaLM على قدم المساواة مع Codex 12B الذي تم ضبطه بدقة بينما يستخدم كود Python أقل 50 مرة للتدريب ، مما يؤكد أن نماذج اللغات الكبيرة تنقل التعلم من كل من لغات البرمجة الأخرى وبيانات اللغة الطبيعية بشكل أكثر فعالية.

أين تتعلم المزيد عن هذا البحث؟

من أين تحصل على رمز التنفيذ؟

- يتوفر تنفيذ PyTorch غير الرسمي لهندسة المحولات المحددة من ورقة بحث PaLM على GitHub جيثب:. لن يتم توسيعه ويتم نشره للأغراض التعليمية فقط.

4. فلامنغو من DeepMind

نبذة عامة

Flamingo هي عائلة متطورة من نماذج اللغات المرئية (VLMs) ، مدربة على مجموعات ويب متعددة الوسائط واسعة النطاق مع نصوص وصور مختلطة. من خلال هذا التدريب ، يمكن للنماذج التكيف مع المهام الجديدة باستخدام الحد الأدنى من الأمثلة المشروحة ، المقدمة كموجه. يدمج Flamingo التطورات المعمارية الرئيسية المصممة لدمج نقاط القوة في نماذج الرؤية فقط ونماذج اللغة فقط ، وتسلسل المعالجة للبيانات المرئية والنصية المتشابكة بشكل متغير ، واستيعاب الصور أو مقاطع الفيديو كمدخلات بسلاسة. تُظهر النماذج قابلية رائعة للتكيف مع مجموعة من مهام الصور والفيديو مثل الإجابة على الأسئلة المرئية ، ومهام التسميات التوضيحية ، والإجابة على الأسئلة المرئية متعددة الخيارات ، ووضع معايير أداء جديدة باستخدام مطالبات خاصة بالمهمة في التعلم قليل اللقطات.

ما هو الهدف؟

- لإحراز تقدم نحو تمكين النماذج متعددة الوسائط من التعلم بسرعة وتنفيذ المهام الجديدة بناءً على تعليمات قصيرة:

- إن النموذج المستخدم على نطاق واسع للتدريب المسبق على نموذج على كمية كبيرة من البيانات الخاضعة للإشراف ، ثم ضبطه لمهمة محددة ، هو كثيف الموارد ويتطلب الآلاف من نقاط البيانات المشروحة جنبًا إلى جنب مع الضبط الدقيق للمعلمة الفائقة لكل مهمة.

- تسمح النماذج الحالية التي تستخدم هدفًا تباينًا بالتكيف التام مع المهام الجديدة ولكنها تقصر في المهام ذات النهايات المفتوحة مثل التسميات التوضيحية أو الإجابة على الأسئلة المرئية لأنها تفتقر إلى قدرات إنشاء اللغة.

- يهدف هذا البحث إلى تقديم نموذج جديد يعالج بفعالية هذه القضايا ويظهر الأداء المتفوق في الأنظمة منخفضة البيانات.

كيف يتم التعامل مع المشكلة؟

- قدم DeepMind Flamingo ، VLMs المصممة للتعلم بعدة لقطات على مختلف مهام الرؤية والمهام اللغوية المفتوحة ، باستخدام عدد قليل من أمثلة الإدخال / الإخراج.

- نماذج Flamingo هي نماذج إنشاء نص انحدار تلقائي مكيفة بصريًا يمكنها معالجة الرموز النصية الممزوجة بالصور و / أو مقاطع الفيديو وإنشاء نص كمخرجات.

- تشتمل بنية Flamingo على نموذجين تكميليين مدربين مسبقًا ومجمدين:

- نموذج رؤية قادر على "إدراك" المشاهد المرئية.

- نموذج لغوي كبير مكلف بأداء الاستدلال الأساسي.

- تدمج مكونات العمارة الجديدة هذه النماذج بطريقة تحافظ على المعرفة المكتسبة أثناء التدريب المسبق المكثف حسابيًا.

- بالإضافة إلى ذلك ، تتميز طرز Flamingo بهندسة قائمة على Perceiver ، مما يسمح لها باستيعاب صور أو مقاطع فيديو عالية الدقة. يمكن لهذه البنية أن تولد عددًا ثابتًا من الرموز المرئية لكل صورة / فيديو من مجموعة واسعة ومتغيرة من ميزات الإدخال المرئي.

ما هي النتائج؟

- يُظهر البحث أنه على غرار LLMs ، وهي عبارة عن متعلمين جيدين قليلو اللقطات ، يمكن أن تتعلم VLM من بعض أمثلة الإدخال / الإخراج لمهام فهم الصور والفيديو مثل التصنيف أو التعليق أو الإجابة على الأسئلة.

- يضع Flamingo معيارًا جديدًا في التعلم قليل اللقطات ، مما يدل على الأداء المتفوق في مجموعة واسعة من 16 لغة متعددة الوسائط ومهمة فهم الصور / الفيديو.

- بالنسبة لـ 6 من هذه المهام الـ 16 ، يتفوق Flamingo على أداء أحدث التقنيات ، على الرغم من أنه يستخدم فقط 32 مثالًا خاصًا بالمهمة - حوالي 1000 مرة أقل من بيانات التدريب الخاصة بالمهمة مقارنة بالنماذج الحالية ذات الأداء الأفضل.

أين تتعلم المزيد عن هذا البحث؟

من أين تحصل على رمز التنفيذ؟

- DeepMind لم تفرج عن التطبيق الرسمي لـ Flamingo.

- قد تجد تطبيق مفتوح المصدر للنهج المقدم في OpenFlamingo جيثب ريبو.

- يتوفر تطبيق PyTorch البديل هنا.

5. BLIP-2 بواسطة Salesforce

نبذة عامة

BLIP-2 هو إطار عمل ما قبل التدريب الفعال والعام لنماذج الرؤية واللغة ، وهو مصمم للتحايل على التكلفة الباهظة المتزايدة للنماذج واسعة النطاق قبل التدريب. يستفيد BLIP-2 من برامج تشفير الصور المجمدة المدربة مسبقًا ونماذج اللغات الكبيرة المجمدة لتمهيد التدريب المسبق للغة الرؤية ، بما في ذلك محول Querying خفيف الوزن تم تدريبه مسبقًا على مرحلتين. تبدأ المرحلة الأولى في تعلم تمثيل الرؤية واللغة من برنامج تشفير الصور المجمد ، وتدفع المرحلة الثانية التعلم التوليدي من الرؤية إلى اللغة من نموذج اللغة المجمدة. على الرغم من وجود عدد أقل من المعلمات القابلة للتدريب ، إلا أن BLIP-2 يتفوق على أحدث الأساليب ، متجاوزًا برنامج DeepMind's Flamingo80B بنسبة 8.7٪ على VQAv2 بدون طلقة مع عدد أقل من المعلمات القابلة للتدريب 54 مرة. يعرض النموذج أيضًا إمكانات واعدة لتوليد الصور من صورة إلى نص من خلال اتباع تعليمات اللغة الطبيعية.

ما هو الهدف؟

- للحصول على أحدث أداء في مهام لغة الرؤية ، مع تقليل تكاليف الحساب.

كيف يتم التعامل مع المشكلة؟

- قدم فريق Salesforce إطارًا جديدًا للتدريب المسبق للغة الرؤية أطلق عليه اسم BLIP-2 ، Bcom.ootstrapping Lعذاب-Iبركه Pإعادة التدريب مع النماذج أحادية النمط المجمدة:

- تظل النماذج أحادية الوسائط المدربة مسبقًا مجمدة أثناء التدريب المسبق لتقليل تكلفة الحساب وتجنب مشكلة النسيان الكارثي.

- لتسهيل المحاذاة عبر الوسائط وسد فجوة الأسلوب بين نماذج الرؤية المدربة مسبقًا ونماذج اللغة المدربة مسبقًا ، يقترح الفريق محول استعلام خفيف الوزن (Q-Former) يعمل بمثابة عنق زجاجة معلومات بين وحدة تشفير الصور المجمدة والمجمدة ماجستير.

- تم تدريب Q-Former مسبقًا باستخدام إستراتيجية جديدة من مرحلتين:

- تقوم مرحلة ما قبل التدريب الأولى بتعلم تمثيل الرؤية واللغة. هذا يفرض Q-Former لتعلم التمثيل المرئي الأكثر صلة بالنص.

- تقوم المرحلة الثانية قبل التدريب بإجراء التعلم التوليدي من الرؤية إلى اللغة من خلال توصيل مخرجات Q-Former بـ LLM مجمدة. تم تدريب Q-Former بحيث يمكن تفسير التمثيل المرئي لمخرجاته بواسطة LLM.

ما هي النتائج؟

- يقدم BLIP-2 نتائج استثنائية وحديثة عبر مجموعة متنوعة من مهام الرؤية واللغة ، بما في ذلك الإجابة على الأسئلة المرئية وتعليق الصور واسترجاع نص الصورة.

- على سبيل المثال ، يتفوق على Flamingo بنسبة 8.7٪ على VQAv2 بدون طلقة.

- علاوة على ذلك ، يتم تحقيق هذا الأداء المتميز بكفاءة كمبيوتر أعلى بشكل ملحوظ:

- يتفوق BLIP-2 على Flamingo-80B مع استخدام عدد أقل من المعلمات القابلة للتدريب بمعدل 54 مرة.

- يتمتع BLIP-2 بالقدرة على إجراء إنشاء صورة إلى نص بدون لقطة استجابة لتعليمات اللغة الطبيعية ، مما يمهد الطريق لتطوير مهارات مثل التفكير المعرفي البصري والمحادثة المرئية من بين آخرين.

- أخيرًا ، من المهم ملاحظة أن BLIP-2 هو نهج متعدد الاستخدامات يمكنه الاستفادة من نماذج أحادية أكثر تعقيدًا لزيادة تحسين أداء التدريب المسبق للغة الرؤية.

أين تتعلم المزيد عن هذا البحث؟

من أين تحصل على رمز التنفيذ؟

يتوفر تطبيق BLIP-2 الرسمي على GitHub جيثب:.

6. LLaMA بواسطة Meta AI

نبذة عامة

يؤكد فريق Meta AI أن النماذج الأصغر المدربة على المزيد من الرموز يسهل إعادة تدريبها وضبطها لتطبيقات منتجات معينة. لذلك ، يقدمون المكالمات (Lالدو Laنجوى Mأوديل ميتا AI) ، مجموعة من نماذج اللغة الأساسية مع معلمات 7B إلى 65B. تم تدريب LLaMA 33B و 65 B على 1.4 تريليون رمز ، بينما تم تدريب أصغر طراز ، LLaMA 7B ، على تريليون رمز. لقد استخدموا مجموعات البيانات المتاحة للجمهور حصريًا ، دون الاعتماد على بيانات الملكية أو المقيدة. قام الفريق أيضًا بتنفيذ تحسينات معمارية رئيسية وتقنيات تحسين سرعة التدريب. وبالتالي ، تفوق LLaMA-13B على GPT-3 ، حيث كان أصغر بعشر مرات ، وأظهر LLaMA-10B أداءً تنافسيًا مع PaLM-65B.

ما هو الهدف؟

- لإثبات جدوى تدريب النماذج عالية الأداء فقط على مجموعات البيانات المتاحة للجمهور ، دون الاعتماد على مصادر بيانات مقيدة أو مقيدة.

- لتزويد مجتمع البحث بنماذج أصغر وأكثر أداءً ، وبالتالي ، تمكين أولئك الذين ليس لديهم إمكانية الوصول إلى كميات كبيرة من البنية التحتية ، من دراسة نماذج اللغة الكبيرة.

كيف يتم التعامل مع المشكلة؟

- لتدريب نموذج LLaMA ، استخدم الباحثون فقط البيانات المتاحة للجمهور والمتوافقة مع المصادر المفتوحة.

- لقد أدخلوا أيضًا بعض التحسينات على بنية المحولات القياسية:

- وباعتماد منهجية GPT-3 ، تم تعزيز استقرار التدريب عن طريق تطبيع المدخلات لكل طبقة فرعية من المحولات ، بدلاً من تطبيع المخرجات.

- مستوحاة من نماذج PaLM ، قام الباحثون باستبدال ReLU non-linearity بوظيفة تنشيط SwiGLU ، لتحسين الأداء.

- مستوحاة من سو وآخرون (2021)قاموا بإلغاء عمليات الزفاف الموضعية المطلقة وبدلاً من ذلك ، قاموا بدمج حفلات الزفاف الموضعية الدوارة (RoPE) في كل طبقة من طبقات الشبكة.

- أخيرًا ، قام فريق Meta AI بتحسين سرعة التدريب لنموذجهم من خلال:

- استخدام التنفيذ السببي الفعال للانتباه متعدد الرؤوس من خلال عدم تخزين أوزان الانتباه أو حساب درجات مفتاح / استعلام مقنع.

- استخدام نقاط التفتيش لتقليل عمليات التنشيط المعاد حسابها أثناء المرور الخلفي.

- التداخل في حساب عمليات التنشيط والاتصال بين وحدات معالجة الرسومات عبر الشبكة (بسبب عمليات all_reduce).

ما هي النتائج؟

- يتفوق LLaMA-13B على GPT-3 على الرغم من كونه أصغر بعشر مرات ، بينما يحتفظ LLaMA-10B به ضد PaLM-65B.

أين تتعلم المزيد عن هذا البحث؟

من أين تحصل على رمز التنفيذ؟

- يوفر Meta AI الوصول إلى LLaMA للباحثين الأكاديميين والأفراد المرتبطين بالحكومة والمجتمع المدني والمؤسسات الأكاديمية ومختبرات أبحاث الصناعة العالمية على أساس تقييم الحالة الفردية. للتقديم ، انتقل إلى ما يلي مستودع جيثب.

7. GPT-4 بواسطة OpenAI

نبذة عامة

GPT-4 هو نموذج متعدد الوسائط واسع النطاق يقبل إدخالات الصور والنص ويولد مخرجات نصية. بسبب مخاوف المنافسة والسلامة ، تم حجب تفاصيل محددة حول بنية النموذج والتدريب. من حيث الأداء ، يتجاوز GPT-4 نماذج اللغة السابقة في المعايير التقليدية ويظهر تحسينات كبيرة في فهم نية المستخدم وخصائص الأمان. يحقق النموذج أيضًا أداءً على مستوى الإنسان في العديد من الاختبارات ، بما في ذلك أعلى درجة بنسبة 10٪ في امتحان شريط موحد مُحاكى.

ما هو الهدف؟

- لتطوير نموذج متعدد الوسائط واسع النطاق يمكنه قبول مدخلات الصور والنص وإنتاج مخرجات نصية.

- لتطوير البنية التحتية وطرق التحسين التي تتصرف بشكل متوقع عبر مجموعة واسعة من المقاييس.

كيف يتم التعامل مع المشكلة؟

- نظرًا للمناظر الطبيعية التنافسية والآثار المتعلقة بالسلامة ، قررت شركة OpenAI حجب التفاصيل المتعلقة بالهندسة المعمارية ، وحجم النموذج ، والأجهزة ، وحساب التدريب ، وبناء مجموعة البيانات ، وطرق التدريب.

- يكشفون أن:

- GPT-4 هو نموذج قائم على المحولات ، تم تدريبه مسبقًا للتنبؤ بالرمز المميز التالي في المستند.

- يستخدم البيانات المتاحة للجمهور والبيانات المرخصة من جهة خارجية.

- تم ضبط النموذج باستخدام التعلم المعزز من ردود الفعل البشرية (RLHF).

- تشير المعلومات غير المؤكدة إلى أن GPT-4 ليس نموذجًا كثيفًا فريدًا مثل سابقاتها ، ولكنه تحالف قوي من ثمانية نماذج منفصلة ، كل منها يحزم 220 مليار معلمة مذهلة.

ما هي النتائج؟

- يحقق GPT-4 أداءً على مستوى الإنسان في معظم الاختبارات المهنية والأكاديمية ، ولا سيما تسجيل أعلى 10٪ في امتحان شريط موحد مُحاكى.

- يتفوق نموذج GPT-4 الأساسي المدربين مسبقًا على نماذج اللغة الحالية والأنظمة الحديثة السابقة في معايير البرمجة اللغوية العصبية التقليدية ، دون صياغة خاصة بالمعايير أو بروتوكولات تدريب إضافية.

- يوضح GPT-4 تحسنًا كبيرًا في نية المستخدم التالية ، مع تفضيل ردوده على استجابات GPT-3.5 في 70.2٪ من 5,214 مطالبة من ChatGPT وواجهة برمجة تطبيقات OpenAI.

- تحسنت خصائص أمان GPT-4 بشكل ملحوظ مقارنةً بـ GPT-3.5 ، مع انخفاض بنسبة 82٪ في الاستجابة لطلبات المحتوى غير المسموح بها وزيادة بنسبة 29٪ في الامتثال لسياسات الطلبات الحساسة (على سبيل المثال ، المشورة الطبية وإيذاء النفس).

أين تتعلم المزيد عن هذا البحث؟

من أين تحصل على رمز التنفيذ؟

- لا يتوفر تنفيذ رمز GPT-4.

تطبيقات العالم الحقيقي لنماذج اللغة الكبيرة (الرؤية)

جاءت أهم الإنجازات البحثية للذكاء الاصطناعي في السنوات الأخيرة من نماذج ذكاء اصطناعي كبيرة مدربة على مجموعات بيانات ضخمة. تُظهر هذه النماذج أداءً مثيرًا للإعجاب ، ومن الرائع التفكير في كيفية قيام الذكاء الاصطناعي بإحداث ثورة في الصناعات بأكملها ، مثل خدمة العملاء ، والتسويق ، والتجارة الإلكترونية ، والرعاية الصحية ، وتطوير البرمجيات ، والصحافة ، وغيرها الكثير.

نماذج اللغات الكبيرة لها العديد من تطبيقات العالم الحقيقي. يسرد GPT-4 ما يلي:

- فهم وتوليد اللغة الطبيعية لروبوتات المحادثة والمساعدين الافتراضيين.

- الترجمة الآلية بين اللغات.

- تلخيص المقالات أو التقارير أو المستندات النصية الأخرى.

- تحليل المشاعر لأبحاث السوق أو مراقبة وسائل التواصل الاجتماعي.

- إنشاء محتوى للتسويق أو وسائل التواصل الاجتماعي أو الكتابة الإبداعية.

- أنظمة الإجابة على الأسئلة لدعم العملاء أو قواعد المعرفة.

- تصنيف النص لتصفية البريد العشوائي أو تصنيف الموضوع أو تنظيم المستند.

- أدوات مخصصة لتعلم اللغة والدروس الخصوصية.

- إنشاء التعليمات البرمجية والمساعدة في تطوير البرامج.

- تحليل ومساعدة المستندات الطبية والقانونية والفنية.

- أدوات الوصول للأفراد ذوي الإعاقة ، مثل تحويل النص إلى كلام وتحويل الكلام إلى نص.

- خدمات التعرف على الكلام والنسخ.

إذا أضفنا جزءًا مرئيًا ، فستتوسع مجالات التطبيقات الممكنة بشكل أكبر:

من المثير جدًا متابعة التطورات الأخيرة في مجال الذكاء الاصطناعي والتفكير في تطبيقاتها المحتملة في العالم الحقيقي. ومع ذلك ، قبل نشر هذه النماذج في الحياة الواقعية ، نحتاج إلى معالجة المخاطر والقيود المقابلة ، والتي للأسف كبيرة جدًا.

المخاطر والقيود

إذا سألت GPT-4 عن مخاطرها وقيودها ، فمن المحتمل أن تزودك بقائمة طويلة من المخاوف ذات الصلة. بعد تصفية هذه القائمة وإضافة بعض الاعتبارات الإضافية ، انتهى بي الأمر بالمجموعة التالية من المخاطر والقيود الرئيسية التي تمتلكها نماذج اللغات الكبيرة الحديثة:

- التحيز والتمييز: تتعلم هذه النماذج من كميات هائلة من البيانات النصية ، والتي غالبًا ما تحتوي على تحيزات ومحتوى تمييزي. نتيجة لذلك ، يمكن للمخرجات الناتجة أن تديم القوالب النمطية واللغة المسيئة والتمييز على أساس عوامل مثل الجنس أو العرق أو الدين عن غير قصد.

- معلومات خاطئة: قد تنشئ النماذج اللغوية الكبيرة محتوى غير صحيح من الناحية الواقعية أو مضلل أو قديم. بينما يتم تدريب النماذج على مجموعة متنوعة من المصادر ، إلا أنها قد لا توفر دائمًا المعلومات الأكثر دقة أو حداثة. يحدث هذا غالبًا لأن النموذج يعطي الأولوية لتوليد مخرجات صحيحة نحويًا أو تبدو متماسكة ، حتى لو كانت مضللة.

- قلة الفهم: على الرغم من أن هذه النماذج يبدو أنها تفهم لغة الإنسان ، إلا أنها تعمل في المقام الأول من خلال تحديد الأنماط والجمعيات الإحصائية في بيانات التدريب. ليس لديهم فهم عميق للمحتوى الذي يقومون بإنشائه ، والذي يمكن أن يؤدي في بعض الأحيان إلى مخرجات غير منطقية أو غير ذات صلة.

- محتوى غير لائق: يمكن أن تنشئ النماذج اللغوية أحيانًا محتوى مسيئًا أو ضارًا أو غير مناسب. بينما يتم بذل الجهود لتقليل مثل هذا المحتوى ، إلا أنه لا يزال من الممكن أن يحدث بسبب طبيعة بيانات التدريب وعدم قدرة النماذج على تمييز السياق أو نية المستخدم.

وفي الختام

أحدثت نماذج اللغات الكبيرة ثورة بلا شك في مجال معالجة اللغة الطبيعية وأظهرت إمكانات هائلة في تعزيز الإنتاجية عبر مختلف الأدوار والصناعات. إن قدرتهم على إنشاء نص يشبه الإنسان ، وأتمتة المهام العادية ، وتقديم المساعدة في العمليات الإبداعية والتحليلية ، جعلتهم أدوات لا غنى عنها في عالم اليوم سريع الخطى والمدفوع بالتكنولوجيا.

ومع ذلك ، فمن الأهمية بمكان إدراك وفهم القيود والمخاطر المرتبطة بهذه النماذج القوية. لا يمكن تجاهل قضايا مثل التحيز والمعلومات الخاطئة واحتمال الاستخدام الضار. مع استمرارنا في دمج هذه التقنيات التي يحركها الذكاء الاصطناعي في حياتنا اليومية ، من الضروري تحقيق توازن بين الاستفادة من قدراتها وضمان الإشراف البشري ، لا سيما في المواقف الحساسة وعالية الخطورة.

إذا نجحنا في تبني تقنيات الذكاء الاصطناعي التوليدية بمسؤولية ، فسنمهد الطريق لمستقبل يعمل فيه الذكاء الاصطناعي والخبرة البشرية معًا لدفع الابتكار وخلق عالم أفضل للجميع.

هل تستمتع بهذه المقالة؟ قم بالتسجيل للحصول على المزيد من تحديثات أبحاث الذكاء الاصطناعي.

سنخبرك عندما نصدر المزيد من المقالات الموجزة مثل هذه.

مقالات ذات صلة

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون السيارات / المركبات الكهربائية ، كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- BlockOffsets. تحديث ملكية الأوفست البيئية. الوصول هنا.

- المصدر https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- :لديها

- :يكون

- :ليس

- :أين

- $ UP

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- القدرة

- ماهرون

- من نحن

- فوق

- مطلق

- أكاديمي

- استمر

- يقبل

- الوصول

- يمكن الوصول

- استيعاب

- وفقا

- دقة

- دقيق

- تحقق

- يحقق

- تحقيق

- نقر

- في

- تفعيل

- التنشيط

- الأفعال

- تكيف

- تكيف

- تضيف

- مضيفا

- إضافة

- إضافي

- العنوان

- عناوين

- اعتماد

- التطورات

- نصيحة

- بعد

- ضد

- الوكيل

- AI

- منظمة العفو الدولية البحوث

- وتهدف

- AL

- سواء

- الكل

- السماح

- السماح

- يسمح

- على طول

- أيضا

- البديل

- بالرغم ان

- دائما

- وسط

- من بين

- كمية

- المبالغ

- an

- تحليل

- تحليلية

- و

- آخر

- إجابة

- أي وقت

- API

- تظهر

- التطبيقات

- التقديم

- نهج

- مناسب

- ما يقرب من

- معماري

- هندسة معمارية

- هي

- المناطق

- حول

- مجموعة

- فنـون

- البند

- مقالات

- مصطنع

- الذكاء الاصطناعي

- AS

- مساعدة

- مساعدين

- أسوشيتد

- جمعيات

- At

- اهتمام

- الكتاب

- أتمتة

- متاح

- المتوسط

- تجنب

- جائزة

- الرصيد

- شريط

- قاعدة

- على أساس

- الأساسية

- أساس

- BE

- لان

- أصبح

- قبل

- يجري

- أقل من

- مؤشر

- المعايير

- الفوائد

- أفضل

- ما بين

- انحياز

- التحيزات

- مليار

- كُتُب

- التمهيد

- على حد سواء

- الحدود

- اختراق

- اختراقات

- BRIDGE

- واسع

- نساعدك في بناء

- ابني

- بنيت

- لكن

- by

- تسمى

- CAN

- مرشح

- لا تستطيع

- قدرات

- قادر على

- الطاقة الإنتاجية

- حذر

- حقيبة

- كارثية

- سبب

- الرئيس التنفيذي

- الرئيس التنفيذي ومؤسس

- تحدي

- فرصة

- تغيير

- chatbots

- شات جي بي تي

- شيبس

- مطالبة

- تصنيف

- سحابة

- المؤسس المشارك

- الكود

- متماسك

- مجموعة شتاء XNUMX

- مجموعة

- تركيبات

- تأتي

- التزام

- Communication

- مجتمع

- مقارنة

- متوافق

- تنافسي

- مكمل

- مجمع

- الالتزام

- مكونات

- حساب

- إحصاء

- الكمبيوتر

- الحوسبة

- المفاهيمي

- اهتمامات

- الاعداد

- تم تأكيد

- الرابط

- بناء على ذلك

- الاعتبارات

- إنشاء

- محتوى

- سياق الكلام

- السياقات

- استمر

- تباين

- محادثة

- المحادثات

- تحويل

- تصحيح

- المقابلة

- التكلفة

- التكاليف

- استطاع

- خلق

- خلق

- الإبداع

- معقول

- حاسم

- حالياًّ

- زبون

- خدمة العملاء

- دعم العملاء

- المتطور والحديث

- يوميا

- البيانات

- نقاط البيانات

- قواعد البيانات

- التاريخ

- قررت

- تخفيض

- عميق

- العقل العميق

- يسلم

- شرح

- تظاهر

- يوضح

- التظاهر

- ديموس

- اعتمادا

- نشر

- تصميم

- على الرغم من

- تفاصيل

- تطوير

- المطورين

- تطوير

- التطوير التجاري

- حوار

- حوار

- صعبة

- الإعاقة

- كشف

- تمييز

- تميز

- عدة

- do

- وثيقة

- وثائق

- هل

- هيمنة

- لا

- دزينة

- قيادة

- يطلق عليها اسم

- اثنان

- أثناء

- e

- التجارة الإلكترونية

- E & T

- كل

- في وقت مبكر

- أسهل

- تربوي

- تأثير

- على نحو فعال

- كفاءة

- فعال

- جهود

- اقصاء

- ظهرت

- تمكين

- تمكين

- يشمل

- جذاب

- انجليزي

- تعزيز

- تعزيز

- التحسينات

- تعزيز

- ضمان

- أساسي

- إنشاء

- يؤسس

- أخلاقي

- تقييم

- تقييم

- التقييمات

- حتى

- كل

- كل شىء

- دليل

- المتطورة

- فحص

- مثال

- أمثلة

- يتجاوز

- استثنائي

- المثيره

- على وجه الحصر

- المعارض

- القائمة

- وسع

- تجارب

- خبرة

- استكشاف

- خارجي

- f1

- تسهيل

- العوامل

- فال

- للعائلات

- بعيدا

- ساحر

- خطى سريعة

- الميزات

- عقار مميز

- المميزات

- ردود الفعل

- قليل

- أقل

- حقل

- الشكل

- تصفية

- الاسم الأول

- حل

- ثابت

- اتباع

- متابعيك

- في حالة

- أشكال

- أسس

- مؤسس

- الإطار

- تبدأ من

- مجمد

- وظيفة

- أساسي

- في الأساس

- إضافي

- مستقبل

- اكتسبت

- فجوة

- الجنس

- توليد

- ولدت

- يولد

- توليد

- جيل

- توليدي

- الذكاء الاصطناعي التوليدي

- مولد كهربائي

- دولار فقط واحصل على خصم XNUMX% على جميع

- GitHub جيثب:

- لمحة

- العالمية

- Go

- هدف

- الذهاب

- خير

- شراء مراجعات جوجل

- جوجل

- حكومة

- وحدات معالجة الرسومات

- درجة

- الرائد

- تجمع

- كان

- يحدث

- الثابت

- أجهزة التبخير

- الضارة

- يملك

- وجود

- الرعاية الصحية

- هنا

- عالي الجودة

- عالية الدقة

- مخاطرة عالية

- أعلى

- أعلى

- يحمل

- كيفية

- لكن

- HTML

- HTTPS

- ضخم

- الانسان

- مئات

- الضجيج

- ضبط Hyperparameter

- فكرة

- تحديد

- if

- صورة

- صور

- هائلة

- التنفيذ

- نفذت

- آثار

- أهمية

- مثير للإعجاب

- تحسن

- تحسن

- تحسين

- تحسينات

- in

- في العمق

- عجز

- تتضمن

- شامل

- بما فيه

- الاشتقاق

- يدمج

- دمج

- القيمة الاسمية

- زيادة

- في ازدياد

- على نحو متزايد

- فرد

- الأفراد

- الصناعات

- العالمية

- معلومات

- البنية التحتية

- يبادر

- الابتكار

- إدخال

- المدخلات

- بدلًا من ذلك

- المؤسسات

- تعليمات

- دمج

- رؤيتنا

- نية

- وكتابة مواضيع مثيرة للاهتمام

- إلى

- تقديم

- أدخلت

- اخترع

- قضية

- مسائل

- IT

- انها

- نفسها

- صحافة

- JPG

- م

- القفل

- الأهداف الرئيسية

- علم

- المعرفة

- مختبرات

- نقص

- المشهد

- لغة

- اللغات

- كبير

- على نطاق واسع

- أكبر

- آخر

- طبقة

- طبقات

- قيادة

- تعلم

- تعلم

- شروط وأحكام

- أقل

- مستوى

- ومستوياتها

- الرافعة المالية

- روافع

- الاستفادة من

- مرخص

- الحياة

- خفيفة الوزن

- مثل

- على الأرجح

- القيود

- قائمة

- قوائم

- حياة

- اللاما نوع من الجمال

- محليا

- منطقي

- طويل

- بحث

- الكثير

- منخفض

- الآلات

- صنع

- جعل

- يصنع

- كثير

- ماركوس

- تجارة

- أبحاث السوق

- التسويق

- مادة

- الرياضيات

- ماكس العرض

- أقصى

- مايو..

- ذات مغزى

- الوسائط

- طبي

- دمج

- مييتااا

- آلية العمل

- طرق

- مایکروسافت

- مانع

- أدنى

- معلومات خاطئة

- مضلل

- الأخطاء

- مختلط

- ML

- نموذج

- عارضات ازياء

- تقدم

- تم التعديل

- مراقبة

- الأكثر من ذلك

- أكثر

- كثيرا

- متعدد

- المسلمون

- طبيعي

- اللغة الطبيعية

- معالجة اللغات الطبيعية

- الطبيعة

- حاجة

- بحاجة

- شبكة

- عصبي

- اللغة العصبية

- الشبكة العصبية

- جديد

- أخبار

- التالي

- رحلة جميلة

- البرمجة اللغوية العصبية

- لا سيما

- لا شى

- عدد

- كثير

- موضوعي

- أهداف

- حدث

- of

- هجومي

- رسمي

- غالبا

- on

- ONE

- منها

- فقط

- جاكيت

- المصدر المفتوح

- OpenAI

- طريقة التوسع

- عمليات

- التحسين

- or

- منظمة

- أخرى

- أخرى

- لنا

- خارج

- التفوق على

- يتفوق

- الناتج

- معلقة

- على مدى

- الخاصة

- كف

- ورق

- نموذج

- المعلمة

- المعلمات

- جزء

- شارك

- خاصة

- pass

- أنماط

- تدمير

- رصف

- إلى

- نفذ

- أداء

- أداء

- ينفذ

- عبارات

- اختيار

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- القرون

- البوينت

- نقاط

- سياسات الخصوصية والبيع

- ممكن

- محتمل

- مدعوم

- قوي

- تنبأ

- المفضل

- سابق

- في المقام الأول

- قبل

- ترتيب الاولويات

- المشكلة

- مشاكل

- عملية المعالجة

- العمليات

- معالجة

- إنتاج

- المنتج

- إنتاجية

- محترف

- برمجة وتطوير

- لغات البرمجة

- التقدّم

- واعد

- HAS

- يقترح

- الملكية

- البروتوكولات

- تزود

- المقدمة

- ويوفر

- علانية

- نشرت

- أغراض

- دفع

- بايثون

- pytorch

- نوعي

- جودة

- سؤال

- الأسئلة المتكررة

- بسرعة

- سباق

- نطاق

- بسرعة

- بدلا

- نادي القراءة

- حقيقي

- الحياه الحقيقيه

- العالم الحقيقي

- الأخيرة

- مؤخرا

- اعتراف

- الاعتراف

- تخفيض

- تقليص

- الأنظمة

- تعزيز التعلم

- الافراج عن

- صدر

- ذات الصلة

- الخدمة الموثوقة

- مصادر موثوقة

- دين

- الاعتماد

- لا تزال

- بقي

- لافت للنظر

- استبدال

- التقارير

- التمثيل

- طلبات

- تطلب

- يتطلب

- بحث

- مجتمع الأبحاث

- الباحثين

- موارد كثيفة

- احترام

- الاستجابة

- استجابة

- ردود

- مقيد

- نتيجة

- النتائج

- يحتفظ

- التعليقات

- ثور

- ثورة

- المخاطر

- منافسة

- قوي

- الأدوار

- غرفة

- خزنة

- السلامة

- SALESFORCE

- نفسه

- حجم

- النطاقات

- التحجيم

- سيناريوهات

- مشاهد

- المدرسة

- أحرز هدفاً

- عشرات

- النقاط

- بسلاسة

- الثاني

- بدا

- رأيت

- مختار

- حساس

- مستقل

- مسلسلات

- جدي

- الخدمة

- خدماتنا

- طقم

- ضبط

- عدة

- صدمت

- قصير

- إظهار

- أظهرت

- يظهر

- إشارة

- هام

- بشكل ملحوظ

- وبالمثل

- صيغة المفرد

- حالات

- المقاس

- مهارات

- الأصغر

- So

- حتى الآن

- العدالة

- وسائل التواصل الاجتماعي

- جاليات

- تطبيقات الكمبيوتر

- تطوير البرمجيات

- فقط

- حل

- يحل

- بعض

- متطور

- مصدر

- مصادر

- مصادر

- البريد المزعج

- محدد

- على وجه التحديد

- النوعية

- مذهل

- الكلام إلى نص

- سرعة

- استقرار

- المسرح

- مراحل

- معيار

- المعايير

- الولايه او المحافظه

- دولة من بين الفن

- إحصائي

- إحصائيات

- لا يزال

- الإستراتيجيات

- نقاط القوة

- ضرب

- دراسة

- جوهري

- النجاح

- هذه

- اقترح

- وتقترح

- ملخص

- أعلى

- إشراف

- الدعم

- تجاوز

- نظام

- أنظمة

- محادثات

- مهمة

- المهام

- فريق

- تقني

- تقنيات

- التكنولوجيا

- سياسة الحجب وتقييد الوصول

- تجربه بالعربي

- توليد النص

- النص إلى كلام

- من

- شكر

- أن

- •

- المستقبل

- الدولة

- العالم

- من مشاركة

- منهم

- then

- هناك.

- وبالتالي

- وبالتالي

- تشبه

- هم

- اعتقد

- طرف ثالث

- هؤلاء

- على الرغم من؟

- الآلاف

- ثلاثة

- عبر

- مرات

- إلى

- اليوم

- سويا

- رمز

- Tokenization

- الرموز

- جدا

- أدوات

- تيشرت

- توب بوتس

- موضوع

- المواضيع

- نحو

- تقليدي

- قطار

- متدرب

- قادة الإيمان

- تحويل

- محول

- تحويل

- خدمات ترجمة

- تريليون

- تورينج

- الدروس الخصوصية

- اثنان

- دون شروط

- مع

- فهم

- فهم

- تعهد

- مما لا شك فيه

- لسوء الحظ

- الكون

- مختلف

- حديث جديد

- آخر التحديثات

- تستخدم

- مستعمل

- مستخدم

- يستخدم

- استخدام

- يستخدم

- تشكيلة

- مختلف

- كبير

- متعدد الجوانب

- جدا

- فيديو

- مقاطع فيديو

- افتراضي

- رؤيتنا

- VOX

- وكان

- طريق..

- we

- الويب

- حسن

- كان

- ابحث عن

- متى

- التي

- في حين

- من الذى

- كامل

- واسع

- مدى واسع

- ويكيبيديا

- سوف

- مع

- في غضون

- بدون

- كلمات

- للعمل

- العمل معا

- العالم

- جاري الكتابة

- سنوات

- حتى الآن

- لصحتك!

- زفيرنت

- التعلم بدون طلقة