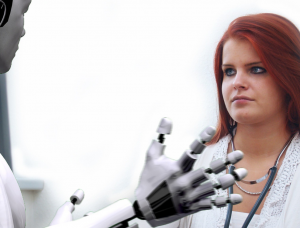

人工智能 (AI) 彻底改变了各个行业,带来了众多好处和机遇。然而,人们开始担心人工智能可能会延续歧视和偏见。本文探讨了人工智能歧视的主题,揭示了识别和解决人工智能系统中嵌入的偏见所面临的挑战。业内人士对人工智能的道德和伦理影响表示怀疑,理由是担心错误信息、算法偏见以及误导性内容的产生。随着围绕人工智能的争论愈演愈烈,人们越来越呼吁进行有意义的监管,以确保透明度、问责制和基本权利的保护。

人工智能给金融业带来的挑战

FIS Worldpay 加密和 Web3 负责人 Nabil Manji 表示,AI 产品的有效性在很大程度上取决于用于培训的源材料的质量。 Manji 在接受 CNBC 采访时解释说,影响人工智能性能的两个主要因素是:它可以访问的数据和大型语言模型的功能。

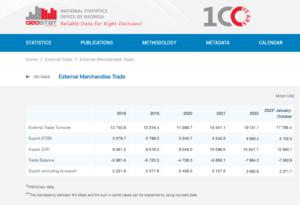

为了说明数据的重要性,Manji 提到像 Reddit 这样的公司已经公开宣布限制数据抓取,要求付费才能访问。在金融服务领域,他强调了各种语言和格式的碎片化数据系统所面临的挑战。缺乏整合和协调限制了人工智能驱动产品的有效性,特别是与拥有标准化和现代化数据基础设施的行业相比。

Manji 认为,区块链或分布式账本技术的利用可能为解决这一问题提供潜在的解决方案。这种创新方法可以提高传统银行复杂系统中存储的碎片数据的透明度。然而,他承认,银行的高度监管和行动缓慢的性质可能会阻碍他们迅速采用新人工智能工具的能力,这与微软和谷歌等更灵活的科技公司不同,这些公司在过去几年一直处于推动创新的最前沿。几十年。

考虑到这些因素,由于数据集成的复杂性和银行业的固有性质,金融业在利用人工智能方面面临着独特的挑战。

Twitter 机器学习道德、透明度和问责制前负责人鲁曼·乔杜里 (Rumman Chowdhury) 表示,贷款是人工智能系统中的偏见如何对边缘化社区产生不利影响的一个显着例子。乔杜里在阿姆斯特丹的一次小组讨论中发表讲话,强调了 1930 世纪 XNUMX 年代芝加哥“划红线”的历史实践。红线涉及根据种族人口统计数据拒绝向以非裔美国人为主的社区提供贷款。

乔杜里解释说,尽管现代算法可能没有明确地将种族作为数据点,但偏见仍然可以隐式编码。在开发算法来评估地区和个人的贷款风险时,包含偏见的历史数据可能会无意中延续歧视。

安格尔·布什 (Angle Bush) 是人工智能领域黑人女性的远见卓识者,他强调了在使用人工智能系统做出贷款审批决定时,承认历史数据中再现偏见所带来的危险的重要性。这种做法可能会导致边缘化社区的贷款申请被自动拒绝,从而使种族或性别不平等永久化。

经验丰富的人工智能开发人员Frost Li指出了个性化的挑战 人工智能集成。选择“核心特征”来训练人工智能模型有时可能会涉及不相关的因素,从而可能导致有偏差的结果。李举了一个例子,说明针对外国人的金融科技初创公司可能会面临与当地银行不同的信用评估标准,因为当地银行更熟悉当地学校和社区。

Taktile 是一家专门从事金融科技自动化决策的初创公司,其首席运营官尼克拉斯·古斯克 (Niklas Guske) 澄清说,生成式人工智能通常不用于创建消费者的信用评分或风险评分。相反,它的优势在于对文本文件等非结构化数据进行预处理,以提高传统承保模型的数据质量。

总之,人工智能在贷款和金融服务中的使用引起了人们对偏见和歧视的担忧。数据中嵌入的历史偏差以及人工智能训练过程中不相关特征的选择可能会导致不公平的结果。对于银行和金融机构来说,认识并解决这些问题至关重要,以防止在实施人工智能解决方案时无意中出现歧视现象。

人工智能歧视的证明

正如涉及苹果和高盛的案例所强调的那样,证明基于人工智能的歧视可能具有挑战性。纽约州金融服务部驳回了对女性 Apple Card 实行较低限额的指控,理由是缺乏确凿的证据。

欧洲反种族主义网络主任金·斯穆特指出,人工智能的大规模部署带来了决策过程的不透明,使个人难以识别和解决歧视问题。

斯穆特解释说,个人通常对人工智能系统如何运作了解有限,因此很难发现歧视或系统性偏见的情况。当歧视是影响多个人的更广泛问题的一部分时,情况就会变得更加复杂。斯穆特提到了荷兰儿童福利丑闻,由于制度偏见,大量福利索赔被错误地标记为欺诈。发现此类功能障碍具有挑战性,获得补救可能既困难又耗时,从而导致重大且有时是不可逆转的伤害。

这些例子说明了证实基于人工智能的歧视以及在发生此类歧视时获得补救措施的固有困难。人工智能系统的复杂性和决策过程缺乏透明度可能使个人难以有效识别和解决歧视情况。

乔杜里表示,迫切需要一个类似于联合国的全球监管机构来应对人工智能相关的风险。尽管人工智能表现出了显着的创新,但技术专家和伦理学家对其道德和伦理影响提出了担忧。这些担忧包括错误信息、人工智能算法中嵌入的种族和性别偏见以及 ChatGPT 等工具生成误导性内容等问题。

乔杜里对进入后真相世界表示担忧,在这个世界中,包括文本、视频和音频在内的在线信息由于生成人工智能而变得不可信。这就提出了我们如何确保信息的完整性以及如何依靠它来做出明智决策的问题。以欧盟《人工智能法案》为例,目前对人工智能进行有意义的监管至关重要。然而,人们担心监管提案生效需要很长的时间,这可能会延迟必要的行动。

Smouter 强调人工智能算法需要更高的透明度和问责制。这包括使算法更容易为非专家所理解,进行测试和发布结果,建立独立的投诉流程,进行定期审计和报告,以及让种族社区参与技术的设计和部署。 《人工智能法》从基本权利的角度出发,并引入了补救等概念,预计将在大约两年内开始执行。缩短这一时间表将有利于维护透明度和问责制作为创新的组成部分。

- SEO 支持的内容和 PR 分发。 今天得到放大。

- PlatoData.Network 垂直生成人工智能。 赋予自己力量。 访问这里。

- 柏拉图爱流。 Web3 智能。 知识放大。 访问这里。

- 柏拉图ESG。 汽车/电动汽车, 碳, 清洁科技, 能源, 环境, 太阳能, 废物管理。 访问这里。

- 块偏移量。 现代化环境抵消所有权。 访问这里。

- Sumber: https://www.forexnewsnow.com/fintech/the-urgency-of-addressing-ai-discrimination-transparency-accountability-and-regulatory-timelines/

- :具有

- :是

- :不是

- :在哪里

- a

- 对,能力--

- 关于

- ACCESS

- 问责制

- 承认

- 法案

- 行动

- 地址

- 解决

- 采用

- 有利

- 不利

- 影响

- 非洲人

- 驳

- 敏捷

- AI

- 人工智能法

- 人工智能系统

- 人工智能培训

- 算法

- 指控

- 尽管

- 美国人

- 阿姆斯特丹

- an

- 和

- 预期

- Apple

- Apple Card

- 应用领域

- 的途径

- 批准

- 约

- 保健

- 刊文

- 人造的

- 人工智能

- AS

- 方面

- 评估

- 评定

- 相关

- At

- 音频

- 审计

- 自动表

- 自动化

- 银行业

- 银行业

- 银行

- 基于

- BE

- 成为

- 成为

- 很

- 背后

- 得益

- 好处

- 偏见

- 偏

- 偏见

- 黑色

- blockchain

- 身体

- 带来

- 更广泛

- by

- 呼叫

- CAN

- 能力

- 卡

- 案件

- 挑战

- 挑战

- 挑战

- ChatGPT

- 芝加哥

- 孩子

- 索赔

- 澄清

- CNBC

- 地区

- 公司

- 相比

- 抱怨

- 复杂

- 复杂性

- 复杂

- 概念

- 关注

- 开展

- 合并

- 消费者

- 包含

- 内容

- 相反

- 贡献

- 常规

- 鸪鸪声

- 创造

- 信用

- 标准

- 关键

- 加密

- 危险

- data

- 数据基础设施

- 数据集成

- 数据质量

- 辩论

- 几十年

- 决策

- 决定

- 人口统计

- 问题类型

- 依靠

- 部署

- 设计

- 开发商

- 发展

- 不同

- 难

- 困难

- 副总经理

- 发现

- XNUMX歧視

- 讨论

- 分布

- 分布式帐簿

- 分布式分类帐技术

- 驾驶

- 两

- ,我们将参加

- 荷兰人

- 有效

- 只

- 效用

- 嵌入式

- 出现

- 强调

- 环绕

- 强制

- 提高

- 增强

- 确保

- 进入

- 特别

- 建立

- 伦理

- 伦理

- 欧洲

- 甚至

- 证据

- 明显

- 例子

- 例子

- 有经验

- 解释

- 介绍

- 探讨

- 特快

- 面部彩妆

- 面孔

- 因素

- 熟悉

- 特征

- 少数

- 档

- 金融

- 金融业

- 金融机构

- 金融服务

- fintech

- 金融科技初创企业

- fintechs

- FIS

- 针对

- 第一线

- 前

- 支离破碎

- 欺诈

- 止

- 根本

- 性别

- 代

- 生成的

- 生成式人工智能

- 全球

- 高盛

- 高盛

- 谷歌

- 更大的

- 成长

- 伤害

- 有

- he

- 头

- 严重

- 突出

- 高度

- 历史的

- 创新中心

- 但是

- HTTPS

- 鉴定

- 确定

- 实施

- 启示

- 重要性

- 威风

- in

- 包括

- 包括

- 包含

- 独立

- 个人

- 行业

- 行业中的应用:

- 不平等

- 信息

- 通知

- 基础设施

- 固有

- 創新

- 创新

- 机构

- 机构

- 积分

- 积分

- 诚信

- 房源搜索

- 专属采访

- 成

- 推出

- 涉及

- 参与

- 涉及

- 问题

- 问题

- IT

- 它的

- 知识

- 缺乏

- 语言

- 语言

- 大

- 铅

- 领导

- 学习

- 莱杰

- 贷款

- 借力

- li

- 谎言

- 光

- 喜欢

- 有限

- 范围

- 贷款

- 贷款

- 本地

- 当地银行

- 降低

- 机

- 机器学习

- 主要

- 使

- 制作

- 质量

- 材料

- 可能..

- 有意义的

- 提到

- 微软

- 可能

- 误传

- 误导

- 模型

- 模型

- 现代

- 时刻

- 道德

- 更多

- 多

- 联合国

- 自然

- 必要

- 需求

- 网络

- 全新

- 纽约

- 纽约州

- 纽约州金融服务部

- 非专家

- 显着

- 数

- 众多

- EB-XNUMX签证项目的众多好处。

- 获得

- of

- 提供

- 提供

- 经常

- on

- 在线

- 操作

- 机会

- or

- 输出

- 结果

- 面板

- 小组讨论

- 部分

- 过去

- 付款

- 性能

- 定期

- 个性化

- 透视

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 点

- 点

- 潜力

- 可能

- 在练习上

- 主要

- 紧迫

- 防止

- 市场问题

- 过程

- 核心产品

- 建议

- 保护

- 提供

- 提供

- 公然

- 出版

- 目的

- 质量

- 有疑问吗?

- 种族

- 种族主义

- 凸

- 提高

- 承认

- 减少

- 引用

- 关于

- 监管

- 税法法规

- 监管

- 依靠

- 卓越

- 报告

- 限制

- 成果

- 革命性

- 权利

- 风险

- 风险

- 高盛

- 丑闻

- 学区情况

- 分数

- 得分

- 刮

- 扇形

- 选择

- 选择

- 特色服务

- 如图

- 意义

- 显著

- 类似

- 方案,

- 解决方案

- 来源

- 发言

- 专业

- 启动

- 初创企业

- 州/领地

- 国务院

- 仍

- 存储

- 实力

- 这样

- 概要

- 周围

- 如飞

- 系统的

- 产品

- 滑车

- 需要

- 瞄准

- 科技

- 高科技公司

- 技术专家

- 专业技术

- 测试

- 这

- 其

- 那里。

- 从而

- 博曼

- Free Introduction

- 耗时的

- 时间表

- 时间表

- 至

- 工具

- 主题

- 产品培训

- 用户评论透明

- 二

- 一般

- 可理解的

- 保险业

- 不公平

- 独特

- 联合的

- 联合国

- 不像

- 坚持

- 急

- 使用

- 用过的

- 各个

- 视频

- 有远见的

- we

- Web3

- 福利

- 为

- ,尤其是

- 这

- 而

- 中

- 女性

- 世界

- WorldPay的

- 担心

- 将

- 年

- 纽约

- 和风网