安全专家警告说,随着人工智能 (AI) 创新的不断快速发展,2024 年将是组织和管理机构制定安全标准、协议和其他护栏以防止人工智能领先的关键时刻。

大型语言模型 (LLM) 由复杂的算法和海量数据集提供支持,展现出卓越的语言理解能力和类人对话能力。迄今为止,这些平台中最复杂的平台之一是 OpenAI 的 GPT-4,它拥有先进的推理和解决问题的能力,并为该公司的 ChatGPT 机器人提供动力。该公司与微软合作,已经开始开发 GPT-5,首席执行官 Sam Altman 表示 会走得更远 ——达到拥有“超级智能”的程度。

这些模型代表了组织显着提高生产力和效率的巨大潜力,但专家们一致认为,对于整个行业来说,时机已经到来 解决固有的安全风险 由它们的开发和部署构成。的确, Writerbuddy AI 的最新研究提供基于人工智能的内容编写工具的ChatGPT 发现,ChatGPT 的访问量已经达到 14 亿次,并且还在不断增加。

基于人工智能的隐私和安全公司 MineOS 的首席执行官 Gal Ringel 表示,随着组织在人工智能方面取得进展,“应该结合严格的道德考虑和风险评估”。

人工智能是一种生存威胁吗?

对下一代人工智能安全性的担忧从 34,000 月份开始蔓延,近 XNUMX 名顶尖技术专家签署了一封公开信,呼吁停止开发比人工智能更强大的生成式人工智能系统。 OpenAI的GPT-4。信中提到了该技术对社会带来的“深远风险”,以及“人工智能实验室失控的竞赛,旨在开发和部署更强大的数字思维,没有人——甚至是它们的创造者——能够理解、预测或可靠控制。”

尽管存在这些反乌托邦的恐惧,大多数安全专家并不担心机器变得比人类更聪明并接管世界的世界末日场景。

网络安全公司 Netrix 销售工程总监马特·威尔逊 (Matt Wilson) 表示:“这封公开信从广泛意义上指出了对人工智能快速发展和潜在应用的担忧,‘这对人类有好处吗?’” “虽然在某些情况下令人印象深刻,但公共版本的人工智能工具似乎并没有那么具有威胁性。”

研究人员指出,令人担忧的是,人工智能的进步和采用速度太快,以至于无法妥善管理风险。人工智能安全提供商 SlashNext 的首席执行官帕特里克·哈尔 (Patrick Harr) 表示:“我们无法重新盖上潘多拉魔盒的盖子。”

此外,人工智能安全公司 DarkTrace Federal 首席执行官马库斯·福勒 (Marcus Fowler) 表示,仅仅“试图阻止该领域的创新速度无助于减轻”其带来的风险,必须单独解决这些风险。他说,这并不意味着人工智能的发展应该继续不受限制。相反,风险评估和实施适当保障措施的速度应与法学硕士的培训和发展速度相匹配。

“人工智能技术正在快速发展,因此政府和使用人工智能的组织也必须加快围绕人工智能安全的讨论,”福勒解释道。

生成式人工智能风险

生成式人工智能有几个被广泛认可的风险,需要考虑,而且随着下一代技术变得更加智能,这些风险只会变得更糟。对于人类来说幸运的是,到目前为止,它们都没有提出人工智能密谋摧毁其创造者的科幻世界末日场景。

相反,它们包括更为常见的威胁,例如数据泄露,可能涉及业务敏感信息;滥用进行恶意活动;不准确的输出可能会误导或迷惑用户,最终导致负面的业务后果。

由于法学硕士需要访问大量数据才能提供准确且与上下文相关的输出,因此敏感信息可能会无意中泄露或被滥用。

“主要的风险是员工喂养它 包含商业敏感信息 当要求它编写计划或重新措辞包含公司专有信息的电子邮件或业务平台时,”林格尔指出。

从网络攻击的角度来看,威胁行为者已经找到了多种方法来武器化 ChatGPT 和其他人工智能系统。一种方法是使用这些模型来创建复杂的商业电子邮件泄露 (BEC) 和其他网络钓鱼攻击,这需要创建旨在成功的社会工程、个性化消息。

“对于恶意软件,ChatGPT 使网络犯罪分子能够进行无限的代码变体,以领先恶意软件检测引擎一步,”Harr 说。

AI 幻觉还构成重大安全威胁,并允许恶意行为者以独特的方式武装 ChatGPT 等基于 LLM 的技术。人工智能幻觉是人工智能做出的一种看似合理的反应,但这种反应是不充分的、有偏见的或完全不真实的。 Gartner 副总裁阿维瓦·利坦 (Avivah Litan) 警告说:“虚构的或其他不需要的响应可能会引导组织做出错误的决策、流程和误导性的沟通。”

数据安全提供商 Securiti 的人工智能副总裁 Michael Rinehart 表示,威胁行为者还可以利用这些幻觉来毒害法学硕士,并“生成特定的错误信息来回答问题”。 “这可以扩展到易受攻击的源代码生成,并且可能扩展到能够引导网站用户进行不安全操作的聊天模型。”

攻击者甚至可以 发布恶意版本的软件包 法学硕士可能会向软件开发人员推荐,认为这是对问题的合法解决方案。通过这种方式,攻击者可以进一步将人工智能武器化以发动供应链攻击。

前进的道路

专家指出,在人工智能创新超出行业控制能力之前,管理这些风险需要采取谨慎的集体行动。但他们也有关于如何解决人工智能问题的想法。

哈尔相信“与A对抗AI”战略,其中“安全解决方案的进步和阻止人工智能引发的风险的战略必须以同等或更快的速度发展。

“网络安全保护需要利用人工智能来成功地利用人工智能技术对抗网络威胁,”他补充道。 “相比之下,传统安全技术没有机会抵御这些攻击。”

然而,组织还应该采取谨慎的方法来采用人工智能——包括 基于人工智能的安全解决方案 ——Netrix 的 Wilson 警告说,以免给环境带来更多风险。

“了解人工智能是什么,不是什么,”他建议道。 “挑战那些声称使用人工智能来描述它的作用、它如何增强他们的解决方案以及为什么这对您的组织很重要的供应商。”

Securiti 的 Rinehart 提供了一种两层方法,通过部署有针对性的解决方案,然后在使组织面临不必要的风险之前立即设置护栏,将人工智能逐步引入环境。

“首先采用特定于应用程序的模型,可能会通过知识库进行增强,这些模型是为在特定用例中提供价值而量身定制的,”他说。 “然后……实施一个监控系统,通过检查往返于模型的消息是否存在隐私和安全问题来保护这些模型。”

专家还建议在部署人工智能之前制定围绕人工智能的安全政策和程序,而不是事后才考虑,以降低风险。他们甚至可以设立专门的人工智能风险官或工作组来监督合规性。

在企业之外,整个行业还必须采取措施围绕人工智能建立安全标准和实践,让每个开发和使用该技术的人都可以采用——这需要全球范围内公共和私营部门的集体行动,DarkTrace Federal 的福勒说。

他引用了 构建安全人工智能系统的指南 由美国网络安全和基础设施安全局(CISA)和英国国家网络安全中心(NCSC)合作发布,作为人工智能持续发展应采取的努力的一个例子。

Securiti 的 Rinehart 表示:“从本质上讲,2024 年将见证传统安全和尖端人工智能技术的快速适应,以在新兴的生成式人工智能时代保护用户和数据。”

- :具有

- :是

- :不是

- $UP

- 000

- 14

- 2024

- a

- 对,能力--

- 关于

- 加快

- ACCESS

- 陪

- 精准的

- 操作

- 行动

- 活动

- 演员

- 适应

- 地址

- 解决

- 添加

- 采用

- 采用

- 采用

- 高级

- 进步

- 进步

- 驳

- 机构

- 向前

- AI

- 人工智能系统

- 算法

- 所有类型

- 让

- 已经

- 还

- 量

- an

- 和

- 和基础设施

- 出现

- 应用领域

- 的途径

- 适当

- 保健

- ARM

- 围绕

- 人造的

- 人工智能

- 人工智能(AI)

- AS

- 问

- 评定

- 评估

- At

- 攻击

- 尝试

- 增强

- 背部

- 战斗

- BE

- BEC

- 成为

- 很

- before

- 作为

- 相信

- 相信

- 偏

- 亿

- 拥有

- 机构

- 博特

- 都

- 盒子

- 广阔

- 建筑物

- 商业

- 商业电子邮件泄露

- 但是

- by

- 被称为

- CAN

- 不能

- 能力

- 能力

- 例

- 注意事项

- 中心

- CEO

- 一定

- 链

- 挑战

- 机会

- 即时通话

- ChatGPT

- CISA

- 引

- 要求

- 码

- 集体

- 集体行动

- 如何

- 通信

- 公司

- 对照

- 符合

- 妥协

- 关心

- 关于

- 关注

- 后果

- 考虑

- 注意事项

- 继续

- 持续

- 继续

- 相反

- 控制

- 听起来像对话

- 计数

- 再加

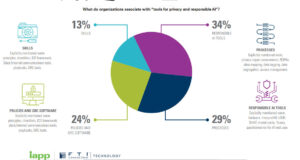

- 创建信息图

- 创建

- 创作者

- 关键

- 前沿

- 网络

- 网络安全

- 网络攻击

- 网络罪犯

- 网络安全

- 网络安全和基础设施安全局

- data

- 数据安全

- 数据集

- 日期

- 决策

- 专用

- 需求

- 演示

- 部署

- 部署

- 部署

- 部署

- 描述

- 设计

- 摧毁

- 检测

- 开发

- 发达

- 开发商

- 发展

- 研发支持

- 数字

- 导演

- 副总经理

- 讨论

- 不

- 不会

- 不

- 末日

- 反乌托邦

- 效率

- 工作的影响。

- 邮箱地址

- 电子邮件

- 新兴经济体的新市场。

- 员工

- 使

- 设计

- 工程师

- 引擎

- 增强

- 巨大

- 企业

- 环境

- 等于

- 时代

- 本质

- 建立

- 醚(ETH)

- 伦理

- 甚至

- EVER

- 每个人

- 进化

- 演变

- 例子

- 存在

- 期望

- 专家

- 介绍

- 事实

- 熟悉

- 远

- 故障

- 恐惧

- 联邦

- 喂养

- 虚构

- 公司

- 姓氏:

- 固定

- 一气呵成

- 重点

- 针对

- 力

- 幸好

- 发现

- 止

- FT

- 推动

- 进一步

- 未来

- 收益

- GAL

- Gartner公司

- 生成

- 代

- 代

- 生成的

- 生成式人工智能

- 得到

- 越来越

- 全球

- 世界规模

- Go

- 非常好

- 治理

- 各国政府

- 更大的

- 民政事务总署

- 有

- he

- 帮助

- 创新中心

- How To

- HTTPS

- 人类

- 人类

- 思路

- 立即

- 实施

- 实施

- 有声有色

- in

- 不准确

- 不经意间

- 包括

- 包含

- 行业中的应用:

- info

- 信息

- 基础设施

- 固有

- 創新

- 房源搜索

- 成

- 介绍

- ISN

- 问题

- IT

- 它的

- JPG

- 知识

- 实验室

- 语言

- 泄漏

- 遗产

- 合法

- 邮件

- 杠杆作用

- 喜欢

- 机

- 主要

- 使

- 恶意

- 恶意软件

- 恶意软件检测

- 管理

- 三月

- 马库斯

- 大规模

- 匹配

- Matt

- 事项

- 意味着

- 测量

- 仅仅

- 条未读消息

- Michael (中国)

- 微软

- 可能

- 头脑

- 误传

- 误导

- 滥用

- 减轻

- 模型

- 监控

- 更多

- 最先进的

- 安装

- 移动

- 许多

- 必须

- 无数的

- National

- NCSC

- 几乎

- 需要

- 负

- 下页

- 没有

- 不包含

- 注意

- 注意到

- 观察

- of

- 优惠精选

- 官

- on

- 一

- 仅由

- 打开

- OpenAI

- or

- 组织

- 组织

- 其他名称

- 输出

- 超过

- 监视

- 步伐

- Pandora

- 合作伙伴

- 帕特里克

- 个性化你的

- 透视

- 钓鱼

- 网络钓鱼攻击

- 地方

- 计划

- 平台

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 点

- 毒药

- 政策

- 构成

- 构成

- 或者

- 潜力

- 可能

- 供电

- 强大

- 权力

- 做法

- 预测

- 礼物

- 总统

- 防止

- 隐私

- 隐私和安全

- 私立

- 私营部门

- 市场问题

- 问题解决

- 程序

- 过程

- 生产率

- 深刻的

- 进展

- 正确

- 所有权

- 保护

- 协议

- 提供

- 提供者

- 国家

- 出版

- 放

- 把

- 题

- 很快

- 种族

- 快

- 率

- 宁

- 确认

- 建议

- 相应

- 卓越

- 改写

- 代表

- 代表

- 要求

- 研究

- 研究人员

- 响应

- 回复

- 导致

- 揭密

- 严格

- 风险

- 风险评估

- 风险

- s

- 保护

- 保障

- 实现安全

- 说

- 销售

- Sam

- 说

- 鳞片

- 脚本

- 情景

- 扇形

- 安全

- 保安

- 安全政策

- 安全风险

- 感

- 敏感

- 集

- 套数

- 设置

- 几个

- 应该

- 签

- 显著

- 网站

- 天网

- 聪明

- So

- 至今

- 社会

- 社会

- 软件

- 方案,

- 解决方案

- 东西

- 极致

- 太空

- 具体的

- 站

- 标准

- 开始

- 留

- 驾驶

- 步

- 步骤

- Stop 停止

- 策略

- 策略

- 成功

- 顺利

- 这样

- 超级智能

- 供应

- 供应链

- 系统

- 产品

- T

- 量身定制

- 采取

- 任务

- 专案组

- 技术

- 技术专家

- 专业技术

- 比

- 这

- 英国

- 世界

- 其

- 他们

- 然后

- 博曼

- 他们

- Free Introduction

- 那些

- 威胁

- 威胁者

- 威胁

- 次

- 至

- 也有

- 工具

- 工具

- 最佳

- 对于

- 传统

- 熟练

- true

- 类型

- Uk

- 最终

- 理解

- 理解

- 独特

- 无用

- us

- 使用

- 用户

- 运用

- 有效

- 折扣值

- 变化

- 广阔

- 厂商

- 副

- 副总裁

- 访客

- 脆弱

- 警告

- 方法..

- 方法

- we

- 什么是

- ,尤其是

- 这

- 而

- 全

- 为什么

- 广泛

- 将

- 威尔逊

- 见证

- 工作

- 世界

- 更坏

- 写

- 年

- 您一站式解决方案

- 和风网