Suresh 是一位技术高管,在半导体、人工智能、网络安全、物联网、硬件、软件等领域拥有深厚的技术专业知识。他在该行业工作了 20 年,最近担任开源零基础公司的执行董事。他在阿布扎比技术创新研究所以及英特尔、高通和联发科等其他财富 500 强半导体公司担任各种领导职务,负责研发高性能、高能效、后量子安全、安全的芯片开发适用于数据中心、客户端、智能手机、网络、物联网和 AI/ML 市场的微芯片/片上系统 (SoC)/加速器。他为 Falcon 法学硕士(huggingface 排名第一)做出了贡献,并且是定制 AI 硬件平台的首席架构师(已取消 - 优先级发生变化)。他拥有超过 1 项美国专利,并在超过 15 场会议上发表文章/发表演讲。

Suresh 是一位技术高管,在半导体、人工智能、网络安全、物联网、硬件、软件等领域拥有深厚的技术专业知识。他在该行业工作了 20 年,最近担任开源零基础公司的执行董事。他在阿布扎比技术创新研究所以及英特尔、高通和联发科等其他财富 500 强半导体公司担任各种领导职务,负责研发高性能、高能效、后量子安全、安全的芯片开发适用于数据中心、客户端、智能手机、网络、物联网和 AI/ML 市场的微芯片/片上系统 (SoC)/加速器。他为 Falcon 法学硕士(huggingface 排名第一)做出了贡献,并且是定制 AI 硬件平台的首席架构师(已取消 - 优先级发生变化)。他拥有超过 1 项美国专利,并在超过 15 场会议上发表文章/发表演讲。

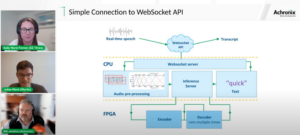

Suresh 还积极担任 RISC-V International 的领导职务,担任可信计算小组的主席,开发 RISC-V 机密计算能力,并担任 AI/ML 小组的主席,为 AI/ML 工作负载开发 RISC-V 硬件加速,例如ChatGPT 类应用程序中使用的 Transformer 大型语言模型。他还为初创企业和风险投资公司提供投资决策支持、产品策略、技术尽职调查等方面的建议。

他获得了 INSEAD 的 MBA 学位、Birla Institute of Technology & Science Pilani 的硕士学位、麻省理工学院的系统工程证书、斯坦福大学的人工智能证书以及 TÜV SÜD 的汽车功能安全证书。

告诉我们您的公司

“玛斯蒂卡人工智能”(Mastiṣka 在梵文中是“大脑”的意思)是一家人工智能公司,专注于构建类脑计算机,以便为未来的生成式人工智能用例更有效地运行基础模型。

你在解决什么问题?

鉴于人工智能/ GenAI 的优势,其需求必然会增加,其对我们星球的副作用也会增加。我们如何减少或消除人工智能对地球的副作用?碳捕获和核电正朝着正确的方向发展。但我们需要从根本上重新思考人工智能的处理方式,这是进行大量矩阵乘法的错误方法吗?

我们的大脑可以在 10W 及以下的情况下并行学习和执行许多任务,但为什么这些 AI 系统要消耗 10 兆瓦来训练模型呢?

也许未来会出现节能架构,例如最接近人脑的神经形态架构和基于尖峰神经网络的变压器,其能耗可能会降低 100-1000 倍,从而降低使用人工智能的成本,从而使其民主化并节省我们的时间。行星。

目前我们在人工智能方面面临的挑战是:a)可用性,b)可访问性,c)可负担性,d)环境安全以及解决这些问题的一些建议。

如果我们预见到未来,一些有用的 AGI 概念会在电影《她》中得到展示,其中的角色“萨曼莎”——一个自然的对话代理人,理解情感,表现出同理心,是工作中令人惊叹的副驾驶——并且继续运行一整天的手持设备,那么我们现在可能必须解决以下挑战。

问题 1:培训法学硕士的费用从 150 万到 10 多万美元不等,而且只允许那些财力雄厚的人开发人工智能。最重要的是,推理成本也巨大(成本比网络搜索高 10 倍)

—> 我们需要提高模型/硬件的能源效率,使人工智能民主化,造福人类。

问题 2:为对话代理或推荐系统运行巨大的人工智能模型,会在电力消耗和冷却方面对环境造成影响。

—> 我们需要提高模型/硬件的能源效率,为我们的孩子拯救我们的星球。

问题 3:人脑有能力并且可以执行多任务,但仅消耗 10 瓦而不是兆瓦。

—> 也许我们应该更快地建造像我们的大脑一样的机器,而不是常规的矩阵乘法器。

人类只有通过可持续创新才能繁荣发展,而不是以创新的名义砍伐所有森林、煮沸海洋。为了我们的孩子和子孙后代的福祉,我们必须保护我们的星球……

你最擅长的应用领域是什么?

基于 Transformer(和未来神经架构)的基础模型的训练和推理,与当今基于 GPU 的解决方案相比,能源效率提高 50-100 倍。

是什么让您的客户夜不能寐?

目前使用其他产品的客户面临的问题:

训练庞大的语言模型的电力消耗超出了屋顶,例如,在 13 个 GPU 上对 390B 文本标记训练 200B 参数的 LLM 7 天的成本为 151,744 美元(来源:HuggingFace 新训练集群服务页面 – https://lnkd.in/g6Vc5cz3)。甚至具有 100+B 参数的更大模型仅训练成本就高达 10+M 美元。然后每次新的提示请求到达时都要为推理付费。

加州大学河滨分校的研究人员估计了类似 ChatGPT 的服务对环境的影响,并表示每次您询问它时,它会消耗 500 毫升的水(接近 16 盎司水瓶中的水量)。一系列 5 到 50 个提示或问题。该范围根据服务器所在位置和季节而有所不同。该估算包括公司未测量的间接用水量,例如冷却为数据中心供电的发电厂的用水量。 (来源: https://lnkd.in/gybcxX8C)

非当前产品客户的问题:

无力承担购买硬件的资本支出

无力使用云服务

无法创新或利用人工智能——坚持消除任何竞争优势的服务模式

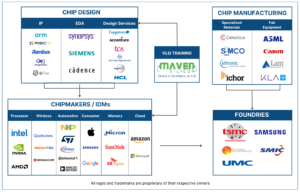

竞争格局是什么样的?您如何脱颖而出?

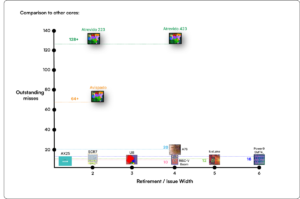

- GPU 在训练领域占据主导地位,尽管专用 ASIC 也在这一领域展开竞争

- 云和边缘推理有太多可用选项

数字、模拟、光子——凡是你能想到的,人们都在试图解决同样的问题。

您能否分享一下您对 AI/ML 芯片架构现状的看法,即您认为目前最重要的趋势和机遇是什么?

以下趋势:

趋势1: 10 年前,硬件支持的深度学习蓬勃发展,而现在同样的硬件正在抑制进步。由于硬件成本和运行模型的电力成本巨大,访问硬件成为了一个挑战。只有财力雄厚的公司才有能力承担这些费用并逐渐成为垄断企业。

趋势2: 现在有了这些模型,我们需要将它们用于实际用途,这样推理负载就会增加,让带有AI加速器的CPU再次成为人们关注的焦点。

趋势3: 初创公司正在尝试提出替代的浮点数表示形式,传统的 IEEE 格式(例如对数和基于位置)虽然不错,但还不够。当我们尝试优化其中一个而另一个却失败时,PPA$ 设计空间优化就会爆炸。

趋势4: 该行业正在从基于服务的人工智能模型转向在自己的场所托管自己的私有模型,但由于供应短缺、制裁等原因,获取硬件是一个挑战

目前事态:

十年前,硬件和数据的可用性推动了人工智能的发展,现在相同的硬件却在某种程度上抑制了人工智能的发展——让我解释一下

自从 CPU 表现不佳、GPU 被重新用于 AI 以来,发生了很多事情

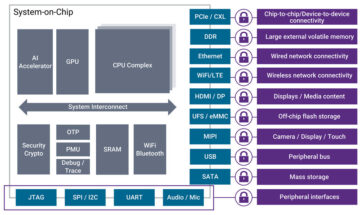

公司一直致力于解决 AI/ML 的 4 个部分,即:1) 云训练、2) 云推理、3) 边缘推理和 4) 边缘训练(隐私敏感应用程序的联邦学习)。

数字和模拟

培训方面——大量公司在生产 GPU、基于 RISC-V 的客户加速器、晶圆级芯片(850K 核心)等传统 CPU 所缺乏的(其通用用途)。推理方面——每个制造商都可以在智能手机、笔记本电脑和其他边缘设备中使用神经网络加速器。

基于模拟忆阻器的架构不久前也出现了。

我们相信,如果我们通过矩阵扩展等加速来增强 CPU 的推理能力

RISC-V 方面的事情:

在 RISC-V 方面,我们正在开发用于矩阵运算和其他非线性运算的加速器,以消除变压器工作负载可能出现的瓶颈。冯诺依曼瓶颈也可以通过构建更接近计算的存储器来解决,最终使具有人工智能加速功能的 CPU 成为推理的正确选择。

机会:

存在独特的机会来填补基础模型市场。示例 – OpenAI 一直提到他们无法获得足够的 AI 计算 (GPU) 来继续推动其 ChatGPT 服务……新闻报道称电力成本是常规互联网搜索的 10 倍,并且需要 500 毫升的水来冷却系统对于每个查询。这里有一个市场需要填补——它不是利基市场,而是整个市场,它将使人工智能民主化,解决上述所有挑战——a)可用性,b)可访问性,c)可负担性,d)环境安全

您正在开发哪些新功能/技术?

我们正在利用神经形态技术和定制模型来构建类脑计算机,以利用节能硬件,重用可用的开放框架

您如何看待 AI/ML 行业在未来 12-18 个月内的增长或变化?

由于对 GPU 的需求下降(成本约为 30 万美元),加上世界上一些地区面临购买这些 GPU 的制裁,世界上一些地区感觉他们在无法获得 GPU 的情况下被冻结在人工智能研究和开发中。替代硬件平台将占领市场。

模型可能会开始缩小——定制模型甚至从根本上来说信息密度将会增加

同样的问题,但未来3-5年的增长和变化如何?

a) 具有人工智能扩展的CPU将占领人工智能推理市场

b) 模型将变得灵活,随着信息密度从 16% 提高到 90%,参数将消失

c) 能源效率提高,二氧化碳足迹减少

d) 新的架构出现

e) 硬件成本和能源成本下降,因此小公司创建和训练模型的进入壁垒变得可以承受

f) 人们谈论 AGI 之前的时刻,但我的基准是电影“她”中的萨曼莎(对话式人工智能)……考虑到扩大规模的高昂成本,这可能不太可能

哪些挑战可能会影响或限制人工智能/机器学习行业的增长?

a) 访问硬件

b) 能源成本和冷却成本以及环境危害

另请参阅:

首席执行官访谈:Pragmatic 的 David Moore

- :具有

- :是

- :不是

- :在哪里

- $UP

- 1

- 10

- 150

- 20

- 20 年

- 200

- 50

- 500

- 7

- a

- Able

- 关于

- 以上

- 阿布扎比

- 促进

- 加速器

- ACCESS

- 访问

- 积极地

- 地址

- 解决

- 解决

- 优点

- 事务

- 再次

- 经纪人

- 中介代理

- 德盛

- 前

- AI

- AI模型

- 研究

- 人工智能系统

- 人工智能用例

- AI / ML

- 对齐的

- 所有类型

- 允许

- 允许

- 沿

- 还

- 替代

- 惊人

- an

- 和

- 另一个

- 任何

- 分析数据

- 应用领域

- 应用领域

- 架构

- 保健

- 地区

- 抵达

- 人造的

- 人工智能

- AS

- 亚瑟士

- 问

- At

- 汽车

- 可用性

- 可使用

- 远离

- b

- 屏障

- 基于

- BE

- 成为

- 成为

- 成为

- 很

- 作为

- 相信

- 如下。

- 基准

- 得益

- 好处

- 之间

- 超越

- 瓶颈

- 界

- 大脑

- 大脑

- 建立

- 建筑物

- 但是

- 购买

- by

- 加州

- CAN

- 取消

- 能力

- 能力

- 资本

- 捕获

- 碳

- 碳捕获

- 例

- 中心

- CEO

- CEO访谈

- 证书

- 挑战

- 挑战

- 更改

- 变

- 改变

- 字符

- ChatGPT

- 儿童

- 芯片

- 碎屑

- 选择

- 乔普拉

- 客户

- 关闭

- 接近

- 云端技术

- 簇

- co2

- 如何

- 公司

- 公司

- 相比

- 竞争

- 竞争的

- 计算

- 一台

- 电脑

- 计算

- 概念

- 会议

- 消耗

- 消费

- 继续

- 贡献

- 听起来像对话

- 会话AI

- Cool

- 价格

- 成本

- 可以

- 创建信息图

- 电流

- 当前状态

- 目前

- 习俗

- 顾客

- 合作伙伴

- 切割

- 网络安全

- data

- 数据中心

- 数据中心

- David

- 天

- 一年中的

- 决定

- 深

- 深入学习

- 更深

- 需求

- 民主化

- 民主化

- 证明

- 密度

- 根据

- 设计

- 开发

- 发达

- 发展

- 研发支持

- 设备

- 阿布扎比

- 区分

- 勤勉

- 方向

- 副总经理

- do

- 不

- 做

- 美元

- 别

- 向下

- dr

- 下降

- 两

- 赚

- 边缘

- 影响

- 效率

- 高效

- 有效

- 电力

- 用电量

- 消除

- 消除

- 情绪

- 移情

- 能源

- 能源效率

- 工程师

- 提高

- 更多

- 整个

- 条目

- 环境

- 环境的

- 设想

- 评估

- 估计

- 等

- 醚(ETH)

- 甚至

- 终于

- 所有的

- 例子

- 执行

- 执行董事

- 存在

- 专门知识

- 爆炸

- 扩展

- 面部彩妆

- 面对

- 鹘

- 快

- 感觉

- 填

- 企业

- 漂浮的

- 重点

- 脚部

- 针对

- 预见

- 格式

- 运气

- 基金会

- 框架

- 止

- 冻结

- 推动

- 实用

- 从根本上

- 未来

- 其他咨询

- 代

- 生成的

- 生成式人工智能

- 特定

- Go

- GOES

- 去

- 非常好

- 图形处理器

- 团队

- 成长

- 事业发展

- 硬件

- 有

- he

- 于是

- 相关信息

- 高

- 持有

- 托管

- 创新中心

- HTTPS

- 巨大

- 拥抱脸

- 人

- 人类

- IEEE

- if

- 图片

- 影响力故事

- 改善

- 提高

- in

- 其他

- 包括

- 增加

- 行业中的应用:

- 信息

- 创新

- 創新

- 创新

- 代替

- 研究所

- 英特尔

- 房源搜索

- 国际

- 网络

- 专属采访

- 投资

- 物联网

- IT

- 它的

- 只是

- 孩子们

- 类

- 缺乏

- 景观

- 语言

- 笔记本电脑

- 大

- 大

- 铅

- 领导团队

- 学习用品

- 学习

- 让

- 杠杆作用

- 借力

- 喜欢

- 聚光灯

- 极限

- 加载

- 位于

- 看

- 看起来像

- 降低

- 机

- 制作

- 生产厂家

- 许多

- 市场

- 市场

- 矩阵

- 最大宽度

- 可能..

- 也许

- MBA

- me

- 意

- 手段

- 衡量

- 回忆

- 提到

- 可能

- 百万

- 百万美元

- 麻省理工学院简介

- 模型

- 模型

- 时刻

- 垄断

- 个月

- 更多

- 最先进的

- 电影

- 移动

- MS

- 必须

- my

- 姓名

- 亦即

- 自然

- 需求

- 基于网络的

- 工业网络

- 神经

- 全新

- 消息

- 下页

- 壁龛

- 夜

- 敏捷

- 现在

- 核

- 核电

- 数

- 大洋

- of

- on

- 一

- 仅由

- 打开

- 开放源码

- OpenAI

- 运营

- 机会

- 优化

- 优化

- 附加选项

- or

- 其他名称

- 我们的

- 输出

- 己

- 页

- 并行

- 参数

- 参数

- 部分

- 专利

- 员工

- 也许

- 行星

- 工厂

- 平台

- 平台

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 过多

- 加

- 口袋

- 点

- 位置

- 可能

- 功率

- 发电厂

- 实用

- 打印

- 私立

- 市场问题

- 问题

- 产品

- 核心产品

- 本人简介

- 进展

- 提示

- 保护

- 目的

- 目的

- 推

- 认沽期权

- 高通公司

- 题

- 有疑问吗?

- 范围

- 排名

- 阅读

- 最近

- 推荐

- 建议

- 减少

- 减少

- 定期

- 业务报告

- 请求

- 研究

- 研究和开发

- 研究人员

- 右

- 河滨

- 角色

- 天台

- 运行

- 运行

- 运行

- 安全

- 实现安全

- 同

- 制裁

- 沙箱

- 保存

- 保存

- 对工资盗窃

- 缩放

- 科学

- 搜索

- 季节

- 扇形

- 安全

- 看到

- 中模板

- 半导体

- 半导体

- 系列

- 服务器

- 服务

- 特色服务

- 服务

- Share

- 短缺

- 应该

- 显示

- 作品

- 侧

- 显著

- 自

- 小

- 智能手机

- 智能手机

- So

- 软件

- 解决方案

- 解决

- 一些

- 来源

- 太空

- 专门

- 花费

- 斯坦福

- 开始

- 初创企业

- 州/领地

- 策略

- 最强

- 这样

- 供应

- SUPPORT

- 可持续发展

- 产品

- 滑车

- 抢断

- 剪裁

- 采取

- 谈论

- 任务

- 文案

- 专业技术

- 技术创新

- 条款

- 文本

- 比

- 这

- 未来

- 信息

- 世界

- 其

- 他们

- 然后

- 那里。

- 从而

- 博曼

- 他们

- 事

- Free Introduction

- 那些

- 虽然?

- 兴旺

- 次

- 至

- 今天的

- 令牌

- 明天

- 也有

- 最佳

- 折腾

- 传统

- 培训

- 产品培训

- 变压器

- 变形金刚

- 趋势

- 信任

- 尝试

- 试图

- 下

- 理解

- 大学

- 美国加州大学

- 不会

- us

- 用法

- 使用

- 用过的

- 运用

- 各个

- 冒险

- 创投

- 风险投资公司

- 非常

- 的

- 是

- 水

- 方法..

- we

- 卷筒纸

- 福利

- 为

- 什么是

- ,尤其是

- 这

- WHO

- 为什么

- 将

- 也完全不需要

- 工作

- 加工

- 世界

- 将

- 错误

- 年

- 您

- 您一站式解决方案

- 和风网