生成式人工智能的快速发展带来了充满希望的新创新,同时也提出了新的挑战。这些挑战包括在生成人工智能之前常见的一些挑战,例如偏见和可解释性,以及 基础模型独有的新功能 (FM),包括幻觉和中毒。在 AWS,我们致力于 负责任地开发生成式人工智能, 采取以人为本的方法,优先考虑教育、科学和客户,将负责任的人工智能集成到整个端到端人工智能生命周期中。

在过去的一年里,我们在生成式人工智能应用程序和模型中引入了新功能,例如内置安全扫描 亚马逊 CodeWhisperer,检测和阻止有害内容的培训 亚马逊泰坦,以及数据隐私保护 亚马逊基岩。我们对安全、透明和负责任的生成人工智能的投资包括与全球社区和政策制定者的合作,因为我们鼓励和支持 白宫自愿人工智能承诺 和 人工智能安全峰会 在英国。我们继续与客户携手合作,通过专用工具(例如 亚马逊SageMaker澄清, 使用 Amazon SageMaker 进行机器学习治理等等。

引入新的负责任的人工智能创新

随着生成式人工智能扩展到新的行业、组织和用例,这种增长必须伴随着对负责任的 FM 开发的持续投资。客户希望他们的 FM 在构建时考虑到安全性、公平性和安全性,以便他们能够负责任地部署人工智能。在今年的 AWS re:Invent 上,我们很高兴宣布推出新功能,通过新的内置工具、客户保护、提高透明度的资源以及打击虚假信息的工具,通过广泛的功能促进负责任的生成式 AI 创新。我们的目标是为客户提供所需的信息,以根据关键的负责任的人工智能考虑因素(例如毒性和鲁棒性)评估 FM,并引入护栏以根据客户用例和负责任的人工智能政策应用保护措施。与此同时,我们的客户希望在自己的组织内使用人工智能服务和 FM 时,更好地了解它们的安全性、公平性、保密性和其他属性。我们很高兴宣布提供更多资源,帮助客户更好地了解我们的 AWS AI 服务并提供他们所需的透明度。

实施保障措施:Amazon Bedrock 的 Guardrails

在大规模引入生成式人工智能时,安全是首要任务。组织希望促进客户与生成式人工智能应用程序之间的安全交互,避免有害或冒犯性语言并符合公司政策。最简单的方法是在整个组织内实施一致的保障措施,以便每个人都可以安全地进行创新。昨天我们发布了预览版 亚马逊基岩护栏- 一项新功能,可以根据客户用例和负责任的人工智能策略轻松实施特定于应用程序的保护措施。

Guardrail 可以提高 Amazon Bedrock 上的 FM 对应用程序中不良和有害内容的响应方式的一致性。客户可以将护栏应用于 Amazon Bedrock 上的大型语言模型以及微调模型,并与 亚马逊基岩代理。 Guardrails 允许您指定要避免的主题,并且该服务会自动检测并阻止属于受限类别的查询和响应。客户还可以跨类别配置内容过滤阈值,包括仇恨言论、侮辱、性语言和暴力,以将有害内容过滤到所需的级别。例如,可以设置在线银行应用程序来避免提供投资建议并限制不适当的内容(例如仇恨言论、侮辱和暴力)。在不久的将来,客户还可以编辑用户输入和 FM 响应中的个人身份信息 (PII),设置脏话过滤器,并提供自定义单词列表来阻止用户和 FM 之间的交互,从而提高合规性并进一步保护用户。借助 Guardrails,您可以利用生成式 AI 更快地进行创新,同时保持与公司政策一致的保护和保障措施。

确定特定用例的最佳 FM:Amazon Bedrock 中的模型评估

如今,组织拥有广泛的 FM 选项来为其生成式 AI 应用程序提供支持。为了在用例的准确性和性能之间取得适当的平衡,组织必须有效地比较模型,并根据对他们来说很重要的关键负责任的人工智能和质量指标找到最佳选择。为了评估模型,组织必须首先花几天时间确定基准、设置评估工具并运行评估,所有这些都需要深厚的数据科学专业知识。此外,这些测试对于评估主观标准(例如品牌声音、相关性和风格)没有用处,因为主观标准需要通过繁琐、耗时的人工审核工作流程进行判断。对于每个新用例,这些评估所需的时间、专业知识和资源使得组织很难根据负责任的人工智能维度评估模型,并就哪种模型将为客户提供最准确、最安全的体验做出明智的选择。

现已推出预览版, Amazon Bedrock 上的模型评估 帮助客户根据自定义指标(例如准确性和安全性)使用自动或人工评估来评估、比较和选择适合其特定用例的最佳 FM。在 Amazon Bedrock 控制台中,客户可以选择他们想要针对给定任务(例如问答或内容摘要)进行比较的 FM。对于自动评估,客户选择预定义的评估标准(例如准确性、稳健性和毒性)并上传自己的测试数据集或从内置的公开可用数据集中进行选择。对于需要判断的主观标准或细微内容,客户只需点击几下即可轻松设置基于人工的评估工作流程。这些工作流程利用客户的内部工作团队,或使用 AWS 提供的托管劳动力来评估模型响应。在基于人的评估过程中,客户定义特定于用例的指标(例如相关性、风格和品牌声音)。客户完成设置过程后,Amazon Bedrock 就会运行评估并生成报告,以便客户可以轻松了解模型在关键安全性和准确性标准方面的表现,并为其用例选择最佳模型。

这种评估模型的能力不仅限于 Amazon Bedrock,客户还可以使用 Amazon SageMaker Clarify 中的模型评估来轻松评估、比较和选择跨关键质量和责任指标(例如准确性、稳健性和毒性)的最佳 FM 选项。所有 FM。

打击虚假信息:亚马逊泰坦中的水印

今天,我们宣布 亚马逊泰坦图像生成器 预览版,使客户能够快速生成和大规模增强高质量图像。我们在模型开发过程的每个阶段都考虑了负责任的人工智能,包括训练数据选择、构建过滤功能以检测和删除不适当的用户输入和模型输出,以及提高模型输出的人口多样性。默认情况下,所有 Amazon Titan 生成的图像都包含不可见水印,该水印旨在通过提供识别 AI 生成图像的谨慎机制来帮助减少虚假信息的传播。 AWS 是首批广泛发布内置隐形水印的模型提供商之一,这些水印集成到图像输出中,并且旨在防止更改。

建立信任:通过赔偿支持我们的模型和应用程序

建立客户信任是 AWS 的核心。自成立以来,我们一直与客户一起踏上旅程,随着生成式人工智能的发展,我们仍然致力于共同构建创新技术。为了使客户能够利用我们的生成式人工智能的力量,他们需要知道自己受到保护。 AWS 为以下 Amazon 生成式 AI 服务的输出提供版权赔偿范围:Amazon Titan Text Express、Amazon Titan Text Lite、Amazon Titan Embeddings、Amazon Titan Multimodal Embeddings、Amazon CodeWhisperer Professional、 AWS 健康抄写员, 亚马逊Lex及 亚马逊个性化。这意味着负责任地使用服务的客户将受到保护,免受第三方声称这些服务生成的输出侵犯版权的索赔(请参阅第 50.10 节) 服务条款)。此外,我们针对使用服务的标准知识产权赔偿可保护客户免受第三方声称服务和用于培训服务的数据侵犯知识产权的索赔。换句话说,如果您使用上面列出的 Amazon 生成式 AI 服务,并且有人起诉您侵犯知识产权,AWS 将为该诉讼辩护,其中包括承担针对您的任何判决或和解费用。

我们支持我们的生成式人工智能服务,并努力不断改进它们。随着 AWS 推出新服务和生成式 AI 不断发展,AWS 将继续不懈地致力于赢得和维护客户信任。

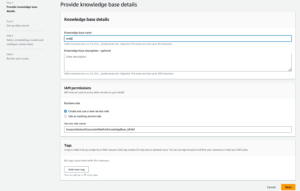

提高透明度:适用于 Amazon Titan Text 的 AWS AI 服务卡

We 推出AWS AI服务卡 re:Invent 2022 作为透明度资源,帮助客户更好地了解我们的 AWS AI 服务。 AI 服务卡是一种负责任的 AI 文档形式,为客户提供了一个单一位置来查找有关我们的 AI 服务的预期用例和限制、负责任的 AI 设计选择以及部署和性能优化最佳实践的信息。它们是我们致力于以负责任的方式构建我们的服务的全面开发过程的一部分,该过程解决公平性、可解释性、真实性和稳健性、治理、透明度、隐私和安全、安全性和可控性。

在今年的 re:Invent 大会上,我们宣布了 亚马逊泰坦文本的新人工智能服务卡 提高基础模型的透明度。我们还推出了四张新的人工智能服务卡,包括: Amazon Comprehend 检测 PII, Amazon Transcribe 毒性检测, Amazon Rekognition 人脸活跃度及 AWS 健康抄写员。您可以在以下位置探索这些卡片中的每一张 AWS 网站。 随着生成式人工智能的不断发展和发展,技术开发、测试和使用方式的透明度将成为赢得组织及其客户信任的重要组成部分。在 AWS,我们致力于继续向更广泛的社区提供 AI 服务卡等透明度资源,并迭代和收集有关最佳前进方式的反馈。

在整个生成式人工智能生命周期中投资负责任的人工智能

我们对本周在 re:Invent 上宣布的新创新感到兴奋,这些创新为我们的客户提供了更多工具、资源和内置保护,以安全地构建和使用生成式 AI。从模型评估到护栏再到水印,客户现在可以更快地将生成式人工智能引入其组织,同时降低风险。对客户的新保护(例如知识产权赔偿范围)和用于提高透明度的新资源(例如额外的人工智能服务卡)也是我们致力于在技术公司、政策制定者、社区团体、科学家等之间建立信任的关键例子。我们继续在基础模型的整个生命周期中对负责任的人工智能进行有意义的投资,以帮助我们的客户以安全、可靠和负责任的方式扩展人工智能。

作者简介

彼得哈利南 在 AWS AI 与负责任的 AI 专家团队一起领导负责任 AI 的科学和实践计划。 他在人工智能(哈佛大学博士)和创业(Blindsight,出售给亚马逊)方面拥有深厚的专业知识。 他的志愿活动包括担任斯坦福大学医学院的咨询教授,以及马达加斯加美国商会的主席。 如果可能,他会和孩子们一起去山上:滑雪、登山、远足和漂流

彼得哈利南 在 AWS AI 与负责任的 AI 专家团队一起领导负责任 AI 的科学和实践计划。 他在人工智能(哈佛大学博士)和创业(Blindsight,出售给亚马逊)方面拥有深厚的专业知识。 他的志愿活动包括担任斯坦福大学医学院的咨询教授,以及马达加斯加美国商会的主席。 如果可能,他会和孩子们一起去山上:滑雪、登山、远足和漂流

瓦西·菲洛明(Vasi Philomin) 目前是 AWS 生成人工智能副总裁。他领导了包括 Amazon Bedrock、Amazon Titan 和 Amazon CodeWhisperer 在内的生成式 AI 工作。

瓦西·菲洛明(Vasi Philomin) 目前是 AWS 生成人工智能副总裁。他领导了包括 Amazon Bedrock、Amazon Titan 和 Amazon CodeWhisperer 在内的生成式 AI 工作。

- :具有

- :是

- :不是

- $UP

- 10

- 100

- 125

- 2022

- 50

- a

- 对,能力--

- Able

- 关于

- 以上

- 伴随着

- 精准的

- 横过

- 活动

- 增加

- 额外

- 地址

- 忠告

- 驳

- AI

- 人工智能服务

- 瞄准

- 对齐

- 一样

- 所有类型

- 靠

- 还

- Amazon

- 亚马逊 CodeWhisperer

- 亚马逊SageMaker

- 亚马逊网络服务

- 美国人

- 其中

- an

- 和

- 宣布

- 公布

- 宣布

- 另一个

- 任何

- 应用领域

- 应用领域

- 使用

- 的途径

- 保健

- 围绕

- AS

- 问

- 评估

- At

- 自动表

- 自动

- 可使用

- 避免

- 避免

- AWS

- AWS re:Invent

- 当前余额

- 银行业

- 基于

- BE

- 很

- before

- 背后

- 基准

- 最佳

- 最佳实践

- 更好

- 之间

- 偏见

- 阻止

- 都

- 品牌

- 带来

- 带来

- 广阔

- 更广泛

- 建立

- 建立信任

- 建筑物

- 建

- 内建的

- by

- CAN

- 能力

- 能力

- 卡

- 牌

- 案件

- 例

- 类别

- 挑战

- 房间

- 儿童

- 选择

- 选择

- 索赔

- 攀登

- 合作

- 打击

- 组合

- 购买的订单均

- 商业

- 承诺

- 提交

- 相当常见

- 社体的一部分

- 公司

- 公司

- 比较

- 符合

- 元件

- 理解

- 全面

- 注意事项

- 考虑

- 一贯

- 安慰

- 咨询

- 包含

- 内容

- 不断

- 继续

- 继续

- 继续

- 版权

- 侵犯版权

- 核心

- 成本

- 覆盖

- 覆盖

- 标准

- 目前

- 习俗

- 顾客

- 合作伙伴

- data

- 数据隐私

- 数据科学

- 数据集

- 一年中的

- 深

- 深厚的专业知识

- 默认

- 定义

- 交付

- 人口统计学

- 部署

- 部署

- 设计

- 设计

- 期望

- 检测

- 发达

- 研发支持

- 难

- 尺寸

- 造谣

- 多元化

- do

- 文件

- 驾驶

- ,我们将参加

- e

- 每

- 赚

- 佣金

- 最简单的

- 容易

- 易

- 教育

- 有效

- 工作的影响。

- 或

- 如虎添翼

- enable

- 鼓励

- 端至端

- 提高

- 整个

- 创业

- 醚(ETH)

- 评估

- 评估

- 评估

- 评价

- 所有的

- 每个人

- 发展

- 例子

- 例子

- 兴奋

- 体验

- 专门知识

- 专家

- 可解释性

- 探索

- 特快

- 面部彩妆

- 公平

- 秋季

- 快

- 反馈

- 少数

- 过滤

- 过滤

- 过滤器

- 找到最适合您的地方

- 完

- 姓氏:

- 专注焦点

- 以下

- 针对

- 申请

- 向前

- 培育

- 基金会

- 四

- 止

- 进一步

- 此外

- 未来

- 收集

- 产生

- 产生

- 生成的

- 生成式人工智能

- 特定

- 给

- 全球

- 治理

- 组的

- 增长

- 事业发展

- 有害

- 马具

- 哈佛

- 恨

- 仇恨言论

- 有

- he

- 帮助

- 帮助

- 高品质

- 徒步旅行

- 他的

- 别墅

- 创新中心

- HTTPS

- 人

- 鉴定

- 确定

- if

- 图片

- 图片

- 实施

- 重要

- 改善

- 改善

- in

- 成立

- 包括

- 包括

- 包括

- 包含

- 增加

- 行业

- 信息

- 通知

- 侵害

- 项目

- 创新

- 創新

- 创新

- 创新

- 创新技术

- 输入

- 整合

- 集成

- 拟

- 互动

- 成

- 介绍

- 介绍

- 介绍

- 投资

- 投资

- 无形

- IP

- IT

- 旅程

- JPG

- 只是

- 键

- 知道

- 语言

- 大

- 启动

- 发射

- 诉讼

- 信息

- 让

- Level

- 杠杆作用

- 生命周期

- 喜欢

- 极限

- 限制

- 有限

- 清单

- 已发布

- 维持

- 使

- 制作

- 管理

- 有意义的

- 手段

- 机制

- 药物

- 指标

- 介意

- 缓解

- 模型

- 模型

- 更多

- 最先进的

- 必须

- 近

- 需求

- 全新

- 现在

- of

- 折扣

- 进攻

- 优惠精选

- on

- 一旦

- 那些

- 在线

- 网上银行

- 优化

- 附加选项

- 附加选项

- or

- 组织

- 组织

- 其他名称

- 我们的

- 输出

- 输出

- 己

- 部分

- 过去

- 性能

- 执行

- 亲自

- 博士学位

- ii

- 地方

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 政策

- 政策制定者

- 可能

- 功率

- 在练习上

- 做法

- 总统

- 防止

- 预览

- 优先

- 优先

- 隐私

- 隐私和安全

- 过程

- 生产

- 亵渎

- 所以专业

- 教授

- 有希望

- 促进

- 保护

- 保护

- 保护

- 提供

- 提供

- 供应商

- 优

- 公然

- 放

- 质量

- 查询

- 提高

- 范围

- 快

- 急速

- RE

- 减少

- 释放

- 相关性

- 留

- 去掉

- 报告

- 必须

- 需要

- 耐

- 资源

- 资源

- 回应

- 回复

- 责任

- 提供品牌战略规划

- 负责任

- 受限

- 右

- 风险

- 稳健性

- 运行

- 运行

- 安全

- 保障

- 安然

- 实现安全

- sagemaker

- 同

- 鳞片

- 规模艾

- 秤

- 扫描

- 学校

- 科学

- 科学家

- 部分

- 安全

- 保安

- 看到

- 选择

- 选择

- 服务

- 特色服务

- 服务

- 集

- 设置

- 沉降

- 格局

- 自

- 单

- So

- 出售

- 一些

- 有人

- 具体的

- 言语

- 花

- 传播

- 阶段

- 站

- 标准

- 地位

- 斯坦福

- 斯坦福大学

- 罢工

- 样式

- 这样

- 起诉

- 支持

- 持续

- 服用

- 任务

- 团队

- 专业技术

- 科技公司

- 测试

- 测试

- 测试

- 文本

- 这

- 信息

- 英国

- 其

- 他们

- 博曼

- 他们

- 第三方

- Free Introduction

- 本星期

- 今年

- 那些

- 通过

- 次

- 泰坦

- 至

- 一起

- 工具

- Topics

- 培训

- 产品培训

- 用户评论透明

- 透明

- 信任

- 转

- Uk

- 理解

- 承担

- 独特

- 大学

- 使用

- 用例

- 用过的

- 用户

- 用户

- 运用

- 重要

- 音色

- 自愿的

- 志愿者

- vp

- 想

- 水印

- 水印

- 水印

- 方法..

- 方法

- we

- 卷筒纸

- Web服务

- 您的网站

- 周

- 井

- 为

- 什么是

- ,尤其是

- 这

- 而

- WHO

- 全

- 宽

- 大范围

- 广泛

- 将

- 中

- 话

- 工作

- 工作流程

- 劳动力

- 年

- 昨天

- 您

- 和风网