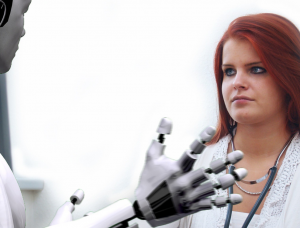

مصنوعی ذہانت (AI) نے مختلف صنعتوں میں انقلاب برپا کر دیا ہے، جس سے بے شمار فوائد اور مواقع مل رہے ہیں۔ تاہم، AI کے امتیازی سلوک اور تعصب کو برقرار رکھنے کی صلاحیت کے حوالے سے خدشات سامنے آئے ہیں۔ یہ مضمون AI امتیازی سلوک کے موضوع کی کھوج کرتا ہے، جس میں AI سسٹمز میں شامل تعصبات کی شناخت اور ان سے نمٹنے کے چیلنجوں پر روشنی ڈالی گئی ہے۔ صنعت کے اندرونی افراد AI کے اخلاقی اور اخلاقی مضمرات کے بارے میں شکوک و شبہات کا اظہار کرتے ہیں، غلط معلومات، الگورتھم میں تعصب، اور گمراہ کن مواد کی تخلیق کے بارے میں خدشات کا حوالہ دیتے ہوئے. جیسے جیسے AI سے متعلق بحثیں تیز ہوتی جا رہی ہیں، شفافیت، جوابدہی، اور بنیادی حقوق کے تحفظ کو یقینی بنانے کے لیے بامعنی ضابطے کا مطالبہ بڑھتا جا رہا ہے۔

AI کے ساتھ مالیاتی صنعتوں کے لیے چیلنجز

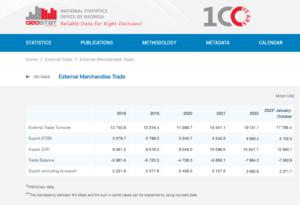

FIS کی طرف سے Worldpay میں crypto اور Web3 کے سربراہ نبیل منجی کے مطابق، AI مصنوعات کی تاثیر کا بہت زیادہ انحصار تربیت کے لیے استعمال کیے جانے والے ماخذ مواد کے معیار پر ہے۔ CNBC کے ساتھ ایک انٹرویو میں، منجی نے وضاحت کی کہ دو اہم عوامل AI کی کارکردگی میں اہم کردار ادا کرتے ہیں: وہ ڈیٹا جس تک اسے رسائی حاصل ہے اور بڑی زبان کے ماڈل کی صلاحیتیں۔

ڈیٹا کی اہمیت کو واضح کرنے کے لیے، منجی نے ذکر کیا کہ Reddit جیسی کمپنیوں نے عوامی طور پر ڈیٹا سکریپنگ پر پابندیوں کا اعلان کیا ہے، جس کے لیے رسائی کے لیے ادائیگی کی ضرورت ہے۔ مالیاتی خدمات کے شعبے میں، انہوں نے مختلف زبانوں اور فارمیٹس میں بکھرے ہوئے ڈیٹا سسٹمز کے چیلنج کو اجاگر کیا۔ استحکام اور ہم آہنگی کی یہ کمی AI سے چلنے والی مصنوعات کی تاثیر کو محدود کرتی ہے، خاص طور پر جب معیاری اور جدید ڈیٹا انفراسٹرکچر والی صنعتوں کے مقابلے میں۔

منجی کے مطابق، بلاک چین یا تقسیم شدہ لیجر ٹیکنالوجی کا استعمال اس مسئلے سے نمٹنے کے لیے ممکنہ حل پیش کر سکتا ہے۔ یہ اختراعی نقطہ نظر روایتی بینکوں کے پیچیدہ نظاموں میں ذخیرہ شدہ بکھرے ہوئے ڈیٹا میں بہتر شفافیت فراہم کر سکتا ہے۔ تاہم، انہوں نے تسلیم کیا کہ بینکوں کی انتہائی منظم اور سست رفتاری کی نوعیت ان کی تیزی سے نئے AI ٹولز کو اپنانے کی صلاحیت میں رکاوٹ بن سکتی ہے، مائیکروسافٹ اور گوگل جیسی زیادہ چست ٹیک کمپنیوں کے برعکس، جو پچھلے کچھ عرصے سے جدت طرازی میں سب سے آگے ہیں۔ دہائیوں

ان عوامل پر غور کرنے سے یہ بات واضح ہو جاتی ہے کہ مالیاتی صنعت کو ڈیٹا انضمام کی پیچیدگیوں اور بینکنگ سیکٹر کی موروثی نوعیت کی وجہ سے AI سے فائدہ اٹھانے میں منفرد چیلنجز کا سامنا ہے۔

ٹویٹر میں مشین لرننگ اخلاقیات، شفافیت اور جوابدہی کے سابق سربراہ رومن چودھری کے مطابق، قرض دینا اس بات کی ایک قابل ذکر مثال ہے کہ کس طرح AI سسٹمز میں تعصب پسماندہ کمیونٹیز کو بری طرح متاثر کر سکتا ہے۔ ایمسٹرڈیم میں ایک پینل ڈسکشن سے خطاب کرتے ہوئے، چودھری نے 1930 کی دہائی کے دوران شکاگو میں "ریڈ لائننگ" کے تاریخی عمل پر روشنی ڈالی۔ ریڈ لائننگ میں نسلی آبادی کی بنیاد پر بنیادی طور پر افریقی امریکی محلوں کو قرضوں سے انکار کرنا شامل تھا۔

چودھری نے وضاحت کی کہ اگرچہ جدید الگورتھم میں واضح طور پر نسل کو ڈیٹا پوائنٹ کے طور پر شامل نہیں کیا جا سکتا، تب بھی تعصبات کو واضح طور پر انکوڈ کیا جا سکتا ہے۔ قرض دینے کے مقاصد کے لیے اضلاع اور افراد کے خطرے کا اندازہ لگانے کے لیے الگورتھم تیار کرتے وقت، تعصبات پر مشتمل تاریخی ڈیٹا نادانستہ طور پر امتیازی سلوک کو برقرار رکھ سکتا ہے۔

اینگل بش، مصنوعی ذہانت میں سیاہ فام خواتین کے پیچھے بصیرت رکھنے والے، نے قرض کی منظوری کے تعین کے لیے اے آئی سسٹمز کو استعمال کرتے وقت تاریخی ڈیٹا میں شامل تعصبات کو دوبارہ پیدا کرنے سے وابستہ خطرات کو تسلیم کرنے کی اہمیت کو اجاگر کیا۔ اس طرح کا عمل پسماندہ کمیونٹیز کی طرف سے قرض کی درخواستوں کو خود بخود مسترد کرنے کا باعث بن سکتا ہے، اس طرح نسلی یا صنفی عدم مساوات کو برقرار رکھا جا سکتا ہے۔

فروسٹ لی، ایک تجربہ کار AI ڈویلپر نے ذاتی نوعیت کے چیلنجز کی نشاندہی کی۔ AI انضمام. AI ماڈلز کی تربیت کے لیے "بنیادی خصوصیات" کو منتخب کرنے میں بعض اوقات غیر متعلقہ عوامل شامل ہو سکتے ہیں جو متعصب نتائج کا باعث بن سکتے ہیں۔ لی نے ایک مثال پیش کی کہ کس طرح غیر ملکیوں کو نشانہ بنانے والے فنٹیک اسٹارٹ اپس کو مقامی بینکوں کے مقابلے میں مختلف کریڈٹ اسیسمنٹ معیارات کا سامنا کرنا پڑ سکتا ہے، جو مقامی اسکولوں اور کمیونٹیز سے زیادہ واقف ہیں۔

فنٹیکس کے لیے خودکار فیصلہ سازی میں مہارت رکھنے والے ایک اسٹارٹ اپ تکٹائل کے سی او او نکلاس گسکے نے واضح کیا کہ جنریٹو AI عام طور پر صارفین کے کریڈٹ اسکور بنانے یا رسک اسکورنگ کے لیے استعمال نہیں ہوتا ہے۔ اس کے برعکس، اس کی طاقت روایتی انڈر رائٹنگ ماڈلز کے لیے ڈیٹا کے معیار کو بڑھانے کے لیے ٹیکسٹ فائلوں کی طرح غیر ساختہ ڈیٹا کی پری پروسیسنگ میں مضمر ہے۔

خلاصہ یہ کہ قرض دینے اور مالیاتی خدمات میں AI کا استعمال تعصب اور امتیازی سلوک کے بارے میں خدشات کو جنم دیتا ہے۔ ڈیٹا میں شامل تاریخی تعصبات اور AI ٹریننگ کے دوران غیر متعلقہ خصوصیات کا انتخاب غیر منصفانہ نتائج کا باعث بن سکتا ہے۔ بینکوں اور مالیاتی اداروں کے لیے یہ بہت اہم ہے کہ وہ ان مسائل کو پہچانیں اور ان کو حل کریں تاکہ AI سلوشنز کو نافذ کرتے وقت نادانستہ طور پر ہونے والے امتیازی سلوک کو روکا جا سکے۔

AI- امتیازی سلوک کا ثبوت

AI پر مبنی امتیازی سلوک کو ثابت کرنا مشکل ہو سکتا ہے، جیسا کہ Apple اور Goldman Sachs کے معاملے جیسی مثالوں سے روشنی ڈالی جاتی ہے۔ نیویارک اسٹیٹ ڈپارٹمنٹ آف فنانشل سروسز نے ٹھوس ثبوت کی کمی کا حوالہ دیتے ہوئے خواتین کے لیے ایپل کارڈ پر کم حدیں لگانے کے الزامات کو مسترد کردیا۔

نسل پرستی کے خلاف یورپی نیٹ ورک کے ڈائریکٹر کم سماؤٹر بتاتے ہیں کہ AI کی بڑے پیمانے پر تعیناتی فیصلہ سازی کے عمل میں دھندلاپن کو جنم دیتی ہے، جس سے افراد کے لیے امتیازی سلوک کی شناخت اور اس کا ازالہ کرنا مشکل ہو جاتا ہے۔

سماؤٹر وضاحت کرتا ہے کہ افراد کو اکثر اس بارے میں محدود معلومات ہوتی ہیں کہ AI سسٹم کیسے کام کرتے ہیں، جس سے امتیازی سلوک یا نظامی تعصب کی مثالوں کا پتہ لگانا مشکل ہو جاتا ہے۔ یہ اور بھی پیچیدہ ہو جاتا ہے جب امتیازی سلوک ایک وسیع تر مسئلے کا حصہ ہے جو متعدد افراد کو متاثر کرتا ہے۔ سماؤٹر نے ڈچ چائلڈ ویلفیئر اسکینڈل کا حوالہ دیا، جہاں ادارہ جاتی تعصب کی وجہ سے بڑی تعداد میں فائدے کے دعووں کو غلط طور پر دھوکہ دہی کا لیبل لگایا گیا تھا۔ اس طرح کی خرابیوں کی دریافت مشکل ہے، اور اس کا ازالہ کرنا مشکل اور وقت طلب ہوسکتا ہے، جس سے اہم اور بعض اوقات ناقابل واپسی نقصان ہوتا ہے۔

یہ مثالیں AI پر مبنی امتیازی سلوک کو ثابت کرنے اور اس طرح کے امتیازی سلوک کے واقع ہونے پر علاج حاصل کرنے میں موروثی مشکلات کو واضح کرتی ہیں۔ AI نظاموں کی پیچیدگی اور فیصلہ سازی کے عمل میں شفافیت کی کمی افراد کے لیے امتیازی سلوک کے واقعات کو مؤثر طریقے سے پہچاننا اور ان سے نمٹنے کے لیے مشکل بنا سکتی ہے۔

چودھری کے مطابق، AI سے منسلک خطرات سے نمٹنے کے لیے اقوام متحدہ کی طرح ایک عالمی ریگولیٹری ادارے کی اشد ضرورت ہے۔ جب کہ AI نے قابل ذکر جدت طرازی کا مظاہرہ کیا ہے، اس کے اخلاقی اور اخلاقی مضمرات کے حوالے سے ماہرین تکنیکی ماہرین اور ماہرین اخلاقیات نے تشویش کا اظہار کیا ہے۔ ان خدشات میں غلط معلومات، AI الگورتھم میں سرایت شدہ نسلی اور صنفی تعصب، اور ChatGPT جیسے ٹولز کے ذریعے گمراہ کن مواد کی تخلیق جیسے مسائل شامل ہیں۔

چوہدری پوسٹ ٹروتھ دنیا میں داخل ہونے کے بارے میں تشویش کا اظہار کرتے ہیں جہاں متن، ویڈیو اور آڈیو سمیت آن لائن معلومات جنریٹیو AI کی وجہ سے ناقابل اعتماد ہو جاتی ہیں۔ یہ سوال اٹھاتا ہے کہ ہم معلومات کی سالمیت کو کیسے یقینی بنا سکتے ہیں اور ہم باخبر فیصلے کرنے کے لیے اس پر کیسے بھروسہ کر سکتے ہیں۔ مثال کے طور پر یورپی یونین کے AI ایکٹ کے ساتھ، AI کا بامعنی ضابطہ اس وقت بہت اہم ہے۔ تاہم، ریگولیٹری پروپوزل کے موثر ہونے کے لیے جو طویل ٹائم لائن لگتی ہے اس کے بارے میں خدشات ہیں، ممکنہ طور پر ضروری کارروائیوں میں تاخیر ہو رہی ہے۔

Smouter AI الگورتھم میں زیادہ شفافیت اور جوابدہی کی ضرورت پر زور دیتا ہے۔ اس میں الگورتھم کو غیر ماہرین کے لیے زیادہ قابل فہم بنانا، ٹیسٹ کا انعقاد اور نتائج شائع کرنا، شکایت کے آزاد عمل قائم کرنا، وقتاً فوقتاً آڈٹ اور رپورٹنگ کرنا، اور ٹیکنالوجی کے ڈیزائن اور تعیناتی میں نسلی برادریوں کو شامل کرنا شامل ہے۔ اے آئی ایکٹ کا نفاذ، جو بنیادی حقوق کا نقطہ نظر لیتا ہے اور ازالے جیسے تصورات کو متعارف کرواتا ہے، تقریباً دو سالوں میں شروع ہونے کی امید ہے۔ اس ٹائم لائن کو کم کرنا بدعت کے لازمی پہلوؤں کے طور پر شفافیت اور جوابدہی کو برقرار رکھنے کے لیے فائدہ مند ہوگا۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ آٹوموٹو / ای وی، کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- بلاک آفسیٹس۔ ماحولیاتی آفسیٹ ملکیت کو جدید بنانا۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://www.forexnewsnow.com/fintech/the-urgency-of-addressing-ai-discrimination-transparency-accountability-and-regulatory-timelines/

- : ہے

- : ہے

- : نہیں

- :کہاں

- a

- کی صلاحیت

- ہمارے بارے میں

- تک رسائی حاصل

- احتساب

- کا اعتراف

- ایکٹ

- اعمال

- پتہ

- خطاب کرتے ہوئے

- اپنانے

- فائدہ مند

- منفی طور پر

- پر اثر انداز

- افریقی

- کے خلاف

- فرتیلی

- AI

- اے آئی ایکٹ

- اے آئی سسٹمز

- اے آئی کی تربیت

- یلگوردمز

- الزامات

- اگرچہ

- امریکی

- ایمسٹرڈیم

- an

- اور

- متوقع

- ایپل

- ایپل کارڈ

- ایپلی کیشنز

- نقطہ نظر

- منظوری

- تقریبا

- کیا

- مضمون

- مصنوعی

- مصنوعی ذہانت

- AS

- پہلوؤں

- تشخیص کریں

- تشخیص

- منسلک

- At

- آڈیو

- آڈٹ

- خودکار

- خودکار

- بینکنگ

- بینکنگ سیکٹر

- بینکوں

- کی بنیاد پر

- BE

- بن

- ہو جاتا ہے

- رہا

- پیچھے

- فائدہ

- فوائد

- تعصب

- باصلاحیت

- باضابطہ

- سیاہ

- blockchain

- جسم

- لاتا ہے

- وسیع

- by

- فون

- کر سکتے ہیں

- صلاحیتوں

- کارڈ

- کیس

- چیلنج

- چیلنجوں

- چیلنج

- چیٹ جی پی ٹی

- شکاگو

- بچے

- دعوے

- واضح

- CNBC

- کمیونٹی

- کمپنیاں

- مقابلے میں

- شکایت

- پیچیدہ

- پیچیدگیاں

- پیچیدگی

- تصورات

- اندراج

- چل رہا ہے

- سمیکن

- صارفین

- پر مشتمل ہے

- مواد

- برعکس

- شراکت

- روایتی

- coo

- تخلیق

- کریڈٹ

- معیار

- اہم

- کرپٹو

- خطرات

- اعداد و شمار

- ڈیٹا انفراسٹرکچر

- ڈیٹا انضمام

- ڈیٹا کی معیار

- بحث

- دہائیوں

- فیصلہ کرنا

- فیصلے

- آبادی

- شعبہ

- انحصار کرتا ہے

- تعیناتی

- ڈیزائن

- ڈیولپر

- ترقی

- مختلف

- مشکل

- مشکلات

- ڈائریکٹر

- دریافت

- تبعیض

- بحث

- تقسیم کئے

- تقسیم شدہ لیجر۔

- تقسیم شدہ لیجر ٹیکنالوجی

- ڈرائیونگ

- دو

- کے دوران

- ڈچ

- موثر

- مؤثر طریقے

- تاثیر

- ایمبیڈڈ

- ابھرتی ہوئی

- پر زور دیتا ہے

- احاطہ

- نافذ کرنے والے

- بڑھانے کے

- بہتر

- کو یقینی بنانے کے

- اندر

- خاص طور پر

- قیام

- اخلاقی

- اخلاقیات

- یورپی

- بھی

- ثبوت

- واضح

- مثال کے طور پر

- مثال کے طور پر

- تجربہ کار

- وضاحت کی

- بیان کرتا ہے

- دریافت کرتا ہے

- ایکسپریس

- چہرہ

- چہرے

- عوامل

- واقف

- خصوصیات

- چند

- فائلوں

- مالی

- مالیاتی صنعتیں

- مالیاتی ادارے

- مالیاتی خدمات

- فن ٹیک

- فنٹیک اسٹارٹ اپس

- fintechs

- FIS

- کے لئے

- سب سے اوپر

- سابق

- بکھری

- دھوکہ دہی

- سے

- بنیادی

- جنس

- نسل

- پیداواری

- پیداواری AI۔

- گلوبل

- گولڈن

- گولڈمین سیکس

- گوگل

- زیادہ سے زیادہ

- بڑھتے ہوئے

- نقصان پہنچانے

- ہے

- he

- سر

- بھاری

- روشنی ڈالی گئی

- انتہائی

- تاریخی

- کس طرح

- تاہم

- HTTPS

- شناخت

- کی نشاندہی

- پر عمل درآمد

- اثرات

- اہمیت

- مسلط کرنا

- in

- شامل

- شامل ہیں

- سمیت

- آزاد

- افراد

- صنعتوں

- صنعت

- اسماتایں

- معلومات

- مطلع

- انفراسٹرکچر

- ذاتی، پیدائشی

- جدت طرازی

- جدید

- ادارہ

- اداروں

- اٹوٹ

- انضمام

- سالمیت

- انٹیلی جنس

- انٹرویو

- میں

- متعارف کرواتا ہے

- شامل

- ملوث

- شامل

- مسئلہ

- مسائل

- IT

- میں

- علم

- نہیں

- زبان

- زبانیں

- بڑے

- قیادت

- معروف

- سیکھنے

- لیجر

- قرض دینے

- لیورنگنگ

- li

- جھوٹ ہے

- روشنی

- کی طرح

- لمیٹڈ

- حدود

- قرض

- قرض

- مقامی

- مقامی بینکس

- کم

- مشین

- مشین لرننگ

- مین

- بنا

- بنانا

- ماس

- مواد

- مئی..

- بامعنی

- ذکر کیا

- مائیکروسافٹ

- شاید

- غلط معلومات

- گمراہ کرنا

- ماڈل

- ماڈل

- جدید

- لمحہ

- اخلاقی

- زیادہ

- ایک سے زیادہ

- متحدہ

- فطرت، قدرت

- ضروری

- ضرورت ہے

- نیٹ ورک

- نئی

- NY

- نیویارک ریاست

- نیو یارک اسٹیٹ ڈیپارٹمنٹ آف ایسوسی ایشن

- غیر ماہرین

- قابل ذکر

- تعداد

- متعدد

- بے شمار فوائد

- حاصل کرنا

- of

- پیش کرتے ہیں

- کی پیشکش

- اکثر

- on

- آن لائن

- کام

- مواقع

- or

- باہر

- نتائج

- پینل

- پینل ڈسکشن

- حصہ

- گزشتہ

- ادائیگی

- کارکردگی

- متواتر

- شخصی

- نقطہ نظر

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پوائنٹ

- پوائنٹس

- ممکنہ

- ممکنہ طور پر

- پریکٹس

- بنیادی طور پر

- دبانے

- کی روک تھام

- مسئلہ

- عمل

- حاصل

- تجاویز

- تحفظ

- فراہم

- فراہم

- عوامی طور پر

- پبلشنگ

- مقاصد

- معیار

- سوالات

- ریس

- نسل پرستی

- اٹھایا

- اٹھاتا ہے

- تسلیم

- اٹ

- کو کم کرنے

- حوالہ جات

- کے بارے میں

- باضابطہ

- ریگولیشن

- ریگولیٹری

- انحصار کرو

- قابل ذکر

- رپورٹ

- پابندی

- نتائج کی نمائش

- انقلاب آگیا

- حقوق

- رسک

- خطرات

- سیکس

- سکینڈل

- اسکولوں

- اسکور

- اسکورنگ

- scraping کی

- شعبے

- منتخب

- انتخاب

- سروسز

- دکھایا گیا

- اہمیت

- اہم

- اسی طرح

- حل

- حل

- ماخذ

- بات

- مہارت

- شروع

- سترٹو

- حالت

- محکمہ خارجہ

- ابھی تک

- ذخیرہ

- طاقت

- اس طرح

- خلاصہ

- ارد گرد

- تیزی سے

- نظام پسند

- سسٹمز

- ٹیکل

- لیتا ہے

- ھدف بندی

- ٹیک

- ٹیک کمپنیوں

- تکنیکی ماہرین

- ٹیکنالوجی

- ٹیسٹ

- کہ

- ۔

- ماخذ

- ان

- وہاں.

- اس طرح

- یہ

- اس

- وقت لگتا

- ٹائم لائن

- ٹائم لائنز

- کرنے کے لئے

- اوزار

- موضوع

- ٹریننگ

- شفافیت

- ٹویٹر

- دو

- عام طور پر

- فہم

- لکھا ہوا

- غیر منصفانہ

- منفرد

- متحدہ

- متحدہ ممالک

- برعکس

- اونچا

- فوری طور پر

- استعمال کی شرائط

- استعمال کیا جاتا ہے

- مختلف

- ویڈیو

- بصیرت

- we

- Web3

- ویلفیئر

- تھے

- جب

- جس

- جبکہ

- ساتھ

- کے اندر

- خواتین

- دنیا

- مدنظر WorldPay

- فکر

- گا

- سال

- یارک

- زیفیرنیٹ