مصنوعی ذہانت کے تیزی سے ترقی پذیر میدان میں، قدرتی زبان کی پروسیسنگ محققین اور ڈویلپرز کے لیے یکساں طور پر ایک فوکل پوائنٹ بن گئی ہے۔ کی بنیادوں پر تعمیر ٹرانسفارمر فن تعمیر اور BERT کا دو طرفہ اپ گریڈ، حالیہ برسوں میں زبان کے بہت سے اہم نمونے سامنے آئے ہیں، جو مشینیں کیا سمجھ اور پیدا کر سکتی ہیں اس کی حدود کو آگے بڑھاتے ہیں۔

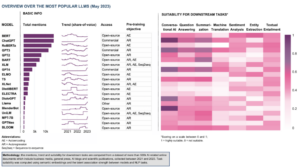

اس مضمون میں، ہم بڑے پیمانے پر زبان کے ماڈلز کی دنیا میں ہونے والی تازہ ترین پیشرفت کا جائزہ لیں گے، ہر ماڈل کے ذریعے متعارف کرائے گئے اضافہ، ان کی صلاحیتوں اور ممکنہ ایپلی کیشنز کو تلاش کریں گے۔ ہم بصری زبان کے ماڈلز (VLMs) کو بھی دیکھیں گے جو نہ صرف متنی بلکہ بصری ڈیٹا پر بھی کارروائی کرنے کے لیے تربیت یافتہ ہیں۔

اگر آپ اِدھر اُدھر چھوڑنا چاہتے ہیں، تو یہاں ہم نے نمایاں کردہ زبان کے ماڈلز ہیں:

- OpenAI کے ذریعے GPT-3

- گوگل کے ذریعہ LaMDA

- PaLM by Google

- فلیمنگو بذریعہ ڈیپ مائنڈ

- سیلز فورس کے ذریعے BLIP-2

- LLaMA بذریعہ Meta AI

- OpenAI کے ذریعے GPT-4

اگر یہ گہرائی والا تعلیمی مواد آپ کے لیے مفید ہے، تو آپ کر سکتے ہیں۔ ہماری AI ریسرچ میلنگ لسٹ کو سبسکرائب کریں۔ جب ہم نیا مواد جاری کرتے ہیں تو متنبہ کیا جائے۔

2023 میں سب سے اہم بڑی زبان کے ماڈل (LLMs) اور بصری زبان کے ماڈل (VLMs)

1. OpenAI کے ذریعے GPT-3

خلاصہ

OpenAI ٹیم نے GPT-3 کو ہر نئے زبان کے کام کے لیے لیبل لگا ڈیٹا سیٹ رکھنے کے متبادل کے طور پر متعارف کرایا۔ انہوں نے تجویز کیا کہ زبان کے ماڈلز کو بڑھانا ٹاسک-ایگنوسٹک چند شاٹ کارکردگی کو بہتر بنا سکتا ہے۔ اس تجویز کو جانچنے کے لیے، انہوں نے 175B-پیرامیٹر آٹوریگریسو لینگویج ماڈل کو تربیت دی، جسے کہا جاتا ہے۔ GPT-3، اور دو درجن سے زیادہ NLP کاموں پر اس کی کارکردگی کا جائزہ لیا۔ چند شاٹ لرننگ، ون شاٹ لرننگ، اور زیرو شاٹ لرننگ کے تحت ہونے والی تشخیص نے یہ ظاہر کیا کہ GPT-3 نے امید افزا نتائج حاصل کیے اور یہاں تک کہ کبھی کبھار عمدہ ماڈلز کے ذریعے حاصل کیے گئے جدید ترین نتائج سے بھی بہتر کارکردگی کا مظاہرہ کیا۔

مقصد کیا ہے؟

- موجودہ مسئلے کا متبادل حل تجویز کرنے کے لیے، جب ہر نئے زبان کے کام کے لیے لیبل والے ڈیٹاسیٹ کی ضرورت ہوتی ہے۔

مسئلہ کیسے حل کیا جاتا ہے؟

- محققین نے ٹاسک ایگنوسٹک چند شاٹ کارکردگی کو بہتر بنانے کے لیے زبان کے ماڈلز کو بڑھانے کا مشورہ دیا۔

- ۔ GPT-3 ماڈل اسی ماڈل اور فن تعمیر کو GPT-2 کے طور پر استعمال کرتا ہے، جس میں ترمیم شدہ ابتداء، پری نارملائزیشن، اور ریورس ایبل ٹوکنائزیشن شامل ہے۔

- تاہم، GPT-2 کے برعکس، یہ ٹرانسفارمر کی تہوں میں باری باری گھنے اور مقامی طور پر بینڈڈ ویرل توجہ کے نمونوں کا استعمال کرتا ہے، جیسا کہ اسپارس ٹرانسفارمر.

نتائج کیا ہیں؟

- GPT-3 ماڈل فائن ٹیوننگ کے بغیر متعدد NLP کاموں پر امید افزا نتائج حاصل کرتا ہے، اور یہاں تک کہ کبھی کبھار جدید ترین ماڈلز کو بھی پیچھے چھوڑ دیتا ہے جو اس مخصوص کام کے لیے ٹھیک بنائے گئے تھے:

- پر CoQA بینچ مارک، زیرو شاٹ سیٹنگ میں 81.5 F1، ون شاٹ سیٹنگ میں 84.0 F1، اور چند شاٹ سیٹنگ میں 85.0 F1، فائن ٹیونڈ SOTA کے حاصل کردہ 90.7 F1 سکور کے مقابلے۔

- پر ٹریویا کیو اے بینچ مارک، زیرو شاٹ سیٹنگ میں 64.3% درستگی، ون شاٹ سیٹنگ میں 68.0%، اور چند شاٹ سیٹنگ میں 71.2%، اسٹیٹ آف دی آرٹ (68%) کو 3.2% سے پیچھے چھوڑ دیا۔

- پر لامبڈا ڈیٹا سیٹ، زیرو شاٹ سیٹنگ میں 76.2% درستگی، ون شاٹ سیٹنگ میں 72.5%، اور چند شاٹ سیٹنگ میں 86.4%، اسٹیٹ آف دی آرٹ (68%) کو 18% سے پیچھے چھوڑ دیا۔

- 175B-پیرامیٹر GPT-3 ماڈل کے ذریعہ تخلیق کردہ خبروں کے مضامین کو حقیقی سے الگ کرنا مشکل ہے، انسانی تشخیص کے مطابق (درستگی کے ساتھ موقع کی سطح سے بمشکل ~52% پر)۔

- GPT-3 کی شاندار کارکردگی کے باوجود، اسے AI کمیونٹی سے ملے جلے جائزے ملے:

- "GPT-3 ہائپ بہت زیادہ ہے۔ یہ متاثر کن ہے (اچھی تعریفوں کے لیے شکریہ!) لیکن اس میں اب بھی سنگین کمزوریاں ہیں اور بعض اوقات بہت احمقانہ غلطیاں بھی کر دیتی ہیں۔ AI دنیا کو بدلنے والا ہے، لیکن GPT-3 صرف ایک ابتدائی جھلک ہے۔ ہمیں ابھی بہت کچھ معلوم کرنا ہے۔" - سیم آلٹ مین، OpenAI کے سی ای او اور شریک بانی.

- "میں حیران ہوں کہ GPT-3 سے مسلمانوں کے بارے میں ایسا متن بنانا کتنا مشکل ہے جس کا تشدد سے کوئی تعلق نہیں ہے... یا مارے جا رہے ہیں..." - ابوبکر عابد، سی ای او اور گریڈیو کے بانی.

- "نہیں. GPT-3 بنیادی طور پر اس دنیا کو نہیں سمجھتا جس کے بارے میں یہ بات کرتا ہے۔ کارپس کو مزید بڑھانے سے یہ ایک زیادہ قابل اعتماد پیسٹیچ پیدا کرنے کی اجازت دے گا لیکن اس کی دنیا کے بارے میں فہم کی بنیادی کمی کو دور نہیں کرے گا۔ GPT-4 کے ڈیمو کو اب بھی انسانی چیری چننے کی ضرورت ہوگی۔ - گیری مارکس، سی ای او اور Robust.ai کے بانی.

- "جی پی ٹی 3 کی شاندار کارکردگی کو مستقبل میں بڑھانا بتاتا ہے کہ زندگی، کائنات اور ہر چیز کا جواب صرف 4.398 ٹریلین پیرامیٹرز ہے۔" - جیفری ہنٹن، ٹورنگ ایوارڈ یافتہ.

اس تحقیق کے بارے میں مزید کہاں جانیں؟

آپ نفاذ کوڈ کہاں سے حاصل کر سکتے ہیں؟

- کوڈ بذات خود دستیاب نہیں ہے، لیکن GPT-2048 سے غیر مشروط، غیر فلٹر شدہ 3 ٹوکن نمونوں کے ساتھ ڈیٹاسیٹ کے کچھ اعدادوشمار جاری کیے گئے ہیں۔ GitHub کے.

2. گوگل کے ذریعہ LaMDA

خلاصہ

Laزبان Mکے لئے مثالیں Dآئیلاگ Aدرخواستیں (لا ایم ڈی اے) کو ٹرانسفارمر پر مبنی نیورل لینگویج ماڈلز کے ایک گروپ کو ٹھیک کرنے کے عمل کے ذریعے تخلیق کیا گیا تھا جو خاص طور پر مکالموں کے لیے تیار کیے گئے ہیں۔ ان ماڈلز میں زیادہ سے زیادہ 137B پیرامیٹرز ہیں اور انہیں علم کے بیرونی ذرائع استعمال کرنے کی تربیت دی گئی تھی۔ LaMDA ڈویلپرز کے ذہن میں تین اہم مقاصد تھے - معیار، حفاظت، اور بنیاد۔ نتائج نے ظاہر کیا کہ فائن ٹیوننگ معیار کے فرق کو انسانی سطح تک کم کرنے کی اجازت دیتی ہے، لیکن ماڈل کی کارکردگی حفاظت اور زمینی پن کے حوالے سے انسانی سطح سے نیچے رہی۔

گوگل کا بارڈ، جاری حال ہی میں ChatGPT کے متبادل کے طور پر، LaMDA کے ذریعے تقویت یافتہ ہے۔ بارڈ کو اکثر کے طور پر لیبل کرنے کے باوجود بورنگ، اسے تحفظ کو ترجیح دینے کے لیے گوگل کے عزم کے ثبوت کے طور پر دیکھا جا سکتا ہے، یہاں تک کہ تخلیقی AI کے میدان میں غلبہ قائم کرنے کے لیے گوگل اور مائیکروسافٹ کے درمیان شدید رقابت کے درمیان۔

مقصد کیا ہے؟

- اوپن ڈومین ڈائیلاگ ایپلی کیشنز کے لیے ایک ماڈل بنانے کے لیے، جہاں ایک ڈائیلاگ ایجنٹ کسی بھی موضوع کے بارے میں بات کرنے کے قابل ہو جس کے جوابات سمجھدار، سیاق و سباق کے لیے مخصوص، قابل اعتماد ذرائع پر مبنی ہوں، اور اخلاقی ہوں۔

مسئلہ کیسے حل کیا جاتا ہے؟

- LaMDA پر بنایا گیا ہے۔ ٹرانسفارمر، ایک نیورل نیٹ ورک فن تعمیر جسے گوگل ریسرچ نے 2017 میں ایجاد کیا اور اوپن سورس کیا۔

- BERT اور GPT-3 سمیت دیگر بڑے لینگویج ماڈلز کی طرح، LaMDA کو ٹیرا بائٹس ٹیکسٹ ڈیٹا پر تربیت دی جاتی ہے تاکہ یہ سیکھا جا سکے کہ الفاظ کا ایک دوسرے سے کیا تعلق ہے اور پھر یہ اندازہ لگایا جاتا ہے کہ آگے کون سے الفاظ آنے کا امکان ہے۔

- تاہم، زیادہ تر زبان کے ماڈلز کے برعکس، LaMDA کو مکالمے کی تربیت دی گئی تھی تاکہ وہ باریکیوں کو حاصل کر سکیں جو زبان کی دوسری شکلوں سے کھلی بات چیت کو ممتاز کرتی ہیں۔

- اس کے ردعمل کی حساسیت، حفاظت اور مخصوصیت کو بہتر بنانے کے لیے ماڈل کو بھی ٹھیک بنایا گیا ہے۔ اگرچہ "یہ اچھا ہے" اور "میں نہیں جانتا" جیسے جملے بہت سے ڈائیلاگ منظرناموں میں معنی خیز ہو سکتے ہیں، لیکن ان سے دلچسپ اور دل چسپ گفتگو کا امکان نہیں ہے۔

- LaMDA جنریٹر سب سے پہلے امیدواروں کے متعدد جوابات تیار کرتا ہے، جو تمام اسکور اس بنیاد پر کیے جاتے ہیں کہ وہ کتنے محفوظ، سمجھدار، مخصوص اور دلچسپ ہیں۔ کم حفاظتی اسکور والے جوابات کو فلٹر کر دیا جاتا ہے، اور پھر جواب کے طور پر اعلیٰ درجہ کا نتیجہ منتخب کیا جاتا ہے۔

نتائج کیا ہیں؟

- متعدد تجربات سے پتہ چلتا ہے کہ LaMDA مختلف موضوعات پر کھلے عام گفتگو میں حصہ لے سکتا ہے۔

- معیار کی جانچ کی ایک سیریز نے اس بات کی تصدیق کی کہ ماڈل کے جوابات سمجھدار، مخصوص، دلچسپ اور قابل اعتماد بیرونی ذرائع پر مبنی ہوتے ہیں لیکن بہتری کی گنجائش اب بھی باقی ہے۔

- اب تک کی تمام پیش رفت کے باوجود، مصنفین تسلیم کرتے ہیں کہ ماڈل میں اب بھی بہت سی حدود ہیں جن کے نتیجے میں نامناسب یا نقصان دہ ردعمل پیدا ہو سکتا ہے۔

اس تحقیق کے بارے میں مزید کہاں جانیں؟

آپ نفاذ کوڈ کہاں سے حاصل کر سکتے ہیں؟

- LaMDA کے پری ٹریننگ فن تعمیر کے لیے اوپن سورس PyTorch کا نفاذ دستیاب ہے۔ GitHub کے.

3. PaLM by Google

خلاصہ

Paراستے Lانگریزی Mمثال (کھجور) ایک 540-بلین پیرامیٹر ہے، ٹرانسفارمر پر مبنی لینگویج ماڈل۔ PaLM کو پاتھ ویز کا استعمال کرتے ہوئے 6144 TPU v4 چپس پر تربیت دی گئی، ایک سے زیادہ TPU Pods میں موثر تربیت کے لیے ایک نیا ML نظام۔ ماڈل چند شاٹ لرننگ میں اسکیلنگ کے فوائد کو ظاہر کرتا ہے، سینکڑوں زبانوں کی سمجھ اور نسل کے معیارات پر جدید ترین نتائج حاصل کرتا ہے۔ PaLM ملٹی سٹیپ استدلال کے کاموں پر جدید ترین ماڈلز کو پیچھے چھوڑتا ہے اور BIG-بینچ بینچ مارک پر اوسط انسانی کارکردگی سے زیادہ ہے۔

مقصد کیا ہے؟

- اس بات کی سمجھ کو بہتر بنانے کے لیے کہ کس طرح بڑے لینگویج ماڈلز کی اسکیلنگ چند شاٹ لرننگ کو متاثر کرتی ہے۔

مسئلہ کیسے حل کیا جاتا ہے؟

- کلیدی خیال پاتھ ویز سسٹم کے ساتھ 540 بلین پیرامیٹر لینگویج ماڈل کی تربیت کو پیمانہ کرنا ہے:

- ٹیم دو Cloud TPU v4 Pods میں Pod کی سطح پر ڈیٹا کی ہم آہنگی کا استعمال کر رہی تھی جبکہ ہر Pod کے اندر معیاری ڈیٹا اور ماڈل کی ہم آہنگی کا استعمال کر رہی تھی۔

- وہ ٹریننگ کو 6144 TPU v4 چپس تک سکیل کرنے کے قابل تھے، جو آج تک کی ٹریننگ کے لیے استعمال ہونے والی سب سے بڑی TPU پر مبنی سسٹم کنفیگریشن ہے۔

- ماڈل نے 57.8% ہارڈویئر FLOPs کے استعمال کی تربیتی کارکردگی حاصل کی، جو کہ مصنفین کا دعویٰ ہے، اس پیمانے پر بڑے لینگویج ماڈلز کے لیے ابھی تک سب سے زیادہ حاصل شدہ تربیتی کارکردگی ہے۔

- PaLM ماڈل کے تربیتی ڈیٹا میں انگریزی اور کثیر لسانی ڈیٹاسیٹس کا مجموعہ شامل ہے جس میں اعلیٰ معیار کی ویب دستاویزات، کتابیں، ویکیپیڈیا، گفتگو، اور GitHub کوڈ شامل ہیں۔

نتائج کیا ہیں؟

- متعدد تجربات یہ ظاہر کرتے ہیں کہ ماڈل کی کارکردگی میں تیزی سے اضافہ ہوا ہے کیونکہ ٹیم نے اپنے سب سے بڑے ماڈل تک پہنچایا ہے۔

- PaLM 540B نے متعدد انتہائی مشکل کاموں پر کامیابی حاصل کی:

- زبان کی سمجھ اور نسل. متعارف کرائے گئے ماڈل نے 28 میں سے 29 کاموں پر پہلے بڑے ماڈلز کی چند شاٹ کارکردگی کو پیچھے چھوڑ دیا جس میں سوال جواب دینے والے کام، بند اور جملے کی تکمیل کے کام، سیاق و سباق میں پڑھنے کے فہم کے کام، عام فہم استدلال کے کام، SuperGLUE کام، اور شامل ہیں۔ مزید. BIG- بنچ کے کاموں پر PaLM کی کارکردگی نے ظاہر کیا کہ یہ وجہ اور اثر میں فرق کر سکتا ہے، نیز مناسب سیاق و سباق میں تصوراتی امتزاج کو سمجھ سکتا ہے۔

- استدلال۔. 8 شاٹ پرامپٹنگ کے ساتھ، PaLM GSM58K میں 8% مسائل کو حل کرتا ہے، جو کہ گریڈ اسکول لیول کے ہزاروں چیلنجنگ ریاضی کے سوالات کا ایک معیار ہے، GPT-55 3B ماڈل کو فائن ٹیوننگ کے ذریعے حاصل کیے گئے 175% کے پہلے اسکور کو پیچھے چھوڑتا ہے۔ PaLM ایسے حالات میں واضح وضاحتیں پیدا کرنے کی صلاحیت کا بھی مظاہرہ کرتا ہے جن کے لیے کثیر مرحلہ منطقی تخمینہ، عالمی علم، اور زبان کی گہری سمجھ کے پیچیدہ امتزاج کی ضرورت ہوتی ہے۔

- کوڈ جنریشن. PaLM تربیت کے لیے 12 گنا کم Python کوڈ استعمال کرتے ہوئے فائن ٹیونڈ Codex 50B کے برابر کارکردگی کا مظاہرہ کرتا ہے، اس بات کی تصدیق کرتا ہے کہ بڑے لینگویج ماڈلز دوسری پروگرامنگ زبانوں اور قدرتی زبان کے ڈیٹا دونوں سے سیکھنے کو زیادہ مؤثر طریقے سے منتقل کرتے ہیں۔

اس تحقیق کے بارے میں مزید کہاں جانیں؟

آپ نفاذ کوڈ کہاں سے حاصل کر سکتے ہیں؟

- PaLM ریسرچ پیپر سے مخصوص ٹرانسفارمر فن تعمیر کا ایک غیر سرکاری PyTorch نفاذ دستیاب ہے۔ GitHub کے. یہ پیمانہ نہیں ہوگا اور صرف تعلیمی مقاصد کے لیے شائع کیا گیا ہے۔

4. ڈیپ مائنڈ کے ذریعہ فلیمنگو

خلاصہ

فلیمنگو بصری زبان کے ماڈلز (VLMs) کا ایک جدید خاندان ہے، جو مخلوط متن اور تصاویر کے ساتھ بڑے پیمانے پر ملٹی موڈل ویب کارپورا پر تربیت یافتہ ہے۔ اس تربیت کے ساتھ، ماڈل کم سے کم تشریح شدہ مثالوں کا استعمال کرتے ہوئے نئے کاموں کے مطابق ڈھال سکتے ہیں، جو فوری طور پر فراہم کی گئی ہیں۔ فلیمنگو کلیدی تعمیراتی پیشرفت کو شامل کرتا ہے جو پہلے سے تربیت یافتہ وژن صرف اور صرف زبان کے ماڈلز کی طاقتوں کو ضم کرنے کے لیے ڈیزائن کیا گیا ہے، متغیر طور پر باہم منسلک بصری اور متنی ڈیٹا کے عمل کی ترتیب، اور بغیر کسی رکاوٹ کے ان پٹ کے طور پر تصاویر یا ویڈیوز کو ایڈجسٹ کرتا ہے۔ یہ ماڈل تصویری اور ویڈیو کاموں کی ایک حد کے لیے متاثر کن موافقت کا مظاہرہ کرتے ہیں جیسے کہ بصری سوال کا جواب دینا، عنوان دینے والے کام، اور متعدد انتخابی بصری سوالوں کے جوابات، چند شاٹ لرننگ میں ٹاسک کے مخصوص اشارے کا استعمال کرتے ہوئے کارکردگی کے نئے معیارات مرتب کرنا۔

مقصد کیا ہے؟

- مختصر ہدایات کی بنیاد پر ملٹی موڈل ماڈلز کو تیزی سے سیکھنے اور نئے کام انجام دینے کے قابل بنانے کی طرف پیش رفت کرنے کے لیے:

- بڑے پیمانے پر زیر استعمال ڈیٹا پر ایک ماڈل کو پہلے سے تربیت دینے، پھر اسے مخصوص کام کے لیے ٹھیک کرنے کا وسیع پیمانے پر استعمال ہونے والا نمونہ وسائل کے لحاظ سے بہت زیادہ ہے اور اس کے لیے محتاط فی ٹاسک ہائپر پیرامیٹر ٹیوننگ کے ساتھ ہزاروں تشریح شدہ ڈیٹا پوائنٹس کی ضرورت ہوتی ہے۔

- موجودہ ماڈلز جو متضاد مقصد کا استعمال کرتے ہیں وہ نئے کاموں میں صفر شاٹ موافقت کی اجازت دیتے ہیں لیکن زیادہ کھلے کاموں جیسے کیپشننگ یا بصری سوالوں کے جوابات میں کمی کرتے ہیں کیونکہ ان میں زبان کی تخلیق کی صلاحیتوں کی کمی ہے۔

- اس تحقیق کا مقصد ایک نیا ماڈل متعارف کرانا ہے جو ان مسائل کو مؤثر طریقے سے حل کرتا ہے اور کم ڈیٹا والے نظاموں میں اعلیٰ کارکردگی کا مظاہرہ کرتا ہے۔

مسئلہ کیسے حل کیا جاتا ہے؟

- ڈیپ مائنڈ نے صرف چند ان پٹ/آؤٹ پٹ مثالوں کا استعمال کرتے ہوئے، مختلف اوپن اینڈ ویژن اور زبان کے کاموں پر چند شاٹ لرننگ کے لیے ڈیزائن کیے گئے فلیمنگو، VLM متعارف کرائے ہیں۔

- فلیمنگو ماڈل بصری طور پر کنڈیشنڈ آٹوریگریسو ٹیکسٹ جنریشن ماڈل ہیں جو امیجز اور/یا ویڈیوز کے ساتھ ملا کر ٹیکسٹ ٹوکن پر کارروائی کر سکتے ہیں اور آؤٹ پٹ کے طور پر ٹیکسٹ تیار کر سکتے ہیں۔

- فلیمنگو کے فن تعمیر میں دو تکمیلی پہلے سے تربیت یافتہ اور منجمد ماڈل شامل ہیں:

- ایک وژن ماڈل جو بصری مناظر کو "سمجھنے" کے قابل ہے۔

- بنیادی استدلال کو انجام دینے کے ساتھ ایک بڑا زبان کا ماڈل۔

- نوول فن تعمیر کے اجزاء ان ماڈلز کو اس طرح مربوط کرتے ہیں جو ان کی کمپیوٹیشنل طور پر گہری پری ٹریننگ کے دوران حاصل کردہ علم کو برقرار رکھتا ہے۔

- اس کے علاوہ، فلیمنگو ماڈلز پرسیور پر مبنی فن تعمیر کی خصوصیت رکھتے ہیں، جس سے وہ اعلیٰ ریزولوشن والی تصاویر یا ویڈیوز کو نگل سکتے ہیں۔ یہ فن تعمیر بصری ان پٹ خصوصیات کی ایک وسیع اور متغیر صف سے فی تصویر/ویڈیو کے لیے ایک مقررہ تعداد میں بصری ٹوکن تیار کر سکتا ہے۔

نتائج کیا ہیں؟

- تحقیق سے پتہ چلتا ہے کہ ایل ایل ایم کی طرح، جو چند شاٹ سیکھنے والے اچھے ہیں، وی ایل ایم تصویر اور ویڈیو کو سمجھنے کے کاموں کے لیے چند ان پٹ/آؤٹ پٹ مثالوں سے سیکھ سکتے ہیں جیسے درجہ بندی، کیپشننگ، یا سوال جواب۔

- فلیمنگو چند شاٹ لرننگ میں ایک نیا بینچ مارک قائم کرتا ہے، 16 ملٹی موڈل زبان اور تصویر/ویڈیو کو سمجھنے کے کاموں کی وسیع رینج پر اعلیٰ کارکردگی کا مظاہرہ کرتا ہے۔

- ان 6 میں سے 16 کاموں کے لیے، فلیمنگو فن کی بہترین کارکردگی کو پیچھے چھوڑ دیتا ہے، حالانکہ یہ صرف 32 کام کے لیے مخصوص مثالوں کا استعمال کرتا ہے – موجودہ اعلیٰ کارکردگی والے ماڈلز سے تقریباً 1000 گنا کم ٹاسک کے لیے مخصوص تربیتی ڈیٹا۔

اس تحقیق کے بارے میں مزید کہاں جانیں؟

آپ نفاذ کوڈ کہاں سے حاصل کر سکتے ہیں؟

- ڈیپ مائنڈ نے فلیمنگو کے باضابطہ نفاذ کو جاری نہیں کیا۔

- آپ کو میں متعارف کرائے گئے نقطہ نظر کا اوپن سورس نفاذ مل سکتا ہے۔ اوپن فلیمنگو گیتھب ریپو.

- متبادل PyTorch نفاذ دستیاب ہے۔ یہاں.

5. سیلز فورس کے ذریعے BLIP-2

خلاصہ

BLIP-2 وژن اور زبان کے ماڈلز کے لیے ایک موثر اور عام پری ٹریننگ فریم ورک ہے، جو بڑے پیمانے پر ماڈلز کی پری ٹریننگ کی بڑھتی ہوئی ممنوعہ لاگت کو روکنے کے لیے ڈیزائن کیا گیا ہے۔ BLIP-2 وژن کی زبان کی پری ٹریننگ کو بوٹسٹریپ کرنے کے لیے آف دی شیلف منجمد پری ٹرینڈ امیج انکوڈرز اور منجمد بڑے لینگویج ماڈلز کا فائدہ اٹھاتا ہے، جس میں دو مراحل میں پہلے سے تربیت یافتہ ایک ہلکا پھلکا Querying Transformer شامل ہوتا ہے۔ پہلا مرحلہ منجمد امیج انکوڈر سے وژن کی زبان کی نمائندگی سیکھنے کا آغاز کرتا ہے، اور دوسرا مرحلہ منجمد لینگویج ماڈل سے وژن ٹو لینگویج جنریٹو سیکھنے کو آگے بڑھاتا ہے۔ قابل ذکر حد تک کم تربیت کے قابل پیرامیٹرز ہونے کے باوجود، BLIP-2 جدید ترین طریقوں سے بہتر کارکردگی کا مظاہرہ کرتا ہے، جس نے ڈیپ مائنڈ کے Flamingo80B کو زیرو شاٹ VQAv8.7 پر 2x کم قابل تربیت پیرامیٹرز کے ساتھ 54 فیصد سے پیچھے چھوڑ دیا۔ یہ ماڈل قدرتی زبان کی ہدایات پر عمل کرتے ہوئے زیرو شاٹ امیج ٹو ٹیکسٹ جنریشن کی صلاحیتوں کو بھی ظاہر کرتا ہے۔

مقصد کیا ہے؟

- وژن لینگویج کے کاموں پر جدید ترین کارکردگی حاصل کرنے کے لیے، جبکہ حسابی لاگت کو کم کرنا۔

مسئلہ کیسے حل کیا جاتا ہے؟

- سیلز فورس ٹیم نے ایک نیا وژن لینگویج پری ٹریننگ فریم ورک متعارف کرایا جس کا نام BLIP-2 ہے، Bاوٹسٹریپنگ Lزبان -Image Pمنجمد یونی موڈل ماڈلز کے ساتھ دوبارہ تربیت:

- کمپیوٹیشن لاگت کو کم کرنے اور تباہ کن بھول جانے کے مسئلے سے بچنے کے لیے پہلے سے تربیت یافتہ یونی موڈل ماڈلز پری ٹریننگ کے دوران منجمد رہتے ہیں۔

- کراس موڈل الائنمنٹ کو سہولت فراہم کرنے اور پہلے سے تربیت یافتہ وژن ماڈلز اور پہلے سے تربیت یافتہ لینگویج ماڈلز کے درمیان موڈالٹی فرق کو پر کرنے کے لیے، ٹیم نے ایک ہلکا پھلکا Querying Transformer (Q-Former) تجویز کیا جو منجمد امیج انکوڈر اور منجمد کے درمیان معلوماتی رکاوٹ کے طور پر کام کرتا ہے۔ ایل ایل ایم۔

- Q-سابق ایک نئی دو مراحل کی حکمت عملی کے ساتھ پہلے سے تربیت یافتہ ہے:

- تربیت سے پہلے کا پہلا مرحلہ بصارت کی زبان کی نمائندگی کا کام انجام دیتا ہے۔ یہ Q-Former کو متن سے سب سے زیادہ متعلقہ بصری نمائندگی سیکھنے پر مجبور کرتا ہے۔

- دوسرا پری ٹریننگ مرحلہ Q-Former کے آؤٹ پٹ کو منجمد LLM سے جوڑ کر وژن سے زبان میں جنریٹو لرننگ انجام دیتا ہے۔ Q-Former کو اس طرح تربیت دی جاتی ہے کہ اس کی آؤٹ پٹ بصری نمائندگی کی تشریح LLM کے ذریعے کی جا سکے۔

نتائج کیا ہیں؟

- BLIP-2 وژن کی زبان کے مختلف کاموں میں غیر معمولی، جدید ترین نتائج فراہم کرتا ہے، جس میں بصری سوالوں کے جوابات، تصویری کیپشننگ، اور تصویری متن کی بازیافت شامل ہیں۔

- مثال کے طور پر، یہ صفر شاٹ VQAv8.7 پر فلیمنگو کو 2 فیصد سے پیچھے چھوڑ دیتا ہے۔

- مزید یہ کہ، یہ شاندار کارکردگی نمایاں طور پر اعلیٰ کمپیوٹر کی کارکردگی کے ساتھ حاصل کی جاتی ہے:

- BLIP-2 80× کم قابل تربیت پیرامیٹرز استعمال کرتے ہوئے Flamingo-54B کو پیچھے چھوڑ دیتا ہے۔

- BLIP-2 قدرتی زبان کی ہدایات کے جواب میں زیرو شاٹ امیج ٹو ٹیکسٹ جنریشن کرنے کی صلاحیت رکھتا ہے، اس طرح بصری علم کی استدلال اور دوسروں کے درمیان بصری گفتگو جیسی مہارتوں کو فروغ دینے کی راہ ہموار ہوتی ہے۔

- آخر میں، یہ نوٹ کرنا ضروری ہے کہ BLIP-2 ایک ورسٹائل اپروچ ہے جو وژن لینگویج پری ٹریننگ کی کارکردگی کو مزید بہتر بنانے کے لیے زیادہ نفیس یکساں ماڈلز کا فائدہ اٹھا سکتا ہے۔

اس تحقیق کے بارے میں مزید کہاں جانیں؟

آپ نفاذ کوڈ کہاں سے حاصل کر سکتے ہیں؟

سرکاری BLIP-2 کا نفاذ دستیاب ہے۔ GitHub کے.

6. LLaMA بذریعہ Meta AI

خلاصہ

Meta AI ٹیم کا دعویٰ ہے کہ زیادہ ٹوکنز پر تربیت یافتہ چھوٹے ماڈلز کو دوبارہ تربیت دینا اور مخصوص پروڈکٹ ایپلی کیشنز کے لیے ٹھیک کرنا آسان ہے۔ لہذا، وہ متعارف کراتے ہیں لاما (Lآرج Laزبان Mاوڈیل میٹا AI)، 7B سے 65B پیرامیٹرز کے ساتھ بنیادی زبان کے ماڈلز کا مجموعہ۔ LLaMA 33B اور 65B کو 1.4 ٹریلین ٹوکنز پر تربیت دی گئی، جبکہ سب سے چھوٹے ماڈل، LLaMA 7B کو ایک ٹریلین ٹوکنز پر تربیت دی گئی۔ انہوں نے ملکیتی یا محدود ڈیٹا پر انحصار کیے بغیر، خصوصی طور پر عوامی طور پر دستیاب ڈیٹا سیٹس کا استعمال کیا۔ ٹیم نے اہم تعمیراتی اضافہ اور تربیت کی رفتار کو بہتر بنانے کی تکنیکوں کو بھی نافذ کیا۔ نتیجتاً، LLaMA-13B نے 3 گنا سے زیادہ چھوٹا ہونے کی وجہ سے GPT-10 کو پیچھے چھوڑ دیا، اور LLaMA-65B نے PaLM-540B کے ساتھ مسابقتی کارکردگی کا مظاہرہ کیا۔

مقصد کیا ہے؟

- ملکیتی یا محدود ڈیٹا کے ذرائع پر انحصار کیے بغیر، صرف عوامی طور پر قابل رسائی ڈیٹا سیٹس پر اعلیٰ کارکردگی کا مظاہرہ کرنے والے ماڈلز کی تربیت کی فزیبلٹی کو ظاہر کرنے کے لیے۔

- تحقیقی کمیونٹی کو چھوٹے اور زیادہ پرفارمنس ماڈل فراہم کرنے کے لیے اور اس طرح، ان لوگوں کو قابل بنانا جن کے پاس بنیادی ڈھانچے کی بڑی مقدار تک رسائی نہیں ہے، بڑے زبان کے ماڈلز کا مطالعہ کرنے کے لیے۔

مسئلہ کیسے حل کیا جاتا ہے؟

- LLaMA ماڈل کو تربیت دینے کے لیے، محققین نے صرف وہ ڈیٹا استعمال کیا جو عوامی طور پر دستیاب ہے، اور اوپن سورسنگ کے ساتھ مطابقت رکھتا ہے۔

- انہوں نے معیاری ٹرانسفارمر فن تعمیر میں کچھ بہتری بھی متعارف کروائی ہے:

- GPT-3 طریقہ کار کو اپناتے ہوئے، تربیت کے استحکام کو آؤٹ پٹ کو معمول پر لانے کے بجائے ہر ٹرانسفارمر ذیلی پرت کے لیے ان پٹ کو معمول پر لا کر بڑھایا گیا۔

- PaLM ماڈلز سے متاثر ہو کر، محققین نے کارکردگی کو بہتر بنانے کے لیے ReLU غیر خطی کو SwiGLU ایکٹیویشن فنکشن سے بدل دیا۔

- طرف سے حوصلہ افزائی Su et al (2021)، انہوں نے مطلق پوزیشنی ایمبیڈنگز کو ختم کیا اور اس کے بجائے، نیٹ ورک کی ہر پرت پر روٹری پوزیشنل ایمبیڈنگز (RoPE) کو شامل کیا۔

- آخر کار، میٹا اے آئی ٹیم نے اپنے ماڈل کی تربیت کی رفتار کو بذریعہ بہتر بنایا:

- توجہ کے وزن کو ذخیرہ نہ کرکے یا ماسکڈ کلید/ استفسار کے اسکورز کو کمپیوٹنگ کرکے موثر کازل ملٹی ہیڈ توجہ کے نفاذ کا استعمال۔

- پسماندہ پاس کے دوران دوبارہ گنتی کی سرگرمیوں کو کم سے کم کرنے کے لیے چیک پوائنٹ کا استعمال۔

- نیٹ ورک پر ایکٹیویشنز کی گنتی اور GPUs کے درمیان مواصلت کو اوور لیپ کرنا (آل_ریڈیوس آپریشنز کی وجہ سے)۔

نتائج کیا ہیں؟

- LLaMA-13B 3 گنا سے زیادہ چھوٹا ہونے کے باوجود GPT-10 کو پیچھے چھوڑ دیتا ہے، جب کہ LLaMA-65B PaLM-540B کے مقابلے میں اپنی حیثیت رکھتا ہے۔

اس تحقیق کے بارے میں مزید کہاں جانیں؟

آپ نفاذ کوڈ کہاں سے حاصل کر سکتے ہیں؟

- Meta AI انفرادی کیس کی تشخیص کی بنیاد پر تعلیمی محققین، حکومت، سول سوسائٹی، تعلیمی اداروں، اور عالمی صنعت کی تحقیقی لیبز سے وابستہ افراد کو LLaMA تک رسائی فراہم کرتا ہے۔ درخواست دینے کے لیے، درج ذیل پر جائیں۔ GitHub ذخیرہ.

7. OpenAI کے ذریعے GPT-4

خلاصہ

GPT-4 ایک بڑے پیمانے پر ملٹی موڈل ماڈل ہے جو امیج اور ٹیکسٹ ان پٹس کو قبول کرتا ہے اور ٹیکسٹ آؤٹ پٹ تیار کرتا ہے۔ مسابقتی اور حفاظتی خدشات کی وجہ سے، ماڈل کے فن تعمیر اور تربیت کے بارے میں مخصوص تفصیلات کو روک دیا گیا ہے۔ کارکردگی کے لحاظ سے، GPT-4 روایتی بینچ مارکس پر زبان کے پچھلے ماڈلز کو پیچھے چھوڑتا ہے اور صارف کے ارادے کی سمجھ اور حفاظتی خصوصیات میں نمایاں بہتری دکھاتا ہے۔ یہ ماڈل مختلف امتحانات میں انسانی سطح کی کارکردگی بھی حاصل کرتا ہے، بشمول نقلی یونیفارم بار امتحان میں ٹاپ 10% سکور۔

مقصد کیا ہے؟

- ایک بڑے پیمانے پر ملٹی موڈل ماڈل تیار کرنے کے لیے جو امیج اور ٹیکسٹ ان پٹ کو قبول کر سکے اور ٹیکسٹ آؤٹ پٹ تیار کر سکے۔

- بنیادی ڈھانچے اور اصلاح کے طریقوں کو تیار کرنا جو ترازو کی وسیع رینج میں متوقع طور پر برتاؤ کرتے ہیں۔

مسئلہ کیسے حل کیا جاتا ہے؟

- مسابقتی زمین کی تزئین اور حفاظتی مضمرات کی وجہ سے، OpenAI نے فن تعمیر، ماڈل سائز، ہارڈ ویئر، ٹریننگ کمپیوٹ، ڈیٹا سیٹ کی تعمیر، اور تربیت کے طریقوں کی تفصیلات کو روکنے کا فیصلہ کیا۔

- وہ انکشاف کرتے ہیں کہ:

- GPT-4 ایک ٹرانسفارمر پر مبنی ماڈل ہے، جو کسی دستاویز میں اگلے ٹوکن کی پیشن گوئی کرنے کے لیے پہلے سے تربیت یافتہ ہے۔

- یہ عوامی طور پر دستیاب ڈیٹا اور تیسرے فریق کے لائسنس یافتہ ڈیٹا کا استعمال کرتا ہے۔

- Reinforcement Learning from Human Feedback (RLHF) کا استعمال کرتے ہوئے ماڈل کو ٹھیک بنایا گیا تھا۔

- غیر مصدقہ معلومات سے پتہ چلتا ہے کہ GPT-4 اپنے پیشروؤں کی طرح ایک واحد گھنے ماڈل نہیں ہے، بلکہ آٹھ الگ الگ ماڈلز کا پاور ہاؤس اتحاد ہے، ہر ایک حیران کن 220 بلین پیرامیٹرز پیک کرتا ہے۔

نتائج کیا ہیں؟

- GPT-4 زیادہ تر پیشہ ورانہ اور تعلیمی امتحانات میں انسانی سطح کی کارکردگی کو حاصل کرتا ہے، خاص طور پر نقلی یکساں بار کے امتحان میں سب سے اوپر 10% میں اسکور حاصل کرتا ہے۔

- پہلے سے تربیت یافتہ بیس GPT-4 ماڈل موجودہ لینگویج ماڈلز اور روایتی NLP بینچ مارکس پر پہلے کے جدید ترین سسٹمز سے بہتر کارکردگی کا مظاہرہ کرتا ہے، بغیر بینچ مارک مخصوص کرافٹنگ یا اضافی تربیتی پروٹوکول کے۔

- GPT-4 مندرجہ ذیل صارف کے ارادے میں کافی بہتری کا مظاہرہ کرتا ہے، جس کے جوابات کو ChatGPT اور OpenAI API کے 3.5 پرامپٹس میں سے 70.2% میں GPT-5,214 کے جوابات پر ترجیح دی جاتی ہے۔

- GPT-4 کی حفاظتی خصوصیات GPT-3.5 کے مقابلے میں نمایاں طور پر بہتر ہوئی ہیں، جس میں مواد کی نامنظور درخواستوں کا جواب دینے میں 82% کمی اور حساس درخواستوں (مثلاً طبی مشورہ اور خود کو نقصان پہنچانے) کے لیے پالیسیوں کی تعمیل میں 29% اضافہ ہوا ہے۔

اس تحقیق کے بارے میں مزید کہاں جانیں؟

آپ نفاذ کوڈ کہاں سے حاصل کر سکتے ہیں؟

- GPT-4 کے کوڈ کا نفاذ دستیاب نہیں ہے۔

بڑے (وژن) زبان کے ماڈلز کی حقیقی دنیا کی ایپلی کیشنز

حالیہ برسوں کی سب سے اہم AI تحقیقی کامیابیاں بڑے ڈیٹا سیٹس پر تربیت یافتہ بڑے AI ماڈلز سے آتی ہیں۔ یہ ماڈل متاثر کن کارکردگی کا مظاہرہ کرتے ہیں، اور یہ سوچنا دلکش ہے کہ کس طرح AI پوری صنعتوں، جیسے کسٹمر سروس، مارکیٹنگ، ای کامرس، صحت کی دیکھ بھال، سافٹ ویئر ڈویلپمنٹ، صحافت، اور بہت سی دوسری صنعتوں میں انقلاب لا سکتا ہے۔

بڑے زبان کے ماڈلز میں حقیقی دنیا کی متعدد ایپلی کیشنز ہوتی ہیں۔ GPT-4 درج ذیل فہرست کرتا ہے:

- چیٹ بوٹس اور ورچوئل اسسٹنٹس کے لیے فطری زبان کی سمجھ اور نسل۔

- زبانوں کے درمیان مشینی ترجمہ۔

- مضامین، رپورٹس، یا دیگر متنی دستاویزات کا خلاصہ۔

- مارکیٹ ریسرچ یا سوشل میڈیا مانیٹرنگ کے لیے جذباتی تجزیہ۔

- مارکیٹنگ، سوشل میڈیا، یا تخلیقی تحریر کے لیے مواد تیار کرنا۔

- کسٹمر سپورٹ یا علمی بنیادوں کے لیے سوال جواب دینے والے نظام۔

- اسپام فلٹرنگ، موضوع کی درجہ بندی، یا دستاویز کی تنظیم کے لیے متن کی درجہ بندی۔

- ذاتی زبان سیکھنے اور ٹیوشن ٹولز۔

- کوڈ جنریشن اور سافٹ ویئر ڈویلپمنٹ میں مدد۔

- طبی، قانونی، اور تکنیکی دستاویزات کا تجزیہ اور مدد۔

- معذور افراد کے لیے قابل رسائی ٹولز، جیسے کہ متن سے تقریر اور تقریر سے متن کی تبدیلی۔

- تقریر کی شناخت اور نقل کی خدمات۔

اگر ہم ایک بصری حصہ شامل کرتے ہیں، تو ممکنہ ایپلی کیشنز کے شعبے مزید پھیلتے ہیں:

حالیہ AI کامیابیوں کی پیروی کرنا اور ان کی ممکنہ حقیقی دنیا کی ایپلی کیشنز کے بارے میں سوچنا بہت دلچسپ ہے۔ تاہم، ان ماڈلز کو حقیقی زندگی میں تعینات کرنے سے پہلے ہمیں متعلقہ خطرات اور حدود کو دور کرنے کی ضرورت ہے، جو بدقسمتی سے کافی اہم ہیں۔

خطرات اور حدود

اگر آپ GPT-4 سے اس کے خطرات اور حدود کے بارے میں پوچھتے ہیں، تو یہ ممکنہ طور پر آپ کو متعلقہ خدشات کی ایک طویل فہرست فراہم کرے گا۔ اس فہرست کو فلٹر کرنے اور کچھ اضافی تحفظات شامل کرنے کے بعد، میں نے جدید بڑے لینگوئج ماڈلز کے پاس درج ذیل کلیدی خطرات اور حدود کا خاتمہ کیا ہے۔

- تعصب اور امتیازی سلوک: یہ ماڈل متنی ڈیٹا کی وسیع مقدار سے سیکھتے ہیں، جس میں اکثر تعصب اور امتیازی مواد ہوتا ہے۔ نتیجے کے طور پر، پیدا شدہ نتائج نادانستہ طور پر دقیانوسی تصورات، جارحانہ زبان، اور جنس، نسل یا مذہب جیسے عوامل کی بنیاد پر امتیازی سلوک کو برقرار رکھ سکتے ہیں۔

- غلط معلومات: بڑے زبان کے ماڈلز ایسا مواد تیار کر سکتے ہیں جو حقیقت میں غلط، گمراہ کن یا پرانا ہو۔ اگرچہ ماڈلز کو مختلف ذرائع سے تربیت دی جاتی ہے، لیکن وہ ہمیشہ درست یا تازہ ترین معلومات فراہم نہیں کر سکتے۔ اکثر ایسا ہوتا ہے کیونکہ ماڈل ایسے آؤٹ پٹ کو ترجیح دیتا ہے جو گرائمر کے لحاظ سے درست ہوں یا ہم آہنگ معلوم ہوں، چاہے وہ گمراہ کن ہوں۔

- تفہیم کا فقدان: اگرچہ یہ ماڈلز انسانی زبان کو سمجھتے دکھائی دیتے ہیں، لیکن یہ بنیادی طور پر تربیتی ڈیٹا میں پیٹرن اور شماریاتی ایسوسی ایشنز کی نشاندہی کرکے کام کرتے ہیں۔ وہ اپنے تیار کردہ مواد کی گہری سمجھ نہیں رکھتے ہیں، جس کے نتیجے میں بعض اوقات بے ہودہ یا غیر متعلقہ نتائج برآمد ہوتے ہیں۔

- نامناسب مواد: زبان کے ماڈل بعض اوقات ایسا مواد تیار کر سکتے ہیں جو ناگوار، نقصان دہ، یا نامناسب ہو۔ اگرچہ اس طرح کے مواد کو کم سے کم کرنے کی کوششیں کی جاتی ہیں، لیکن یہ تربیتی ڈیٹا کی نوعیت اور ماڈلز کے سیاق و سباق یا صارف کے ارادے کو سمجھنے میں ناکامی کی وجہ سے اب بھی ہو سکتا ہے۔

نتیجہ

بڑے لینگویج ماڈلز نے بلاشبہ قدرتی لینگویج پروسیسنگ کے شعبے میں انقلاب برپا کیا ہے اور مختلف کرداروں اور صنعتوں میں پیداواری صلاحیت کو بڑھانے میں بے پناہ صلاحیت کا مظاہرہ کیا ہے۔ انسان جیسا متن بنانے، دنیاوی کاموں کو خودکار بنانے، اور تخلیقی اور تجزیاتی عمل میں مدد فراہم کرنے کی ان کی صلاحیت نے انہیں آج کی تیز رفتار، ٹیکنالوجی سے چلنے والی دنیا میں ناگزیر اوزار بنا دیا ہے۔

تاہم، ان طاقتور ماڈلز سے وابستہ حدود اور خطرات کو تسلیم کرنا اور سمجھنا بہت ضروری ہے۔ تعصب، غلط معلومات، اور بدنیتی پر مبنی استعمال کے امکانات جیسے مسائل کو نظر انداز نہیں کیا جا سکتا۔ جیسا کہ ہم ان AI سے چلنے والی ٹیکنالوجیز کو اپنی روزمرہ کی زندگیوں میں ضم کرتے رہتے ہیں، ان کی صلاحیتوں سے فائدہ اٹھانے اور انسانی نگرانی کو یقینی بنانے کے درمیان توازن قائم کرنا ضروری ہے، خاص طور پر حساس اور زیادہ خطرے والے حالات میں۔

اگر ہم جنریٹیو AI ٹیکنالوجیز کو ذمہ داری سے اپنانے میں کامیاب ہو جاتے ہیں، تو ہم ایک ایسے مستقبل کی راہ ہموار کریں گے جہاں مصنوعی ذہانت اور انسانی مہارت مل کر جدت کو آگے بڑھانے اور سب کے لیے ایک بہتر دنیا تخلیق کرنے کے لیے کام کریں۔

اس مضمون کا لطف اٹھائیں؟ مزید AI ریسرچ اپ ڈیٹس کے لیے سائن اپ کریں۔

جب ہم اس جیسے مزید خلاصہ مضامین جاری کریں گے تو ہم آپ کو بتائیں گے۔

متعلقہ

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ آٹوموٹو / ای وی، کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- بلاک آفسیٹس۔ ماحولیاتی آفسیٹ ملکیت کو جدید بنانا۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- : ہے

- : ہے

- : نہیں

- :کہاں

- $UP

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- کی صلاحیت

- قابلیت

- ہمارے بارے میں

- اوپر

- مطلق

- تعلیمی

- قبول کریں

- قبول کرتا ہے

- تک رسائی حاصل

- قابل رسائی

- ایڈجسٹ کریں

- کے مطابق

- درستگی

- درست

- حاصل کیا

- حاصل کرتا ہے

- حصول

- تسلیم کرتے ہیں

- کے پار

- چالو کرنے کی

- ایکٹیویشنز

- کام کرتا ہے

- اپنانے

- موافقت

- شامل کریں

- انہوں نے مزید کہا

- اس کے علاوہ

- ایڈیشنل

- پتہ

- پتے

- اپنانے

- ترقی

- مشورہ

- کے بعد

- کے خلاف

- ایجنٹ

- AI

- عی تحقیق

- مقصد ہے

- AL

- اسی طرح

- تمام

- کی اجازت

- اجازت دے رہا ہے

- کی اجازت دیتا ہے

- ساتھ

- بھی

- متبادل

- اگرچہ

- ہمیشہ

- کے درمیان

- کے درمیان

- رقم

- مقدار

- an

- تجزیہ

- تجزیاتی

- اور

- ایک اور

- جواب

- کوئی بھی

- اے پی آئی

- ظاہر

- ایپلی کیشنز

- کا اطلاق کریں

- نقطہ نظر

- مناسب

- تقریبا

- ارکیٹیکچرل

- فن تعمیر

- کیا

- علاقوں

- ارد گرد

- لڑی

- فن

- مضمون

- مضامین

- مصنوعی

- مصنوعی ذہانت

- AS

- اسسٹنس

- اسسٹنٹ

- منسلک

- ایسوسی ایشن

- At

- توجہ

- مصنفین

- خود کار طریقے سے

- دستیاب

- اوسط

- سے اجتناب

- ایوارڈ

- متوازن

- بار

- بیس

- کی بنیاد پر

- بنیادی

- بنیاد

- BE

- کیونکہ

- بن

- اس سے پہلے

- کیا جا رہا ہے

- نیچے

- معیار

- معیارات

- فوائد

- بہتر

- کے درمیان

- تعصب

- باضابطہ

- ارب

- کتب

- بوٹسٹریپ

- دونوں

- حدود

- پیش رفت

- کامیابیاں

- پل

- وسیع

- تعمیر

- عمارت

- تعمیر

- لیکن

- by

- کہا جاتا ہے

- کر سکتے ہیں

- امیدوار

- نہیں کر سکتے ہیں

- صلاحیتوں

- صلاحیت رکھتا

- اہلیت

- ہوشیار

- کیس

- تباہ کن

- کیونکہ

- سی ای او

- سی ای او اور بانی

- چیلنج

- موقع

- تبدیل

- چیٹ بٹس

- چیٹ جی پی ٹی

- چپس

- کا دعوی

- درجہ بندی

- بادل

- شریک بانی

- کوڈ

- مربوط

- مجموعہ

- مجموعہ

- کے مجموعے

- کس طرح

- وابستگی

- مواصلات

- کمیونٹی

- مقابلے میں

- ہم آہنگ

- مقابلہ

- تکمیلی

- پیچیدہ

- تعمیل

- اجزاء

- حساب

- کمپیوٹنگ

- کمپیوٹر

- کمپیوٹنگ

- تصوراتی

- اندراج

- ترتیب

- منسلک

- مربوط

- اس کے نتیجے میں

- خیالات

- تعمیر

- مواد

- سیاق و سباق

- سیاق و سباق

- جاری

- اس کے برعکس

- بات چیت

- مکالمات

- تبادلوں سے

- درست

- اسی کے مطابق

- قیمت

- اخراجات

- سکتا ہے

- تخلیق

- بنائی

- تخلیقی

- معتبر

- اہم

- موجودہ

- گاہک

- کسٹمر سروس

- کسٹمر سپورٹ

- جدید

- روزانہ

- اعداد و شمار

- ڈیٹا پوائنٹس

- ڈیٹاسیٹس

- تاریخ

- فیصلہ کیا

- کمی

- گہری

- Deepmind

- فراہم کرتا ہے

- مظاہرہ

- demonstrated,en

- ثبوت

- مظاہرین

- ڈیمو

- منحصر ہے

- تعینات

- ڈیزائن

- کے باوجود

- تفصیلات

- ترقی

- ڈویلپرز

- ترقی

- ترقی

- مکالمے کے

- مکالمے کے

- مشکل

- معذوریوں

- ظاہر

- تبعیض

- ممتاز

- متنوع

- do

- دستاویز

- دستاویزات

- کرتا

- غلبے

- نہیں

- درجن سے

- ڈرائیو

- ڈوب

- دو

- کے دوران

- e

- ای کامرس

- ای اینڈ ٹی

- ہر ایک

- ابتدائی

- آسان

- تعلیمی

- اثر

- مؤثر طریقے

- کارکردگی

- ہنر

- کوششوں

- ختم ہوگیا

- ابھرتی ہوئی

- کو چالو کرنے کے

- کو فعال کرنا

- احاطہ کرتا ہے

- مشغول

- انگریزی

- بڑھانے کے

- بہتر

- اضافہ

- بڑھانے

- کو یقینی بنانے ہے

- ضروری

- قائم کرو

- قائم ہے

- اخلاقی

- اندازہ

- تشخیص

- اندازہ

- بھی

- ہر کوئی

- سب کچھ

- ثبوت

- تیار ہوتا ہے

- امتحان

- مثال کے طور پر

- مثال کے طور پر

- سے تجاوز

- غیر معمولی

- دلچسپ

- خاص طور سے

- نمائش

- موجودہ

- توسیع

- تجربات

- مہارت

- ایکسپلور

- بیرونی

- f1

- سہولت

- عوامل

- گر

- خاندان

- دور

- دلچسپ

- تیز رفتار

- نمایاں کریں

- شامل

- خصوصیات

- آراء

- چند

- کم

- میدان

- اعداد و شمار

- فلٹرنگ

- مل

- پہلا

- درست کریں

- مقرر

- پر عمل کریں

- کے بعد

- کے لئے

- فارم

- بنیادیں

- بانی

- فریم ورک

- سے

- منجمد

- تقریب

- بنیادی

- بنیادی طور پر

- مزید

- مستقبل

- حاصل کی

- فرق

- جنس

- پیدا

- پیدا

- پیدا ہوتا ہے

- پیدا کرنے والے

- نسل

- پیداواری

- پیداواری AI۔

- جنریٹر

- حاصل

- GitHub کے

- جھلک

- گلوبل

- Go

- مقصد

- جا

- اچھا

- گوگل

- گوگل

- حکومت

- GPUs

- گریڈ

- جھنڈا

- گروپ

- تھا

- ہوتا ہے

- ہارڈ

- ہارڈ ویئر

- نقصان دہ

- ہے

- ہونے

- صحت کی دیکھ بھال

- یہاں

- اعلی معیار کی

- بهترین ریزولوشن

- اعلی خطرہ

- اعلی

- سب سے زیادہ

- کی ڈگری حاصل کی

- کس طرح

- تاہم

- HTML

- HTTPS

- بھاری

- انسانی

- سینکڑوں

- ہائپ

- ہائپر پیرامیٹر ٹیوننگ

- خیال

- کی نشاندہی

- if

- تصویر

- تصاویر

- بہت زیادہ

- نفاذ

- عملدرآمد

- اثرات

- اہم

- متاثر کن

- کو بہتر بنانے کے

- بہتر

- بہتری

- بہتری

- in

- میں گہرائی

- اسمرتتا

- شامل

- شامل

- سمیت

- شامل

- شامل

- شامل کرنا

- اضافہ

- اضافہ

- اضافہ

- دن بدن

- انفرادی

- افراد

- صنعتوں

- صنعت

- معلومات

- انفراسٹرکچر

- شروع کرتا ہے

- جدت طرازی

- ان پٹ

- آدانوں

- کے بجائے

- اداروں

- ہدایات

- ضم

- انٹیلی جنس

- ارادے

- دلچسپ

- میں

- متعارف کرانے

- متعارف

- آویشکار

- مسئلہ

- مسائل

- IT

- میں

- خود

- صحافت

- فوٹو

- صرف

- کلیدی

- اہم مقاصد

- جان

- علم

- لیبز

- نہیں

- زمین کی تزئین کی

- زبان

- زبانیں

- بڑے

- بڑے پیمانے پر

- سب سے بڑا

- تازہ ترین

- پرت

- تہوں

- قیادت

- جانیں

- سیکھنے

- قانونی

- کم

- سطح

- سطح

- لیوریج

- لیتا ہے

- لیورنگنگ

- لائسنس یافتہ

- زندگی

- ہلکا پھلکا

- کی طرح

- امکان

- حدود

- لسٹ

- فہرستیں

- زندگی

- لاما

- مقامی طور پر

- منطقی

- لانگ

- دیکھو

- بہت

- لو

- مشینیں

- بنا

- بنا

- بناتا ہے

- بہت سے

- مارکس

- مارکیٹ

- مارکیٹ کی تحقیق

- مارکیٹنگ

- مواد

- ریاضی

- زیادہ سے زیادہ چوڑائی

- زیادہ سے زیادہ

- مئی..

- بامعنی

- میڈیا

- طبی

- ضم کریں

- میٹا

- طریقہ کار

- طریقوں

- مائیکروسافٹ

- برا

- کم سے کم

- غلط معلومات

- گمراہ کرنا

- غلطیوں

- مخلوط

- ML

- ماڈل

- ماڈل

- جدید

- نظر ثانی کی

- نگرانی

- زیادہ

- سب سے زیادہ

- بہت

- ایک سے زیادہ

- مسلمان

- قدرتی

- قدرتی زبان

- قدرتی زبان عملیات

- فطرت، قدرت

- ضرورت ہے

- ضرورت

- نیٹ ورک

- عصبی

- اعصابی زبان

- عصبی نیٹ ورک

- نئی

- خبر

- اگلے

- اچھا

- ویزا

- خاص طور پر

- کچھ بھی نہیں

- تعداد

- متعدد

- مقصد

- مقاصد

- واقع

- of

- جارحانہ

- سرکاری

- اکثر

- on

- ایک

- والوں

- صرف

- کھول

- اوپن سورس

- اوپنائی

- کام

- آپریشنز

- اصلاح کے

- or

- تنظیم

- دیگر

- دیگر

- ہمارے

- باہر

- باہر نکلنا

- Outperforms

- پیداوار

- بقایا

- پر

- خود

- پام

- کاغذ.

- پیرا میٹر

- پیرامیٹر

- پیرامیٹرز

- حصہ

- شرکت

- خاص طور پر

- منظور

- پیٹرن

- ہموار

- ہموار

- فی

- انجام دینے کے

- کارکردگی

- کارکردگی کا مظاہرہ

- کارکردگی کا مظاہرہ

- جملے

- لینے

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- pods

- پوائنٹ

- پوائنٹس

- پالیسیاں

- ممکن

- ممکنہ

- طاقت

- طاقتور

- پیشن گوئی

- کو ترجیح دی

- پچھلا

- بنیادی طور پر

- پہلے

- ترجیح

- مسئلہ

- مسائل

- عمل

- عمل

- پروسیسنگ

- پیدا

- مصنوعات

- پیداوری

- پیشہ ورانہ

- پروگرامنگ

- پروگرامنگ زبانوں

- پیش رفت

- وعدہ

- خصوصیات

- تجویز کرتا ہے

- ملکیت

- پروٹوکول

- فراہم

- فراہم

- فراہم کرتا ہے

- عوامی طور پر

- شائع

- مقاصد

- دھکیلنا

- ازگر

- pytorch

- قابلیت

- معیار

- سوال

- سوالات

- جلدی سے

- ریس

- رینج

- میں تیزی سے

- بلکہ

- پڑھنا

- اصلی

- حقیقی زندگی

- حقیقی دنیا

- حال ہی میں

- حال ہی میں

- تسلیم

- تسلیم

- کو کم

- کو کم کرنے

- حکومتیں

- قابو پانے کی تعلیم

- جاری

- جاری

- متعلقہ

- قابل اعتماد

- قابل اعتماد ذرائع

- مذہب

- یقین ہے

- رہے

- رہے

- قابل ذکر

- کی جگہ

- رپورٹیں

- نمائندگی

- درخواستوں

- کی ضرورت

- کی ضرورت ہے

- تحقیق

- ریسرچ کمیونٹی

- محققین

- وسائل سے متعلق

- احترام

- جواب دیں

- جواب

- جوابات

- محدود

- نتیجہ

- نتائج کی نمائش

- برقرار رکھتا ہے

- جائزہ

- انقلاب

- انقلاب آگیا

- خطرات

- دشمنی

- مضبوط

- کردار

- کمرہ

- محفوظ

- سیفٹی

- فروختforce

- اسی

- پیمانے

- ترازو

- سکیلنگ

- منظرنامے

- مناظر

- سکول

- سکور

- اسکور

- اسکورنگ

- بغیر کسی رکاوٹ کے

- دوسری

- لگتا ہے

- دیکھا

- منتخب

- حساس

- علیحدہ

- سیریز

- سنگین

- سروس

- سروسز

- مقرر

- قائم کرنے

- کئی

- حیران

- مختصر

- دکھائیں

- سے ظاہر ہوا

- شوز

- سائن ان کریں

- اہم

- نمایاں طور پر

- اسی طرح

- واحد

- حالات

- سائز

- مہارت

- چھوٹے

- So

- اب تک

- سماجی

- سوشل میڈیا

- سوسائٹی

- سافٹ ویئر کی

- سوفٹ ویئر کی نشوونما

- مکمل طور پر

- حل

- حل کرتا ہے

- کچھ

- بہتر

- ماخذ

- ذرائع

- سورسنگ

- سپیم سے

- مخصوص

- خاص طور پر

- نردجیکرن

- شاندار

- تقریر سے متن

- تیزی

- استحکام

- اسٹیج

- مراحل

- معیار

- معیار

- حالت

- ریاستی آرٹ

- شماریات

- کے اعداد و شمار

- ابھی تک

- حکمت عملی

- طاقت

- ہڑتال

- مطالعہ

- کافی

- کامیاب ہوں

- اس طرح

- مشورہ

- پتہ چلتا ہے

- خلاصہ

- اعلی

- نگرانی

- حمایت

- حد تک

- کے نظام

- سسٹمز

- مذاکرات

- ٹاسک

- کاموں

- ٹیم

- ٹیکنیکل

- تکنیک

- ٹیکنالوجی

- شرائط

- ٹیسٹ

- متن کی نسل

- متن سے تقریر۔

- سے

- شکریہ

- کہ

- ۔

- مستقبل

- ریاست

- دنیا

- ان

- ان

- تو

- وہاں.

- اس طرح

- لہذا

- یہ

- وہ

- لگتا ہے کہ

- تیسری پارٹی

- اس

- ان

- اگرچہ؟

- ہزاروں

- تین

- کے ذریعے

- اوقات

- کرنے کے لئے

- آج کا

- مل کر

- ٹوکن

- ٹوکن بنانا

- ٹوکن

- بھی

- اوزار

- سب سے اوپر

- ٹاپ بوٹس

- موضوع

- موضوعات

- کی طرف

- روایتی

- ٹرین

- تربیت یافتہ

- ٹریننگ

- منتقل

- ٹرانسفارمر

- تبدیل

- ترجمہ

- ٹریلین

- ٹورنگ

- ٹیوشن

- دو

- غیر مشروط

- کے تحت

- سمجھ

- افہام و تفہیم

- شروع

- بلاشبہ

- بدقسمتی سے

- کائنات

- برعکس

- اپ ڈیٹ کرنے کے لئے

- تازہ ترین معلومات

- استعمال کی شرائط

- استعمال کیا جاتا ہے

- رکن کا

- استعمال

- کا استعمال کرتے ہوئے

- استعمال کرتا ہے

- مختلف اقسام کے

- مختلف

- وسیع

- ورسٹائل

- بہت

- ویڈیو

- ویڈیوز

- مجازی

- نقطہ نظر

- VOX

- تھا

- راستہ..

- we

- ویب

- اچھا ہے

- تھے

- کیا

- جب

- جس

- جبکہ

- ڈبلیو

- پوری

- وسیع

- وسیع رینج

- وکیپیڈیا

- گے

- ساتھ

- کے اندر

- بغیر

- الفاظ

- کام

- مل کے کام کرو

- دنیا

- تحریری طور پر

- سال

- ابھی

- آپ

- زیفیرنیٹ

- زیرو شاٹ لرننگ