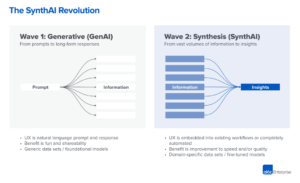

Üretken yapay zekada (AI) bir teknoloji yığınının çok erken aşamalarının ortaya çıktığını görmeye başlıyoruz. Yüzlerce yeni girişim, temel modeller geliştirmek, yapay zekaya özgü uygulamalar oluşturmak ve altyapıyı/araçları ayağa kaldırmak için pazara akın ediyor.

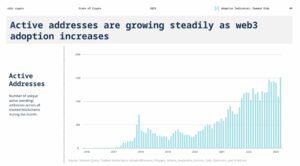

Pek çok sıcak teknoloji trendi, pazar yetişmeden çok önce abartılıyor. Ancak üretken AI patlamasına, gerçek pazarlarda gerçek kazançlar ve gerçek şirketlerden gerçek ilgi eşlik etti. Stable Diffusion ve ChatGPT gibi modeller, kullanıcı büyümesi için tarihi rekorlar kırıyor ve birkaç uygulama, lansmanından sonraki bir yıldan kısa bir süre içinde 100 milyon dolarlık yıllık gelire ulaştı. Yan yana karşılaştırmalar AI modellerini gösterir insanlardan daha iyi performans göstermek bazı görevlerde birden çok büyüklük sırasına göre.

Bu nedenle, büyük bir dönüşümün gerçekleştiğini öne sürmek için yeterli erken veri var. Bilmediğimiz ve şimdi kritik soru haline gelen şey şudur: Bu piyasada değer nerede tahakkuk edecek?

Geçen yıl boyunca, doğrudan üretken AI ile ilgilenen büyük şirketlerde düzinelerce startup kurucusu ve işletmecisi ile görüştük. bunu gözlemledik altyapı satıcıları yığından akan dolarların çoğunu ele geçirerek muhtemelen bu pazarda şimdiye kadarki en büyük kazananlar. Uygulama şirketleri gelirlerini çok hızlı bir şekilde artırıyorlar, ancak genellikle elde tutma, ürün farklılaştırması ve brüt marjlarla mücadele ediyorlar. Ve en model sağlayıcıları, bu pazarın varlığından sorumlu olmasına rağmen, henüz büyük bir ticari ölçeğe ulaşamadı.

Başka bir deyişle, en fazla değeri yaratan şirketler - yani üretken yapay zeka modellerini eğitmek ve bunları yeni uygulamalarda uygulamak - bunun çoğunu yakalayamadı. Bundan sonra ne olacağını tahmin etmek çok daha zor. Ancak anlaşılması gereken en önemli şeyin, yığının hangi bölümlerinin gerçekten farklı ve savunulabilir olduğu olduğunu düşünüyoruz. Bunun pazar yapısı (yani yatay ve dikey şirket gelişimi) ve uzun vadeli değer faktörleri (örneğin marjlar ve elde tutma) üzerinde büyük bir etkisi olacaktır. Şimdiye kadar, yapısal savunulabilirlik bulmakta zorlandık hiçbir yerde görevliler için geleneksel hendeklerin dışında, yığında.

Üretken yapay zeka konusunda inanılmaz derecede iyimseriz ve bunun yazılım endüstrisinde ve ötesinde büyük bir etkisi olacağına inanıyoruz. Bu yazının amacı, pazarın dinamiklerini ortaya çıkarmak ve üretken yapay zeka iş modelleri hakkında daha geniş soruları yanıtlamaya başlamaktır.

Üst düzey teknoloji yığını: Altyapı, modeller ve uygulamalar

Üretken yapay zeka pazarının nasıl şekillendiğini anlamak için öncelikle yığının bugün nasıl göründüğünü tanımlamamız gerekiyor. İşte ön görüşümüz.

Yığın üç katmana ayrılabilir:

- Uygulamalar üretken yapay zeka modellerini, kendi model işlem hatlarını ("uçtan uca uygulamalar") çalıştıran veya üçüncü taraf bir API'ye dayanan, kullanıcıya yönelik bir ürüne entegre eden

- Modeller özel API'ler veya açık kaynaklı kontrol noktaları olarak kullanıma sunulan (sırasıyla bir barındırma çözümü gerektiren) yapay zeka ürünlerine güç veren

- Altyapı üretken yapay zeka modelleri için eğitim ve çıkarım iş yükleri çalıştıran satıcılar (ör. bulut platformları ve donanım üreticileri)

Şuna dikkat etmek önemlidir: Bu bir pazar haritası değil, pazarı analiz etmek için bir çerçevedir. Her kategoride, tanınmış satıcılardan birkaç örnek listeledik. Kapsamlı olmak veya piyasaya sürülen tüm şaşırtıcı üretken yapay zeka uygulamalarını listelemek için herhangi bir girişimde bulunmadık. Ayrıca, henüz yüksek düzeyde standartlaştırılmamış olan ve gelecekteki bir gönderide ele alınacak olan MLops veya LLMops araçlarını burada derinlemesine incelemiyoruz.

Üretken yapay zeka uygulamalarının ilk dalgası geniş bir ölçeğe ulaşmaya başlıyor, ancak elde tutma ve farklılaştırmayla mücadele ediyor

Önceki teknoloji döngülerinde, geleneksel görüş, büyük, bağımsız bir şirket kurmak için son müşteriye sahip olmanız gerektiğiydi - bu ister bireysel tüketiciler ister B2B alıcılar anlamına gelsin. Üretken yapay zeka alanındaki en büyük şirketlerin aynı zamanda son kullanıcı uygulamaları olacağına inanmak cazip geliyor. Şimdiye kadar, durumun böyle olduğu net değil.

Elbette, üretken yapay zeka uygulamalarının büyümesi, tamamen yenilik ve çok sayıda kullanım durumu tarafından yönlendirilen, şaşırtıcı olmuştur. Aslında, şimdiden yıllık geliri 100 milyon doları aşan en az üç ürün kategorisinin farkındayız: görüntü oluşturma, metin yazarlığı ve kod yazma.

Ancak büyüme, dayanıklı yazılım şirketleri oluşturmak için tek başına yeterli değildir. Kritik olarak, büyüme karlı olmalıdır - yani kullanıcılar ve müşteriler kaydolduktan sonra kar elde ederler (yüksek brüt marjlar) ve uzun süre kalırlar (yüksek elde tutma). Güçlü bir teknik farklılığın olmadığı durumlarda B2B ve B2C uygulamaları, ağ etkileri, verileri tutma veya giderek daha karmaşık hale gelen iş akışları oluşturma yoluyla uzun vadeli müşteri değeri sağlar.

Üretken yapay zekada, bu varsayımlar mutlaka doğru değildir. Konuştuğumuz uygulama şirketlerinde çok çeşitli brüt kar marjları var - birkaç durumda %90'a kadar çıkıyor, ancak çoğunlukla %50-60'a kadar düşüyor ve büyük ölçüde model çıkarım maliyetinden kaynaklanıyor. Dönüşüm hunisinin tepesindeki büyüme inanılmazdı, ancak mevcut müşteri edinme stratejilerinin ölçeklenebilir olup olmayacağı belli değil — şimdiden ücretli edinme etkinliğinin ve elde tutmanın azalmaya başladığını görüyoruz. Benzer yapay zeka modellerine dayandıklarından ve rakiplerin kopyalaması zor olan bariz ağ etkilerini veya veri/iş akışlarını keşfetmediklerinden birçok uygulama da nispeten farklılaşmamıştır.

Bu nedenle, son kullanıcı uygulamalarını satmanın sürdürülebilir, üretken bir AI işi kurmanın tek ve hatta en iyi yolu olduğu henüz açık değil. Dil modellerinde rekabet ve verimlilik arttıkça marjlar da artmalıdır (bununla ilgili daha fazlası aşağıda). AI turistleri piyasadan ayrıldıkça elde tutma artmalıdır. Ve dikey olarak entegre edilmiş uygulamaların farklılaşmayı yönlendirmede bir avantaja sahip olduğuna dair güçlü bir argüman var. Ama hala kanıtlanacak çok şey var.

İleriye bakıldığında, üretken AI uygulama şirketlerinin karşılaştığı bazı büyük sorular şunları içerir:

- Dikey entegrasyon (“model + uygulama”). Yapay zeka modellerini bir hizmet olarak kullanmak, uygulama geliştiricilerin küçük bir ekiple hızla yineleme yapmasına ve teknoloji ilerledikçe model sağlayıcıları değiştirmesine olanak tanır. Kapak tarafında, bazı geliştiriciler ürünün is model ve sıfırdan eğitim, savunulabilirlik oluşturmanın tek yoludur - örneğin, tescilli ürün verileri üzerinde sürekli olarak yeniden eğitim. Ancak bu, çok daha yüksek sermaye gereksinimleri ve daha az çevik bir ürün ekibi pahasına gelir.

- Bina özellikleri ve uygulamalar. Üretken AI ürünleri bir dizi farklı biçim alır: masaüstü uygulamaları, mobil uygulamalar, Figma/Photoshop eklentileri, Chrome uzantıları, hatta Discord botları. Kullanıcı arabirimi genellikle yalnızca bir metin kutusu olduğundan, AI ürünlerini kullanıcıların halihazırda çalıştığı yerlere entegre etmek kolaydır. Bunlardan hangileri bağımsız şirketler haline gelecek ve hangileri Microsoft veya Google gibi halihazırda yapay zekayı ürün gruplarına dahil eden yerleşik şirketler tarafından emilecek?

- Aldatmaca döngüsü aracılığıyla yönetme. Müşteri kayıplarının mevcut üretken yapay zeka ürünleri partisinin doğasında mı yoksa erken bir pazarın ürünü mü olduğu henüz net değil. Ya da üretken yapay zekaya olan ilgi artışı, yutturmaca yatıştıkça düşecek mi? Bağış toplama konusunda gaz pedalına ne zaman basılacağı; müşteri edinmeye ne kadar agresif yatırım yapılmalı; hangi kullanıcı segmentlerine öncelik verileceği; ve ürün-pazar uygunluğunun ne zaman beyan edileceği.

Model sağlayıcılar üretken yapay zekayı icat etti, ancak büyük ticari ölçeğe ulaşamadı

Google, OpenAI ve Stability gibi yerlerde yapılan mükemmel araştırma ve mühendislik çalışmaları olmasaydı, şimdi üretken yapay zeka dediğimiz şey var olamazdı. Yeni model mimarileri ve eğitim boru hatlarını ölçeklendirmeye yönelik kahramanca çabalar sayesinde, hepimiz mevcut büyük dil modellerinin (LLM'ler) ve görüntü oluşturma modellerinin akıllara durgunluk veren yeteneklerinden yararlanıyoruz.

Yine de, bu şirketlerle ilişkili gelir, kullanım ve vızıltı ile karşılaştırıldığında hala nispeten küçüktür. Görüntü oluşturmada, Stable Diffusion, kullanıcı arayüzleri, barındırılan teklifler ve ince ayar yöntemlerinden oluşan bir ekosistem tarafından desteklenen patlayıcı bir topluluk büyümesi gördü. Ancak Kararlılık, işlerinin temel ilkesi olarak ana kontrol noktalarını ücretsiz olarak verir. Doğal dil modellerinde OpenAI, GPT-3/3.5 ve ChatGPT ile hakimdir. Ancak Nispeten Şimdiye kadar OpenAI üzerine inşa edilmiş birkaç öldürücü uygulama var ve fiyatlar şimdiden bir kez düştü.

Bu sadece geçici bir fenomen olabilir. Stability, henüz para kazanmaya odaklanmamış yeni bir şirkettir. OpenAI, daha öldürücü uygulamalar geliştirildikçe tüm NLP kategorisi gelirlerinin önemli bir bölümünü kazanan devasa bir işletme olma potansiyeline sahiptir - özellikle de Microsoft'un ürün portföyüne entegrasyon sorunsuz gider Bu modellerin büyük kullanımı göz önüne alındığında, büyük ölçekli gelirler çok geride olmayabilir.

Ancak karşıt güçler de var. Açık kaynak olarak yayınlanan modeller, büyük ölçekli model eğitimiyle ilişkili maliyetleri (onlarca veya yüz milyonlarca dolara kadar) karşılamayan dış şirketler de dahil olmak üzere herkes tarafından barındırılabilir. Ve herhangi bir kapalı kaynak modelinin üstünlüğünü süresiz olarak koruyup koruyamayacağı da net değil. Örneğin, Anthropic, Cohere ve Character.ai gibi şirketler tarafından oluşturulan LLM'lerin, benzer veri kümeleri (yani internet) ve benzer model mimarileri üzerinde eğitilerek OpenAI performans seviyelerine yaklaştığını görmeye başlıyoruz. Kararlı Difüzyon örneği şunu önermektedir: if açık kaynak modelleri yeterli düzeyde performansa ve topluluk desteğine ulaşırsa, tescilli alternatifler rekabet etmekte zorlanabilir.

Şimdiye kadar model sağlayıcılar için belki de en net çıkarım, ticarileştirmenin büyük olasılıkla barındırmaya bağlı olduğudur. Tescilli API'lere (örneğin OpenAI'den) olan talep hızla artıyor. Açık kaynak modeller için barındırma hizmetleri (örn. Hugging Face ve Replicate), modelleri kolayca paylaşmak ve entegre etmek için yararlı merkezler olarak ortaya çıkıyor ve hatta model üreticileri ile tüketiciler arasında bazı dolaylı ağ etkilerine sahip. Ayrıca, kurumsal müşterilerle ince ayar ve barındırma anlaşmaları yaparak para kazanmanın mümkün olduğuna dair güçlü bir hipotez var.

Bunun ötesinde, model sağlayıcıların karşı karşıya olduğu bir dizi büyük soru var:

- Ticarileştirme. AI modellerinin zaman içinde performansta birleşeceğine dair yaygın bir inanç var. Uygulama geliştiricilerle konuşurken, hem metin hem de resim modellerinde güçlü liderlerle bunun henüz gerçekleşmediği açık. Avantajları, benzersiz model mimarilerine değil, yüksek sermaye gereksinimlerine, tescilli ürün etkileşim verilerine ve kıt yapay zeka yeteneğine dayanmaktadır. Bu kalıcı bir avantaj olarak hizmet edecek mi?

- Mezuniyet riski. Model sağlayıcılara güvenmek, uygulama şirketlerinin işe başlaması ve hatta işlerini büyütmesi için harika bir yoldur. Ancak, ölçeğe ulaştıklarında kendi modellerini oluşturmaları ve/veya barındırmaları için teşvik vardır. Ve birçok model sağlayıcı, gelirin çoğunluğunu temsil eden birkaç uygulama ile oldukça çarpık müşteri dağılımlarına sahiptir. Bu müşteriler şirket içi yapay zeka geliştirmeye geçerse/geçtiğinde ne olur?

- Para önemli mi? Üretken yapay zekanın vaadi o kadar büyük ve aynı zamanda potansiyel olarak o kadar zararlı ki, birçok model sağlayıcı kamu yararına çalışan şirketler (B kolordu) olarak örgütlendi, sınırlı kâr payları çıkardı veya başka bir şekilde kamu yararını açıkça misyonlarına dahil etti. Bu, bağış toplama çabalarını hiç engellemedi. Ancak, çoğu model sağlayıcının gerçekten istemek değeri yakalamak için ve gerekirse.

Altyapı sağlayıcıları her şeye dokunur ve meyvelerini toplar

Üretken yapay zekadaki neredeyse her şey bir noktada bulutta barındırılan bir GPU'dan (veya TPU'dan) geçer. Eğitim iş yükleri çalıştıran model sağlayıcılar / araştırma laboratuvarları, çıkarım/ince ayar çalıştıran barındırma şirketleri veya her ikisinin bir kombinasyonunu yapan uygulama şirketleri için — FLO'LAR üretken yapay zekanın can damarıdır. Çok uzun zamandır ilk kez, en yıkıcı bilgi işlem teknolojisindeki ilerleme, büyük ölçüde hesaplamaya bağlı.

Sonuç olarak, üretici yapay zeka pazarındaki paranın çoğu, nihayetinde altyapı şirketlerine akıyor. biraz koymak çok yaklaşık rakamlar: Ortalama olarak, uygulama şirketlerinin gelirlerinin yaklaşık %20-40'ını çıkarım ve müşteri başına ince ayar için harcadığını tahmin ediyoruz. Bu genellikle ya doğrudan bilgi işlem örnekleri için bulut sağlayıcılarına ya da gelirlerinin yaklaşık yarısını bulut altyapısına harcayan üçüncü taraf model sağlayıcılarına ödenir. Yani, %10-20 olduğunu tahmin etmek mantıklıdır. toplam gelir üretken yapay zekada bugün bulut sağlayıcılarına gidiyor.

Bunun da ötesinde, kendi modellerini eğiten girişimler, risk sermayesinde milyarlarca dolar topladı ve bunların çoğu (ilk turlarda %80-90'a kadar) tipik olarak bulut sağlayıcılarıyla da harcandı. Birçok halka açık teknoloji şirketi, harici bulut sağlayıcılarla veya doğrudan donanım üreticileriyle model eğitimine yılda yüz milyonlar harcıyor.

Teknik terimlerle buna "çok para" diyeceğiz - özellikle gelişmekte olan bir pazar için. Çoğu yerde harcanıyor Büyük 3 bulutlar: Amazon Web Services (AWS), Google Cloud Platform (GCP) ve Microsoft Azure. Bu bulut sağlayıcıları toplu olarak fazla harcamak Yıllık 100 milyar dolar en kapsamlı, güvenilir ve uygun maliyetli platformlara sahip olmalarını sağlamak için yatırım harcamalarında. Üretken yapay zekada, özellikle, kıt donanıma (örneğin, Nvidia A100 ve H100 GPU'lar) tercihli erişime sahip oldukları için tedarik kısıtlamalarından da yararlanırlar.

İlginç bir şekilde, güvenilir bir rekabetin ortaya çıktığını görmeye başlıyoruz. Oracle gibi meydan okuyanlar, büyük yatırım harcamaları ve satış teşvikleri ile ilerleme kaydetti. Coreweave ve Lambda Labs gibi birkaç girişim, özellikle büyük model geliştiricileri hedefleyen çözümlerle hızla büyüdü. Maliyet, kullanılabilirlik ve kişiselleştirilmiş destek konusunda rekabet ederler. Ayrıca, büyük bulutlar GPU sanallaştırma limitleri nedeniyle yalnızca sanal makine örnekleri sunarken, daha ayrıntılı kaynak soyutlamalarını (yani kapsayıcıları) ortaya çıkarırlar.

Sahne arkasında, yapay zeka iş yüklerinin büyük çoğunluğunu çalıştıran, üretken yapay zekada şimdiye kadarki belki de en büyük kazanan: Nvidia. Şirket 3.8 $ bildirdi milyar 2023 mali yılının üçüncü çeyreğinde veri merkezi GPU gelirinin yüzdesi, üretken yapay zeka kullanım durumları için anlamlı bir bölüm dahil. Ayrıca, GPU mimarisine, sağlam bir yazılım ekosistemine ve akademik toplulukta yoğun kullanıma yönelik onlarca yıllık yatırım yoluyla bu işin etrafında güçlü hendekler inşa ettiler. Son bir analiz Nvidia GPU'larının araştırma makalelerinde en iyi yapay zeka çipi girişimlerinin toplamından 90 kat daha fazla alıntılandığını buldu.

Google Tensör İşleme Birimleri (TPU'lar) dahil olmak üzere başka donanım seçenekleri mevcuttur; AMD Instinct GPU'ları; AWS Inferentia ve Trainium yongaları; ve Cerebras, Sambanova ve Graphcore gibi girişimlerden AI hızlandırıcılar. Oyuna geç kalan Intel de üst düzey Habana yongaları ve Ponte Vecchio GPU'ları ile pazara giriyor. Ancak şimdiye kadar, bu yeni çiplerden çok azı önemli bir pazar payı aldı. İzlenecek iki istisna, TPU'ları Stable Diffusion topluluğunda ve bazı büyük GCP anlaşmalarında ilgi gören Google ve üretim yaptığına inanılan TSMC'dir. herşey Nvidia GPU'ları da dahil olmak üzere burada listelenen yongaların sayısı (Intel, yongalarını yapmak için kendi fabrikasyonlarının ve TSMC'nin bir karışımını kullanır).

Diğer bir deyişle altyapı, yığındaki kazançlı, dayanıklı ve görünüşte savunulabilir bir katmandır. Altyapı şirketleri için yanıtlanması gereken büyük sorular şunları içerir:

- Durum bilgisiz iş yüklerine tutunmak. Nvidia GPU'ları, kiraladığınız her yerde aynıdır. Model çıkarımının ekli veritabanları veya depolama gerektirmemesi anlamında (model ağırlıklarının kendileri dışında) çoğu AI iş yükü durum bilgisizdir. Bu, AI iş yüklerinin bulutlar arasında geleneksel uygulama iş yüklerinden daha taşınabilir olabileceği anlamına gelir. Bu bağlamda, bulut sağlayıcıları nasıl yapışkanlık yaratabilir ve müşterilerin en ucuz seçeneğe atlamasını nasıl önleyebilir?

- Çip kıtlığının sonunda hayatta kalmak. Bulut sağlayıcıları ve Nvidia'nın kendisi için fiyatlandırma, en çok arzu edilen GPU'ların kıt tedarikiyle desteklendi. Bir sağlayıcı bize A100'lerin liste fiyatının aslında artmış bilgi işlem donanımı için oldukça alışılmadık bir durum olan lansmanından bu yana. Artan üretim ve/veya yeni donanım platformlarının benimsenmesi yoluyla bu tedarik kısıtlaması nihayetinde ortadan kaldırıldığında, bu durum bulut sağlayıcılarını nasıl etkileyecek?

- Meydan okuyan bir bulut yarıp geçebilir mi? Biz güçlü inananlarız dikey bulutlar daha özel tekliflerle Büyük 3'ten pazar payı alacak. Şimdiye kadar AI'da meydan okuyanlar, ılımlı teknik farklılaşma ve görevdeki bulut sağlayıcılarının hem en büyük müşteriler hem de yeni ortaya çıkan rakipler olduğu Nvidia'nın desteğiyle anlamlı bir çekiş gücü elde ettiler. Uzun vadeli soru şu: Bu, Büyük 3'ün ölçek avantajlarının üstesinden gelmek için yeterli olacak mı?

Öyleyse… değer nerede birikecek?

Tabii henüz bilmiyoruz. Ancak üretken yapay zeka için sahip olduğumuz ilk verilere dayanarak, önceki AI/ML şirketleriyle olan deneyimimiz, sezgimiz şudur.

Bugün, üretken AI'da herhangi bir sistemik hendek yok gibi görünüyor. Birinci dereceden bir yaklaşım olarak, uygulamalar benzer modeller kullandıklarından güçlü ürün farklılaştırmasından yoksundurlar; modeller, benzer mimarilere sahip benzer veri kümeleri üzerinde eğitildiklerinden, belirsiz uzun vadeli farklılaşmalarla karşı karşıya kalırlar; bulut sağlayıcıları, aynı GPU'ları çalıştırdıkları için derin teknik farklılıklardan yoksundur; ve hatta donanım şirketleri bile çiplerini aynı fabrikalarda üretiyor.

Elbette standart hendekler vardır: ölçekli hendekler ("Senden daha fazla param var veya toplayabilirim!"), tedarik zinciri hendekleri ("GPU'larım var, sende yok!"), ekosistem hendekleri (" Herkes zaten benim yazılımımı kullanıyor!”), algoritmik hendekler (“Biz sizden daha zekiyiz!”), dağıtım hendekleri (“Zaten bir satış ekibim ve sizden daha fazla müşterim var!”) ve veri boru hattı hendekleri (“Ben' İnternette senden daha fazla gezindim!”). Ancak bu hendeklerin hiçbiri uzun vadede dayanıklı olma eğiliminde değildir. Güçlü, doğrudan ağ etkilerinin yığının herhangi bir katmanında yer alıp almadığını söylemek için henüz çok erken.

Mevcut verilere dayanarak, üretken yapay zekada uzun vadeli, kazanan her şeyi alır dinamiğinin olup olmayacağı net değil.

Bu garip. Ama bizim için iyi bir haber. Bu pazarın potansiyel büyüklüğünü kavramak zor - ortası bir yerde. tüm yazılımlar ve tüm insan çabaları - bu nedenle, yığının her seviyesinde çok, çok sayıda oyuncu ve sağlıklı rekabet bekliyoruz. Ayrıca, son pazarlar ve son kullanıcılar tarafından dikte edilen en iyi yaklaşımla hem yatay hem de dikey şirketlerin başarılı olmasını bekliyoruz. Örneğin, son üründeki birincil farklılaşma yapay zekanın kendisiyse, dikeyleştirme (yani, kullanıcıya yönelik uygulamayı evde geliştirilen modele sıkı bir şekilde bağlamak) büyük olasılıkla galip gelecektir. Oysa yapay zeka daha büyük, uzun kuyruklu bir özellik kümesinin parçasıysa, yataylaştırmanın gerçekleşmesi daha olasıdır. Tabii ki, zamanla daha geleneksel hendeklerin inşa edildiğini de görmeliyiz ve hatta yeni hendek türlerinin ortaya çıktığını görebiliriz.

Durum ne olursa olsun, emin olduğumuz bir şey var ki, üretken yapay zeka oyunu değiştiriyor. Hepimiz kuralları gerçek zamanlı olarak öğreniyoruz, kilidi açılacak muazzam miktarda değer var ve sonuç olarak teknoloji manzarası çok çok farklı görünecek. Ve bunun için buradayız!

Bu gönderideki tüm resimler Midjourney kullanılarak oluşturuldu.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- Plato blok zinciri. Web3 Metaverse Zekası. Bilgi Güçlendirildi. Buradan Erişin.

- Kaynak: https://a16z.com/2023/01/19/who-owns-the-generative-ai-platform/

- $ 100 milyon

- $3

- 1

- a

- A100

- Hakkımızda

- akademik

- hızlandırıcılar

- erişim

- elde

- edinme

- karşısında

- aslında

- Benimseme

- gelişmeler

- avantaj

- avantajları

- Sonra

- anlaşmalar

- önde

- AI

- AI platformu

- AI kullanım durumları

- AI / ML

- algoritmik

- Türkiye

- veriyor

- tek başına

- zaten

- alternatifleri

- şaşırtıcı

- Amazon

- Amazon Web Servisleri

- Amazon Web Services (AWS)

- AMD

- miktar

- çözümlemek

- ve

- yıllık

- cevap

- kimse

- API'ler

- uygulamayı yükleyeceğiz

- görünmek

- Uygulama

- uygulamaları

- Uygulanması

- yaklaşım

- uygulamalar

- mimari

- tartışmak

- tartışma

- etrafında

- yapay

- yapay zeka

- Yapay zeka (AI)

- ilişkili

- kullanılabilirliği

- mevcut

- ortalama

- AWS

- AWS Çıkarımları

- masmavi

- B2B

- B2C

- merkezli

- Ayı

- Çünkü

- müşterimiz

- önce

- arkasında

- inanç

- Inanmak

- inanılır

- müminler

- altında

- yarar

- İYİ

- arasında

- Ötesinde

- Büyük

- Biggest

- Milyar

- milyarlarca

- patlama

- botlar

- bağlı

- kutu

- mola

- parlak

- Daha geniş

- inşa etmek

- bina

- yapılı

- Boğa gibi

- iş

- işletmeler

- Alıcılar

- çağrı

- yetenekleri

- Başkent

- ele geçirmek

- Yakalama

- dava

- durumlarda

- kategoriler

- Kategoriler

- Merkez

- belli

- meydan okuyucu

- değişiklikler

- karakter

- ChatGPT

- en ucuz

- yonga

- cips

- krom

- atıf

- açık

- yakın

- bulut

- bulut altyapısı

- Bulut Platformu

- kod

- toplu olarak

- kombinasyon

- kombine

- nasıl

- ticari

- ticarileştirilmesi

- ortak

- topluluk

- Şirketler

- şirket

- karşılaştırıldığında

- yarışmak

- rekabet

- rakipler

- karmaşık

- kapsamlı

- hesaplamak

- bilgisayar

- kısıtlamaları

- Tüketiciler

- Konteynerler

- bağlam

- sürekli olarak

- geleneksel

- yakınsamak

- metin yazarlığı

- çekirdek

- Kurumlar

- Ücret

- maliyetler

- kurs

- yaratmak

- çevrimiçi kurslar düzenliyorlar.

- Oluşturma

- inandırıcı

- kritik

- akım

- müşteri

- Müşteriler

- döngüleri

- veri

- Veri Merkezi

- veritabanları

- veri kümeleri

- anlaşma

- Fırsatlar

- yıl

- derin

- Talep

- masaüstü

- geliştirmek

- geliştiriciler

- gelişme

- Devs

- farklı

- değişik formlar

- farklılaşmış

- Yayılma

- direkt

- direkt olarak

- anlaşmazlık

- keşfetti

- tartışma

- yıkıcı

- dağıtım

- Dağılımlar

- bölünmüş

- yapıyor

- dolar

- hakim

- Dont

- onlarca

- sürücü

- tahrik

- sürücüler

- sürme

- dinamik

- dinamik

- her

- Daha erken

- Erken

- Kazanma

- kolayca

- ekosistem

- kenar

- etkileri

- verim

- çabaları

- ya

- ortaya çıkan

- Mühendislik

- yeterli

- sağlamak

- kuruluş

- kurumsal müşteriler

- özellikle

- tahmin

- Hatta

- sonunda

- her şey

- örnek

- örnekler

- beklemek

- deneyim

- uzantıları

- dış

- Yüz

- karşı

- Düşmek

- Özellikler(Hazırlık aşamasında)

- Özellikler

- az

- bulmak

- bulma

- Ad

- ilk kez

- Mali

- uygun

- Fiske

- Akan

- Akışları

- odaklanmış

- takip etme

- Güçler

- formlar

- bulundu

- vakıf

- Kurucuları

- iskelet

- Ücretsiz

- itibaren

- Kaynak Yaratma

- gelecek

- Kazançlar

- oyun

- GAZ

- genellikle

- oluşturmak

- nesil

- üretken

- üretken yapay zeka

- almak

- verilmiş

- verir

- gol

- Goes

- gidiş

- Tercih Etmenizin

- Google Bulut

- Google Bulut Platformu

- GPU

- GPU'lar

- kavramak

- harika

- brüt

- Büyümek

- Büyüyen

- yetişkin

- Büyüme

- Yarım

- olmak

- olmuş

- olur

- Zor

- donanım

- zararlı

- sağlıklı

- okuyun

- Yüksek

- daha yüksek

- büyük ölçüde

- tarihsel

- vurmak

- ambar

- tutma

- Yatay

- ev sahibi

- ev sahipliği yaptı

- hosting

- SICAK

- Ne kadar

- HTTPS

- Kocaman

- insan

- Yüzlerce

- yüz milyonlarca

- Yutturmaca

- görüntü

- görüntü üretimi

- görüntüleri

- darbe

- etkileri

- önemli

- iyileştirmek

- in

- Diğer

- özendirici

- teşvikler

- dahil

- Dahil olmak üzere

- Anonim

- birleşmeyle

- Artırmak

- artmış

- Artışlar

- giderek

- inanılmaz

- görevdeki

- bağımsız

- bireysel

- sanayi

- Altyapı

- doğal

- entegre

- entegre

- bütünleşme

- Intel

- İstihbarat

- etkileşim

- faiz

- arayüzler

- Internet

- sezgi

- İcat edildi

- Yatırım yapmak

- yatırım

- Veriliş

- IT

- kendisi

- anahtar

- Bilmek

- Labs

- Eksiklik

- manzara

- dil

- büyük

- büyük ölçekli

- çok

- büyük

- Soyad

- Geçen yıl

- Geç

- başlatmak

- tabaka

- katmanları

- liderleri

- öğrenme

- Ayrılmak

- seviye

- seviyeleri

- Muhtemelen

- sınırları

- hatları

- Liste

- Listelenmiş

- Uzun

- uzun zaman

- uzun süreli

- Bakın

- GÖRÜNÜYOR

- Çok

- Düşük

- kazançlı

- yapılmış

- korumak

- büyük

- çoğunluk

- yapmak

- Üreticiler

- çok

- harita

- marjları

- pazar

- pazar haritası

- Pazar Yapısı

- Piyasalar

- masif

- kitlesel

- maksimum genişlik

- anlamlı

- anlamına geliyor

- yöntemleri

- Microsoft

- Microsoft Azure

- Orta Yolculuk

- milyon

- milyonlarca

- Misyonumuz

- MLO'lar

- Telefon

- mobil uygulamalar

- model

- modelleri

- para kazanma

- para kazanma

- para

- Daha

- çoğu

- çoklu

- oluşmaya başlayan

- Doğal (Madenden)

- Doğal lisan

- zorunlu olarak

- gerek

- ağ

- yeni

- yeni donanım

- haber

- sonraki

- çevik

- nlp

- roman

- yenilik

- numara

- sayılar

- Nvidia

- Açık

- teklif

- teklifleri

- ONE

- açık

- açık kaynak

- OpenAI

- operatörler

- seçenek

- Opsiyonlar

- kehanet

- emir

- Düzenlenmiş

- Diğer

- aksi takdirde

- dışında

- Üstesinden gelmek

- kendi

- sahibi

- ödenmiş

- kâğıtlar

- Bölüm

- belirli

- parçalar

- geçer

- yol

- performans

- belki

- Kişiselleştirilmiş

- fenomen

- boru hattı

- yer

- Yerler

- platform

- Platformlar

- Platon

- Plato Veri Zekası

- PlatoVeri

- oyuncular

- bolluk

- eklentileri

- Nokta

- mümkün

- Çivi

- potansiyel

- potansiyel

- güç kelimesini seçerim

- tahmin

- önlemek

- fiyat

- Fiyatlar

- birincil

- Önceki

- Öncelik

- işleme

- Üreticileri

- PLATFORM

- üretim

- Ürünler

- Kâr

- kârlı

- kar

- Ilerleme

- söz

- özel

- Kanıtlamak

- sağlayan

- sağlayıcılar

- halka açık

- koymak

- Çeyrek

- soru

- Sorular

- hızla

- yükseltmek

- yükseltilmiş

- menzil

- hızla

- ulaşmak

- ulaştı

- gerçek

- gerçek zaman

- makul

- son

- kayıtlar

- Nispeten

- serbest

- güvenilir

- çıkarıldı

- Kira

- temsil

- gerektirir

- Yer Alan Kurallar

- araştırma

- kaynak

- sorumlu

- sonuç

- tutma

- gelir

- gelir

- Risk

- gürbüz

- mermi

- kurallar

- koşmak

- koşu

- satış

- Satış Teşvikleri

- aynı

- ölçeklenebilir

- ölçek

- Kıt

- Kıtlık

- Sahneler

- görme

- segmentler

- Satışa

- duyu

- hizmet vermek

- hizmet

- Hizmetler

- set

- ayar

- birkaç

- Shape

- paylaş

- Paylar

- meli

- şov

- işaret

- önemli

- benzer

- beri

- beden

- küçük

- düzgünce

- So

- şu ana kadar

- Yazılım

- çözüm

- Çözümler

- biraz

- bir yerde

- Kaynak

- özel

- özellikle

- geçirmek

- harcanmış

- istikrar

- kararlı

- yığın

- aşamaları

- durmak

- bağımsız

- standart

- başlama

- başladı

- XNUMX dakika içinde!

- başlangıç

- Startups

- Sopa

- Yine

- hafızası

- stratejileri

- güçlü

- yapısal

- yapı

- Çabalama

- başarılı olmak

- yeterli

- Önerdi

- arz

- destek

- destekli

- dalgalanma

- sürdürülebilir

- anahtar

- sistemik

- Bizi daha iyi tanımak için

- alma

- Yetenek

- konuşma

- Hedeflenen

- görevleri

- takım

- teknoloji

- teknoloji şirketleri

- Teknik

- Teknoloji

- geçici

- şartlar

- The

- ve bazı Asya

- kendilerini

- şey

- Üçüncü

- üçüncü şahıslara ait

- üç

- İçinden

- bağlı

- sıkıca

- zaman

- zamanlar

- için

- bugün

- çok

- üst

- dokunma

- çekiş

- geleneksel

- eğitilmiş

- Eğitim

- Dönüşüm

- muazzam

- Trendler

- gerçek

- TSMC

- DÖNÜŞ

- türleri

- tipik

- ui

- eninde sonunda

- altında yatan

- anlamak

- benzersiz

- birimleri

- olağandışı

- us

- kullanım

- kullanım

- kullanıcı

- kullanıcılar

- değer

- Geniş

- satıcıları

- girişim

- girişim sermayesi

- üzerinden

- Görüntüle

- İzle

- dalga

- ağ

- web hizmetleri

- tanınmış

- Ne

- olup olmadığını

- hangi

- süre

- DSÖ

- geniş

- Geniş ürün yelpazesi

- Vikipedi

- irade

- kazanmak

- Kazananlar

- bilgelik

- olmadan

- sözler

- İş

- iş akışları

- yazı yazıyor

- yıl

- zefirnet