07 Şub 2023 (

Nanowerk HaberleriOpenAI'nin GPT-3'ü gibi büyük dil modelleri, şiirden programlama koduna kadar insan benzeri metinler üretebilen devasa sinir ağlarıdır. Çok sayıda internet verisi kullanılarak eğitilen bu makine öğrenimi modelleri, giriş metninin küçük bir kısmını alıyor ve ardından gelmesi muhtemel metni tahmin ediyor. Ancak bu modellerin yapabileceği tek şey bu değil. Araştırmacılar, büyük bir dil modelinin, o görev için eğitilmemiş olmasına rağmen yalnızca birkaç örnek gördükten sonra bir görevi yerine getirmeyi öğrendiği, bağlam içi öğrenme olarak bilinen ilginç bir olguyu araştırıyorlar. Örneğin, birisi modele birkaç örnek cümle ve onların duygularını (olumlu veya olumsuz) besleyebilir, ardından onu yeni bir cümleyle yönlendirebilir ve model doğru duyguyu verebilir. Genellikle GPT-3 gibi bir makine öğrenimi modelinin bu yeni görev için yeni verilerle yeniden eğitilmesi gerekir. Bu eğitim süreci sırasında model, görevi öğrenmek için yeni bilgileri işlerken parametrelerini günceller. Ancak bağlam içi öğrenmede modelin parametreleri güncellenmez, dolayısıyla model hiçbir şey öğrenmeden yeni bir görev öğreniyormuş gibi görünür. MIT, Google Research ve Stanford Üniversitesi'nden bilim insanları bu gizemi çözmeye çalışıyor. Parametreleri güncellemeden nasıl öğrenebileceklerini görmek için büyük dil modellerine çok benzeyen modeller üzerinde çalıştılar. Araştırmacıların teorik sonuçları, bu devasa sinir ağı modellerinin, içlerine gömülü daha küçük, daha basit doğrusal modelleri içerebildiğini gösteriyor. Büyük model daha sonra bu küçük, doğrusal modeli, yalnızca daha büyük modelde zaten bulunan bilgileri kullanarak yeni bir görevi tamamlamak üzere eğitmek için basit bir öğrenme algoritması uygulayabilir. Parametreleri sabit kalır. Bağlam içi öğrenmenin ardındaki mekanizmaları anlamaya yönelik önemli bir adım olan bu araştırma, bu büyük modellerin uygulayabileceği öğrenme algoritmaları etrafında daha fazla araştırmaya kapı açıyor, diyor bilgisayar bilimleri yüksek lisans öğrencisi ve bir makalenin baş yazarı Ekin Akyürek (

“Bağlam içi öğrenme hangi öğrenme algoritmasıdır? Doğrusal modellerle araştırmalar”) bu fenomeni araştırıyoruz. Bağlam içi öğrenmenin daha iyi anlaşılmasıyla araştırmacılar, modellerin maliyetli yeniden eğitime gerek kalmadan yeni görevleri tamamlamasını sağlayabilir. "Genellikle bu modellere ince ayar yapmak istiyorsanız alana özel veriler toplamanız ve bazı karmaşık mühendislikler yapmanız gerekir. Ama şimdi onu sadece bir girdiyle, beş örnekle besleyebiliriz ve o da istediğimizi başarır. Yani bağlam içi öğrenme oldukça heyecan verici bir olgu” diyor Akyürek. Makalede Akyürek'e katılanlar arasında Google Brain'de araştırma bilimcisi ve Alberta Üniversitesi'nde bilgisayar bilimi profesörü Dale Schuurmans; yanı sıra kıdemli yazarlar, MIT Elektrik Mühendisliği ve Bilgisayar Bilimleri Bölümü'nde X Konsorsiyumu Yardımcı Doçenti ve MIT Bilgisayar Bilimi ve Yapay Zeka Laboratuvarı (CSAIL) üyesi olan Jacob Andreas; Stanford'da bilgisayar bilimi ve istatistik alanında yardımcı doçent olan Tengyu Ma; ve Google Brain'in baş bilim insanı ve araştırma direktörü Danny Zhou. Araştırma Uluslararası Öğrenme Temsilleri Konferansı'nda sunulacak.

Model içinde model

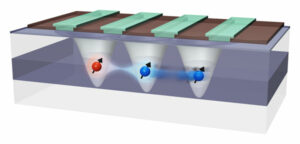

Akyürek, makine öğrenimi araştırma topluluğunda pek çok bilim insanının, büyük dil modellerinin eğitilme şekli nedeniyle bağlam içi öğrenme gerçekleştirebileceğine inanmaya başladığını söylüyor. Örneğin, GPT-3 yüz milyarlarca parametreye sahiptir ve Wikipedia makalelerinden Reddit gönderilerine kadar internetteki çok sayıda metin okunarak eğitilmiştir. Yani birisi yeni bir görevin model örneklerini gösterdiğinde muhtemelen çok benzer bir şey görmüştür çünkü eğitim veri seti milyarlarca web sitesinden metin içeriyordu. Yeni görevleri yerine getirmeyi öğrenmek yerine, eğitim sırasında gördüğü kalıpları tekrarlar. Akyürek, bağlam içi öğrencilerin yalnızca daha önce görülen kalıpları eşleştirmekle kalmayıp, bunun yerine yeni görevleri yerine getirmeyi öğrendiklerini varsaydı. Kendisi ve diğerleri, daha önce hiçbir yerde göremedikleri sentetik verileri kullanarak bu modellere yönlendirmeler vererek deneyler yapmış ve modellerin hâlâ sadece birkaç örnekten ders çıkarabildiğini bulmuşlardı. Akyürek ve meslektaşları, belki de bu sinir ağı modellerinin, modellerin yeni bir görevi tamamlamak için eğitebilecekleri daha küçük makine öğrenimi modellerine sahip olduğunu düşündüler. "Bu, bu büyük modellerde gördüğümüz öğrenme olaylarının neredeyse tamamını açıklayabilir" diyor. Bu hipotezi test etmek için araştırmacılar, GPT-3 ile aynı mimariye sahip olan ancak bağlam içi öğrenme için özel olarak eğitilmiş, transformatör adı verilen bir sinir ağı modeli kullandılar. Bu transformatörün mimarisini keşfederek, onun gizli durumları dahilinde doğrusal bir model yazabildiğini teorik olarak kanıtladılar. Bir sinir ağı, verileri işleyen birçok birbirine bağlı düğüm katmanından oluşur. Gizli durumlar giriş ve çıkış katmanları arasındaki katmanlardır. Matematiksel değerlendirmeleri, bu doğrusal modelin transformatörün en eski katmanlarında bir yerde yazıldığını gösteriyor. Transformatör daha sonra basit öğrenme algoritmalarını uygulayarak doğrusal modeli güncelleyebilir. Temelde model kendisinin daha küçük bir versiyonunu simüle eder ve eğitir.

Gizli katmanları araştırmak

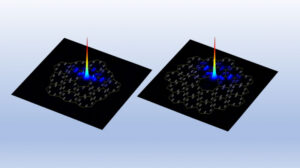

Araştırmacılar bu hipotezi, belirli bir miktarı geri kazanmak için transformatörün gizli katmanlarına baktıkları araştırma deneyleri kullanarak araştırdılar. "Bu durumda, doğrusal modelin asıl çözümünü kurtarmaya çalıştık ve parametrenin gizli durumlarda yazıldığını gösterebildik. Bu, doğrusal modelin orada bir yerde olduğu anlamına geliyor” diyor. Bu teorik çalışmayı temel alan araştırmacılar, sinir ağına yalnızca iki katman ekleyerek bir transformatörün bağlam içi öğrenme gerçekleştirmesini sağlayabilirler. Akyürek, bunun mümkün olabilmesi için hala üzerinde çalışılması gereken pek çok teknik ayrıntının olduğu konusunda uyarıyor, ancak bu, mühendislerin yeni verilerle yeniden eğitime ihtiyaç duymadan yeni görevleri tamamlayabilecek modeller oluşturmasına yardımcı olabilir. Akyürek, gelecekte bu çalışmada incelediği doğrusal modellerden daha karmaşık işlevlerle bağlam içi öğrenmeyi keşfetmeye devam etmeyi planlıyor. Davranışlarının basit öğrenme algoritmaları tarafından da tanımlanıp tanımlanmadığını görmek için bu deneyleri büyük dil modellerine de uygulayabilirler. Ayrıca bağlam içi öğrenmeyi mümkün kılabilecek eğitim öncesi veri türlerini daha derinlemesine incelemek istiyor. "Bu çalışmayla insanlar artık bu modellerin örneklerden nasıl öğrenebileceğini görselleştirebiliyor. Dolayısıyla bazı insanların bağlam içi öğrenmeye ilişkin görüşlerini değiştireceğini umuyorum” diyor Akyürek. “Bu modeller insanların düşündüğü kadar aptal değil. Sadece bu görevleri ezberlemekle kalmıyorlar. Yeni görevleri öğrenebilirler ve bunun nasıl yapılabileceğini gösterdik.”

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- Plato blok zinciri. Web3 Metaverse Zekası. Bilgi Güçlendirildi. Buradan Erişin.

- Kaynak: https://www.nanowerk.com/news2/robotics/newsid=62325.php