Hızla gelişen yapay zeka alanında, doğal dil işleme, hem araştırmacılar hem de geliştiriciler için bir odak noktası haline geldi. temelleri üzerine bina Transformatör mimarisi ve BERT'in çift yönlü yükseltmesi, son yıllarda makinelerin anlayıp üretebileceklerinin sınırlarını zorlayan birkaç çığır açan dil modeli ortaya çıktı.

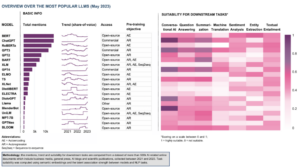

Bu makalede, büyük ölçekli dil modelleri dünyasındaki en son gelişmeleri inceleyeceğiz, her modelin sunduğu geliştirmeleri, yeteneklerini ve potansiyel uygulamalarını keşfedeceğiz. Sadece metinsel değil görsel verileri de işlemek için eğitilmiş Görsel Dil Modellerini (VLM'ler) de inceleyeceğiz.

Etrafta gezinmek isterseniz, öne çıkardığımız dil modelleri şunlardır:

- OpenAI tarafından GPT-3

- Google'dan LaMDA

- Google'dan PaLM

- DeepMind tarafından Flamingo

- Salesforce'tan BLIP-2

- Meta AI'dan LLaMA

- OpenAI tarafından GPT-4

Bu kapsamlı eğitim içeriği sizin için yararlıysa şunları yapabilirsiniz: AI araştırma e-posta listemize abone olun yeni materyal çıkardığımızda uyarılmak.

2023'ün En Önemli Büyük Dil Modelleri (LLM'ler) ve Görsel Dil Modelleri (VLM'ler)

1. OpenAI'den GPT-3

Özet

OpenAI ekibi, her yeni dil görevi için etiketlenmiş bir veri kümesine sahip olmaya alternatif olarak GPT-3'ü tanıttı. Dil modellerini ölçeklendirmenin görevden bağımsız birkaç adımlık performansı iyileştirebileceğini öne sürdüler. Bu öneriyi test etmek için 175B parametreli bir otoregresif dil modeli geliştirdiler. GPT 3ve performansını iki düzineden fazla NLP görevinde değerlendirdi. Birkaç adımda öğrenme, tek adımda öğrenme ve sıfır atışta öğrenme kapsamında yapılan değerlendirme, GPT-3'ün umut verici sonuçlar elde ettiğini ve hatta zaman zaman ince ayarlı modellerle elde edilen son teknoloji ürünü sonuçlardan daha iyi performans gösterdiğini gösterdi.

Amaç ne?

- Her yeni dil görevi için etiketli bir veri kümesi gerektiğinde, mevcut soruna alternatif bir çözüm önermek.

Soruna nasıl yaklaşılır?

- Araştırmacılar, görevden bağımsız birkaç adımlık performansı iyileştirmek için dil modellerini ölçeklendirmeyi önerdiler.

- The GPT 3 model, GPT-2 ile aynı modeli ve mimariyi kullanır; değiştirilmiş başlatma, ön normalleştirme ve tersine çevrilebilir belirteçlendirme dahil.

- Bununla birlikte, GPT-2'nin aksine, transformatörün katmanlarında olduğu gibi alternatif yoğun ve yerel olarak bantlanmış seyrek dikkat desenleri kullanır. Seyrek Trafo.

Sonuçlar ne?

- İnce ayar gerektirmeyen GPT-3 modeli, bir dizi NLP görevinde ümit verici sonuçlar elde eder ve hatta bazen bu özel görev için ince ayarlanmış son teknoloji ürünü modelleri geride bırakır:

- Üzerinde CoQA ince ayarlı SOTA ile elde edilen 81.5 F1 puanına kıyasla sıfır atış ayarında 84.0 F1, tek atış ayarında 85.0 F1 ve az atış ayarında 90.7 F1.

- Üzerinde önemsiz şeylerQA kıyaslama, sıfır atış ayarında% 64.3 doğruluk, tek atış ayarında% 68.0 ve az atış ayarında% 71.2, son teknolojiyi (% 68)% 3.2 geride bıraktı.

- Üzerinde Lambada veri seti, sıfır atış ayarında% 76.2 doğruluk, tek atış ayarında% 72.5 ve az atış ayarında% 86.4, son teknolojiyi (% 68)% 18 geride bırakmıştır.

- İnsan değerlendirmelerine göre, 175B parametreli GPT-3 modelinin ürettiği haber makalelerini gerçek olanlardan ayırt etmek zordur (doğruluk oranı ~% 52 olan şans seviyesinin biraz üzerindedir).

- GPT-3'ün olağanüstü performansına rağmen, yapay zeka topluluğundan karışık eleştiriler aldı:

- "GPT-3 yutturmaca çok fazla. Etkileyici (güzel iltifatlar için teşekkürler!) Ama yine de ciddi zayıf yönleri var ve bazen çok saçma hatalar yapıyor. AI dünyayı değiştirecek, ancak GPT-3 yalnızca çok erken bir bakış. Hala çözmemiz gereken çok şey var. " - Sam Altman, CEO ve OpenAI kurucu ortağı.

- "GPT-3'ten Müslümanlar hakkında şiddetle veya öldürülmekle ilgisi olmayan metinler üretmenin ne kadar zor olduğuna şok oldum ..." - Abubakar Abid, Gradio CEO'su ve kurucusu.

- "Hayır. GPT-3 temelde bahsettiği dünyayı anlamıyor. Külliyatı daha da artırmak, onun daha inandırıcı bir pastiş oluşturmasına izin verecek, ancak dünyayı anlama konusundaki temel eksikliğini düzeltmeyecektir. GPT-4 demoları yine de insanlardan kiraz toplamayı gerektirecek. " - Robust.ai CEO'su ve kurucusu Gary Marcus.

- "GPT3'ün muhteşem performansını geleceğe doğru tahmin etmek, hayata, evrene ve her şeye cevabın sadece 4.398 trilyon parametre olduğunu gösteriyor." - Geoffrey Hinton, Turing Ödülü sahibi.

Bu araştırma hakkında daha fazla bilgiyi nereden edinebilirsiniz?

Uygulama kodunu nereden edinebilirsiniz?

- Kodun kendisi mevcut değil, ancak GPT-2048'ten koşulsuz, filtrelenmemiş 3 belirteç örnekleriyle birlikte bazı veri kümesi istatistikleri GitHub.

2. Google'dan LaMDA

Özet

Ladil Miçin modeller Ddiyalog Auygulamalar (MDA) diyaloglar için özel olarak tasarlanmış bir grup Transformer tabanlı nöral dil modelinde ince ayar yapma süreciyle oluşturulmuştur. Bu modeller maksimum 137B parametreye sahiptir ve harici bilgi kaynaklarını kullanmak üzere eğitilmiştir. LaMDA geliştiricilerinin aklında üç temel hedef vardı - kalite, güvenlik ve sağlamlık. Sonuçlar, ince ayarın kalite farkını insan seviyelerine daraltmaya izin verdiğini, ancak modelin performansının güvenlik ve topraklama açısından insan seviyelerinin altında kaldığını gösterdi.

Google'ın Bard'ı, serbest son zamanlarda ChatGPT'ye alternatif olarak LaMDA tarafından desteklenmektedir. Bard genellikle olarak etiketlenmesine rağmen sıkıcı, üretken yapay zeka alanında hakimiyet kurmak için Google ile Microsoft arasındaki yoğun rekabetin ortasında bile, Google'ın güvenliğe öncelik verme taahhüdünün kanıtı olarak görülebilir.

Amaç ne?

- Bir diyalog aracısının, mantıklı, bağlama özgü, güvenilir kaynaklara dayalı ve etik yanıtlarla herhangi bir konu hakkında sohbet edebildiği açık alan diyalog uygulamaları için bir model oluşturmak.

Soruna nasıl yaklaşılır?

- LaMDA üzerine kuruludur Trafo, Google Research'ün 2017'de icat ettiği ve açık kaynaklı bir sinir ağı mimarisi.

- BERT ve GPT-3 gibi diğer büyük dil modelleri gibi LaMDA da terabaytlarca metin verisi üzerinde eğitilerek sözcüklerin birbirleriyle nasıl ilişkili olduğunu öğrenir ve ardından hangi sözcüklerin geleceğini tahmin eder.

- Bununla birlikte, çoğu dil modelinden farklı olarak, LaMDA, açık uçlu konuşmayı diğer dil biçimlerinden ayıran nüansları yakalamak için diyalog konusunda eğitildi.

- Model ayrıca, yanıtlarının duyarlılığını, güvenliğini ve özgüllüğünü geliştirmek için ince ayarlanmıştır. "Güzel" ve "Bilmiyorum" gibi ifadeler birçok diyalog senaryosunda anlamlı olabilse de, ilginç ve ilgi çekici sohbetlere yol açmaları pek olası değildir.

- LaMDA üreteci önce, tümü ne kadar güvenli, mantıklı, spesifik ve ilginç olduklarına göre puanlanan birkaç aday yanıtı üretir. Düşük güvenlik puanına sahip yanıtlar filtrelenir ve ardından en üst sıradaki sonuç yanıt olarak seçilir.

Sonuçlar ne?

- Çok sayıda deney, LaMDA'nın çeşitli konularda açık uçlu konuşmalara katılabileceğini göstermektedir.

- Bir dizi niteliksel değerlendirme, modelin yanıtlarının mantıklı, spesifik, ilginç olduğunu ve güvenilir dış kaynaklara dayandığını doğruladı, ancak hala iyileştirme için yer var.

- Şimdiye kadar kaydedilen tüm ilerlemelere rağmen, yazarlar, modelin hala uygunsuz ve hatta zararlı yanıtların üretilmesine neden olabilecek birçok sınırlamaya sahip olduğunun farkındadır.

Bu araştırma hakkında daha fazla bilgiyi nereden edinebilirsiniz?

Uygulama kodunu nereden edinebilirsiniz?

- LaMDA'nın eğitim öncesi mimarisi için açık kaynaklı bir PyTorch uygulaması şu adreste mevcuttur: GitHub.

3. Google'dan PaLM

Özet

Paher şekilde Language Mödel (Avuç içi) 540 milyar parametreli, Transformer tabanlı bir dil modelidir. PaLM, birden çok TPU Bölmesinde verimli eğitim için yeni bir makine öğrenimi sistemi olan Pathways kullanılarak 6144 TPU v4 yongaları üzerinde eğitildi. Model, birkaç adımda öğrenmede ölçeklendirmenin faydalarını gösterirken, yüzlerce dil anlama ve oluşturma kıyaslamasında en son teknolojiye sahip sonuçlara ulaşıyor. PaLM, çok adımlı muhakeme görevlerinde ince ayarlı son teknoloji modellerden daha iyi performans gösterir ve BIG-bench kıyaslamasında ortalama insan performansını aşar.

Amaç ne?

- Büyük dil modellerinin ölçeklendirilmesinin birkaç adımda öğrenmeyi nasıl etkilediğinin anlaşılmasını geliştirmek.

Soruna nasıl yaklaşılır?

- Ana fikir, Pathways sistemi ile 540 milyar parametreli bir dil modelinin eğitimini ölçeklendirmek:

- Ekip, her Kapsülde standart veri ve model paralelliği kullanırken iki Cloud TPU v4 Kapsülünün Kapsül düzeyinde veri paralelliğini kullanıyordu.

- Eğitimi, bugüne kadar eğitim için kullanılan en büyük TPU tabanlı sistem yapılandırması olan 6144 TPU v4 yongalarına ölçeklendirebildiler.

- Model, yazarların iddia ettiği gibi, bu ölçekte büyük dil modelleri için henüz elde edilen en yüksek eğitim verimliliği olan %57.8 donanım FLOP kullanımının eğitim verimliliğine ulaştı.

- PaLM modeli için eğitim verileri, yüksek kaliteli web belgeleri, kitaplar, Wikipedia, konuşmalar ve GitHub kodunu içeren İngilizce ve çok dilli veri kümelerinin bir kombinasyonunu içeriyordu.

Sonuçlar ne?

- Çok sayıda deney, ekip en büyük modellerine ölçeklendikçe model performansının hızla arttığını gösteriyor.

- PaLM 540B, çok sayıda çok zor görevde çığır açan bir performans elde etti:

- Dil anlayışı ve nesil. Tanıtılan model, soru cevaplama görevleri, tamamlama ve cümle tamamlama görevleri, bağlam içi okuduğunu anlama görevleri, sağduyulu akıl yürütme görevleri, SuperGLUE görevleri ve Daha. PaLM'nin BIG-bench görevlerindeki performansı, neden ve sonucu ayırt edebildiğini ve uygun bağlamlarda kavramsal kombinasyonları anlayabildiğini gösterdi.

- muhakeme. PaLM, 8 adımlı ipucuyla, GPT-58 8B modelinde ince ayar yaparak elde edilen %55'lik en yüksek puan olan binlerce zorlu ilkokul düzeyinde matematik sorusunun bir ölçütü olan GSM3K'daki sorunların %175'ini çözer. PaLM ayrıca çok adımlı mantıksal çıkarım, dünya bilgisi ve derin dil anlayışının karmaşık bir kombinasyonunu gerektiren durumlarda açık açıklamalar üretme yeteneğini de gösterir.

- Kod oluşturma. PaLM, eğitim için 12 kat daha az Python kodu kullanırken, ince ayarlı Codex 50B ile eşit performans göstererek, büyük dil modellerinin hem diğer programlama dillerinden hem de doğal dil verilerinden öğrenmeyi daha etkin bir şekilde aktardığını doğrular.

Bu araştırma hakkında daha fazla bilgiyi nereden edinebilirsiniz?

Uygulama kodunu nereden edinebilirsiniz?

- PaLM araştırma belgesindeki belirli Transformer mimarisinin resmi olmayan bir PyTorch uygulaması şu adreste mevcuttur: GitHub. Ölçeklenmeyecek ve yalnızca eğitim amaçlı yayınlanacaktır.

4. DeepMind'dan Flamingo

Özet

Flamingo, karma metin ve resimlerle büyük ölçekli çok modlu web korporası üzerinde eğitilmiş, son teknoloji bir Görsel Dil Modelleri (VLM'ler) ailesidir. Bu eğitim ile modeller, bilgi istemi olarak sağlanan minimum açıklamalı örnekleri kullanarak yeni görevlere uyum sağlayabilir. Flamingo, önceden eğitilmiş yalnızca görüntülü ve yalnızca dilli modellerin güçlü yanlarını birleştirmek, değişken şekilde serpiştirilmiş görsel ve metinsel verilerin işlem dizilerini birleştirmek ve görüntüleri veya videoları sorunsuz bir şekilde girdi olarak yerleştirmek için tasarlanmış önemli mimari gelişmeleri içerir. Modeller, görsel soru yanıtlama, altyazı oluşturma görevleri ve çoktan seçmeli görsel soru yanıtlama gibi bir dizi görüntü ve video görevine etkileyici bir şekilde uyarlanabilirlik göstererek, birkaç adımda öğrenmede göreve özel istemleri kullanarak yeni performans standartları belirliyor.

Amaç ne?

- Kısa talimatlara dayalı yeni görevleri hızlı bir şekilde öğrenmek ve gerçekleştirmek için çok modlu modellerin etkinleştirilmesine yönelik ilerleme kaydetmek için:

- Bir modeli büyük miktarda denetlenen veri üzerinde önceden eğitme ve ardından belirli bir görev için ince ayar yapmaya yönelik yaygın olarak kullanılan paradigma, kaynak yoğundur ve görev başına dikkatli hiperparametre ayarıyla birlikte binlerce açıklamalı veri noktası gerektirir.

- Karşıt bir hedef kullanan mevcut modeller, yeni görevlere sıfır atış uyarlamasına izin verir, ancak altyazı veya görsel soru yanıtlama gibi daha açık uçlu görevlerde dil oluşturma yeteneklerinden yoksun oldukları için yetersiz kalırlar.

- Bu araştırma, bu sorunları etkili bir şekilde ele alan ve düşük veri rejimlerinde üstün performans gösteren yeni bir model tanıtmayı amaçlamaktadır.

Soruna nasıl yaklaşılır?

- DeepMind, yalnızca birkaç giriş/çıkış örneği kullanarak çeşitli açık uçlu vizyon ve dil görevlerinde birkaç adımda öğrenme için tasarlanmış VLM'ler olan Flamingo'yu tanıttı.

- Flamingo modelleri, resimler ve/veya videolarla karıştırılmış metin belirteçlerini işleyebilen ve çıktı olarak metin oluşturabilen, görsel olarak şartlandırılmış otoregresif metin oluşturma modelleridir.

- Flamingo'nun mimarisi, önceden eğitilmiş ve donmuş iki tamamlayıcı modeli birleştirir:

- Görsel sahneleri "algılayabilen" bir görüntü modeli.

- Temel muhakemeyi gerçekleştirmekle görevli geniş bir dil modeli.

- Yeni mimari bileşenler, bu modelleri, hesaplama açısından yoğun ön eğitimleri sırasında kazanılan bilgileri koruyacak şekilde entegre eder.

- Ek olarak, Flamingo modelleri, yüksek çözünürlüklü görüntüleri veya videoları almalarına izin veren, Algılayıcı tabanlı bir mimariye sahiptir. Bu mimari, geniş ve değişken bir görsel giriş özellikleri dizisinden görüntü/video başına sabit sayıda görsel belirteç üretebilir.

Sonuçlar ne?

- Araştırma, çok iyi öğrenen LLM'lere benzer şekilde, VLM'lerin sınıflandırma, altyazı oluşturma veya soru yanıtlama gibi görüntü ve video anlama görevleri için birkaç girdi/çıktı örneğinden öğrenebileceğini göstermektedir.

- Flamingo, çok sayıda 16 çok modlu dil ve görüntü/video anlama görevinde üstün performans sergileyerek, az atışla öğrenmede yeni bir ölçüt oluşturuyor.

- Flamingo, bu 6 görevden 16'sı için, göreve özgü yalnızca 32 örnek kullanmasına rağmen ince ayarlı son teknolojinin performansını geride bırakıyor - mevcut en iyi performans gösteren modellerden yaklaşık 1000 kat daha az göreve özel eğitim verisi.

Bu araştırma hakkında daha fazla bilgiyi nereden edinebilirsiniz?

Uygulama kodunu nereden edinebilirsiniz?

- DeepMind, Flamingo'nun resmi uygulamasını yayınlamadı.

- Tanıtılan yaklaşımın açık kaynak uygulamasını şurada bulabilirsiniz: OpenFlamingo Github Deposu.

- Alternatif PyTorch uygulaması mevcuttur okuyun.

5. Salesforce'tan BLIP-2

Özet

BLIP-2, büyük ölçekli modellerin ön eğitiminin giderek artan maliyetini aşmak için tasarlanmış, vizyon ve dil modelleri için verimli ve genel bir ön eğitim çerçevesidir. BLIP-2, iki aşamada önceden eğitilmiş hafif bir Querying Transformer içeren, önyükleyici görüntü dili ön eğitimi için kullanıma hazır donmuş önceden eğitilmiş görüntü kodlayıcıları ve donmuş büyük dil modellerinden yararlanır. İlk aşama, donmuş bir görüntü kodlayıcıdan öğrenmeyi görüntü dili temsili ile başlatır ve ikinci aşama, donmuş bir dil modelinden görüntüden dile üretken öğrenmeyi ilerletir. Önemli ölçüde daha az eğitilebilir parametreye sahip olmasına rağmen BLIP-2, 80 kat daha az eğitilebilir parametreyle sıfır vuruşlu VQAv8.7'de DeepMind'in Flamingo2B'sini %54 geride bırakarak en son teknolojiye sahip yöntemlerden daha iyi performans gösterir. Model ayrıca, doğal dil talimatlarını izleyerek umut verici sıfır çekim görüntüden metne oluşturma yetenekleri sergiliyor.

Amaç ne?

- Hesaplama maliyetlerini düşürürken görsel dil görevlerinde son teknoloji ürünü performans elde etmek için.

Soruna nasıl yaklaşılır?

- Salesforce ekibi, BLIP-2 adlı yeni bir vizyon dili ön eğitim çerçevesini kullanıma sundu. Bsızdırma Ldil-Isihirbaz Pdondurulmuş tek modlu modellerle yeniden eğitim:

- Önceden eğitilmiş tek modlu modeller, hesaplama maliyetini azaltmak ve feci unutma sorununu önlemek için ön eğitim sırasında donmuş halde kalır.

- Modlar arası hizalamayı kolaylaştırmak ve önceden eğitilmiş görüntü modelleri ile önceden eğitilmiş dil modelleri arasındaki modalite boşluğunu doldurmak için ekip, donmuş görüntü kodlayıcı ile donmuş kodlayıcı arasında bir bilgi darboğaz görevi gören hafif bir Sorgulama Transformatörü (Q-Former) önerir. LLM.

- Q-former, iki aşamalı yeni bir strateji ile önceden eğitilmiştir:

- İlk ön eğitim aşaması, görsel-dil temsili öğrenmeyi gerçekleştirir. Bu, Q-Former'ı metinle en alakalı görsel temsili öğrenmeye zorlar.

- İkinci ön eğitim aşaması, Q-Former'ın çıktısını dondurulmuş bir LLM'ye bağlayarak vizyondan dile üretken öğrenmeyi gerçekleştirir. Q-Former, çıktı görsel temsilinin LLM tarafından yorumlanabileceği şekilde eğitilmiştir.

Sonuçlar ne?

- BLIP-2, görsel soru yanıtlama, resim alt yazısı ekleme ve resim-metin alımını kapsayan çeşitli görsel dil görevlerinde olağanüstü, son teknoloji sonuçlar sunar.

- Örneğin, sıfır atışlı VQAv8.7'de Flamingo'dan %2 daha iyi performans gösterir.

- Ayrıca, bu olağanüstü performans, önemli ölçüde daha yüksek bilgisayar verimliliği ile elde edilir:

- BLIP-2, 80 kat daha az eğitilebilir parametre kullanırken Flamingo-54B'den daha iyi performans gösterir.

- BLIP-2, doğal dil talimatlarına yanıt olarak sıfır çekim görüntüden metne oluşturma kapasitesine sahiptir, böylece görsel bilgi muhakemesi ve görsel konuşma gibi diğer becerilerin geliştirilmesinin yolunu açar.

- Son olarak, BLIP-2'nin görme dili ön eğitiminin performansını daha da artırmak için daha gelişmiş tek modlu modellerden yararlanabilen çok yönlü bir yaklaşım olduğunu belirtmek önemlidir.

Bu araştırma hakkında daha fazla bilgiyi nereden edinebilirsiniz?

Uygulama kodunu nereden edinebilirsiniz?

Resmi BLIP-2 uygulaması şu adreste mevcuttur: GitHub.

6. Meta AI'dan LLaMA

Özet

Meta AI ekibi, daha fazla belirteç üzerinde eğitilen daha küçük modellerin belirli ürün uygulamaları için yeniden eğitilmesinin ve ince ayar yapılmasının daha kolay olduğunu iddia ediyor. Bu nedenle tanıştırırlar aramalar (Large Ladil Mörnek Meta AI), 7B ila 65B parametreleriyle temel dil modelleri koleksiyonu. LLaMA 33B ve 65B, 1.4 trilyon jetonla eğitilirken, en küçük model olan LLaMA 7B, bir trilyon jetonla eğitildi. Özel veya kısıtlı verilere bağlı olmaksızın, yalnızca halka açık veri kümelerini kullandılar. Ekip ayrıca önemli mimari iyileştirmeler ve eğitim hızı optimizasyon teknikleri uyguladı. Sonuç olarak, LLaMA-13B, 3 kattan daha küçük olan GPT-10'ten daha iyi performans gösterdi ve LLaMA-65B, PaLM-540B ile rekabetçi bir performans sergiledi.

Amaç ne?

- Tescilli veya kısıtlı veri kaynaklarına dayanmadan, yalnızca herkesin erişebileceği veri kümelerinde en iyi performans gösteren modelleri eğitmenin fizibilitesini göstermek.

- Araştırma topluluğuna daha küçük ve daha performanslı modeller sağlamak ve böylece büyük miktarda altyapıya erişimi olmayanların büyük dil modellerini incelemesini sağlamak.

Soruna nasıl yaklaşılır?

- Araştırmacılar, LLaMA modelini eğitmek için yalnızca halka açık ve açık kaynak kullanımıyla uyumlu verileri kullandı.

- Ayrıca standart Transformer mimarisine birkaç iyileştirme getirdiler:

- GPT-3 metodolojisini benimseyen eğitimin kararlılığı, çıkışı normalleştirmek yerine her trafo alt katmanı için girişi normalleştirerek geliştirildi.

- PaLM modellerinden ilham alan araştırmacılar, performansı iyileştirmek için ReLU doğrusal olmama durumunu SwiGLU aktivasyon fonksiyonu ile değiştirdiler.

- Esinlenen Su ve diğerleri (2021), mutlak konumsal yerleştirmeleri ortadan kaldırdılar ve bunun yerine ağın her katmanına döner konumsal gömmeler (RoPE) dahil ettiler.

- Son olarak Meta AI ekibi, modellerinin eğitim hızını şu şekilde iyileştirdi:

- Dikkat ağırlıklarını saklamayarak veya maskelenmiş anahtar/sorgu puanlarını hesaplamayarak verimli nedensel çok başlı dikkat uygulamasını kullanma.

- Geriye geçiş sırasında yeniden hesaplanan etkinleştirmeleri en aza indirmek için kontrol noktası kullanma.

- Aktivasyonların hesaplanması ve ağ üzerinden GPU'lar arasındaki iletişimin çakışması (all_reduce işlemleri nedeniyle).

Sonuçlar ne?

- LLaMA-13B, 3 kattan daha küçük olmasına rağmen GPT-10'ü geride bırakırken LLaMA-65B, PaLM-540B'ye karşı yerini koruyor.

Bu araştırma hakkında daha fazla bilgiyi nereden edinebilirsiniz?

Uygulama kodunu nereden edinebilirsiniz?

- Meta AI, akademik araştırmacılara, hükümetle bağlantılı bireylere, sivil topluma, akademik kurumlara ve küresel endüstri araştırma laboratuvarlarına bireysel vaka değerlendirme temelinde LLaMA'ya erişim sağlar. Başvurmak için aşağıdakilere gidin GitHub deposu.

7. OpenAI'den GPT-4

Özet

GPT 4 görüntü ve metin girişlerini kabul eden ve metin çıktıları üreten büyük ölçekli, çok modlu bir modeldir. Rekabet ve güvenlik endişeleri nedeniyle, modelin mimarisi ve eğitimiyle ilgili belirli ayrıntılar gizlenmiştir. Performans açısından GPT-4, geleneksel kıyaslamalarda önceki dil modellerini geride bırakıyor ve kullanıcı amacını anlama ve güvenlik özelliklerinde önemli gelişmeler gösteriyor. Model ayrıca, simüle edilmiş Tek Tip Çubuk Muayenesinde en yüksek %10'luk puan da dahil olmak üzere çeşitli sınavlarda insan düzeyinde performans elde ediyor.

Amaç ne?

- Görüntü ve metin girişlerini kabul edebilen ve metin çıktıları üretebilen büyük ölçekli, çok modlu bir model geliştirmek.

- Çok çeşitli ölçeklerde öngörülebilir şekilde davranan altyapı ve optimizasyon yöntemleri geliştirmek.

Soruna nasıl yaklaşılır?

- Rekabetçi ortam ve güvenlik etkileri nedeniyle OpenAI, mimari, model boyutu, donanım, eğitim hesaplaması, veri kümesi oluşturma ve eğitim yöntemleri hakkındaki ayrıntıları saklamaya karar verdi.

- Şunu ifşa ederler:

- GPT-4, bir belgedeki bir sonraki belirteci tahmin etmek için önceden eğitilmiş, Transformer tabanlı bir modeldir.

- Herkese açık verileri ve üçüncü taraf lisanslı verileri kullanır.

- Model, İnsan Geri Bildiriminden (RLHF) Takviyeli Öğrenim kullanılarak ince ayar yapılmıştır.

- Doğrulanmamış bilgiler, GPT-4'ün öncekiler gibi tekil yoğun bir model olmadığını, her biri şaşırtıcı derecede 220 milyar parametre içeren sekiz ayrı modelden oluşan güçlü bir koalisyon olduğunu gösteriyor.

Sonuçlar ne?

- GPT-4, çoğu profesyonel ve akademik sınavda insan düzeyinde performans elde eder ve özellikle simüle edilmiş Tek Tip Bar Sınavında ilk %10'a girer.

- Önceden eğitilmiş temel GPT-4 modeli, kıyaslamaya özel işçilik veya ek eğitim protokolleri olmaksızın geleneksel NLP kıyaslamalarında mevcut dil modellerinden ve önceki son teknoloji sistemlerden daha iyi performans gösterir.

- GPT-4, ChatGPT ve OpenAI API'den gelen 3.5 istemin %70.2'sinde GPT-5,214'in yanıtlarına göre tercih edilen yanıtlarıyla kullanıcı amacını takip etmede önemli bir gelişme gösteriyor.

- GPT-4'ün güvenlik özellikleri, izin verilmeyen içerik isteklerine yanıt vermede %3.5 azalma ve hassas istekler (ör. tıbbi tavsiye ve kendine zarar verme) için politikalara uygunlukta %82 artışla GPT-29'e kıyasla önemli ölçüde iyileşmiştir.

Bu araştırma hakkında daha fazla bilgiyi nereden edinebilirsiniz?

Uygulama kodunu nereden edinebilirsiniz?

- GPT-4'ün kod uygulaması mevcut değil.

Büyük (Vizyon) Dil Modellerinin Gerçek Dünya Uygulamaları

Son yıllardaki en önemli AI araştırma atılımları, devasa veri kümeleri üzerinde eğitilmiş büyük AI modellerinden gelmektedir. Bu modeller etkileyici performans sergiliyor ve yapay zekanın müşteri hizmetleri, pazarlama, e-ticaret, sağlık, yazılım geliştirme, gazetecilik ve diğer pek çok sektör gibi tüm sektörlerde nasıl devrim yaratabileceğini düşünmek büyüleyici.

Büyük dil modelleri çok sayıda gerçek dünya uygulamasına sahiptir. GPT-4 aşağıdakileri listeler:

- Chatbot'lar ve sanal asistanlar için doğal dil anlayışı ve üretimi.

- Diller arasında makine çevirisi.

- Makalelerin, raporların veya diğer metin belgelerinin özeti.

- Pazar araştırması veya sosyal medya takibi için duygu analizi.

- Pazarlama, sosyal medya veya yaratıcı yazı için içerik üretimi.

- Müşteri desteği veya bilgi tabanları için soru yanıtlama sistemleri.

- Spam filtreleme, konu sınıflandırması veya belge organizasyonu için metin sınıflandırması.

- Kişiselleştirilmiş dil öğrenme ve özel ders araçları.

- Kod üretimi ve yazılım geliştirme yardımı.

- Tıbbi, yasal ve teknik belge analizi ve yardımı.

- Metinden konuşmaya ve konuşmayı metne dönüştürme gibi engelli bireyler için erişilebilirlik araçları.

- Konuşma tanıma ve transkripsiyon hizmetleri.

Görsel bir kısım eklersek, olası uygulama alanları daha da genişler:

Son yapay zeka buluşlarını takip etmek ve bunların gerçek dünyadaki potansiyel uygulamaları hakkında düşünmek çok heyecan verici. Ancak, bu modelleri gerçek hayatta uygulamadan önce, ne yazık ki oldukça önemli olan ilgili riskleri ve sınırlamaları ele almamız gerekiyor.

Riskler ve Sınırlamalar

GPT-4'e riskleri ve sınırlamaları hakkında soru sorarsanız, muhtemelen size ilgili endişelerin uzun bir listesini verecektir. Bu listeyi filtreledikten ve bazı ek hususlar ekledikten sonra, modern büyük dil modellerinin sahip olduğu aşağıdaki temel riskler ve sınırlamalar grubuna ulaştım:

- Önyargı ve ayrımcılık: Bu modeller, genellikle önyargılar ve ayrımcı içerik içeren çok miktarda metin verisinden öğrenir. Sonuç olarak, üretilen çıktılar cinsiyet, ırk veya din gibi faktörlere dayalı basmakalıpları, saldırgan dili ve ayrımcılığı istemeden sürdürebilir.

- yanlış bilgi: Büyük dil modelleri, gerçeklere dayalı olarak yanlış, yanıltıcı veya güncelliğini yitirmiş içerik üretebilir. Modeller çok çeşitli kaynaklar üzerinde eğitilirken, her zaman en doğru veya güncel bilgileri sağlamayabilirler. Çoğu zaman bu, modelin yanıltıcı olsalar bile gramer açısından doğru veya tutarlı görünen çıktılar üretmeye öncelik vermesi nedeniyle olur.

- Anlayışsızlık: Bu modeller insan dilini anlıyor gibi görünse de, öncelikle eğitim verilerindeki kalıpları ve istatistiksel ilişkileri belirleyerek çalışırlar. Ürettikleri içerik hakkında derin bir anlayışa sahip değiller, bu da bazen anlamsız veya alakasız çıktılara yol açabiliyor.

- Uygunsuz içerik: Dil modelleri bazen rahatsız edici, zararlı veya uygunsuz içerik üretebilir. Bu tür içerikleri en aza indirmek için çaba harcansa da, eğitim verilerinin doğası ve modellerin bağlamı veya kullanıcı amacını ayırt edememesi nedeniyle yine de oluşabilir.

Sonuç

Büyük dil modelleri, şüphesiz doğal dil işleme alanında devrim yaratmış ve çeşitli roller ve endüstriler arasında üretkenliği artırmada muazzam bir potansiyel göstermiştir. İnsan benzeri metinler oluşturma, sıradan görevleri otomatikleştirme ve yaratıcı ve analitik süreçlerde yardım sağlama yetenekleri, onları günümüzün hızlı tempolu, teknoloji odaklı dünyasında vazgeçilmez araçlar haline getirdi.

Ancak, bu güçlü modellerle ilişkili sınırlamaları ve riskleri kabul etmek ve anlamak çok önemlidir. Önyargı, yanlış bilgilendirme ve kötü niyetli kullanım potansiyeli gibi konular göz ardı edilemez. Bu yapay zeka odaklı teknolojileri günlük hayatımıza entegre etmeye devam ederken, özellikle hassas ve yüksek riskli durumlarda, bu teknolojilerin yeteneklerini kullanmakla insan denetimini sağlamak arasında bir denge kurmak çok önemlidir.

Üretken yapay zeka teknolojilerini sorumlu bir şekilde benimsemeyi başarırsak, yapay zeka ve insan uzmanlığının inovasyonu yönlendirmek ve herkes için daha iyi bir dünya yaratmak için birlikte çalıştığı bir geleceğin yolunu açacağız.

Bu makaleyi beğendiniz mi? Daha fazla AI araştırma güncellemesi için kaydolun.

Bunun gibi daha özet makaleler yayınladığımızda size haber vereceğiz.

İlgili bağlantılar

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. Otomotiv / EV'ler, karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- Blok Ofsetleri. Çevre Dengeleme Sahipliğini Modernleştirme. Buradan Erişin.

- Kaynak: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- $UP

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- kabiliyet

- Yapabilmek

- Hakkımızda

- yukarıdaki

- kesin

- akademik

- Kabul et

- Kabul eder

- erişim

- ulaşılabilir

- Karşılamak

- Göre

- doğruluk

- doğru

- elde

- Elde Ediyor

- elde

- onaylamak

- karşısında

- Etkinleştirme

- aktivasyonlar

- eylemler

- uyarlamak

- adaptasyon

- eklemek

- ekleme

- ilave

- Ek

- adres

- adresleri

- Benimsemek

- gelişmeler

- tavsiye

- Sonra

- karşı

- Danışman

- AI

- ai araştırma

- Amaçları

- AL

- benzer

- Türkiye

- izin vermek

- Izin

- veriyor

- boyunca

- Ayrıca

- alternatif

- Rağmen

- her zaman

- ortasında

- arasında

- miktar

- tutarları

- an

- analiz

- Analitik

- ve

- Başka

- cevap

- herhangi

- api

- görünmek

- uygulamaları

- Tamam

- yaklaşım

- uygun

- yaklaşık olarak

- mimari

- mimari

- ARE

- alanlar

- etrafında

- Dizi

- Sanat

- göre

- mal

- yapay

- yapay zeka

- AS

- Yardım

- yardımcıları

- ilişkili

- dernekler

- At

- Dikkat

- Yazarlar

- otomatikleştirmek

- mevcut

- ortalama

- önlemek

- ödül

- Bakiye

- bar

- baz

- merkezli

- temel

- temel

- BE

- Çünkü

- müşterimiz

- önce

- olmak

- altında

- kıyaslama

- kriterler

- faydaları

- Daha iyi

- arasında

- önyargı

- önyargıları

- Milyar

- Kitaplar

- Çizme atkısı

- her ikisi de

- sınırları

- buluş

- buluşların

- KÖPRÜ

- geniş

- inşa etmek

- bina

- yapılı

- fakat

- by

- denilen

- CAN

- aday

- yapamam

- yetenekleri

- yetenekli

- Kapasite

- dikkatli

- dava

- felaket

- Sebeb olmak

- ceo

- CEO ve Kurucu

- zor

- şans

- değişiklik

- chatbots

- ChatGPT

- cips

- iddia

- sınıflandırma

- bulut

- Kurucu

- kod

- tutarlı

- Toplamak

- kombinasyon

- kombinasyonları

- nasıl

- taahhüt

- Yakın İletişim

- topluluk

- karşılaştırıldığında

- uyumlu

- rekabet

- tamamlayıcı

- karmaşık

- uyma

- bileşenler

- hesaplama

- hesaplamak

- bilgisayar

- bilgisayar

- kavramsal

- Endişeler

- yapılandırma

- ONAYLANDI

- bağlantı

- sonuç olarak

- hususlar

- kas kütlesi inşasında ve

- içerik

- bağlam

- bağlamlar

- devam etmek

- kontrast

- konuşma

- konuşmaları

- Dönüştürme

- doğru

- uyan

- Ücret

- maliyetler

- olabilir

- yaratmak

- çevrimiçi kurslar düzenliyorlar.

- Yaratıcı

- inandırıcı

- çok önemli

- akım

- müşteri

- Müşteri Hizmetleri

- Kullanıcı Desteği

- keskin kenar

- günlük

- veri

- Veri noktaları

- veri kümeleri

- Tarih

- karar

- azaltmak

- derin

- DeepMind

- sağlıyor

- göstermek

- gösterdi

- gösteriyor

- tasviridir

- Demolar

- bağlı

- dağıtma

- tasarlanmış

- Rağmen

- ayrıntılar

- geliştirmek

- geliştiriciler

- gelişen

- gelişme

- Diyalog

- Diyalog

- zor

- engelli

- ifşa

- ayırt etme

- ayırmak

- çeşitli

- do

- belge

- evraklar

- yok

- Hakimiyet

- Dont

- düzine

- sürücü

- dublajlı

- gereken

- sırasında

- e

- e-ticaret

- E&T

- her

- Erken

- kolay

- eğitsel

- Efekt

- etkili bir şekilde

- verim

- verimli

- çabaları

- elimine

- ortaya

- etkinleştirmek

- etkinleştirme

- kapsayan

- çekici

- İngilizce

- artırmak

- gelişmiş

- geliştirmeleri

- artırılması

- sağlanması

- gerekli

- kurmak

- kurar

- törel

- değerlendirilir

- değerlendirme

- değerlendirmeler

- Hatta

- Her

- her şey

- kanıt

- gelişen

- inceleme

- örnek

- örnekler

- aşıyor

- olağanüstü

- heyecan verici

- sadece

- sergileyen

- mevcut

- Genişletmek

- deneyler

- Uzmanlık

- Keşfetmek

- dış

- f1

- kolaylaştırmak

- faktörler

- Düşmek

- aile

- uzak

- büyüleyici

- hızlı tempolu

- Özellikler(Hazırlık aşamasında)

- özellikli

- Özellikler

- geribesleme

- az

- daha az

- alan

- şekil

- süzme

- bulmak

- Ad

- sabit

- sabit

- takip et

- takip etme

- İçin

- formlar

- Temeller

- kurucu

- iskelet

- itibaren

- dondurulmuş

- işlev

- temel

- esasen

- daha fazla

- gelecek

- kazandı

- boşluk

- Cinsiyet

- oluşturmak

- oluşturulan

- üretir

- üreten

- nesil

- üretken

- üretken yapay zeka

- jeneratör

- almak

- GitHub

- belirti

- Küresel

- Go

- gol

- gidiş

- Tercih Etmenizin

- Google'ın

- Hükümet

- GPU'lar

- sınıf

- çığır açan

- grup

- vardı

- olur

- Zor

- donanım

- zararlı

- Var

- sahip olan

- sağlık

- okuyun

- Yüksek kaliteli

- yüksek çözünürlük

- yüksek risk

- daha yüksek

- en yüksek

- tutar

- Ne kadar

- Ancak

- HTML

- HTTPS

- Kocaman

- insan

- Yüzlerce

- Yutturmaca

- Hiperparametre Ayarı

- Fikir

- belirlenmesi

- if

- görüntü

- görüntüleri

- muazzam

- uygulama

- uygulanan

- etkileri

- önemli

- etkileyici

- iyileştirmek

- gelişmiş

- iyileşme

- iyileştirmeler

- in

- derinlemesine

- yetersizlik

- dahil

- dahil

- Dahil olmak üzere

- Anonim

- birleştirir

- birleşmeyle

- Artırmak

- artmış

- artan

- giderek

- bireysel

- bireyler

- Endüstri

- sanayi

- bilgi

- Altyapı

- Başlattı

- Yenilikçilik

- giriş

- girişler

- yerine

- kurumları

- talimatlar

- entegre

- İstihbarat

- niyet

- ilginç

- içine

- tanıtmak

- tanıttı

- İcat edildi

- konu

- sorunlar

- IT

- ONUN

- kendisi

- gazetecilik

- jpg

- sadece

- anahtar

- anahtar görevler

- Bilmek

- bilgi

- Labs

- Eksiklik

- manzara

- dil

- Diller

- büyük

- büyük ölçekli

- büyük

- son

- tabaka

- katmanları

- öncülük etmek

- ÖĞRENİN

- öğrenme

- Yasal Şartlar

- az

- seviye

- seviyeleri

- Kaldıraç

- leverages

- kaldıraç

- ruhsatlı

- hayat

- hafif

- sevmek

- Muhtemelen

- sınırlamaları

- Liste

- Listeler

- Yaşıyor

- lama

- lokal olarak

- mantıksal

- Uzun

- Bakın

- Çok

- Düşük

- Makineler

- yapılmış

- yapmak

- YAPAR

- çok

- Marcus

- pazar

- Pazar araştırması

- Pazarlama

- malzeme

- matematik

- maksimum genişlik

- maksimum

- Mayıs..

- anlamlı

- medya

- tıbbi

- gitmek

- Meta

- metodoloji

- yöntemleri

- Microsoft

- akla

- en az

- yanlış bilgi

- yanıltıcı

- hataları

- karışık

- ML

- model

- modelleri

- Modern

- değiştirilmiş

- izleme

- Daha

- çoğu

- çok

- çoklu

- Müslümanlar

- Doğal (Madenden)

- Doğal lisan

- Doğal Dil İşleme

- Tabiat

- gerek

- gerekli

- ağ

- sinirsel

- Sinir Dili

- sinir ağı

- yeni

- haber

- sonraki

- güzel

- nlp

- özellikle

- hiçbir şey değil

- numara

- sayısız

- nesnel

- hedefleri

- meydana

- of

- saldırgan

- resmi

- sık sık

- on

- ONE

- olanlar

- bir tek

- açık

- açık kaynak

- OpenAI

- işletmek

- Operasyon

- optimizasyon

- or

- kuruluşlar

- Diğer

- Diğer

- bizim

- dışarı

- bir üstün

- Mağazasından

- çıktı

- ödenmemiş

- tekrar

- kendi

- palmiye

- kâğıt

- paradigma

- parametre

- parametreler

- Bölüm

- katılmak

- özellikle

- geçmek

- desen

- kaldırım döşemek

- asfaltlama

- başına

- yapmak

- performans

- icra

- gerçekleştirir

- ifadeler

- seçmek

- Platon

- Plato Veri Zekası

- PlatoVeri

- bakla

- Nokta

- noktaları

- politikaları

- mümkün

- potansiyel

- powered

- güçlü

- tahmin

- tercihli

- önceki

- öncelikle

- Önceki

- önceliklendirme

- Sorun

- sorunlar

- süreç

- Süreçler

- işleme

- üretmek

- PLATFORM

- verimlilik

- profesyonel

- Programlama

- Programlama dilleri

- Ilerleme

- umut verici

- özellikleri

- önermektedir

- özel

- protokolleri

- sağlamak

- sağlanan

- sağlar

- alenen

- yayınlanan

- amaçlı

- itme

- Python

- pytorch

- nitel

- kalite

- soru

- Sorular

- hızla

- Yarış

- menzil

- hızla

- daha doğrusu

- Okuma

- gerçek

- gerçek hayat

- Gerçek dünya

- son

- geçenlerde

- tanıma

- tanımak

- azaltmak

- azaltarak

- rejimler

- takviye öğrenme

- serbest

- serbest

- uygun

- güvenilir

- güvenilir kaynaklar

- din

- güvenerek

- kalmak

- kalmıştır

- dikkat çekici

- yerine

- Raporlar

- temsil

- isteklerinizi

- gerektirir

- gerektirir

- araştırma

- Araştırma Topluluğu

- Araştırmacılar

- yoğun kaynak

- saygı

- yanıt

- yanıt

- yanıtları

- kısıtlı

- sonuç

- Sonuçlar

- korur

- Yorumları

- devrim yapmak

- devrim

- riskler

- rekabet

- gürbüz

- rolleri

- oda

- güvenli

- Güvenlik

- satış ekibi

- aynı

- ölçek

- terazi

- ölçekleme

- senaryolar

- Sahneler

- Okul

- Gol

- skorları

- puanlama

- sorunsuz

- İkinci

- görünmek

- görüldü

- seçilmiş

- hassas

- ayrı

- Dizi

- ciddi

- hizmet

- Hizmetler

- set

- ayar

- birkaç

- sarsılmış

- kısa

- şov

- gösterdi

- Gösteriler

- işaret

- önemli

- önemli ölçüde

- benzer şekilde

- tekil

- durumlar

- beden

- becerileri

- daha küçük

- So

- şu ana kadar

- Sosyal Medya

- sosyal medya

- Toplum

- Yazılım

- yazılım geliştirme

- yalnızca

- çözüm

- çözer

- biraz

- sofistike

- Kaynak

- kaynaklar

- Kaynak Bulma

- Spam

- özel

- özellikle

- özgüllük

- muhteşem

- konuşmadan yazıya

- hız

- istikrar

- Aşama

- aşamaları

- standart

- standartlar

- Eyalet

- state-of-the-art

- istatistiksel

- istatistik

- Yine

- Stratejileri

- güçlü

- grev

- Ders çalışma

- önemli

- başarılı olmak

- böyle

- önermek

- Önerdi

- ÖZET

- üstün

- denetleme

- destek

- aştı

- sistem

- Sistemler

- Görüşmeler

- Görev

- görevleri

- takım

- Teknik

- teknikleri

- Teknolojileri

- şartlar

- test

- metin oluşturma

- Text-to-Speech

- göre

- Teşekkürler

- o

- The

- Gelecek

- Devlet

- Dünya

- ve bazı Asya

- Onları

- sonra

- Orada.

- böylece

- bu nedenle

- Bunlar

- onlar

- düşünmek

- üçüncü şahıslara ait

- Re-Tweet

- Bu

- gerçi?

- Binlerce

- üç

- İçinden

- zamanlar

- için

- bugünkü

- birlikte

- simge

- dizgeciklere

- Jeton

- çok

- araçlar

- üst

- TOPBOTLAR

- konu

- Konular

- karşı

- geleneksel

- Tren

- eğitilmiş

- Eğitim

- transfer

- transformatör

- dönüşüm

- Çeviri

- Trilyon

- turing

- Özel Ders

- iki

- koşulsuz

- altında

- anlamak

- anlayış

- üstlenmek

- şüphesiz

- ne yazık ki

- Evren

- aksine

- aktüel

- Güncellemeler

- kullanım

- Kullanılmış

- kullanıcı

- kullanım

- kullanma

- kullanır

- çeşitlilik

- çeşitli

- Geniş

- çok yönlü

- çok

- Video

- Videolar

- Sanal

- vizyonumuz

- VOX

- oldu

- Yol..

- we

- ağ

- İYİ

- vardı

- Ne

- ne zaman

- hangi

- süre

- DSÖ

- bütün

- geniş

- Geniş ürün yelpazesi

- Vikipedi

- irade

- ile

- içinde

- olmadan

- sözler

- İş

- birlikte çalışmak

- Dünya

- yazı yazıyor

- yıl

- henüz

- sen

- zefirnet

- Sıfır Atışta Öğrenme