Giriş

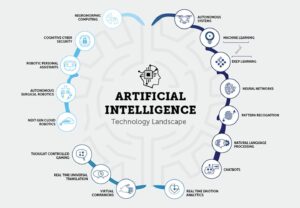

Yapay zeka (AI) alanı büyümeye ve gelişmeye devam ettikçe, gelecek vaat eden yapay zeka geliştiricilerinin en son araştırma ve gelişmelerden haberdar olmaları giderek daha önemli hale geliyor. Bunu yapmanın en iyi yollarından biri, en ileri teknikler ve algoritmalar hakkında değerli bilgiler sağlayan GenAI geliştiricileri için AI Makalelerini okumaktır. Bu makale GenAI geliştiricileri için 15 temel AI makalesini inceleyecek. Bu makaleler doğal dil işlemeden bilgisayarlı görmeye kadar çeşitli konuları kapsamaktadır. Yapay zeka anlayışınızı geliştirecek ve bu heyecan verici alanda ilk işinize girme şansınızı artıracaklar.

Yapay Zeka Makalelerinin GenAI Geliştiricileri İçin Önemi

GenAI geliştiricileri için AI Makaleleri, araştırmacıların ve uzmanların bulgularını, metodolojilerini ve buluşlarını daha geniş bir toplulukla paylaşmalarına olanak tanır. Bu makaleleri okuyarak yapay zekadaki en son gelişmelere erişim kazanırsınız, bu da diğerlerinden önde olmanıza ve işinizde bilinçli kararlar vermenize olanak tanır. Dahası, GenAI geliştiricileri için AI Makaleleri sıklıkla algoritmalar ve teknikler hakkında ayrıntılı açıklamalar sunarak bunların nasıl çalıştıkları ve gerçek dünya sorunlarına nasıl uygulanabilecekleri konusunda size daha derin bir anlayış sağlar.

GenAI geliştiricileri için AI Makalelerini okumak, gelecek vaat eden AI geliştiricileri için çeşitli avantajlar sunar. İlk olarak, alandaki en son araştırma ve trendlerden haberdar olmanıza yardımcı olur. İşverenler genellikle en son gelişmelere aşina olan adayları aradığından, bu bilgi yapay zeka ile ilgili işlere başvururken çok önemlidir. Ek olarak, AI makalelerini okumak bilginizi genişletmenize ve AI kavramları ve metodolojileri hakkında daha derin bir anlayış kazanmanıza olanak tanır. Bu bilgi projelerinize ve araştırmalarınıza uygulanarak sizi daha yetkin ve yetenekli bir yapay zeka geliştiricisi haline getirebilir.

İçindekiler

Genel Bakış: Bağlantılı Nesil Yapay Zeka Geliştiricileri için Temel Yapay Zeka Makaleleri

Makale 1: Transformers: İhtiyacınız Olan Tek Şey Dikkat

Bağlantı: Burayı oku

Makale Özeti

Makalede, makine çevirisi gibi dizi iletim görevleri için yeni bir sinir ağı mimarisi olan Transformer tanıtılmaktadır. Tekrarlayan veya evrişimli sinir ağlarına dayanan geleneksel modellerin aksine Transformer, yalnızca dikkat mekanizmalarına güvenerek tekrarlama ve evrişim ihtiyacını ortadan kaldırır. Yazarlar, bu mimarinin çeviri kalitesi, artırılmış paralelleştirilebilirlik ve azaltılmış eğitim süresi açısından üstün performans sunduğunu ileri sürmektedir.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- Dikkat Mekanizması

Transformer tamamen dikkat mekanizmaları üzerine inşa edilmiştir ve girdi ve çıktı dizileri arasındaki küresel bağımlılıkları yakalamasına olanak tanır. Bu yaklaşım, modelin dizilerdeki öğeler arasındaki mesafeyle sınırlı olmaksızın ilişkileri dikkate almasına olanak tanır.

- parallelleştirme

Transformer mimarisinin en büyük avantajlarından biri artan paralelleştirilebilirliğidir. Geleneksel yinelenen modeller sıralı hesaplamadan muzdariptir ve bu da paralelleştirmeyi zorlaştırır. Transformer'ın tasarımı, eğitim sırasında paralel işlemenin daha verimli olmasını sağlayarak eğitim sürelerini azaltır.

- Üstün Kalite ve Verimlilik

Makalede, Transformer'ın mevcut modellerle karşılaştırıldığında üstün çeviri kalitesi elde ettiğini gösteren, makine çevirisi görevlerine ilişkin deneysel sonuçlar sunulmaktadır. Topluluk modelleri de dahil olmak üzere önceki en son teknoloji sonuçlarından önemli bir farkla daha iyi performans gösteriyor. Ayrıca Transformer bu sonuçları önemli ölçüde daha az eğitim süresiyle gerçekleştirir.

- Çeviri Performansı

WMT 2014 İngilizceden Almancaya çeviri görevinde, önerilen model 28.4'lük bir BLEU puanı elde ederek mevcut en iyi sonuçları 2 BLEU'nun üzerinde geride bıraktı. İngilizceden Fransızcaya görevde model, sekiz GPU'da yalnızca 41.8 gün süren eğitimin ardından 3.5'lik yeni bir tek modelli, son teknoloji BLEU puanı oluşturuyor.

- Diğer Görevlere GenellemeYazarlar, Transformer mimarisinin makine çevirisinin ötesindeki görevlere de iyi bir şekilde genelleştirildiğini gösteriyor. Modeli İngiliz seçim bölgesi ayrıştırmasına başarılı bir şekilde uygulayarak farklı dizi transdüksiyon problemlerine uyarlanabilirliğini gösterdiler.

Makale 2: BERT: Dil Anlamak için Derin Çift Yönlü Transformatörlerin Ön Eğitimi

Bağlantı: Burayı oku

Makale Özeti

Dil modeli ön eğitiminin çeşitli doğal dil işleme görevlerini iyileştirmede etkili olduğu kanıtlanmıştır. Makale, önceden eğitilmiş dil temsillerini uygulamak için özellik tabanlı ve ince ayar yaklaşımları arasında ayrım yapmaktadır. BERT, ince ayar yaklaşımlarındaki sınırlamaları, özellikle de standart dil modellerinin tek yönlülük kısıtlamasını ele almak için tanıtıldı. Makale, çift yönlü temsilleri mümkün kılmak için Cloze görevinden ilham alan bir "Maskeli Dil Modeli" (MLM) eğitim öncesi hedefi önermektedir. Metin çifti temsillerini ortaklaşa önceden eğitmek için bir "sonraki cümle tahmini" görevi de kullanılır.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- Çift Yönlü Eğitim Öncesi Önemi

Makale dil temsilleri için çift yönlü ön eğitimin önemini vurgulamaktadır. Önceki modellerden farklı olarak BERT, önceki çalışmalarda kullanılan tek yönlü dil modellerini geride bırakarak derin çift yönlü temsilleri mümkün kılmak için maskeli dil modellerini kullanır.

- Göreve Özel Mimarilerde Azalma

BERT, önceden eğitilmiş temsillerin yoğun mühendislik gerektiren göreve özel mimarilere olan ihtiyacı azalttığını göstermektedir. Cümle düzeyinde ve belirteç düzeyinde çeşitli görevlerde en son teknolojiye sahip performansa ulaşan ve göreve özgü mimarilerden daha iyi performans gösteren ilk ince ayar tabanlı temsil modeli haline gelir.

- Son Teknoloji Gelişmeler

BERT, on bir doğal dil işleme görevinde son teknoloji ürünü yeni sonuçlar elde ederek çok yönlülüğünü ortaya koyuyor. Dikkate değer iyileştirmeler arasında GLUE puanında önemli bir artış, MultiNLI doğruluğu ve SQuAD v1.1 ve v2.0 soru yanıtlama görevlerindeki iyileştirmeler yer alıyor.

Ayrıca şunu okuyabilirsiniz: Maskeli Dil Modellemesi ile BERT'de İnce Ayar Yapma

Makale 3: GPT: Dil Modelleri Birkaç Adımda Öğrenir

Bağlantı: Burayı oku

Makale Özeti

Bu makale, doğal dil işleme (NLP) görevlerinde, dil modellerinin ölçeğini büyüterek elde edilen gelişmeleri tartışıyor; GPT 3 (Generative Pre-trained Transformer 3), 175 milyar parametreye sahip otoregresif bir dil modeli. Yazarlar şunu vurguluyor: son zamanlarda NLP modelleri Ön eğitim ve ince ayar yoluyla önemli kazanımlar gösterseler de, ince ayar için genellikle binlerce örnek içeren göreve özel veri kümeleri gerektirirler. Bunun aksine, insanlar birkaç örnekle veya basit talimatlarla yeni dil görevlerini yerine getirebilirler.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- Ölçeği Artırmak Birkaç Atış Performansını Artırır

Yazarlar, dil modellerinin ölçeğini büyütmenin görevden bağımsız, az sayıdaki performansı önemli ölçüde artırdığını gösteriyor. GPT-3, büyük parametre boyutuyla bazen göreve özgü ince ayar veya gradyan güncellemeleri olmadan, en son teknolojiye sahip ince ayar yaklaşımlarıyla rekabet edebilirlik elde eder.

- Geniş Uygulanabilirlik

GPT-3, çeviri, soru cevaplama, kapatma görevleri ve anında akıl yürütme veya etki alanı uyarlaması gerektiren görevler de dahil olmak üzere çeşitli NLP görevlerinde güçlü bir performans sergiliyor. - Zorluklar ve Sınırlamalar

GPT-3 dikkate değer az sayıda öğrenme yeteneği gösterse de, yazarlar zorlandığı veri kümelerini tespit ediyor ve büyük web derlemleri üzerinde eğitimle ilgili metodolojik sorunları vurguluyor. - İnsan Benzeri Makale Üretimi

GPT-3, insan değerlendiricilerin, insanlar tarafından yazılan makalelerden ayırt etmekte zorlandığı haber makaleleri oluşturabilir. - Toplumsal Etkiler ve Daha Geniş Hususlar

Makale, GPT-3'ün özellikle insan benzeri metin oluşturma konusundaki yeteneklerinin daha geniş toplumsal etkilerini tartışıyor. Çeşitli görevlerdeki performansının sonuçları, pratik uygulamalar ve potansiyel zorluklar açısından değerlendirilmektedir. - Mevcut NLP Yaklaşımlarının Sınırlamaları

Yazarlar, mevcut NLP yaklaşımlarının sınırlamalarını, özellikle de göreve özgü ince ayar veri kümelerine olan güvenlerini vurguluyor; bunlar, büyük etiketli veri kümelerine duyulan gereksinim ve dar görev dağılımlarına aşırı uyum riski gibi zorluklar ortaya çıkarıyor. Ek olarak, bu modellerin eğitim dağılımlarının sınırları dışında genelleme kabiliyetine ilişkin endişeler ortaya çıkmaktadır.

Makale 4: CNN'ler: Derin Evrişimli Sinir Ağlarıyla ImageNet Sınıflandırması

Bağlantı: Burayı oku

Makale Özeti

Makale, ImageNet Büyük Ölçekli Görsel Tanıma Yarışması (ILSVRC) veri kümelerinde görüntü sınıflandırması için geniş, derin evrişimli bir sinir ağının (CNN) geliştirilmesini ve eğitilmesini açıklamaktadır. Model, önceki en gelişmiş yöntemlere kıyasla sınıflandırma doğruluğunda önemli gelişmeler elde etmektedir.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- Model Mimarisi

Çalışmada kullanılan sinir ağı, 60 milyon parametreli ve 650,000 nöronlu derin bir CNN'dir. Bazıları maksimum havuzlama katmanları tarafından takip edilen beş evrişimli katmandan ve sınıflandırma için son 1000 yollu softmax'a sahip üç tamamen bağlı katmandan oluşur.

- Eğitim verileri

Model, ImageNet ILSVRC-1.2 yarışmasından elde edilen 2010 milyon yüksek çözünürlüklü görüntüden oluşan önemli bir veri kümesi üzerinde eğitilmiştir. Eğitim süreci, görüntülerin 1000 farklı sınıfa göre sınıflandırılmasını içerir.

- Performans

Model, test verilerinde sırasıyla %1 ve %5'lık ilk 37.5 ve ilk 17.0 hata oranlarına ulaşıyor. Bu hata oranları önceki teknolojiye göre önemli ölçüde daha iyidir ve bu da önerilen yaklaşımın etkililiğini göstermektedir.

- Aşırı Uyumdaki İyileştirmeler

Makalede, aşırı uyum sorunlarına çözüm bulmak için, doymamış nöronlar, daha hızlı eğitim için verimli GPU uygulaması ve tamamen bağlı katmanlarda "bırakma" adı verilen bir düzenleme yöntemi dahil olmak üzere çeşitli teknikler tanıtılmaktadır. - Hesaplamalı Verimlilik

Büyük CNN'lerin eğitiminin hesaplama gereksinimlerine rağmen makale, mevcut GPU'ların ve optimize edilmiş uygulamaların bu tür modellerin yüksek çözünürlüklü görüntüler üzerinde eğitilmesini mümkün kıldığını belirtiyor.

- Katılımlar

Makale, en büyük evrişimli sinir ağlarından birinin ImageNet veri kümeleri üzerinde eğitilmesi ve ILSVRC yarışmalarında son teknoloji sonuçların elde edilmesi de dahil olmak üzere çalışmanın katkılarını vurgulamaktadır.

Ayrıca şunu okuyabilirsiniz: Evrişimsel Sinir Ağlarını Öğrenmek için Kapsamlı Bir Eğitim

Makale 5: GAT'ler: Grafik Dikkat Ağları

Bağlantı: Burayı oku

Makale Özeti

Makale, grafik yapılı verilerde düğüm sınıflandırması için dikkat temelli bir mimari tanıtıyor ve çeşitli kıyaslamalarda bunun verimliliğini, çok yönlülüğünü ve rekabetçi performansını sergiliyor. Dikkat mekanizmalarının dahil edilmesinin keyfi yapılandırılmış grafikleri işlemek için güçlü bir araç olduğu kanıtlanmıştır.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- Grafik Dikkat Ağları (GAT'ler)GAT'ler, grafik evrişimlerine dayanan önceki yöntemlerdeki sınırlamaları ele almak için maskelenmiş öz-dikkatli katmanlardan yararlanır. Mimari, maliyetli matris işlemlerine veya grafik yapısına ilişkin önsel bilgiye dayanmadan, farklı düğümlere dolaylı olarak farklı ağırlıklar belirleyerek, düğümlerin kendi mahallelerinin özelliklerine dikkat etmelerine olanak tanır.

- Spektral Tabanlı Zorlukların Ele Alınması

GAT'lar, spektral tabanlı grafik sinir ağlarındaki çeşitli zorlukları aynı anda ele alır. Grafik Dikkat Ağı (GAT) zorlukları, mekansal olarak yerelleştirilmiş filtreleri, yoğun hesaplamaları ve uzaysal olarak yerelleştirilmemiş filtreleri içerir. Ek olarak, GAT'lar Laplacian öz tabanına bağlıdır ve bu onların tümevarımsal ve transdüktif problemlere uygulanabilirliğine katkıda bulunur.

- Karşılaştırmalarda Performans

GAT modelleri, dört yerleşik grafik kıyaslaması üzerinden en son teknolojiye sahip sonuçları elde eder veya eşleştirir: Cora, Citeseer ve Pubmed alıntı ağı veri kümelerinin yanı sıra bir protein-protein etkileşimi veri kümesi. Bu kıyaslamalar hem geçişken hem de tümevarımsal öğrenme senaryolarını kapsamakta ve GAT'ların çok yönlülüğünü ortaya koymaktadır.

- Önceki Yaklaşımlarla Karşılaştırma

Bu makale, özyinelemeli sinir ağları da dahil olmak üzere önceki yaklaşımlara kapsamlı bir genel bakış sunmaktadır. Grafik Sinir Ağları (GNN'ler), spektral ve spektral olmayan yöntemler ve dikkat mekanizmaları. GAT'lar, düğüm-komşu çiftleri arasında etkili paralelleştirmeye ve farklı derecelerdeki düğümlere uygulamaya olanak tanıyan dikkat mekanizmalarını içerir.

- Verimlilik ve UygulanabilirlikGAT'ler, komşulara keyfi ağırlıklar belirleyerek farklı derecelerdeki grafik düğümlerine uygulanabilecek paralelleştirilebilir, verimli bir işlem sunar. Model, tümevarımsal öğrenme problemlerine doğrudan uygulanarak, onu tamamen görünmeyen grafiklere genelleştirmenin gerekli olduğu görevlere uygun hale getirir.

- Önceki Modellerle İlişkisi

Yazarlar, GAT'ların MoNet'in belirli bir örneği olarak yeniden formüle edilebileceğini, ilişkisel ağlarla benzerlikler paylaşabileceğini ve mahalle dikkat operasyonlarını kullanan çalışmalara bağlanabileceğini belirtiyor. Önerilen dikkat modeli, Duan ve diğerleri gibi ilgili yaklaşımlarla karşılaştırılmıştır. (2017) ve Denil ve ark. (2017).

Makale 6: ViT: Bir Görüntü 16x16 Kelime Değerindedir: Büyük Ölçekte Görüntü Tanıma için Transformatörler

Bağlantı: Burayı oku

Makale Özeti

Makale, Transformer mimarilerinin doğal dil işlemedeki başarısına rağmen, bilgisayarlı görmede evrişimsel mimarilerin hakimiyetini kabul etmektedir. NLP'deki transformatörlerin verimliliğinden ve ölçeklenebilirliğinden ilham alan yazarlar, minimum değişiklikle standart bir transformatörü doğrudan görüntülere uyguladılar.

Tanıtıyorlar Görüntü Trafosu (ViT)görüntülerin yamalara bölündüğü ve bu yamaların doğrusal yerleştirme sırasının Transformer'a girdi olarak hizmet ettiği yer. Model, denetimli bir şekilde görüntü sınıflandırma görevleri konusunda eğitilir. Başlangıçta, güçlü bir düzenleme olmaksızın ImageNet gibi orta büyüklükteki veri kümeleri üzerinde eğitildiğinde ViT, karşılaştırılabilir ResNet'lerin biraz altında doğruluklara ulaşır.

Ancak yazarlar, belirli tümevarımsal önyargıların yokluğunun dayattığı sınırlamaları aşarak, büyük ölçekli eğitimin ViT'nin başarısı için çok önemli olduğunu ortaya koyuyor. Devasa veri kümeleri üzerinde önceden eğitildiğinde ViT, ImageNet, CIFAR-100 ve VTAB dahil olmak üzere birçok kıyaslamada son teknoloji evrişimli ağlardan daha iyi performans gösterir. Makale, bilgisayarlı görmede Transformer mimarileriyle dikkat çekici sonuçlar elde etmede ölçeklendirmenin etkisinin altını çiziyor.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- Bilgisayarla Görmede Transformatör

Makale, bilgisayarla görme görevleri için evrişimli sinir ağlarına (CNN'ler) olan yaygın güvene meydan okuyor. Bu, saf bir Transformer'ın doğrudan görüntü yama dizilerine uygulandığında görüntü sınıflandırma görevlerinde mükemmel performans elde edebileceğini göstermektedir.

- Görüntü Trafosu (ViT)

Yazarlar, NLP'deki Transformers'a benzer kişisel dikkat mekanizmalarını kullanan bir model olan Vision Transformer'ı (ViT) tanıtıyorlar. ViT, ImageNet, CIFAR-100 ve VTAB dahil olmak üzere çeşitli görüntü tanıma kriterlerinde rekabetçi sonuçlar elde edebilir.

- Eğitim Öncesi ve Transfer Öğrenimi

Makale, NLP'deki yaklaşıma benzer şekilde büyük miktarda veri üzerinde ön eğitimin ve ardından öğrenilen temsillerin belirli görüntü tanıma görevlerine aktarılmasının önemini vurgulamaktadır. ViT, ImageNet-21k veya JFT-300M gibi büyük veri kümeleri üzerinde önceden eğitildiğinde, çeşitli kıyaslamalarda son teknoloji evrişimli ağlardan daha iyi performans gösterir.

- Hesaplamalı VerimlilikViT, eğitim sırasında önemli ölçüde daha az hesaplama kaynağıyla dikkat çekici sonuçlar elde ediyor son teknoloji evrişimli ağlar. Bu verimlilik, özellikle modelin büyük ölçekte önceden eğitilmesi durumunda dikkate değerdir.

- Ölçeklendirme Etkisi

Makale, bilgisayarlı görmede Transformer mimarileriyle üstün performans elde etmede ölçeklendirmenin önemini vurgulamaktadır. Milyonlarca ila yüz milyonlarca görüntü içeren veri kümeleri üzerinde büyük ölçekli eğitim, ViT'nin CNN'lerde mevcut bazı tümevarımsal önyargıların eksikliğinin üstesinden gelmesine yardımcı olur.

Kağıt 7: AlphaFold2: AlphaFold ile son derece doğru protein yapısı

Bağlantı: Burayı oku

Makale Özeti

"AlphaFold2: AlphaFold ile son derece doğru protein yapısı" makalesi, protein yapılarını doğru bir şekilde tahmin eden bir derin öğrenme modeli olan AlphaFold2'yi tanıtıyor. AlphaFold2, yeni, dikkat temelli bir mimariden yararlanıyor ve protein katlamada çığır açıyor.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- AlfaKatlama2 proteinlerin 3 boyutlu yapısını amino asit dizilerinden tahmin etmek için dikkat mekanizmalarına sahip derin bir sinir ağı kullanır.

- Model, bilinen protein yapılarından oluşan geniş bir veri kümesi üzerinde eğitildi ve 14. Protein Yapısı Tahmininin Kritik Değerlendirmesi (CASP14) protein katlama yarışmasında benzeri görülmemiş bir doğruluk elde etti.

- AlphaFold2'nin doğru tahminleri potansiyel olarak ilaç keşfi, protein mühendisliği ve biyokimyanın diğer alanlarında devrim yaratabilir.

Makale 8: GAN'lar: Üretken Rekabet Ağları

Bağlantı: Burayı oku

Makale Özeti

Makale, derin üretken modellerin eğitimindeki zorlukları ele alıyor ve rakip ağlar adı verilen yenilikçi bir yaklaşımı tanıtıyor. Bu çerçevede, üretken ve ayrımcı modeller, üretken modelin gerçek verilerden ayırt edilemeyecek örnekler üretmeyi amaçladığı bir oyun içerisindedir. Bunun aksine, ayrımcı model gerçek ve üretilmiş örnekler arasında ayrım yapar. Rekabetçi eğitim süreci, üretken modelin veri dağıtımını kurtarmasıyla benzersiz bir çözüme yol açar.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- Çekişmeli Çerçeve

Yazarlar, iki modelin aynı anda eğitildiği çekişmeli bir çerçeve sunuyor; veri dağılımını yakalayan üretken bir model (G) ve bir örneğin üretken modelden ziyade eğitim verilerinden gelme olasılığını tahmin eden ayırt edici bir model (D).

- Minimax OyunuEğitim prosedürü, ayrımcı modelin hata yapma olasılığının maksimuma çıkarılmasını içerir. Bu çerçeve, minimax iki oyunculu bir oyun olarak formüle edilmiştir; burada üretken model, gerçek verilerden ayırt edilemeyen örnekler üretmeyi amaçlarken, ayırt edici model, bir örneğin gerçek mi yoksa doğru şekilde oluşturulmuş mu olduğunu sınıflandırmayı amaçlar.

- Benzersiz çözüm

G ve D için keyfi fonksiyonlarda benzersiz bir çözüm mevcuttur; G eğitim verisi dağılımını kurtarır ve D her yerde 1/2'ye eşittir. Bu dengeye çekişmeli eğitim süreciyle ulaşılır.

- Çok Katmanlı Algılayıcılar (MLP'ler)Yazarlar, çok katmanlı algılayıcılar G ve D'yi temsil ettiğinde tüm sistemin geri yayılma kullanılarak eğitilebileceğini göstermektedir. Bu, eğitim ve numune oluşturma sırasında Markov zincirlerine veya yuvarlanmamış yaklaşık çıkarım ağlarına olan ihtiyacı ortadan kaldırır.

- Yaklaşık Çıkarım Yok

Önerilen çerçeve, maksimum olasılık tahmininde zorlu olasılıksal hesaplamalara yaklaşmanın zorluklarını ortadan kaldırır. Aynı zamanda üretken bağlamda parçalı doğrusal birimlerin faydalarından yararlanma konusundaki zorlukların da üstesinden gelir.

Makale 9: RoBERTa: Sağlam Şekilde Optimize Edilmiş BERT Eğitim Öncesi Yaklaşımı

Bağlantı: Burayı oku

Makale Özeti

Makale, BERT'in yetersiz antrenman sorununu ele alıyor ve BERT'in performansını aşan optimize edilmiş bir versiyon olan RoBERTa'yı tanıtıyor. RoBERTa'nın eğitim prosedüründeki değişiklikler ve yeni bir veri kümesinin (CC-NEWS) kullanılması, çoklu doğal dil işleme görevlerinde en son teknolojiye sahip sonuçlara katkıda bulunur. Bulgular, dil modeli ön eğitiminin etkililiğinde tasarım seçimlerinin ve eğitim stratejilerinin önemini vurgulamaktadır. RoBERTa modeli ve kodu da dahil olmak üzere yayımlanan kaynaklar araştırma topluluğuna katkıda bulunuyor.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- BERT Alt Eğitimi

Yazarlar bunu buluyor BertYaygın olarak kullanılan bir dil modeli olan , önemli ölçüde yetersiz eğitilmişti. Hiperparametre ayarının ve eğitim seti boyutunun etkisini dikkatle değerlendirerek, BERT'in kendisinden sonra yayınlanan tüm modellerin performansına uyacak veya bu performansı aşacak şekilde geliştirilebileceğini gösteriyorlar.

- Geliştirilmiş Eğitim Tarifi (RoBERTa)

Yazarlar BERT eğitim prosedürüne RoBERTa'yı sağlayan değişiklikler getiriyor. Bu değişiklikler, daha büyük gruplarla uzatılmış eğitim sürelerini, sonraki cümle tahmin hedefinin ortadan kaldırılmasını, daha uzun diziler üzerinde eğitimi ve eğitim verileri için dinamik maskeleme modeli ayarlamalarını içerir.

- Veri Kümesi KatkısıMakalede, boyutu özel olarak kullanılan diğer veri kümeleriyle karşılaştırılabilir olan CC-NEWS adı verilen yeni bir veri kümesi tanıtılmaktadır. Bu veri kümesinin dahil edilmesi, eğitim kümesi boyutu etkilerinin daha iyi kontrol edilmesine yardımcı olur ve aşağı yönlü görevlerde performansın artmasına katkıda bulunur.

- Performans Başarıları

RoBERTa, önerilen modifikasyonlarla GLUE, RACE ve SQuAD dahil olmak üzere çeşitli kıyaslama görevlerinde en son teknolojiye sahip sonuçlara ulaşıyor. MNLI, QNLI, RTE, STS-B, SQuAD ve RACE gibi görevlerde tüm BERT sonrası yöntemlerin performansıyla eşleşir veya bu performansı aşar.

- Maskeli Dil Modeli Ön Eğitiminin Rekabet Gücü

Makale, maskeli dil modeli ön eğitim hedefinin doğru tasarım seçimleriyle birlikte yakın zamanda önerilen diğer eğitim hedefleriyle rekabet halinde olduğunu yeniden doğrulamaktadır.

- Yayınlanan Kaynaklar

Yazarlar, PyTorch'ta uygulanan ön eğitim ve ince ayar koduyla birlikte RoBERTa modellerini yayınlayarak bulgularının tekrarlanabilirliğine ve daha fazla araştırılmasına katkıda bulunuyorlar.

Ayrıca Oku: RoBERTa'ya Nazik Bir Giriş

Makale 10: NeRF: Görüntü Sentezi için Sahneleri Nöral Parlaklık Alanları Olarak Temsil Etme

Bağlantı: Burayı oku

Makale Özeti

Optimizasyon, bilinen kamera pozları ile gözlemlenen görüntüler ile sürekli sahne temsilinden oluşturulan görünümler arasındaki hatanın en aza indirilmesini içerir. Makale, daha yüksek frekanslı işlevleri yönetmek için konumsal kodlamayı tanıtarak ve yeterli örnekleme için gereken sorgu sayısını azaltmak amacıyla hiyerarşik bir örnekleme prosedürü önererek yakınsama ve verimlilikle ilgili zorlukları ele almaktadır.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- Sürekli Sahne Gösterimi

Makale, temel çok katmanlı algılayıcı (MLP) ağlarını kullanarak karmaşık sahneleri 5D sinirsel parlaklık alanları olarak temsil etmek için bir yöntem sunuyor.

- Türevlenebilir İşleme

Önerilen işleme prosedürü, standart RGB görüntüleri kullanılarak gradyan bazlı optimizasyona izin veren klasik hacim işleme tekniklerine dayanmaktadır.

- Hiyerarşik Örnekleme Stratejisi

Yakınsama sorunlarını ele alarak, görünür sahne içeriğine sahip alanlara yönelik MLP kapasitesini optimize etmek için hiyerarşik bir örnekleme stratejisi tanıtıldı.

- Konumsal KodlamaGiriş 5D koordinatlarını daha yüksek boyutlu bir alana eşlemek için konumsal kodlamanın kullanılması, yüksek frekanslı sahne içeriği için sinirsel parlaklık alanlarının başarılı bir şekilde optimize edilmesini sağlar.

Önerilen yöntem, sinirsel 3D temsillerin yerleştirilmesi ve derin evrişimli ağların eğitimi de dahil olmak üzere en son teknolojiye sahip görüntü sentezi yaklaşımlarını aşıyor. Bu makale, karmaşık sahne geometrisi ve görünümünü ele almadaki etkinliğini vurgulamak için ek videoda gösterilen ek karşılaştırmalarla birlikte, doğal ortamlarda RGB görüntülerinden yüksek çözünürlüklü fotogerçekçi yeni görünümler oluşturmak için sürekli bir sinirsel sahne temsilini tanıtmaktadır.

Makale 11: FunSearch: Büyük dil modelleriyle program aramadan elde edilen matematiksel keşifler

Bağlantı: Burayı oku

Makale Özeti

Makale, özellikle bilimsel keşiflerde karmaşık sorunları çözmek için Büyük Dil Modellerinden (LLM'ler) yararlanmaya yönelik yeni bir yaklaşım olan FunSearch'ü tanıtıyor. Ele alınan birincil zorluk, yüksek lisans eğitimlerinde makul ancak yanlış ifadelere yol açan konfabulasyonların (halüsinasyonlar) ortaya çıkmasıdır. FunSearch, bu sınırlamanın üstesinden gelmek için önceden eğitilmiş bir LLM'yi evrimsel bir prosedürde sistematik bir değerlendiriciyle birleştirir.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- Yüksek Lisans ile Problem Çözme

Makale, yüksek lisans eğitimlerinin karmaşık problemler için yeni fikirler ve doğru çözümler üretme konusunda kafa karıştırıcı olması veya başarısız olması sorununu ele alıyor. Özellikle matematiksel ve bilimsel zorluklar için yeni, doğrulanabilir doğru fikirler bulmanın önemini vurguluyor.

- Evrimsel Prosedür – FunSearch

FunSearch, önceden eğitilmiş bir LLM'yi evrimsel bir süreçte bir değerlendiriciyle birleştirir. Düşük puan alan programları tekrar tekrar yüksek puan alan programlara dönüştürerek yeni bilgilerin keşfedilmesini sağlar. Süreç, en iyi çekim yönlendirmesini, program iskeletlerinin geliştirilmesini, program çeşitliliğini korumayı ve eşzamansız olarak ölçeklendirmeyi içerir.

- Extremal Kombinatoriklere Uygulama

Bu makale, FunSearch'ün aşırı kombinatoriklerdeki üst sınır belirleme sorunu üzerindeki etkinliğini göstermektedir. FunSearch, en iyi bilinen sonuçları aşan ve asimptotik alt sınırda 20 yıldaki en büyük iyileşmeyi sağlayan büyük kapsamlı kümelerin yeni yapılarını keşfeder.

- Algoritmik Problem – Çevrimiçi Kutu Paketleme

FunSearch, çevrimiçi çöp kutusu paketleme sorununa uygulanarak, iyi çalışılmış ilgi dağılımlarında geleneksel algoritmalardan daha iyi performans gösteren yeni algoritmaların keşfedilmesine yol açar. Potansiyel uygulamalar arasında iş planlama algoritmalarının iyileştirilmesi de yer alıyor.

- Programlar ve ÇözümlerFunSearch, doğrudan çözüm çıktısı vermek yerine, bir sorunun nasıl çözüleceğini açıklayan programlar oluşturmaya odaklanır. Bu programlar daha yorumlanabilir olma eğilimindedir, alan uzmanlarıyla etkileşimi kolaylaştırır ve sinir ağları gibi diğer açıklama türlerine göre konuşlandırılması daha kolaydır.

- Disiplinlerarası Etki

FunSearch'ün metodolojisi, çok çeşitli sorunların keşfedilmesine olanak tanıyarak onu disiplinlerarası uygulamalarla çok yönlü bir yaklaşım haline getirir. Makale, LLM'leri kullanarak doğrulanabilir bilimsel keşifler yapma potansiyelini vurguluyor.

Makale 12: VAE'ler: Değişken Bölümleri Otomatik Kodlama

Bağlantı: Burayı oku

Makale Özeti

"Otomatik Kodlama Varyasyonel Bayes" makalesi, özellikle sonsal dağılımlar zorlu olduğunda ve büyük veri kümeleriyle uğraşırken, sürekli gizli değişkenlere sahip yönlendirilmiş olasılıksal modellerde verimli çıkarım ve öğrenme zorluğunu ele almaktadır. Yazarlar, büyük veri kümeleri için iyi ölçeklenen ve zorlu sonsal dağılımlarda bile uygulanabilir kalan stokastik bir varyasyonel çıkarım ve öğrenme algoritması önermektedir.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- Varyasyonel Alt Sınırın Yeniden Parametrelendirilmesi

Makale, bir alt sınır tahmincisi ile sonuçlanan varyasyonel alt sınırın yeniden parametrelendirilmesini göstermektedir. Bu tahmin edici, standart stokastik gradyan yöntemleri kullanılarak optimizasyona uygundur ve bu da onu hesaplama açısından verimli kılar.

- Sürekli Gizli Değişkenler için Verimli Arka ÇıkarımYazarlar, veri noktası başına sürekli gizli değişkenlere sahip veri kümeleri için Otomatik Kodlama VB (AEVB) algoritmasını önermektedir. Bu algoritma, bir tanıma modelini optimize etmek için Stokastik Gradyan Değişken Bayes (SGVB) tahmincisini kullanır ve atalardan kalma örnekleme yoluyla verimli yaklaşık arka çıkarımı mümkün kılar. Bu yaklaşım, her veri noktası için Markov Zinciri Monte Carlo (MCMC) gibi pahalı yinelemeli çıkarım şemalarından kaçınır.

- Teorik Avantajlar ve Deneysel Sonuçlar

Önerilen yöntemin teorik avantajları deneysel sonuçlara yansıtılmıştır. Makale, yeniden parametrelendirme ve tanıma modelinin hesaplama verimliliği ve ölçeklenebilirliğe yol açarak yaklaşımı büyük veri kümelerine ve sonsalın zorlu olduğu durumlarda uygulanabilir hale getirdiğini öne sürüyor.

Ayrıca okuyun: Makine Öğreniminde Stokastik Özünün Ortaya Çıkarılması

Kağıt 13: UZUN KISA SÜRELİ BELLEK

Bağlantı: Burayı oku

Makale Özeti

Bu makale, tekrarlayan sinir ağlarında bilginin uzun zaman aralıklarında saklanmasını öğrenmenin zorluğunu ele almaktadır. Yetersiz ve azalan hata geri akışı sorunlarının üstesinden gelen, "Uzun Kısa Süreli Bellek" (LSTM) adı verilen yeni, etkili, gradyan tabanlı bir yöntem sunar. LSTM, "sabit hata karuselleri" aracılığıyla sabit hata akışını zorunlu kılar ve erişimi kontrol etmek için çarpımsal kapı birimlerini kullanır. Yerel uzay-zaman karmaşıklığı (zaman adımı ve ağırlık başına O(1)) ile deneysel sonuçlar, LSTM'nin, özellikle uzun zaman gecikmeli görevler için öğrenme hızı ve başarı oranları açısından mevcut algoritmalardan daha iyi performans gösterdiğini göstermektedir.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- Problem analizi

Makale, tekrarlayan sinir ağlarında hata geri akışıyla ilgili zorlukların ayrıntılı bir analizini sunarak, zaman içinde patlayan veya kaybolan hata sinyalleri sorunlarını vurguluyor.

- LSTM'nin Tanıtımı

Yazarlar, LSTM'yi, kaybolan ve patlayan hata sinyalleri sorunlarını çözmek için tasarlanmış yeni bir mimari olarak tanıtıyorlar. LSTM, özel birimler aracılığıyla sabit hata akışını içerir ve bu hata akışına erişimi düzenlemek için çarpımsal kapı birimleri kullanır.

- Deneysel sonuçlar

Yapay verilerle yapılan deneyler yoluyla makale, LSTM'nin BPTT, RTRL, Tekrarlayan basamaklı korelasyon, Elman ağları ve Sinir Dizisi Parçalama dahil olmak üzere diğer tekrarlayan ağ algoritmalarından daha iyi performans gösterdiğini göstermektedir. LSTM, özellikle uzun gecikmeli karmaşık görevleri çözmede daha hızlı öğrenme ve daha yüksek başarı oranları gösterir.

- Uzay ve Zamanda Yerel

LSTM, zaman adımı ve ağırlık başına hesaplama karmaşıklığının O(1) olduğu, uzay ve zamanda yerel bir mimari olarak tanımlanır.

- uygulanabilirlik

Önerilen LSTM mimarisi, önceki tekrarlayan ağ algoritmaları tarafından başarılı bir şekilde ele alınamayan karmaşık, yapay, uzun süreli gecikmeli görevleri etkili bir şekilde çözmektedir.

- Sınırlamalar ve Avantajlar

Makalede LSTM'nin sınırlamaları ve avantajları tartışılarak, önerilen mimarinin pratik uygulanabilirliği hakkında fikir verilmektedir.

Ayrıca okuyun: LSTM nedir? Uzun Kısa Süreli Belleğe Giriş

Makale 14: Doğal Dil Denetiminden Aktarılabilir Görsel Modellerin Öğrenilmesi

Bağlantı: Burayı oku

Makale Özeti

Makale, önceden belirlenmiş nesne kategorilerinin sabit kümelerine dayanmak yerine, görüntülerle ilgili ham metinden doğrudan öğrenerek son teknoloji ürünü bilgisayarlı görüş sistemlerinin eğitimini araştırıyor. Yazarlar, internetten toplanan 400 milyon (resim, metin) çiftinden oluşan bir veri kümesini kullanarak, belirli bir görsele hangi başlığın karşılık geldiğini tahmin etmeye yönelik bir ön eğitim görevi önermektedir. Ortaya çıkan model, CLIP (Karşılaştırmalı Dil-Görüntü Ön Eğitimi), görüntü temsillerinin verimli ve ölçeklenebilir şekilde öğrenildiğini gösterir. Ön eğitimden sonra, doğal dil görsel kavramlara atıfta bulunarak çeşitli alt görevlere sıfır atış aktarımını mümkün kılar. CLIP, 30'dan fazla bilgisayarlı görüntü veri kümesiyle karşılaştırılarak göreve özel eğitim gerektirmeden rekabetçi performans sergiliyor.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

- Bilgisayarla Görme İçin Doğal Dil Eğitimi

Makale, ImageNet gibi kalabalık etiketli veri kümeleri üzerinde geleneksel eğitim yaklaşımı yerine bilgisayarlı görme modellerini eğitmek için doğal dil denetiminin kullanımını araştırıyor.

- Eğitim Öncesi GörevYazarlar basit bir ön eğitim görevi öneriyorlar: belirli bir görüntüye hangi başlığın karşılık geldiğini tahmin etmek. Bu görev, çevrimiçi olarak toplanan 400 milyon (görüntü, metin) çiftinden oluşan devasa bir veri kümesinde en son teknolojiye sahip görüntü temsillerini sıfırdan öğrenmek için kullanılır.

- Sıfır Atış Transferi

Ön eğitimden sonra model, öğrenilen görsel kavramlara atıfta bulunmak veya yenilerini tanımlamak için doğal dili kullanır. Bu, belirli bir veri kümesi eğitimi gerektirmeden modelin alt görevlere sıfır atışla aktarılmasını sağlar.

- Çeşitli Görevlerde Kıyaslama

Makale, OCR, videolarda eylem tanıma, coğrafi konum belirleme ve ayrıntılı nesne sınıflandırması gibi görevleri kapsayan 30'dan fazla farklı bilgisayarlı görüntü veri kümesi üzerinde önerilen yaklaşımın performansını değerlendirmektedir.

- Rekabetçi Performans

Model, çeşitli görevlerde tamamen denetlenen temellerle rekabetçi bir performans sergiliyor ve genellikle veri kümesine özgü ek eğitim olmadan göreve özgü veri kümeleri üzerinde eğitilen modellerin doğruluğuyla eşleşiyor veya onları aşıyor.

- Ölçeklenebilirlik Çalışması

Yazarlar, farklı seviyelerde hesaplama kaynaklarına sahip sekiz modelden oluşan bir seriyi eğiterek yaklaşımlarının ölçeklenebilirliğini inceliyorlar. Aktarım performansının, hesaplamanın sorunsuz bir şekilde tahmin edilebilir bir işlevi olduğu bulunmuştur.

- Model Sağlamlığı

Makale, sıfır atışlı CLIP modellerinin, eşdeğer doğrulukla denetlenen ImageNet modellerinden daha sağlam olduğunu vurgulayarak, görevden bağımsız modellerin sıfır atışlı değerlendirmesinin, bir modelin kapasitesinin daha temsili bir ölçüsünü sağladığını öne sürüyor.

Makale 15: LORA: BÜYÜK DİL MODELLERİNİN DÜŞÜK DÜZEYDE UYARLANMASI

Bağlantı: Burayı oku

Makale Özeti

Makale, LoRA'yı, önceden eğitilmiş büyük dil modellerini belirli görevlere uyarlamak ve artan boyutlarıyla ilişkili dağıtım zorluklarını ele almak için etkili bir yöntem olarak önermektedir. Yöntem, çeşitli kıyaslamalarda model kalitesini korurken veya geliştirirken, eğitilebilir parametreleri ve GPU bellek gereksinimlerini önemli ölçüde azaltır. Açık kaynak uygulaması, LoRA'nın pratik uygulamalarda benimsenmesini daha da kolaylaştırır.

GenAI Geliştiricileri için Yapay Zeka Makalelerine İlişkin Temel Bilgiler

1. Sorun bildirimi

- Büyük ölçekli ön eğitim ve ardından ince ayar, doğal dil işlemede yaygın bir yaklaşımdır.

- Modeller büyüdükçe, özellikle GPT-3 (175 milyar parametre) gibi çok büyük parametrelere sahip modeller dağıtılırken ince ayar yapılması daha az uygulanabilir hale gelir.

2. Önerilen Çözüm: Düşük Sıralı Uyarlama (LoRA)

- Makalede, önceden eğitilmiş model ağırlıklarını donduran ve Transformer mimarisinin her katmanına eğitilebilir sıra ayrıştırma matrisleri sunan bir yöntem olan LoRA tanıtılmaktadır.

- LoRA, tam ince ayar ile karşılaştırıldığında aşağı akış görevleri için eğitilebilir parametrelerin sayısını önemli ölçüde azaltır.

3. LoRA'nın Faydaları

- Parametre Azaltma: İnce ayar ile karşılaştırıldığında LoRA, eğitilebilir parametrelerin sayısını 10,000 kata kadar azaltarak hesaplama açısından daha verimli hale getirebilir.

- Bellek Verimliliği: LoRA, ince ayara kıyasla GPU bellek gereksinimlerini 3 kata kadar azaltır.

- Model Kalitesi: Eğitilebilir daha az parametreye sahip olmasına rağmen LoRA, RoBERTa, DeBERTa, GPT-2 ve GPT-3 dahil olmak üzere çeşitli modellerde model kalitesi açısından ince ayara eşit veya ondan daha iyi performans gösterir.

4. Dağıtım Zorluklarının Aşılması

- Makale, LoRA'yı tanıtarak birçok parametreli modelleri dağıtmanın zorluğunu ele alıyor ve tüm modelin yeniden eğitilmesine gerek kalmadan verimli görev değişimine olanak tanıyor.

5. Verimlilik ve Düşük Çıkarım Gecikmesi

- LoRA, farklı görevler için birden fazla LoRA modülü oluşturmaya yönelik önceden eğitilmiş bir modelin paylaşılmasını kolaylaştırarak depolama gereksinimlerini ve görev değiştirme yükünü azaltır.

- Uyarlanabilir optimize ediciler kullanıldığında girişin önündeki donanım engeli 3 kata kadar azaltılarak eğitim daha verimli hale getirilir.

6. Uyumluluk ve Entegrasyon

- LoRA, önceki çeşitli yöntemlerle uyumludur ve önek ayarlama gibi yöntemlerle birleştirilebilir.

- Önerilen doğrusal tasarım, tamamen ince ayarlı modellerle karşılaştırıldığında ek çıkarım gecikmesi sunmadan, konuşlandırma sırasında eğitilebilir matrislerin donmuş ağırlıklarla birleştirilmesine olanak tanır.

7. Ampirik inceleme

- Makale, dil modeli uyarlamasındaki sıralama eksikliğine ilişkin ampirik bir araştırmayı içermekte ve LoRA yaklaşımının etkililiğine dair içgörüler sağlamaktadır.

8. Açık Kaynak Uygulaması

- Yazarlar, LoRA'nın PyTorch modelleriyle entegrasyonunu kolaylaştıran ve RoBERTa, DeBERTa ve GPT-2 için uygulamaları ve model kontrol noktalarını yayınlayan bir paket sunuyor.

Şunları da okuyabilirsiniz: LoRA ve QLoRA ile Büyük Dil Modellerinde Parametre Açısından Verimli İnce Ayar

Sonuç

Sonuç olarak, bu makalede vurgulanan GenAI geliştiricileri için 15 temel AI Belgesini incelemek, yalnızca bir öneri değil, aynı zamanda gelecek vaat eden geliştiriciler için stratejik bir zorunluluktur. Bu yapay zeka makaleleri, doğal dil işleme, bilgisayarlı görme ve ötesi gibi kritik alanları kapsayan, yapay zekanın çeşitli alanlarında kapsamlı bir yolculuk sunuyor. Geliştiriciler, bu makalelerde sunulan anlayışlara ve yeniliklere kendilerini kaptırarak, alanın en ileri teknikleri ve algoritmaları hakkında derinlemesine bir anlayış kazanırlar.

İlgili bağlantılar

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://www.analyticsvidhya.com/blog/2024/01/essential-ai-papers-every-gen-ai-developer-must-read/

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- $UP

- 000

- 1

- 10

- 11

- 12

- 13

- 14

- %15

- 17

- 20

- 20 yıl

- 2014

- 2017

- 28

- 30

- 3d

- 400

- 41

- 60

- 7

- 8

- 9

- 913

- a

- kabiliyet

- Hakkımızda

- AC

- erişim

- doğruluk

- doğru

- tam olarak

- Başarmak

- elde

- Elde Ediyor

- elde

- karşısında

- Action

- adaptasyon

- adaptif

- Ek

- Ayrıca

- adres

- ele

- adresleri

- adresleme

- ayarlamaları

- Benimseme

- gelişmeler

- avantaj

- avantajları

- düşmanca

- Sonra

- önde

- AI

- Amaçları

- AL

- algoritma

- algoritmalar

- Türkiye

- izin vermek

- Izin

- veriyor

- boyunca

- Ayrıca

- tutarları

- an

- analiz

- ve

- herhangi

- uygulanabilir

- Uygulama

- uygulamaları

- uygulamalı

- geçerlidir

- Tamam

- Uygulanması

- yaklaşım

- yaklaşımlar

- yaklaşık

- mimari

- ARE

- alanlar

- tartışmak

- ortaya

- göre

- mal

- yapay

- yapay zeka

- Yapay zeka (AI)

- AS

- can atan

- değerlendirme

- ilişkili

- At

- katılmak

- Dikkat

- Yazarlar

- bariyer

- merkezli

- temel

- BE

- olur

- olmak

- altında

- kıyaslama

- Benchmarking

- kriterler

- faydaları

- İYİ

- Daha iyi

- arasında

- Ötesinde

- önyargıları

- Milyar

- BIN

- artırmak

- her ikisi de

- bağlı

- buluş

- buluşların

- Daha geniş

- bina

- yapılı

- fakat

- by

- denilen

- geldi

- kamera

- CAN

- adaylar

- kapak

- yetenekleri

- kabiliyet

- Kapasite

- ele geçirmek

- yakalar

- dikkatlice

- şelaleler

- kategoriler

- belli

- zincir

- zincirler

- meydan okuma

- zorluklar

- zor

- şansı

- değişiklikler

- choices

- sınıflar

- sınıflandırma

- sınıflandırmak

- CNN

- kod

- kombine

- biçerdöverler

- ortak

- topluluk

- karşılaştırılabilir

- karşılaştırıldığında

- karşılaştırmalar

- uyumlu

- yetkili

- rekabet

- Yarışmalar

- rekabet

- rekabet

- tamamen

- karmaşık

- karmaşıklık

- kapsamlı

- hesaplama

- bilişimsel

- hesaplamalar

- bilgisayar

- Bilgisayar görüşü

- bilgisayar

- kavramlar

- Endişeler

- sonuç

- Sosyal medya

- bağlı

- Düşünmek

- kabul

- oluşur

- sabit

- içerik

- yarışma

- bağlam

- devam ediyor

- sürekli

- kontrast

- katkıda bulunmak

- katkıda bulunur

- katkıda

- katkıları

- kontrol

- Yakınsama

- evrişimli sinir ağı

- doğru

- doğru

- Ilişki

- tekabül

- pahalı

- kapak

- kaplama

- kritik

- çok önemli

- akım

- eğri

- keskin kenar

- veri

- veri kümeleri

- Günler

- ilgili

- kararlar

- azalır

- derin

- derin öğrenme

- derin sinir ağı

- derin

- talepleri

- göstermek

- gösteriyor

- tasviridir

- bağlı

- bağımlılıklar

- dağıtmak

- dağıtma

- açılma

- tanımlamak

- tarif edilen

- açıklar

- Dizayn

- tasarlanmış

- Rağmen

- detaylı

- Geliştirici

- geliştiriciler

- gelişen

- farklı

- zor

- zorluklar

- yönlendirilmiş

- direkt olarak

- keşfeder

- keşif

- mesafe

- ayırmak

- farklılaşacaktır

- dağıtım

- Dağılımlar

- çeşitli

- Çeşitlilik

- do

- domain

- etki

- Hakimiyet

- ilaç

- ilaç keşfi

- sırasında

- dinamik

- E&T

- her

- kolay

- Etkili

- etkili bir şekilde

- etki

- etkileri

- etki

- verim

- verimli

- sekiz

- ya

- elemanları

- on bir

- ortadan kaldırır

- ortadan

- vurgulamak

- vurgulamaktadır

- işverenler

- istihdam

- etkinleştirmek

- sağlar

- etkinleştirme

- kodlama

- meşgul

- Mühendislik

- İngilizce

- artırmak

- geliştirmeleri

- Geliştirir

- sağlanması

- Tüm

- Baştan sona

- giriş

- eşit

- denge

- Eşdeğer

- hata

- özellikle

- öz

- gerekli

- kurulmuş

- kurar

- tahminleri

- Eter (ETH)

- değerlendirilmesi

- değerlendirme

- Hatta

- her yerde

- gelişmek

- geliştikçe

- gelişen

- örnekler

- aşmak

- aşıyor

- mükemmel

- heyecan verici

- sergileyen

- mevcut

- var

- Genişletmek

- pahalı

- deneysel

- deneyler

- uzmanlara göre

- keşif

- keşfetmek

- araştırıyor

- Keşfetmek

- genişletilmiş

- kolaylaştırır

- kolaylaştırıcı

- başarısız

- tanıdık

- Daha hızlı

- mümkün

- Özellikler

- az

- daha az

- alan

- Alanlar

- filtreler

- son

- bulmak

- bulma

- bulgular

- Ad

- uydurma

- beş

- sabit

- akış

- odaklanır

- odaklanma

- takip

- İçin

- bulundu

- dört

- iskelet

- Sıklık

- itibaren

- dondurulmuş

- tam

- tamamen

- işlev

- fonksiyonlar

- daha fazla

- Kazanç

- Kazançlar

- oyun

- Gans

- kapı

- genai

- oluşturmak

- oluşturulan

- üreten

- üretken

- üretken model

- nazik

- geometri

- verilmiş

- Verilmesi

- Küresel

- GPU

- GPU'lar

- grafik

- grafik sinir ağları

- grafikler

- Büyümek

- sap

- kullanma

- donanım

- sahip olan

- yardımcı olur

- hiyerarşik

- Yüksek

- Yüksek frekans

- yüksek çözünürlük

- daha yüksek

- Vurgulamak

- Vurgulanan

- vurgulayarak

- özeti

- büyük ölçüde

- Ne kadar

- Nasıl Yapılır

- HTTPS

- insan

- İnsanlar

- Yüzlerce

- yüz milyonlarca

- Hiperparametre Ayarı

- fikirler

- belirlemek

- görüntü

- Görüntü sınıflandırması

- Görüntü Tanıma

- IMAGEnet

- görüntüleri

- darbe

- Etkiler

- zorunlu

- uygulama

- uygulamaları

- uygulanan

- etkileri

- önem

- önemli

- dayatılan

- gelişmiş

- iyileşme

- iyileştirmeler

- geliştirir

- geliştirme

- in

- dahil

- içerir

- Dahil olmak üzere

- birleştirmek

- birleştirir

- Artırmak

- artmış

- artan

- giderek

- belirten

- bilgi

- bilgi

- başlangıçta

- yenilikler

- yenilikçi

- giriş

- anlayışlar

- ilham

- örnek

- yerine

- talimatlar

- bütünleşme

- İstihbarat

- yoğun

- etkileşim

- etkileşimleri

- faiz

- Internet

- içine

- tanıtmak

- tanıttı

- Tanıtımlar

- tanıtım

- Giriş

- soruşturma

- dahil

- içerir

- konu

- sorunlar

- IT

- ONUN

- İş

- Mesleki Öğretiler

- seyahat

- jpg

- bilgi

- bilinen

- Eksiklik

- iniş

- manzara

- dil

- büyük

- büyük ölçekli

- büyük

- büyük

- Gecikme

- son

- tabaka

- katmanları

- önemli

- İlanlar

- ÖĞRENİN

- öğrendim

- öğrenme

- az

- seviyeleri

- Kaldıraç

- leverages

- kaldıraç

- sevmek

- olasılık

- sınırlama

- sınırlamaları

- Sınırlı

- yerel

- Uzun

- uzun zaman

- Bakın

- Düşük

- alt

- düşürücü

- makine

- makine çevirisi

- yapılmış

- sürdürmek

- büyük

- yapmak

- Yapımı

- tavır

- çok

- harita

- Kenar

- masif

- Maç

- maçlar

- uygun

- matematiksel

- Matris

- maksimum genişlik

- maksimize

- maksimum

- ölçmek

- mekanizmaları

- Bellek

- sadece

- birleştirme

- yöntem

- metodolojiler

- metodoloji

- yöntemleri

- milyon

- milyonlarca

- en az

- minimize

- hata

- model

- modelleri

- Değişiklikler

- Modüller

- Daha

- daha verimli

- Dahası

- çoğu

- çoklu

- şart

- Okumalısınız

- Doğal (Madenden)

- Doğal lisan

- Doğal Dil İşleme

- Tabiat

- gerek

- gerekli

- ihtiyaçlar

- Nerf

- Ağlar

- ağ

- ağlar

- sinirsel

- sinir ağı

- nöral ağlar

- NörIPS

- Nöronlar

- yeni

- haber

- sonraki

- nlp

- yok hayır

- düğüm

- düğümler

- dikkate değer

- notlar

- notlar

- roman

- numara

- nesne

- nesnel

- hedefleri

- gözlenen

- olay

- OCR

- of

- teklif

- Teklifler

- sık sık

- on

- ONE

- olanlar

- Online

- bir tek

- açık kaynak

- operasyon

- Operasyon

- optimizasyon

- optimize

- optimize

- or

- Diğer

- daha iyi çalmak

- bir üstün

- Mağazasından

- çıktı

- dışında

- tekrar

- Üstesinden gelmek

- aşılmasında

- genel bakış

- paket

- çiftleri

- pankaj

- kâğıt

- kâğıtlar

- Paralel

- parametre

- parametreler

- belirli

- özellikle

- Yamalar

- model

- başına

- yapmak

- performans

- gerçekleştirir

- dönemleri

- fotogerçekçi

- Platon

- Plato Veri Zekası

- PlatoVeri

- akla yakın

- Nokta

- pozlar

- potansiyel

- potansiyel

- güçlü

- Pratik

- Pratik uygulamalar

- tahmin

- tahmin edilebilir

- tahmin

- tahmin

- Tahminler

- öngörür

- mevcut

- sundu

- hediyeler

- önceki

- birincil

- Önceki

- olasılık

- Sorun

- sorunlar

- prosedür

- süreç

- işleme

- üretmek

- derin

- Programı

- Programlar

- Projeler

- önermek

- önerilen

- önermektedir

- öneren

- Protein

- Proteinler

- kanıtlanmış

- kanıtlıyor

- sağlamak

- sağlar

- sağlama

- yayınlanan

- pytorch

- kalite

- sorgular

- Yarış

- menzil

- rütbe

- oranlar

- daha doğrusu

- Çiğ

- ulaştı

- Okumak

- Okuma

- tekrar onaylar

- gerçek

- Gerçek dünya

- son

- geçenlerde

- yemek tarifi

- tanıma

- Tavsiye

- kazanılması

- yinelenme

- tekrarlayan

- Recursive

- azaltmak

- Indirimli

- azaltır

- azaltarak

- azalma

- referans

- referanslar

- yansıtılan

- ilişkin

- düzenlemek

- ilgili

- İlişkiler

- serbest

- serbest

- güven

- güvenerek

- kalıntılar

- dikkat çekici

- render

- render

- temsil etmek

- temsil

- temsilci

- temsil

- gerektirir

- gereklilik

- Yer Alan Kurallar

- araştırma

- Araştırma Topluluğu

- Araştırmacılar

- Kaynaklar

- sırasıyla

- Ortaya çıkan

- Sonuçlar

- yeniden eğitme

- açığa vurmak

- devrim yapmak

- RGB

- krallar gibi yaşamaya

- Risk

- gürbüz

- ölçeklenebilirlik

- ölçeklenebilir

- ölçek

- terazi

- ölçekleme

- senaryolar

- sahne

- Sahneler

- çizelgeleme

- şemaları

- bilimsel

- Gol

- çizik

- Ara

- cümle

- Dizi

- Dizi

- vermektedir

- set

- Setleri

- ayarlar

- birkaç

- paylaş

- paylaşımı

- kısa dönem

- şov

- görücüye

- vitrine

- gösterme

- Gösteriler

- sinyalleri

- önem

- önemli

- önemli ölçüde

- benzer

- benzerlikler

- Basit

- aynı anda

- durumlar

- beden

- yetenekli

- düzgünce

- Toplumsal

- yalnızca

- çözüm

- Çözümler

- ÇÖZMEK

- çözer

- Çözme

- biraz

- bazen

- uzay

- Uzay ve zaman

- gerginlik

- özel

- özel

- Spektral

- hız

- bölmek

- standart

- state-of-the-art

- ifadeleri

- kalmak

- adım

- hafızası

- mağaza

- Stratejik

- stratejileri

- Stratejileri

- güçlü

- yapı

- yapılandırılmış

- yapılar

- mücadeleler

- Ders çalışma

- önemli

- esasen

- başarı

- başarılı

- Başarılı olarak

- böyle

- Önerdi

- uygun

- üstün

- denetleme

- aşan

- aşarak

- SVG

- sentez

- sistem

- Sistemler

- Görev

- görevleri

- teknikleri

- eğilimindedir

- şartlar

- test

- metin

- göre

- o

- The

- Grafik

- ve bazı Asya

- Onları

- sonra

- teorik

- Bunlar

- onlar

- Re-Tweet

- Binlerce

- üç

- İçinden

- zaman

- zamanlar

- için

- araç

- Konular

- karşı

- geleneksel

- Tren

- eğitilmiş

- Eğitim

- transfer

- aktarma

- transformatör

- transformatörler

- Çeviri

- Çeviri Kalitesi

- Trendler

- öğretici

- iki

- türleri

- çizgi

- anlayış

- benzersiz

- birimleri

- aksine

- eşi görülmemiş

- güncellenmiş

- Güncellemeler

- kullanım

- Kullanılmış

- kullanım

- kullanma

- kullanır

- v1

- Değerli

- çeşitli

- doğrulanabilir

- çok yönlü

- çok yönlülük

- versiyon

- Video

- Videolar

- Görüntüle

- Gösterim

- gözle görülür

- vizyonumuz

- görüş sistemleri

- görsel

- Görsel tanıma

- hacim

- vs

- oldu

- yolları

- ağ

- ağırlık

- İYİ

- ne zaman

- olup olmadığını

- hangi

- süre

- geniş

- Geniş ürün yelpazesi

- geniş ölçüde

- Daha geniş

- Daha geniş bir topluluk

- Vikipedi

- irade

- ile

- içinde

- olmadan

- sözler

- İş

- çalışır

- değer

- yazılı

- yıl

- verimli

- sen

- zefirnet