07 ก.พ. 2023 (

ข่าวนาโนเวิร์ค) โมเดลภาษาขนาดใหญ่ เช่น GPT-3 ของ OpenAI เป็นโครงข่ายประสาทเทียมขนาดใหญ่ที่สามารถสร้างข้อความที่เหมือนมนุษย์ ตั้งแต่บทกวีไปจนถึงโค้ดโปรแกรม โมเดลแมชชีนเลิร์นนิงเหล่านี้ได้รับการฝึกฝนโดยใช้ข้อมูลอินเทอร์เน็ตจำนวนมหาศาล โดยจะใช้ข้อความอินพุตเพียงเล็กน้อย จากนั้นคาดเดาข้อความที่น่าจะตามมา

แต่นั่นไม่ใช่ทั้งหมดที่โมเดลเหล่านี้สามารถทำได้ นักวิจัยกำลังสำรวจปรากฏการณ์ที่น่าสงสัยที่เรียกว่าการเรียนรู้ในบริบท ซึ่งโมเดลภาษาขนาดใหญ่เรียนรู้ที่จะทำงานให้สำเร็จหลังจากดูตัวอย่างเพียงไม่กี่ตัวอย่าง แม้ว่าจะไม่ได้รับการฝึกฝนมาสำหรับงานนั้นก็ตาม ตัวอย่างเช่น บางคนสามารถป้อนประโยคตัวอย่างหลายประโยคและความรู้สึกของพวกเขาให้กับโมเดล (เชิงบวกหรือเชิงลบ) จากนั้นให้ป้อนประโยคใหม่ จากนั้นโมเดลก็สามารถให้ความรู้สึกที่ถูกต้องได้

โดยทั่วไปแล้ว โมเดลแมชชีนเลิร์นนิงเช่น GPT-3 จะต้องได้รับการฝึกอบรมใหม่ด้วยข้อมูลใหม่สำหรับงานใหม่นี้ ในระหว่างกระบวนการฝึกอบรม โมเดลจะอัปเดตพารามิเตอร์ขณะประมวลผลข้อมูลใหม่เพื่อเรียนรู้งาน แต่ด้วยการเรียนรู้ในบริบท พารามิเตอร์ของโมเดลจะไม่ได้รับการอัปเดต ดังนั้นดูเหมือนว่าโมเดลจะเรียนรู้งานใหม่โดยไม่ต้องเรียนรู้อะไรเลย

นักวิทยาศาสตร์จาก MIT, Google Research และมหาวิทยาลัยสแตนฟอร์ดกำลังพยายามไขปริศนานี้ พวกเขาศึกษาโมเดลที่คล้ายคลึงกับโมเดลภาษาขนาดใหญ่มากเพื่อดูว่าพวกเขาสามารถเรียนรู้โดยไม่ต้องอัปเดตพารามิเตอร์ได้อย่างไร

ผลทางทฤษฎีของนักวิจัยแสดงให้เห็นว่าแบบจำลองโครงข่ายประสาทเทียมขนาดใหญ่เหล่านี้สามารถบรรจุแบบจำลองเชิงเส้นที่เล็กกว่าและเรียบง่ายกว่าที่ฝังอยู่ภายในได้ โมเดลขนาดใหญ่สามารถใช้อัลกอริธึมการเรียนรู้แบบง่ายๆ เพื่อฝึกโมเดลเชิงเส้นที่มีขนาดเล็กกว่านี้เพื่อทำงานใหม่ให้สำเร็จ โดยใช้เฉพาะข้อมูลที่มีอยู่ในโมเดลขนาดใหญ่เท่านั้น พารามิเตอร์ยังคงคงที่

ขั้นตอนสำคัญในการทำความเข้าใจกลไกเบื้องหลังการเรียนรู้ในบริบท งานวิจัยนี้เปิดประตูสู่การสำรวจเพิ่มเติมเกี่ยวกับอัลกอริธึมการเรียนรู้ที่โมเดลขนาดใหญ่เหล่านี้สามารถนำมาใช้ได้ Ekin Akyürek นักศึกษาระดับบัณฑิตศึกษาด้านวิทยาการคอมพิวเตอร์และผู้เขียนรายงานกล่าว (

“What learning algorithm is in-context learning? Investigations with linear models”) สำรวจปรากฏการณ์นี้ ด้วยความเข้าใจที่ดีขึ้นเกี่ยวกับการเรียนรู้ในบริบท นักวิจัยจึงสามารถเปิดใช้งานแบบจำลองเพื่อทำงานใหม่ให้เสร็จสิ้นได้โดยไม่จำเป็นต้องฝึกอบรมซ้ำซึ่งมีค่าใช้จ่ายสูง

“โดยปกติแล้ว หากคุณต้องการปรับแต่งโมเดลเหล่านี้ คุณจะต้องรวบรวมข้อมูลเฉพาะโดเมนและดำเนินการทางวิศวกรรมที่ซับซ้อน แต่ตอนนี้เราสามารถป้อนข้อมูล XNUMX ตัวอย่างให้กับมันได้ และมันจะบรรลุผลตามที่เราต้องการ ดังนั้นการเรียนรู้ในบริบทจึงเป็นปรากฏการณ์ที่น่าตื่นเต้นทีเดียว” Akyürek กล่าว

การเข้าร่วมAkyürekในหนังสือพิมพ์คือ Dale Schuurmans นักวิทยาศาสตร์การวิจัยที่ Google Brain และศาสตราจารย์ด้านวิทยาการคอมพิวเตอร์ที่มหาวิทยาลัยอัลเบอร์ตา; เช่นเดียวกับผู้เขียนอาวุโส Jacob Andreas ผู้ช่วยศาสตราจารย์ X Consortium ในภาควิชาวิศวกรรมไฟฟ้าและวิทยาการคอมพิวเตอร์ของ MIT และสมาชิกของ MIT Computer Science and Artificial Intelligence Laboratory (CSAIL) Tengyu Ma ผู้ช่วยศาสตราจารย์ด้านวิทยาการคอมพิวเตอร์และสถิติที่ Stanford; และ Danny Zhou นักวิทยาศาสตร์หลักและผู้อำนวยการฝ่ายวิจัยของ Google Brain งานวิจัยนี้จะถูกนำเสนอในการประชุมนานาชาติว่าด้วยการนำเสนอการเรียนรู้

โมเดลภายในโมเดล

ในชุมชนการวิจัยแมชชีนเลิร์นนิง นักวิทยาศาสตร์หลายคนเชื่อว่าโมเดลภาษาขนาดใหญ่สามารถดำเนินการเรียนรู้ในบริบทได้เนื่องจากวิธีการฝึกฝน Akyürek กล่าว

ตัวอย่างเช่น GPT-3 มีพารามิเตอร์นับแสนล้านและได้รับการฝึกโดยการอ่านข้อความจำนวนมากบนอินเทอร์เน็ต ตั้งแต่บทความ Wikipedia ไปจนถึงโพสต์ Reddit ดังนั้น เมื่อมีคนแสดงตัวอย่างโมเดลของงานใหม่ ก็น่าจะได้เห็นสิ่งที่คล้ายกันมากแล้ว เนื่องจากชุดข้อมูลการฝึกอบรมมีข้อความจากเว็บไซต์หลายพันล้านแห่ง มันทำซ้ำรูปแบบที่เห็นระหว่างการฝึก แทนที่จะเรียนรู้ที่จะดำเนินการใหม่

Akyürek ตั้งสมมติฐานว่าผู้เรียนในบริบทไม่เพียงแต่จับคู่รูปแบบที่เห็นก่อนหน้านี้เท่านั้น แต่ยังได้เรียนรู้ที่จะดำเนินการใหม่ๆ อีกด้วย เขาและคนอื่นๆ ทดลองโดยแจ้งแบบจำลองเหล่านี้โดยใช้ข้อมูลสังเคราะห์ ซึ่งพวกเขาไม่เคยเห็นที่ไหนมาก่อน และพบว่าแบบจำลองยังคงสามารถเรียนรู้ได้จากตัวอย่างเพียงไม่กี่ตัวอย่าง Akyürek และเพื่อนร่วมงานของเขาคิดว่าบางทีโมเดลโครงข่ายประสาทเทียมเหล่านี้อาจมีโมเดลการเรียนรู้ของเครื่องขนาดเล็กอยู่ภายใน ซึ่งโมเดลดังกล่าวสามารถฝึกให้ทำงานใหม่ได้

“นั่นสามารถอธิบายปรากฏการณ์การเรียนรู้เกือบทั้งหมดที่เราได้เห็นจากแบบจำลองขนาดใหญ่เหล่านี้” เขากล่าว

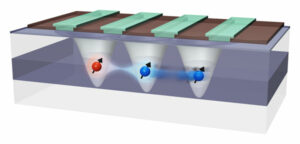

เพื่อทดสอบสมมติฐานนี้ นักวิจัยได้ใช้โมเดลโครงข่ายประสาทเทียมที่เรียกว่าหม้อแปลงไฟฟ้า ซึ่งมีสถาปัตยกรรมแบบเดียวกับ GPT-3 แต่ได้รับการฝึกอบรมมาโดยเฉพาะสำหรับการเรียนรู้ในบริบท

ด้วยการสำรวจสถาปัตยกรรมของหม้อแปลงนี้ พวกเขาพิสูจน์ทางทฤษฎีว่าสามารถเขียนแบบจำลองเชิงเส้นภายในสถานะที่ซ่อนอยู่ได้ โครงข่ายประสาทเทียมประกอบด้วยโหนดที่เชื่อมต่อถึงกันหลายชั้นซึ่งประมวลผลข้อมูล สถานะที่ซ่อนอยู่คือเลเยอร์ระหว่างเลเยอร์อินพุตและเอาต์พุต

การประเมินทางคณิตศาสตร์ของพวกเขาแสดงให้เห็นว่าแบบจำลองเชิงเส้นนี้เขียนอยู่ที่ไหนสักแห่งในชั้นแรกสุดของหม้อแปลงไฟฟ้า หม้อแปลงไฟฟ้าสามารถอัปเดตโมเดลเชิงเส้นได้โดยใช้อัลกอริธึมการเรียนรู้อย่างง่าย

โดยพื้นฐานแล้ว โมเดลจะจำลองและฝึกเวอร์ชันที่เล็กกว่าของตัวเอง

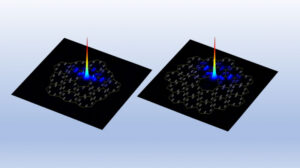

การตรวจสอบชั้นที่ซ่อนอยู่

นักวิจัยได้สำรวจสมมติฐานนี้โดยใช้การทดลองเชิงลึก โดยตรวจดูชั้นที่ซ่อนอยู่ของหม้อแปลงไฟฟ้าเพื่อพยายามกู้คืนปริมาณที่แน่นอน

“ในกรณีนี้ เราพยายามกู้คืนโซลูชันจริงเป็นโมเดลเชิงเส้น และเราสามารถแสดงได้ว่าพารามิเตอร์ถูกเขียนในสถานะที่ซ่อนอยู่ ซึ่งหมายความว่าแบบจำลองเชิงเส้นอยู่ในนั้นที่ไหนสักแห่ง” เขากล่าว

จากงานเชิงทฤษฎีนี้ นักวิจัยอาจสามารถเปิดใช้งานหม้อแปลงไฟฟ้าเพื่อทำการเรียนรู้ในบริบทโดยการเพิ่มเพียงสองชั้นในโครงข่ายประสาทเทียม Akyürek เตือนว่ายังมีรายละเอียดทางเทคนิคมากมายที่ต้องดำเนินการก่อนที่จะเป็นไปได้ แต่สิ่งนี้สามารถช่วยวิศวกรสร้างแบบจำลองที่สามารถทำงานใหม่ให้เสร็จสมบูรณ์ได้โดยไม่จำเป็นต้องฝึกอบรมด้วยข้อมูลใหม่

ในอนาคต Akyürek วางแผนที่จะสำรวจการเรียนรู้ในบริบทต่อไปด้วยฟังก์ชันที่ซับซ้อนกว่าแบบจำลองเชิงเส้นที่พวกเขาศึกษาในงานนี้ พวกเขายังสามารถใช้การทดลองเหล่านี้กับโมเดลภาษาขนาดใหญ่เพื่อดูว่าพฤติกรรมของพวกเขาได้รับการอธิบายโดยอัลกอริธึมการเรียนรู้อย่างง่ายหรือไม่ นอกจากนี้ เขาต้องการเจาะลึกลงไปถึงประเภทของข้อมูลการฝึกอบรมล่วงหน้าที่สามารถเปิดใช้งานการเรียนรู้ในบริบทได้

“ด้วยงานนี้ ผู้คนสามารถจินตนาการได้ว่าโมเดลเหล่านี้สามารถเรียนรู้จากตัวอย่างได้อย่างไร ดังนั้นความหวังของฉันคือมันจะเปลี่ยนมุมมองของบางคนเกี่ยวกับการเรียนรู้ในบริบท” Akyürek กล่าว “โมเดลเหล่านี้ไม่ได้โง่อย่างที่คนคิด พวกเขาไม่เพียงแค่จดจำงานเหล่านี้เท่านั้น พวกเขาสามารถเรียนรู้งานใหม่ๆ และเราได้แสดงให้เห็นว่าสามารถทำได้อย่างไร”

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- เพลโตบล็อคเชน Web3 Metaverse ข่าวกรอง ขยายความรู้. เข้าถึงได้ที่นี่.

- ที่มา: https://www.nanowerk.com/news2/robotics/newsid=62325.php