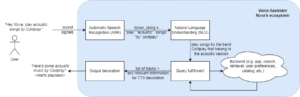

ความก้าวหน้าล่าสุดในการพัฒนา LLM ทำให้การใช้งาน NLP เป็นที่นิยมมากขึ้น ซึ่งก่อนหน้านี้ได้รับการแก้ไขโดยใช้วิธีการเรียนรู้ของเครื่องแบบเก่า โมเดลภาษาขนาดใหญ่สามารถแก้ปัญหาภาษาได้หลากหลาย เช่น การจำแนก การสรุป การดึงข้อมูล การสร้างเนื้อหา การตอบคำถาม และการรักษาการสนทนา ทั้งหมดนี้ใช้เพียงโมเดลเดียว แต่เราจะรู้ได้อย่างไรว่าพวกเขาทำงานได้ดีกับงานต่างๆ เหล่านี้?

การเพิ่มขึ้นของ LLM ทำให้เกิดปัญหาที่ยังไม่ได้รับการแก้ไข: เราไม่มีมาตรฐานที่เชื่อถือได้ในการประเมิน สิ่งที่ทำให้การประเมินทำได้ยากขึ้นคือใช้สำหรับงานที่หลากหลายมาก และเราขาดคำจำกัดความที่ชัดเจนว่าอะไรคือคำตอบที่ดีสำหรับกรณีการใช้งานแต่ละกรณี

บทความนี้กล่าวถึงแนวทางปัจจุบันในการประเมิน LLM และแนะนำกระดานผู้นำ LLM ใหม่ซึ่งใช้ประโยชน์จากการประเมินโดยมนุษย์ซึ่งปรับปรุงตามเทคนิคการประเมินที่มีอยู่

รูปแบบการประเมินเบื้องต้นรูปแบบแรกและปกติคือการรันโมเดลบนชุดข้อมูลที่ได้รับการดูแลจัดการหลายชุด และตรวจสอบประสิทธิภาพของโมเดล HuggingFace สร้างไฟล์ เปิดลีดเดอร์บอร์ด LLM โดยที่โมเดลขนาดใหญ่ที่เข้าถึงได้แบบเปิดได้รับการประเมินโดยใช้ชุดข้อมูลที่รู้จักกันดีสี่ชุด (ความท้าทายในการใช้เหตุผล AI2 , เฮลลาสแวก , มมส , ความจริงQA). ซึ่งสอดคล้องกับการประเมินอัตโนมัติและตรวจสอบความสามารถของแบบจำลองในการรับข้อเท็จจริงสำหรับคำถามเฉพาะบางข้อ

นี่คือตัวอย่างคำถามจาก มมส ชุดข้อมูล

หัวเรื่อง: วิทยาลัยแพทยศาสตร์

คำถาม: ผลข้างเคียงที่คาดหวังจากการเสริมครีเอทีนคือ

- ก) กล้ามเนื้ออ่อนแรง

- B) เพิ่มมวลกาย

- C) ปวดกล้ามเนื้อ

- D) การสูญเสียอิเล็กโทรไลต์

คำตอบ: (ข)

การให้คะแนนแบบจำลองในการตอบคำถามประเภทนี้ถือเป็นตัวชี้วัดที่สำคัญและทำหน้าที่ได้ดีในการตรวจสอบข้อเท็จจริง แต่ไม่ได้ทดสอบความสามารถในการสร้างของแบบจำลอง นี่อาจเป็นข้อเสียที่ใหญ่ที่สุดของวิธีการประเมินนี้ เนื่องจากการสร้างข้อความอิสระเป็นหนึ่งในคุณสมบัติที่สำคัญที่สุดของ LLM

ดูเหมือนว่าจะมีความเห็นเป็นเอกฉันท์ภายในชุมชนว่าการประเมินแบบจำลองอย่างเหมาะสมนั้น เราจำเป็นต้องมีการประเมินโดยมนุษย์ โดยทั่วไปจะทำโดยการเปรียบเทียบการตอบสนองจากโมเดลต่างๆ

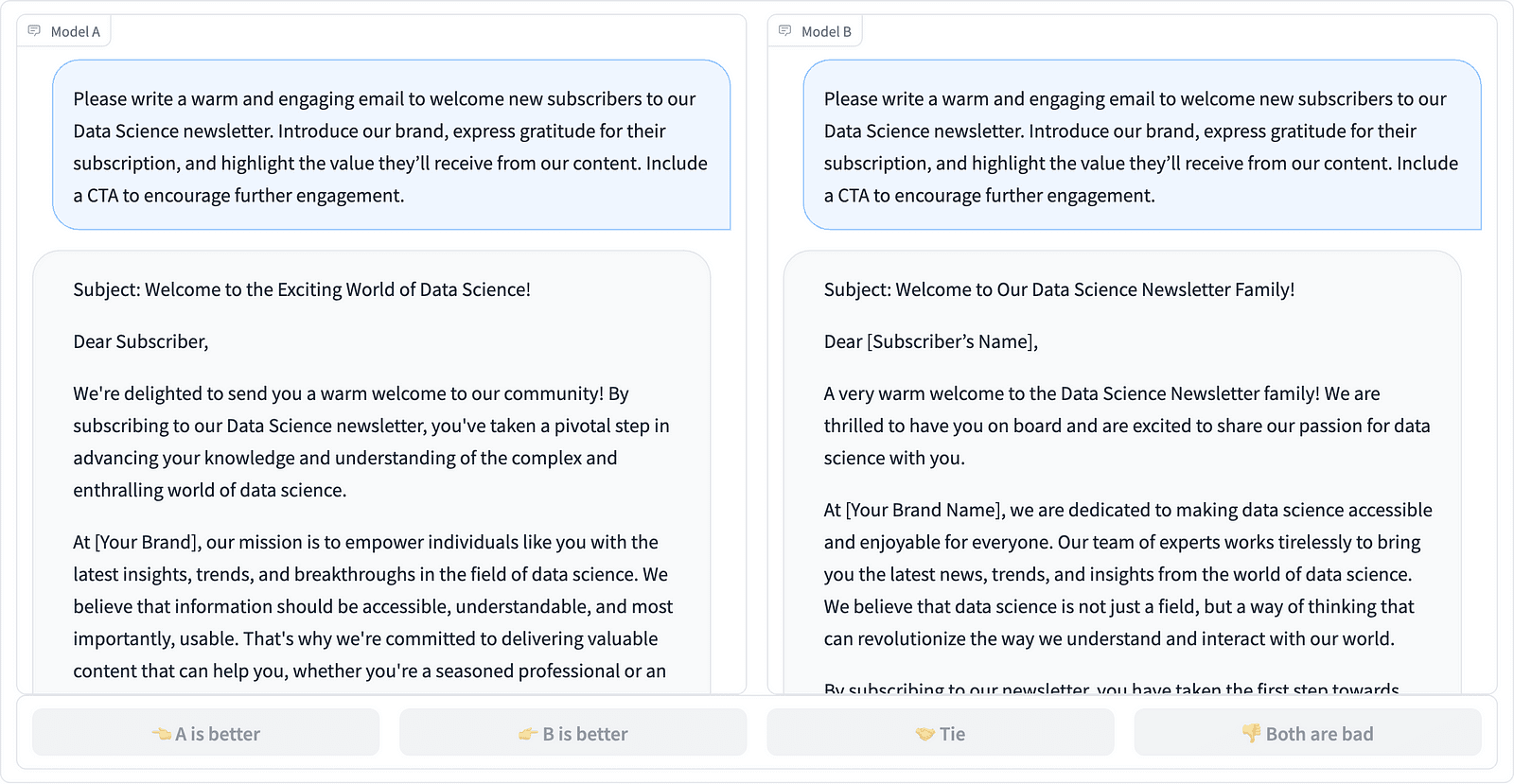

การเปรียบเทียบความสำเร็จพร้อมท์สองรายการในโครงการ LMSYS – ภาพหน้าจอโดยผู้เขียน

ผู้อธิบายประกอบจะตัดสินใจว่าคำตอบใดดีกว่า ดังที่เห็นในตัวอย่างด้านบน และบางครั้งก็ระบุปริมาณความแตกต่างในคุณภาพของการดำเนินการให้เสร็จสิ้นทันที LMSYS Org ได้สร้าง ลีดเดอร์ ที่ใช้การประเมินโดยมนุษย์ประเภทนี้และเปรียบเทียบแบบจำลองที่แตกต่างกัน 17 แบบ โดยรายงาน คะแนน Elo สำหรับแต่ละรุ่น

เนื่องจากการประเมินโดยมนุษย์อาจปรับขนาดได้ยาก จึงมีความพยายามในการปรับขนาดและเร่งกระบวนการประเมินให้เร็วขึ้น และส่งผลให้เกิดโครงการที่น่าสนใจชื่อว่า อัลปาก้าEval. ในที่นี้แต่ละแบบจำลองจะถูกเปรียบเทียบกับเส้นพื้นฐาน (ข้อความ-davinci-003 จัดทำโดย GPT-4) และการประเมินโดยมนุษย์จะถูกแทนที่ด้วยการพิจารณาของ GPT-4 สิ่งนี้รวดเร็วและปรับขนาดได้ แต่เราสามารถเชื่อถือโมเดลที่นี่เพื่อทำการให้คะแนนได้หรือไม่ เราจำเป็นต้องตระหนักถึงอคติของแบบจำลอง โครงการนี้ได้แสดงให้เห็นแล้วว่า GPT-4 อาจสนับสนุนคำตอบที่ยาวกว่า

วิธีการประเมิน LLM มีการพัฒนาอย่างต่อเนื่องในขณะที่ชุมชน AI ค้นหาแนวทางที่ง่าย ยุติธรรม และปรับขนาดได้ การพัฒนาล่าสุดมาจากทีมงานที่ Toloka พร้อมด้วยระบบใหม่ ลีดเดอร์ เพื่อพัฒนามาตรฐานการประเมินในปัจจุบันให้ก้าวหน้ายิ่งขึ้น

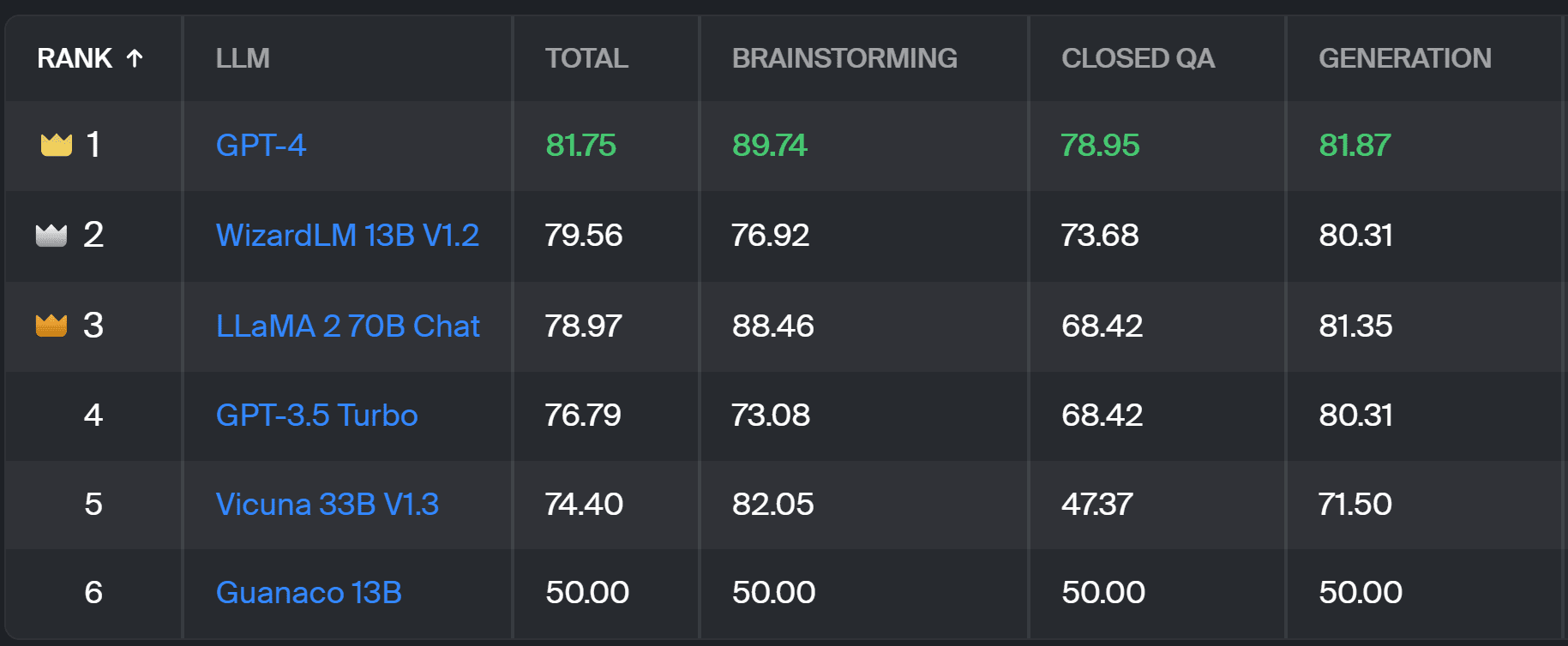

ใหม่ ลีดเดอร์ เปรียบเทียบการตอบสนองของโมเดลกับการแจ้งเตือนผู้ใช้ในโลกแห่งความเป็นจริงซึ่งจัดหมวดหมู่ตามงาน NLP ที่มีประโยชน์ตามที่ระบุไว้ใน เอกสาร InstructGPT นี้. นอกจากนี้ยังแสดงอัตราการชนะโดยรวมของแต่ละรุ่นในทุกหมวดหมู่

กระดานผู้นำ Toloka – ภาพหน้าจอโดยผู้เขียน

การประเมินที่ใช้สำหรับโปรเจ็กต์นี้คล้ายกับการประเมินใน AlpacaEval คะแนนบนกระดานผู้นำแสดงถึงอัตราการชนะของรุ่นที่เกี่ยวข้องเมื่อเปรียบเทียบกับ กวานาโก 13B ซึ่งทำหน้าที่เป็นการเปรียบเทียบพื้นฐานในที่นี้ ทางเลือกของ Guanaco 13B คือการปรับปรุงวิธี AlpacaEval ซึ่งใช้โมเดล text-davinci-003 ที่ล้าสมัยเร็วๆ นี้เป็นหลัก

การประเมินจริงทำได้โดยผู้เชี่ยวชาญด้านคำอธิบายประกอบที่เป็นมนุษย์ตามชุดการแจ้งเตือนในโลกแห่งความเป็นจริง สำหรับแต่ละพรอมต์ ผู้อธิบายประกอบจะได้รับการดำเนินการให้เสร็จสิ้นสองครั้ง และถามว่าพวกเขาต้องการรายการใด คุณสามารถดูรายละเอียดเกี่ยวกับวิธีการได้ โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม.

การประเมินโดยมนุษย์ประเภทนี้มีประโยชน์มากกว่าวิธีการประเมินอัตโนมัติอื่นๆ และควรปรับปรุงการประเมินโดยมนุษย์ที่ใช้สำหรับ ลีดเดอร์บอร์ด LMSYS ข้อเสียของวิธี LMSYS คือใครก็ตามที่มี ลิงค์ สามารถมีส่วนร่วมในการประเมิน ทำให้เกิดคำถามที่จริงจังเกี่ยวกับคุณภาพของข้อมูลที่รวบรวมในลักษณะนี้ ผู้เชี่ยวชาญด้านคำอธิบายประกอบแบบปิดมีศักยภาพที่ดีกว่าเพื่อให้ได้ผลลัพธ์ที่เชื่อถือได้ และ Toloka ใช้เทคนิคการควบคุมคุณภาพเพิ่มเติมเพื่อรับรองคุณภาพของข้อมูล

ในบทความนี้ เราได้แนะนำโซลูชันใหม่ที่มีแนวโน้มสำหรับการประเมิน LLM นั่นก็คือ Toloka Leaderboard แนวทางนี้เป็นนวัตกรรม ผสมผสานจุดแข็งของวิธีการที่มีอยู่ เพิ่มรายละเอียดเฉพาะงาน และใช้เทคนิคคำอธิบายประกอบของมนุษย์ที่เชื่อถือได้เพื่อเปรียบเทียบแบบจำลอง

สำรวจกระดานและแบ่งปันความคิดเห็นและข้อเสนอแนะของคุณเพื่อการปรับปรุงกับเรา

มักดาเลนา คอนคีวิช เป็นผู้เผยแพร่ข้อมูลที่ Toloka ซึ่งเป็นบริษัทระดับโลกที่สนับสนุนการพัฒนา AI ที่รวดเร็วและปรับขนาดได้ เธอสำเร็จการศึกษาระดับปริญญาโทสาขาปัญญาประดิษฐ์จากมหาวิทยาลัยเอดินบะระ และเคยทำงานเป็นวิศวกร NLP นักพัฒนา และนักวิทยาศาสตร์ข้อมูลสำหรับธุรกิจในยุโรปและอเมริกา เธอยังมีส่วนร่วมในการสอนและให้คำปรึกษานักวิทยาศาสตร์ข้อมูล และมีส่วนสนับสนุนสิ่งพิมพ์ด้านวิทยาศาสตร์ข้อมูลและแมชชีนเลิร์นนิงเป็นประจำ

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- $ ขึ้น

- 17

- a

- ความสามารถ

- เกี่ยวกับเรา

- ข้างบน

- ข้าม

- ที่เกิดขึ้นจริง

- จริง

- เพิ่มเติม

- เพิ่ม

- ความก้าวหน้า

- ความก้าวหน้า

- AI

- ทั้งหมด

- ด้วย

- สหรัฐอเมริกา

- an

- และ

- คำตอบ

- คำตอบ

- ใด

- มีผลบังคับใช้

- เข้าใกล้

- วิธีการ

- เป็น

- สนามกีฬา

- บทความ

- เทียม

- ปัญญาประดิษฐ์

- AS

- At

- อัตโนมัติ

- ทราบ

- b

- baseline

- BE

- เพราะ

- รับ

- ดีกว่า

- อคติ

- ที่ใหญ่ที่สุด

- คณะกรรมการ

- ร่างกาย

- นำ

- ธุรกิจ

- แต่

- by

- CAN

- สามารถ

- กรณี

- หมวดหมู่

- ท้าทาย

- การตรวจสอบ

- ทางเลือก

- การจัดหมวดหมู่

- ชัดเจน

- ปิด

- รวม

- มา

- ชุมชน

- บริษัท

- เปรียบเทียบ

- เมื่อเทียบกับ

- เปรียบเทียบ

- การเปรียบเทียบ

- เอกฉันท์

- เนื้อหา

- การสร้างเนื้อหา

- อย่างต่อเนื่อง

- ก่อ

- ควบคุม

- การสนทนา

- สอดคล้อง

- ที่สร้างขึ้น

- การสร้าง

- ฝูงชน

- curated

- ปัจจุบัน

- ข้อมูล

- คุณภาพของข้อมูล

- วิทยาศาสตร์ข้อมูล

- นักวิทยาศาสตร์ข้อมูล

- ชุดข้อมูล

- ตัดสินใจ

- คำนิยาม

- องศา

- รายละเอียด

- ผู้พัฒนา

- พัฒนาการ

- ความแตกต่าง

- ต่าง

- ข้อเสียเปรียบ

- หลาย

- do

- ทำ

- การทำ

- ทำ

- Dont

- ข้อเสีย

- แต่ละ

- ง่าย

- เอดินเบอระ

- ผล

- ความพยายาม

- อิเล็กโทร

- วิศวกร

- ทำให้มั่นใจ

- ยุโรป

- ประเมินค่า

- ประเมิน

- การประเมินการ

- การประเมินผล

- ผู้สอนศาสนา

- คาย

- ตรวจสอบ

- ตัวอย่าง

- ที่มีอยู่

- ที่คาดหวัง

- ชำนาญ

- ข้อเท็จจริง

- ธรรม

- FAST

- โปรดปราน

- คุณสมบัติ

- หา

- ชื่อจริง

- สำหรับ

- ฟอร์ม

- สี่

- ฟรี

- ราคาเริ่มต้นที่

- ต่อไป

- ได้รับ

- รวมตัวกัน

- การสร้าง

- กำเนิด

- ได้รับ

- GitHub

- กำหนด

- เหตุการณ์ที่

- ดี

- งานที่ดี

- ยาก

- ยาก

- มี

- โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม

- อย่างสูง

- ถือ

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- HTTPS

- กอดใบหน้า

- เป็นมนุษย์

- สำคัญ

- ปรับปรุง

- การปรับปรุง

- การปรับปรุง

- ช่วยเพิ่ม

- in

- ข้อมูล

- แรกเริ่ม

- นวัตกรรม

- Intelligence

- น่าสนใจ

- แนะนำ

- เปิดตัว

- ร่วมมือ

- IT

- ITS

- การสัมภาษณ์

- เพียงแค่

- แค่หนึ่ง

- KD นักเก็ต

- ทราบ

- ไม่มี

- ภาษา

- ใหญ่

- ล่าสุด

- การเรียนรู้

- การใช้ประโยชน์

- เบา

- อีกต่อไป

- ปิด

- เครื่อง

- เรียนรู้เครื่อง

- การบำรุงรักษา

- ทำให้

- ลักษณะ

- มวล

- เจ้านาย

- อาจ..

- การให้คำปรึกษา

- วิธี

- ระเบียบวิธี

- วิธีการ

- เมตริก

- แบบ

- โมเดล

- ข้อมูลเพิ่มเติม

- มากที่สุด

- กล้ามเนื้อ

- จำเป็นต้อง

- ใหม่

- โซลูชั่นใหม่

- NLP

- of

- เก่ากว่า

- on

- ONE

- เปิด

- ความคิดเห็น

- อื่นๆ

- ที่ระบุไว้

- ทั้งหมด

- ส่วนหนึ่ง

- ดำเนินการ

- การปฏิบัติ

- ดำเนินการ

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- ที่มีศักยภาพ

- ชอบ

- ก่อนหน้านี้

- อาจ

- ปัญหา

- ปัญหาที่เกิดขึ้น

- กระบวนการ

- โครงการ

- แวว

- แจ้ง

- อย่างถูกต้อง

- ให้

- สิ่งพิมพ์

- คุณภาพ

- คำถาม

- คำถาม

- การยก

- คะแนน

- โลกแห่งความจริง

- สม่ำเสมอ

- น่าเชื่อถือ

- แทนที่

- การรายงาน

- แสดง

- ว่า

- คำตอบ

- การตอบสนอง

- ส่งผลให้

- ผลสอบ

- ขึ้น

- วิ่ง

- s

- ที่ปรับขนาดได้

- ขนาด

- วิทยาศาสตร์

- นักวิทยาศาสตร์

- นักวิทยาศาสตร์

- คะแนน

- คะแนน

- ค้นหา

- ดูเหมือนว่า

- เห็น

- ร้ายแรง

- ให้บริการอาหาร

- ชุด

- หลาย

- Share

- เธอ

- น่า

- แสดง

- แสดงให้เห็นว่า

- ด้าน

- คล้ายคลึงกัน

- เดียว

- ทางออก

- การแก้

- บาง

- บางครั้ง

- โดยเฉพาะ

- ความเร็ว

- มาตรฐาน

- มาตรฐาน

- จุดแข็ง

- อย่างเช่น

- ที่สนับสนุน

- เอา

- งาน

- การเรียนการสอน

- ทีม

- เทคนิค

- ทดสอบ

- ข้อความ

- กว่า

- ที่

- พื้นที่

- ของพวกเขา

- พวกเขา

- ที่นั่น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- นี้

- ไปยัง

- วางใจ

- สอง

- ชนิด

- เป็นปกติ

- มหาวิทยาลัย

- เมื่อ

- us

- การใช้

- ใช้

- ใช้กรณี

- มือสอง

- ผู้ใช้งาน

- ใช้

- การใช้

- ตามปกติ

- ความหลากหลาย

- ทาง..

- we

- ความอ่อนแอ

- ดี

- โด่งดัง

- คือ

- อะไร

- ความหมายของ

- ที่

- ชนะ

- กับ

- ภายใน

- ทำงาน

- เธอ

- ของคุณ

- ลมทะเล