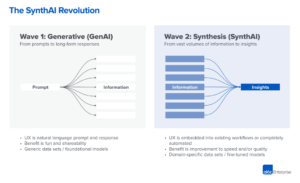

Vi börjar se de mycket tidiga stadierna av en teknisk stack dyka upp inom generativ artificiell intelligens (AI). Hundratals nya startups rusar in på marknaden för att utveckla grundmodeller, bygga AI-native appar och stå upp infrastruktur/verktyg.

Många heta tekniktrender blir överhypade långt innan marknaden kommer ikapp. Men den generativa AI-boomen har åtföljts av verkliga vinster på verkliga marknader och verklig dragkraft från riktiga företag. Modeller som Stable Diffusion och ChatGPT sätter historiska rekord för användartillväxt, och flera applikationer har nått 100 miljoner dollar av årliga intäkter mindre än ett år efter lanseringen. Jämförelser sida vid sida visar AI-modeller överträffa människor i vissa uppgifter i flera storleksordningar.

Så det finns tillräckligt med tidiga data för att antyda att massiv transformation äger rum. Vad vi inte vet, och vad som nu har blivit den kritiska frågan, är: Var på denna marknad kommer värdet att uppstå?

Under det senaste året har vi träffat dussintals startupgrundare och operatörer i stora företag som arbetar direkt med generativ AI. Det har vi observerat leverantörer av infrastruktur är troligen de största vinnarna på denna marknad hittills, och fångar majoriteten av dollar som flödar genom stacken. Applikationsföretag växer omsättningen mycket snabbt men kämpar ofta med behålla, produktdifferentiering och bruttomarginaler. Och de flesta modellleverantörer, även om de är ansvarig för själva existensen av denna marknad, har de ännu inte uppnått stor kommersiell skala.

Med andra ord har de företag som skapar mest värde – dvs. att träna generativa AI-modeller och tillämpa dem i nya appar – inte fångat upp det mesta. Att förutse vad som kommer att hända härnäst är mycket svårare. Men vi tror att det viktigaste att förstå är vilka delar av stacken som verkligen är differentierade och försvarbara. Detta kommer att ha stor inverkan på marknadsstrukturen (dvs. horisontell kontra vertikal företagsutveckling) och drivkrafterna för långsiktigt värde (t.ex. marginaler och retention). Hittills har vi haft svårt att hitta strukturell försvarbarhet var som helst i traven, utanför traditionella vallgravar för dominerande operatörer.

Vi är oerhört hausse på generativ AI och tror att det kommer att få en enorm inverkan i mjukvaruindustrin och utanför. Målet med det här inlägget är att kartlägga dynamiken på marknaden och börja svara på de bredare frågorna om generativa AI-affärsmodeller.

Teknikstack på hög nivå: Infrastruktur, modeller och appar

För att förstå hur den generativa AI-marknaden tar form måste vi först definiera hur stacken ser ut idag. Här är vår preliminära uppfattning.

Stacken kan delas upp i tre lager:

- Applikationer som integrerar generativa AI-modeller i en användarinriktad produkt, antingen med sina egna modellpipelines ("end-to-end-appar") eller förlitar sig på ett tredjeparts-API

- Modeller som driver AI-produkter, tillgängliga antingen som proprietära API:er eller som checkpoints med öppen källkod (som i sin tur kräver en värdlösning)

- Infrastruktur leverantörer (dvs. molnplattformar och hårdvarutillverkare) som kör utbildnings- och slutledningsarbetsbelastningar för generativa AI-modeller

Det är viktigt att notera: Detta är inte en marknadskarta, utan ett ramverk för att analysera marknaden. I varje kategori har vi listat några exempel på välkända leverantörer. Vi har inte gjort några försök att vara heltäckande eller lista alla fantastiska generativa AI-applikationer som har släppts. Vi går inte heller in på MLops eller LLMops-verktyg här, som ännu inte är särskilt standardiserade och kommer att behandlas i ett framtida inlägg.

Den första vågen av generativa AI-appar börjar nå skala, men kämpar med retention och differentiering

I tidigare teknikcykler var den konventionella visdomen att för att bygga ett stort, oberoende företag måste du äga slutkunden - oavsett om det betydde enskilda konsumenter eller B2B-köpare. Det är frestande att tro att de största företagen inom generativ AI också kommer att vara slutanvändarapplikationer. Än så länge är det inte klart att så är fallet.

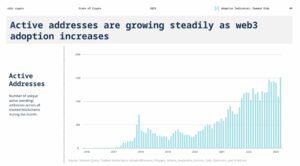

För att vara säker har tillväxten av generativa AI-applikationer varit häpnadsväckande, driven av ren nyhet och en uppsjö av användningsfall. Faktum är att vi är medvetna om minst tre produktkategorier som redan har överskridit 100 miljoner USD i årliga intäkter: bildgenerering, copywriting och kodskrivning.

Men enbart tillväxt räcker inte för att bygga hållbara mjukvaruföretag. Kritiskt sett måste tillväxten vara lönsam – i den meningen att användare och kunder, när de väl registrerat sig, genererar vinster (höga bruttomarginaler) och stannar kvar under lång tid (hög retention). I avsaknad av stark teknisk differentiering driver B2B- och B2C-appar långsiktigt kundvärde genom nätverkseffekter, att hålla fast vid data eller bygga allt mer komplexa arbetsflöden.

I generativ AI stämmer inte dessa antaganden nödvändigtvis. Över appföretag som vi har pratat med finns det ett brett utbud av bruttomarginaler – så höga som 90 % i några få fall men oftare så låga som 50–60 %, till stor del drivna av kostnaden för modellinferens. Tillväxten i toppen av tratten har varit fantastisk, men det är oklart om nuvarande kundförvärvsstrategier kommer att vara skalbara – vi ser redan att betalda förvärvseffektivitet och bibehållande börjar avta. Många appar är också relativt odifferentierade, eftersom de förlitar sig på liknande underliggande AI-modeller och inte har upptäckt uppenbara nätverkseffekter, eller data/arbetsflöden, som är svåra för konkurrenter att duplicera.

Så det är ännu inte uppenbart att försäljning av slutanvändarappar är den enda, eller till och med den bästa, vägen till att bygga en hållbar generativ AI-verksamhet. Marginalerna bör förbättras i takt med att konkurrensen och effektiviteten i språkmodeller ökar (mer om detta nedan). Retentionen bör öka när AI-turister lämnar marknaden. Och det finns ett starkt argument att framföra att vertikalt integrerade appar har en fördel när det gäller att driva differentiering. Men det finns mycket kvar att bevisa.

När man ser framåt är några av de stora frågorna som företag inom generativa AI-appar står inför:

- Vertikal integration ("modell + app"). Att konsumera AI-modeller som en tjänst gör att apputvecklare kan iterera snabbt med ett litet team och byta modellleverantörer allt eftersom tekniken går framåt. På baksidan, vissa utvecklare hävdar att produkten is modellen, och att träning från grunden är det enda sättet att skapa försvar – dvs genom att ständigt omträna på egen produktdata. Men det kommer på bekostnad av mycket högre kapitalkrav och ett mindre smidigt produktteam.

- Byggfunktioner kontra appar. Generativa AI-produkter tar ett antal olika former: stationära appar, mobilappar, Figma/Photoshop-plugins, Chrome-tillägg, till och med Discord-bots. Det är enkelt att integrera AI-produkter där användare redan arbetar, eftersom gränssnittet i allmänhet bara är en textruta. Vilka av dessa kommer att bli fristående företag - och vilka kommer att absorberas av etablerade företag, som Microsoft eller Google, som redan införlivar AI i sina produktlinjer?

- Klara sig genom hypecykeln. Det är ännu inte klart om churn är inneboende i den nuvarande satsen av generativa AI-produkter, eller om det är en artefakt av en tidig marknad. Eller om det ökade intresset för generativ AI kommer att avta när hypen avtar. Dessa frågor har viktiga konsekvenser för appföretag, inklusive när man ska trycka på gaspedalen vid insamling; hur aggressivt att investera i kundförvärv; vilka användarsegment som ska prioriteras; och när man ska förklara produkt-marknad lämplig.

Modellleverantörer uppfann generativ AI, men har inte nått stor kommersiell skala

Det vi nu kallar generativ AI skulle inte existera utan det briljanta forsknings- och ingenjörsarbete som gjorts på platser som Google, OpenAI och Stability. Genom nya modellarkitekturer och heroiska ansträngningar för att skala utbildningspipelines drar vi alla nytta av de häpnadsväckande kapaciteterna hos nuvarande stora språkmodeller (LLM) och bildgenereringsmodeller.

Ändå är intäkterna förknippade med dessa företag fortfarande relativt små jämfört med användningen och buzz. I bildgenerering har Stable Diffusion sett en explosiv gemenskapstillväxt, med stöd av ett ekosystem av användargränssnitt, värdbaserade erbjudanden och finjusteringsmetoder. Men Stability ger bort sina stora checkpoints gratis som en kärna i deras verksamhet. I naturliga språkmodeller dominerar OpenAI med GPT-3/3.5 och ChatGPT. Men relativt få killappar byggda på OpenAI finns hittills, och priserna har redan gjort det tappade en gång.

Detta kan bara vara ett tillfälligt fenomen. Stabilitet är ett nytt företag som ännu inte har fokuserat på intäktsgenerering. OpenAI har potential att bli en enorm verksamhet och tjäna en betydande del av alla intäkter från NLP-kategorin när fler mördande appar byggs – särskilt om deras integration i Microsofts produktportfölj går smidigt. Med tanke på den enorma användningen av dessa modeller kanske storskaliga intäkter inte ligger långt efter.

Men det finns också motverkande krafter. Modeller som släpps som öppen källkod kan vara värd för vem som helst, inklusive externa företag som inte bär kostnaderna i samband med storskalig modellutbildning (upp till tiotals eller hundratals miljoner dollar). Och det är inte klart om några modeller med sluten källkod kan behålla sin fördel på obestämd tid. Till exempel börjar vi se LLM:er byggda av företag som Anthropic, Cohere och Character.ai komma närmare OpenAI prestandanivåer, utbildade på liknande datamängder (dvs. internet) och med liknande modellarkitekturer. Exemplet med stabil diffusion antyder det if modeller med öppen källkod når en tillräcklig nivå av prestanda och gemenskapsstöd, då kan proprietära alternativ ha svårt att konkurrera.

Det kanske tydligaste alternativet för modellleverantörer hittills är att kommersialisering troligen är knuten till värd. Efterfrågan på proprietära API:er (t.ex. från OpenAI) växer snabbt. Värdtjänster för modeller med öppen källkod (t.ex. Hugging Face och Replicate) växer fram som användbara nav för att enkelt dela och integrera modeller – och till och med ha vissa indirekta nätverkseffekter mellan modelltillverkare och konsumenter. Det finns också en stark hypotes om att det är möjligt att tjäna pengar genom finjustering och hostingavtal med företagskunder.

Utöver det finns det dock ett antal stora frågor som modellleverantörer står inför:

- Varuanpassning. Det finns en vanlig uppfattning att AI-modeller kommer att konvergera i prestanda över tiden. När man pratar med apputvecklare är det tydligt att det inte har hänt ännu, med starka ledare inom både text- och bildmodeller. Deras fördelar är inte baserade på unika modellarkitekturer, utan på höga kapitalkrav, proprietära produktinteraktionsdata och knappa AI-talanger. Kommer detta att fungera som en varaktig fördel?

- Examen risk. Att förlita sig på modellleverantörer är ett bra sätt för appföretag att komma igång och till och med växa sina företag. Men det finns incitament för dem att bygga och/eller vara värd för sina egna modeller när de når skala. Och många modellleverantörer har mycket skeva kundfördelningar, med ett fåtal appar som representerar majoriteten av intäkterna. Vad händer om/när dessa kunder går över till intern AI-utveckling?

- Är pengar viktigt? Löftet om generativ AI är så stort – och även potentiellt så skadligt – att många modellleverantörer har organiserat sig som allmännyttiga företag (B-kår), utfärdat vinstbegränsade andelar eller på annat sätt införlivat allmännyttan uttryckligen i sitt uppdrag. Detta har inte alls hindrat deras insamlingsinsatser. Men det finns en rimlig diskussion om huruvida de flesta modellleverantörer faktiskt vill för att fånga värde, och om de borde.

Infrastrukturleverantörer rör allt och skördar frukterna

Nästan allt i generativ AI passerar någon gång genom en molnvärd GPU (eller TPU). Oavsett om det är modellleverantörer/forskningslabb som kör utbildningsarbetsbelastningar, värdföretag som kör slutledning/finjustering eller applikationsföretag som gör någon kombination av båda — FLOPPAR är livsnerven för generativ AI. För första gången på mycket länge är framstegen inom den mest störande datortekniken massivt beräkningsbunden.

Som ett resultat rinner mycket av pengarna på den generativa AI-marknaden i slutändan igenom till infrastrukturföretag. För att sätta några mycket grova siffror kring det: Vi uppskattar att appföretag i genomsnitt spenderar cirka 20-40 % av intäkterna på slutsatser och finjusteringar per kund. Detta betalas vanligtvis antingen direkt till molnleverantörer för beräkningsinstanser eller till tredjepartsmodellleverantörer – som i sin tur spenderar ungefär hälften av sina intäkter på molninfrastruktur. Så det är rimligt att gissa att 10-20 % av totala intäkter i generativ AI går idag till molnleverantörer.

Utöver detta har startups som tränar sina egna modeller samlat in miljarder dollar i riskkapital - varav majoriteten (upp till 80-90% i tidiga omgångar) vanligtvis också spenderas med molnleverantörerna. Många offentliga teknikföretag spenderar hundratals miljoner per år på modellutbildning, antingen med externa molnleverantörer eller direkt med hårdvarutillverkare.

Detta är vad vi skulle kalla, i tekniska termer, "mycket pengar" - särskilt för en begynnande marknad. Det mesta spenderas på Big 3 moln: Amazon Web Services (AWS), Google Cloud Platform (GCP) och Microsoft Azure. Dessa molnleverantörer tillsammans spendera mer än $ 100 miljarder per år i capex för att säkerställa att de har de mest heltäckande, pålitliga och kostnadseffektiva plattformarna. I synnerhet inom generativ AI drar de också nytta av utbudsbegränsningar eftersom de har företrädesrätt åtkomst till knapp hårdvara (t.ex. Nvidia A100 och H100 GPU).

Intressant är dock att vi börjar se trovärdig konkurrens dyka upp. Utmanare som Oracle har gjort inhopp med stora investeringsutgifter och försäljningsincitament. Och några få startups, som Coreweave och Lambda Labs, har vuxit snabbt med lösningar riktade specifikt till stora modellutvecklare. De konkurrerar om kostnader, tillgänglighet och personlig support. De exponerar också mer granulära resursabstraktioner (dvs behållare), medan de stora molnen endast erbjuder VM-instanser på grund av GPU-virtualiseringsbegränsningar.

Bakom kulisserna, att köra de allra flesta AI-arbetsbelastningar, är kanske den största vinnaren inom generativ AI hittills: Nvidia. Företaget rapporterade 3.8 XNUMX dollar miljard av GPU-intäkter från datacenter under tredje kvartalet av räkenskapsåret 2023, inklusive en meningsfull del för generativa AI-användningsfall. Och de har byggt starka vallgravar kring den här verksamheten genom årtionden av investeringar i GPU-arkitekturen, ett robust mjukvaruekosystem och djup användning i det akademiska samhället. En ny analys fann att Nvidia GPU:er citeras i forskningsrapporter 90 gånger mer än de bästa AI-chipstarterna tillsammans.

Andra hårdvarualternativ finns, inklusive Google Tensor Processing Units (TPUs); AMD Instinct GPU:er; AWS Inferentia och Trainium chips; och AI-acceleratorer från startups som Cerebras, Sambanova och Graphcore. Intel, sent till spelet, kommer också in på marknaden med sina avancerade Habana-chips och Ponte Vecchio GPU:er. Men hittills har få av dessa nya marker tagit betydande marknadsandelar. De två undantagen att titta på är Google, vars TPU:er har fått dragkraft i Stable Diffusion-gemenskapen och i några stora GCP-affärer, och TSMC, som tros tillverka alla av chipsen som listas här, inklusive Nvidia GPU:er (Intel använder en blandning av sina egna fabs och TSMC för att göra sina chips).

Infrastruktur är med andra ord ett lukrativt, hållbart och till synes försvarbart lager i högen. De stora frågorna att besvara för infraföretag inkluderar:

- Håller fast vid statslösa arbetsbelastningar. Nvidia GPU:er är desamma var du än hyr dem. De flesta AI-arbetsbelastningar är tillståndslösa, i den meningen att modellinferens inte kräver bifogade databaser eller lagring (annat än för själva modellvikterna). Detta innebär att AI-arbetsbelastningar kan vara mer bärbara över moln än traditionella applikationsarbetsbelastningar. Hur kan molnleverantörer i detta sammanhang skapa klibbighet och hindra kunder från att hoppa till det billigaste alternativet?

- Att överleva slutet på chipbristen. Prissättning för molnleverantörer, och för Nvidia självt, har stötts av knappa leveranser av de mest önskvärda GPU:erna. En leverantör berättade att listpriset för A100s faktiskt har ökat sedan lanseringen, vilket är mycket ovanligt för datorhårdvara. När denna försörjningsbegränsning så småningom tas bort, genom ökad produktion och/eller införande av nya hårdvaruplattformar, hur kommer detta att påverka molnleverantörer?

- Kan ett utmanarmoln slå igenom? Vi tror starkt på det vertikala moln kommer att ta marknadsandelar från Big 3 med mer specialiserade erbjudanden. Inom AI hittills har utmanare skapat meningsfull dragkraft genom måttlig teknisk differentiering och stöd från Nvidia – för vilka de etablerade molnleverantörerna är både de största kunderna och nya konkurrenter. Den långsiktiga frågan är, kommer detta att vara tillräckligt för att övervinna skalfördelarna med Big 3?

Så... var kommer värdet att uppstå?

Det vet vi förstås inte än. Men baserat på de tidiga data vi har för generativ AI, i kombination med vår erfarenhet av tidigare AI/ML-företag, vår intuition är följande.

Det verkar idag inte finnas några systemiska vallgravar i generativ AI. Som en första ordningens approximation saknar applikationer stark produktdifferentiering eftersom de använder liknande modeller; modeller står inför otydlig långsiktig differentiering eftersom de är tränade på liknande datamängder med liknande arkitekturer; molnleverantörer saknar djup teknisk differentiering eftersom de kör samma GPU:er; och till och med hårdvaruföretagen tillverkar sina chips på samma fabs.

Det finns, naturligtvis, standardvallgravarna: skala vallgravar ("Jag har eller kan samla in mer pengar än du!"), vallgravar i leveranskedjan ("Jag har GPU:erna, du har inte!"), ekosystemvallgravar (" Alla använder redan min programvara!”), algoritmiska vallgravar (“Vi är smartare än du!”), distributionsvallgravar (“Jag har redan ett säljteam och fler kunder än du!”) och datapipeline vallgravar (“Jag” har crawlat mer av internet än du!”). Men ingen av dessa vallgravar tenderar att vara hållbara på lång sikt. Och det är för tidigt att säga om starka, direkta nätverkseffekter får fäste i något lager av stacken.

Baserat på tillgängliga data är det helt enkelt inte klart om det kommer att finnas en långsiktig, vinnare-ta-allt-dynamik i generativ AI.

Det här är konstigt. Men för oss är det goda nyheter. Den potentiella storleken på denna marknad är svår att förstå – någonstans däremellan all mjukvara och alla mänskliga ansträngningar — så vi förväntar oss många, många spelare och sund konkurrens på alla nivåer i stacken. Vi förväntar oss också att både horisontella och vertikala företag ska lyckas, med det bästa tillvägagångssättet dikterat av slutmarknader och slutanvändare. Till exempel, om den primära differentieringen i slutprodukten är själva AI:n, är det troligt att vertikaliseringen (dvs. tät koppling av den användarvända appen till den hemodlade modellen) vinner fram. Medan om AI är en del av en större funktionsuppsättning med lång svans, är det mer troligt att horisontalisering kommer att inträffa. Naturligtvis bör vi också se byggandet av mer traditionella vallgravar med tiden - och vi kan till och med se nya typer av vallgravar få fäste.

Hur som helst, en sak vi är säkra på är att generativ AI förändrar spelet. Vi lär oss alla reglerna i realtid, det finns en enorm mängd värde som kommer att låsas upp, och det tekniska landskapet kommer att se mycket, mycket annorlunda ut som ett resultat. Och vi är här för det!

Alla bilder i det här inlägget skapades med Midjourney.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. Tillgång här.

- Källa: https://a16z.com/2023/01/19/who-owns-the-generative-ai-platform/

- $ 100 miljoner

- $3

- 1

- a

- A100

- Om oss

- akademiska

- acceleratorer

- tillgång

- uppnås

- förvärv

- tvärs

- faktiskt

- Antagande

- framsteg

- Fördel

- fördelar

- Efter

- avtal

- framåt

- AI

- AI-plattform

- ai användningsfall

- AI / ML

- algoritmisk

- Alla

- tillåter

- ensam

- redan

- alternativ

- fantastiska

- amason

- Amazon Web Services

- Amazon Web Services (AWS)

- AMD

- mängd

- analysera

- och

- årsbasis

- svara

- någon

- API: er

- app

- visas

- Ansökan

- tillämpningar

- Tillämpa

- tillvägagångssätt

- appar

- arkitektur

- argumenterar

- Argumentet

- runt

- konstgjord

- artificiell intelligens

- Konstgjord intelligens (AI)

- associerad

- tillgänglighet

- tillgänglig

- genomsnitt

- AWS

- AWS slutledning

- Azure

- B2B

- B2C

- baserat

- Bear

- därför att

- blir

- innan

- bakom

- tro

- tro

- tros

- troende

- nedan

- fördel

- BÄST

- mellan

- Bortom

- Stor

- störst

- Miljarder

- miljarder

- bom

- botar

- bunden

- Box

- Ha sönder

- lysande

- bredare

- SLUTRESULTAT

- Byggnad

- byggt

- Hausse

- företag

- företag

- köpare

- Ring

- kapacitet

- kapital

- fånga

- Fångande

- Vid

- fall

- kategorier

- Kategori

- Centrum

- vissa

- utmanare

- Förändringar

- karaktär

- ChatGPT

- billigaste

- chip

- Pommes frites

- krom

- citerade

- klar

- närmare

- cloud

- molninfrastruktur

- Molnplattform

- koda

- kollektivt

- kombination

- kombinerad

- komma

- kommersiella

- kommersialisering

- Gemensam

- samfundet

- Företag

- företag

- jämfört

- konkurrera

- konkurrens

- konkurrenter

- komplex

- omfattande

- Compute

- databehandling

- begränsningar

- konsumenter

- Behållare

- sammanhang

- kontinuerligt

- konventionell

- konvergerar

- copywriting

- Kärna

- Företag

- Pris

- Kostar

- Naturligtvis

- skapa

- skapas

- Skapa

- trovärdig

- kritisk

- Aktuella

- kund

- Kunder

- cykler

- datum

- Data Center

- databaser

- datauppsättningar

- behandla

- Erbjudanden

- årtionden

- djup

- Efterfrågan

- desktop

- utveckla

- utvecklare

- Utveckling

- devs

- olika

- olika former

- differentierad

- Diffusion

- rikta

- direkt

- oenighet

- upptäckt

- diskussion

- störande

- fördelning

- Distributioner

- dividerat

- gör

- dollar

- dominerar

- inte

- dussintals

- driv

- driven

- chaufförer

- drivande

- dynamisk

- Dynamiken

- varje

- Tidigare

- Tidig

- tjänar

- lätt

- ekosystemet

- kant

- effekter

- effektivitet

- ansträngningar

- antingen

- smärgel

- Teknik

- tillräckligt

- säkerställa

- Företag

- företagskunder

- speciellt

- uppskatta

- Även

- så småningom

- allt

- exempel

- exempel

- förvänta

- erfarenhet

- förlängningar

- extern

- Ansikte

- vänd

- Höst

- Leverans

- Funktioner

- få

- hitta

- finna

- Förnamn

- första gången

- Fiskal

- passa

- Flip

- Strömmande

- flöden

- fokuserade

- efter

- Krafter

- former

- hittade

- fundament

- grundare

- Ramverk

- Fri

- från

- Insamlingar

- framtida

- resultat

- lek

- GAS

- allmänhet

- generera

- generering

- generativ

- Generativ AI

- skaffa sig

- ges

- ger

- Målet

- Går

- kommer

- god

- Google Cloud

- Google Cloud Platform

- GPU

- GPUs

- grepp

- stor

- grov

- Väx

- Odling

- vuxen

- Tillväxt

- Hälften

- hända

- hänt

- händer

- Hård

- hårdvara

- skadliga

- friska

- här.

- Hög

- högre

- höggradigt

- historisk

- Träffa

- hålla

- innehav

- Horisontell

- värd

- värd

- värd

- HET

- Hur ser din drömresa ut

- HTTPS

- stor

- humant

- Hundratals

- hundratals miljoner

- Hype

- bild

- bildgenerering

- bilder

- Inverkan

- implikationer

- med Esport

- förbättra

- in

- I andra

- Incitament

- incitament

- innefattar

- Inklusive

- Inkorporerad

- införlivande

- Öka

- ökat

- Ökar

- alltmer

- oerhört

- Sittande

- oberoende

- individuellt

- industrin

- Infrastruktur

- inneboende

- integrera

- integrerade

- integrering

- Intel

- Intelligens

- interaktion

- intresse

- gränssnitt

- Internet

- intuition

- uppfann

- Invest

- investering

- Utfärdad

- IT

- sig

- Nyckel

- Vet

- Labs

- Brist

- liggande

- språk

- Large

- storskalig

- till stor del

- större

- Efternamn

- Förra året

- Sent

- lansera

- lager

- skikt

- ledare

- inlärning

- Lämna

- Nivå

- nivåer

- sannolikt

- gränser

- rader

- Lista

- Noterade

- Lång

- länge sedan

- lång sikt

- se

- UTSEENDE

- Lot

- Låg

- lukrativ

- gjord

- bibehålla

- större

- Majoritet

- göra

- Tillverkare

- många

- karta

- marginaler

- marknad

- marknadskarta

- Marknadsstruktur

- Marknader

- massiv

- massivt

- max-bredd

- meningsfull

- betyder

- metoder

- Microsoft

- Microsoft Azure

- MidJourney

- miljon

- miljoner

- Mission

- MLOps

- Mobil

- mobil-appar

- modell

- modeller

- intäktsgenerering

- tjäna pengar

- pengar

- mer

- mest

- multipel

- begynnande

- Natural

- Naturligt språk

- nödvändigtvis

- Behöver

- nät

- Nya

- ny maskinvara

- nyheter

- Nästa

- vig

- nlp

- roman

- nyhet

- antal

- nummer

- Nvidia

- Uppenbara

- erbjudanden

- offer~~POS=TRUNC

- ONE

- öppet

- öppen källkod

- OpenAI

- operatörer

- Alternativet

- Tillbehör

- orakel

- ordrar

- Organiserad

- Övriga

- annat

- utanför

- Övervinna

- egen

- äger

- betalas

- papper

- del

- särskilt

- reservdelar till din klassiker

- passerar

- bana

- prestanda

- kanske

- personlig

- Fenomenet

- rörledning

- Plats

- platser

- plattform

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- spelare

- uppsjö

- insticksmoduler

- Punkt

- möjlig

- Inlägg

- potentiell

- potentiellt

- kraft

- förutsäga

- förhindra

- pris

- Priser

- primär

- Innan

- Prioritera

- bearbetning

- producenter

- Produkt

- Produktion

- Produkter

- Vinst

- lönsam

- vinster

- Framsteg

- löfte

- proprietary

- Bevisa

- leverantör

- leverantörer

- allmän

- sätta

- Kvartal

- fråga

- frågor

- snabbt

- höja

- insamlat

- område

- snabbt

- nå

- kommit fram till

- verklig

- realtid

- rimlig

- senaste

- register

- relativt

- frigörs

- pålitlig

- avlägsnas

- Hyra

- representerar

- kräver

- Krav

- forskning

- resurs

- ansvarig

- resultera

- retentionstid

- intäkter

- intäkter

- Risk

- robusta

- omgångar

- regler

- Körning

- rinnande

- försäljning

- Försäljningsincitament

- Samma

- skalbar

- Skala

- Knappa

- Brist

- scener

- se

- segment

- Försäljningen

- känsla

- tjänar

- service

- Tjänster

- in

- inställning

- flera

- Forma

- Dela

- aktier

- skall

- show

- signera

- signifikant

- liknande

- eftersom

- Storlek

- Small

- mjukt

- So

- än så länge

- Mjukvara

- lösning

- Lösningar

- några

- någonstans

- Källa

- specialiserad

- specifikt

- spendera

- spent

- Stabilitet

- stabil

- stapel

- stadier

- stå

- fristående

- standard

- starta

- igång

- Starta

- start

- Startups

- Stick

- Fortfarande

- förvaring

- strategier

- stark

- strukturell

- struktur

- Kamp

- lyckas

- tillräcklig

- Föreslår

- leverera

- stödja

- Som stöds

- uppstår

- hållbart

- Växla

- systemisk

- Ta

- tar

- Talang

- tala

- riktade

- uppgifter

- grupp

- tech

- Tech företag

- Teknisk

- Teknologi

- temporär

- villkor

- Smakämnen

- deras

- sig själva

- sak

- Tredje

- tredje part

- tre

- Genom

- Bunden

- tätt

- tid

- gånger

- till

- i dag

- alltför

- topp

- Rör

- dragkraft

- traditionell

- tränad

- Utbildning

- Transformation

- enorm

- Trender

- sann

- tsmc

- SVÄNG

- typer

- typiskt

- ui

- Ytterst

- underliggande

- förstå

- unika

- enheter

- ovanlig

- us

- Användning

- användning

- Användare

- användare

- värde

- Omfattande

- försäljare

- våga

- riskkapital

- via

- utsikt

- Kolla på

- Våg

- webb

- webbservice

- ALLBEKANT

- Vad

- om

- som

- medan

- VEM

- bred

- Brett utbud

- wikipedia

- kommer

- vinna

- vinnare

- visdom

- utan

- ord

- Arbete

- arbetsflöden

- skrivning

- år

- zephyrnet