Datasjöar och semantiska lager har funnits länge – var och en bor i sina egna muromgärdade trädgårdar, tätt kopplade till ganska smala användningsområden. När data- och analysinfrastrukturen migrerar till molnet, utmanar många hur dessa grundläggande teknologikomponenter passar in i den moderna data- och analysstapeln. I den här artikeln kommer vi att dyka in i hur ett datasjöhus och ett semantiskt lager tillsammans upphäver det traditionella förhållandet mellan datasjöar och analysinfrastruktur. Vi kommer att lära oss hur ett semantiskt sjöhus dramatiskt kan förenkla molndataarkitekturer, eliminera onödiga datarörelser och minska tid till värde och molnkostnader.

Den traditionella data- och analysarkitekturen

2006 introducerade Amazon Amazon Web Services (AWS) som ett nytt sätt att ladda ner det lokala datacentret till molnet. En central AWS-tjänst var dess fildatalager och med det föddes den första molndatasjön, Amazon S3. Andra molnleverantörer skulle därefter introducera sina egna versioner av molndatasjöinfrastruktur.

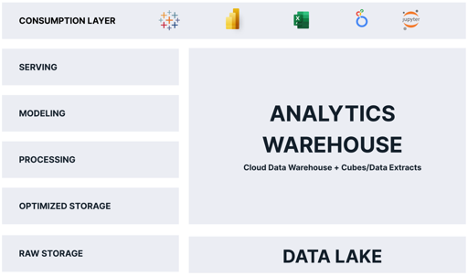

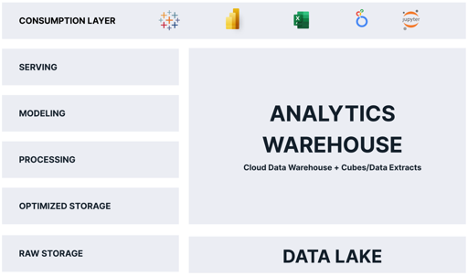

Under större delen av sitt liv har molndatasjön blivit förpassad till att spela rollen som dum, billig datalagring - a staging område för rådata, tills data kunde bearbetas till något användbart. För analys fungerade datasjön som en hållpenna för data tills den kunde kopieras och laddas in i en optimerad analysplattform, vanligtvis ett relationellt molndatalager som matar antingen OLAP-kuber, proprietära business intelligence (BI) verktygsdataextrakt som Tableau Hyper eller Power BI Premium, eller alla ovanstående. Som ett resultat av detta bearbetningsmönster behövde data lagras minst två gånger, en gång i sin råa form och en gång i sin "analytikoptimerade" form.

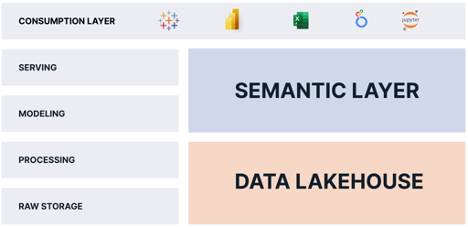

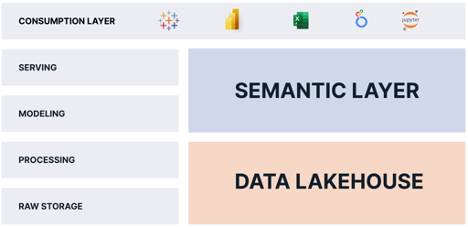

Inte överraskande ser de flesta traditionella molnanalysarkitekturer ut som diagrammet nedan:

Som du kan se är "analytiklagret" ansvarigt för en majoritet av de funktioner som levererar analyser till konsumenterna. Problemet med denna arkitektur är följande:

- Data lagras två gånger, vilket ökar kostnaderna och skapar komplexitet i verksamheten.

- Data i analyslagret är en ögonblicksbild, vilket innebär att data omedelbart är inaktuella.

- Data i analyslagret är vanligtvis en delmängd av data i datasjön, vilket begränsar de frågor som konsumenter kan ställa.

- Analyslagret skalas separat och annorlunda än molndataplattformen, vilket introducerar extra kostnader, säkerhetsproblem och operationell komplexitet.

Med tanke på dessa nackdelar kan du fråga "Varför skulle molndataarkitekter välja detta designmönster?" Svaret ligger i kraven från analytikkonsumenterna. Även om datasjön teoretiskt sett skulle kunna betjäna analytiska frågor direkt till konsumenter, är datasjön i praktiken för långsam och inkompatibel med populära analysverktyg.

Om bara datasjön kunde leverera fördelarna med ett analyslager och vi kunde undvika att lagra data två gånger!

Födelsen av Data Lakehouse

Begreppet "Lakehouse" debuterade 2020 med det framträdande vitboken Databricks "Vad är ett Lakehouse?" av Ben Lorica, Michael Armbrust, Reynold Xin, Matei Zaharia och Ali Ghodsi. Författarna introducerade idén att datasjön kunde fungera som en motor för att leverera analyser, inte bara en statisk filbutik.

Data Lakehouse-leverantörer levererade sin vision genom att introducera höghastighets, skalbara frågemotorer som arbetar på rådatafiler i datasjön och exponerar ett ANSI-standard SQL-gränssnitt. Med denna nyckelinnovation hävdar förespråkare för denna arkitektur att datasjöar kan bete sig som ett analyslager, utan att behöva duplicera data.

Det visar sig dock att analyslagret utför andra viktiga funktioner som inte enbart tillfredsställs av datalakehouse-arkitekturen, inklusive:

- Levererar "speed of thought"-frågor (frågor på under 2 sekunder) konsekvent över ett brett spektrum av frågor.

- Presenterar ett företagsvänligt semantiskt lager som låter konsumenter ställa frågor utan att behöva skriva SQL.

- Tillämpa datastyrning och säkerhet vid frågetillfället.

Så för att ett datasjöhus verkligen ska ersätta analyslagret behöver vi något annat.

Det semantiska skiktets roll

Jag har skrivit mycket om rollen som den semantiskt lager i den moderna datastacken. För att sammanfatta, är ett semantiskt lager en logisk vy av affärsdata som utnyttjar datavirtualiseringsteknik för att översätta fysisk data till affärsvänlig data vid frågetillfället.

Genom att lägga till en semantisk lagerplattform ovanpå ett datasjöhus kan vi eliminera analyslagerfunktionerna helt eftersom den semantiska lagerplattformen:

- Levererar "speed of thought-frågor" på datasjöhuset med hjälp av datavirtualisering och automatisk justering av frågeprestanda.

- Levererar ett affärsvänligt semantiskt lager som ersätter de egenutvecklade semantiska vyerna som är inbäddade i varje BI-verktyg och låter företagsanvändare ställa frågor utan att behöva skriva SQL-frågor.

- Levererar datastyrning och säkerhet vid frågetid.

En semantisk lagerplattform levererar de saknade bitarna som datasjöhuset saknar. Genom att kombinera ett semantiskt lager med ett datasjöhus kan organisationer:

- Eliminera datakopior och förenkla datapipelines.

- Konsolidera datastyrning och säkerhet.

- Leverera en "enda källa till sanning" för affärsmått.

- Minska operativ komplexitet genom att behålla data i datasjön.

- Ge tillgång till mer data och mer aktuell data till analytikerkonsumenter.

The Semantic Lakehouse: Alla vinner

Alla vinner med denna arkitektur. Konsumenter får tillgång till mer finkornig data utan latens. IT- och datateknikteam har mindre data att flytta och omvandla. Finans spenderar mindre pengar på kostnader för molninfrastruktur.

Som du kan se, genom att kombinera ett semantiskt lager med ett datasjöhus, kan organisationer förenkla sin data- och analysverksamhet och leverera mer data, snabbare, till fler konsumenter, med lägre kostnad.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. Tillgång här.

- Källa: https://www.dataversity.net/the-semantic-lakehouse-explained/

- :är

- 1

- 2020

- a

- Om oss

- ovan

- tillgång

- Annat

- Alla

- tillåter

- ensam

- amason

- Amazon Web Services

- Amazon Web Services (AWS)

- Analytisk

- analytics

- och

- svara

- arkitektur

- ÄR

- OMRÅDE

- argumenterar

- runt

- Artikeln

- AS

- At

- Författarna

- Automatiserad

- AWS

- BE

- därför att

- nedan

- Fördelarna

- mellan

- födda

- företag

- business intelligence

- by

- KAN

- fall

- Centrum

- utmanande

- billig

- Välja

- cloud

- molninfrastruktur

- kombinera

- Komplexiteten

- komponenter

- oro

- konsumenter

- kopior

- Kärna

- Pris

- Kostar

- kunde

- kopplad

- skapar

- datum

- Data Center

- datasjö

- Dataplattform

- datalagret

- Databrickor

- DATAVERSITET

- leverera

- levereras

- leverera

- levererar

- krav

- Designa

- direkt

- dramatiskt

- nackdelar

- varje

- antingen

- eliminera

- inbäddade

- Motor

- Teknik

- Motorer

- förklarade

- extrakt

- ganska

- snabbare

- matning

- Fil

- Filer

- finansiering

- Förnamn

- passa

- följer

- För

- formen

- från

- funktioner

- Gardens

- skaffa sig

- styrning

- Har

- Hög

- innehav

- Hur ser din drömresa ut

- html

- HTTPS

- Tanken

- in

- Inklusive

- Ökar

- Infrastruktur

- Innovation

- Intelligens

- Gränssnitt

- införa

- introducerade

- införa

- IT

- DESS

- hålla

- Nyckel

- sjö

- Latens

- lager

- LÄRA SIG

- hävstångs

- livet

- tycka om

- gränser

- levande

- logisk

- Lång

- länge sedan

- se

- ser ut som

- Lot

- Majoritet

- många

- max-bredd

- betyder

- Metrics

- Michael

- kanske

- saknas

- Modern Konst

- pengar

- mer

- mest

- flytta

- rörelse

- Behöver

- behövs

- behöver

- Nya

- of

- on

- operativa

- Verksamhet

- optimerad

- organisationer

- Övriga

- egen

- Mönster

- prestanda

- utför

- fysisk

- bitar

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- i

- Populära

- kraft

- Power BI

- praktiken

- Premium

- Problem

- bearbetning

- proprietary

- frågor

- område

- Raw

- rådata

- minska

- relation

- ersätta

- ansvarig

- resultera

- Roll

- nöjd

- skalbar

- skalor

- sekunder

- säkerhet

- tjänar

- service

- Tjänster

- förenkla

- långsam

- Snapshot

- något

- Källa

- fart

- SQL

- stapel

- standard

- lagra

- lagras

- sammanfatta

- Tableau

- lag

- Teknologi

- den där

- Smakämnen

- deras

- Dessa

- trodde

- tätt

- tid

- till

- tillsammans

- alltför

- verktyg

- verktyg

- topp

- traditionell

- Förvandla

- Översätt

- Dubbelt

- typiskt

- under

- användning

- användare

- värde

- försäljare

- utsikt

- visningar

- syn

- avgörande

- Väggmurad

- Warehouse

- Sätt..

- webb

- webbservice

- som

- medan

- vit

- bred

- Brett utbud

- kommer

- Vinner

- med

- utan

- Arbete

- skulle

- skriva

- skriven

- zephyrnet