Jag pratade nyligen med Stelios Diamantidis (framstående arkitekt, chef för strategi, Autonomous Design Solutions) om Synopsys tillkännagivande om 100th kund tapeout med deras DSO.ai-lösning. Min oro för AI-relaterade artiklar är att undvika den hype som omger AI i allmänhet, och omvänt skepsisen som reaktion på den hypen som fick en del att avfärda alla AI-anspråk som ormolja. Jag blev glad över att höra Stelios skratta och hålla med helhjärtat. Vi hade en mycket grundad diskussion om vad DSO.ai kan göra idag, vad deras referenskunder ser i lösningen (baserat på vad den kan göra idag) och vad han kunde berätta om tekniken.

Vad DSO.ai gör

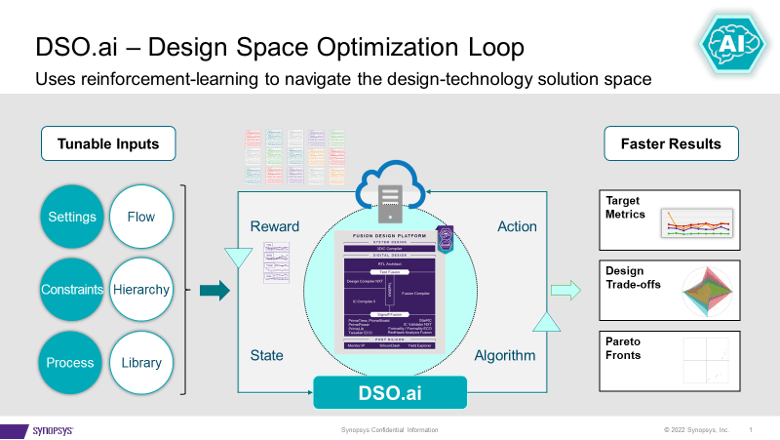

DSO.ai kopplar ihop med Fusion Compiler och IC Compiler II, vilket som Stelios var noga med att betona betyder att detta är en optimeringslösning på blocknivå; Fullständiga SoCs är inte ett mål ännu. Detta passar nuvarande designpraxis eftersom Stelios sa att ett viktigt mål är att enkelt passa in i befintliga flöden. Syftet med tekniken är att göra det möjligt för implementeringsingenjörer, ofta en enskild ingenjör, att förbättra sin produktivitet samtidigt som de utforskar ett större designutrymme för en bättre PPA än vad som annars skulle ha kunnat upptäckas.

Synopsys tillkännagav den första tapeouten sommaren 2021 och har nu annonserat 100 tapeouts. Det talar väl för efterfrågan på och effektiviteten av en lösning som denna. Stelios tillade att värdet blir ännu mer uppenbart för applikationer som måste instansiera ett block många gånger. Tänk på en server med många kärnor, en GPU eller en nätverksswitch. Optimera ett block en gång, instansiera många gånger – det kan lägga till en betydande PPA-förbättring.

Jag frågade om kunder som gör detta alla arbetar vid 7nm och lägre. Överraskande nog finns det aktiv användning ända upp till 40nm. Ett intressant exempel är en blixtkontroll, en design som inte är särskilt prestandakänslig men som kan uppgå till tiotals till hundratals miljoner enheter. Att minska storleken med 5% här kan ha stor inverkan på marginalerna.

Vad finns under huven

DSO.ai är baserad på förstärkningsinlärning, ett hett ämne nu för tiden, men jag lovade ingen hype i den här artikeln. Jag bad Stelios att borra ner lite mer men blev inte förvånad när han sa att han inte kunde avslöja för mycket. Det han kunde berätta för mig var intressant nog. Han påpekade att i mer allmänna tillämpningar, en cykel genom en träningsuppsättning (en epok) antar en snabb (sekunder till minuter) metod för att bedöma nästa möjliga steg, genom till exempel gradientjämförelser.

Men seriös blockdesign kan inte optimeras med snabba uppskattningar. Varje försök måste löpa genom hela produktionsflödet, kartlägga till verkliga tillverkningsprocesser. Flöden som kan ta timmar att köra. En del av strategin för effektivt förstärkningsinlärning givet denna begränsning är parallellism. Resten är DSO.ai hemlig sås. Visst kan du föreställa dig att om den hemliga såsen kan komma med effektiva förbättringar baserat på en given epok, så kommer parallellism att påskynda framstegen genom nästa epok.

För detta ändamål måste denna förmåga verkligen köras i ett moln för att stödja parallellism. Privat moln på plats är ett alternativ. Microsoft har meddelat att de är värd för DSO.ai på Azure, och ST rapporterar i pressmeddelandet DSO.ai att de använde denna förmåga för att optimera implementeringen av en Arm-kärna. Jag föreställer mig att det kan finnas några intressanta debatter kring för- och nackdelar med att köra en optimering i ett offentligt moln över säg 1000 servrar om areaminskningen är värd det.

Feedback från kunder

Synopsys hävdar att kunder (inklusive ST och SK Hynix i detta tillkännagivande) rapporterar 3x+ produktivitetsökningar, upp till 25 % lägre total effekt och betydande minskning av formstorleken, allt med minskad användning av totala resurser. Med tanke på vad Stelios beskrev låter detta rimligt för mig. Verktyget tillåter utforskning av fler punkter i designtillståndsutrymmet inom ett givet schema än vad som skulle vara möjligt om den utforskningen var manuell. Så länge sökalgoritmen (den hemliga såsen) är effektiv, skulle det naturligtvis hitta ett bättre optimum än en manuell sökning.

Kort sagt, varken AI-hype eller snake oil. DSO.ai föreslår att AI går in i mainstream som en trovärdig teknisk förlängning av befintliga flöden. Du kan lära dig mer av pressmeddelande och från denna blogg.

Dela det här inlägget via:

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. Tillgång här.

- Källa: https://semiwiki.com/artificial-intelligence/324430-synopsys-design-space-optimization-hits-a-milestone/

- 100

- 2021

- a

- Om oss

- accelerera

- tvärs

- aktiv

- lagt till

- AI

- algoritm

- Alla

- tillåter

- och

- meddelade

- Tillkännagivande

- tillämpningar

- OMRÅDE

- ARM

- runt

- Artikeln

- artiklar

- autonom

- undvika

- Azure

- baserat

- blir

- nedan

- Bättre

- Stor

- Bit

- Blockera

- noggrann

- säkerligen

- hävdar

- cloud

- komma

- Oro

- Nackdelar

- styrenhet

- Kärna

- kunde

- Naturligtvis

- trovärdig

- Aktuella

- kund

- Kunder

- cykel

- Dagar

- debatter

- Efterfrågan

- beskriven

- Designa

- den

- diskussion

- Avfärda

- Distingerad

- gör

- ner

- varje

- lätt

- Effektiv

- effektivitet

- betona

- möjliggöra

- ingenjör

- Teknik

- Ingenjörer

- tillräckligt

- epok

- uppskattningar

- Även

- exempel

- befintliga

- utforskning

- Utforska

- förlängning

- SNABB

- hitta

- Förnamn

- passa

- Blixt

- flöda

- flöden

- från

- full

- sammansmältning

- Allmänt

- ges

- Målet

- GPU

- lyckligt

- huvud

- här.

- träffar

- värd

- HET

- ÖPPETTIDER

- HTTPS

- Hype

- Inverkan

- genomförande

- med Esport

- förbättra

- förbättring

- in

- Inklusive

- Ökar

- intressant

- IT

- större

- skrattar

- LÄRA SIG

- inlärning

- Lång

- gjord

- Vanliga

- manuell

- Produktion

- många

- kartläggning

- marginaler

- max-bredd

- betyder

- metod

- Microsoft

- kanske

- milstolpe

- miljon

- minuter

- mer

- Varken

- nät

- Nästa

- Uppenbara

- Olja

- ONE

- optimering

- Optimera

- optimerad

- optimal

- Alternativet

- annat

- övergripande

- del

- prestanda

- plato

- Platon Data Intelligence

- PlatonData

- Punkt

- poäng

- möjlig

- Inlägg

- kraft

- praxis

- tryck

- Pressmeddelande

- privat

- processer

- Produktion

- produktivitet

- Framsteg

- utlovade

- PROS

- allmän

- Offentligt moln

- Syftet

- Snabbt

- Reaktionen

- verklig

- rimlig

- nyligen

- Minskad

- reducerande

- förstärkning lärande

- frigöra

- rapport

- Rapportering

- Resurser

- REST

- avslöjar

- Körning

- rinnande

- Nämnda

- tidtabellen

- Sök

- sekunder

- Secret

- känslig

- allvarlig

- in

- Kort

- signifikant

- enda

- Storlek

- Skepsis

- lösning

- Lösningar

- några

- Utrymme

- talar

- Ange

- Steg

- Strategi

- Föreslår

- sommar

- stödja

- överraskad

- Växla

- Ta

- Målet

- Teknologi

- Smakämnen

- Området

- deras

- Genom

- gånger

- till

- i dag

- alltför

- verktyg

- ämne

- Totalt

- Utbildning

- rättegång

- under

- enheter

- användning

- värde

- via

- Vad

- som

- medan

- kommer

- inom

- arbetssätt

- värt

- skulle

- zephyrnet