07 februari 2023 (

Nanowerk Nyheter) Stora språkmodeller som OpenAI:s GPT-3 är massiva neurala nätverk som kan generera människoliknande text, från poesi till programmeringskod. Dessa maskininlärningsmodeller är utbildade med hjälp av mängder av internetdata och tar en liten bit av inmatad text och förutsäger sedan texten som sannolikt kommer härnäst. Men det är inte allt dessa modeller kan göra. Forskare utforskar ett märkligt fenomen som kallas in-context learning, där en stor språkmodell lär sig att utföra en uppgift efter att bara ha sett några få exempel – trots att den inte var tränad för den uppgiften. Till exempel kan någon mata modellen med flera exempelmeningar och deras känslor (positiva eller negativa), sedan uppmana den med en ny mening, och modellen kan ge den korrekta känslan. Vanligtvis skulle en maskininlärningsmodell som GPT-3 behöva omskolas med ny data för denna nya uppgift. Under denna utbildningsprocess uppdaterar modellen sina parametrar när den bearbetar ny information för att lära sig uppgiften. Men med inlärning i sammanhanget uppdateras inte modellens parametrar, så det verkar som om modellen lär sig en ny uppgift utan att lära sig något alls. Forskare från MIT, Google Research och Stanford University strävar efter att reda ut detta mysterium. De studerade modeller som är väldigt lika stora språkmodeller för att se hur de kan lära sig utan att uppdatera parametrar. Forskarnas teoretiska resultat visar att dessa massiva neurala nätverksmodeller kan innehålla mindre, enklare linjära modeller begravda inuti dem. Den stora modellen skulle sedan kunna implementera en enkel inlärningsalgoritm för att träna denna mindre, linjära modell för att slutföra en ny uppgift, genom att endast använda information som redan finns i den större modellen. Dess parametrar förblir fasta. Ett viktigt steg mot att förstå mekanismerna bakom inlärning i sammanhang, den här forskningen öppnar dörren till mer utforskning kring de inlärningsalgoritmer som dessa stora modeller kan implementera, säger Ekin Akyürek, doktorand i datavetenskap och huvudförfattare till en artikel (

“What learning algorithm is in-context learning? Investigations with linear models”) utforska detta fenomen. Med en bättre förståelse för inlärning i sammanhang kan forskare göra det möjligt för modeller att slutföra nya uppgifter utan behov av kostsam omskolning. "Om du vill finjustera dessa modeller måste du vanligtvis samla in domänspecifik data och göra en del komplex konstruktion. Men nu kan vi bara ge den en input, fem exempel, och den åstadkommer vad vi vill. Så inlärning i sammanhang är ett ganska spännande fenomen”, säger Akyürek. Dale Schuurmans, en forskare vid Google Brain och professor i datavetenskap vid University of Alberta, ansluter sig till Akyürek på tidningen; såväl som seniorförfattarna Jacob Andreas, X-konsortiets biträdande professor vid MIT-avdelningen för elektroteknik och datavetenskap och medlem av MIT Computer Science and Artificial Intelligence Laboratory (CSAIL); Tengyu Ma, biträdande professor i datavetenskap och statistik vid Stanford; och Danny Zhou, huvudforskare och forskningschef på Google Brain. Forskningen kommer att presenteras vid den internationella konferensen om läranderepresentationer.

En modell i en modell

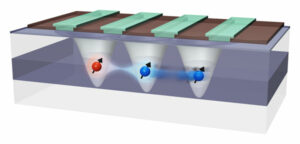

I forskarsamhället för maskininlärning har många forskare kommit att tro att stora språkmodeller kan utföra inlärning i sammanhang på grund av hur de tränas, säger Akyürek. Till exempel har GPT-3 hundratals miljarder parametrar och tränades genom att läsa enorma delar av text på internet, från Wikipedia-artiklar till Reddit-inlägg. Så när någon visar modellexemplen på en ny uppgift har den förmodligen redan sett något mycket liknande eftersom dess träningsdatauppsättning inkluderade text från miljarder webbplatser. Den upprepar mönster som den har sett under träning, snarare än att lära sig att utföra nya uppgifter. Akyürek antog att elever i sammanhanget inte bara matchar tidigare sett mönster, utan istället lär sig att utföra nya uppgifter. Han och andra hade experimenterat genom att ge dessa modeller uppmaningar med hjälp av syntetiska data, som de inte kunde ha sett någonstans tidigare, och funnit att modellerna fortfarande kunde lära sig av bara några få exempel. Akyürek och hans kollegor trodde att dessa neurala nätverksmodeller kanske har mindre maskininlärningsmodeller inuti sig som modellerna kan träna för att slutföra en ny uppgift. "Det kan förklara nästan alla inlärningsfenomen som vi har sett med dessa stora modeller", säger han. För att testa denna hypotes använde forskarna en neural nätverksmodell som kallas en transformator, som har samma arkitektur som GPT-3, men som hade utbildats specifikt för inlärning i sammanhang. Genom att utforska denna transformators arkitektur bevisade de teoretiskt att den kan skriva en linjär modell inom sina dolda tillstånd. Ett neuralt nätverk består av många lager av sammankopplade noder som behandlar data. De dolda tillstånden är skikten mellan in- och utgångsskikten. Deras matematiska utvärderingar visar att denna linjära modell är skriven någonstans i de tidigaste lagren av transformatorn. Transformatorn kan sedan uppdatera den linjära modellen genom att implementera enkla inlärningsalgoritmer. I huvudsak simulerar och tränar modellen en mindre version av sig själv.

Undersöka dolda lager

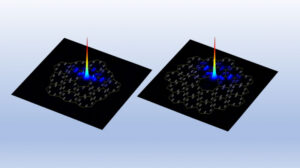

Forskarna utforskade denna hypotes med hjälp av sonderingsexperiment, där de tittade i transformatorns dolda lager för att försöka återvinna en viss kvantitet. "I det här fallet försökte vi återställa den faktiska lösningen till den linjära modellen, och vi kunde visa att parametern är skriven i de dolda tillstånden. Det betyder att den linjära modellen finns där någonstans, säger han. Utifrån detta teoretiska arbete kan forskarna möjligen göra det möjligt för en transformator att utföra inlärning i sammanhanget genom att bara lägga till två lager till det neurala nätverket. Det finns fortfarande många tekniska detaljer att räkna ut innan det skulle vara möjligt, varnar Akyürek, men det kan hjälpa ingenjörer att skapa modeller som kan slutföra nya uppgifter utan att behöva omskola med ny data. Framöver planerar Akyürek att fortsätta utforska inlärning i sammanhang med funktioner som är mer komplexa än de linjära modeller de studerade i detta arbete. De skulle också kunna tillämpa dessa experiment på stora språkmodeller för att se om deras beteenden också beskrivs av enkla inlärningsalgoritmer. Dessutom vill han gräva djupare i vilka typer av förträningsdata som kan möjliggöra inlärning i sammanhang. "Med detta arbete kan människor nu visualisera hur dessa modeller kan lära sig av exemplar. Så min förhoppning är att det förändrar vissa människors syn på inlärning i sammanhang, säger Akyürek. "De här modellerna är inte så dumma som folk tror. De memorerar inte bara dessa uppgifter. De kan lära sig nya uppgifter, och vi har visat hur det kan göras.”

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. Tillgång här.

- Källa: https://www.nanowerk.com/news2/robotics/newsid=62325.php