Efter år av utveckling kan Meta äntligen rulla ut sina hemmagjorda AI-acceleratorer på ett meningsfullt sätt i år.

Facebook-imperiet bekräftade sin önskan att komplettera distributionerna av Nvidia H100 och AMD MI300X GPU:er med sin Meta Training Inference Accelerator (MTIA) familj av chips denna vecka. Specifikt kommer Meta att distribuera en slutledningsoptimerad processor, enligt uppgift kodnamnet Artemis, baserad på Silicon Valley-jättens första generationens delar retad förra året.

"Vi är entusiastiska över de framsteg vi har gjort med våra interna kiselsatsningar med MTIA och är på väg att börja implementera vår slutledningsvariant i produktionen 2024," sa en talesperson för Meta. Registret på torsdag.

"Vi ser att våra internt utvecklade acceleratorer är mycket komplementära till kommersiellt tillgängliga GPU:er för att leverera den optimala blandningen av prestanda och effektivitet på Meta-specifika arbetsbelastningar," fortsatte representanten. Detaljer? Nej. Talesmannen sa till oss: "Vi ser fram emot att dela fler uppdateringar om våra framtida MTIA-planer senare i år."

Vi uppfattar det som att det andra generationens slutledningsfokuserade chipet rullar ut brett, efter en första generationens labbversion för slutledning, och vi kan senare få reda på delar som främst är avsedda för träning eller träning och slutledning.

Meta har blivit en av Nvidia och AMD:s bästa kunder i takt med att dess användning av AI-arbetsbelastningar har växt, vilket ökar dess behov och användning av specialiserat kisel för att få dess maskininlärningsprogram att köras så snabbt som möjligt. Därför är Instagram-jättens beslut att utveckla sina egna anpassade processorer inte så överraskande.

Faktum är att mega-företaget, på ytan, är relativt sent till den anpassade AI-kiselfesten när det gäller implementering i verkliga världen. Amazon och Google har använt egentillverkade komponenter för att accelerera interna maskininlärningssystem, såsom rekommendationsmodeller och kund ML-kod under några år. Samtidigt avslöjade Microsoft sina hemmagjorda acceleratorer förra året.

Men utöver det faktum att Meta rullar ut ett MTIA-inferenschip i stor skala, har det sociala nätverket inte avslöjat sin exakta arkitektur eller vilka arbetsbelastningar det reserverar för internt kisel och vilka det lastar av till AMD och Nvidias GPU:er.

Det är troligt att Meta kommer att köra etablerade modeller på sina anpassade ASIC:er för att frigöra GPU-resurser för mer dynamiska eller utvecklande applikationer. Vi har sett Meta gå den här vägen tidigare med anpassade acceleratorer utformade för att ladda ner data och beräkna intensiva videoarbetsbelastningar.

När det gäller den underliggande designen berättar industribevakarna på SemiAnalysis att det nya chippet är nära baserad på arkitekturen i Metas första generationsdelar.

Språngbrädor

Tillkännagav i början av 2023 efter tre års utveckling, Metas MTIA v1-delar, som våra vänner på Nästa plattform tittade på förra våren, designades specifikt med djupinlärningsrekommendationsmodeller i åtanke.

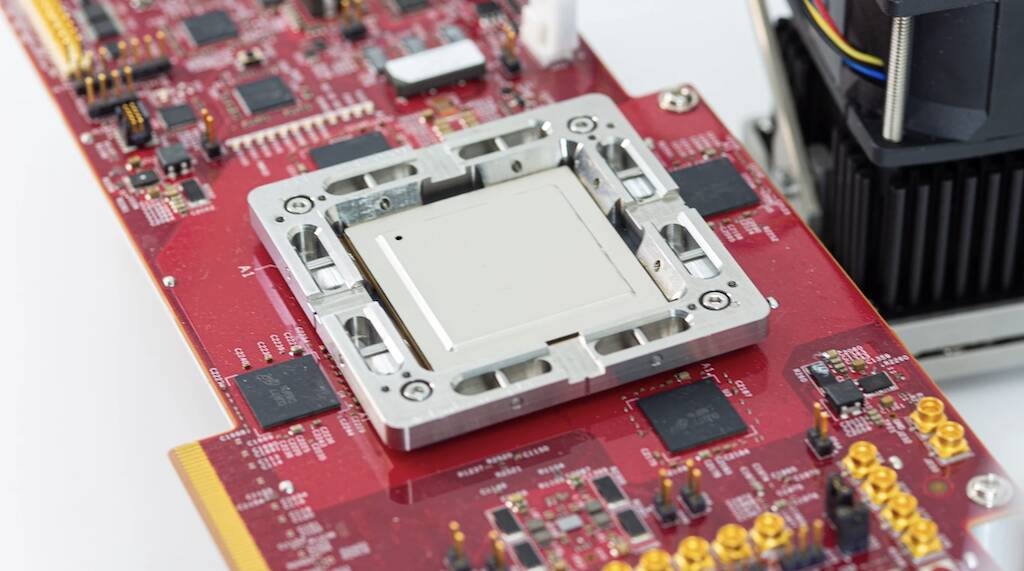

Den första generationens chip byggdes runt ett RISC-V CPU-kluster och tillverkades med TSMC:s 7nm-process. Under huven använde komponenten en åtta gånger åtta matris av bearbetningselement som var och en var utrustad med två RV CPU-kärnor, varav en är utrustad med vektormatematiktillägg. Dessa kärnor matas från generösa 128 MB on-chip SRAM och upp till 128 GB LPDDR5-minne.

Som Meta hävdade förra året körde chippet på 800 MHz och toppade med 102.4 biljoner operationer per sekund av INT8-prestanda eller 51.2 teraFLOPS med halv precision (FP16). Som jämförelse kan Nvidias H100 klara nästan fyra petaFLOPS glesa FP8-prestanda. Även om det inte var så kraftfullt som varken Nvidia eller AMD:s GPU:er, hade chippet en stor fördel: Strömförbrukning. Själva chippet hade en termisk designeffekt på bara 25 watt.

Enligt Semi -analys, Metas senaste chip har förbättrade kärnor och byter ut LPDDR5 mot minne med hög bandbredd som paketerats med TSMC:s chip-on-wafer-on-substrat (CoWoS)-teknik.

En annan anmärkningsvärd skillnad är att Metas andra generations chip faktiskt kommer att få en omfattande distribution över sin datacenterinfrastruktur. Enligt Facebook-titanen, medan den första generationens del användes för att köra produktionsreklammodeller, lämnade den aldrig labbet.

Jagar artificiell allmän intelligens

Anpassade delar åt sidan har Facebook- och Instagram-föräldern dumpat miljarder av dollar på GPU:er under de senaste åren för att påskynda alla möjliga uppgifter som är dåligt lämpade för konventionella CPU-plattformar. Framväxten av stora språkmodeller, som GPT-4 och Metas egen Llama 2, har dock förändrat landskapet och drivit utbyggnaden av massiva GPU-kluster.

I den skala Meta verkar har dessa trender krävt drastiska förändringar av dess infrastruktur, inklusive redesign av flera datacenter för att stödja de enorma kraft- och kylningskrav som är förknippade med stora AI-distributioner.

Och Metas implementeringar kommer bara att bli större under de närmaste månaderna när företaget flyttar fokus från metaversen till utveckling artificiell allmän intelligens. Antagligen kommer arbete på AI att hjälpa till att bilda metaversen eller något liknande.

Enligt vd Mark Zuckerberg planerar Meta att distribuera så många som 350,000 100 Nvidia HXNUMX bara i år.

The biz tillkännagav också planer på att distribuera AMD:s nya lanserades MI300X GPU:er i sina datacenter. Zuckerberg hävdade att hans företag skulle avsluta året med motsvarande beräkningskraft på 600,000 100 HXNUMX. Så uppenbarligen kommer Metas MTIA-chips inte att ersätta GPU:er snart. ®

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://go.theregister.com/feed/www.theregister.com/2024/02/02/meta_ai_chips/

- : har

- :är

- $UPP

- 000

- 102

- 2%

- 2023

- 2024

- 25

- 350

- 4

- 51

- 600

- 800

- a

- Om oss

- accelerera

- accelerator

- acceleratorer

- Enligt

- tvärs

- faktiskt

- Fördel

- reklam

- Efter

- AI

- Alla

- ensam

- vid sidan av

- också

- amason

- AMD

- an

- och

- meddelade

- tillämpningar

- arkitektur

- ÄR

- runt

- konstgjord

- konstgjord allmän intelligens

- AS

- ASIC

- åt sidan

- associerad

- At

- tillgänglig

- baserat

- BE

- blir

- varit

- innan

- BÄST

- Bortom

- biz

- ståtar

- byggt

- by

- kapabel

- VD

- ändrats

- Förändringar

- chip

- Pommes frites

- hävdade

- klart

- nära

- kluster

- CO

- koda

- kommersiellt

- företag

- jämförelse

- komplementär

- komponent

- komponenter

- Compute

- databehandling

- beräkningskraft

- BEKRÄFTAT

- konsumtion

- fortsatte

- konventionell

- FÖRETAG

- CPU

- beställnings

- kund

- Kunder

- datum

- Datacenter

- Beslutet

- leverera

- distribuera

- utplacera

- utplacering

- distributioner

- Designa

- utformade

- lust

- detaljer

- utveckla

- utvecklade

- Utveckling

- DID

- Skillnaden

- dollar

- gjort

- ner

- driven

- dynamisk

- varje

- Tidig

- effektivitet

- ansträngningar

- antingen

- element

- Empire

- anställd

- änden

- utrustad

- Motsvarande

- etablerade

- Eter (ETH)

- utvecklas

- exciterade

- förlängningar

- Ansikte

- Faktum

- familj

- SNABB

- Fed

- få

- Slutligen

- hitta

- Fokus

- efter

- För

- formen

- Framåt

- fyra

- Fri

- vänner

- från

- framtida

- Allmänt

- allmän intelligens

- generös

- skaffa sig

- jätte

- Go

- kommer

- GPU

- GPUs

- vuxen

- hade

- Hälften

- Har

- hjälpa

- höggradigt

- hans

- hemodlade

- huva

- Men

- HTTPS

- enorma

- förbättras

- in

- Inklusive

- ökande

- industrin

- Infrastruktur

- Intelligens

- avsedd

- intensiv

- inre

- invändigt

- isn

- IT

- DESS

- sig

- jpg

- bara

- lab

- liggande

- språk

- Large

- större

- Efternamn

- Förra året

- Sent

- senare

- senaste

- vänster

- tycka om

- sannolikt

- Lama

- se

- gjord

- större

- göra

- sätt

- många

- markera

- Mark Zuckerberg

- massiv

- matte

- Matris

- Maj..

- betyda

- meningsfull

- Samtidigt

- Minne

- meta

- Metavers

- Microsoft

- emot

- Blanda

- ML

- modeller

- månader

- mer

- Nära

- nästan

- Behöver

- nät

- aldrig

- Nya

- nytt chip

- nytt

- Nästa

- inte heller

- anmärkningsvärd

- Nvidia

- of

- on

- ONE

- endast

- fungerar

- Verksamhet

- optimala

- or

- vår

- ut

- över

- egen

- förpackade

- del

- reservdelar till din klassiker

- parti

- för

- prestanda

- planer

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- möjlig

- kraft

- den mäktigaste

- exakt

- Precision

- primärt

- process

- bearbetning

- Processorn

- processorer

- Produktion

- Framsteg

- RE

- verkliga världen

- senaste

- relativt

- Krav

- Resurser

- Reuters

- avslöjade

- Rise

- Rulla

- Rullande

- Rutt

- Körning

- s

- Skala

- Andra

- se

- sett

- flera

- delning

- Skift

- Kisel

- Silicon Valley

- So

- Social hållbarhet

- sociala nätverk

- Mjukvara

- några

- något

- Alldeles strax

- gles

- specialiserad

- specifikt

- talesman

- vår

- starta

- sådana

- komplettera

- stödja

- förvånande

- System

- T

- tar

- uppgifter

- tech

- tala

- villkor

- den där

- Smakämnen

- Landskapet

- Den Metaverse

- termisk

- Dessa

- detta

- denna vecka

- i år

- tre

- torsdag

- Således

- titan

- till

- berättade

- toppad

- spår

- handel

- Utbildning

- Trender

- Biljon

- tsmc

- två

- under

- underliggande

- Uppdateringar

- us

- användning

- Begagnade

- med hjälp av

- v1

- Dal

- Variant

- Ve

- vektor

- version

- Video

- var

- Sätt..

- we

- vecka

- były

- som

- medan

- brett

- utbredd

- kommer

- med

- Vann

- Arbete

- skulle

- år

- år

- zephyrnet

- Zucker