Meta har släppt ännu en typ av öppen maskininlärningsmodell, denna gång inställd för generering av mjukvarukällkod.

Kod lama är en familj av stora språkmodeller – därav den enstaka versaler "LLaMA" – baserad på Llama 2-modellen frigörs i juli. Den har finjusterats och tränats för att dispensera och diskutera källkod som svar på textuppmaningar, istället för prosa som dess stamfader.

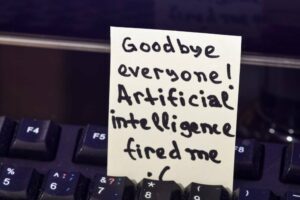

Som med all avancerad teknologi, kommer Code Llama med risker

"Code Llama har potential att användas som ett produktivitets- och utbildningsverktyg för att hjälpa programmerare att skriva mer robust, väldokumenterad mjukvara," hävdade Meta i ett tillkännagivande Torsdag.

Om du ber Code Llama att skriva en funktion som producerar Fibonacci-sekvensen, kommer modellen att generera både kod och naturligt språk som förklarar källan, säger Meta. Och AI-modellen kan göra det i Python, C++, Java, PHP, Typescript (Javascript), C#, Bash och andra språk.

Användare uppmanas dock att adressera Code Llama på engelska eftersom modellen inte har genomgått säkerhetstestning på andra språk och kan bara säga något hemskt om den frågas på en ur sikte språk.

"Som med all spetsteknologi, kommer Code Llama med risker," förklarar Meta och noterar att Code Llama svarade med säkrare svar än ChatGPT (GPT3.5 Turbo).

Enligt Meta överträffar Code Llama öppen källkod, kodspecifika LLM:er och sin egen moder Llama 2 på två riktmärken – HumanEval och mestadels grundläggande Python-programmering (MBPP) – och matchar prestandan för OpenAI:s ChatGPT.

Code Llama finns i tre storlekar – 7B, 13B och 34B parametrar – och varje variant tränades med 500B tokens av kod och kodrelaterad data. En token är ungefär fyra tecken på engelska. Den största versionen av OpenAI:s Codex, när den släpptes, hade 12B parametrar.

De två minsta Code Llama-modellerna, säger Meta, har tränats för att fylla i saknad källa vilket gör att de kan användas för kodkomplettering utan ytterligare finjustering. 34B-versionen sägs ge de bästa resultaten, men de två mindre svarar snabbare, vilket gör dem bättre för uppgifter som kodkomplettering där latensen märks.

Det finns också två varianter: Code Llama – Python och Code Llama – Instruct. Den förra kommer från finjustering av Code Llama med ytterligare 100B tokens av Python-kod. Den senare har finjusterats för att följa ingångs- och utmatningsmönster, vilket gör den bättre lämpad för kodgenerering.

Pålitlighet, någon?

LLM tillhandahåller ofta felaktig svar till programmeringsmeddelanden, även om de ändå används av många utvecklare för att återkalla rote-mönster och API-parametrar, eller för att undvika sökfrågor och dokumentationskontroller.

En av försäljningsargumenten med Code Llama är att den kan hantera inmatning och utmatning av kodsekvenser som består av upp till 100,000 XNUMX tokens. Det vill säga, du kan fråga modellen med många rader kod och du kan få ett utförligt svar.

"Förutom att det är en förutsättning för att generera längre program, låser längre inmatningssekvenser upp spännande nya användningsfall för en kod LLM," förklarade Meta. "Användare kan till exempel förse modellen med mer sammanhang från sin kodbas för att göra generationerna mer relevanta. Det hjälper också till att felsöka scenarier i större kodbaser, där det kan vara en utmaning för utvecklare att hålla koll på all kod relaterad till ett konkret problem."

Användare kan ge modellen mer sammanhang från sin kodbas för att göra generationerna mer relevanta

Code Llama ansluter sig till ett växande fält av kodkunniga modeller som ursprungligen seedades av OpenAIs Codex och GitHubs associerade rättegång belastad Copilot (2021) programmeringsförslagstjänst. Programmeringspositiva modeller som följde inkluderar DeepMinds AlphaCode (2022), OpenAI:s GPT-4 (2023), Amazon Code Whisperer (2023) och Googles Bard (2023), ställdes i april att generera källkod.

Dessutom har det funnits olika öppen källkod (eller typ av öppen) LLM som StarCoder och XGen, för att nämna två.

Meta har släppt Code Llama under samma samhällslicens som Llama 2, och citerar megaföretagets tro på "ett öppet förhållningssätt till AI" som det bästa sättet att utveckla verktyg som är innovativa, säkra och ansvarsfulla.

Men som allmänt noterats med Llama 2, är gemenskapslicensen inte en öppen källkodslicens. Metas "öppna inställning" till AI är stängd för konkurrens - licensen tillåter uttryckligen att programvaran används "för att förbättra alla andra stora språkmodeller."

Och medan Metas community-licens tillåter kommersiell användning av dess olika lamor, drar den gränsen för tjänster med "mer än 700 miljoner aktiva användare per månad."

Det snarare välj grupp av megatjänster – YouTube, WeChat, TikTok, LinkedIn, Telegram, Snapchat och Douyin, bland sociala medieplattformar som inte redan drivs av Meta, och förmodligen företag som kör operativsystembaserade plattformar som Apple, Google och Microsoft – "måste begära en licens från Meta, som Meta kan ge dig efter eget gottfinnande...” ®

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Fordon / elbilar, Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- ChartPrime. Höj ditt handelsspel med ChartPrime. Tillgång här.

- BlockOffsets. Modernisera miljökompensation ägande. Tillgång här.

- Källa: https://go.theregister.com/feed/www.theregister.com/2023/08/25/meta_lets_code_llama_run/

- : har

- :är

- :inte

- :var

- $UPP

- 000

- 100

- 2021

- 2022

- 2023

- 700

- a

- aktiv

- Dessutom

- adress

- anslutit sig

- AI

- Alla

- tillåter

- redan

- också

- amason

- bland

- an

- och

- Annan

- svar

- vilken som helst

- någon

- api

- Apple

- tillvägagångssätt

- April

- ÄR

- AS

- associerad

- At

- undvika

- baserat

- bash

- grundläggande

- BE

- varit

- Där vi får lov att vara utan att konstant prestera,

- tro

- riktmärken

- BÄST

- Bättre

- båda

- men

- by

- C + +

- KAN

- kapitalisering

- fall

- utmanande

- tecken

- ChatGPT

- Kontroller

- hävdade

- stängt

- CO

- koda

- Kodbas

- kommer

- kommersiella

- samfundet

- Företag

- konkurrens

- fullbordan

- sammanhang

- skapande

- skärning

- datum

- Deepmind

- utveckla

- utvecklare

- DID

- diskutera

- do

- dokumentation

- douyin

- drar

- under

- varje

- kant

- pedagogiska

- Engelska

- Eter (ETH)

- exempel

- spännande

- förklarade

- förklara

- Förklarar

- extra

- familj

- snabbare

- FB

- Fibonacci

- fält

- fylla

- änden

- följt

- För

- Tidigare

- fyra

- från

- fungera

- ytterligare

- generera

- generera

- generering

- generationer

- skaffa sig

- GitHub

- bevilja

- större

- Odling

- hade

- hantera

- Har

- har

- hjälpa

- hjälper

- därav

- Men

- HTTPS

- if

- förbättra

- in

- I andra

- innefattar

- initialt

- innovativa

- ingång

- istället

- fråga

- IT

- DESS

- java

- JavaScript

- Fogar

- jpg

- Juli

- bara

- språk

- Språk

- Large

- större

- största

- Latens

- inlärning

- Lets

- Licens

- tycka om

- linje

- rader

- Lama

- längre

- Maskinen

- maskininlärning

- göra

- Framställning

- många

- Maj..

- Media

- meta

- Microsoft

- kanske

- miljon

- saknas

- modell

- modeller

- månad

- mer

- för det mesta

- måste

- namn

- Natural

- Naturligt språk

- Nya

- noterade

- notera

- tillfällig

- of

- Ofta

- on

- ONE

- öppet

- öppen källkod

- OpenAI

- drift

- or

- Övriga

- utklassar

- produktion

- egen

- parametrar

- mönster

- prestanda

- PHP

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- poäng

- potentiell

- producerar

- produktivitet

- stamfader

- programmerare

- Programmering

- Program

- ge

- sätta

- Python

- sökfrågor

- snarare

- RE

- Red

- relaterad

- frigörs

- relevanta

- begära

- Svara

- respons

- ansvarig

- Resultat

- Riot

- risker

- robusta

- ungefär

- Körning

- rinnande

- s

- säker

- säkrare

- Säkerhet

- Nämnda

- Samma

- säga

- säger

- scenarier

- Sök

- Försäljningen

- Sekvens

- service

- Tjänster

- storlekar

- mindre

- snapchat

- So

- Social hållbarhet

- sociala medier

- sociala medierna

- Mjukvara

- något

- Källa

- källkod

- T

- uppgifter

- grupp

- Teknologi

- Telegram

- villkor

- Testning

- än

- den där

- Smakämnen

- källan

- deras

- Dem

- Där.

- de

- detta

- fastän?

- tre

- Genom

- torsdag

- Tick tack

- tid

- till

- token

- tokens

- verktyg

- verktyg

- topp

- tränad

- två

- skrivmaskin

- under

- låser upp

- användning

- Begagnade

- användare

- med hjälp av

- Variant

- olika

- version

- var

- Sätt..

- när

- som

- medan

- brett

- wikipedia

- kommer

- med

- utan

- skriva

- ännu

- dig

- Youtube

- zephyrnet