Smakämnen metaversumet lovar att bli nästa stora grej efter revolutionen för mobilt internet. Det räcker inte att koppla samman människor – ambitiösa företag vill föra dem samman i en virtuell värld som perfekt replikerar den verkliga. Avatarer kommer att interagera med varandra, göra affärer och ha kul precis som i den fysiska världen.

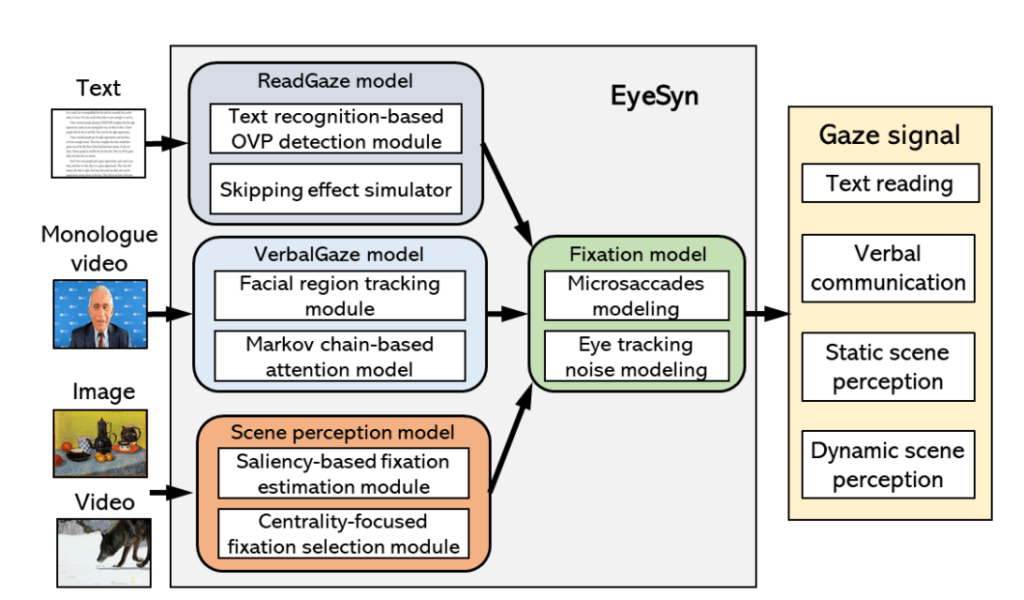

För att nå dit finns det ett ständigt behov av datauppsättningar att träna AI och utveckla metaverse-plattformar. Och Duke University har precis levererat en viktig pusselbit. Ett team av dataingenjörer har nyligen utvecklat EyeSyn – virtuella ögon som efterliknar rörelsen och fokus hos verkliga mänskliga ögon.

Varför fokusera på att utveckla virtuella ögon?

Metaversens utveckling beror på hur användare interagerar med den virtuella världen och vad de fokuserar på. Mänsklig ögonrörelse är det mest relevanta sättet att utvärdera vad användare tycker är intressant, spännande och värt att titta på. Ögonen har förmågan att berätta mer om en persons känslor, intressen, preferenser och fördomar än någon annan typ av icke-verbal kommunikation.

"Om du är intresserad av att upptäcka om en person läser en serietidning eller avancerad litteratur genom att bara titta på deras ögon, kan du göra det," sade Nortel Networks biträdande professor i elektro- och datorteknik vid Duke University, Maria Gorlatova, förklarar konceptet bakom EyeSyn-programmet. "Var du prioriterar din vision säger mycket om dig som person också. Det kan oavsiktligt avslöja sexuella och rasistiska fördomar, intressen som vi inte vill att andra ska veta om och information som vi kanske inte ens känner till om oss själva.”

Vikten av ögonrörelse för att utveckla metaversen

Ansträngningarna för att utveckla den simulerade plattformen för mänskliga ögonrörelser EyeSyn är väl motiverade. Skapare och utvecklare av AR- och VR-innehåll kan lära sig mycket om användarnas preferenser. Således kan de:

- Servera dem skräddarsytt innehåll;

- Minska upplösningen för perifer syn för att spara datorkraft;

- Tillåt användare att anpassa sin interaktion med virtuella tillgångar enligt deras preferenser.

Med de virtuella ögonen som utvecklats av teamet av forskare vid Duke University kan företag som arbetar med att bygga metaversen träna sina AR- och VR-plattformar och mjukvara utan att behöva komma åt riktiga användares eyetracking-data.

EyeSyn Virtual Eyes öppnar möjligheter för mindre företag

Samtidigt kommer de virtuella ögonen att tillåta mindre innehållsskapare att få tillgång till värdefull eyetracking-data, utan att utföra dyra tester med verkliga användare.

"Vi ville utveckla mjukvara som... tillåter mindre företag som inte har de nivåerna av resurser att komma in i metaverse-spelet," sa Gorlatova. "Mindre företag kan använda det snarare än att spendera tid och pengar på att försöka bygga sina egna datauppsättningar i verkligheten (med mänskliga ämnen).

Hur exakta är de virtuella ögonen?

Duke University-teamet testade EyeSyn på videor av Dr. Anthony Fauci under presskonferenser och jämförde resultaten med faktiska ögonrörelser av mänskliga tittare. Resultaten indikerar en nära matchning mellan de virtuella ögonens fokus och verkliga människors.

"Den syntetiska data ensam är inte perfekt, men det är en bra utgångspunkt," sa Gorlatova. "Om du ger EyeSyn många olika ingångar och kör det tillräckligt många gånger, kommer du att skapa en datamängd av syntetiska ögonrörelser som är tillräckligt stor för att träna en klassificerare (maskininlärning) för ett nytt program."

Att använda EyeSyn åtgärdar problemet med integritetsproblem

Företag har ännu en anledning att ta till de virtuella ögonen som utvecklats av Duke University. Att spela in riktiga människors ögonrörelser innebär att samla in personuppgifter – för närvarande en mycket känslig fråga.

De virtuella ögonen tillhör inte någon person – det finns därför ingen potentiell intrång i dataintegriteten när man skapar och använder datauppsättningar på detta sätt.

Den fullständiga rapporten om EyeSyn virtuella ögon kommer att presenteras av forskargruppen på Internationell konferens om informationsbehandling i sensornätverk, som kommer att äga rum i stort sett den 4-6 maj.

- Om Oss

- tillgång

- Enligt

- exakt

- aktiv

- aktivitet

- adresser

- avancerat

- Annan

- AR

- Tillgångar

- Assistent

- Avatars

- Blockera

- gränsen

- brott

- SLUTRESULTAT

- Byggnad

- företag

- Samla

- Kommunikation

- Företag

- jämfört

- databehandling

- beräkningskraft

- begrepp

- Konferens

- konferenser

- innehåll

- Skapa

- skaparna

- datum

- dataintegritet

- datauppsättning

- utveckla

- utvecklade

- utvecklare

- utveckla

- Utveckling

- olika

- Visa

- Duke

- ansträngningar

- Teknik

- Ingenjörer

- ögat

- Fokus

- full

- kul

- lek

- god

- har

- Hur ser din drömresa ut

- HTTPS

- humant

- vikt

- med Esport

- informationen

- intressen

- Internet

- fråga

- IT

- Large

- LÄRA SIG

- inlärning

- litteraturen

- du letar

- Maskinen

- maskininlärning

- Match

- Media

- Metavers

- Mobil

- pengar

- mer

- mest

- rörelse

- nätverk

- öppet

- möjligheter

- Övriga

- Personer

- personlig

- personlig information

- fysisk

- bit

- plattform

- Plattformar

- Punkt

- potentiell

- kraft

- tryck

- privatpolicy

- Program

- pussel

- Läsning

- meddelanden

- relevanta

- rapport

- forskning

- forskare

- Resort

- Resurser

- Resultat

- Körning

- Nämnda

- in

- Social hållbarhet

- sociala medier

- Mjukvara

- Spendera

- grupp

- tester

- tid

- tillsammans

- universitet

- användning

- användare

- Video

- Virtuell

- virtuell värld

- syn

- vr

- Vad

- om

- VEM

- utan

- Arbete

- världen

- värt