En teknisk artikel med titeln "WWW: What, When, Where to Compute-in-Memory" publicerades av forskare vid Purdue University.

Sammanfattning:

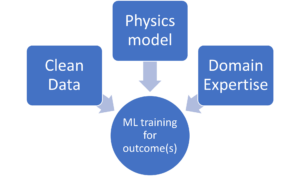

"Compute-in-memory (CiM) har dykt upp som en övertygande lösning för att lindra höga dataöverföringskostnader i von Neumanns maskiner. CiM kan utföra massivt parallella General Matrix Multiplication (GEMM) operationer i minnet, den dominerande beräkningen i Machine Learning (ML) slutledning. Emellertid ställer omanvändning av minne för beräkning nyckelfrågor om 1) Vilken typ av CiM som ska användas: Med tanke på en mängd analoga och digitala CiM:er behövs det att avgöra deras lämplighet ur ett systemperspektiv. 2) När ska man använda CiM: ML-inferens inkluderar arbetsbelastningar med en mängd olika minnes- och beräkningskrav, vilket gör det svårt att identifiera när CiM är mer fördelaktigt än standardbehandlingskärnor. 3) Var ska man integrera CiM: Varje minnesnivå har olika bandbredd och kapacitet, vilket påverkar datarörelsen och fördelarna med CiM-integrering.

I det här dokumentet utforskar vi svaren på dessa frågor om CiM-integration för ML-inferensacceleration. Vi använder Timeloop-Accelergy för tidig utvärdering på systemnivå av CiM-prototyper, inklusive både analoga och digitala primitiver. Vi integrerar CiM i olika cacheminnesnivåer i en Nvidia A100-liknande baslinjearkitektur och skräddarsyr dataflödet för olika ML-arbetsbelastningar. Våra experiment visar att CiM-arkitekturer förbättrar energieffektiviteten, uppnår upp till 0.12 gånger lägre energi än den etablerade baslinjen med INT-8-precision, och upp till 4x prestandaökningar med viktinterfoliering och duplicering. Det föreslagna arbetet ger insikter i vilken typ av CiM som ska användas, och när och var man optimalt kan integrera den i cachehierarkin för GEMM-acceleration."

Hitta tekniskt dokument här. Publicerad december 2023 (förtryck).

Sharma, Tanvi, Mustafa Ali, Indranil Chakraborty och Kaushik Roy. "WWW: Vad, när, var ska man beräkna-i-minne." arXiv förtryck arXiv:2312.15896 (2023).

Relaterad läsning

Ökar AI-energieffektiviteten med dator i minnet

Hur man bearbetar zettascale-arbetsbelastningar och håller sig inom en fast energibudget.

Modellering beräkna i minnet med biologisk effektivitet

Generativ AI tvingar chiptillverkare att använda beräkningsresurser mer intelligent.

SRAM In AI: The Future Of Memory

Varför SRAM ses som ett kritiskt element i nya och traditionella datorarkitekturer.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://semiengineering.com/cim-integration-for-ml-inference-acceleration/

- : har

- :är

- :var

- $UPP

- 1

- 2023

- a

- acceleration

- uppnå

- AI

- lindra

- an

- och

- svar

- arkitektur

- AS

- At

- Bandbredd

- Baslinje

- fördelaktigt

- Fördelarna

- båda

- budget

- by

- cache

- KAN

- Kapacitet

- övertygande

- beräkning

- Compute

- Kostar

- kritisk

- datum

- December

- bestämmande

- olika

- svårt

- digital

- dominerande

- varje

- Tidig

- effektivitet

- elementet

- dykt

- energi

- energieffektivitet

- etablerade

- utvärdering

- experiment

- utforska

- fixerad

- För

- Krafter

- från

- framtida

- resultat

- Allmänt

- ges

- här.

- hierarkin

- Hög

- Men

- HTTPS

- identifiera

- förbättra

- in

- innefattar

- Inklusive

- insikter

- integrera

- integrering

- in

- IT

- jpg

- Nyckel

- inlärning

- Nivå

- nivåer

- lägre

- Maskinen

- maskininlärning

- Maskiner

- Framställning

- massivt

- Matris

- Minne

- ML

- mer

- rörelse

- mängd

- behövs

- Nya

- Nvidia

- of

- on

- öppet

- Verksamhet

- vår

- Papper

- Parallell

- utföra

- prestanda

- perspektiv

- plato

- Platon Data Intelligence

- PlatonData

- utgör

- kraft

- Precision

- process

- bearbetning

- föreslagen

- prototyper

- ger

- publicerade

- frågor

- om

- Krav

- forskare

- Resurser

- roy

- show

- lösning

- standard

- bo

- lämplighet

- System

- Teknisk

- än

- den där

- Smakämnen

- Framtiden

- deras

- Dessa

- detta

- betitlad

- till

- traditionell

- Typ

- universitet

- användning

- mängd

- olika

- ses

- av

- var

- we

- vikt

- Vad

- när

- med

- inom

- Arbete

- zephyrnet