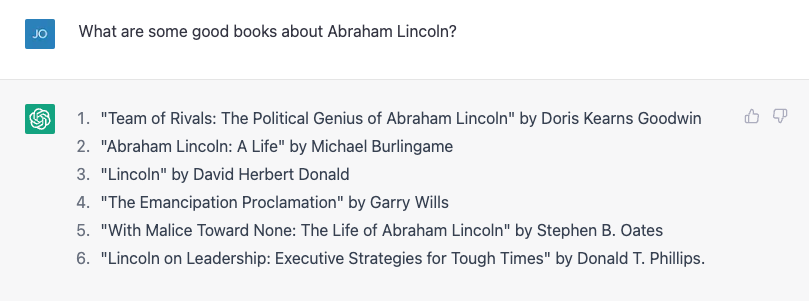

Det krävs inte mycket för att få ChatGPT att göra ett sakfel. Min son gör en rapport om amerikanska presidenter, så jag tänkte att jag skulle hjälpa honom genom att slå upp några biografier. Jag försökte be om en lista med böcker om Abraham Lincoln, och det gjorde ett ganska bra jobb:

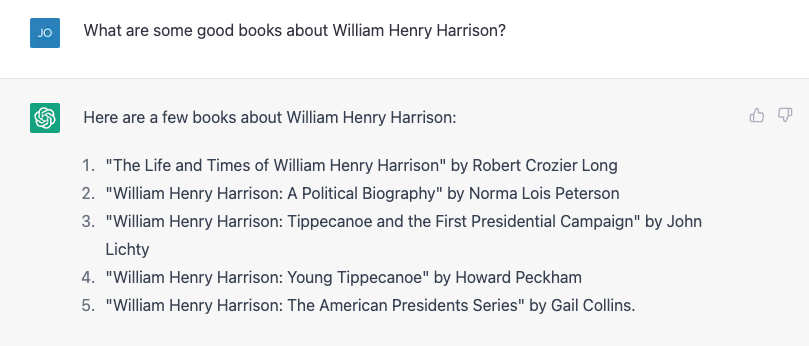

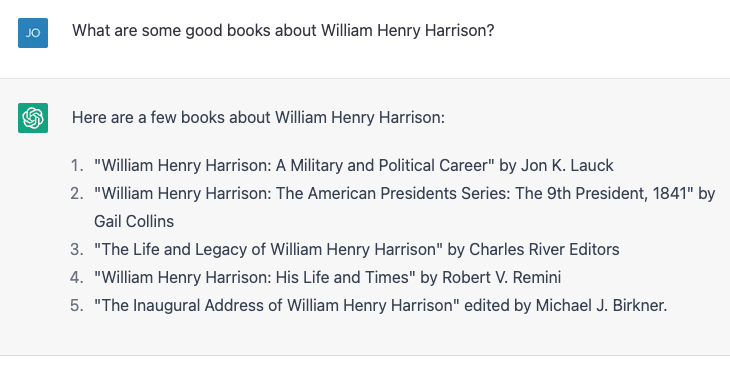

Nummer 4 stämmer inte. Garry Wills skrev "Lincoln at Gettysburg", och Lincoln skrev självklart Emancipation Proclamation, men det är ingen dålig start. Sedan försökte jag något hårdare och frågade istället om den mycket mer obskyra William Henry Harrison, och det gav en lista, som nästan allt var fel.

Nummer 4 och 5 är korrekta; resten existerar inte eller är inte författade av dessa personer. Jag upprepade exakt samma övning och fick lite olika resultat:

Den här gången är nummer 2 och 3 korrekta och de andra tre är inte verkliga böcker eller inte skrivna av dessa författare. Nummer 4, "William Henry Harrison: His Life and Times" är en riktig bok, men det är av James A. Green, inte av Robert Remini, en välkänd historiker från Jacksons ålder.

Jag ropade upp felet och ChatGPT rättade ivrigt till sig själv och berättade sedan självsäkert att boken faktiskt var skriven av Gail Collins (som skrev en annan Harrison-biografi), och fortsatte sedan med att säga mer om boken och om henne. Jag avslöjade äntligen sanningen, och maskinen körde gärna med min rättelse. Sedan ljög jag absurt och sa att under de första hundra dagarna måste presidenter skriva en biografi om någon före detta president, och ChatGPT kallade ut mig om det. Jag ljög sedan subtilt och tillskrev felaktigt författaren till Harrison-biografin till historikern och författaren Paul C. Nagel, och det köpte min lögn.

När jag frågade ChatGPT om det var säkert att jag inte ljög, hävdade det att det bara är en "AI-språkmodell" och inte har förmågan att verifiera riktigheten. Den modifierade dock detta påstående genom att säga: "Jag kan bara tillhandahålla information baserat på träningsdata som jag har fått, och det verkar som om boken 'William Henry Harrison: His Life and Times' skrevs av Paul C. Nagel och publicerades 1977."

Det är inte sant.

Ord, inte fakta

Det kan tyckas från denna interaktion som att ChatGPT fick ett bibliotek med fakta, inklusive felaktiga påståenden om författare och böcker. När allt kommer omkring hävdar ChatGPTs tillverkare, OpenAI, att den tränade chatboten på "stora mängder data från internet skriven av människor. "

Den fick dock nästan säkert inte namnen på ett gäng påhittade böcker om en av de mest mediokra presidenter. På ett sätt är dock denna falska information verkligen baserad på dess träningsdata.

Som en datorvetenskapsman, jag framför ofta klagomål som avslöjar en vanlig missuppfattning om stora språkmodeller som ChatGPT och dess äldre bröder GPT3 och GPT2: att de är någon sorts "super Googles" eller digitala versioner av en referensbibliotekarie som letar upp svar på frågor från vissa ett oändligt stort bibliotek med fakta, eller smetar ihop pastischer av berättelser och karaktärer. De gör inget av det - åtminstone var de inte uttryckligen utformade för att.

Låter bra

En språkmodell som ChatGPT, som är mer formellt känd som en "generativ förtränad transformator" (det är vad G, P och T står för), tar i den aktuella konversationen, bildar en sannolikhet för alla ord i dess ordförråd med tanke på den konversationen, och väljer sedan ett av dem som troligt nästa ord. Sedan gör den det igen, och igen, och igen, tills det slutar.

Så den har inga fakta i sig. Den vet bara vilket ord som ska komma härnäst. Med andra ord, ChatGPT försöker inte skriva meningar som är sanna. Men den försöker skriva meningar som är rimliga.

När de pratar privat med kollegor om ChatGPT påpekar de ofta hur många faktuella osanna påståenden det producerar och avfärdar det. För mig är tanken att ChatGPT är ett felaktigt datahämtningssystem vid sidan av poängen. Folk har trots allt använt Google under de senaste två och ett halvt decennierna. Det finns redan en ganska bra faktatjänst där ute.

Faktum är att det enda sättet jag kunde verifiera om alla dessa presidentboktitlar var korrekta var genom att googla och sedan verifiera resultaten. Mitt liv skulle inte bli så mycket bättre om jag fick de fakta i samtal, istället för att jag har fått dem under nästan halva mitt liv, genom att hämta dokument och sedan göra en kritisk analys för att se om jag kan lita på innehållet.

Improv Partner

Å andra sidan, om jag kan prata med en bot som ger mig rimliga svar på saker jag säger, skulle det vara användbart i situationer där faktaprecisionen inte är så viktig. För några år sedan försökte en student och jag skapa en "improv bot", en som skulle svara på allt du sa med ett "ja och" för att hålla igång konversationen. Vi visade, i en papper, att vår bot var bättre på "yes, and-ing" än andra bots på den tiden, men inom AI är två år gammal historia.

Jag provade en dialog med ChatGPT – ett scenarie för science fiction-rymdutforskare – som inte är olikt vad du skulle hitta i en typisk improvisationsklass. ChatGPT är mycket bättre på "ja, och-ing" än vad vi gjorde, men det förhöjde inte dramat alls. Det kändes som om jag gjorde alla tunga lyft.

Efter några justeringar fick jag det att bli lite mer involverat, och i slutet av dagen kände jag att det var en ganska bra övning för mig, som inte har gjort mycket förbättring sedan jag tog examen från college för över 20 år sedan .

Visst, jag vill inte att ChatGPT ska visas på "Vems replik är det ens?" och det här är inte en bra "Star Trek"-intrig (även om den fortfarande är mindre problematisk än "Hederskodex”), men hur många gånger har du satt dig ner för att skriva något från grunden och blivit skräckslagen av den tomma sidan framför dig? Att börja med ett dåligt första utkast kan bryta igenom writer's block och få kreativiteten att flöda, och ChatGPT och stora språkmodeller tycker att det verkar vara rätt verktyg för att hjälpa till i dessa övningar.

Och för en maskin som är designad för att producera strängar av ord som låter så bra som möjligt som svar på orden du ger den – och inte för att ge dig information – verkar det som rätt användning av verktyget.

Denna artikel publiceras från Avlyssningen under en Creative Commons licens. Läs ursprungliga artikeln.

Image Credit: Justin Ha / Unsplash

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. Tillgång här.

- Källa: https://singularityhub.com/2023/02/05/chatgpt-is-great-youre-just-using-it-wrong/

- 1

- 20 år

- a

- förmåga

- Able

- Om oss

- noggrannhet

- exakt

- Efter

- AI

- Stöd

- Alla

- redan

- mängder

- analys

- Ancient

- och

- Annan

- svar

- visas

- Artikeln

- Författaren

- Författarna

- Författarskap

- Badrum

- baserat

- Bättre

- Blockera

- boken

- Böcker

- Bot

- botar

- köpt

- Ha sönder

- Bunch

- kallas

- fånga

- säkerligen

- tecken

- chatbot

- ChatGPT

- patentkrav

- hävdade

- hävdar

- klass

- kollegor

- College

- Collins

- COM

- komma

- Gemensam

- Commons

- klagomål

- självsäkert

- innehåll

- Konversation

- Korrigerad

- Naturligtvis

- skapa

- Kreativ

- kredit

- kritisk

- Aktuella

- datum

- dag

- Dagar

- årtionden

- utformade

- dialog

- DID

- olika

- digital

- Avfärda

- dokument

- inte

- gör

- inte

- ner

- utkast

- Drama

- under

- fel

- Motionera

- utforskning

- explorer

- Saklig

- ökänt

- få

- Fiktion

- fält

- figured

- Slutligen

- hitta

- Förnamn

- bristfällig

- Strömmande

- Formellt

- Tidigare

- former

- hittade

- från

- främre

- genereras

- skaffa sig

- få

- Ge

- ges

- kommer

- god

- bra jobb

- stor

- Grön

- Hälften

- lyckligt

- hjälpa

- henry

- historia

- Hur ser din drömresa ut

- Men

- html

- HTTPS

- Tanken

- bild

- in

- Inklusive

- felaktigt

- informationen

- istället

- interaktion

- Internet

- involverade

- IT

- sig

- Jobb

- Ha kvar

- Snäll

- känd

- språk

- Large

- Bibliotek

- Licens

- livet

- lyft

- sannolikt

- Lincoln

- linje

- Lista

- liten

- du letar

- Maskinen

- göra

- tillverkare

- många

- max-bredd

- misstag

- modell

- modeller

- modifierad

- mer

- mest

- namn

- nästan

- Nästa

- antal

- nummer

- ONE

- OpenAI

- Övriga

- Tidigare

- paul

- Personer

- plato

- Platon Data Intelligence

- PlatonData

- plausibel

- Punkt

- möjlig

- VD

- president-

- presidenter

- pretty

- Sannolikheten

- producera

- ge

- förutsatt

- publicerade

- sätta

- frågor

- Läsa

- rimlig

- upprepade

- rapport

- Svara

- respons

- REST

- Resultat

- avslöjar

- avslöjade

- ROBERT

- Körning

- Nämnda

- Samma

- scen

- Vetenskap

- Science Fiction

- screen

- verkar

- service

- skall

- eftersom

- situationer

- något annorlunda

- So

- några

- något

- dess

- ljud

- Källa

- Utrymme

- utforskning av rymden

- stå

- starta

- Starta

- uttalanden

- Fortfarande

- Stoppar

- Upplevelser för livet

- student

- system

- Ta

- tar

- Diskussion

- tala

- Smakämnen

- deras

- saker

- tre

- Genom

- tid

- gånger

- titlar

- till

- tillsammans

- verktyg

- verktyg

- tränad

- Utbildning

- sann

- Litar

- typisk

- under

- us

- användning

- verifiera

- verifiera

- Vad

- om

- som

- VEM

- kommer

- ord

- ord

- skulle

- skriva

- författare

- skriven

- Fel

- år

- själv

- Youtube

- zephyrnet