Suresh är en teknikchef med djup teknisk expertis inom halvledare, artificiell intelligens, cybersäkerhet, internet-of-things, hårdvara, mjukvara, etc. Han tillbringade 20 år i branschen, senast som verkställande direktör för öppen källkod noll- litar på chiputveckling vid Technology Innovation Institute, Abu Dhabi, och i andra Fortune 500-halvledarföretag som Intel, Qualcomm och MediaTek i olika ledarroller, där han forskat och utvecklat högpresterande, energieffektiva, postkvantsäkra, säkra mikrochips/system-på-chips (SoCs)/acceleratorer för datacenter-, klient-, smartphone-, nätverks-, IoT- och AI/ML-marknaderna. Han bidrog till Falcon LLM (rankad #1 i huggingface) och var den ledande arkitekten för den anpassade AI-hårdvaruplattformen (inställd – prioriteringar ändrade). Han har 15+ amerikanska patent och har publicerat/presenterat på mer än 20+ konferenser.

Suresh är en teknikchef med djup teknisk expertis inom halvledare, artificiell intelligens, cybersäkerhet, internet-of-things, hårdvara, mjukvara, etc. Han tillbringade 20 år i branschen, senast som verkställande direktör för öppen källkod noll- litar på chiputveckling vid Technology Innovation Institute, Abu Dhabi, och i andra Fortune 500-halvledarföretag som Intel, Qualcomm och MediaTek i olika ledarroller, där han forskat och utvecklat högpresterande, energieffektiva, postkvantsäkra, säkra mikrochips/system-på-chips (SoCs)/acceleratorer för datacenter-, klient-, smartphone-, nätverks-, IoT- och AI/ML-marknaderna. Han bidrog till Falcon LLM (rankad #1 i huggingface) och var den ledande arkitekten för den anpassade AI-hårdvaruplattformen (inställd – prioriteringar ändrade). Han har 15+ amerikanska patent och har publicerat/presenterat på mer än 20+ konferenser.

Suresh tjänar också aktivt i en ledande position på RISC-V International där han är ordförande för Trusted Computing Group för att utveckla RISC-Vs konfidentiella datorkapacitet och är ordförande för AI/ML-gruppen för att utveckla RISC-V-hårdvaruacceleration för AI/ML-arbetsbelastningar som t.ex. Transformator stora språkmodeller som används i applikationer av ChatGPT-typ. Han ger också råd till startups och riskkapitalföretag om investeringsbeslutsstöd, produktstrategi, teknologisk due diligence, etc.

Han tog en MBA från INSEAD, en MS från Birla Institute of Technology & Science Pilani, ett Systems Engineering-certifikat från MIT, ett AI-certifikat från Stanford och ett fordonsfunktionellt säkerhetscertifikat från TÜV SÜD.

Berätta om ditt företag

"Mastiṣka AI” (Mastiṣka betyder hjärna på sanskrit) är ett AI-företag fokuserat på att bygga hjärnliknande datorer för att köra grundmodeller mer effektivt för morgondagens generativa AI-användningsfall.

Vilka problem löser du?

Med tanke på fördelarna med AI/GenAI kommer dess efterfrågan bara att öka, och det kommer också dess bieffekter på vår planet. Hur kan vi minska eller neutralisera biverkningarna av AI på vår planet? Kolavskiljning och kärnkraft är i rätt riktning. Men vi måste i grunden tänka om hur vi gör AI, är det fel sätt att göra tonvis av matrismultiplikationer?

Vår hjärna kan lära sig och utföra många uppgifter parallellt, i och under 10W, men varför förbrukar dessa AI-system 10s megawatt för att träna modeller?

Kanske kommer framtiden att ha energieffektiva arkitekturer som neuromorfa arkitekturer och spikneurala nätverksbaserade transformatorer som är närmast den mänskliga hjärnan, som kan förbruka 100-1000 gånger lägre energi, och därmed minska kostnaderna för att använda AI, och därmed demokratisera den och rädda vår planet.

De nuvarande utmaningarna vi står inför med AI är a) tillgänglighet, b) tillgänglighet, c) prisvärdhet och d) miljösäkerhet tillsammans med några rekommendationer för att hantera dem.

Om vi förutser i framtiden, demonstreras några användbara AGI-koncept i filmen "HER", där karaktären "Samantha" – en samtalsagent som är naturlig, förstår känslor, visar empati, är en fantastisk copilot på jobbet – och kör på handhållna enheter hela dagen, då kanske vi måste ta itu med utmaningarna nedan just nu.

Problem 1: Att träna en LLM kan kosta allt från 150K till 10+ miljoner dollar, och det tillåter bara de med djupare fickor att utveckla AI. Dessutom är slutledningskostnaderna också enorma (kostar 10 gånger mer än en webbsökning)

—> Vi måste förbättra energieffektiviteten hos modeller/hårdvara för att demokratisera AI till förmån för mänskligheten.

Problem 2: Att köra enorma AI-modeller för samtalsagenter eller rekommendationssystem sätter en belastning på miljön när det gäller elförbrukning och kyla.

—> Vi måste förbättra energieffektiviteten hos modeller/hårdvara för att rädda vår planet för våra barn.

Problem 3: Den mänskliga hjärnan är kapabel och kan multitaska, men förbrukar bara 10 watt istället för megawatt.

—> Vi kanske borde bygga maskiner som våra hjärnor och inte de vanliga matrismultiplikatorerna snabbare.

Mänskligheten kan bara frodas med hållbara innovationer, och inte genom att hugga ner alla skogar och koka haven i innovationens namn. Vi måste skydda vår planet för våra barns välfärd och kommande generationer...

Vilka applikationsområden är dina starkaste?

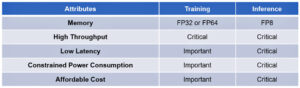

Utbildning och inferencing av transformatorbaserade (och framtida neural arkitektur) baserade grundmodeller, 50-100 gånger mer energieffektivt jämfört med dagens GPU-baserade lösningar.

Vad håller dina kunder vakna på natten?

Problem för kunder som för närvarande använder andra produkter:

Elförbrukningen för att träna humungous språkmodeller är bortom taket, till exempel att träna en 13B parameter LLM på 390B texttokens på 200 GPU: er under 7 dagar kostar $151,744 XNUMX (Källa: HuggingFace nya utbildningskluster servicesida – https://lnkd.in/g6Vc5cz3). Och även större modeller med 100+B parametrar kostar $10+M bara att träna. Betala sedan för slutledning varje gång en ny snabb begäran kommer.

Vattenförbrukning för kylning, forskare vid University of California, Riverside uppskattade miljöpåverkan av ChatGPT-liknande tjänster och säger att den suger upp 500 milliliter vatten (nära vad som finns i en 16-ounce vattenflaska) varje gång du frågar den en serie med mellan 5 till 50 uppmaningar eller frågor. Utbudet varierar beroende på var dess servrar finns och säsong. Uppskattningen inkluderar indirekt vattenanvändning som företagen inte mäter — som att kyla kraftverk som förser datacentren med el. (Källa: https://lnkd.in/gybcxX8C)

Problem för icke-kunder av aktuella produkter:

Har inte råd med CAPEX att köpa hårdvara

Har inte råd att använda molntjänster

Kan inte förnya eller utnyttja AI – fastnat i tjänstemodellen som eliminerar alla konkurrensfördelar

Hur ser konkurrenslandskapet ut och hur skiljer man åt?

- GPU:er dominerar träningsutrymmet, även om specialiserade ASIC:er också konkurrerar i detta segment

- Cloud & Edge-inferens har för många tillgängliga alternativ

Digital, Analog, Photonic — you name it människor försöker ta itu med samma problem.

Kan du dela med dig av dina tankar om det aktuella läget för chiparkitektur för AI/ML, vilket betyder, vad ser du som de viktigaste trenderna och möjligheterna just nu?

Följande trender:

Trend 1: För 10 år sedan blomstrade hårdvaruaktiverad djupinlärning, och nu hämmar samma hårdvara framsteg. På grund av den enorma kostnaden för hårdvara och elkostnader för att köra modeller har det blivit en utmaning att komma åt hårdvaran. Endast företag med djupa fickor har råd med dessa och håller på att bli monopol.

Trend 2: Nu när dessa modeller finns där måste vi använda dem för praktiska ändamål så att slutledningsbelastningen kommer att öka, vilket gör att processorer med AI-acceleratorer kan komma till rampljuset igen.

Trend 3: Nystartade företag försöker komma på alternativa flyttalsrepresentationer som det traditionella IEEE-formatet – som logaritmiskt och posit-baserat – är bra men inte tillräckligt. PPA$ design utrymme optimering exploderar när vi försöker optimera en och en annan går för en toss.

Trend 4: Branschen går bort från den tjänstebaserade modellen för AI till att vara värd för sina egna privata modeller i sina egna lokaler - men tillgång till hårdvara är en utmaning på grund av brist på försörjning, sanktioner, etc.

Aktuellt läge:

Tillgängligheten av hårdvara och data drev tillväxten av AI för 10 år sedan, nu är det samma hårdvara som hämmar det — låt mig förklara

Ända sedan CPU:er mådde dåligt och GPU:er användes för att göra AI, har många saker hänt

Företag har ägnat sig åt fyra segment av AI/ML, nämligen – 4) molnutbildning, 1) molninferencing, 2) edge-inferencing och 3) edge-träning (federated learning för integritetskänsliga applikationer).

Digital & Analog

Utbildningssidan – en uppsjö av företag som gör GPU:er, kundacceleratorer baserade på RISC-V, skivor i skivskala (850 XNUMX kärnor) och så vidare där traditionella processorer saknar (deras allmänna syfte). Inferenssida – NN-acceleratorer finns tillgängliga från alla tillverkare, i smartphones, bärbara datorer och andra edge-enheter.

Analoga memristor-baserade arkitekturer dök också upp för en tid sedan.

Vi tror att processorer kan vara mycket bra på att dra slutsatser om vi förbättrar den med acceleration som matristillägg

RISC-V-sidan av saken:

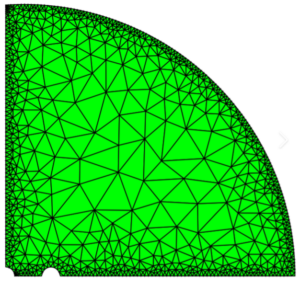

På RISC-V-sidan utvecklar vi acceleratorer för matrisoperationer och andra icke-linjära operationer för att eliminera möjliga flaskhalsar för transformatorarbetsbelastningar. Von Neumann-flaskhalsar åtgärdas också genom att skapa minnen närmare datoranvändning, vilket så småningom gör processorer med AI-acceleration till det rätta valet för slutledning.

Möjligheter:

Det finns unika möjligheter att fylla marknaden för grundmodeller. Exempel – OpenAI har nämnt att de inte kunde säkra tillräckligt med AI-beräkning (GPU) för att fortsätta driva sina ChatGPT-tjänster... och nyheterna rapporterar om elkostnader som är 10 gånger högre än vanliga internetsökningar och 500 ml vatten för att kyla ner systemen för varje fråga. Det finns en marknad att fylla i här - det är inte en nisch, utan hela marknaden som kommer att demokratisera AI och tackla alla de utmaningar som nämns ovan - a) tillgänglighet, b) tillgänglighet, c) överkomliga priser och d) miljösäkerhet

Vilka nya funktioner/teknik arbetar du med?

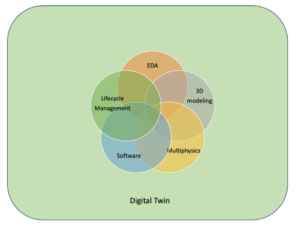

Vi bygger hjärna som datorer som utnyttjar neuromodrfiska tekniker och skräddarsy modeller för att dra fördel av den energieffektiva hårdvaran, återanvändning av möjliga öppna ramar

Hur ser du för dig att AI/ML-sektorn växer eller förändras under de kommande 12-18 månaderna?

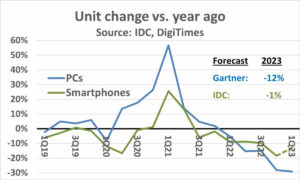

Eftersom efterfrågan på GPU:er har minskat (kostar som $30 XNUMX) plus att vissa delar av världen står inför sanktioner för att köpa dessa GPU:er, känner vissa delar av världen att de är frusna i AI-forskning och -utveckling utan tillgång till GPU:er. Alternativa hårdvaruplattformar kommer att fånga marknaden.

Modeller kanske kommer att börja krympa - anpassade modeller eller till och med i grunden skulle informationstätheten växa

Samma fråga men hur är tillväxten och förändringen de kommande 3-5 åren?

a) CPU: er med AI-tillägg skulle fånga AI-slutledningsmarknaden

b) Modeller skulle bli smidiga och parametrar kommer att falla ut när informationstätheten förbättras från 16 % till 90 %

c) Energieffektiviteten förbättras, CO2-fotavtrycket minskar

d) Nya arkitekturer kommer upp

e) hårdvarukostnader och energikostnader minskar så att inträdesbarriären för mindre företag att skapa och träna modeller blir överkomlig

f) folk pratar om ögonblicket före AGI, men mitt riktmärke skulle vara den karaktäriserade Samantha (konversations-AI) i filmen "henne".. vilket kanske är osannolikt med tanke på den höga kostnaden för att skala upp

Vilka är några av utmaningarna som kan påverka eller begränsa tillväxten inom AI/ML-sektorn?

a) Tillgång till hårdvara

b) Energikostnader och kylkostnader och miljöskador

Läs också:

Vd-intervju: David Moore på Pragmatic

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- : har

- :är

- :inte

- :var

- $UPP

- 1

- 10

- 150

- 20

- 20 år

- 200

- 50

- 500

- 7

- a

- Able

- Om oss

- ovan

- Abu Dhabi

- acceleration

- acceleratorer

- tillgång

- tillgänglighet

- aktivt

- adress

- adresserad

- adresse

- Fördel

- Affairs

- igen

- Recensioner

- medel

- AGI

- sedan

- AI

- AI-modeller

- ai forskning

- AI-system

- ai användningsfall

- AI / ML

- Justerat

- Alla

- tillåta

- tillåter

- längs

- också

- alternativ

- fantastiska

- an

- och

- Annan

- vilken som helst

- var som helst

- Ansökan

- tillämpningar

- arkitektur

- ÄR

- områden

- Ankommer

- konstgjord

- artificiell intelligens

- AS

- ASIC

- be

- At

- fordonsindustrin

- tillgänglighet

- tillgänglig

- bort

- b

- barriär

- baserat

- BE

- blir

- blir

- passande

- varit

- Där vi får lov att vara utan att konstant prestera,

- tro

- nedan

- riktmärke

- fördel

- Fördelarna

- mellan

- Bortom

- flaskhals

- bunden

- Hjärna

- Hjärnorna

- SLUTRESULTAT

- Byggnad

- men

- Köp

- by

- kalifornien

- KAN

- avbokad

- kapacitet

- kapabel

- kapital

- fånga

- kol

- koluppsamling

- fall

- Centers

- VD

- VD-intervju

- certifikat

- utmanar

- utmaningar

- byta

- ändrats

- byte

- karaktär

- ChatGPT

- Barn

- chip

- Pommes frites

- val

- Chopra

- klient

- Stäng

- närmare

- cloud

- kluster

- co2

- komma

- Företag

- företag

- jämfört

- konkurrera

- konkurrenskraftig

- Compute

- dator

- datorer

- databehandling

- Begreppen

- konferenser

- konsumera

- konsumtion

- fortsätta

- bidrog

- konversera

- konversations AI

- kyla

- Pris

- Kostar

- kunde

- skapa

- Aktuella

- Nuvarande tillstånd

- För närvarande

- beställnings

- kund

- Kunder

- skärning

- Cybersäkerhet

- datum

- datacenter

- Datacenter

- David

- dag

- Dagar

- Beslutet

- djup

- djupt lärande

- djupare

- Efterfrågan

- DEMOKRATISERA

- demokrati

- demonstreras

- densitet

- beroende

- Designa

- utveckla

- utvecklade

- utveckla

- Utveckling

- enheter

- Dhabi

- skilja

- flit

- riktning

- Direktör

- do

- gör

- gör

- dollar

- inte

- ner

- dr

- Drop

- grund

- intjänade

- kant

- effekter

- effektivitet

- effektiv

- effektivt

- el

- elförbrukning

- eliminera

- eliminerar

- känslor

- Empati

- energi

- energieffektivitet

- Teknik

- förbättra

- tillräckligt

- Hela

- inträde

- Miljö

- miljömässigt

- envision

- uppskatta

- beräknad

- etc

- Eter (ETH)

- Även

- så småningom

- Varje

- exempel

- verkställande

- Verkställande direktör

- existerar

- expertis

- exploderar

- förlängningar

- Ansikte

- vänd

- falk

- snabbare

- känsla

- fylla

- företag

- flytande

- fokuserade

- Fot

- För

- förutse

- format

- Förmögenhet

- fundament

- ramar

- från

- frystes

- fueled

- funktionella

- fundamentalt

- framtida

- Allmänt

- generationer

- generativ

- Generativ AI

- ges

- Go

- Går

- kommer

- god

- GPUs

- Grupp

- Odling

- Tillväxt

- hårdvara

- Har

- he

- därav

- här.

- Hög

- innehar

- värd

- Hur ser din drömresa ut

- HTTPS

- stor

- Kramar ansikte

- humant

- Mänskligheten

- IEEE

- if

- bild

- Inverkan

- förbättra

- förbättrar

- in

- I andra

- innefattar

- Öka

- industrin

- informationen

- förnya

- Innovation

- innovationer

- istället

- Institute

- Intel

- Intelligens

- Internationell

- Internet

- Intervju

- investering

- iot

- IT

- DESS

- bara

- barn

- Snäll

- Brist

- liggande

- språk

- bärbara datorer

- Large

- större

- leda

- Ledarskap

- LÄRA SIG

- inlärning

- Låt

- Hävstång

- hävstångs

- tycka om

- rampljuset

- BEGRÄNSA

- läsa in

- belägen

- se

- ser ut som

- lägre

- Maskiner

- Framställning

- Tillverkare

- många

- marknad

- Marknader

- Matris

- max-bredd

- Maj..

- kanske

- MBA

- me

- betyder

- betyder

- mäta

- Minnen

- nämnts

- kanske

- miljon

- miljoner dollar

- MIT

- modell

- modeller

- ögonblick

- monopol

- månader

- mer

- mest

- film

- rörliga

- MS

- måste

- my

- namn

- nämligen

- Natural

- Behöver

- nätverksbaserade

- nätverk

- neural

- Nya

- nyheter

- Nästa

- nisch

- natt

- vig

- nu

- nukleär

- Kärnkraft

- antal

- oceaner

- of

- on

- ONE

- endast

- öppet

- öppen källkod

- OpenAI

- Verksamhet

- möjligheter

- optimering

- Optimera

- Tillbehör

- or

- Övriga

- vår

- ut

- egen

- sida

- Parallell

- parameter

- parametrar

- reservdelar till din klassiker

- Patent

- Betala

- Personer

- kanske

- planet

- växter

- plattform

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- uppsjö

- plus

- fickor

- Punkt

- placera

- möjlig

- kraft

- kraftverk

- Praktisk

- Skriva ut

- privat

- Problem

- problem

- Produkt

- Produkter

- Profil

- Framsteg

- prompter

- skydda

- Syftet

- syfte

- Tryck

- Puts

- Qualcomm

- fråga

- frågor

- område

- rankad

- Läsa

- nyligen

- Rekommendation

- rekommendationer

- minska

- reducerande

- regelbunden

- Rapport

- begära

- forskning

- forskning och utveckling

- forskare

- höger

- Flodstrand

- roller

- Taket

- Körning

- rinnande

- kör

- säker

- Säkerhet

- Samma

- sanktioner

- sandlåda

- Save

- sparande

- säga

- skalning

- Vetenskap

- Sök

- Säsong

- sektor

- säkra

- se

- segment

- halvledare

- Halvledare

- Serier

- servrar

- service

- Tjänster

- portion

- Dela

- brist

- skall

- visade

- Visar

- sida

- signifikant

- eftersom

- mindre

- smartphone

- smartphones

- So

- Mjukvara

- Lösningar

- Lösa

- några

- Källa

- Utrymme

- specialiserad

- spent

- stanford

- starta

- Startups

- Ange

- Strategi

- starkaste

- sådana

- leverera

- stödja

- hållbart

- System

- tackla

- tackling

- skrädderi

- Ta

- Diskussion

- uppgifter

- Teknisk

- Teknologi

- teknikinnovation

- villkor

- text

- än

- den där

- Smakämnen

- Framtiden

- den information

- världen

- deras

- Dem

- sedan

- Där.

- vari

- Dessa

- de

- saker

- detta

- de

- fastän?

- Frodas

- tid

- till

- dagens

- tokens

- i morgon

- alltför

- topp

- kasta

- traditionell

- Tåg

- Utbildning

- transformator

- transformatorer

- Trender

- betrodd

- prova

- försöker

- under

- förstår

- universitet

- University of California

- osannolik

- us

- Användning

- användning

- Begagnade

- med hjälp av

- olika

- våga

- riskkapital

- riskkapitalföretag

- mycket

- av

- var

- Vatten

- Sätt..

- we

- webb

- Välfärd

- były

- Vad

- när

- som

- VEM

- varför

- kommer

- med

- utan

- Arbete

- arbetssätt

- världen

- skulle

- Fel

- år

- dig

- Din

- zephyrnet