Beskrivning

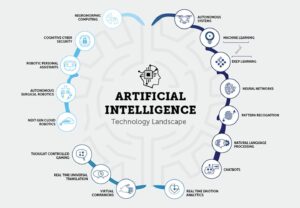

När området för artificiell intelligens (AI) fortsätter att växa och utvecklas, blir det allt viktigare för blivande AI-utvecklare att hålla sig uppdaterad med den senaste forskningen och framstegen. Ett av de bästa sätten att göra detta på är att läsa AI Papers för GenAI-utvecklare, som ger värdefulla insikter i banbrytande tekniker och algoritmer. Den här artikeln kommer att utforska 15 viktiga AI-dokument för GenAI-utvecklare. Dessa papper täcker olika ämnen, från naturlig språkbehandling till datorseende. De kommer att förbättra din förståelse för AI och öka dina chanser att få ditt första jobb inom detta spännande område.

Vikten av AI Papers för GenAI-utvecklare

AI Papers för GenAI-utvecklare låter forskare och experter dela sina resultat, metoder och genombrott med det bredare samhället. Genom att läsa dessa tidningar får du tillgång till de senaste framstegen inom AI, vilket gör att du kan ligga steget före och fatta välgrundade beslut i ditt arbete. Dessutom ger AI Papers for GenAI-utvecklare ofta detaljerade förklaringar av algoritmer och tekniker, vilket ger dig en djupare förståelse för hur de fungerar och hur de kan tillämpas på verkliga problem.

Att läsa AI Papers för GenAI-utvecklare erbjuder flera fördelar för blivande AI-utvecklare. För det första hjälper det dig att hålla dig uppdaterad med den senaste forskningen och trenderna inom området. Denna kunskap är avgörande när du söker AI-relaterade jobb, eftersom arbetsgivare ofta letar efter kandidater som är bekanta med de senaste framstegen. Genom att läsa AI-uppsatser kan du dessutom utöka dina kunskaper och få en djupare förståelse för AI-koncept och -metoder. Denna kunskap kan appliceras på dina projekt och forskning, vilket gör dig till en mer kompetent och skicklig AI-utvecklare.

Innehållsförteckning

En översikt: Essential AI Papers för GenAI-utvecklare med länkar

Papper 1: Transformers: Attention is All You Need

Länk: Läs här

Sammanfattning av papper

Uppsatsen introducerar Transformer, en ny neural nätverksarkitektur för sekvenstransduktionsuppgifter, såsom maskinöversättning. Till skillnad från traditionella modeller baserade på återkommande eller faltande neurala nätverk, förlitar sig Transformatorn enbart på uppmärksamhetsmekanismer, vilket eliminerar behovet av återkommande och faltningar. Författarna hävdar att denna arkitektur erbjuder överlägsen prestanda när det gäller översättningskvalitet, ökad parallelliserbarhet och minskad utbildningstid.

Viktiga insikter i AI Papers för GenAI-utvecklare

- Uppmärksamhetsmekanism

Transformatorn bygger helt på uppmärksamhetsmekanismer, vilket gör att den kan fånga globala beroenden mellan ingångs- och utdatasekvenser. Detta tillvägagångssätt gör det möjligt för modellen att överväga samband utan att begränsas av avståndet mellan element i sekvenserna.

- Parallellisering

En stor fördel med transformatorarkitekturen är dess ökade parallelliserbarhet. Traditionella återkommande modeller lider av sekventiell beräkning, vilket gör parallellisering utmanande. Transformatorns design möjliggör effektivare parallellbearbetning under träning, vilket minskar träningstiderna.

- Överlägsen kvalitet och effektivitet

Uppsatsen presenterar experimentella resultat om maskinöversättningsuppgifter, vilket visar att Transformer uppnår överlägsen översättningskvalitet jämfört med befintliga modeller. Den överträffar tidigare toppmoderna resultat, inklusive ensemblemodeller, med en betydande marginal. Dessutom uppnår transformatorn dessa resultat med betydligt mindre träningstid.

- Översättningsprestanda

På WMT 2014 engelsk-till-tyska översättningsuppgiften uppnår den föreslagna modellen ett BLEU-poäng på 28.4, vilket överträffar befintliga bästa resultat med över 2 BLEU. När det gäller uppgiften engelsk-till-franska, etablerar modellen ett nytt toppmodernt BLEU-poäng på 41.8 för en enda modell efter att ha tränat i endast 3.5 dagar på åtta GPU:er.

- Generalisering till andra uppgifterFörfattarna visar att transformatorarkitekturen generaliserar väl till uppgifter bortom maskinöversättning. De tillämpar framgångsrikt modellen på engelsk valkretsanalys, vilket visar dess anpassningsförmåga till olika sekvenstransduktionsproblem.

Uppsats 2: BERT: Förträning av djupa dubbelriktade transformatorer för språkförståelse

Länk: Läs här

Sammanfattning av papper

Språkmodellförträning har visat sig vara effektiv för att förbättra olika naturliga språkbehandlingsuppgifter. Uppsatsen skiljer mellan funktionsbaserade och finjusterande metoder för att tillämpa förtränade språkrepresentationer. BERT introduceras för att ta itu med begränsningar i finjusteringsmetoder, särskilt enkelriktad begränsning av standardspråkmodeller. Uppsatsen föreslår ett "Masked Language Model" (MLM) förträningsmål, inspirerat av Cloze-uppgiften, för att möjliggöra dubbelriktade representationer. En uppgift för "förutsägelse av nästa mening" används också för att gemensamt förträna representationer av textpar.

Viktiga insikter i AI Papers för GenAI-utvecklare

- Dubbelriktad förträningsvikt

Uppsatsen betonar betydelsen av dubbelriktad förträning för språkrepresentationer. Till skillnad från tidigare modeller, använder BERT maskerade språkmodeller för att möjliggöra djupa dubbelriktade representationer, som överträffar enkelriktade språkmodeller som används av tidigare verk.

- Minskning av uppgiftsspecifika arkitekturer

BERT visar att förutbildade representationer minskar behovet av tungt konstruerade uppgiftsspecifika arkitekturer. Det blir den första finjusteringsbaserade representationsmodellen som uppnår toppmodern prestanda över en mängd olika uppgifter på meningsnivå och tokennivå, vilket överträffar uppgiftsspecifika arkitekturer.

- State-of-the-art framsteg

BERT uppnår nya toppmoderna resultat på elva naturliga språkbehandlingsuppgifter, vilket visar upp dess mångsidighet. Anmärkningsvärda förbättringar inkluderar en avsevärd ökning av GLUE-poängen, MultiNLI-noggrannhet och förbättringar i SQuAD v1.1 och v2.0 frågesvarsuppgifter.

Du kan också läsa: Finjustera BERT med maskerad språkmodellering

Uppsats 3: GPT: Språkmodeller är fåskjutna elever

Länk: Läs här

Sammanfattning av papper

Uppsatsen diskuterar de förbättringar som uppnåtts i naturliga språkbehandlingsuppgifter (NLP) genom att skala upp språkmodeller, med fokus på GPT-3 (Generative Pre-trained Transformer 3), en autoregressiv språkmodell med 175 miljarder parametrar. Författarna lyfter fram det medan det är nyligen NLP-modeller visar betydande vinster genom förträning och finjustering kräver de ofta uppgiftsspecifika datauppsättningar med tusentals exempel för finjustering. Däremot kan människor utföra nya språkuppgifter med få exempel eller enkla instruktioner.

Viktiga insikter i AI Papers för GenAI-utvecklare

- Uppskalning förbättrar Few-Shot-prestandan

Författarna visar att uppskalning av språkmodeller avsevärt förbättrar uppgifts-agnostisk prestanda med få skott. GPT-3, med sin stora parameterstorlek, uppnår ibland konkurrenskraft med toppmoderna finjusteringsmetoder utan uppgiftsspecifika finjusteringar eller gradientuppdateringar.

- Bred tillämplighet

GPT-3 uppvisar stark prestanda för olika NLP-uppgifter, inklusive översättning, frågesvar, cloze-uppgifter och uppgifter som kräver resonemang i farten eller domänanpassning. - Utmaningar och begränsningar

Medan GPT-3 visar anmärkningsvärda få-shot inlärningsförmåga, identifierar författarna datamängder där det kämpar och lyfter fram metodologiska frågor relaterade till utbildning på stora webbkorpora. - Människoliknande artikelgenerering

GPT-3 kan generera nyhetsartiklar som mänskliga utvärderare har svårt att skilja från artiklar skrivna av människor. - Samhällspåverkan och bredare överväganden

Artikeln diskuterar de bredare samhälleliga effekterna av GPT-3:s kapacitet, särskilt när det gäller att generera människoliknande text. Implikationerna av dess prestation i olika uppgifter beaktas i termer av praktiska tillämpningar och potentiella utmaningar. - Begränsningar för nuvarande NLP-metoder

Författarna lyfter fram begränsningarna med nuvarande NLP-metoder, särskilt deras beroende av uppgiftsspecifika finjusteringsdatauppsättningar, vilket innebär utmaningar såsom kravet på stora märkta datauppsättningar och risken för överanpassning till smala uppgiftsfördelningar. Dessutom uppstår oro angående generaliseringsförmågan hos dessa modeller utanför gränserna för deras utbildningsdistribution.

Artikel 4: CNN:er: ImageNet Classification with Deep Convolutional Neural Networks

Länk: Läs här

Sammanfattning av papper

Uppsatsen beskriver utveckling och utbildning av ett stort, djupt konvolutionellt neuralt nätverk (CNN) för bildklassificering på ImageNet Large Scale Visual Recognition Challenge (ILSVRC) datamängder. Modellen uppnår betydande förbättringar i klassificeringsnoggrannhet jämfört med tidigare state-of-the-art metoder.

Viktiga insikter i AI Papers för GenAI-utvecklare

- Modellarkitektur

Det neurala nätverk som används i studien är ett djupt CNN med 60 miljoner parametrar och 650,000 1000 neuroner. Den består av fem faltningslager, några följt av maxpoolande lager, och tre helt sammankopplade lager med en slutlig XNUMX-vägs softmax för klassificering.

- Utbildningsdata

Modellen är tränad på en betydande datauppsättning av 1.2 miljoner högupplösta bilder från ImageNet ILSVRC-2010-tävlingen. Utbildningsprocessen går ut på att klassificera bilder i 1000 olika klasser.

- prestanda

Modellen uppnår topp-1 och topp-5 felfrekvenser på 37.5 % respektive 17.0 % på testdata. Dessa felfrekvenser är avsevärt bättre än den tidigare senaste tekniken, vilket indikerar effektiviteten hos den föreslagna metoden.

- Förbättringar i övermontering

Uppsatsen introducerar flera tekniker för att ta itu med överanpassningsproblem, inklusive icke-mättande neuroner, effektiv GPU-implementering för snabbare träning och en regleringsmetod som kallas "dropout" i helt anslutna lager. - Beräkningseffektivitet

Trots beräkningskraven för att träna stora CNN:er, noterar tidningen att nuvarande GPU:er och optimerade implementeringar gör det möjligt att träna sådana modeller på högupplösta bilder.

- Bidrag

Uppsatsen belyser studiens bidrag, inklusive att träna ett av de största konvolutionella neurala nätverken på ImageNet-datauppsättningar och att uppnå toppmoderna resultat i ILSVRC-tävlingar.

Du kan också läsa: En omfattande handledning för att lära dig Convolutional Neural Networks

Artikel 5: GAT:er: Graph Attention Networks

Länk: Läs här

Sammanfattning av papper

Uppsatsen introducerar en uppmärksamhetsbaserad arkitektur för nodklassificering i grafstrukturerade data, som visar dess effektivitet, mångsidighet och konkurrenskraftiga prestanda över olika riktmärken. Införandet av uppmärksamhetsmekanismer visar sig vara ett kraftfullt verktyg för att hantera godtyckligt strukturerade grafer.

Viktiga insikter i AI Papers för GenAI-utvecklare

- Graph Attention Networks (GAT)GAT:er utnyttjar maskerade självuppmärksamma lager för att hantera begränsningar i tidigare metoder baserade på graffalsningar. Arkitekturen tillåter noder att övervaka sina grannskapsegenskaper, implicit specificerar olika vikter till olika noder utan att förlita sig på kostsamma matrisoperationer eller a priori kunskap om grafstrukturen.

- Ta itu med spektralbaserade utmaningar

GAT:er hanterar samtidigt flera utmaningar i spektralbaserade grafiska neurala nätverk. Graph Attention Network (GAT)-utmaningar involverar rumsligt lokaliserade filter, intensiva beräkningar och icke-spatialt lokaliserade filter. Dessutom beror GAT på den Laplacian egenbasen, vilket bidrar till deras tillämpbarhet på induktiva och transduktiva problem.

- Prestanda över benchmarks

GAT-modeller uppnår eller matchar toppmoderna resultat över fyra etablerade grafiska riktmärken: Cora, Citeseer och Pubmed citeringsnätverksdatauppsättningar, såväl som en protein-proteininteraktionsdatauppsättning. Dessa riktmärken täcker både transduktiva och induktiva inlärningsscenarier, och visar GAT:s mångsidighet.

- Jämförelse med tidigare tillvägagångssätt

Uppsatsen ger en omfattande översikt av tidigare tillvägagångssätt, inklusive rekursiva neurala nätverk, Graf Neurala nätverk (GNN), spektrala och icke-spektrala metoder och uppmärksamhetsmekanismer. GAT:er innehåller uppmärksamhetsmekanismer, vilket möjliggör effektiv parallellisering över nod-grannpar och tillämpning på noder med olika grader.

- Effektivitet och tillämpbarhetGAT erbjuder en parallelliserbar, effektiv operation som kan tillämpas på grafiska noder med olika grader genom att specificera godtyckliga vikter till grannar. Modellen gäller direkt för induktiva inlärningsproblem, vilket gör den lämplig för uppgifter där den behöver generaliseras till helt osynliga grafer.

- Relation till tidigare modeller

Författarna noterar att GAT:er kan omformuleras som en speciell instans av MoNet, dela likheter med relationsnätverk och ansluta till verk som använder grannskapsåtgärder. Den föreslagna uppmärksamhetsmodellen jämförs med relaterade tillvägagångssätt som Duan et al. (2017) och Denil et al. (2017).

Uppsats 6: ViT: En bild är värd 16×16 ord: Transformers för bildigenkänning i skala

Länk: Läs här

Sammanfattning av papper

Uppsatsen erkänner dominansen av konvolutionella arkitekturer i datorseende trots framgångarna med Transformer-arkitekturer i naturlig språkbehandling. Inspirerade av transformatorers effektivitet och skalbarhet i NLP, applicerade författarna en standardtransformator direkt på bilder med minimala modifieringar.

De introducerar Vision Transformer (ViT), där bilder är uppdelade i patchar, och sekvensen av linjära inbäddningar av dessa patchar fungerar som indata till transformatorn. Modellen tränas på bildklassificeringsuppgifter på ett övervakat sätt. Inledningsvis, när den tränas på medelstora datamängder som ImageNet utan stark regularisering, uppnår ViT noggrannheter något under jämförbara ResNets.

Författarna avslöjar dock att storskalig träning är avgörande för ViT:s framgång, och överträffar de begränsningar som avsaknaden av vissa induktiva fördomar innebär. När ViT är förtränad i massiva datamängder, överträffar det toppmoderna konvolutionella nätverk på flera riktmärken, inklusive ImageNet, CIFAR-100 och VTAB. Uppsatsen understryker effekten av skalning för att uppnå anmärkningsvärda resultat med Transformer-arkitekturer i datorseende.

Viktiga insikter i AI Papers för GenAI-utvecklare

- Transformator i datorseende

Uppsatsen utmanar det rådande beroendet av konvolutionella neurala nätverk (CNN) för datorseende uppgifter. Det visar att en ren transformator, när den appliceras direkt på sekvenser av bildlappar, kan uppnå utmärkta prestanda i bildklassificeringsuppgifter.

- Vision Transformer (ViT)

Författarna introducerar Vision Transformer (ViT), en modell som använder sig av självuppmärksamhetsmekanismer som liknar Transformers i NLP. ViT kan uppnå konkurrenskraftiga resultat på olika riktmärken för bildigenkänning, inklusive ImageNet, CIFAR-100 och VTAB.

- Pre-training och Transfer Learning

Uppsatsen betonar vikten av att förträna på stora mängder data, liknande tillvägagångssättet i NLP, och sedan överföra de inlärda representationerna till specifika bildigenkänningsuppgifter. ViT, när den är förtränad på massiva datamängder som ImageNet-21k eller JFT-300M, överträffar toppmoderna konvolutionella nätverk på olika riktmärken.

- BeräkningseffektivitetViT uppnår anmärkningsvärda resultat med betydligt mindre beräkningsresurser under utbildningen än toppmoderna konvolutionella nätverk. Denna effektivitet är särskilt anmärkningsvärd när modellen är förtränad i stor skala.

- Skalningspåverkan

Uppsatsen belyser betydelsen av skalning för att uppnå överlägsen prestanda med Transformer-arkitekturer i datorseende. Storskalig utbildning på datauppsättningar som innehåller miljoner till hundratals miljoner bilder hjälper ViT att övervinna bristen på vissa induktiva fördomar som finns i CNN.

Artikel 7: AlphaFold2: Mycket exakt proteinstruktur med AlphaFold

Länk: Läs här

Sammanfattning av papper

Uppsatsen "AlphaFold2: Mycket exakt proteinstruktur med AlphaFold" introducerar AlphaFold2, en djupinlärningsmodell som exakt förutsäger proteinstrukturer. AlphaFold2 utnyttjar en ny uppmärksamhetsbaserad arkitektur och uppnår ett genombrott inom proteinveckning.

Viktiga insikter i AI Papers för GenAI-utvecklare

- AlphaFold2 använder ett djupt neuralt nätverk med uppmärksamhetsmekanismer för att förutsäga 3D-strukturen hos proteiner från deras aminosyrasekvenser.

- Modellen tränades på ett stort dataset av kända proteinstrukturer och uppnådde oöverträffad noggrannhet i den 14:e Critical Assessment of Protein Structure Prediction (CASP14) proteinveckningstävlingen.

- AlphaFold2:s exakta förutsägelser kan potentiellt revolutionera läkemedelsupptäckten, proteinteknik och andra områden inom biokemin.

Artikel 8: GAN: Generative Adversarial Nets

Länk: Läs här

Sammanfattning av papper

Uppsatsen tar upp utmaningarna med att träna djupa generativa modeller och introducerar ett innovativt tillvägagångssätt som kallas motstridiga nät. Inom detta ramverk deltar generativa och diskriminerande modeller i ett spel där den generativa modellen syftar till att producera prover som inte kan skiljas från verkliga data. Däremot skiljer den diskriminerande modellen mellan verkliga och genererade sampel. Den kontradiktoriska utbildningsprocessen leder till en unik lösning, där den generativa modellen återställer datadistributionen.

Viktiga insikter i AI Papers för GenAI-utvecklare

- Motstridiga ramar

Författarna introducerar ett kontradiktoriskt ramverk där två modeller tränas samtidigt - en generativ modell (G) som fångar datafördelningen och en diskriminerande modell (D) som uppskattar sannolikheten att ett urval kom från träningsdata snarare än den generativa modellen.

- Minimax spelUtbildningsproceduren innebär att maximera sannolikheten för att den diskriminerande modellen gör ett misstag. Detta ramverk är formulerat som ett minimaxspel för två spelare, där den generativa modellen syftar till att generera prover som inte kan särskiljas från verklig data, och den diskriminerande modellen syftar till att klassificera om ett prov är verkligt eller genererat korrekt.

- Unik lösning

En unik lösning finns i godtyckliga funktioner för G och D, där G återställer träningsdatafördelningen och D är lika med 1/2 överallt. Denna jämvikt uppnås genom den kontradiktoriska träningsprocessen.

- Multilayer Perceptrons (MLP)Författarna visar att hela systemet kan tränas med hjälp av backpropagation när flerskiktsperceptroner representerar G och D. Detta eliminerar behovet av Markov-kedjor eller utrullade ungefärliga slutledningsnätverk under träning och generering av prover.

- Ingen ungefärlig slutsats

Det föreslagna ramverket undviker svårigheterna att approximera svårhanterliga probabilistiska beräkningar i maximal sannolikhetsuppskattning. Det övervinner också utmaningar med att utnyttja fördelarna med bitvis linjära enheter i det generativa sammanhanget.

Uppsats 9: Roberta: En robust optimerad BERT-förträningsmetod

Länk: Läs här

Sammanfattning av papper

Tidningen tar upp BERT:s underutbildningsfråga och introducerar RoBERTa, en optimerad version som överträffar BERT:s prestanda. Ändringarna i RoBERTas utbildningsprocedur och användningen av en ny datauppsättning (CC-NEWS) bidrar till toppmoderna resultat för flera naturliga språkbehandlingsuppgifter. Resultaten betonar vikten av designval och träningsstrategier för effektiviteten av förträning av språkmodeller. De frigjorda resurserna, inklusive RobERTa-modellen och koden, bidrar till forskarsamhället.

Viktiga insikter i AI Papers för GenAI-utvecklare

- BERT Underträning

Det finner författarna BERTI, en flitigt använd språkmodell, var betydligt undertränad. Genom att noggrant utvärdera effekten av hyperparameterjustering och träningsuppsättningsstorlek visar de att BERT kan förbättras för att matcha eller överträffa prestandan för alla modeller som publicerats efter det.

- Förbättrat träningsrecept (RoBERTa)

Författarna introducerar modifieringar av BERT-utbildningsproceduren, vilket ger RobERTa. Dessa förändringar innebär förlängda träningsperioder med större partier, eliminering av nästa meningsförutsägelsemål, träning i längre sekvenser och dynamiska maskeringsmönsterjusteringar för träningsdata.

- DatauppsättningsbidragTidningen introducerar en ny datauppsättning som kallas CC-NEWS, som är jämförbar i storlek med andra privata datauppsättningar. Att inkludera denna datauppsättning hjälper till att bättre kontrollera effekterna av träningsuppsättningens storlek och bidrar till förbättrad prestanda på nedströmsuppgifter.

- Prestandaprestationer

Roberta, med de föreslagna ändringarna, uppnår toppmoderna resultat på olika benchmarkuppgifter, inklusive GLUE, RACE och SQuAD. Den matchar eller överträffar prestandan för alla post-BERT-metoder för uppgifter som MNLI, QNLI, RTE, STS-B, SQuAD och RACE.

- Förträning av maskerad språkmodells konkurrenskraft

Uppsatsen bekräftar att det maskerade språkmodellens förträningsmål, med rätt designval, är konkurrenskraftigt med andra nyligen föreslagna utbildningsmål.

- Utgivna resurser

Författarna släpper sin RoBERTa-modell, tillsammans med förträning och finjusteringskod implementerad i PyTorch, vilket bidrar till reproducerbarheten och ytterligare utforskning av deras resultat.

Läs också: En mild introduktion till Roberta

Uppsats 10: NeRF: Att representera scener som neurala strålningsfält för synsyntes

Länk: Läs här

Sammanfattning av papper

Optimering innebär att minimera felet mellan observerade bilder med kända kamerapositioner och vyerna som återges från den kontinuerliga scenrepresentationen. Uppsatsen tar upp utmaningar relaterade till konvergens och effektivitet genom att introducera positionell kodning för att hantera högre frekvensfunktioner och föreslå en hierarkisk samplingsprocedur för att minska antalet frågor som behövs för adekvat sampling.

Nyckelinsikter i AI Papers för GenAI-utvecklare

- Kontinuerlig scenrepresentation

Uppsatsen presenterar en metod för att representera komplexa scener som 5D neurala strålningsfält med hjälp av grundläggande multilayer perceptron (MLP) nätverk.

- Differentierbar rendering

Det föreslagna renderingsförfarandet är baserat på klassiska volymrenderingstekniker, vilket möjliggör gradientbaserad optimering med vanliga RGB-bilder.

- Hierarkisk urvalsstrategi

En hierarkisk samplingsstrategi införs för att optimera MLP-kapaciteten mot områden med synligt sceninnehåll, för att ta itu med konvergensproblem.

- Positionell kodningAnvändning av positionell kodning för att kartlägga inmatade 5D-koordinater till ett högre dimensionellt utrymme möjliggör framgångsrik optimering av neurala strålningsfält för högfrekvent sceninnehåll.

Den föreslagna metoden överträffar state-of-the-art syntetiseringsmetoder, inklusive anpassning av neurala 3D-representationer och träning av djupa faltningsnätverk. Den här artikeln introducerar en kontinuerlig neural scenrepresentation för att återge högupplösta fotorealistiska nya vyer från RGB-bilder i naturliga miljöer, med ytterligare jämförelser som visas i den kompletterande videon för att belysa dess effektivitet när det gäller att hantera komplex scengeometri och utseende.

Uppsats 11: FunSearch: Matematiska upptäckter från programsökning med stora språkmodeller

Länk: Läs här

Sammanfattning av papper

Uppsatsen introducerar FunSearch, en ny metod för att utnyttja stora språkmodeller (LLM) för att lösa komplexa problem, särskilt inom vetenskaplig upptäckt. Den primära utmaningen som tas upp är förekomsten av konfabulationer (hallucinationer) i LLM, vilket leder till rimliga men felaktiga påståenden. FunSearch kombinerar en förutbildad LLM med en systematisk utvärderare i en evolutionär procedur för att övervinna denna begränsning.

Viktiga insikter i AI Papers för GenAI-utvecklare

- Problemlösning med LLM

Uppsatsen tar upp frågan om LLM:s konfabulerande eller misslyckas med att generera nya idéer och korrekta lösningar för komplexa problem. Den betonar vikten av att hitta nya, verifierbart korrekta idéer, särskilt för matematiska och vetenskapliga utmaningar.

- Evolutionär procedur – FunSearch

FunSearch kombinerar en förutbildad LLM med en utvärderare i en evolutionär process. Det utvecklar iterativt program med låga poäng till höga poäng, vilket säkerställer upptäckten av ny kunskap. Processen innefattar best-shot prompting, utvecklande programskelett, upprätthålla programdiversitet och skala asynkront.

- Tillämpning på Extremal Combinatorics

Uppsatsen demonstrerar effektiviteten av FunSearch på problem med capset i extrem kombinatorik. FunSearch upptäcker nya konstruktioner av stora set, som överträffar de mest kända resultaten och ger den största förbättringen på 20 år av den asymptotiska nedre gränsen.

- Algoritmiskt problem – Online Bin Packing

FunSearch tillämpas på problemet med att packa papperskorgen online, vilket leder till upptäckten av nya algoritmer som överträffar traditionella på välstuderade intressefördelningar. De potentiella applikationerna inkluderar förbättring av jobbschemaläggningsalgoritmer.

- Program kontra lösningarFunSearch fokuserar på att skapa program som beskriver hur man löser ett problem snarare än att direkt mata ut lösningar. Dessa program tenderar att vara mer tolkbara, underlätta interaktioner med domänexperter och är lättare att distribuera än andra typer av beskrivningar, såsom neurala nätverk.

- Tvärvetenskaplig påverkan

FunSearchs metodik gör det möjligt att utforska ett brett spektrum av problem, vilket gör det till ett mångsidigt tillvägagångssätt med tvärvetenskapliga tillämpningar. Uppsatsen belyser dess potential för att göra verifierbara vetenskapliga upptäckter med hjälp av LLM.

Artikel 12: VAE: Auto-encoding Variational Bayes

Länk: Läs här

Sammanfattning av papper

Uppsatsen "Auto-Encoding Variational Bayes" tar upp utmaningen med effektiv slutledning och inlärning i riktade probabilistiska modeller med kontinuerliga latenta variabler, särskilt när de bakre fördelningarna är svårhanterliga och har att göra med stora datamängder. Författarna föreslår en stokastisk variationsinferens och inlärningsalgoritm som skalas väl för stora datamängder och förblir tillämpbar även i svårlösta bakre distributioner.

Viktiga insikter i AI Papers för GenAI-utvecklare

- Omparametrisering av Variationell Nedre gräns

Uppsatsen demonstrerar en omparametrisering av den variationsmässiga nedre gränsen, vilket resulterar i en estimator för lägre gräns. Denna estimator är mottaglig för optimering med standardmetoder för stokastiska gradienter, vilket gör den beräkningseffektiv.

- Effektiv bakre slutledning för kontinuerliga latenta variablerFörfattarna föreslår algoritmen Auto-Encoding VB (AEVB) för datauppsättningar med kontinuerliga latenta variabler per datapunkt. Denna algoritm använder SGVB-estimatorn (Stochastic Gradient Variational Bayes) för att optimera en igenkänningsmodell, vilket möjliggör effektiv ungefärlig bakre inferens genom förfädersprovtagning. Detta tillvägagångssätt undviker dyra iterativa slutledningsscheman som Markov Chain Monte Carlo (MCMC) för varje datapunkt.

- Teoretiska fördelar och experimentella resultat

De teoretiska fördelarna med den föreslagna metoden återspeglas i de experimentella resultaten. Uppsatsen föreslår att omparametriserings- och igenkänningsmodellen leder till beräkningseffektivitet och skalbarhet, vilket gör tillvägagångssättet tillämpbart på stora datamängder och i situationer där den bakre delen är svårhanterlig.

Läs också: Avslöjar essensen av Stokastiskt i maskininlärning

Papper 13: LÅNGT KORTTIDSMINNE

Länk: Läs här

Sammanfattning av papper

Uppsatsen tar upp utmaningen att lära sig att lagra information över längre tidsintervall i återkommande neurala nätverk. Den introducerar en ny, effektiv gradientbaserad metod som kallas "Long Short-Term Memory" (LSTM), som övervinner otillräckliga och sönderfallande problem med bakflödesfel. LSTM tvingar fram konstant felflöde genom "konstanta felkaruseller" och använder multiplikativa grindenheter för att kontrollera åtkomst. Med lokal rymd-tidskomplexitet (O(1) per tidssteg och vikt) visar experimentella resultat att LSTM överträffar befintliga algoritmer när det gäller inlärningshastighet och framgångsfrekvens, särskilt för uppgifter med långa tidsfördröjningar.

Viktiga insikter i AI Papers för GenAI-utvecklare

- Problemanalys

Uppsatsen ger en detaljerad analys av de utmaningar som är förknippade med felåterflöde i återkommande neurala nätverk, och belyser problemen med felsignaler som antingen exploderar eller försvinner med tiden.

- Introduktion av LSTM

Författarna introducerar LSTM som en ny arkitektur utformad för att ta itu med problemen med försvinnande och exploderande felsignaler. LSTM inkorporerar konstant felflöde genom specialiserade enheter och använder multiplikativa grindenheter för att reglera åtkomst till detta felflöde.

- Experimentella resultat

Genom experiment med artificiell data visar uppsatsen att LSTM överträffar andra återkommande nätverksalgoritmer, inklusive BPTT, RTRL, Recurrent caskad-korrelation, Elman-nät och Neural Sequence Chunking. LSTM visar snabbare inlärning och högre framgångsfrekvens, särskilt när det gäller att lösa komplexa uppgifter med långa fördröjningar.

- Lokal i tid och rum

LSTM beskrivs som en lokal arkitektur i rum och tid, där beräkningskomplexitet per tidssteg och vikt är O(1).

- Tillämplighet

Den föreslagna LSTM-arkitekturen löser effektivt komplexa, konstgjorda långtidsfördröjningsuppgifter som inte framgångsrikt hanteras av tidigare återkommande nätverksalgoritmer.

- Begränsningar och fördelar

Artikeln diskuterar begränsningarna och fördelarna med LSTM, vilket ger insikter i den föreslagna arkitekturens praktiska tillämpbarhet.

Läs också: Vad är LSTM? Introduktion till långtidsminne

Uppsats 14: Lär dig överförbara visuella modeller från övervakning av naturligt språk

Länk: Läs här

Sammanfattning av papper

Uppsatsen utforskar utbildning av state-of-the-art datorseende system genom att direkt lära sig från rå text om bilder snarare än att förlita sig på fasta uppsättningar av förutbestämda objektkategorier. Författarna föreslår en förträningsuppgift att förutsäga vilken bildtext som motsvarar en given bild, med hjälp av en datauppsättning av 400 miljoner (bild, text) par som samlats in från internet. Den resulterande modellen, CLIP (Contrastive Language-Image Pre-training), demonstrerar effektiv och skalbar inlärning av bildrepresentationer. Efter förträning refererar naturligt språk till visuella koncept, vilket möjliggör noll-shot-överföring till olika nedströmsuppgifter. CLIP är benchmarkad på över 30 datauppsättningar för datorseende, som visar upp konkurrenskraftiga prestanda utan uppgiftsspecifik utbildning.

Viktiga insikter i AI Papers för GenAI-utvecklare

- Utbildning i naturligt språk för datorseende

Uppsatsen utforskar användningen av naturligt språkövervakning för att träna datorseendemodeller istället för den traditionella träningsmetoden på publikmärkta datamängder som ImageNet.

- FörträningsuppgiftFörfattarna föreslår en enkel förträningsuppgift: att förutsäga vilken bildtext som motsvarar en given bild. Den här uppgiften används för att lära sig toppmoderna bildrepresentationer från grunden på en massiv datauppsättning av 400 miljoner (bild, text) par som samlats in online.

- Zero-Shot Transfer

Efter förträning använder modellen naturligt språk för att referera till inlärda visuella begrepp eller beskriva nya. Detta möjliggör noll-shot-överföring av modellen till nedströmsuppgifter utan att kräva specifik datauppsättningsträning.

- Benchmarking på olika uppgifter

Uppsatsen utvärderar prestandan för det föreslagna tillvägagångssättet på över 30 olika datauppsättningar för datorseende, som täcker uppgifter som OCR, åtgärdsigenkänning i videor, geolokalisering och finkornig objektklassificering.

- Konkurrenskraftig prestation

Modellen visar konkurrenskraftiga prestanda med fullt övervakade baslinjer för olika uppgifter, ofta matchande eller överträffande noggrannheten hos modeller som tränats på uppgiftsspecifika datauppsättningar utan ytterligare datauppsättningsspecifik utbildning.

- Skalbarhetsstudie

Författarna studerar skalbarheten av deras tillvägagångssätt genom att träna en serie om åtta modeller med olika nivåer av beräkningsresurser. Överföringsprestandan har visat sig vara en smidigt förutsägbar funktion av beräkningar.

- Modell Robusthet

Artikeln understryker att CLIP-modeller med nollbilder är mer robusta än övervakade ImageNet-modeller med likvärdig noggrannhet, vilket tyder på att nollbildsutvärdering av uppgifts-agnostiska modeller ger ett mer representativt mått på en modells förmåga.

Uppsats 15: LORA: LÅGRANKAD ANPASSNING AV STORA SPRÅKMODELLER

Länk: Läs här

Sammanfattning av papper

Uppsatsen föreslår LoRA som en effektiv metod för att anpassa stora förtränade språkmodeller till specifika uppgifter, för att ta itu med implementeringsutmaningar i samband med deras ökande storlek. Metoden minskar avsevärt träningsbara parametrar och GPU-minneskrav samtidigt som den bibehåller eller förbättrar modellkvaliteten över olika riktmärken. Implementeringen av öppen källkod underlättar ytterligare antagandet av LoRA i praktiska tillämpningar.

Viktiga insikter i AI Papers för GenAI-utvecklare

1. Problemdeklaration

- Storskalig förträning följt av finjustering är ett vanligt tillvägagångssätt inom naturlig språkbehandling.

- Finjustering blir mindre genomförbar när modellerna växer sig större, särskilt när man använder modeller med enorma parametrar, som GPT-3 (175 miljarder parametrar).

2. Föreslagen lösning: Low-Rank Adaptation (LoRA)

- Uppsatsen introducerar LoRA, en metod som fryser förtränade modellvikter och introducerar träningsbara ranknedbrytningsmatriser i varje lager av transformatorarkitekturen.

- LoRA minskar avsevärt antalet träningsbara parametrar för nedströmsuppgifter jämfört med full finjustering.

3. Fördelar med LoRA

- Parameterminskning: Jämfört med finjustering kan LoRA minska antalet inlärningsbara parametrar med upp till 10,000 XNUMX gånger, vilket gör det beräkningsmässigt mer effektivt.

- Minneseffektivitet: LoRA minskar GPU-minneskraven med upp till 3 gånger jämfört med finjustering.

- Modellkvalitet: Trots färre träningsbara parametrar presterar LoRA i paritet eller bättre än finjustering när det gäller modellkvalitet på olika modeller, inklusive RoBERTa, DeBERTa, GPT-2 och GPT-3.

4. Att övervinna implementeringsutmaningar

- Uppsatsen tar upp utmaningen med att distribuera modeller med många parametrar genom att introducera LoRA, vilket möjliggör effektiv uppgiftsbyte utan att omskola hela modellen.

5. Effektivitet och låg slutledningsfördröjning

- LoRA underlättar delning av en förutbildad modell för att bygga flera LoRA-moduler för olika uppgifter, vilket minskar lagringskraven och överkostnader för uppgiftsbyte.

- Utbildningen effektiviseras, vilket sänker hårdvarubarriären för inträde med upp till 3 gånger när du använder adaptiva optimerare.

6. Kompatibilitet och integration

- LoRA är kompatibel med olika tidigare metoder och kan kombineras med dem, såsom prefix-tuning.

- Den föreslagna linjära designen tillåter sammanslagning av träningsbara matriser med frusna vikter under driftsättning, vilket inte introducerar någon ytterligare slutledningsfördröjning jämfört med helt finjusterade modeller.

7. Empirisk undersökning

- Uppsatsen inkluderar en empirisk undersökning av rangbrist i språkmodellanpassning, vilket ger insikter om effektiviteten av LoRA-metoden.

8. Implementering med öppen källkod

- Författarna tillhandahåller ett paket som underlättar integrationen av LoRA med PyTorch-modeller och releaseimplementationer och modellkontrollpunkter för RoBERTa, DeBERTa och GPT-2.

Du kan också läsa: Parametereffektiv finjustering av stora språkmodeller med LoRA och QLoRA

Slutsats

Sammanfattningsvis är att fördjupa sig i de 15 viktiga AI-dokumenten för GenAI-utvecklare som lyfts fram i den här artikeln inte bara en rekommendation utan ett strategiskt krav för alla blivande utvecklare. Dessa AI-papper erbjuder en omfattande resa genom artificiell intelligenss mångsidiga landskap, som spänner över kritiska domäner som naturlig språkbehandling, datorseende och mer. Genom att fördjupa sig i de insikter och innovationer som presenteras i dessa uppsatser får utvecklare en djupgående förståelse för fältets banbrytande tekniker och algoritmer.

Relaterad

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://www.analyticsvidhya.com/blog/2024/01/essential-ai-papers-every-gen-ai-developer-must-read/

- : har

- :är

- :inte

- :var

- $UPP

- 000

- 1

- 10

- 11

- 12

- 13

- 14

- 15%

- 17

- 20

- 20 år

- 2014

- 2017

- 28

- 30

- 3d

- 400

- 41

- 60

- 7

- 8

- 9

- 913

- a

- förmåga

- Om oss

- AC

- tillgång

- noggrannhet

- exakt

- exakt

- Uppnå

- uppnås

- uppnår

- uppnå

- tvärs

- Handling

- anpassning

- adaptiv

- Annat

- Dessutom

- adress

- adresserad

- adresser

- adresse

- justeringar

- Antagande

- framsteg

- Fördel

- fördelar

- kontradiktoriskt

- Efter

- framåt

- AI

- Syftet

- AL

- algoritm

- algoritmer

- Alla

- tillåter

- tillåta

- tillåter

- längs

- också

- mängder

- an

- analys

- och

- vilken som helst

- tillämplig

- Ansökan

- tillämpningar

- tillämpas

- applicerar

- Ansök

- Tillämpa

- tillvägagångssätt

- tillvägagångssätt

- ungefärlig

- arkitektur

- ÄR

- områden

- argumenterar

- stiga upp

- Artikeln

- artiklar

- konstgjord

- artificiell intelligens

- Konstgjord intelligens (AI)

- AS

- blivande

- bedömning

- associerad

- At

- förväntat

- uppmärksamhet

- Författarna

- barriär

- baserat

- grundläggande

- BE

- blir

- Där vi får lov att vara utan att konstant prestera,

- nedan

- riktmärke

- riktmärke

- riktmärken

- Fördelarna

- BÄST

- Bättre

- mellan

- Bortom

- förspänner

- Miljarder

- SOPTUNNA

- lyft

- båda

- bunden

- genombrott

- genombrott

- bredare

- Byggnad

- byggt

- men

- by

- kallas

- kom

- rum

- KAN

- kandidater

- lock

- kapacitet

- kapacitet

- Kapacitet

- fånga

- fångar

- försiktigt

- vattenfall

- kategorier

- vissa

- kedja

- kedjor

- utmanar

- utmaningar

- utmanande

- chanser

- Förändringar

- val

- klasser

- klassificering

- klassificera

- CNN

- koda

- kombinerad

- kombinerar

- Gemensam

- samfundet

- jämförbar

- jämfört

- jämförelser

- kompatibel

- behörig

- konkurrens

- Tävlingar

- konkurrenskraftig

- konkurrenskraft

- fullständigt

- komplex

- Komplexiteten

- omfattande

- beräkning

- beräkningar

- beräkningar

- dator

- Datorsyn

- databehandling

- Begreppen

- oro

- slutsats

- Kontakta

- anslutna

- Tänk

- anses

- består

- konstant

- innehåll

- tävling

- sammanhang

- fortsätter

- kontinuerlig

- Däremot

- bidra

- bidrar

- Bidragande

- bidrag

- kontroll

- Konvergens

- convolutional neuralt nätverk

- korrekt

- korrekt

- Korrelation

- motsvarar

- kostsam

- täcka

- beläggning

- kritisk

- avgörande

- Aktuella

- kurva

- allra senaste

- datum

- datauppsättningar

- Dagar

- som handlar om

- beslut

- minskar

- djup

- djupt lärande

- djupt neuralt nätverk

- djupare

- krav

- demonstrera

- demonstrerar

- demonstrera

- bero

- beroenden

- distribuera

- utplacera

- utplacering

- beskriva

- beskriven

- beskriver

- Designa

- utformade

- Trots

- detaljerad

- Utvecklare

- utvecklare

- utveckla

- olika

- svårt

- svårigheter

- riktad

- direkt

- upptäcker

- Upptäckten

- avstånd

- skilja på

- åtskillnad

- fördelning

- Distributioner

- flera

- Mångfald

- do

- domän

- domäner

- Dominans

- drog

- läkemedelsforskning

- under

- dynamisk

- E&T

- varje

- lättare

- Effektiv

- effektivt

- effektivitet

- effekter

- effektivitet

- effektivitet

- effektiv

- åtta

- antingen

- element

- elva

- eliminerar

- eliminera

- betona

- betonar

- arbetsgivare

- sysselsätter

- möjliggöra

- möjliggör

- möjliggör

- kodning

- engagera

- Teknik

- Engelska

- förbättra

- förbättringar

- Förbättrar

- säkerställa

- Hela

- helt

- inträde

- lika

- Jämvikt

- Motsvarande

- fel

- speciellt

- huvudsak

- väsentlig

- etablerade

- upprättar

- uppskattningar

- Eter (ETH)

- utvärdering

- utvärdering

- Även

- överallt

- utvecklas

- utvecklas

- utvecklas

- exempel

- överstiga

- överstiger

- utmärkt

- spännande

- utställningar

- befintliga

- finns

- Bygga ut

- dyra

- experimentell

- experiment

- experter

- utforskning

- utforska

- utforskar

- Utforska

- förlängas

- underlättar

- underlättande

- inte

- bekant

- snabbare

- möjlig

- Funktioner

- få

- färre

- fält

- Fält

- filter

- slutlig

- hitta

- finna

- resultat

- Förnamn

- montering

- fem

- fixerad

- flöda

- fokuserar

- fokusering

- följt

- För

- hittade

- fyra

- Ramverk

- Frekvens

- från

- frystes

- full

- fullständigt

- fungera

- funktioner

- ytterligare

- Få

- resultat

- lek

- GAN

- gate

- genai

- generera

- genereras

- generera

- generativ

- generativ modell

- mild

- geometri

- ges

- Ge

- Välgörenhet

- GPU

- GPUs

- diagram

- diagram neurala nätverk

- grafer

- Väx

- hantera

- Arbetsmiljö

- hårdvara

- har

- hjälper

- hierarkisk

- Hög

- Hög frekvens

- hög upplösning

- högre

- Markera

- Markerad

- belysa

- höjdpunkter

- höggradigt

- Hur ser din drömresa ut

- How To

- HTTPS

- humant

- Människa

- Hundratals

- hundratals miljoner

- Inställning av hyperparameter

- idéer

- identifiera

- bild

- Bildklassificering

- Bildigenkänning

- IMAGEnet

- bilder

- Inverkan

- Konsekvenser

- nödvändigt

- genomförande

- implementeringar

- genomföras

- implikationer

- vikt

- med Esport

- ålagts

- förbättras

- förbättring

- förbättringar

- förbättrar

- förbättra

- in

- innefattar

- innefattar

- Inklusive

- införliva

- inkorporerar

- Öka

- ökat

- ökande

- alltmer

- indikerar

- informationen

- informeras

- initialt

- innovationer

- innovativa

- ingång

- insikter

- inspirerat

- exempel

- istället

- instruktioner

- integrering

- Intelligens

- intensiv

- interaktion

- interaktioner

- intresse

- Internet

- in

- införa

- introducerade

- Introducerar

- införa

- Beskrivning

- Undersökningen

- engagera

- innebär

- fråga

- problem

- IT

- DESS

- Jobb

- Lediga jobb

- resa

- jpg

- kunskap

- känd

- Brist

- landning

- liggande

- språk

- Large

- storskalig

- större

- största

- Latens

- senaste

- lager

- skikt

- ledande

- Leads

- LÄRA SIG

- lärt

- inlärning

- mindre

- nivåer

- Hävstång

- hävstångs

- hävstångs

- tycka om

- sannolikhet

- begränsning

- begränsningar

- Begränsad

- lokal

- Lång

- länge sedan

- se

- Låg

- lägre

- sänkning

- Maskinen

- maskinöversättning

- gjord

- upprätthålla

- större

- göra

- Framställning

- sätt

- många

- karta

- Marginal

- massiv

- Match

- tändstickor

- matchande

- matematisk

- Matris

- max-bredd

- maximera

- maximal

- mäta

- mekanismer

- Minne

- endast

- sammanslagning

- metod

- metoder

- Metodik

- metoder

- miljon

- miljoner

- minimum

- minimerande

- misstag

- modell

- modeller

- modifieringar

- Moduler

- mer

- mer effektiv

- Dessutom

- mest

- multipel

- måste

- Måste läsa

- Natural

- Naturligt språk

- Naturlig språkbehandling

- Natur

- Behöver

- behövs

- behov

- Nerf

- Nets

- nät

- nätverk

- neural

- neurala nätverk

- neurala nätverk

- NeurIPS

- nervceller

- Nya

- nyheter

- Nästa

- nlp

- Nej

- nod

- noder

- anmärkningsvärd

- Notera

- Anmärkningar

- roman

- antal

- objektet

- mål

- mål

- observerad

- förekomst

- OCR

- of

- erbjudanden

- Erbjudanden

- Ofta

- on

- ONE

- ettor

- nätet

- endast

- öppen källkod

- drift

- Verksamhet

- optimering

- Optimera

- optimerad

- or

- Övriga

- Överträffa

- presterande bättre än

- utklassar

- produktion

- utanför

- över

- Övervinna

- övervinna

- Översikt

- paket

- par

- Pankaj

- Papper

- papper

- Parallell

- parameter

- parametrar

- särskilt

- särskilt

- Plåster

- Mönster

- för

- utföra

- prestanda

- utför

- perioder

- Fotorealistisk

- plato

- Platon Data Intelligence

- PlatonData

- plausibel

- Punkt

- utgör

- potentiell

- potentiellt

- den mäktigaste

- Praktisk

- Praktiska tillämpningar

- förutse

- Förutsägbar

- förutsäga

- förutsägelse

- Förutsägelser

- Förutspår

- presentera

- presenteras

- presenterar

- föregående

- primär

- Innan

- Sannolikheten

- Problem

- problem

- förfaranden

- process

- bearbetning

- producera

- djupgående

- Program

- Program

- projekt

- föreslå

- föreslagen

- föreslår

- föreslår

- Protein

- Proteiner

- beprövade

- bevisar

- ge

- ger

- tillhandahålla

- publicerade

- pytorch

- kvalitet

- sökfrågor

- Lopp

- område

- rangordna

- rates

- snarare

- Raw

- kommit fram till

- Läsa

- Läsning

- bekräftar på nytt

- verklig

- verkliga världen

- senaste

- nyligen

- Receptet

- erkännande

- Rekommendation

- återhämta

- upprepning

- återkommande

- Rekursiv

- minska

- Minskad

- minskar

- reducerande

- reduktion

- referens

- referenser

- reflekterad

- om

- Reglera

- relaterad

- Förhållanden

- frigöra

- frigörs

- tillit

- förlita

- resterna

- anmärkningsvärd

- renderade

- rendering

- representerar

- representation

- representativ

- representerar

- kräver

- krav

- Krav

- forskning

- forskarvärlden

- forskare

- Resurser

- respektive

- resulterande

- Resultat

- omskolning

- avslöjar

- revolutionera

- RGB

- höger

- Risk

- robusta

- skalbarhet

- skalbar

- Skala

- skalor

- skalning

- scenarier

- scen

- scener

- schemaläggning

- system

- vetenskaplig

- göra

- repa

- Sök

- mening

- Sekvens

- Serier

- serverar

- in

- uppsättningar

- inställningar

- flera

- Dela

- delning

- kortsiktigt

- show

- utställningsmonter

- visa upp

- visar

- Visar

- signaler

- signifikans

- signifikant

- signifikant

- liknande

- Likheterna

- Enkelt

- samtidigt

- situationer

- Storlek

- skicklig

- mjukt

- samhällelig

- enbart

- lösning

- Lösningar

- LÖSA

- Löser

- Lösa

- några

- ibland

- Utrymme

- Rum och tid

- spänning

- specialiserad

- specifik

- Spektral

- fart

- delas

- standard

- state-of-the-art

- uttalanden

- bo

- Steg

- förvaring

- lagra

- Strategisk

- strategier

- Strategi

- stark

- struktur

- strukturerade

- strukturer

- Struggles

- Läsa på

- väsentlig

- väsentligen

- framgång

- framgångsrik

- Framgångsrikt

- sådana

- Föreslår

- lämplig

- överlägsen

- övervakning

- överträffar

- överträffar

- SVG

- syntes

- system

- System

- uppgift

- uppgifter

- tekniker

- Tend

- villkor

- testa

- text

- än

- den där

- Smakämnen

- Grafen

- deras

- Dem

- sedan

- teoretiska

- Dessa

- de

- detta

- tusentals

- tre

- Genom

- tid

- gånger

- till

- verktyg

- ämnen

- mot

- traditionell

- Tåg

- tränad

- Utbildning

- överföring

- Överföra

- transformator

- transformatorer

- Översättning

- Översättningskvalitet

- Trender

- handledning

- två

- typer

- understryker

- förståelse

- unika

- enheter

- till skillnad från

- utan motstycke

- uppdaterad

- Uppdateringar

- användning

- Begagnade

- användningar

- med hjälp av

- Återvinnare

- v1

- Värdefulla

- olika

- verifierbar

- mångsidig

- mångsidighet

- version

- Video

- Video

- utsikt

- visningar

- synlig

- syn

- vision system

- visuell

- Visuellt erkännande

- volym

- vs

- var

- sätt

- webb

- vikt

- VÄL

- när

- om

- som

- medan

- bred

- Brett utbud

- brett

- bredare

- Bredare gemenskap

- wikipedia

- kommer

- med

- inom

- utan

- ord

- Arbete

- fungerar

- värt

- skriven

- år

- vilket gav

- dig

- Din

- zephyrnet