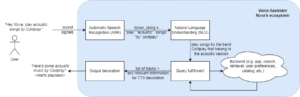

De senaste framstegen i utvecklingen av LLM:er har populariserat deras användning för olika NLP-uppgifter som tidigare hanterats med hjälp av äldre metoder för maskininlärning. Stora språkmodeller kan lösa en mängd olika språkproblem som klassificering, sammanfattning, informationssökning, skapande av innehåll, svar på frågor och upprätthålla en konversation – allt med bara en enda modell. Men hur vet vi att de gör ett bra jobb med alla dessa olika uppgifter?

Framväxten av LLM har visat på ett olöst problem: vi har ingen tillförlitlig standard för att utvärdera dem. Det som gör utvärderingen svårare är att de används för mycket olika uppgifter och vi saknar en tydlig definition av vad som är ett bra svar för varje användningsfall.

Den här artikeln diskuterar nuvarande tillvägagångssätt för att utvärdera LLM och introducerar en ny LLM leaderboard som utnyttjar mänsklig utvärdering som förbättrar befintliga utvärderingstekniker.

Den första och vanliga inledande formen av utvärdering är att köra modellen på flera kurerade datamängder och undersöka dess prestanda. HuggingFace skapade en Öppna LLM Leaderboard där stora modeller med öppen tillgång utvärderas med hjälp av fyra välkända dataset (AI2 Reasoning Challenge , HellaSwag , MMLU , Sanningsfull QA). Detta motsvarar automatisk utvärdering och kontrollerar modellens förmåga att få fakta för vissa specifika frågor.

Detta är ett exempel på en fråga från MMLU datasätt.

Ämne: college_medicine

Fråga: En förväntad bieffekt av kreatintillskott är.

- A) muskelsvaghet

- B) ökning i kroppsmassa

- C) muskelkramper

- D) förlust av elektrolyter

Svar: (B)

Att poängsätta modellen för att svara på den här typen av frågor är ett viktigt mått och fungerar bra för faktakontroll, men det testar inte modellens generativa förmåga. Detta är förmodligen den största nackdelen med denna utvärderingsmetod eftersom generering av fri text är en av de viktigaste funktionerna i LLM.

Det verkar finnas en konsensus inom samhället att för att utvärdera modellen ordentligt behöver vi mänsklig utvärdering. Detta görs vanligtvis genom att jämföra svaren från olika modeller.

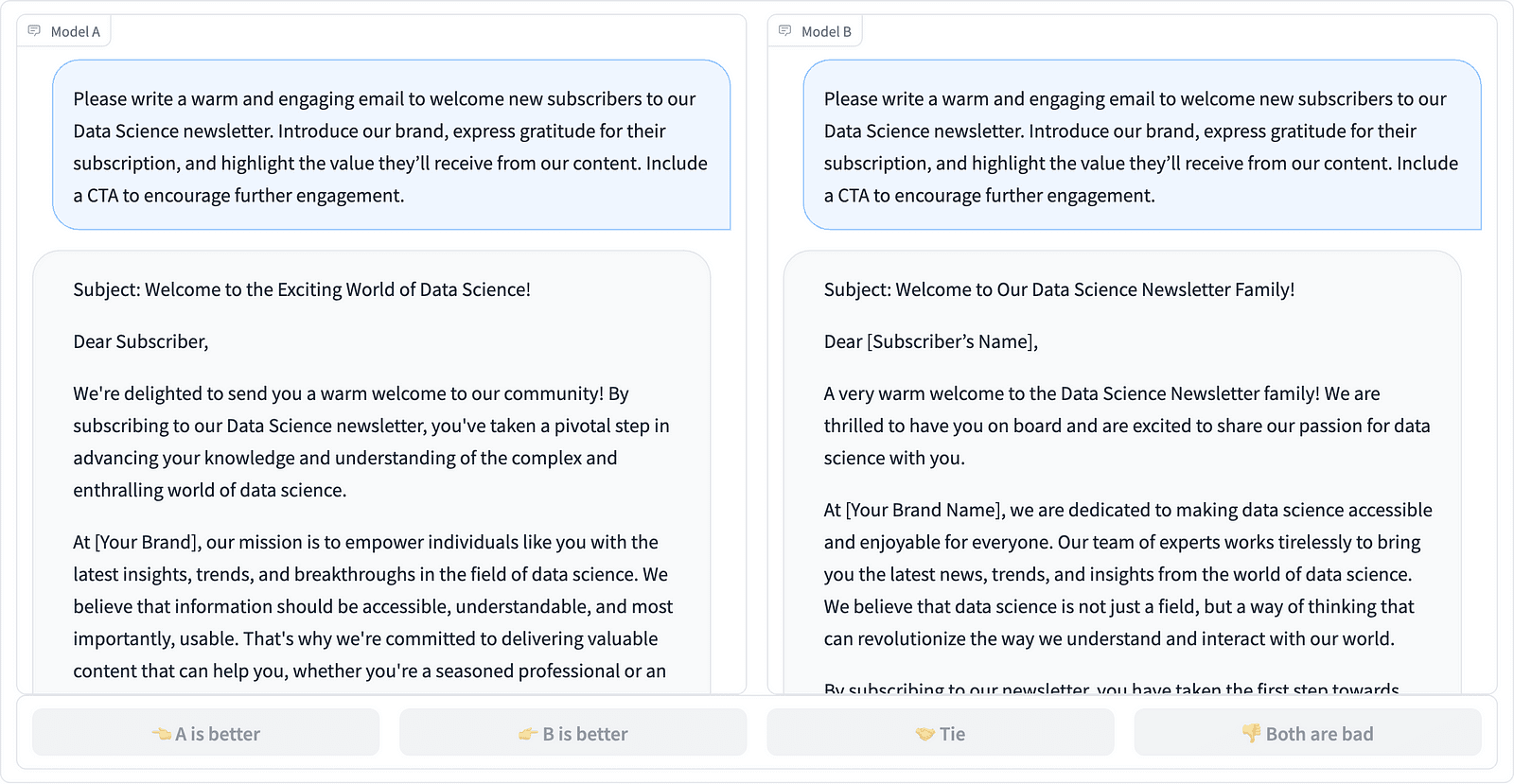

Jämför två snabba slutföranden i LMSYS-projektet – skärmdump av författaren

Annotatorer bestämmer vilket svar som är bättre, som framgår av exemplet ovan, och kvantifierar ibland skillnaden i kvalitet på de uppmaningar som slutförs. LMSYS Org har skapat en leader som använder denna typ av mänsklig utvärdering och jämför 17 olika modeller, rapportering Elo-betyg för varje modell.

Eftersom mänsklig utvärdering kan vara svår att skala har det gjorts försök att skala och påskynda utvärderingsprocessen och detta resulterade i ett intressant projekt som heter AlpacaEval. Här jämförs varje modell med en baslinje (text-davinci-003 tillhandahållen av GPT-4) och mänsklig utvärdering ersätts med GPT-4-bedömning. Detta är verkligen snabbt och skalbart men kan vi lita på att modellen här gör poängsättningen? Vi måste vara medvetna om modellfördomar. Projektet har faktiskt visat att GPT-4 kan gynna längre svar.

LLM-utvärderingsmetoder fortsätter att utvecklas när AI-gemenskapen söker efter enkla, rättvisa och skalbara tillvägagångssätt. Den senaste utvecklingen kommer från teamet på Toloka med en ny leader för att ytterligare främja nuvarande utvärderingsstandarder.

Den nya leader jämför modellsvar med verkliga användarmeddelanden som är kategoriserade efter användbara NLP-uppgifter enligt beskrivningen i detta InstructGPT-papper. Den visar också varje modells totala vinstfrekvens i alla kategorier.

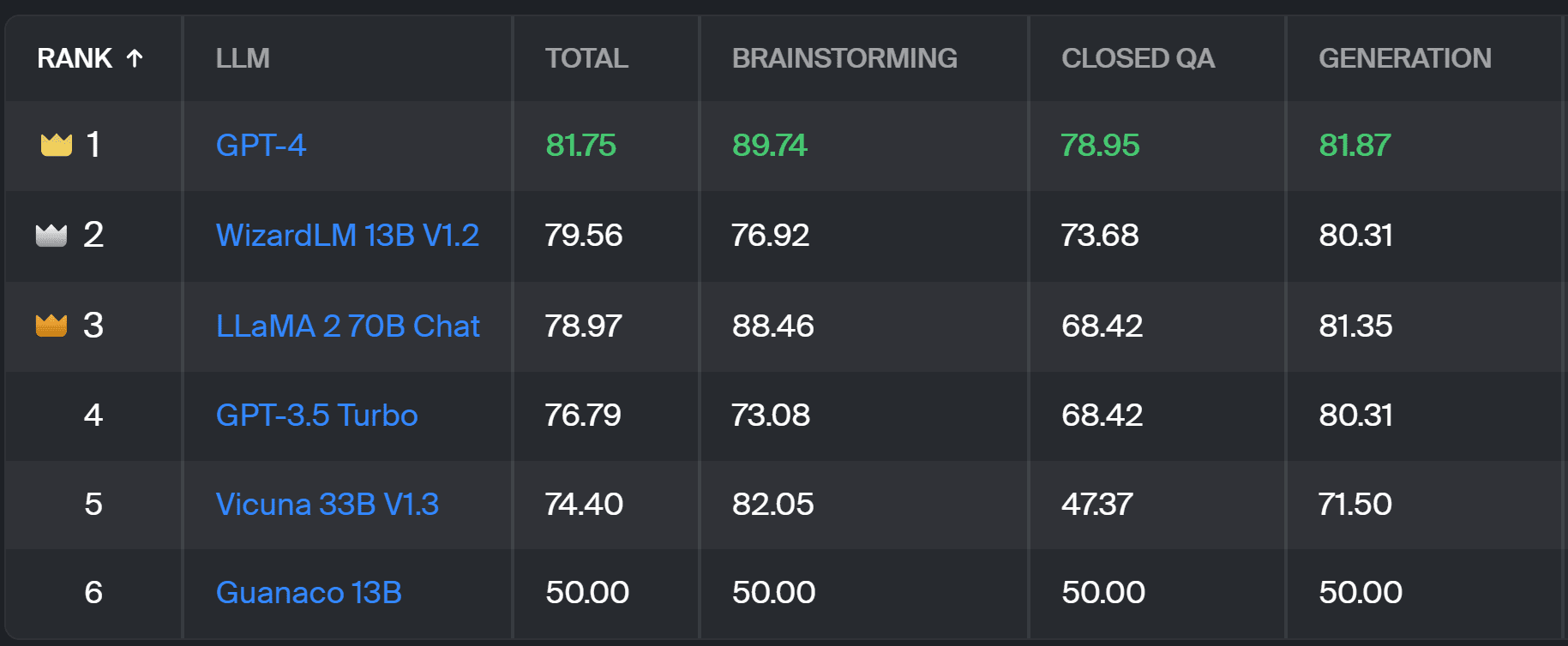

Toloka leaderboard – skärmdump av författaren

Den utvärdering som används för detta projekt liknar den som utfördes i AlpacaEval. Poängen på topplistan representerar vinstgraden för respektive modell i jämförelse med Guanaco 13B modell, som här fungerar som en baslinjejämförelse. Valet av Guanaco 13B är en förbättring av AlpacaEval-metoden, som använder den snart föråldrade text-davinci-003-modellen som baslinje.

Den faktiska utvärderingen görs av mänskliga expertannotatorer på en uppsättning av verkliga uppmaningar. För varje prompt får annotatorer två kompletteringar och frågas vilken de föredrar. Du kan hitta detaljer om metoden här..

Denna typ av mänsklig utvärdering är mer användbar än någon annan automatisk utvärderingsmetod och bör förbättra den mänskliga utvärderingen som används för LMSYS topplista. Nackdelen med LMSYS-metoden är att alla med länk kan delta i utvärderingen och väcker allvarliga frågor om kvaliteten på data som samlas in på detta sätt. En sluten skara expertkommentarer har bättre potential för tillförlitliga resultat, och Toloka tillämpar ytterligare kvalitetskontrolltekniker för att säkerställa datakvaliteten.

I den här artikeln har vi introducerat en lovande ny lösning för att utvärdera LLM:er – Toloka Leaderboard. Tillvägagångssättet är innovativt, kombinerar styrkorna hos befintliga metoder, lägger till uppgiftsspecifik granularitet och använder pålitliga mänskliga anteckningstekniker för att jämföra modellerna.

Utforska tavlan och dela dina åsikter och förslag på förbättringar med oss.

Magdalena Konkiewicz är en dataevangelist på Toloka, ett globalt företag som stödjer snabb och skalbar AI-utveckling. Hon har en magisterexamen i artificiell intelligens från Edinburgh University och har arbetat som NLP-ingenjör, utvecklare och dataforskare för företag i Europa och Amerika. Hon har också varit involverad i undervisning och mentorskap för Data Scientists och bidrar regelbundet till Data Science och Machine Learning-publikationer.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- : har

- :är

- :inte

- :var

- $UPP

- 17

- a

- förmåga

- Om oss

- ovan

- tvärs

- faktiska

- faktiskt

- Annat

- Lägger

- avancera

- framsteg

- AI

- Alla

- också

- amerika

- an

- och

- svara

- svar

- vilken som helst

- applicerar

- tillvägagångssätt

- tillvägagångssätt

- ÄR

- Arena

- Artikeln

- konstgjord

- artificiell intelligens

- AS

- At

- Automat

- medveten

- b

- Baslinje

- BE

- därför att

- varit

- Bättre

- förspänner

- störst

- ombord

- kropp

- fört

- företag

- men

- by

- KAN

- kapabel

- Vid

- kategorier

- utmanar

- Kontroller

- val

- klassificering

- klar

- stängt

- kombinerar

- kommer

- samfundet

- företag

- jämföra

- jämfört

- jämförande

- jämförelse

- Konsensus

- innehåll

- innehållsskapande

- fortsätter

- bidrar

- kontroll

- Konversation

- motsvarar

- skapas

- skapande

- folkmassa

- kurerad

- Aktuella

- datum

- Datakvalitet

- datavetenskap

- datavetare

- datauppsättningar

- beslutar

- definition

- Examen

- detaljer

- Utvecklare

- Utveckling

- Skillnaden

- olika

- Nackdel

- flera

- do

- gör

- gör

- gjort

- inte

- nackdelen

- varje

- lätt

- edinburgh

- effekt

- ansträngningar

- elektrolyter

- ingenjör

- säkerställa

- Europa

- utvärdera

- utvärderade

- utvärdering

- utvärdering

- Evangelist

- utvecklas

- undersöka

- exempel

- befintliga

- förväntat

- expert

- fakta

- verkligt

- SNABB

- gynna

- Funktioner

- hitta

- Förnamn

- För

- formen

- fyra

- Fri

- från

- ytterligare

- Få

- samlade ihop

- generera

- generativ

- skaffa sig

- GitHub

- ges

- Välgörenhet

- god

- bra jobb

- Hård

- hårdare

- Har

- här.

- höggradigt

- innehar

- Hur ser din drömresa ut

- HTTPS

- Kramar ansikte

- humant

- med Esport

- förbättra

- förbättring

- förbättringar

- förbättrar

- in

- informationen

- inledande

- innovativa

- Intelligens

- intressant

- introducerade

- Introducerar

- involverade

- IT

- DESS

- Jobb

- bara

- bara en

- KDnuggets

- Vet

- Brist

- språk

- Large

- senaste

- inlärning

- hävstångs

- ljus

- längre

- förlust

- Maskinen

- maskininlärning

- upprätthålla

- GÖR

- sätt

- Massa

- Master

- Maj..

- mentor

- metod

- Metodik

- metoder

- metriska

- modell

- modeller

- mer

- mest

- muskel

- Behöver

- Nya

- ny lösning

- nlp

- of

- äldre

- on

- ONE

- öppet

- Åsikter

- Övriga

- skisse

- övergripande

- del

- utföra

- prestanda

- utfört

- plato

- Platon Data Intelligence

- PlatonData

- potentiell

- föredra

- tidigare

- förmodligen

- Problem

- problem

- process

- projektet

- lovande

- prompter

- ordentligt

- förutsatt

- publikationer

- kvalitet

- fråga

- frågor

- höja

- Betygsätta

- verkliga världen

- regelbundet

- pålitlig

- ersättas

- Rapportering

- representerar

- att

- respons

- svar

- resulte

- Resultat

- Rise

- Körning

- s

- skalbar

- Skala

- Vetenskap

- Forskare

- vetenskapsmän

- poäng

- poäng

- sök

- verkar

- sett

- allvarlig

- serverar

- in

- flera

- Dela

- hon

- skall

- visas

- Visar

- sida

- liknande

- enda

- lösning

- Lösa

- några

- ibland

- specifik

- fart

- standard

- standarder

- styrkor

- sådana

- Stödjande

- Ta

- uppgifter

- Undervisning

- grupp

- tekniker

- testa

- text

- än

- den där

- Smakämnen

- deras

- Dem

- Där.

- Dessa

- de

- detta

- till

- Litar

- två

- Typ

- typiskt

- universitet

- på

- us

- Användning

- användning

- användningsfall

- Begagnade

- Användare

- användningar

- med hjälp av

- vanliga

- mängd

- Sätt..

- we

- svaghet

- VÄL

- ALLBEKANT

- były

- Vad

- Vad är

- som

- vinna

- med

- inom

- arbetade

- dig

- Din

- zephyrnet