Bild av författare

Den här artikeln kommer att diskutera 7-AI-drivna verktyg som kan hjälpa dig att öka din produktivitet som dataforskare. Dessa verktyg kan hjälpa dig att automatisera uppgifter som datarensning och funktionsval, modelljustering etc., vilket direkt eller indirekt gör ditt arbete mer effektivt, exakt och effektivt och hjälper också till att fatta bättre beslut.

Många av dem har användarvänliga användargränssnitt och är mycket enkla att använda. Samtidigt tillåter vissa datavetare att dela och samarbeta i projekt med andra medlemmar, vilket hjälper till att öka produktiviteten i team.

DataRobot är en webbaserad plattform som hjälper dig att automatisera att bygga, distribuera och underhålla maskininlärningsmodeller. Den stöder många funktioner och tekniker som djupinlärning, ensembleinlärning och tidsserieanalys. Den använder avancerade algoritmer och tekniker som hjälper till att bygga modeller snabbt och exakt och ger även funktioner för att underhålla och övervaka den utplacerade modellen.

Bild av DataRobot

Det tillåter också datavetare att dela och samarbeta i projekt med andra, vilket gör det lättare att arbeta som ett team i komplexa projekt.

H20.ai är en plattform med öppen källkod som tillhandahåller professionella verktyg för datavetare. Dess huvudfunktion är Automated Machine Learning (AutoML) som automatiserar processen att bygga och ställa in maskininlärningsmodellerna. Det inkluderar också algoritmer som gradientförstärkning, slumpmässiga skogar, etc.

Eftersom det är en öppen källkodsplattform kan datavetare anpassa källkoden efter sina behov så att de kan passa in i sina befintliga system.

Bild av H20.ai

Den använder ett versionskontrollsystem som håller reda på alla ändringar och modifieringar som trycks in i koden. H2O.ai kan också köras på moln- och edge-enheter och stödjer en stor och aktiv community av användare och utvecklare som bidrar till plattformen.

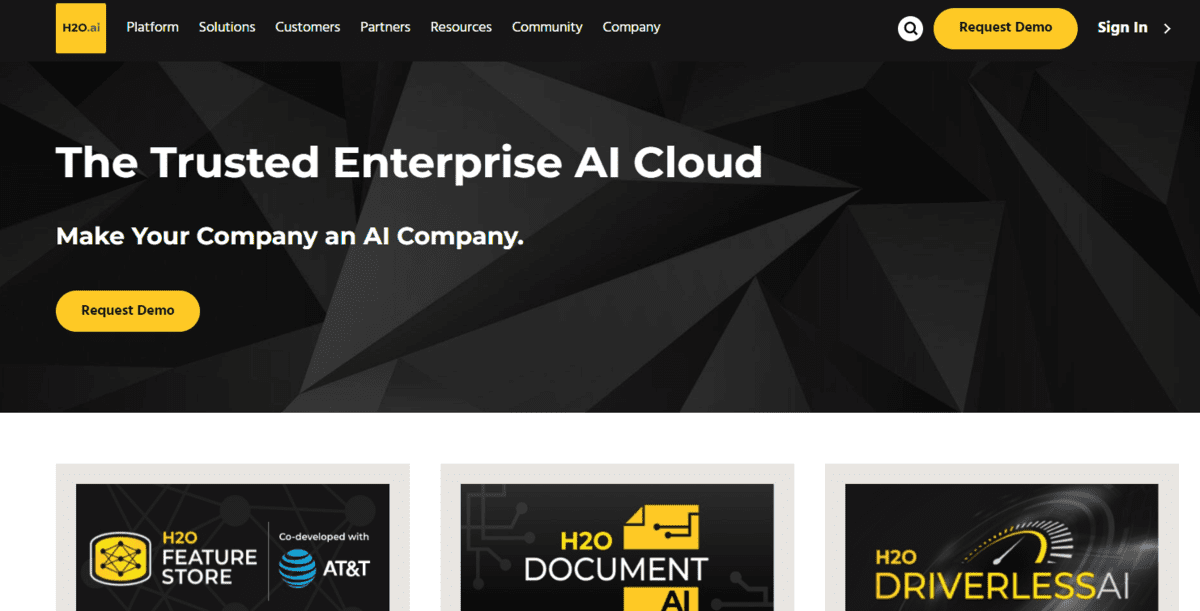

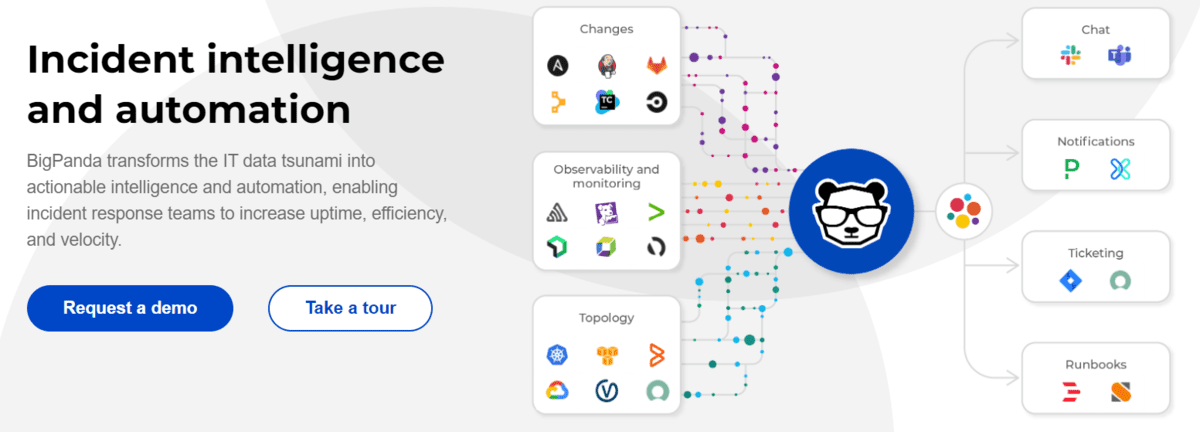

Big Panda används för att automatisera incidenthantering och anomalidetektering i IT-drift. Enkelt uttryckt är anomalidetektering att identifiera mönster, händelser eller observationer i en datauppsättning som väsentligt avviker från det förväntade beteendet. Den används för att identifiera ovanliga eller onormala datapunkter som kan indikera ett problem.

Den använder olika AI- och ML-tekniker för att analysera loggdata och identifiera potentiella problem. Det kan automatiskt lösa incidenter och minska behovet av manuellt ingripande.

Bild av Stor Panda

Big Panda kan övervaka system i realtid, vilket kan hjälpa till att identifiera och lösa problem snabbt. Det kan också hjälpa till att identifiera grundorsaken till incidenter, göra det lättare att lösa problem och förhindra att de inträffar igen.

HuggingFace används för naturlig språkbehandling (NLP) och tillhandahåller förutbildade modeller, vilket gör det möjligt för datavetare att snabbt implementera NLP-uppgifter. Den utför många funktioner som textklassificering, namngiven enhetsigenkänning, svar på frågor och språköversättning. Det ger också möjligheten att finjustera de förtränade modellerna på specifika uppgifter och datauppsättningar, vilket gör det möjligt att förbättra prestandan.

Dess förtränade modeller har uppnått toppmodern prestanda på olika riktmärken eftersom de är tränade på stora mängder data. Detta kan spara tid och resurser för datavetare genom att de kan bygga modeller snabbt utan att träna dem från grunden.

Bild av Kramande ansikte

Plattformen tillåter också datavetare att finjustera de förtränade modellerna på specifika uppgifter och datauppsättningar, vilket kan förbättra modellernas prestanda. Detta kan göras med ett enkelt API, vilket gör det enkelt att använda även för dem med begränsad NLP-erfarenhet.

CatBoost-biblioteket används för gradientförstärkningsuppgifter och är speciellt utformat för att hantera kategoriska data. Den uppnår toppmoderna prestanda på många datamängder och stödjer att påskynda modellträningsprocessen på grund av parallella GPU-beräkningar.

Bild av CatBoost

CatBoost är mest stabil och robust mot överanpassning och brus i data, vilket kan förbättra modellernas generaliseringsförmåga. Den använder en algoritm som kallas "beställd boosting" för att iterativt fylla i saknade värden innan du gör en förutsägelse.

CatBoost ger funktionsviktighet, vilket kan hjälpa dataforskare att förstå varje funktions bidrag till modellförutsägelserna.

Optuna är också ett bibliotek med öppen källkod som huvudsakligen används för justering och optimering av hyperparameter. Detta hjälper dataforskare att hitta de bästa parametrarna för sina maskininlärningsmodeller. Den använder en teknik som kallas "bayesisk optimering" som automatiskt kan söka efter de optimala hyperparametrarna för en given modell.

Bild av Välja

Dess andra huvudfunktion är att den enkelt kan integreras med olika ramverk för maskininlärning och bibliotek som TensorFlow, PyTorch och scikit-learn. Den kan också utföra samtidiga optimeringar av flera mål, vilket ger en bra avvägning mellan prestanda och andra mätvärden.

Det är en plattform för att tillhandahålla förutbildade modeller utformade för att göra det enkelt för utvecklare att integrera dessa modeller i sina befintliga applikationer eller tjänster.

Det tillhandahåller också olika API:er som tal-till-text eller naturlig språkbehandling. Tal-till-text API används för att hämta texten från ljud- eller videofiler med hög noggrannhet. Dessutom kan API:et för naturligt språk hjälpa till att bearbeta uppgifter som sentimentanalys, igenkänning av bildenheter, textsammanfattning, etc.

Bild av AssemblyAI

Att träna en maskininlärningsmodell inkluderar datainsamling och förberedelse, utforskande dataanalys, funktionsteknik, modellval och utbildning, modellutvärdering och slutligen modellinstallation. För att utföra alla uppgifter behöver du kunskapen om de olika verktygen och kommandona som är involverade. Dessa sju verktyg kan hjälpa dig att träna och distribuera din modell med minimal ansträngning.

Sammanfattningsvis hoppas jag att du gillade den här artikeln och tyckte att den var informativ. Om du har några förslag eller feedback, vänligen kontakta mig via LinkedIn.

Ariska Garg är en B.Tech. Elektroteknikstudent, går för närvarande sista året av sin grundexamen. Hans intresse ligger inom området webbutveckling och maskininlärning. Han har följt detta intresse och är angelägen om att arbeta mer i dessa riktningar.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. Tillgång här.

- Källa: https://www.kdnuggets.com/2023/02/7-aipowered-tools-enhance-productivity-data-scientists.html?utm_source=rss&utm_medium=rss&utm_campaign=7-ai-powered-tools-to-enhance-productivity-for-data-scientists

- 7

- a

- förmåga

- Enligt

- noggrannhet

- exakt

- exakt

- uppnås

- uppnår

- aktiv

- avancerat

- AI

- AI-powered

- algoritm

- algoritmer

- Alla

- tillåta

- tillåter

- mängder

- analys

- analysera

- och

- avvikelse av anomali

- api

- API: er

- tillämpningar

- Artikeln

- audio

- automatisera

- Automatiserad

- automatiserad maskininlärning

- automatiserar

- automatiskt

- automatisera

- AutoML

- Bayesian

- därför att

- innan

- riktmärken

- BÄST

- Bättre

- mellan

- lyft

- öka

- SLUTRESULTAT

- Byggnad

- kallas

- Orsak

- Förändringar

- klassificering

- Rengöring

- cloud

- koda

- samarbeta

- samling

- samfundet

- komplex

- beräkningar

- slutsats

- bidra

- bidrag

- kontroll

- För närvarande

- skräddarsy

- datum

- dataanalys

- datapunkter

- datavetare

- DataRobot

- datauppsättningar

- beslut

- djup

- djupt lärande

- distribuera

- utplacerade

- utplacera

- utplacering

- utformade

- Detektering

- utvecklare

- Utveckling

- enheter

- direkt

- diskutera

- varje

- lättare

- lätt

- kant

- Effektiv

- effektiv

- ansträngning

- elektroteknik

- Teknik

- enhet

- etc

- utvärdering

- Även

- händelser

- befintliga

- förväntat

- erfarenhet

- Utforskande dataanalys

- Leverans

- Funktioner

- återkoppling

- fält

- Filer

- fylla

- slutlig

- Slutligen

- hitta

- passa

- hittade

- ramar

- från

- funktioner

- skaffa sig

- ges

- ger

- god

- GPU

- Arbetsmiljö

- hjälpa

- hjälper

- Hög

- hoppas

- HTTPS

- Inställning av hyperparameter

- identifiera

- identifiera

- genomföra

- vikt

- förbättra

- in

- incident

- innefattar

- ökande

- indikerar

- indirekt

- informativ

- integrera

- integrerade

- intresse

- ingripande

- involverade

- problem

- IT

- KDnuggets

- språk

- Large

- inlärning

- bibliotek

- Bibliotek

- Begränsad

- Maskinen

- maskininlärning

- Huvudsida

- Viktigaste funktionen

- bibehålla

- göra

- GÖR

- Framställning

- ledning

- manuell

- många

- Medlemmar

- Metrics

- minsta

- saknas

- ML

- ML -tekniker

- modell

- modeller

- modifieringar

- Övervaka

- mer

- mer effektiv

- mest

- multipel

- Som heter

- Natural

- Naturligt språk

- Naturlig språkbehandling

- Behöver

- behov

- nlp

- Brus

- mål

- öppen källkod

- Verksamhet

- optimala

- optimering

- Övriga

- Övrigt

- Parallell

- parametrar

- mönster

- utföra

- prestanda

- utför

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- snälla du

- poäng

- potentiell

- drivs

- förutsägelse

- Förutsägelser

- förebyggande

- Problem

- problem

- process

- bearbetning

- produktivitet

- professionell

- projekt

- ger

- tillhandahålla

- sköt

- pytorch

- fråga

- snabbt

- slumpmässig

- nå

- realtid

- erkännande

- minska

- lösa

- Resurser

- robusta

- rot

- Körning

- Samma

- Save

- Forskare

- vetenskapsmän

- scikit lära

- Sök

- Val

- känsla

- Serier

- Tjänster

- sju

- Dela

- signifikant

- Enkelt

- samtidig

- So

- några

- Källa

- källkod

- specifik

- specifikt

- tal-till-text

- stabil

- state-of-the-art

- student

- Stöder

- system

- System

- uppgifter

- grupp

- lag

- tech

- tekniker

- tensorflow

- villkor

- Textklassificering

- Smakämnen

- källan

- deras

- tid

- Tidsföljder

- till

- verktyg

- spår

- Tåg

- tränad

- Utbildning

- Översättning

- förstå

- ovanlig

- användning

- användarvänligt

- användare

- Värden

- olika

- version

- versionskontroll

- via

- Video

- webb

- Webbutveckling

- Webb-baserad

- som

- VEM

- kommer

- utan

- Arbete

- år

- Din

- zephyrnet