Sponzorirane vsebine

ChatGPT in podobna orodja, ki temeljijo na velikih jezikovnih modelih (LLM), so neverjetna. Niso pa univerzalna orodja.

To je tako kot izbira drugih orodij za gradnjo in ustvarjanje. Izbrati morate pravega za delo. Ne bi poskušali zategniti vijaka s kladivom ali z metlico obrniti polpete za hamburger. Postopek bi bil neroden, kar bi povzročilo grdo napako.

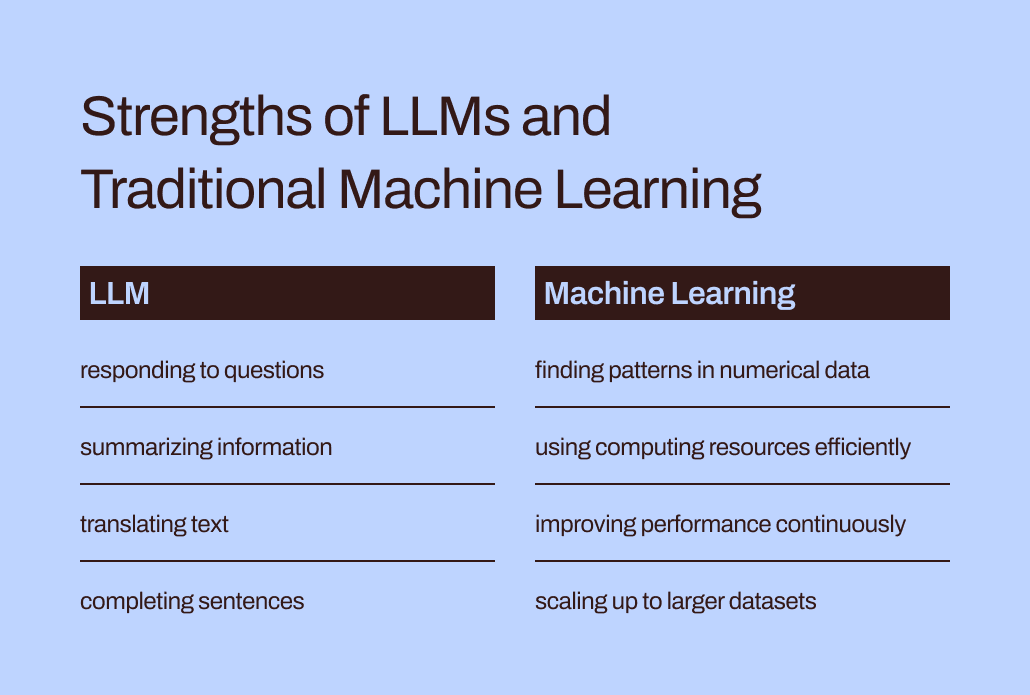

Jezikovni modeli, kot so LLM, so le del širšega nabora orodij za strojno učenje, ki zajema tako generativno umetno inteligenco kot napovedno umetno inteligenco. Izbira pravilne vrste modela strojnega učenja je ključnega pomena za uskladitev z zahtevami vaše naloge.

Poglobimo se v to, zakaj so LLM-ji bolj primerni za pomoč pri pripravi besedila ali idej za darila kot za reševanje najbolj kritičnih nalog napovednega modeliranja vašega podjetja. Še vedno imajo ključno vlogo "tradicionalni" modeli strojnega učenja, ki so bili pred študiji LLM in so vedno znova dokazali svojo vrednost v podjetjih. Raziskali bomo tudi pionirski pristop za skupno uporabo teh orodij – vznemirljiv razvoj, ki ga v Pecanu imenujemo Prediktivni GenAI.

LLM so zasnovani za besede, ne za številke

Pri strojnem učenju se različne matematične metode uporabljajo za analizo tako imenovanih »podatkov za usposabljanje« – začetni nabor podatkov, ki predstavlja problem, ki ga podatkovni analitik ali podatkovni znanstvenik želi rešiti.

Pomena podatkov o usposabljanju ni mogoče preceniti. V sebi vsebuje vzorce in razmerja, ki se jih bo model strojnega učenja »naučil« za napovedovanje rezultatov, ko bo kasneje dobil nove, še nevidene podatke.

Torej, kaj natančno je LLM? Veliki jezikovni modeli ali LLM spadajo pod okrilje strojnega učenja. Izvirajo iz globokega učenja, njihova struktura pa je posebej razvita za obdelavo naravnega jezika.

Lahko bi rekli, da so zgrajeni na podlagi besed. Njihov cilj je preprosto napovedati, katera beseda bo naslednja v zaporedju besed. Na primer, funkcija samodejnega popravljanja iPhonov v sistemu iOS 17 zdaj uporablja LLM za boljše predvidevanje, katero besedo boste najverjetneje nameravali vnesti naslednjo.

Zdaj pa si predstavljajte, da ste model strojnega učenja. (Potrpite z nami, vemo, da je nateg.) Izurjeni ste bili za predvidevanje besed. Prebrali in preučili ste milijone besed iz najrazličnejših virov o najrazličnejših temah. Vaši mentorji (tudi razvijalci) so vam pomagali pri učenju najboljših načinov za predvidevanje besed in ustvarjanje novega besedila, ki ustreza zahtevi uporabnika.

Ampak tukaj je preobrat. Uporabnik vam zdaj ponudi ogromno preglednico podatkov o strankah in transakcijah z milijoni vrstic številk in vas prosi, da predvidite številke, povezane s temi obstoječimi podatki.

Kaj mislite, kako bi se uresničile vaše napovedi? Prvič, verjetno bi vas jezilo, da se ta naloga ne ujema s tem, kar ste se tako zelo trudili naučiti. (Na srečo, kolikor vemo, LLM še nimajo čustev.) Še pomembneje je, da se od vas zahteva, da opravite nalogo, ki se ne ujema s tem, kar ste se naučili. In verjetno ne boste tako uspešni.

Vrzel med usposabljanjem in nalogo pomaga razložiti, zakaj LLM-ji niso najbolj primerni za napovedne naloge, ki vključujejo numerične, tabelarične podatke – primarni format podatkov, ki ga zbira večina podjetij. Namesto tega je model strojnega učenja, posebej oblikovan in natančno nastavljen za ravnanje s to vrsto podatkov, učinkovitejši. Za to je bil dobesedno usposobljen.

Izzivi učinkovitosti in optimizacije LLM

Poleg tega, da se tradicionalne metode strojnega učenja bolje ujemajo z numeričnimi podatki, so veliko bolj učinkovite in jih je lažje optimizirati za boljšo učinkovitost kot LLM.

Vrnimo se k vaši izkušnji z lažnim predstavljanjem LLM. Branje vseh teh besed in preučevanje njihovega sloga in zaporedja zveni kot tona dela, kajne? Potrebno bi bilo veliko truda, da bi vse te informacije ponotranjili.

Podobno lahko zapleteno usposabljanje LLM povzroči modele z milijardami parametrov. Ta zapletenost omogoča tem modelom, da razumejo in se odzovejo na kočljive nianse človeškega jezika. Vendar pa težka usposabljanja prinašajo težke računalniške zahteve, ko LLM ustvarjajo odzive. Numerično usmerjeni "tradicionalni" algoritmi strojnega učenja, kot so odločitvena drevesa ali nevronske mreže, bodo verjetno potrebovali veliko manj računalniških virov. In tu ne gre za "večje je boljše." Tudi če bi LLM lahko obravnavali numerične podatke, bi ta razlika pomenila, da bi bile tradicionalne metode strojnega učenja še vedno hitrejše, učinkovitejše, okoljsko bolj trajnostne in stroškovno učinkovitejše.

Poleg tega, ali ste kdaj vprašali ChatGPT, kako je vedel zagotoviti določen odgovor? Njegov odgovor bo verjetno nekoliko nejasen:

Odzive ustvarjam na podlagi mešanice licenčnih podatkov, podatkov, ki so jih ustvarili trenerji ljudi, in javno dostopnih podatkov. Moje usposabljanje je vključevalo tudi obsežne nabore podatkov, pridobljene iz različnih virov, vključno s knjigami, spletnimi mesti in drugimi besedili, da bi razvil široko razumevanje človeškega jezika. Proces usposabljanja vključuje izvajanje izračunov na tisočih grafičnih procesorjih v tednih ali mesecih, vendar so natančne podrobnosti in časovni okviri last OpenAI.

How much of the “knowledge” reflected in that response came from the human trainers vs. the public data vs. books? Even ChatGPT itself isn’t sure: “The relative proportions of these sources are unknown, and I don’t have detailed visibility into which specific documents were part of my training set.”

It’s a bit unnerving to have ChatGPT provide such confident answers to your questions but not be able to trace its responses to specific sources. LLMs’ limited interpretability and explainability also pose challenges in optimizing them for particular business needs. It can be hard to understand the rationale behind their information or predictions. To further complicate things, certain businesses contend with regulatory demands that mean they must be able to explain the factors influencing a model’s predictions. All in all, these challenges show that traditional machine learning models — generally more interpretable and explainable — are likely better suited for business use cases.

Pravo mesto za LLM v kompletu orodij za napovedovanje podjetij

Torej, ali naj LLM-je preprosto prepustimo njihovim nalogam, povezanim z besedami, in pozabimo nanje za primere predvidene uporabe? Zdaj se morda zdi, da kljub vsemu ne morejo pomagati pri napovedovanju odliva strank ali njihove življenjske vrednosti.

Takole je: čeprav beseda »tradicionalni modeli strojnega učenja« omogoča, da se te tehnike slišijo splošno razumljive in enostavne za uporabo, iz izkušenj pri Pecanu vemo, da se podjetja še vedno v veliki meri trudijo sprejeti celo te bolj znane oblike umetne inteligence.

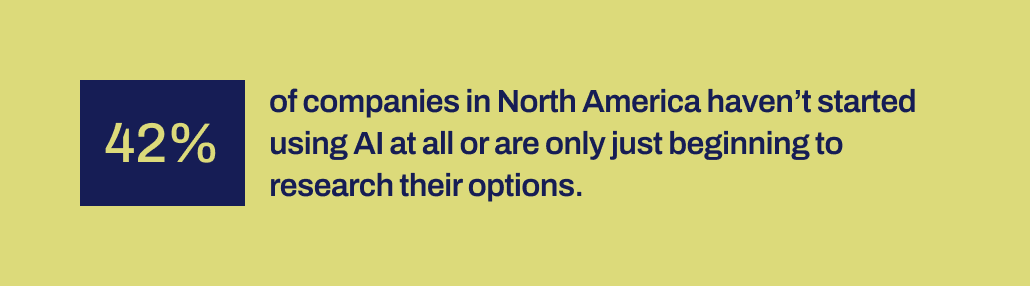

Recent research by Workday reveals that 42% of companies in North America either haven’t initiated the use of AI or are just in the early stages of exploring their options. And it’s been over a decade since machine learning tools became more accessible to companies. They’ve had the time, and various tools are available.

Iz nekega razloga so bile uspešne implementacije umetne inteligence presenetljivo redke kljub množičnemu hrupu okoli podatkovne znanosti in umetne inteligence – in njihovemu priznanemu potencialu za pomemben poslovni vpliv. Manjka nekaj pomembnih mehanizmov, ki bi pomagali premostiti vrzel med obljubami umetne inteligence in zmožnostjo njene produktivne implementacije.

In ravno tu verjamemo, da lahko LLM zdaj igrajo ključno premostitveno vlogo. LLM lahko poslovnim uporabnikom pomagajo premagati prepad med identifikacijo poslovnega problema, ki ga je treba rešiti, in razvojem napovednega modela.

Z LLM-ji zdaj na sliki lahko poslovne in podatkovne ekipe, ki nimajo zmožnosti ali zmogljivosti za ročno kodiranje modelov strojnega učenja, zdaj bolje prevedejo svoje potrebe v modele. Lahko »uporabijo svoje besede«, kot radi rečejo starši, da zaženejo proces modeliranja.

Združevanje LLM s tehnikami strojnega učenja, ustvarjenimi za odličnost pri poslovnih podatkih

Ta zmožnost je zdaj prispela v Pecanov Predictive GenAI, ki združuje prednosti LLM z našo že zelo izpopolnjeno in avtomatizirano platformo za strojno učenje. Naš Prediktivni klepet, ki ga poganja LLM, zbira podatke poslovnega uporabnika za vodenje definicije in razvoja napovednega vprašanja – posebnega problema, ki ga želi uporabnik rešiti z modelom.

Nato z uporabo GenAI naša platforma ustvari Prediktivni zvezek, da naredi naslednji korak k modeliranju še lažji. Spet na podlagi zmogljivosti LLM vsebuje prenosnik vnaprej izpolnjene poizvedbe SQL za izbiro podatkov o usposabljanju za napovedni model. Pecanova avtomatizirana priprava podatkov, inženiring funkcij, izdelava modelov in zmožnosti uvajanja lahko izvedejo preostali proces v rekordnem času, hitreje kot katera koli druga rešitev za napovedno modeliranje.

Skratka, Pecanov Predictive GenAI uporablja neprimerljivo jezikovno znanje LLM-jev, da naredi našo najboljšo platformo za napovedno modeliranje veliko bolj dostopno in prijazno za poslovne uporabnike. Navdušeni smo, da vidimo, kako bo ta pristop pomagal mnogim več podjetjem uspeti z AI.

Torej, medtem ko LLM sam niso najbolj primerni za obravnavo vseh vaših potreb po predvidevanju, imajo lahko močno vlogo pri napredovanju vaših projektov AI. Z razlago vašega primera uporabe in vam daje prednost s samodejno ustvarjeno kodo SQL, je Pecanov Predictive GenAI vodilni pri združevanju teh tehnologij. Ti lahko preverite zdaj z brezplačnim preizkusom.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://www.kdnuggets.com/2024/01/pecan-llms-used-alone-cant-address-companys-predictive-needs?utm_source=rss&utm_medium=rss&utm_campaign=why-llms-used-alone-cant-address-your-companys-predictive-needs

- :ima

- : je

- :ne

- :kje

- 15%

- 17

- a

- sposobnost

- Sposobna

- O meni

- dostopen

- priznali

- Poleg tega

- Naslov

- sprejme

- po

- spet

- AI

- aka

- algoritmi

- uskladiti

- vsi

- omogoča

- sam

- že

- Prav tako

- Neverjetno

- Amerika

- an

- Analitik

- analizirati

- in

- odgovor

- odgovori

- kaj

- pristop

- SE

- okoli

- prispeli

- AS

- pomoč

- At

- Avtomatizirano

- avtomatizirano strojno učenje

- samodejno

- Na voljo

- nazaj

- temeljijo

- BE

- Nosijo

- postal

- bilo

- Začetek

- zadaj

- počutje

- Verjemite

- BEST

- Boljše

- med

- milijardah

- Bit

- Bolt

- knjige

- tako

- Ideja

- MOST

- premostitev

- širši

- Building

- zgrajena

- poslovni

- poslovni učinek

- podjetja

- vendar

- by

- klic

- prišel

- CAN

- Zmogljivosti

- zmožnost

- kapaciteta

- opravlja

- primeru

- primeri

- nekatere

- izzivi

- prepad

- klepet

- ChatGPT

- izbiri

- Koda

- zbiranje

- prihaja

- Podjetja

- Podjetja

- kompleksna

- kompleksnost

- računalniški

- izračuni

- računalništvo

- Prepričani

- predstavljajo

- Vsebuje

- popravi

- stroškovno učinkovito

- bi

- izdelana

- ustvarjajo

- ustvaril

- Ustvarjanje

- kritično

- Cross

- ključnega pomena

- stranka

- datum

- podatkovni analitik

- Priprava podatkov

- znanost o podatkih

- podatkovni znanstvenik

- nabor podatkov

- desetletje

- Odločitev

- globoko

- globoko učenje

- globlje

- opredelitev

- zahteve

- uvajanje

- zasnovan

- Kljub

- podrobno

- Podrobnosti

- Razvoj

- razvili

- Razvijalci

- razvoju

- Razvoj

- Razlika

- drugačen

- DIG

- do

- Dokumenti

- Ne

- don

- dont

- Osnutek

- risanje

- Zgodnje

- lažje

- lahka

- Učinkovito

- učinkovitosti

- učinkovite

- prizadevanje

- bodisi

- obsežno

- Inženiring

- okolju

- Eter (ETH)

- Tudi

- VEDNO

- Primer

- Excel

- razburjen

- zanimivo

- obstoječih

- izkušnje

- Pojasnite

- Pojasnjevanje

- raziskuje

- Raziskovati

- dejavniki

- Napaka

- Padec

- seznanjeni

- daleč

- hitreje

- Feature

- občutki

- manj

- prva

- fit

- Ujema

- Flip

- za

- format

- Obrazci

- Na srečo

- Naprej

- Fundacija

- brezplačno

- Prijazno

- iz

- nadalje

- zlivanje

- vrzel

- genai

- splošno

- ustvarjajo

- ustvarila

- ustvarja

- generativno

- Generativna AI

- darilo

- dana

- daje

- Giving

- Go

- Cilj

- Grafične kartice

- vodi

- imel

- kladivo

- ročaj

- Ravnanje

- Trdi

- Imajo

- pristanišče

- Glava

- težka obremenitev

- pomoč

- pomagal

- pomoč

- Pomaga

- zelo

- drži

- upa

- Kako

- Vendar

- HTTPS

- človeškega

- i

- Ideje

- identifikacijo

- if

- slika

- vpliv

- izvajati

- izvedbe

- Pomembno

- kar je pomembno

- in

- Vključno

- vplivati

- Podatki

- začetna

- začeti

- vhod

- Namesto

- nameravajo

- v

- vključeni

- vključuje

- vključujejo

- iOS

- IT

- ITS

- sam

- Job

- samo

- KDnuggets

- Vedite

- znano

- jezik

- velika

- obsežne

- v veliki meri

- pozneje

- vodi

- UČITE

- naučili

- učenje

- pustite

- Licencirano

- življenska doba

- kot

- Verjeten

- Limited

- Sklop

- stroj

- strojno učenje

- Tehnike strojnega učenja

- je

- Znamka

- IZDELA

- več

- ogromen

- Stave

- matematični

- pomeni

- Mehanizem

- mentorji

- Metode

- morda

- milijoni

- manjka

- mešanico

- Model

- modeliranje

- modeli

- mesecev

- več

- učinkovitejše

- Najbolj

- premikanje

- veliko

- morajo

- my

- naravna

- Naravni jezik

- Obdelava Natural Language

- Nimate

- potrebe

- omrežij

- Nevronski

- nevronske mreže

- Novo

- Naslednja

- sever

- North America

- prenosnik

- zdaj

- senčenje

- številke

- pridobljeni

- of

- on

- ONE

- samo

- OpenAI

- optimizacija

- Optimizirajte

- optimizacijo

- možnosti

- or

- Ostalo

- naši

- ven

- rezultatov

- več

- pretirano

- parametri

- Starši

- del

- zlasti

- vzorci

- opravlja

- performance

- kramp

- slika

- Pionirstvo

- Kraj

- platforma

- platon

- Platonova podatkovna inteligenca

- PlatoData

- Predvajaj

- potencial

- močan

- Ravno

- napovedati

- napovedovanje

- Napovedi

- napovedno

- Priprava

- primarni

- verjetno

- problem

- Postopek

- obravnavati

- projekti

- Obljublja

- lastniško

- dokazano

- zagotavljajo

- javnega

- javno

- poizvedbe

- vprašanje

- vprašanja

- območje

- REDKO

- utemeljitev

- Preberi

- reading

- Razlog

- zapis

- rafinirano

- odsevalo

- regulatorni

- povezane

- Razmerja

- relativna

- PONOVNO

- predstavlja

- zahteva

- Zahteve

- Raziskave

- viri

- Odzove

- Odgovor

- odgovorov

- REST

- povzroči

- rezultat

- Razkrije

- Pravica

- vloga

- tek

- s

- pravijo,

- rek

- Znanost

- Znanstvenik

- glej

- zdi se

- izberite

- izbiranje

- Zaporedje

- nastavite

- Kratke Hlače

- shouldnt

- Prikaži

- Pomen

- pomemben

- Podoben

- preprosto

- saj

- spretnosti

- So

- Rešitev

- SOLVE

- nekaj

- zvok

- zvoki

- Viri

- specifična

- posebej

- Spreadsheet

- SQL

- postopka

- Začetek

- začel

- Korak

- Še vedno

- prednosti

- Struktura

- Boriti se

- študiral

- Študij

- slog

- uspeh

- uspešno

- taka

- Preverite

- trajnostno

- T

- reševanje

- Bodite

- Naloga

- Naloge

- Skupine

- tehnike

- Tehnologije

- besedilo

- kot

- da

- O

- njihove

- Njih

- te

- jih

- stvar

- stvari

- mislim

- ta

- tisti,

- tisoče

- zategniti

- čas

- do

- skupaj

- Ton

- Orodje

- orodja

- Teme

- proti

- sledenje

- tradicionalna

- usposobljeni

- usposabljanje

- transakcija

- prevesti

- Drevesa

- poskusite

- OBRAT

- Twist

- tip

- dežnik

- pod

- razumeli

- razumevanje

- razumel

- združuje

- neznan

- neprimerljivo

- us

- uporaba

- primeru uporabe

- Rabljeni

- uporabnik

- Uporabniki

- uporablja

- uporabo

- vrednost

- raznolikost

- različnih

- Popravljeno

- vidljivost

- ključnega pomena

- vs

- želi

- način..

- načini

- we

- spletne strani

- Weeks

- Dobro

- so bili

- Kaj

- Kaj je

- kdaj

- ki

- medtem

- zakaj

- pogosto

- bo

- z

- v

- beseda

- besede

- delo

- delal

- vredno

- bi

- še

- jo

- Vaša rutina za

- zefirnet